title: 数据库连接池:从银行柜台到代码世界的奇妙旅程

date: 2025/05/08 01:52:52

updated: 2025/05/08 01:52:52

author: cmdragon

excerpt:

FastAPI开发中,Tortoise-ORM的数据库连接池配置对系统性能至关重要。连接池参数如maxsize、timeout和pool_recycle直接影响并发处理能力。通过动态调整连接池大小、集成Prometheus监控和设置告警规则,可以有效优化性能。常见错误如连接池耗尽可通过逐步增加maxsize和优化慢查询解决。综合监控指标和压力测试工具,可以全面评估连接池状态,确保系统稳定性。

categories:

- 后端开发

- FastAPI

tags:

- FastAPI

- Tortoise-ORM

- 数据库连接池

- 性能调优

- Prometheus监控

- 异步编程

- 数据库优化

扫描二维码

关注或者微信搜一搜:编程智域 前端至全栈交流与成长

探索数千个预构建的 AI 应用,开启你的下一个伟大创意:https://tools.cmdragon.cn/

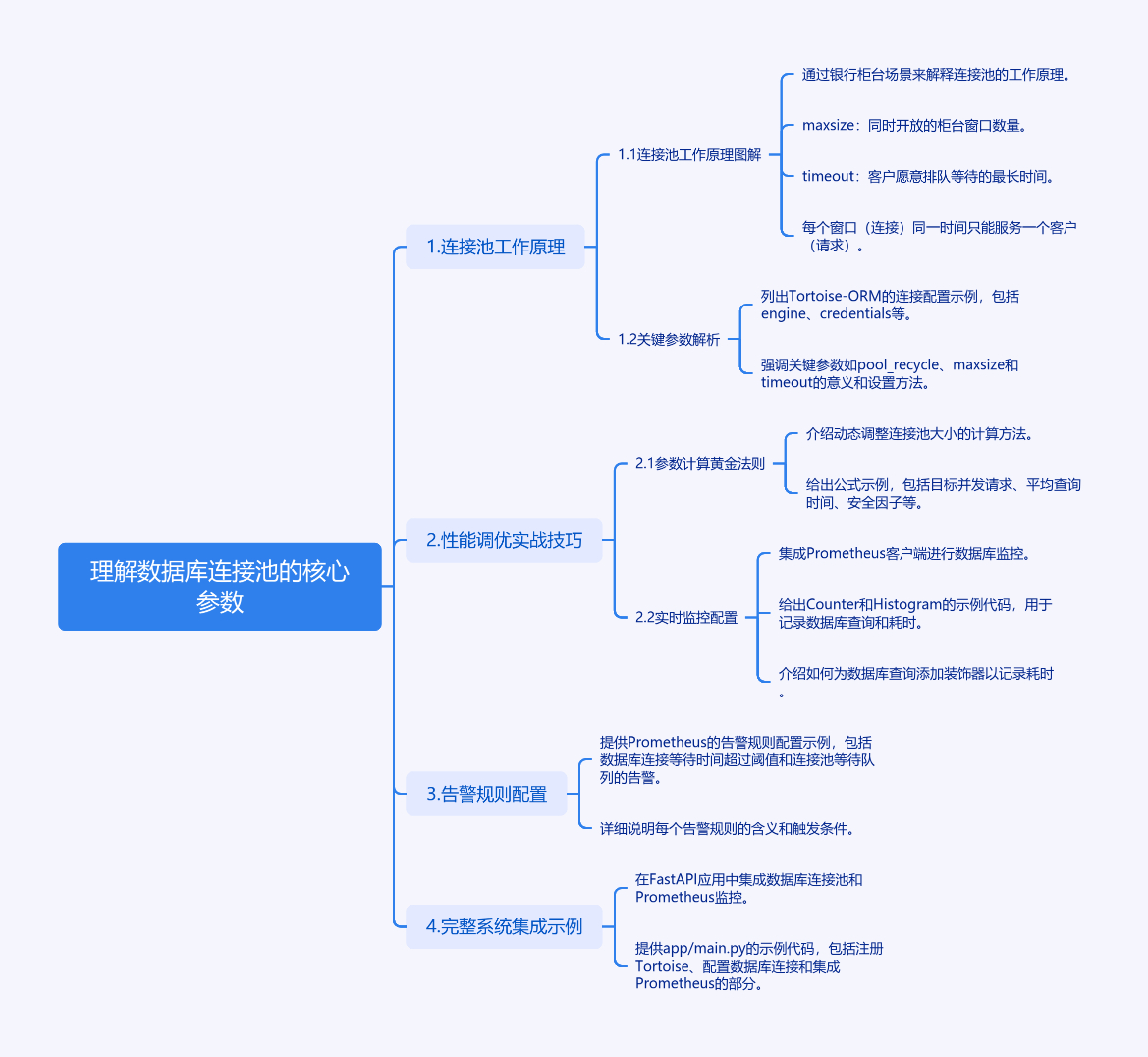

1. 理解数据库连接池的核心参数

当我们使用FastAPI开发高性能API时,数据库连接池管理是保障系统稳定性的关键。Tortoise-ORM作为异步ORM框架,其连接池配置直接影响着应用的并发处理能力。

1.1 连接池工作原理图解

想象一个银行柜台场景:

- maxsize相当于同时开放的柜台窗口数量

- timeout是客户愿意排队等待的最长时间

- 每个窗口(连接)同一时间只能服务一个客户(请求)

1.2 关键参数解析

python

# 典型连接配置示例

TORTOISE_ORM = {

"connections": {

"default": {

"engine": "tortoise.backends.mysql",

"credentials": {

"host": "localhost",

"port": 3306,

"user": "user",

"password": "password",

"database": "mydb",

"pool_recycle": 3600, # 连接重置周期

"maxsize": 20, # 最大连接数

"timeout": 30.0, # 等待超时(秒)

}

}

}

}2. 性能调优实战技巧

2.1 参数计算黄金法则

python

# 动态调整公式示例

def calculate_pool_size():

# 假设每个请求平均需要2ms的数据库操作

target_concurrent_requests = 1000

avg_query_time = 0.002

safety_factor = 1.5

maxsize = (target_concurrent_requests * avg_query_time) * safety_factor

return round(maxsize)2.2 实时监控配置

集成Prometheus客户端:

python

from prometheus_client import Counter, Histogram

DB_QUERY_COUNT = Counter(

'db_query_total',

'Total database queries',

['operation', 'status']

)

DB_QUERY_DURATION = Histogram(

'db_query_duration_seconds',

'Database query duration distribution',

['operation']

)

# 查询耗时记录装饰器

def track_query(func):

async def wrapper(*args, **kwargs):

start_time = time.monotonic()

try:

result = await func(*args, **kwargs)

DB_QUERY_COUNT.labels(operation=func.__name__, status='success').inc()

return result

except Exception as e:

DB_QUERY_COUNT.labels(operation=func.__name__, status='fail').inc()

raise

finally:

duration = time.monotonic() - start_time

DB_QUERY_DURATION.labels(operation=func.__name__).observe(duration)

return wrapper3. 告警规则配置示例

prometheus/alert.rules.yml:

yaml

groups:

- name: database-alerts

rules:

- alert: HighConnectionWait

expr: rate(db_connection_wait_seconds_total[5m]) > 0.5

for: 2m

annotations:

description: '数据库连接等待时间超过阈值'

- alert: ConnectionPoolExhausted

expr: db_pool_usage{state="waiting"} > 0

for: 1m

annotations:

description: '连接池出现等待队列'4. 完整系统集成示例

app/main.py:

python

from fastapi import FastAPI

from tortoise.contrib.fastapi import register_tortoise

from prometheus_client import make_asgi_app

app = FastAPI()

metrics_app = make_asgi_app()

app.mount("/metrics", metrics_app)

register_tortoise(

app,

config={

"connections": {

"default": {

"engine": "tortoise.backends.mysql",

"credentials": {

"host": "localhost",

"user": "root",

"password": "password",

"database": "mydb",

"maxsize": 20,

"timeout": 30.0

}

}

},

"apps": {

"models": {

"models": ["__main__"],

"default_connection": "default"

}

}

}

)

@app.get("/data")

@track_query

async def get_data():

# 示例数据库操作

return {"status": "ok"}5. 常见报错解决方案

错误现象 :

TimeoutError: Connection pool exhausted

解决方案:

- 检查当前连接数:

SHOW STATUS LIKE 'Threads_connected' - 逐步增加maxsize(每次增加10-20%)

- 优化慢查询,添加数据库索引

- 设置合理的连接超时时间

预防建议:

python

# 自动缩放连接池示例

class DynamicConnectionPool:

def __init__(self, base_size=10, max_scale=50):

self.base_size = base_size

self.current_size = base_size

self.max_scale = max_scale

async def adjust_pool(self):

# 根据监控指标自动调整

pass6. 课后Quiz

问题1 :当出现大量ConnectionResetError错误时,应该调整哪个参数?

A) maxsize

B) pool_recycle

C) timeout

D) minsize

答案与解析 :

正确答案是B) pool_recycle。这个参数控制连接重置周期,长时间不重置可能导致服务端主动关闭连接。建议设置为小于数据库的wait_timeout值。

问题2 :如何检测连接池大小是否合理?

A) 监控数据库活跃连接数

B) 查看应用日志中的等待时间

C) 观察Prometheus中的等待队列指标

D) 以上所有

答案与解析 :

正确答案是D) 以上所有。综合多个监控指标才能全面评估连接池状态,单个指标可能无法反映真实情况。

7. 进阶调试技巧

使用查询分析工具:

python

# 在Tortoise配置中启用查询日志

TORTOISE_ORM = {

"connections": {

"default": {

"engine": "tortoise.backends.mysql",

"credentials": {

...

"echo": True # 启用SQL日志

}

}

}

}压力测试命令示例:

bash

# 使用wrk进行并发测试

wrk -t12 -c400 -d30s http://localhost:8000/data监控指标关联分析:

promql

# 计算连接利用率

(db_pool_usage{state="active"} / db_pool_size) * 100运行环境要求:

text

Python 3.8+

FastAPI>=0.68

tortoise-orm>=0.18.0

prometheus-client>=0.11.0余下文章内容请点击跳转至 个人博客页面 或者 扫码关注或者微信搜一搜:编程智域 前端至全栈交流与成长,阅读完整的文章:数据库连接池:从银行柜台到代码世界的奇妙旅程 | cmdragon's Blog

往期文章归档:

- 点赞背后的技术大冒险:分布式事务与SAGA模式 | cmdragon's Blog

- N+1查询:数据库性能的隐形杀手与终极拯救指南 | cmdragon's Blog

- FastAPI与Tortoise-ORM开发的神奇之旅 | cmdragon's Blog

- DDD分层设计与异步职责划分:让你的代码不再"异步"混乱 | cmdragon's Blog

- 异步数据库事务锁:电商库存扣减的防超卖秘籍 | cmdragon's Blog

- FastAPI中的复杂查询与原子更新指南 | cmdragon's Blog

- 深入解析Tortoise-ORM关系型字段与异步查询 | cmdragon's Blog

- FastAPI与Tortoise-ORM模型配置及aerich迁移工具 | cmdragon's Blog

- 异步IO与Tortoise-ORM的数据库 | cmdragon's Blog

- FastAPI数据库连接池配置与监控 | cmdragon's Blog

- 分布式事务在点赞功能中的实现 | cmdragon's Blog

- Tortoise-ORM级联查询与预加载性能优化 | cmdragon's Blog

- 使用Tortoise-ORM和FastAPI构建评论系统 | cmdragon's Blog

- 分层架构在博客评论功能中的应用与实现 | cmdragon's Blog

- 深入解析事务基础与原子操作原理 | cmdragon's Blog

- 掌握Tortoise-ORM高级异步查询技巧 | cmdragon's Blog

- FastAPI与Tortoise-ORM实现关系型数据库关联 | cmdragon's Blog

- Tortoise-ORM与FastAPI集成:异步模型定义与实践 | cmdragon's Blog

- 异步编程与Tortoise-ORM框架 | cmdragon's Blog

- FastAPI数据库集成与事务管理 | cmdragon's Blog

- FastAPI与SQLAlchemy数据库集成 | cmdragon's Blog

- FastAPI与SQLAlchemy数据库集成与CRUD操作 | cmdragon's Blog

- FastAPI与SQLAlchemy同步数据库集成 | cmdragon's Blog

- SQLAlchemy 核心概念与同步引擎配置详解 | cmdragon's Blog

- FastAPI依赖注入性能优化策略 | cmdragon's Blog

- FastAPI安全认证中的依赖组合 | cmdragon's Blog

- FastAPI依赖注入系统及调试技巧 | cmdragon's Blog

- FastAPI依赖覆盖与测试环境模拟 | cmdragon's Blog

- FastAPI中的依赖注入与数据库事务管理 | cmdragon's Blog

- FastAPI依赖注入实践:工厂模式与实例复用的优化策略 | cmdragon's Blog

- FastAPI依赖注入:链式调用与多级参数传递 | cmdragon's Blog

- FastAPI依赖注入:从基础概念到应用 | cmdragon's Blog

- FastAPI中实现动态条件必填字段的实践 | cmdragon's Blog

- FastAPI中Pydantic异步分布式唯一性校验 | cmdragon's Blog

- XML Sitemap