哈喽,大家好,

我是阿星👋

扣子开源了,怎么快速部署到本地呢,一起来跟着操作

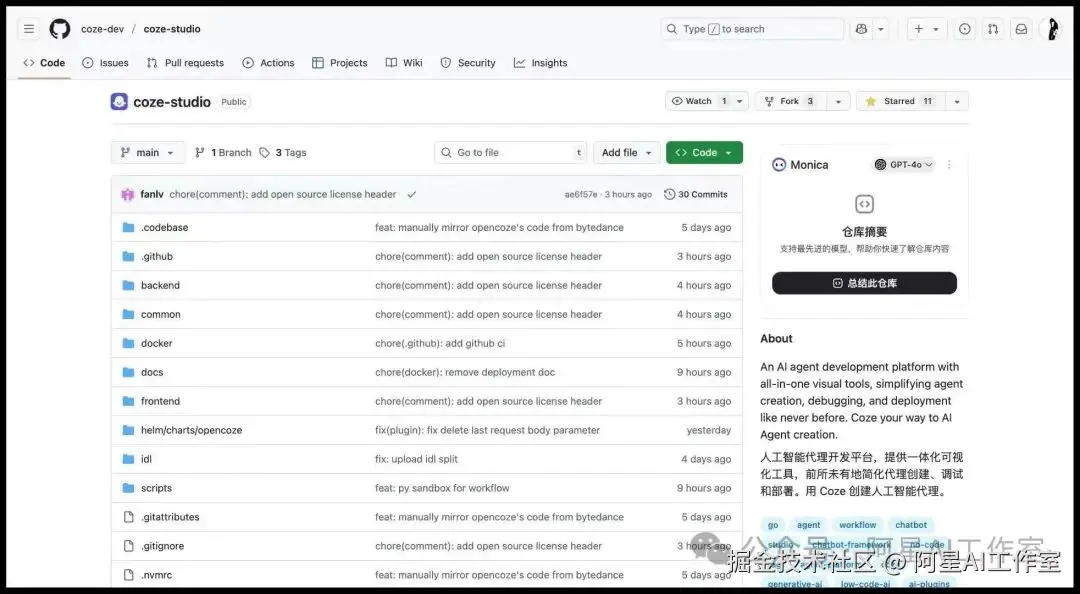

1、下载项目文件

首先,本地新建文件夹,从github克隆代码。

GitHub地址:

shell

# 首先cd到你的目录

bash

# 克隆代码

bash

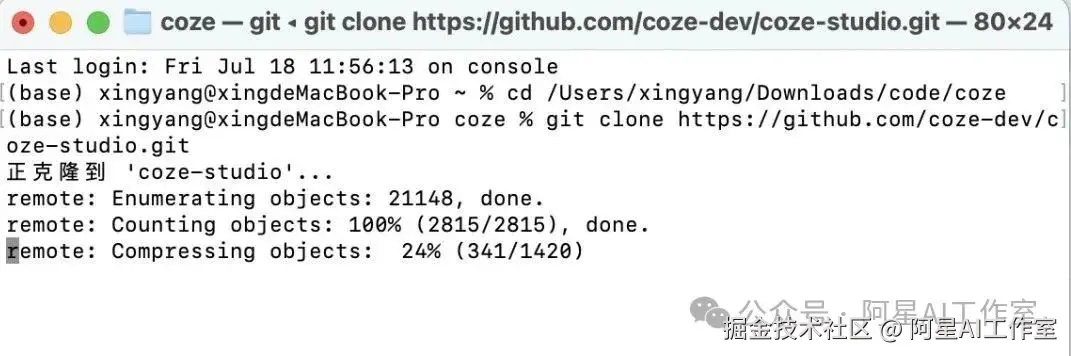

git clone https://github.com/coze-dev/coze-studio.git2、换个路径

但是正式启动之前,要先把大模型配置好。否则你启动了模型没法工作呀。

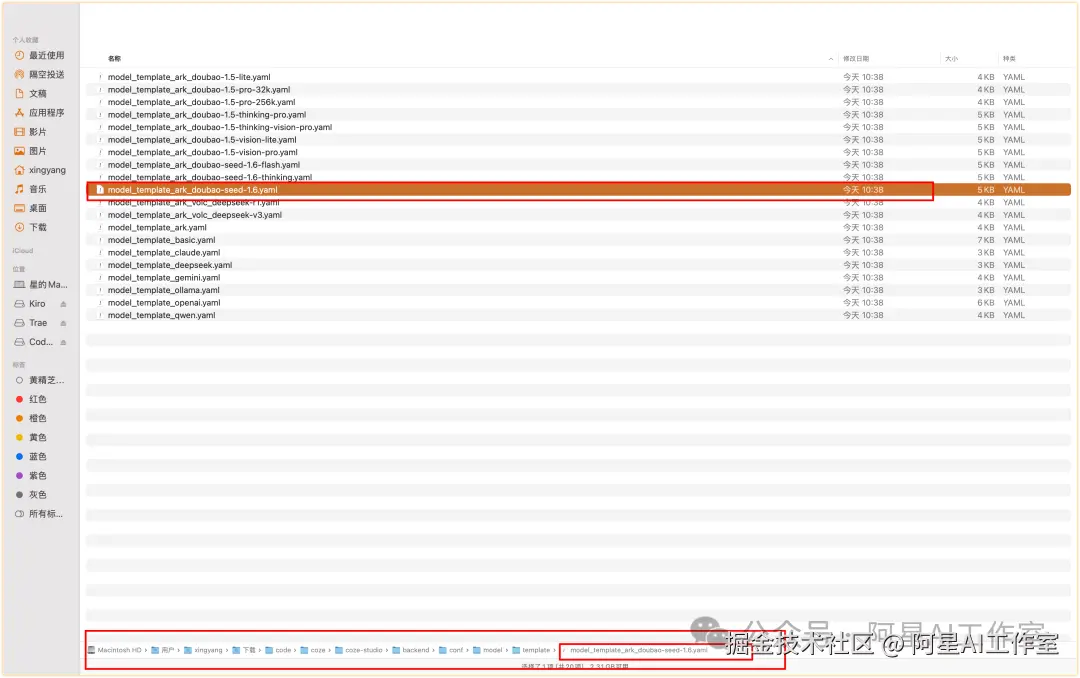

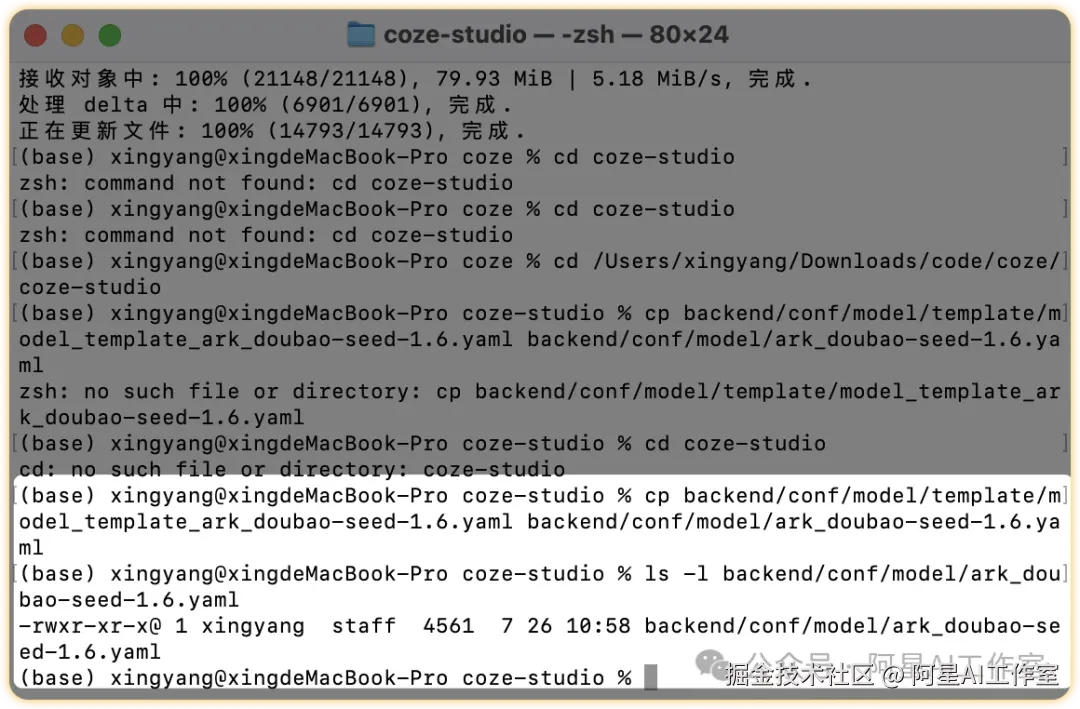

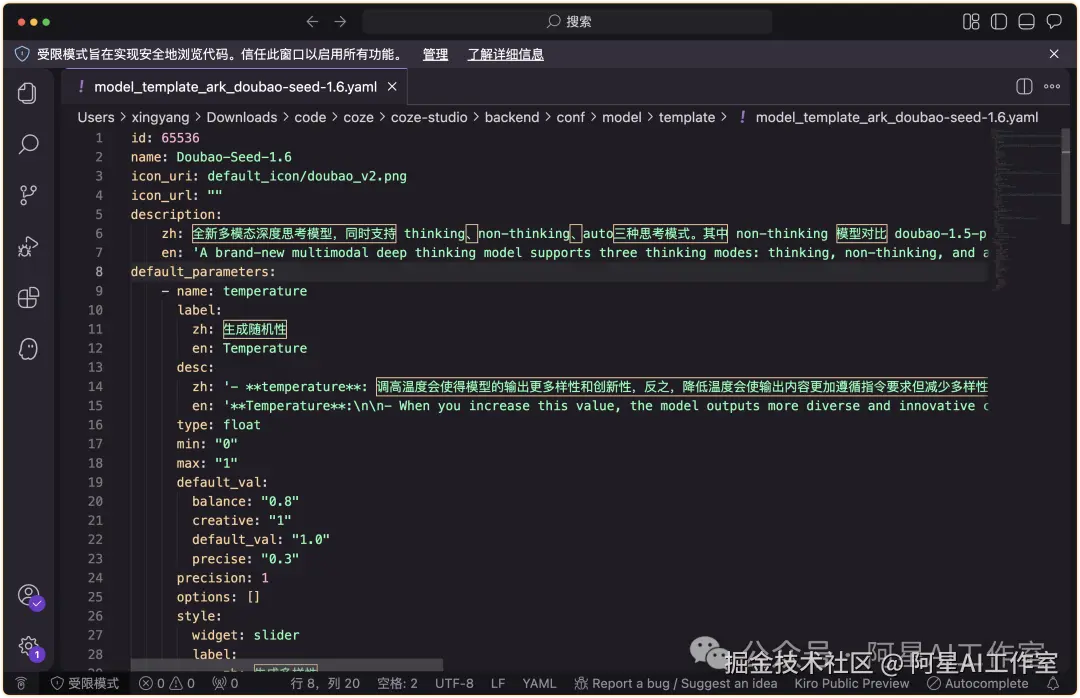

a、从模板目录复制1.6 模型的模版文件,并粘贴到配置文件目录

bash

# 复制1.6 模型配置模版

bash

cd coze-studio

bash

# 然后

bash

cp backend/conf/model/template/model_template_ark_doubao-seed-1.6.yaml backend/conf/model/ark_doubao-seed-1.6.yaml

b、注意,打开你复制后的ark_doubao-seed-1.6.yaml,注意!接下来用的是这个复制后的文件,不是模板里的文件。

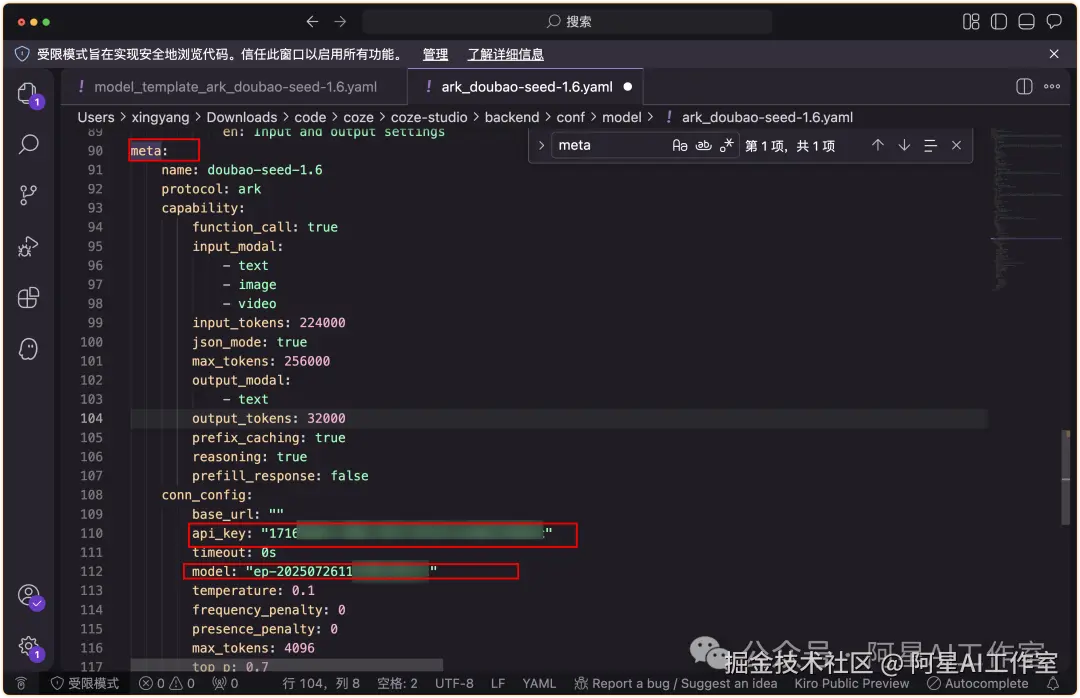

3、更改文件配置

打开ark_doubao-seed-1.6.yaml后,你会看到密密麻麻的代码

小白不要头晕

只 3个参数需要改:

🔴 id:比如123,必须是非 0 的整数,且全局唯一即可

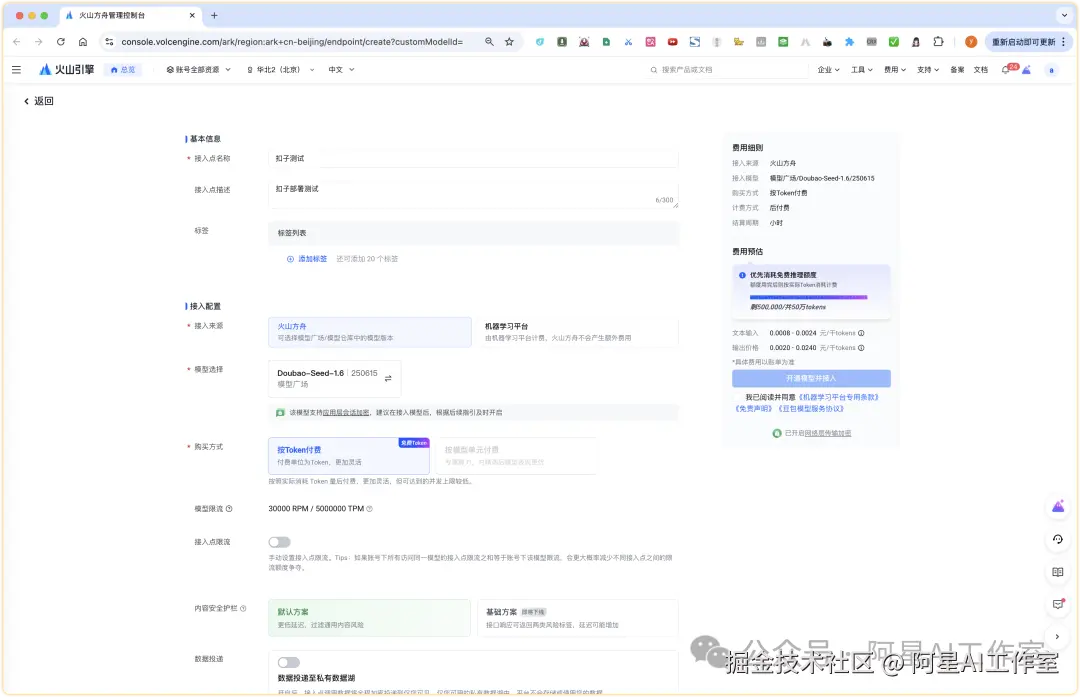

🔴 meta.conn_config.api_key:

就是火山方舟的key,去这个地方获取一个:

API Key (www.volcengine.com/docs/82379/...)

点击创建即可

🔴 meta.conn_config.model :

火山方舟 doubao-seed-1.6 模型接入点的 Endpoint ID

这里获取推理接入点:console.volcengine.com/ark/region:...

然后点击红框里的这个字符,才是你的Endpoint ID

修改完成后大致如下

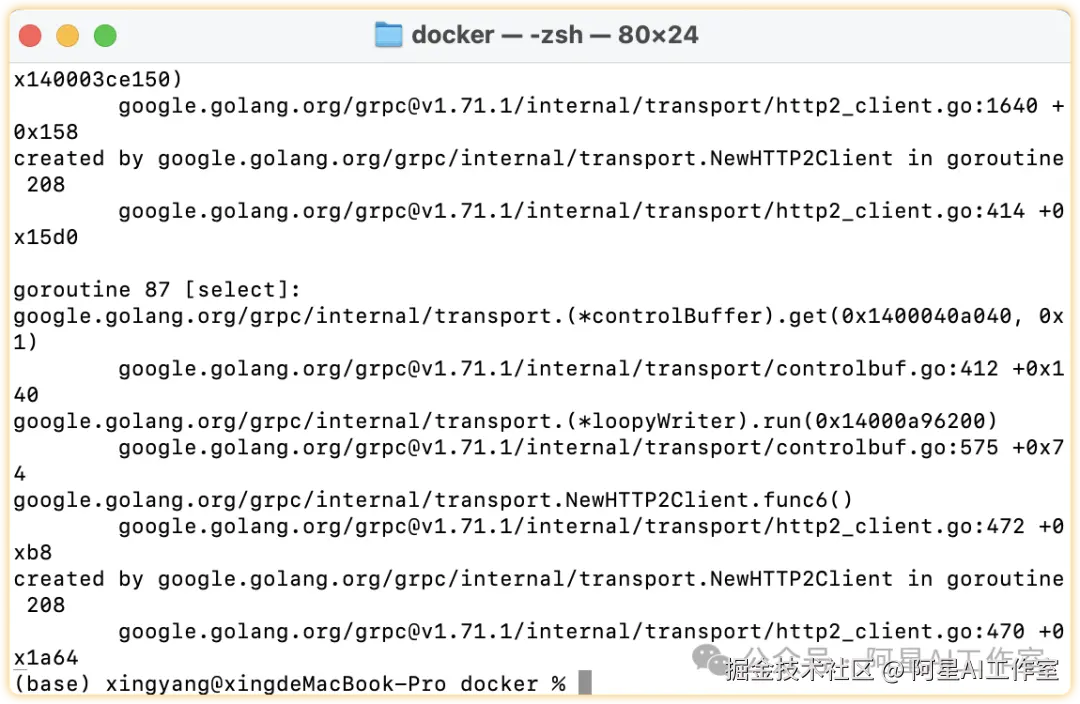

4、docker部署

shell

# 启动服务,换成你自己的路径,比如我的是👉cd /Users/xingyang/Downloads/code/coze/coze-studio/docker#然后分别键入👉 cd docker👉cp .env.example .env👉docker compose --profile '*' up -d然后你就会看到他正在下载

输入邮箱和密码,就可以开始使用啦。

如果还有其他报错比如localhost拒绝了您的请求,直接吧coze-studio文件夹拖到codebuddy里面就可以了。让它给你启动。