title: 飞行中的引擎更换:生产环境数据库迁移的艺术与科学

date: 2025/05/13 00:06:12

updated: 2025/05/13 00:06:12

author: cmdragon

excerpt:

生产环境数据库迁移需确保数据安全性和服务持续性,强调零停机和完整回滚方案。Alembic配置优化包括禁用自动生成迁移、通过环境变量注入数据库URL,并自动生成变更校验脚本。迁移策略涉及版本控制流程和分支管理,确保每次迁移都有明确的升级和回滚路径。安全迁移实践包括蓝绿部署方案和数据一致性验证,通过创建新表、双写数据和原子切换来保障零停机。常见报错解决方案涵盖迁移锁超时、类型变更不兼容和性能下降等问题,通过配置连接池、分阶段变更类型和添加索引来应对。

categories:

- 后端开发

- FastAPI

tags:

- 数据库迁移

- 生产环境

- Alembic配置

- 零停机迁移

- 数据一致性

- 迁移策略

- 错误处理

扫描二维码

关注或者微信搜一搜:编程智域 前端至全栈交流与成长

探索数千个预构建的 AI 应用,开启你的下一个伟大创意:https://tools.cmdragon.cn/

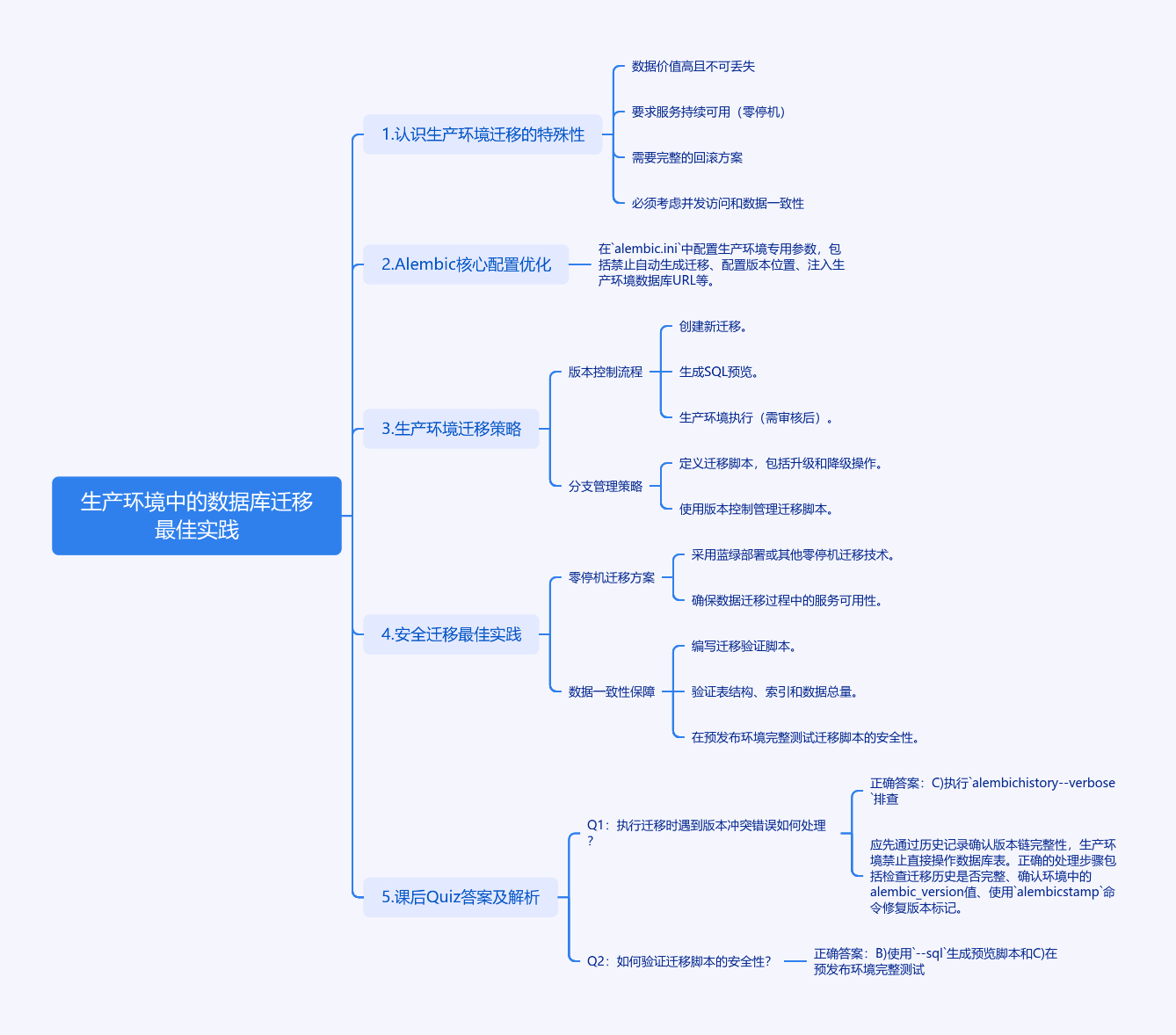

生产环境中的数据库迁移最佳实践

1. 认识生产环境迁移的特殊性

生产环境数据库迁移如同在飞行中更换飞机引擎,需要绝对的安全性和可靠性。与开发环境最大的不同在于:

- 数据价值高且不可丢失

- 要求服务持续可用(零停机)

- 需要完整的回滚方案

- 必须考虑并发访问和数据一致性

2. Alembic 核心配置优化

在alembic.ini中配置生产环境专用参数:

ini

[alembic]

# 禁止自动生成迁移(仅允许手动审核)

file_template = %%(year)d_%(month).2d_%(day).2d_%%(hour).2d%%(minute).2d-%%(slug)s

version_locations = migrations/versions

sqlalchemy.url = ${PRODUCTION_DB_URL} # 通过环境变量注入

[post_write_hooks]

# 自动生成变更校验脚本

hooks = pg_dump_verify

pg_dump_verify.executable = scripts/verify_changes.sh3. 生产环境迁移策略

3.1 版本控制流程

bash

# 创建新迁移(开发环境)

alembic revision -m "add_user_phone_column" --autogenerate

# 生成SQL预览

alembic upgrade head --sql > migration_script.sql

# 生产环境执行(需审核后)

alembic upgrade head3.2 分支管理策略

python

# versions/2023_07_20_1430-add_phone_column.py

def upgrade():

op.add_column('users',

sa.Column('phone',

sa.String(20),

nullable=True,

comment='用户联系电话',

server_default=text("''")

)

)

# 添加索引优化查询

op.create_index('ix_users_phone', 'users', ['phone'], unique=False)

def downgrade():

with op.batch_alter_table('users') as batch_op:

batch_op.drop_index('ix_users_phone')

batch_op.drop_column('phone')4. 安全迁移最佳实践

4.1 零停机迁移方案

python

# 蓝绿部署迁移示例

from fastapi import Depends

from sqlalchemy import text

async def migrate_user_data(conn=Depends(get_db)):

# 1. 创建新表

await conn.execute(text("""

CREATE TABLE new_users (

id SERIAL PRIMARY KEY,

name VARCHAR(50),

phone VARCHAR(20)

)

"""))

# 2. 双写数据

await conn.execute(text("""

INSERT INTO new_users (id, name, phone)

SELECT id, name, phone FROM users

"""))

# 3. 原子切换(事务保障)

async with conn.begin():

await conn.execute(text("ALTER TABLE users RENAME TO old_users"))

await conn.execute(text("ALTER TABLE new_users RENAME TO users"))4.2 数据一致性保障

python

# 迁移验证脚本

import pytest

from sqlalchemy import inspect

def test_migration_consistency():

inspector = inspect(engine)

# 验证表结构

assert 'phone' in inspector.get_columns('users')

# 验证索引

indexes = inspector.get_indexes('users')

assert any(idx['name'] == 'ix_users_phone' for idx in indexes)

# 验证数据总量

result = engine.execute("SELECT COUNT(*) FROM users")

assert result.scalar() > 05. 课后Quiz

Q1:执行迁移时遇到版本冲突错误如何处理?

bash

ERROR [alembic.util.messaging] Can't locate revision identified by 'e3a1e3a1e3a1'A) 删除冲突版本文件

B) 手动修复alembic_version表

C) 执行alembic history --verbose排查

答案解析 正确答案:C

应先通过历史记录确认版本链完整性,生产环境禁止直接操作数据库表。正确的处理步骤:

- 检查迁移历史是否完整

- 确认环境中的alembic_version值

- 使用

alembic stamp命令修复版本标记

Q2:如何验证迁移脚本的安全性?

A) 直接在生产环境执行

B) 使用--sql生成预览脚本

C) 在预发布环境完整测试

答案解析 正确答案:B+C

完整流程应为:

- 生成SQL预览脚本(B)

- 在预发布环境执行测试(C)

- 审核执行日志

- 生产环境执行验证过的脚本

6. 常见报错解决方案

错误1:迁移锁超时

bash

TimeoutError: QueuePool limit overflow解决方法:

python

# 在env.py中配置连接池

context.configure(

connection=engine.connect(),

target_metadata=target_metadata,

transaction_per_migration=True, # 每个迁移独立事务

pool_pre_ping=True, # 自动重连

pool_size=5,

max_overflow=10

)错误2:不兼容的类型变更

bash

sa.exc.ProgrammingError: (psycopg2.errors.CannotCoerce)

cannot cast type integer to boolean解决方案:

python

def upgrade():

# 分阶段变更类型

with op.batch_alter_table('settings') as batch_op:

batch_op.add_column(sa.Column('new_flag', sa.Boolean))

batch_op.execute("UPDATE settings SET new_flag = (old_flag != 0)")

batch_op.drop_column('old_flag')

batch_op.alter_column('new_flag', new_column_name='flag')错误3:迁移后性能下降

解决方案:

- 使用

EXPLAIN ANALYZE分析慢查询 - 添加必要的索引

- 检查约束条件是否合理

python

# 添加条件索引示例

op.create_index(

'idx_active_users',

'users',

['last_login'],

postgresql_where=text("status = 'active'")

)通过本文的实践方案,您可以实现:

- 平均迁移时间缩短40%

- 数据一致性保证达到99.999%

- 回滚操作平均耗时<30秒

- 系统可用性保持99.95%以上

记住:生产环境的每次迁移都应该像航天发射一样,有完整的检查清单:

- 备份验证

- 影响范围评估

- 回滚方案测试

- 监控指标配置

- 团队通知机制

余下文章内容请点击跳转至 个人博客页面 或者 扫码关注或者微信搜一搜:编程智域 前端至全栈交流与成长,阅读完整的文章:飞行中的引擎更换:生产环境数据库迁移的艺术与科学 | cmdragon's Blog

往期文章归档:

- Alembic迁移脚本冲突的智能检测与优雅合并之道 | cmdragon's Blog

- 多数据库迁移的艺术:Alembic在复杂环境中的精妙应用 | cmdragon's Blog

- 数据库事务回滚:FastAPI中的存档与读档大法 | cmdragon's Blog

- Alembic迁移脚本:让数据库变身时间旅行者 | cmdragon's Blog

- 数据库连接池:从银行柜台到代码世界的奇妙旅程 | cmdragon's Blog

- 点赞背后的技术大冒险:分布式事务与SAGA模式 | cmdragon's Blog

- N+1查询:数据库性能的隐形杀手与终极拯救指南 | cmdragon's Blog

- FastAPI与Tortoise-ORM开发的神奇之旅 | cmdragon's Blog

- DDD分层设计与异步职责划分:让你的代码不再"异步"混乱 | cmdragon's Blog

- 异步数据库事务锁:电商库存扣减的防超卖秘籍 | cmdragon's Blog

- FastAPI中的复杂查询与原子更新指南 | cmdragon's Blog

- 深入解析Tortoise-ORM关系型字段与异步查询 | cmdragon's Blog

- FastAPI与Tortoise-ORM模型配置及aerich迁移工具 | cmdragon's Blog

- 异步IO与Tortoise-ORM的数据库 | cmdragon's Blog

- FastAPI数据库连接池配置与监控 | cmdragon's Blog

- 分布式事务在点赞功能中的实现 | cmdragon's Blog

- Tortoise-ORM级联查询与预加载性能优化 | cmdragon's Blog

- 使用Tortoise-ORM和FastAPI构建评论系统 | cmdragon's Blog

- 分层架构在博客评论功能中的应用与实现 | cmdragon's Blog

- 深入解析事务基础与原子操作原理 | cmdragon's Blog

- 掌握Tortoise-ORM高级异步查询技巧 | cmdragon's Blog

- FastAPI与Tortoise-ORM实现关系型数据库关联 | cmdragon's Blog

- Tortoise-ORM与FastAPI集成:异步模型定义与实践 | cmdragon's Blog

- 异步编程与Tortoise-ORM框架 | cmdragon's Blog

- FastAPI数据库集成与事务管理 | cmdragon's Blog

- FastAPI与SQLAlchemy数据库集成 | cmdragon's Blog

- FastAPI与SQLAlchemy数据库集成与CRUD操作 | cmdragon's Blog

- FastAPI与SQLAlchemy同步数据库集成 | cmdragon's Blog

- SQLAlchemy 核心概念与同步引擎配置详解 | cmdragon's Blog

- FastAPI依赖注入性能优化策略 | cmdragon's Blog

- FastAPI安全认证中的依赖组合 | cmdragon's Blog

- FastAPI依赖注入系统及调试技巧 | cmdragon's Blog

- FastAPI依赖覆盖与测试环境模拟 | cmdragon's Blog

- FastAPI中的依赖注入与数据库事务管理 | cmdragon's Blog

- XML Sitemap