title: 数据库迁移的艺术:FastAPI生产环境中的灰度发布与回滚策略

date: 2025/05/17 21:06:56

updated: 2025/05/17 21:06:56

author: cmdragon

excerpt:

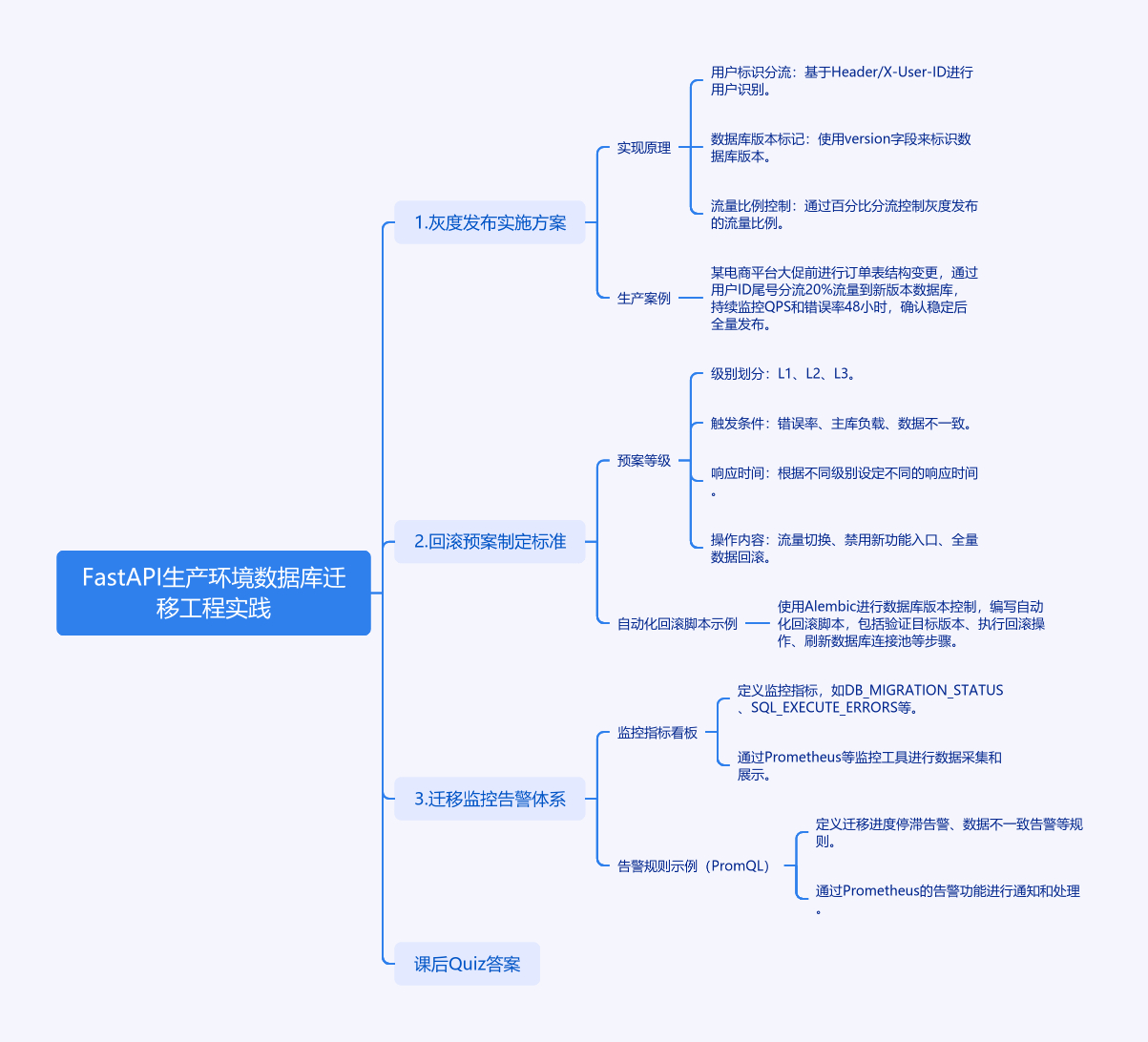

FastAPI生产环境数据库迁移工程实践采用灰度发布、回滚预案和监控告警体系确保安全。灰度发布通过用户标识分流、数据库版本标记和流量比例控制实现渐进式部署。回滚预案分为三级,分别针对错误率、主库负载和数据不一致情况,自动化回滚脚本确保快速响应。监控系统覆盖全链路指标,使用Prometheus进行实时监控和告警,确保迁移过程稳定可控。

categories:

- 后端开发

- FastAPI

tags:

- FastAPI

- 数据库迁移

- 灰度发布

- 回滚预案

- 监控告警

- 生产环境

- 工程实践

扫描二维码

关注或者微信搜一搜:编程智域 前端至全栈交流与成长

探索数千个预构建的 AI 应用,开启你的下一个伟大创意:https://tools.cmdragon.cn/

第一章 FastAPI生产环境数据库迁移工程实践

1.1 灰度发布实施方案

灰度发布是数据库变更的生命保障系统,通过渐进式部署策略降低生产事故风险。我们采用三层灰度机制:

实现原理:

- 用户标识分流(基于Header/X-User-ID)

- 数据库版本标记(version字段)

- 流量比例控制(百分比分流)

python

# app/core/middleware.py

from fastapi import Request, Response

from starlette.middleware.base import BaseHTTPMiddleware

class GrayReleaseMiddleware(BaseHTTPMiddleware):

async def dispatch(self, request: Request, call_next):

# 获取用户标识或随机分流

user_group = request.headers.get('X-User-ID', hash(request.client.host)) % 100

# 检查数据库版本标记

db_version = await check_database_version()

# 分流逻辑

if user_group < current_app.config['GRAY_PERCENT'] and db_version == 'new':

response = await call_next(request)

response.headers['X-Gray-Status'] = 'activated'

return response

else:

return Response(content="Service in maintenance", status_code=503)

# app/models/schemas.py

from pydantic import BaseModel

class UserGraySchema(BaseModel):

user_id: int

group: int = Field(ge=0, le=100,

description="灰度分组0-99,按百分比分配流量")生产案例:

某电商平台大促前进行订单表结构变更,通过用户ID尾号分流20%流量到新版本数据库,持续监控QPS和错误率48小时,确认稳定后全量发布。

1.2 回滚预案制定标准

完整的回滚机制应包含三级防御体系:

预案等级:

| 级别 | 触发条件 | 响应时间 | 操作内容 |

|---|---|---|---|

| L1 | 错误率>5% | 5分钟 | 流量切换至旧版 |

| L2 | 主库负载>80% | 3分钟 | 禁用新功能入口 |

| L3 | 数据不一致 | 立即 | 全量数据回滚 |

自动化回滚脚本示例:

python

# scripts/rollback_manager.py

import subprocess

from alembic.config import Config

from alembic import command

class RollbackEngine:

def __init__(self):

self.alembic_cfg = Config("alembic.ini")

def execute_rollback(self, revision: str):

try:

# 验证目标版本有效性

command.history(self.alembic_cfg)

# 执行回滚操作

command.downgrade(self.alembic_cfg, revision)

# 刷新数据库连接池

restart_database_pool()

except Exception as e:

alert_ops_team(f"Rollback failed: {str(e)}")

raise1.3 迁移监控告警体系

监控系统需要覆盖全链路指标:

监控指标看板:

python

# app/monitoring/prometheus.py

from prometheus_client import Counter, Gauge

DB_MIGRATION_STATUS = Gauge(

'db_migration_state',

'Current migration version status',

['env', 'db_cluster']

)

SQL_EXECUTE_ERRORS = Counter(

'sql_execute_errors_total',

'Total SQL execution errors',

['operation', 'table']

)

def track_migration_metrics():

current_rev = get_current_revision()

DB_MIGRATION_STATUS.labels(

env=os.getenv('ENV'),

db_cluster=DB_CLUSTER_NAME

).set(current_rev)告警规则示例(PromQL):

bash

# 迁移进度停滞告警

ALERT MigrationStalled

IF rate(alembic_migration_seconds_count[5m]) == 0

FOR 10m

# 数据不一致告警

ALERT DataInconsistency

IF (db_rowcount_new - db_rowcount_old) / db_rowcount_old > 0.01课后Quiz

-

当灰度发布过程中出现连接池耗尽,应首先执行哪种操作?

A) 重启数据库

B) 扩容服务器

C) 触发L1级回滚

D) 停止监控收集

答案:C

连接池耗尽属于系统资源类故障,按照预案应立即切换流量保证核心业务

-

如何验证Alembic迁移文件是否幂等?

A) 多次执行upgrade/downgrade

B) 检查文件hash值

C) 对比生产测试环境

D) 人工代码评审

答案:A

通过重复执行迁移操作验证幂等性是最直接有效的方法

常见报错处理

错误1:alembic.util.exc.CommandError: Can't locate revision identified by 'xxxx'

- 原因:迁移版本号冲突

- 解决:

- 执行

alembic history --verbose查看版本树 - 使用

alembic downgrade -1回退到稳定版本 - 删除冲突的迁移文件重新生成

- 执行

错误2:pydantic.error_wrappers.ValidationError

-

预防措施:

- 在Schema中使用Literal类型限定枚举值

pythonfrom pydantic import Literal class UserSchema(BaseModel): status: Literal['active', 'disabled']- 配置严格的输入校验中间件

错误3:sqlalchemy.exc.OperationalError: (pymysql.err.OperationalError) 2013 Lost connection to MySQL server during

query

-

处理流程:

- 检查数据库连接池配置

- 增加TCP keepalive参数

python# 数据库连接配置追加参数 connect_args={"connect_timeout": 30, "keepalives": 1}- 设置SQL执行超时阈值

余下文章内容请点击跳转至 个人博客页面 或者 扫码关注或者微信搜一搜:编程智域 前端至全栈交流与成长,阅读完整的文章:数据库迁移的艺术:FastAPI生产环境中的灰度发布与回滚策略 | cmdragon's Blog

往期文章归档:

- 数据库迁移的艺术:团队协作中的冲突预防与解决之道 | cmdragon's Blog

- 驾驭FastAPI多数据库:从读写分离到跨库事务的艺术 | cmdragon's Blog

- 数据库事务隔离与Alembic数据恢复的实战艺术 | cmdragon's Blog

- FastAPI与Alembic:数据库迁移的隐秘艺术 | cmdragon's Blog

- 飞行中的引擎更换:生产环境数据库迁移的艺术与科学 | cmdragon's Blog

- Alembic迁移脚本冲突的智能检测与优雅合并之道 | cmdragon's Blog

- 多数据库迁移的艺术:Alembic在复杂环境中的精妙应用 | cmdragon's Blog

- 数据库事务回滚:FastAPI中的存档与读档大法 | cmdragon's Blog

- Alembic迁移脚本:让数据库变身时间旅行者 | cmdragon's Blog

- 数据库连接池:从银行柜台到代码世界的奇妙旅程 | cmdragon's Blog

- 点赞背后的技术大冒险:分布式事务与SAGA模式 | cmdragon's Blog

- N+1查询:数据库性能的隐形杀手与终极拯救指南 | cmdragon's Blog

- FastAPI与Tortoise-ORM开发的神奇之旅 | cmdragon's Blog

- DDD分层设计与异步职责划分:让你的代码不再"异步"混乱 | cmdragon's Blog

- 异步数据库事务锁:电商库存扣减的防超卖秘籍 | cmdragon's Blog

- FastAPI中的复杂查询与原子更新指南 | cmdragon's Blog

- 深入解析Tortoise-ORM关系型字段与异步查询 | cmdragon's Blog

- FastAPI与Tortoise-ORM模型配置及aerich迁移工具 | cmdragon's Blog

- 异步IO与Tortoise-ORM的数据库 | cmdragon's Blog

- FastAPI数据库连接池配置与监控 | cmdragon's Blog

- 分布式事务在点赞功能中的实现 | cmdragon's Blog

- Tortoise-ORM级联查询与预加载性能优化 | cmdragon's Blog

- 使用Tortoise-ORM和FastAPI构建评论系统 | cmdragon's Blog

- 分层架构在博客评论功能中的应用与实现 | cmdragon's Blog

- 深入解析事务基础与原子操作原理 | cmdragon's Blog

- 掌握Tortoise-ORM高级异步查询技巧 | cmdragon's Blog

- FastAPI与Tortoise-ORM实现关系型数据库关联 | cmdragon's Blog

- Tortoise-ORM与FastAPI集成:异步模型定义与实践 | cmdragon's Blog

- 异步编程与Tortoise-ORM框架 | cmdragon's Blog

- FastAPI数据库集成与事务管理 | cmdragon's Blog

- FastAPI与SQLAlchemy数据库集成 | cmdragon's Blog

- FastAPI与SQLAlchemy数据库集成与CRUD操作 | cmdragon's Blog

- FastAPI与SQLAlchemy同步数据库集成 | cmdragon's Blog

- SQLAlchemy 核心概念与同步引擎配置详解 | cmdragon's Blog

- XML Sitemap