文章目录

-

- 前言

- 1.安装Ollama

- 2.QwQ-32B模型安装与运行

- 3.Cursor安装与配置

- [4. 简单使用测试](#4. 简单使用测试)

- [5. 调用本地大模型](#5. 调用本地大模型)

- [6. 安装内网穿透](#6. 安装内网穿透)

- [7. 配置固定公网地址](#7. 配置固定公网地址)

- 总结

前言

本文主要介绍如何在Windows环境下,使用Cursor接入Ollama启动本地部署的千问qwq-32b大模型实现辅助编程,并结合cpolar内网穿透工具配置公网地址的自定义OPENAI API,实现随时随地远程使用。为了提升开发效率,借助大型语言模型进行辅助编程的需求日益增长。Cursor作为一款强大的代码助手,因其便捷的操作体验受到许多开发者的青睐。然而,Cursor的核心功能依赖于在线模型的调用,如果你希望在任何地点都能流畅使用Cursor,并同时利用本地大模型的强大能力,例如千问qwq-32b,一个可行的方案是构建一个自定义的OPENAI API接口。由于Cursor的架构设计,这个API接口必须能够通过公网访问。

Cursor非常好用,但是它主要是做线上模型调用的,仅支持公网的模型调用。所以如果想要远程通过Cursor使用本地大模型,需要配置自定义OPENAI API,这个API地址必须公网,不然报错。如果因为担心隐私问题或是想要节省下一笔不菲的在线tokens调用费,那么在本地部署大模型并结合cpolar内网穿透工具来实现随时随地使用Cursor调用本地大模型来辅助开发是一个不错的解决方案。

这样做的好处是双重的:一方面,消除了对公网模型的依赖,避免了因隐私泄露的潜在风险;另一方面,减少了对在线token的消耗,降低了使用成本。简而言之,通过本地部署、cpolar穿透和自定义API的组合,我们能够实现安全、便捷、经济的远程辅助编程体验。

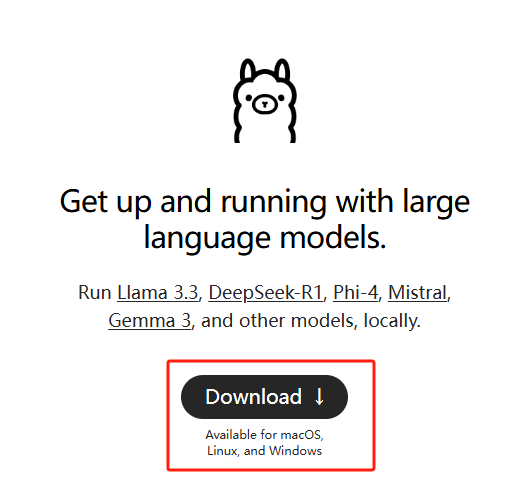

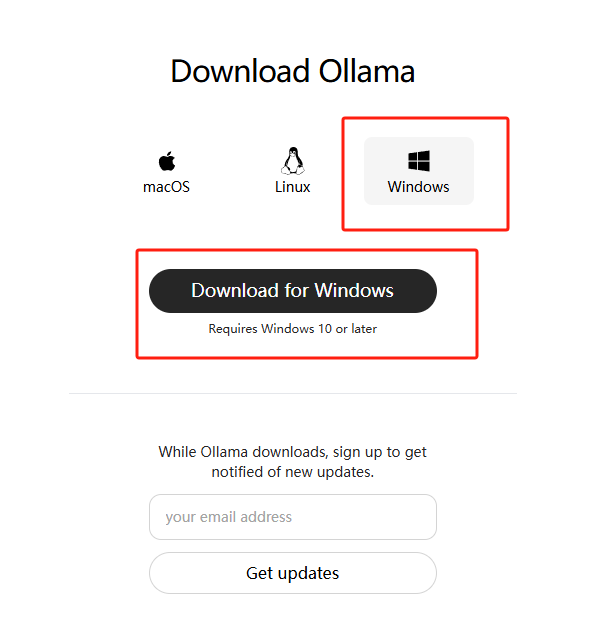

1.安装Ollama

本例中使用的是Windows11系统专业版,通过Ollama运行Gemma3:27B大模型,之前曾经发布过如何在Windows安装Ollama的教程,有需要的同学可以看看这篇文章:Windows本地部署Deepseek-R1大模型并使用Web界面远程交互

简单来说,就是访问Ollama的官网:Download Ollama on Windows

下载对应版本的ollama安装程序并安装:

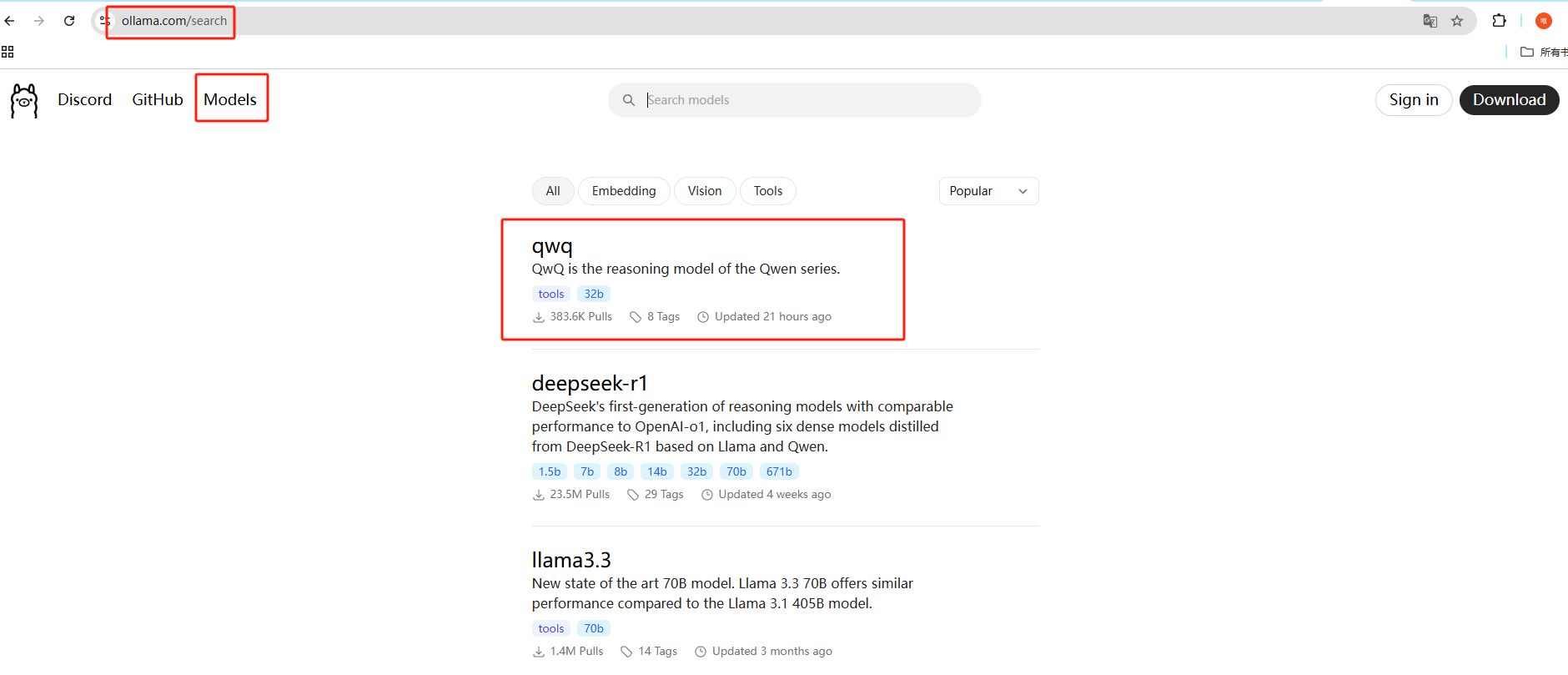

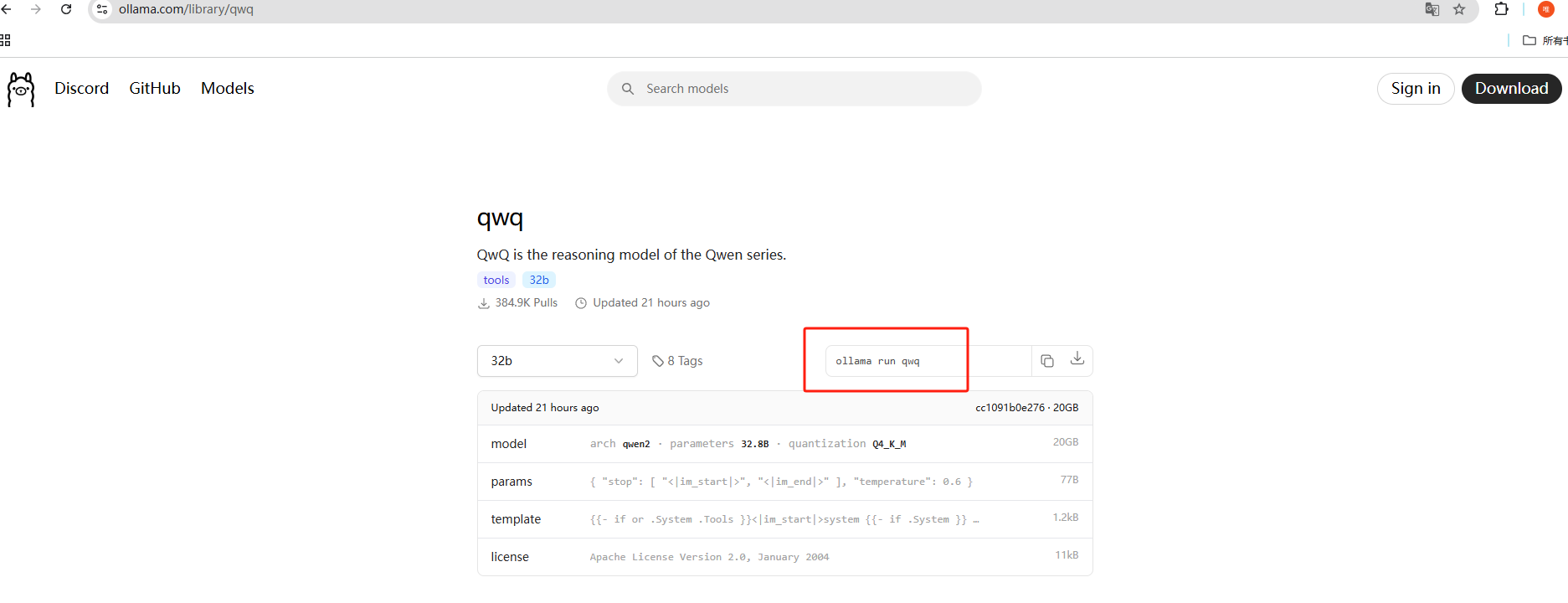

2.QwQ-32B模型安装与运行

在Ollama的官网点击Models,搜索qwq就可以看到模型:

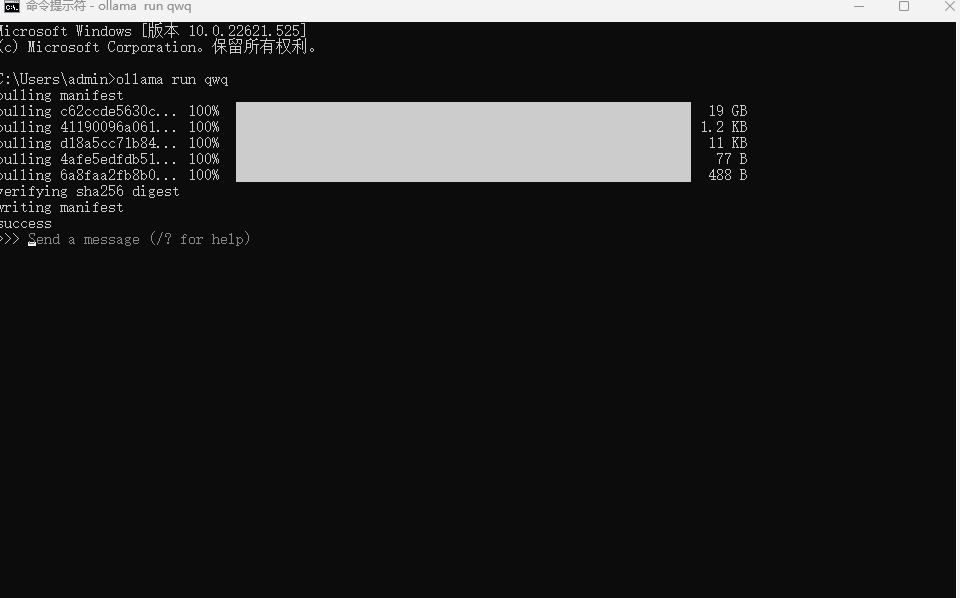

Ollama安装完成之后,就可以开始去下载 QwQ-32B 模型了,使用这个命令就能下载:

shell

ollama run qwq

ps:需要预留20个G以上的储存空间,默认下载到C盘,如果想修改下载位置,可以在终端中执行下方命令来指定模型文件的存放目录,这里以d:\ollama为例,大家可以自定义:

shellset OLLAMA_MODELS=d:\ollama

下载中,时间有点长,等待进度条完成即可,模型安装成功后会提示success,并可以进行提问了:

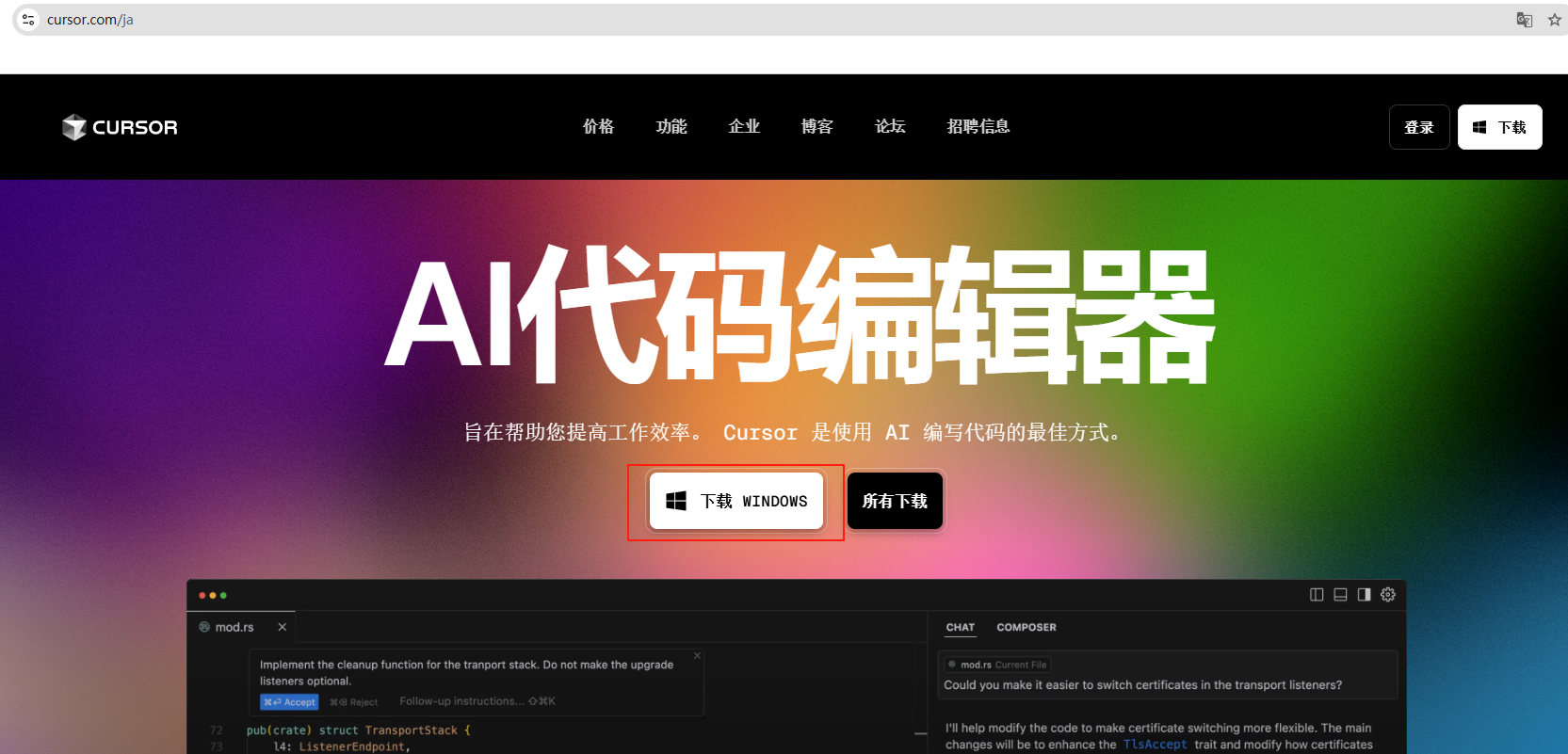

3.Cursor安装与配置

访问cursor官网下载Windows版本: https://www.cursor.com/

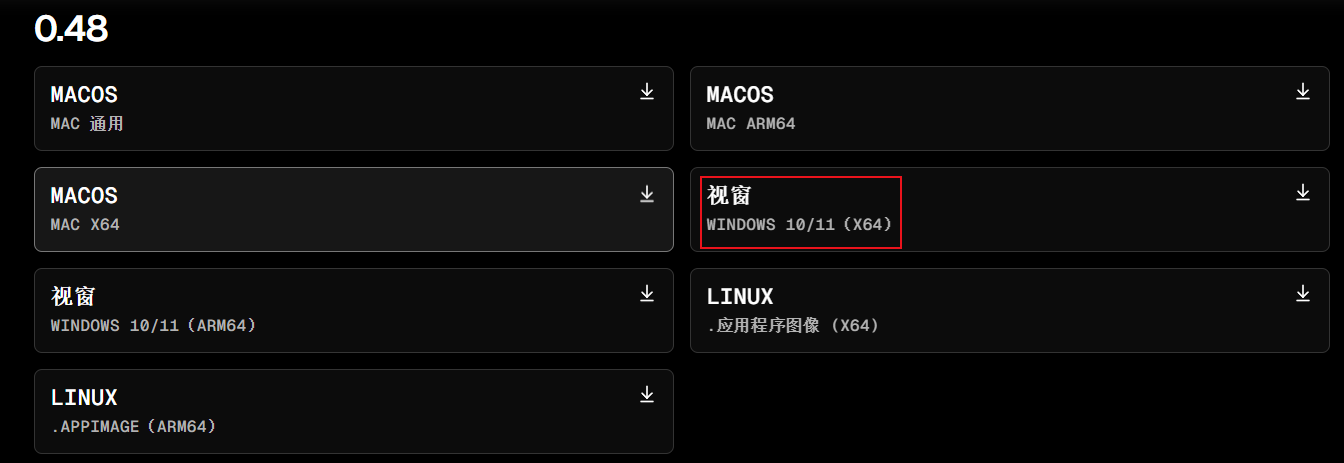

我这里下载的是Windows X64的0.48版本:

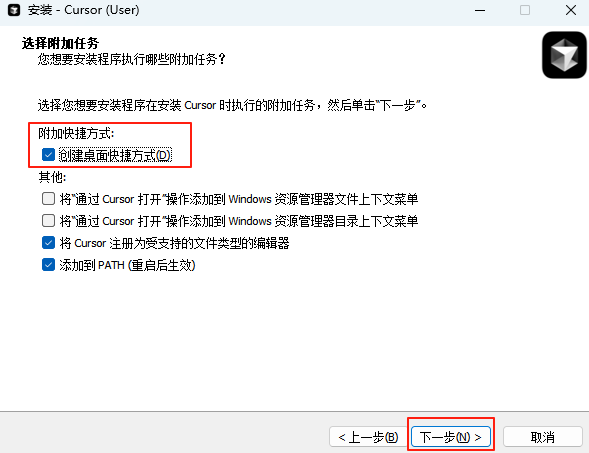

下载后,按照提示一步步安装,如需创建桌面快捷方式,勾选即可:

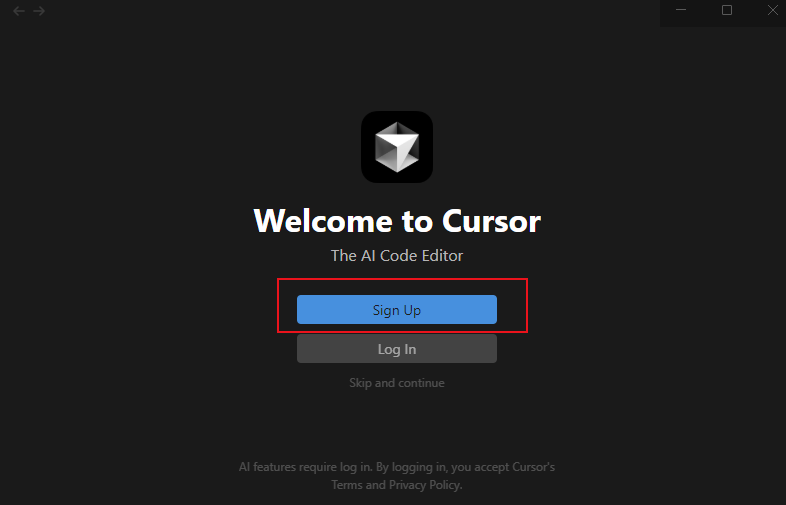

点击完成后,第一次运行程序会弹出登录窗口:

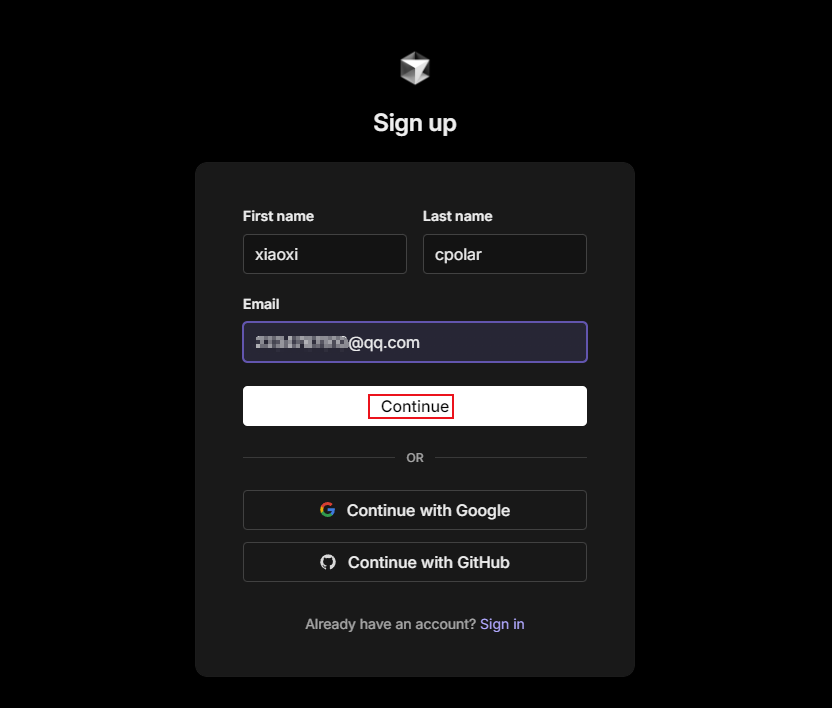

点击Sign UP注册一个账号登录:

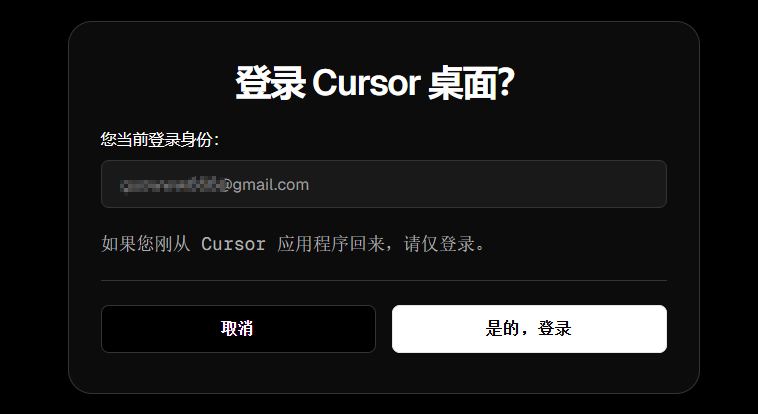

或者使用google或github账号登录,都可以:

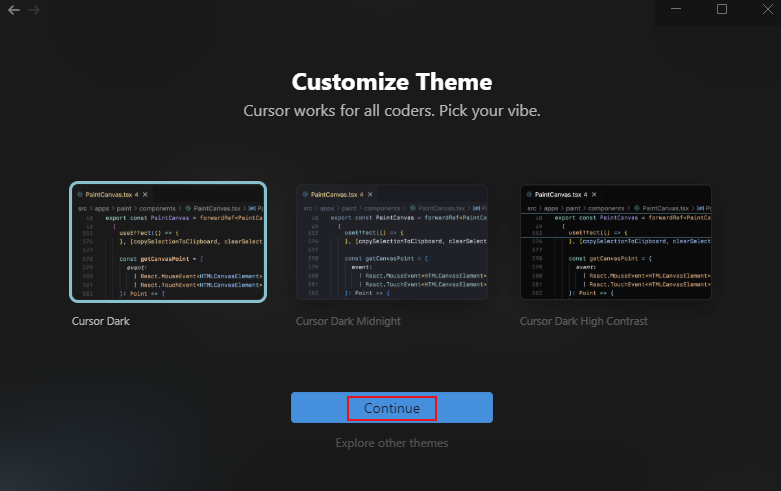

选择一个主题,点击继续:

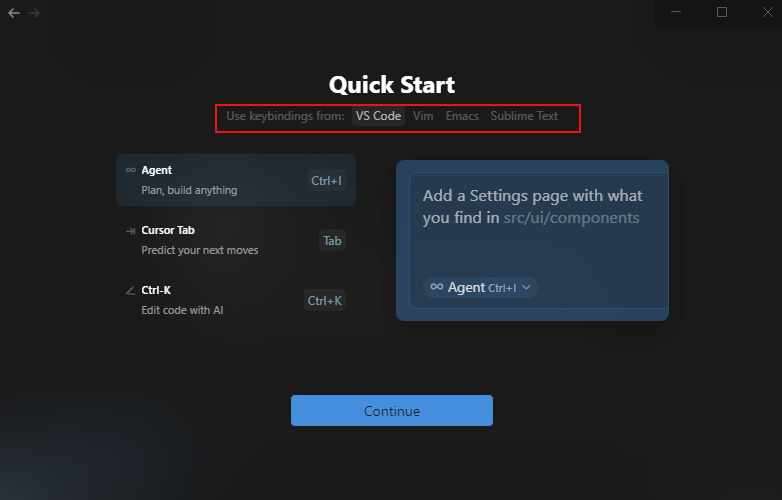

选择快捷键风格,点击继续:

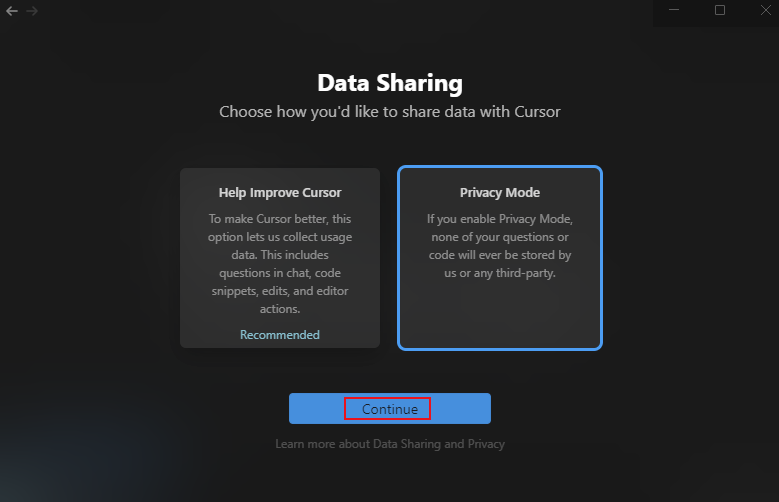

数据分享这里选择了私人模式进行演示,大家可以根据自己情况选择:

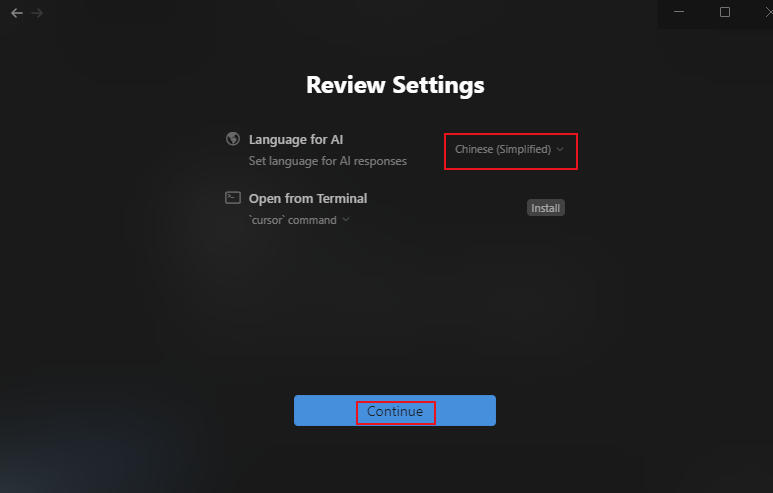

给AI发送信息的语言选择简体中文:

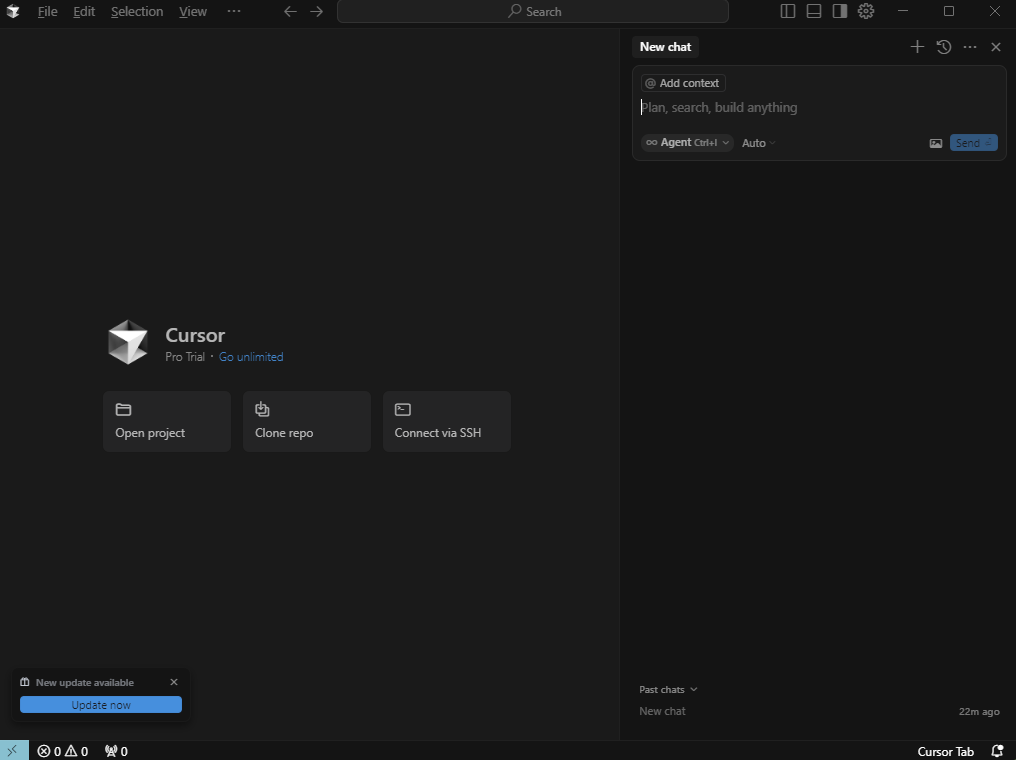

配置完毕后,既可看到Cursor的主界面了:

4. 简单使用测试

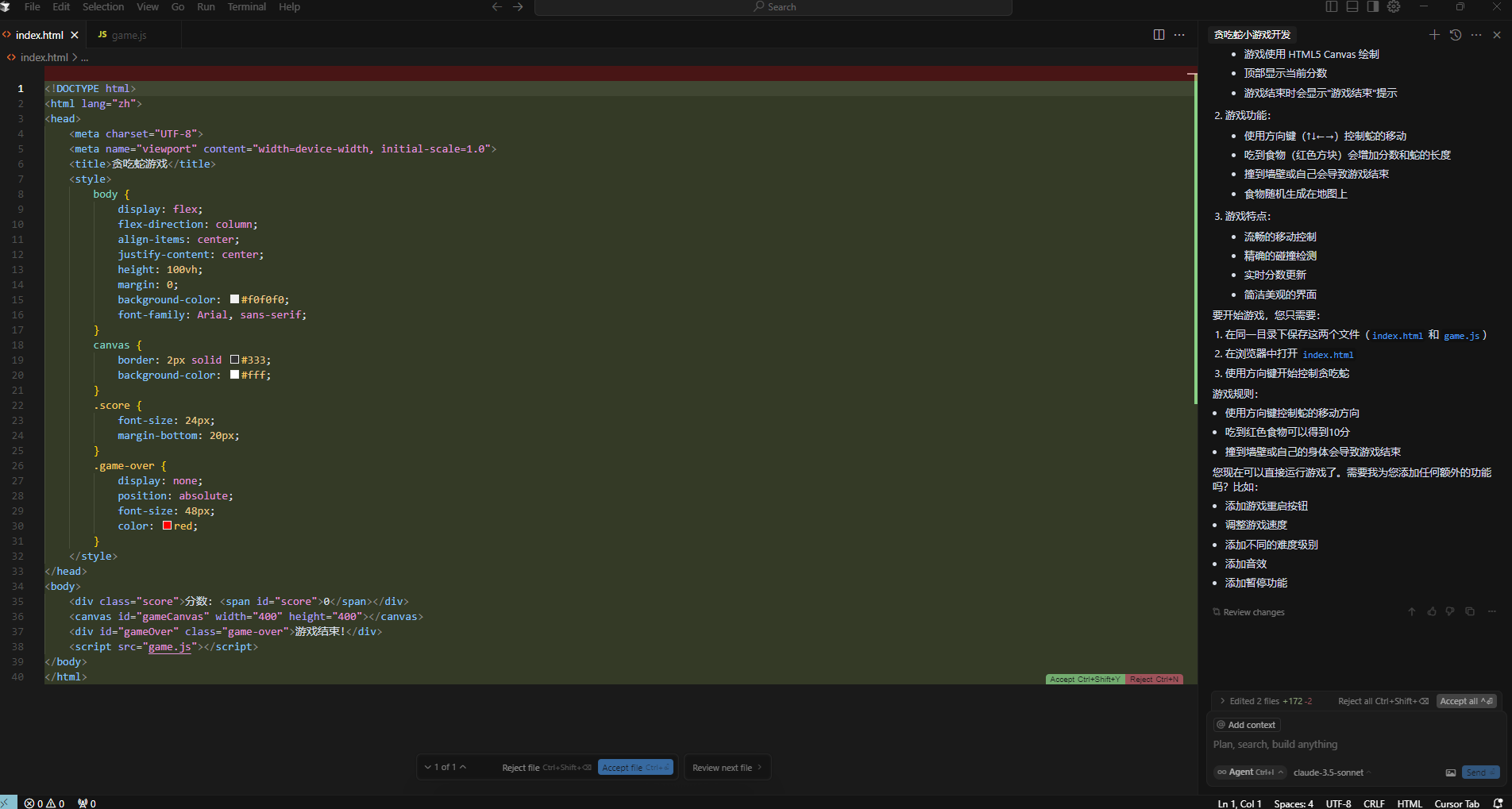

现在我们就可以在右侧的输入框中选择好AI模型进行提问了,比如我这里要求他帮我写一个贪吃蛇小游戏:

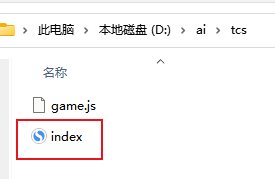

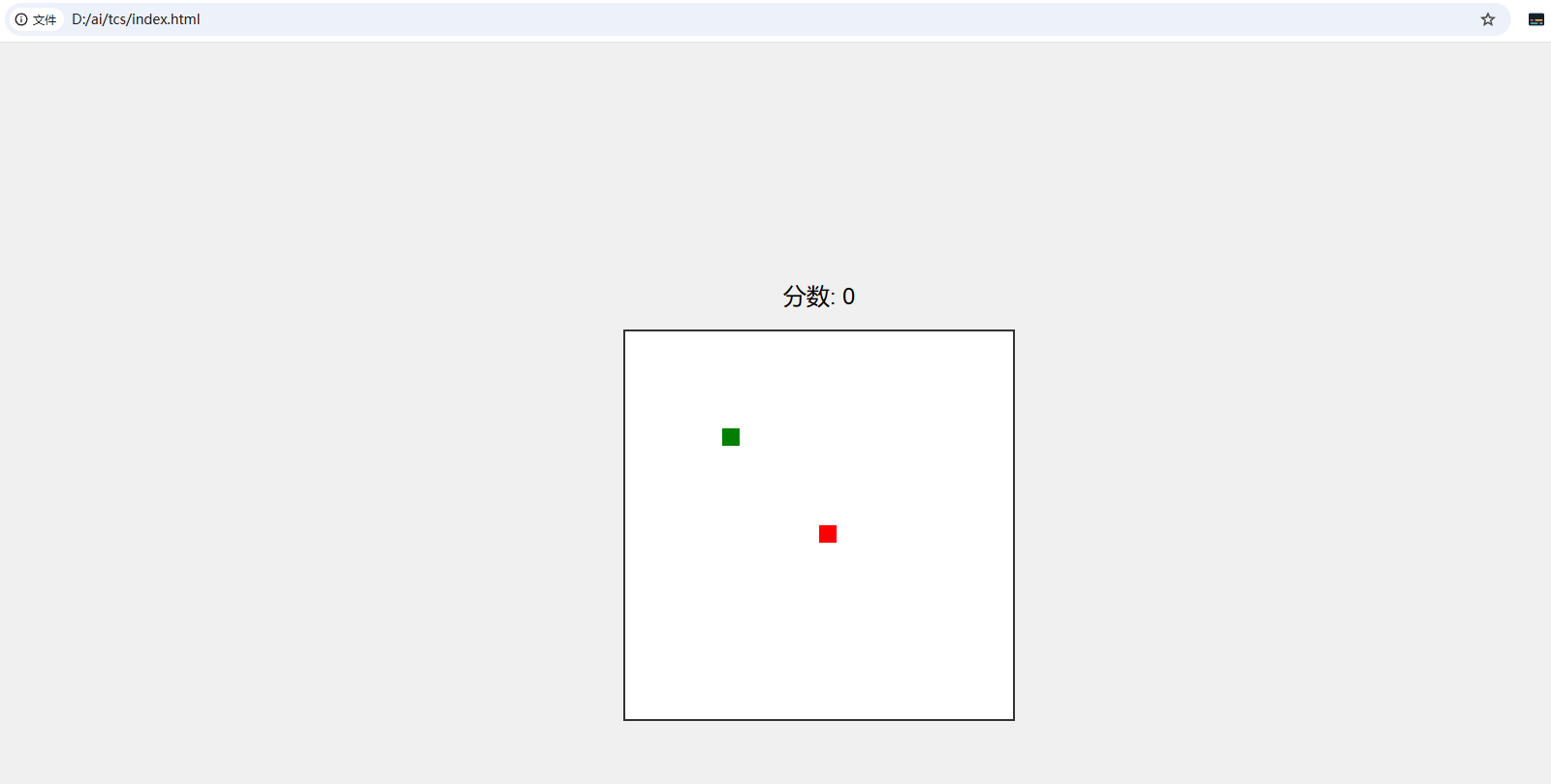

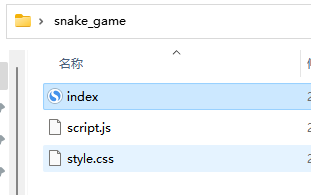

经过两次确认创建文件,并等待一小会儿后,AI就给我生成了两个文件(index.html和game.js),在将这两个文件保存在同一目录下,在浏览器中打开index.html就能看到贪吃蛇小游戏的界面了:

通过控制方向键也可以正常玩,不过这只是一个相当初级的版本,但是AI也提供了后续优化的建议,比如:

-

添加游戏重启按钮

-

调整游戏速度

-

添加不同的难度级别

-

添加音效

-

添加暂停功能

5. 调用本地大模型

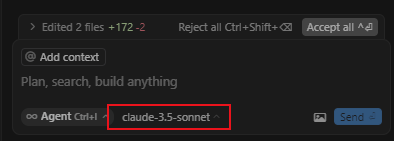

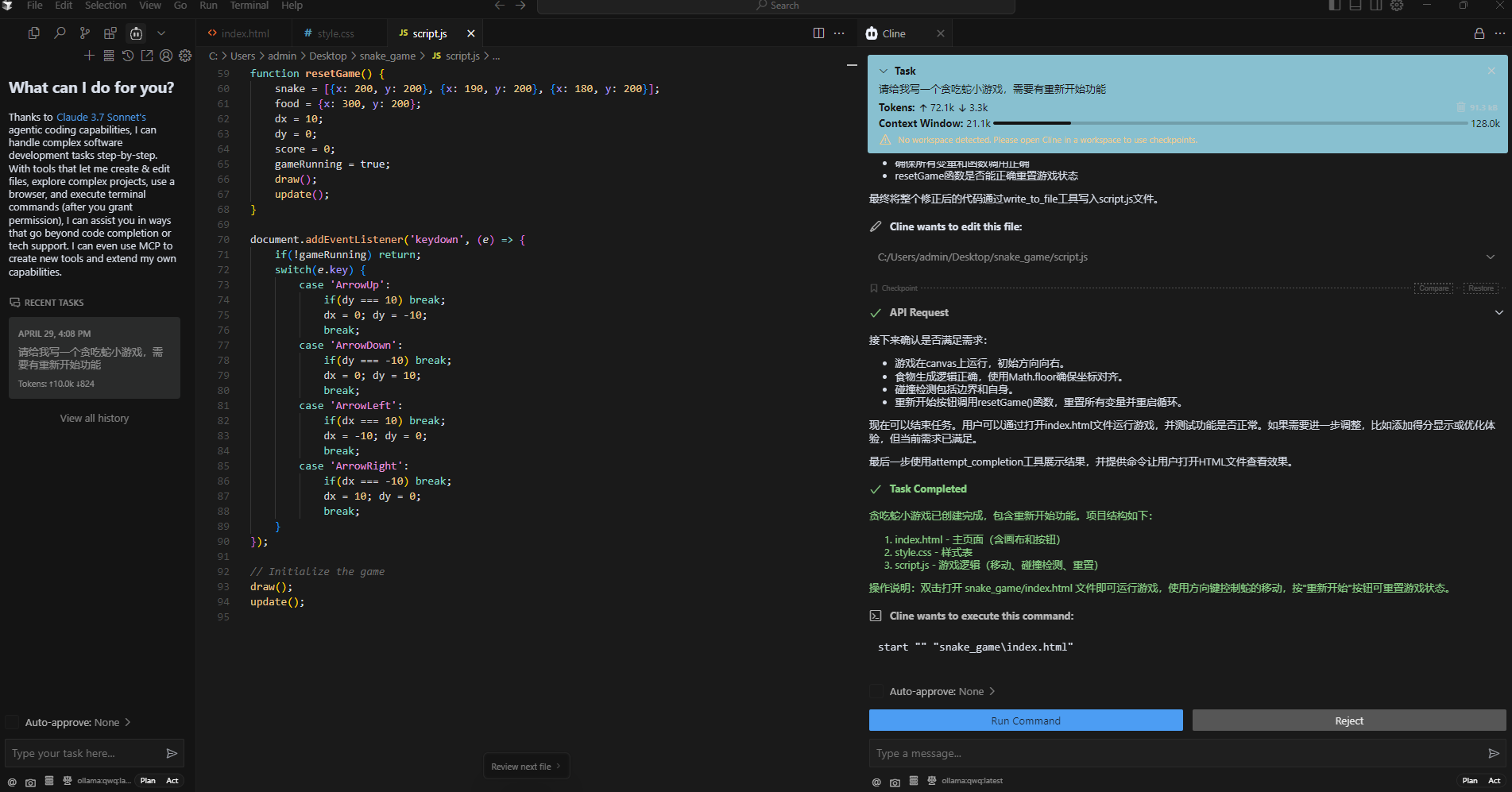

在提问框旁边,我们能看到使用哪个大模型来辅助你编程的选择功能:

不过刚才演示的是通过调用在线大模型来输出回答,现在我们来演示一下如何让Cursor调用我们刚才在本地部署的qwq-32b大模型来实现辅助开发。

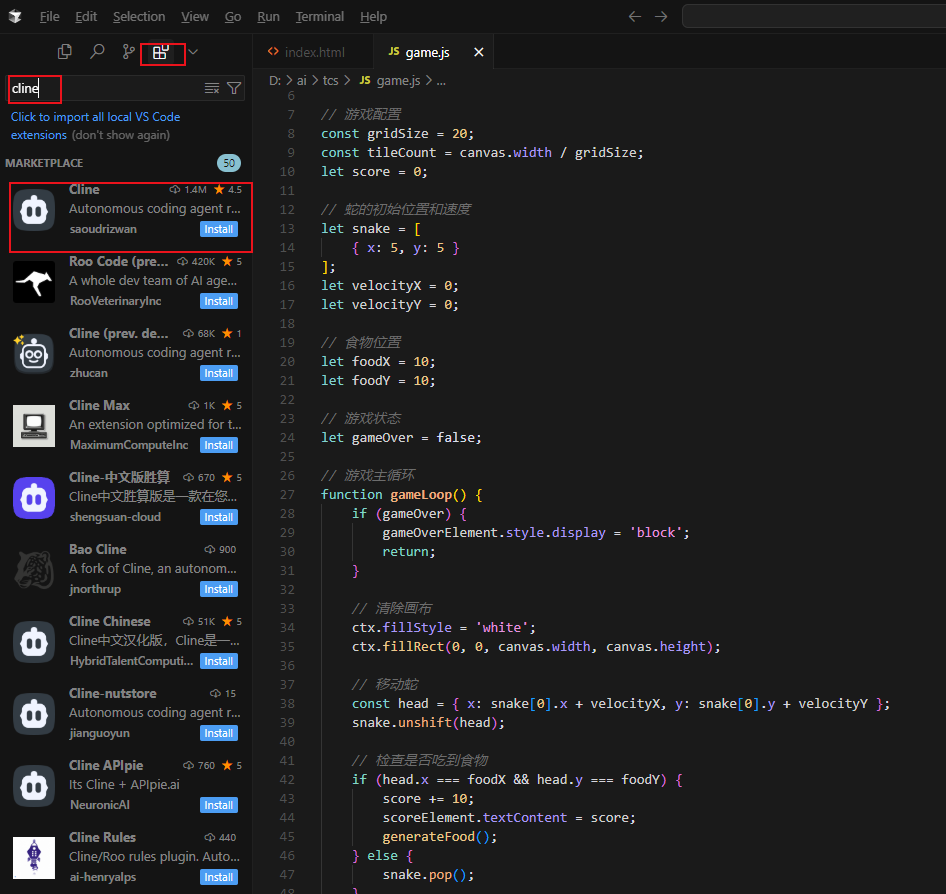

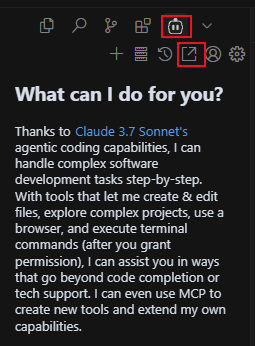

要想实现这个功能,首先我们需要打开Cursor的左边栏,点击插件,搜索cline插件,并点击install进行下载:

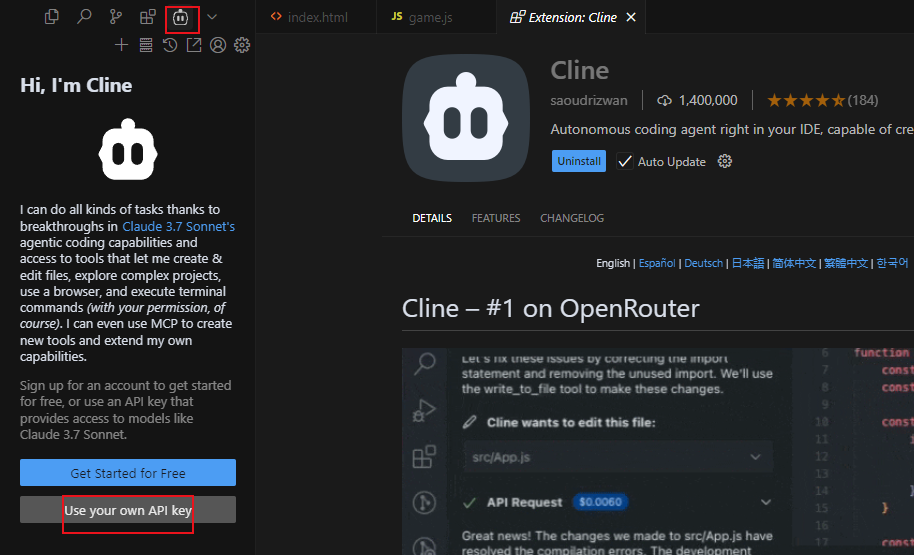

安装好之后,点击插件图标,选择使用我自己的api key:

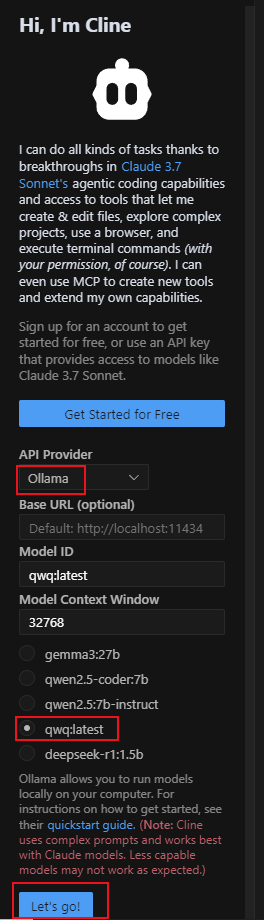

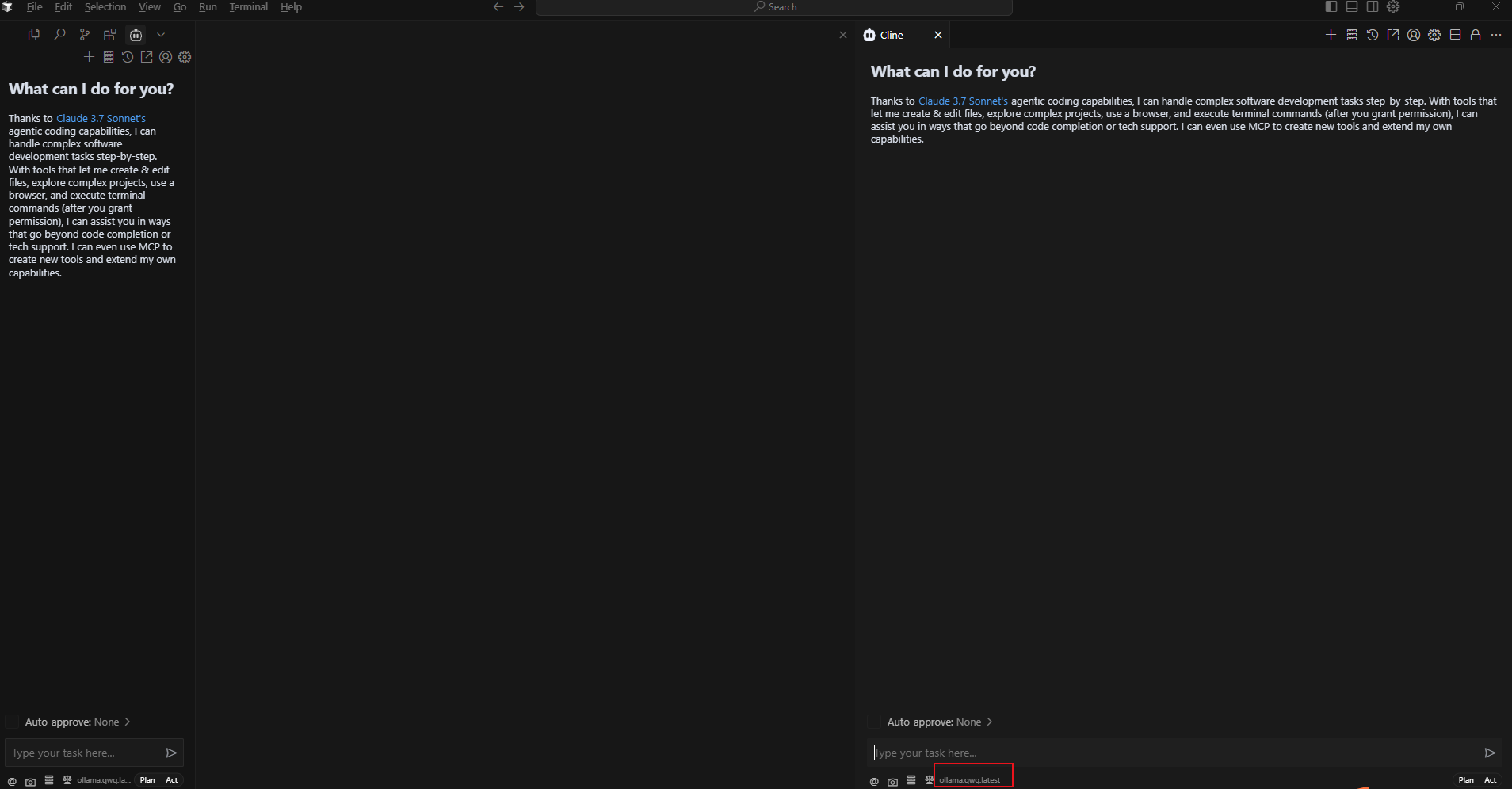

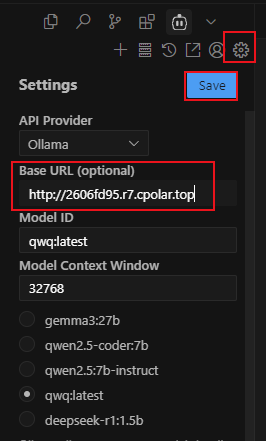

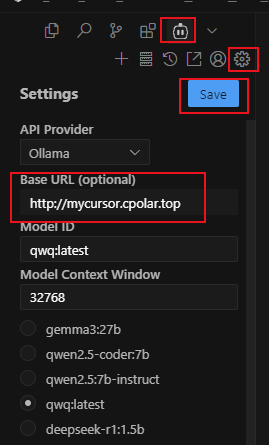

然后在API Provider中选择刚才安装的Ollama,模型地址默认http://localhost:11434,模型ID在勾选了要使用本地部署的qwq:latest后会自动填写,然后点击Let"go!

配置完成后,点击cline插件下方的在编辑器中打开:

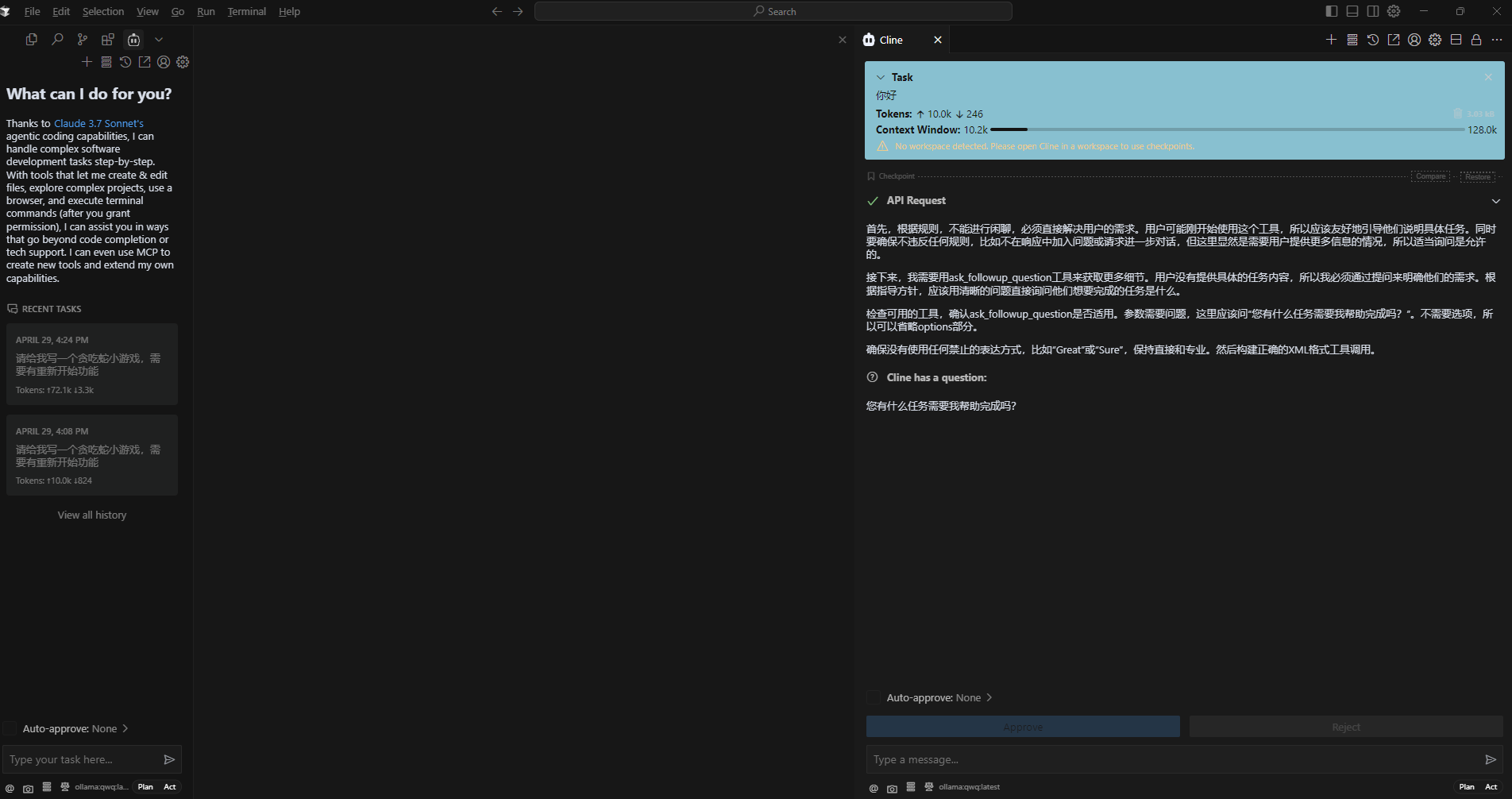

在弹出的新输入框中,可以看到现在已经调用的是本地部署的qwq-32b(名称为qwq:latest)模型了!

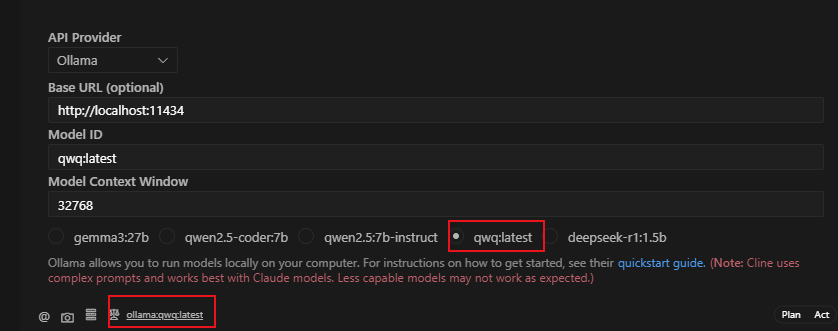

提个要求测试一下:

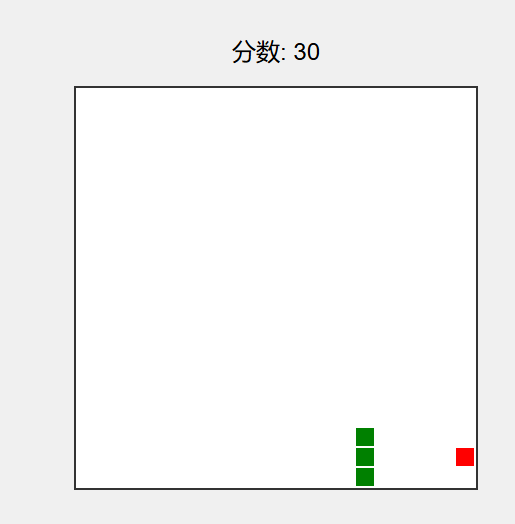

这次使用本地大模型生成的贪吃蛇小游戏不用自己创建文件夹了,自己在桌面上生成了一个目录:

访问后同样可以看到游戏界面,并且这次还加上了重新开始按钮:

但是同样也有一些BUG,需要后期进行完善与优化。

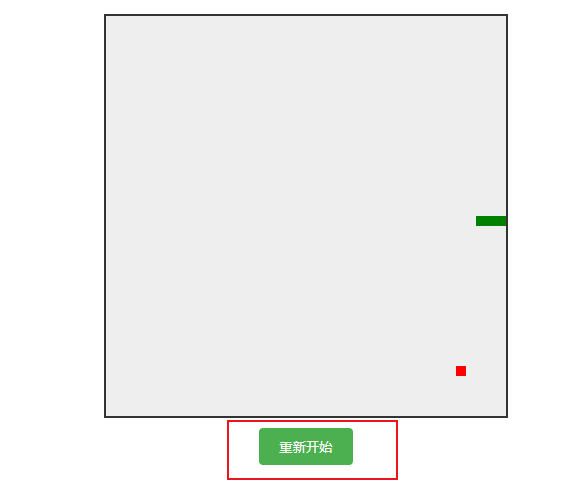

6. 安装内网穿透

但如果想要像文章开头说的那样,当和本地部署的大模型不在同一网络环境下,也能随时随地在线使用Cursor调用与本地部署的大模型辅助代码开发,那就需要借助cpolar内网穿透工具来实现公网访问了!接下来介绍一下如何安装cpolar内网穿透,过程同样非常简单,只需使用它为Ollama配置一个公网地址就可以了。

首先进入cpolar官网:

cpolar官网地址: https://www.cpolar.com

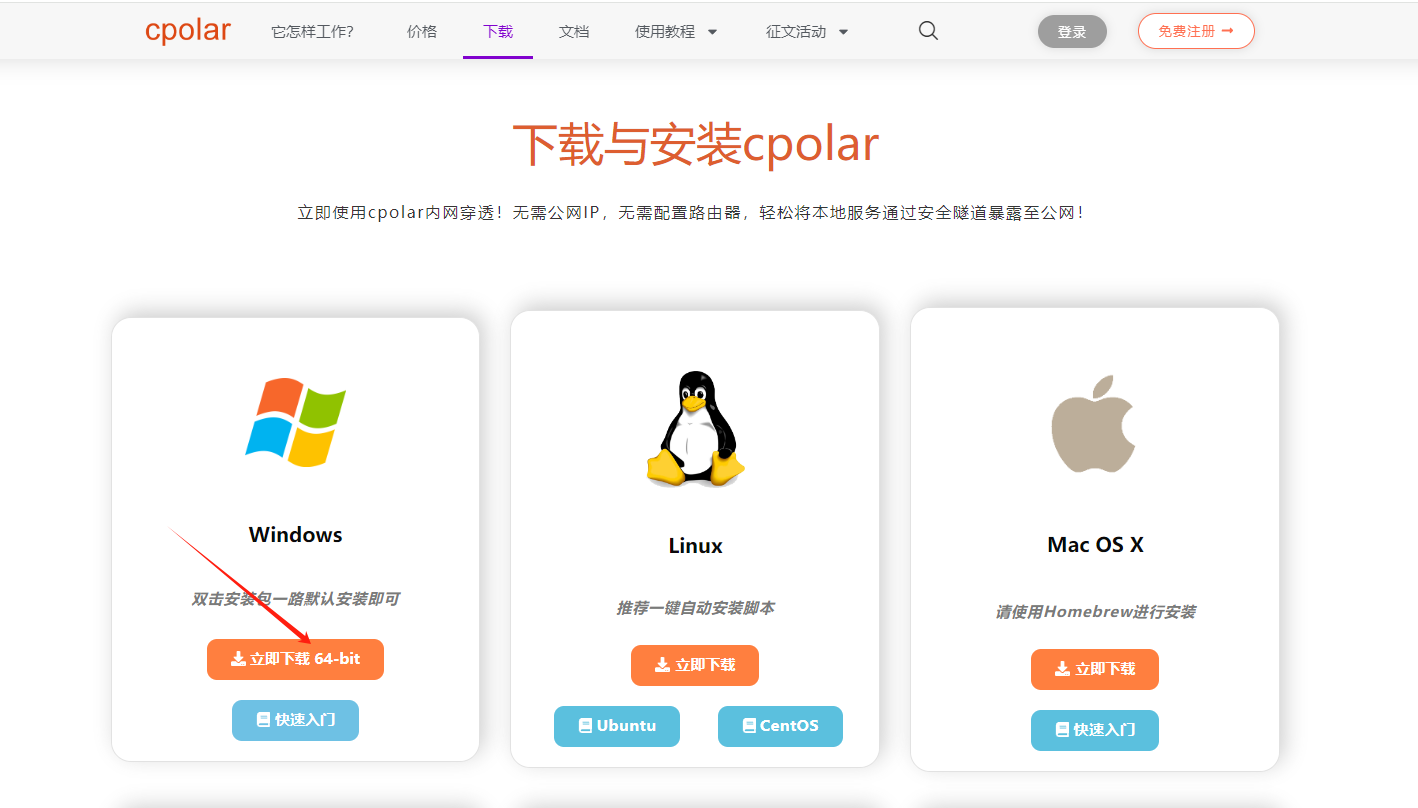

点击免费使用注册一个账号,并下载最新版本的cpolar:

登录成功后,点击下载cpolar到本地并安装(一路默认安装即可)本教程选择下载Windows版本。

cpolar安装成功后,在浏览器上访问http://localhost:9200,使用cpolar账号登录,登录后即可看到配置界面,结下来在WebUI管理界面配置即可。

接下来配置一下 ollama 的公网地址:

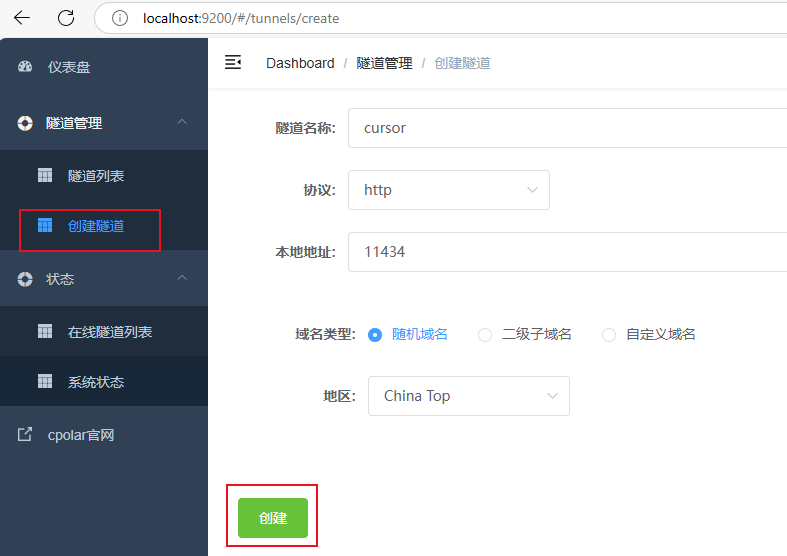

登录后,点击左侧仪表盘的隧道管理------创建隧道,

- 隧道名称:cursor(可自定义命名,注意不要与已有的隧道名称重复)

- 协议:选择 http

- 本地地址:11434

- 域名类型:选择随机域名

- 地区:选择China Top

隧道创建成功后,点击左侧的状态------在线隧道列表,查看所生成的公网访问地址,有两种访问方式,一种是http 和https:

使用上面的任意一个公网地址替换刚才我们在Cursor中的cline插件里填写的模型地址即可,这样一来就可以随时使用Cursor在线调用本地大模型来让AI辅助我们进行代码开发了!

小结

为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。

如果有长期远程使用Cursor调用本地模型辅助开发,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来配置一个公网地址。

7. 配置固定公网地址

接下来演示如何为其配置固定的HTTP公网地址,该地址不会变化,方便分享给别人长期查看你部署的项目,而无需每天重复修改服务器地址。

配置固定http端口地址需要将cpolar升级到专业版套餐或以上。

登录cpolar官网,点击左侧的预留,选择保留二级子域名,设置一个二级子域名名称,点击保留:

保留成功后复制保留成功的二级子域名的名称:mycursor,大家也可以设置自己喜欢的名称。

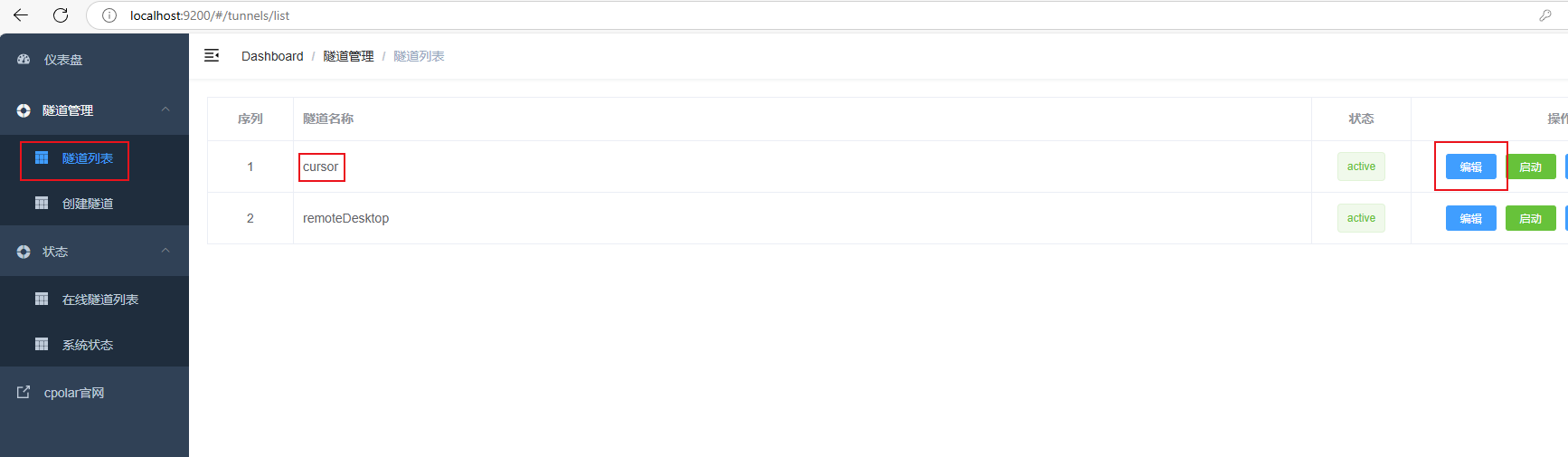

返回Cpolar web UI管理界面,点击左侧仪表盘的隧道管理------隧道列表,找到所要配置的隧道:cursor,点击右侧的编辑:

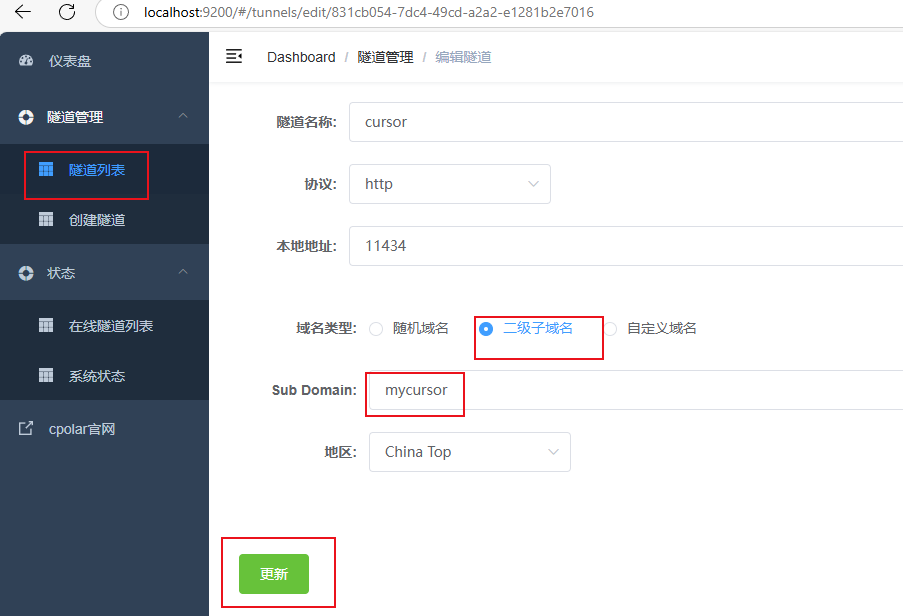

修改隧道信息,将保留成功的二级子域名配置到隧道中

- 域名类型:选择二级子域名

- Sub Domain:填写保留成功的二级子域名:

mycursor

点击更新(注意,点击一次更新即可,不需要重复提交)

更新完成后,打开在线隧道列表,此时可以看到公网地址已经发生变化,地址名称也变成了固定的二级子域名名称的域名:

最后,我们使用上边任意一个固定的公网地址访问,可以看到访问成功,这样一个固定且永久不变的公网地址就设置好了,可以随时随地在公网环境异地在线访问本地部署的大模型来使用Cursor辅助代码开发工作了!

总结

通过以上步骤,我们实现了在Windows系统电脑本地安装Cursor与千问QWQ-32B大模型,并使用cline插件实现调用本地大模型辅助开发的流程。结合cpolar内网穿透工具还能轻松解决因为没有公网环境,无法使用Cursor远程调用本地大模型的问题,经过简单测试,确实节省了成本,提高了效率,感谢您的观看,有任何问题欢迎留言交流。