title: 解锁FastAPI与MongoDB聚合管道的性能奥秘

date: 2025/05/20 20:24:47

updated: 2025/05/20 20:24:47

author: cmdragon

excerpt:

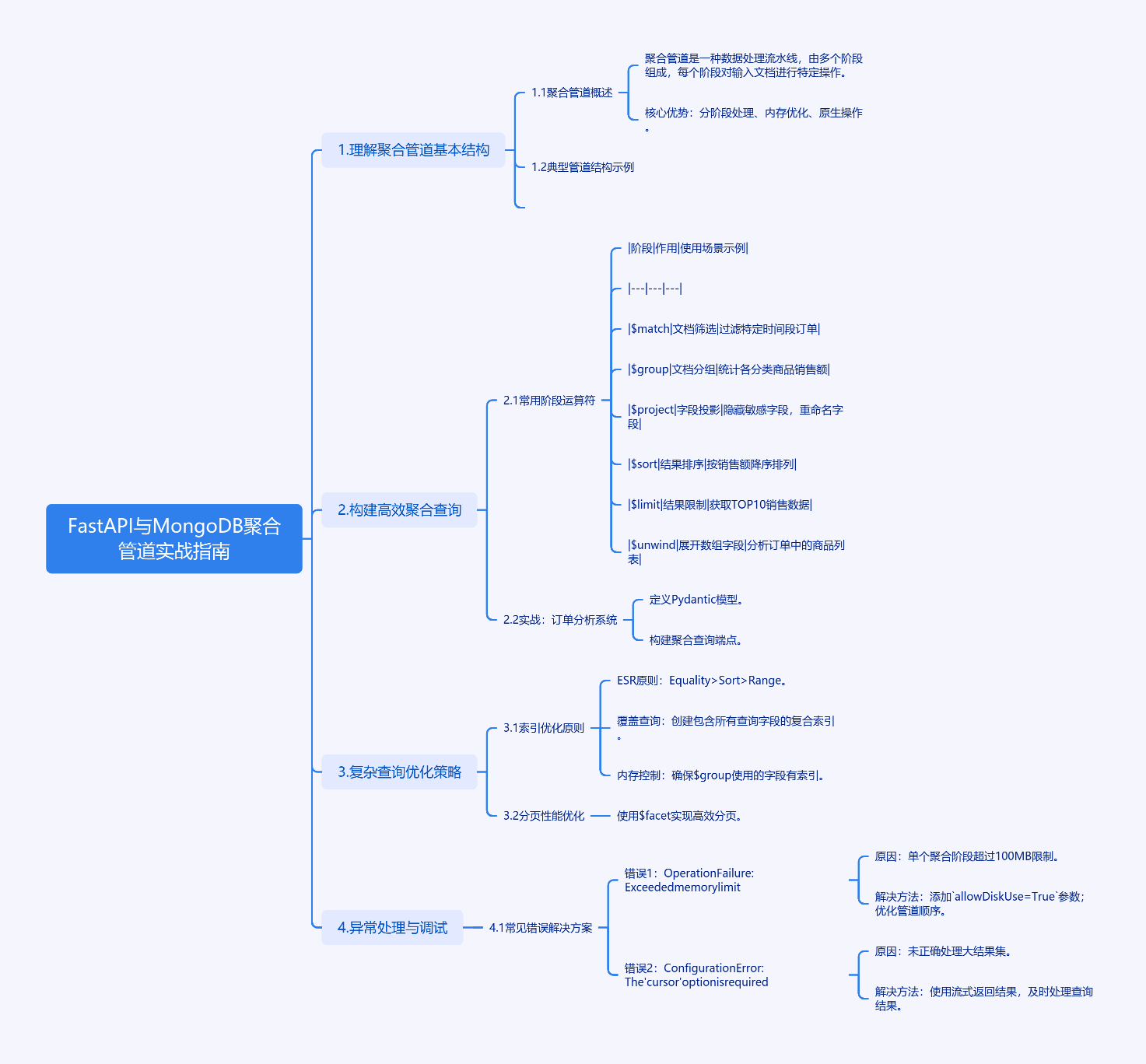

MongoDB聚合管道是一种分阶段处理数据的流水线,通过\(match、\)group等阶段对文档进行特定操作,具有内存优化和原生操作的优势。聚合查询常用阶段包括\(match、\)group、\(project等,适用于订单分析等场景。优化策略包括遵循ESR原则创建索引、使用\)facet实现高效分页。常见错误如内存限制和游标配置问题,可通过添加allowDiskUse=True和正确处理游标解决。进阶技巧包括使用$expr实现复杂逻辑、日期处理和条件投影。

categories:

- 后端开发

- FastAPI

tags:

- FastAPI

- MongoDB

- 聚合管道

- 查询优化

- 数据分析

- 异常处理

- 实战指南

扫描二维码

关注或者微信搜一搜:编程智域 前端至全栈交流与成长

探索数千个预构建的 AI 应用,开启你的下一个伟大创意:https://tools.cmdragon.cn/

1. FastAPI与MongoDB聚合管道实战指南

1.1 理解聚合管道基本结构

MongoDB聚合管道(Aggregation Pipeline)是一种数据处理流水线,由多个阶段(Stage)组成,每个阶段对输入文档进行特定操作。其核心优势体现在:

- 分阶段处理 :类似工厂流水线,数据依次通过\(match、\)group等处理阶段

- 内存优化:单个阶段处理不超过100MB,自动优化执行顺序

- 原生操作:直接使用BSON类型,避免数据转换开销

典型管道结构示例:

python

[

{"$match": {"status": "completed"}},

{"$group": {"_id": "$category", "total": {"$sum": "$amount"}}},

{"$sort": {"total": -1}}

]1.2 构建高效聚合查询

1.2.1 常用阶段运算符

| 阶段 | 作用 | 使用场景示例 |

|---|---|---|

| $match | 文档筛选 | 过滤特定时间段订单 |

| $group | 文档分组 | 统计各分类商品销售额 |

| $project | 字段投影 | 隐藏敏感字段,重命名字段 |

| $sort | 结果排序 | 按销售额降序排列 |

| $limit | 结果限制 | 获取TOP10销售数据 |

| $unwind | 展开数组字段 | 分析订单中的商品列表 |

1.2.2 实战:订单分析系统

定义Pydantic模型:

python

from pydantic import BaseModel

from datetime import datetime

class Order(BaseModel):

order_id: str

user_id: int

items: list

status: str

amount: float

created_at: datetime构建聚合查询端点:

python

from fastapi import APIRouter

from motor.motor_asyncio import AsyncIOMotorClient

router = APIRouter()

@router.get("/orders/stats")

async def get_order_stats():

pipeline = [

{"$match": {"status": "completed"}},

{"$group": {

"_id": {"year": {"$year": "$created_at"}, "month": {"$month": "$created_at"}},

"total_orders": {"$sum": 1},

"total_amount": {"$sum": "$amount"}

}},

{"$sort": {"_id.year": 1, "_id.month": 1}}

]

async with AsyncIOMotorClient("mongodb://localhost:27017") as client:

cursor = client.mydb.orders.aggregate(pipeline)

return await cursor.to_list(length=1000)1.3 复杂查询优化策略

1.3.1 索引优化原则

- ESR原则:Equality > Sort > Range

- 覆盖查询:创建包含所有查询字段的复合索引

- 内存控制:确保$group使用的字段有索引

创建索引示例:

python

# 在FastAPI启动时创建索引

@app.on_event("startup")

async def create_indexes():

db = AsyncIOMotorClient().mydb

await db.orders.create_index([("status", 1), ("created_at", -1)])

await db.orders.create_index([("user_id", 1), ("amount", -1)])1.3.2 分页性能优化

使用$facet实现高效分页:

python

pipeline = [

{"$match": {"status": "completed"}},

{"$facet": {

"metadata": [{"$count": "total"}],

"data": [

{"$skip": 100},

{"$limit": 20},

{"$project": {"_id": 0, "order_id": 1, "amount": 1}}

]

}}

]1.4 异常处理与调试

1.4.1 常见错误解决方案

错误1:OperationFailure: Exceeded memory limit

- 原因:单个聚合阶段超过100MB限制

- 解决方法:

- 添加

allowDiskUse=True参数 - 优化管道顺序,尽早使用\(match和\)project

- 添加

python

await db.orders.aggregate(pipeline, allowDiskUse=True).to_list(None)错误2:ConfigurationError: The 'cursor' option is required

- 原因:未正确处理大结果集

- 解决方法:使用游标方式获取数据

python

cursor = db.orders.aggregate(pipeline, batchSize=1000)

async for doc in cursor:

process(doc)1.5 实战练习

Quiz 1:以下聚合管道有什么潜在性能问题?

python

[

{"$project": {"category": 1}},

{"$match": {"category": {"$in": ["electronics", "books"]}}},

{"$group": {"_id": "$category", "count": {"$sum": 1}}}

]- A. 缺少索引

- B. 阶段顺序错误

- C. 内存使用过高

- D. 字段投影错误

正确答案 :B

解析 :应该将\(match阶段放在最前面,减少后续处理的数据量。优化后的顺序应该是先\)match再$project。

Quiz 2:如何优化以下查询的索引策略?

python

{"$match": {"status": "shipped", "created_at": {"$gte": "2023-01-01"}}}

{"$sort": {"amount": -1}}- A. 创建(status, created_at)索引

- B. 创建(status, amount)索引

- C. 创建(status, created_at, amount)索引

- D. 分别创建status和created_at索引

正确答案 :C

解析:根据ESR原则,等值查询字段(status)在前,范围字段(created_at)次之,排序字段(amount)在最后。

1.6 运行环境配置

安装依赖:

bash

pip install fastapi==0.68.0 motor==3.3.2 pydantic==1.10.7 python-multipart==0.0.5启动服务:

bash

uvicorn main:app --reload --port 8000测试聚合端点:

bash

curl http://localhost:8000/orders/stats1.7 进阶技巧

- 表达式优化:使用$expr实现复杂逻辑

python

{"$match": {

"$expr": {

"$and": [

{"$gt": ["$amount", 100]},

{"$lt": ["$amount", 500]}

]

}

}}- 日期处理:利用日期运算符实现时间分析

python

{"$group": {

"_id": {

"year": {"$year": "$created_at"},

"week": {"$week": "$created_at"}

},

"count": {"$sum": 1}

}}- 条件投影:使用$cond实现字段条件赋值

python

{"$project": {

"discount_flag": {

"$cond": {"if": {"$gt": ["$amount", 200]}, "then": "A", "else": "B"}

}

}}通过本文介绍的聚合管道设计方法和优化策略,开发者可以在FastAPI中高效实现复杂的MongoDB数据分析需求。建议结合MongoDB

Compass的Explain功能验证查询性能,持续优化管道设计。

余下文章内容请点击跳转至 个人博客页面 或者 扫码关注或者微信搜一搜:编程智域 前端至全栈交流与成长,阅读完整的文章:解锁FastAPI与MongoDB聚合管道的性能奥秘 | cmdragon's Blog

往期文章归档:

- 异步之舞:Motor驱动与MongoDB的CRUD交响曲 | cmdragon's Blog

- 异步之舞:FastAPI与MongoDB的深度协奏 | cmdragon's Blog

- 数据库迁移的艺术:FastAPI生产环境中的灰度发布与回滚策略 | cmdragon's Blog

- 数据库迁移的艺术:团队协作中的冲突预防与解决之道 | cmdragon's Blog

- 驾驭FastAPI多数据库:从读写分离到跨库事务的艺术 | cmdragon's Blog

- 数据库事务隔离与Alembic数据恢复的实战艺术 | cmdragon's Blog

- FastAPI与Alembic:数据库迁移的隐秘艺术 | cmdragon's Blog

- 飞行中的引擎更换:生产环境数据库迁移的艺术与科学 | cmdragon's Blog

- Alembic迁移脚本冲突的智能检测与优雅合并之道 | cmdragon's Blog

- 多数据库迁移的艺术:Alembic在复杂环境中的精妙应用 | cmdragon's Blog

- 数据库事务回滚:FastAPI中的存档与读档大法 | cmdragon's Blog

- Alembic迁移脚本:让数据库变身时间旅行者 | cmdragon's Blog

- 数据库连接池:从银行柜台到代码世界的奇妙旅程 | cmdragon's Blog

- 点赞背后的技术大冒险:分布式事务与SAGA模式 | cmdragon's Blog

- N+1查询:数据库性能的隐形杀手与终极拯救指南 | cmdragon's Blog

- FastAPI与Tortoise-ORM开发的神奇之旅 | cmdragon's Blog

- DDD分层设计与异步职责划分:让你的代码不再"异步"混乱 | cmdragon's Blog

- 异步数据库事务锁:电商库存扣减的防超卖秘籍 | cmdragon's Blog

- FastAPI中的复杂查询与原子更新指南 | cmdragon's Blog

- 深入解析Tortoise-ORM关系型字段与异步查询 | cmdragon's Blog

- FastAPI与Tortoise-ORM模型配置及aerich迁移工具 | cmdragon's Blog

- 异步IO与Tortoise-ORM的数据库 | cmdragon's Blog

- FastAPI数据库连接池配置与监控 | cmdragon's Blog

- 分布式事务在点赞功能中的实现 | cmdragon's Blog

- Tortoise-ORM级联查询与预加载性能优化 | cmdragon's Blog

- 使用Tortoise-ORM和FastAPI构建评论系统 | cmdragon's Blog

- 分层架构在博客评论功能中的应用与实现 | cmdragon's Blog

- 深入解析事务基础与原子操作原理 | cmdragon's Blog

- 掌握Tortoise-ORM高级异步查询技巧 | cmdragon's Blog

- FastAPI与Tortoise-ORM实现关系型数据库关联 | cmdragon's Blog

- Tortoise-ORM与FastAPI集成:异步模型定义与实践 | cmdragon's Blog

- 异步编程与Tortoise-ORM框架 | cmdragon's Blog

- FastAPI数据库集成与事务管理 | cmdragon's Blog

- FastAPI与SQLAlchemy数据库集成 | cmdragon's Blog

- XML Sitemap