1. 技术概述

- Spring AI:Spring 官方推出的 AI 框架,简化大模型集成(如文本生成、问答系统),支持多种 LLM 提供商。

- Olama:开源的本地 LLM 推理引擎,支持量化模型部署,提供 REST API 和 CLI 工具,优化本地运行效率。

- 开源大模型:如 Llama 2、Mistral、Zephyr 等,可通过 Olama 在本地环境部署。

- 参考文档:文档 -- Ollama 中文文档|Ollama官方文档

2. 环境准备

系统要求

- 操作系统:Linux/macOS/Windows(推荐 Linux)

- 硬件:至少 16GB RAM(推荐 32GB+),GPU 支持更佳(需兼容 CUDA 或 Metal)

- 软件:Docker(推荐)或直接安装 Olama 二进制文件

安装 ollama

方式 1:Docker 安装

bash

docker pull olamaai/olama:latest方式 2:直接安装(Linux/macOS)

bash

curl https://get.olama.ai/install.sh | bash方式3:windos环境下安装(我使用的这个)

-

官方地址下载:Download Ollama on Windows

bash

https://ollama.com/download

-

我直接使用迅雷下载了,

-

-

开始安装了

安装完成之后ollama会自己启动,我们打开命令窗口输入ollama验证一下是否安装成功了

3.挑选ollama 支持的AI大模型

这个页面挑选一个自己喜欢的AI模型

我选择这个

把页面往下滑动,这底下有对应模型的下载命令,然后复制粘贴到命令窗口里面去即可

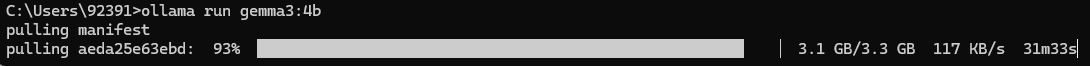

开始下载了

慢慢等待下载走完吧,最后一点点下载的速度很慢,只能慢慢等待

通常情况下安装完成之后可以直接在控制台进行对话了

4.ollama命令

以下是 ollama的核心命令行工具(ollama)的详细说明,按功能分类整理成表格形式:

一、模型管理命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

ollama pull <模型名> |

从远程仓库下载模型到本地(支持别名,如llama2) |

ollama pull llama2:7b |

ollama push <模型名> |

将本地模型推送到远程仓库(需配置权限) | ollama push my-custom-model:v1 |

ollama list |

列出本地已下载的所有模型及其元数据(大小、创建时间等) | ollama list |

ollama rm <模型名> |

删除本地模型(释放磁盘空间) | ollama rm llama2:7b |

ollama show <模型名> |

显示模型详细信息(参数配置、量化级别等) | ollama show mistral:latest |

二、服务控制命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

ollama serve |

启动 Olama 服务(默认监听localhost:3300) |

ollama serve --host 0.0.0.0 --port 8080 |

ollama stop |

停止正在运行的 Olama 服务 | ollama stop |

ollama status |

检查 Olama 服务运行状态 | ollama status |

三、交互命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

ollama chat <模型名> |

启动与指定模型的交互式对话(支持多轮) | ollama chat llama2:7b-chat |

ollama run <模型名> [提示词] |

使用指定模型生成文本(一次性调用) | ollama run llama2 "写一首关于春天的诗" |

四、高级功能命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

ollama create <模型名> -f <配置文件> |

基于配置文件创建自定义模型(如量化、微调) | ollama create my-model -f model-config.yaml |

ollama copy <源模型> <目标模型> |

复制现有模型(用于创建变体或备份) | ollama copy llama2:7b llama2:7b-q4_k_m |

ollama diff <模型1> <模型2> |

比较两个模型的差异(参数、文件等) | ollama diff llama2:7b llama2:13b |

ollama inspect <模型名> |

查看模型内部结构(层、参数等技术细节) | ollama inspect llama2:7b |

五、全局选项(适用于所有命令)

| 选项 | 功能描述 | 示例 |

|---|---|---|

--model-path <路径> |

指定模型存储路径(默认~/.ollama) |

ollama list --model-path /data/models |

--verbose |

启用详细日志输出(调试用) | ollama pull llama2:7b --verbose |

--config <配置文件> |

指定自定义配置文件(覆盖默认设置) | ollama serve --config /etc/ollama/config.yaml |

--timeout <秒数> |

设置命令超时时间(默认 600 秒) | ollama pull llama2:7b --timeout 1200 |