引言

Claude Code是Anthropic公司最近推出的强大AI编程工具,原生设计为仅支持Anthropic的Claude系列模型。然而,国内直接连接Anthropic的Claude系列模型存在诸多限制,且随着AI应用场景的多样化,开发者往往希望灵活访问不同提供商的语言模型。本文将详细介绍Claude Code原生连接的局限性,以及如何通过Claude Code Proxy这一中间层解决方案,使Claude Code能够连接到OpenAI、Azure OpenAI、本地模型(如Ollama)等任何OpenAI兼容API的语言模型,从而大大扩展其使用场景和灵活性。特别地,我将通过我最常用的API代理商OpenRouter,展示如何连接多种非Anthropic模型。

Claude Code的原生连接局限性

Claude Code无法直接连接OpenRouter等OpenAI兼容API的具体原因如下:

-

协议与接口不兼容

- Claude Code遵循Anthropic API规范,默认向

${ANTHROPIC_BASE_URL}/v1/messages发送聊天请求 - 而OpenRouter兼容的是OpenAI规范,只暴露诸如

/v1/chat/completions等端点 - 二者"说话的语言"不同,直接对接会被服务器拒绝

- Claude Code遵循Anthropic API规范,默认向

-

Base URL拼接导致路径错误

- 用户将

ANTHROPIC_BASE_URL设为https://openrouter.ai/api/v1时,Claude Code会自动在后面再拼接/v1/messages,结果变成: openrouter.ai/api/v1/v1/m... - 该重复路径在OpenRouter上根本不存在,直接返回405错误

- 用户将

-

认证方式与环境变量不一致

- Claude Code REPL(交互式)只接受真正的Anthropic Key,并必须通过

/login完成OAuth - 而非交互式模式(

-p/--print)虽然能读ANTHROPIC_API_KEY或ANTHROPIC_AUTH_TOKEN,但即便设置任意字符串,也只是在客户端绕过本地校验,仍无法匹配OpenRouter的Bearer Token逻辑

- Claude Code REPL(交互式)只接受真正的Anthropic Key,并必须通过

-

缺乏协议转换层(Proxy)

- 由于上述接口和协议不匹配,需要引入一个中间代理,将Anthropic的

/v1/messages请求转成OpenAI的/v1/chat/completions,并正确转发认证头 - 没有这层转换,直接打到OpenRouter上就必然失败

- 由于上述接口和协议不匹配,需要引入一个中间代理,将Anthropic的

这些技术障碍使得直接修改环境变量的方法(如设置ANTHROPIC_BASE_URL为OpenRouter地址)无法成功,必须通过专门设计的代理服务来解决。

Claude Code Proxy:连接多模型的桥梁

Claude Code Proxy简介

Claude Code Proxy是一个全新的开源项目,于2025年6月初刚刚发起,专门设计用于解决Claude Code与OpenAI兼容API之间的互操作性问题。作为一个仅有一个多月历史的新兴项目,它代表了社区对Claude Code功能扩展的最新探索,旨在填补官方工具的功能空白,扩展Claude Code的应用范围。

作为一个极新的开源项目,Claude Code Proxy具有以下特点:

- 社区驱动:由AI开发者社区维护和更新,处于活跃开发阶段

- MIT许可证:采用宽松的开源许可,允许自由使用、修改和分发

- 快速迭代:作为新项目,正在快速迭代和完善功能

- 透明开发:代码完全开源,开发过程透明,可审计

- 灵活部署:支持本地部署和容器化,适合各种使用场景

项目地址:github.com/fuergaosi23...

核心功能与优势

尽管是新项目,Claude Code Proxy已经实现了多项核心功能:

- API格式转换:自动将Anthropic API请求转换为OpenAI格式,并将响应转回Anthropic格式

- 完全Claude API兼容 :支持完整的

/v1/messages端点 - 多提供商支持:支持OpenAI、Azure OpenAI、本地模型及任何OpenAI兼容API

- 智能模型映射:通过环境变量将Claude模型名称映射到目标提供商的模型

- 函数调用支持:完整支持工具使用功能并进行适当转换

- 流式响应:支持实时SSE流式传输

- 图像支持:支持Base64编码的图像输入

- 全面错误处理:提供详细的错误日志和处理机制

部署Claude Code Proxy

安装与配置

1. 安装依赖

项目Clone到本地后,直接运行pip install -r requirements.txt即可安装依赖。

2. 配置环境变量

bash

cp .env.example .env

# 编辑.env并添加您的API配置主要配置项包括:

-

必需配置:

OPENAI_API_KEY:目标提供商的API密钥,例如:your-openrouter-api-key

-

安全配置:

ANTHROPIC_API_KEY:客户端验证的预期Anthropic API密钥- 如果设置,客户端必须提供完全匹配的API密钥才能访问代理

- 如果未设置,将接受任何API密钥

-

模型映射配置:

BIG_MODEL:Claude opus请求的映射模型(例如:anthropic/claude-sonnet-4)MIDDLE_MODEL:Claude sonnet请求的映射模型(例如:anthropic/claude-sonnet-4)SMALL_MODEL:Claude haiku请求的映射模型(例如:anthropic/claude-3.5-haiku:beta)

-

API端点配置:

OPENAI_BASE_URL:API基础URL(例如:https://openrouter.ai/api/v1)

-

服务器设置:

HOST:服务器主机(默认:0.0.0.0)PORT:服务器端口(默认:8082)LOG_LEVEL:日志级别(默认:WARNING)

3. 启动代理服务器

bash

# 直接运行

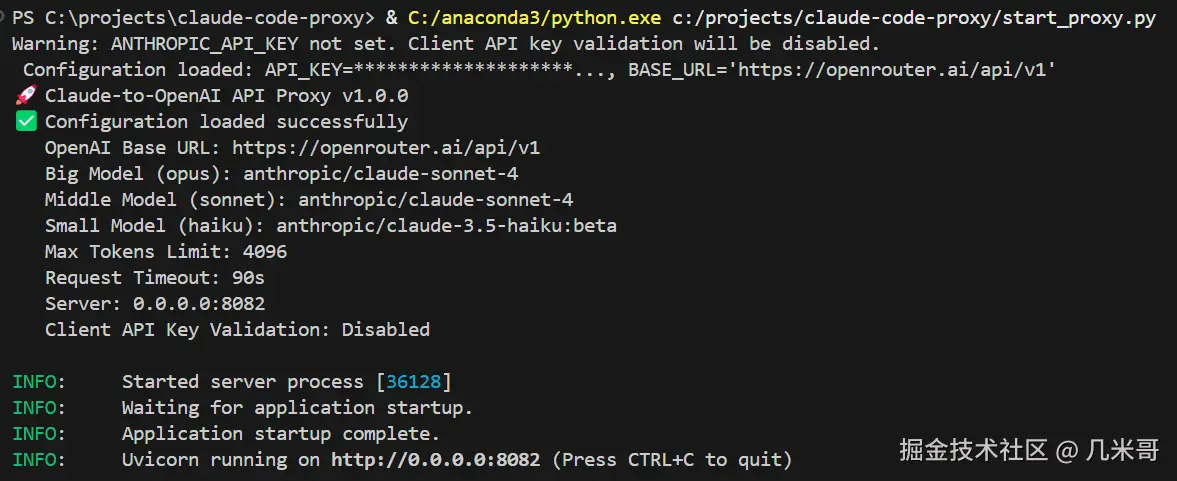

python start_proxy.py代理启动成功后,会显示类似如下的信息:

与Claude Code集成

启动代理服务器后,配置Claude Code使用该代理:

bash

# 如果代理中未设置ANTHROPIC_API_KEY

ANTHROPIC_BASE_URL=http://localhost:8082

ANTHROPIC_AUTH_TOKEN="your openrouter api key"

ANTHROPIC_API_KEY="any-value"

claude

# 如果代理中设置了ANTHROPIC_API_KEY

ANTHROPIC_BASE_URL=http://localhost:8082

ANTHROPIC_AUTH_TOKEN="your openrouter api key"

ANTHROPIC_API_KEY="exact-matching-key"

claude也可以将这些设置添加到环境变量中,以便持久化使用。

连接OpenRouter:访问多种模型的示例

OpenRouter是一个统一的API网关,允许通过单一接口访问多种AI模型。通过Claude Code Proxy,我们可以让Claude Code连接到OpenRouter,从而访问其支持的所有模型。

配置Claude Code Proxy连接OpenRouter

在Claude Code Proxy目录下编辑.env文件,设置以下内容:

ini

OPENAI_API_KEY="your-openrouter-api-key"

OPENAI_BASE_URL="https://openrouter.ai/api/v1"

BIG_MODEL="anthropic/claude-sonnet-4"

MIDDLE_MODEL="anthropic/claude-sonnet-4"

SMALL_MODEL="anthropic/claude-3.5-haiku:beta"这样配置后,Claude Code Proxy会将请求转发到OpenRouter,并根据模型映射规则选择适当的模型。

使用Claude Code访问OpenRouter上的不同模型

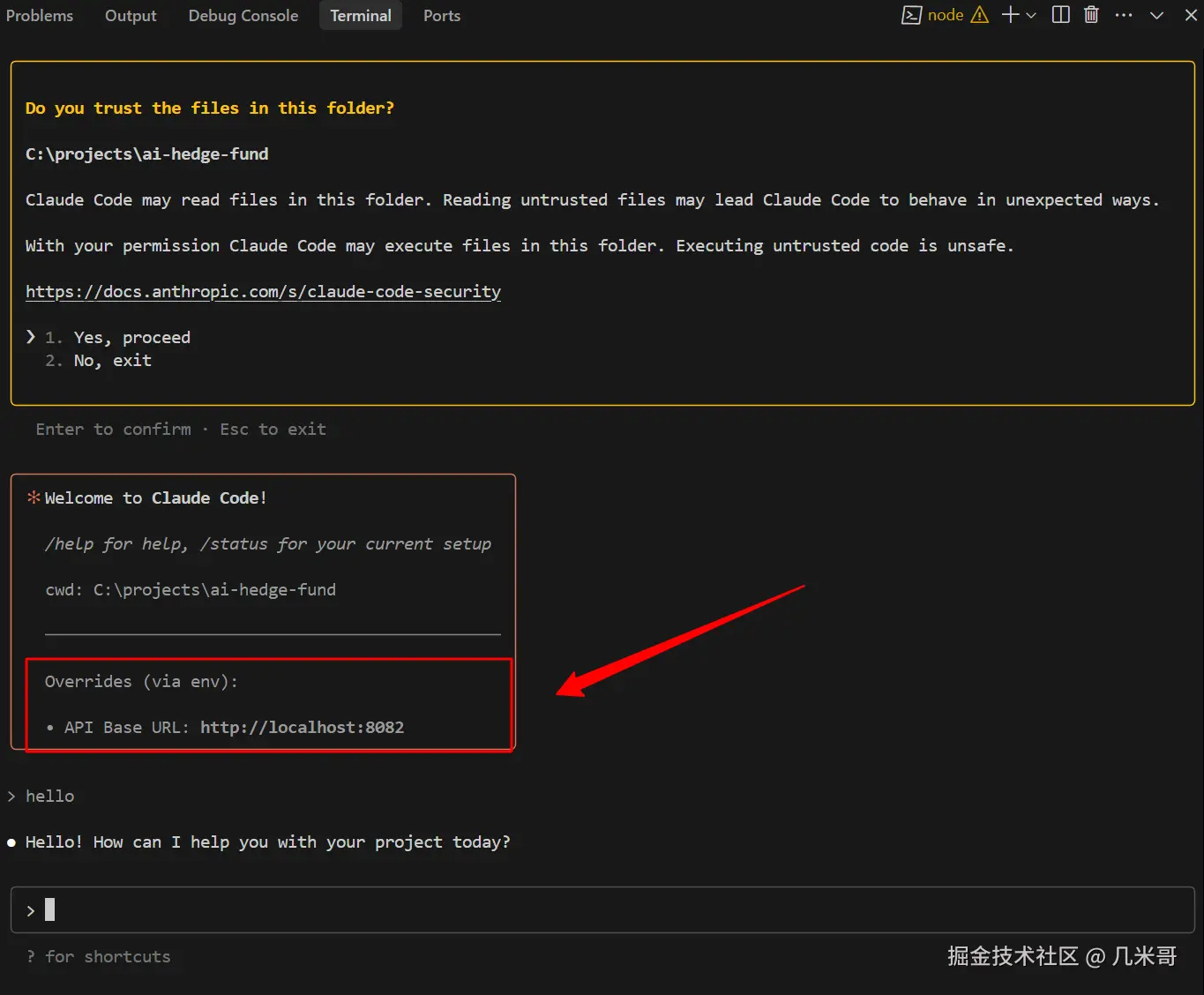

启动代理服务器后,您可以通过Claude Code使用OpenRouter上的各种模型,只需按照下面所示设置环境变量即可:

bash

# 设置环境变量指向代理

export ANTHROPIC_BASE_URL="http://localhost:8082"

export ANTHROPIC_AUTH_TOKEN="your openrouter api key"

# 启动Claude Code

claude如下图所示,Claude Code已经通过本地代理成功连接到OpenRouter上的模型:

在Claude Code中,它会根据您请求的Claude模型自动映射到OpenRouter上的相应模型:

- 当您使用

claude-3-opus时,请求会映射到BIG_MODEL(此例中为anthropic/claude-sonnet-4) - 当您使用

claude-3-sonnet时,请求会映射到MIDDLE_MODEL(此例中为anthropic/claude-sonnet-4) - 当您使用

claude-3-haiku时,请求会映射到SMALL_MODEL(此例中为anthropic/claude-3.5-haiku:beta)

连接其他OpenAI兼容API

除了OpenRouter,Claude Code Proxy还可以连接到其他OpenAI兼容的API。以下是几个常见示例:

Azure OpenAI

ini

OPENAI_API_KEY="your-azure-key"

OPENAI_BASE_URL="https://your-resource.openai.azure.com/openai/deployments/your-deployment"

BIG_MODEL="gpt-4"

MIDDLE_MODEL="gpt-4"

SMALL_MODEL="gpt-35-turbo"本地模型(Ollama)

ini

OPENAI_API_KEY="dummy-key" # 必需但可以是虚拟值

OPENAI_BASE_URL="http://localhost:11434/v1"

BIG_MODEL="llama3.1:70b"

MIDDLE_MODEL="llama3.1:70b"

SMALL_MODEL="llama3.1:8b"其他兼容OpenAI API的服务

只要API兼容OpenAI格式,都可以通过设置适当的OPENAI_BASE_URL和OPENAI_API_KEY来连接。

结论

Claude Code原生设计仅支持Anthropic的Claude系列模型,无法直接连接OpenAI等其他提供商的API。我们详细分析了这一限制的技术原因,包括协议不兼容、URL路径拼接错误、认证方式不一致等问题。

通过Claude Code Proxy这一全新开源项目(2025年6月刚刚启动),我们成功突破了这些限制,使Claude Code能够连接到几乎任何OpenAI兼容的API服务,包括OpenRouter、Azure OpenAI、本地模型等。代理服务器充当了两种不同API规范之间的"翻译器",自动处理请求转换和响应格式调整。

这种方法不仅保留了Claude Code优秀的命令行体验,还大大扩展了其应用场景,使开发者能够根据具体需求灵活选择最合适的模型。无论是需要访问OpenRouter上的Claude Sonnet 4,还是希望使用本地部署的开源模型,Claude Code Proxy都提供了一个统一、简洁的解决方案。

通过本文介绍的配置和使用方法,您可以充分发挥Claude Code的潜力,将其作为连接各种AI模型的统一入口,提高开发效率和灵活性。