1. BaseInfo

| Title | FreeKD: Knowledge Distillation via Semantic Frequency Prompt |

| Adress | https://arxiv.org/abs/2311.12079 |

| Journal/Time | CVPR 2024 |

| Author | 北大,浙大 |

| Code | |

| Read |

2. Creative Q&A

Knowledge Distillation, KD

- 目前知识蒸馏的问题:但教师模型在空间域的连续下采样会干扰学生模型分析需模仿的特定信息,导致精度下降。频域蒸馏面临新挑战,低频带上下文信息,高频带信息更丰富但引入噪声,且并非频带内每个像素对性能贡献相同。

- 提出 Frequency Prompt,插入教师模型,在微调时吸收语义频率上下文。

- 蒸馏期间,通过 Frequency Prompt 生成像素级频率掩码,定位不同频带中感兴趣像素(Pol)。

- 针对密集预测任务,采用位置感知关系频率损失,为学生模型提供高阶空间增强。

该方法称为 FreeKD,可确定频率蒸馏的最佳定位和范围。

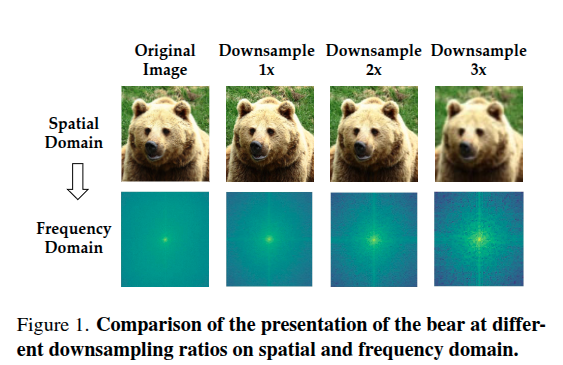

在空间域,随着下采样比例增加,图像分辨率降低;在频域,不同下采样比例呈现出不同的频率信息分布,直观呈现下采样操作对图像在空间域和频域表现的影响

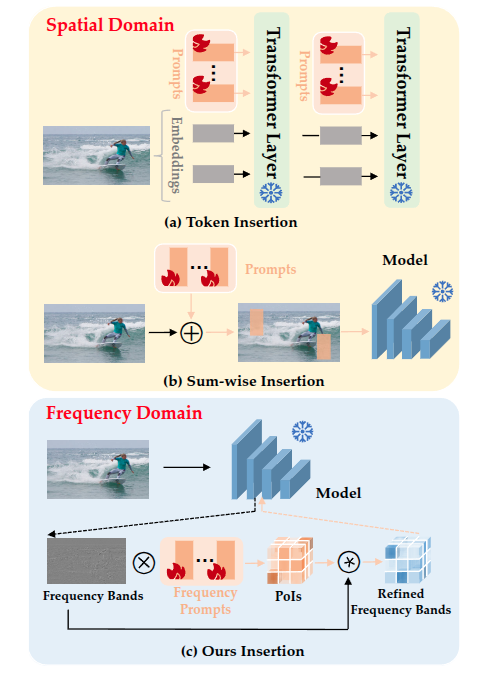

(a) Token Insertion:提示作为 token 插入编码器层。

(b) Sum - wise Insertion:提示在输入图像 RGB 通道上求和插入。

© Ours Insertion(本文方法):提示与中间特征相互作用,从中间特征中提炼频率信息,定位感兴趣像素(Pol)并优化频率带,更好地服务于知识蒸馏过程 。

以往知识蒸馏多使用传统损失函数(如 Kullback - Leibler 散度、均方误差 )处理分类和回归输出或中间特征。

频域

这个没怎么看懂暂时放过。