用LLM生成软件工程证据简报靠谱吗?一场对比实验告诉你答案

论文标题:Investigating the Use of LLMs for Evidence Briefings Generation in Software Engineering

arXiv:2507.15828

Investigating the Use of LLMs for Evidence Briefings Generation in Software Engineering

Mauro Marcelino, Marcos Alves, Bianca Trinkenreich, Bruno Cartaxo, Sérgio Soares, Simone D.J. Barbosa, Marcos Kalinowski

Comments: ESEM 2025 Registered Report with an IPA (In Principle Acceptance) for the Empirical Software Engineering journal

Subjects: Software Engineering (cs.SE)

一段话总结:本文聚焦于使用LLMs生成软件工程领域证据简报 的研究,旨在通过实验评估LLM生成的证据简报与人工生成的在内容保真度、易理解性和有用性上的差异。研究开发了基于RAG的LLM工具,生成了两篇对应人工简报的自动简报,并设计对照实验,由研究人员评估内容保真度,从业人员评估易理解性和有用性,以探究LLM生成简报的适用性。

研究背景:软件工程里的"知识传递难题"

想象一下,医生看病需要参考最新的医学研究,但如果这些研究写成厚厚的专著,医生根本没时间读------于是有了"临床指南"这种精简版总结。在软件工程领域,也有类似的问题。

软件工程研究中,专家们会做大量"系统文献综述(SLR)",总结现有研究成果、找研究缺口,为行业决策提供依据。但问题是,这些SLR往往太学术,工业界的工程师要么读不懂,要么觉得和实际工作没关系。有研究显示,44位软件工程研究者里,只有6人认为自己的SLR真正影响了工业实践;还有研究发现,49篇SLR虽然有价值,但很难转化成工程师能直接用的知识。

为了填补这个"研究与实践的鸿沟",有人提出了"证据简报"------一种一页纸的精简报告,把研究核心发现提炼出来,用工程师能看懂的语言呈现。但新问题来了:证据简报得手动写,费时费力,很难大规模推广。

这时候,大语言模型(LLM)登场了。LLM擅长总结文本、生成内容,在医学、政策等领域已经用来自动生成研究摘要。但它也有"不靠谱"的时候:可能编造信息(幻觉)、需要精心设计提示词,还可能抓不住细节。那么,用LLM自动生成软件工程的证据简报,到底行不行?这就是这篇论文要研究的问题。

创新点:从"手动总结"到"AI生成",不止是效率提升

这篇论文的亮点在于"针对性验证",具体有三个创新:

- 聚焦软件工程场景:虽然LLM能生成摘要,但专门针对软件工程证据简报的对比研究很少,本文填补了这个空白。

- 双视角评估:不只用研究者评估"准不准"(内容保真度),还让工业界从业者评估"好不好用"(易理解性、有用性),更全面。

- RAG技术加持:用"检索增强生成(RAG)"技术,让LLM参考54个人工写的证据简报做例子,确保生成的简报格式、语言符合工程师需求。

研究方法:一场严谨的"对比实验"设计

为了搞清楚LLM生成的简报是否靠谱,研究团队设计了一套详细的实验方案,步骤拆解如下:

第一步:明确实验目标

- 目标1:让研究者评估LLM生成的简报是否和人工的一样"准"(内容保真度)。

- 目标2:让从业者评估LLM生成的简报是否和人工的一样"好懂"(易理解性)、"有用"(有用性)。

第二步:提出假设

实验前先假设"两者没区别"(零假设),最后用数据验证:

- HO₁:研究者对人工和LLM简报的内容保真度感知无差异。

- HO₂:从业者对两者的易理解性感知无差异。

- HO₃:从业者对两者的有用性感知无差异。

第三步:确定实验变量

- 独立变量:简报类型(人工生成 vs LLM生成)。

- 因变量:内容保真度、易理解性、有用性。

- 其他变量:比如研究者的学术背景、从业者的工作年限等,用于更细致的分析。

第四步:设计实验流程

- 选了两篇研究论文(主题是"结对编程"和"完成定义",都是工程师关心的话题),每篇都有"人工简报"和"LLM简报"两个版本。

- 研究者实验:先读论文,再随机读一篇对应简报(人工或LLM),评估"准不准"。

- 从业者实验:直接随机读一篇人工、一篇LLM简报,评估"好不好懂""有没有用"。

- 评估方式:用7分制量表(1=强烈反对,7=强烈同意)打分,还能写文字补充。

第五步:LLM工具配置

用的是GPT-4-o-mini模型,关键参数如下:

| 配置项 | 具体值 |

|---|---|

| 模型 | GPT-4-o-mini |

| 调用方式 | OpenAI API |

| 温度(创造性) | 0.5(中等创造性) |

| 参考数据 | 54个人工证据简报(RAG检索) |

| 输出限制 | 1024个令牌 |

第六步:考虑"有效性威胁"

为了让结果可信,团队提前想了可能的问题及解决办法:

- 比如"顺序影响"(先读人工简报可能影响对LLM简报的判断):用随机顺序解决。

- 比如"LLM参数变了怎么办":固定所有参数并公开存档。

主要贡献:为"AI生成证据简报"铺路

虽然实验结果还没出来,但这篇论文的价值已经很明显:

- 提供工具:开发了基于RAG的LLM工具,能自动生成符合格式的证据简报,减少手动工作量。

- 建立评估框架:从研究者和从业者双视角设计评估指标,为后续同类研究提供参考。

- 推动知识转移:如果实验证明LLM生成的简报靠谱,就能快速把更多研究成果转化给工业界,缩小"研究与实践鸿沟"。

总结

这篇论文聚焦"用LLM自动生成软件工程证据简报"的可行性,通过设计严谨的对照实验,对比人工和LLM生成简报在"内容保真度""易理解性""有用性"上的差异。研究用GPT-4-o-mini结合RAG技术生成简报,让研究者和从业者分别评估,最终结果将决定LLM生成的简报是否能大规模推广。

无论结果如何,它都为"用AI解决软件工程知识转移难题"提供了重要的实验基础。

解决的主要问题及成果

目前的核心成果是:

- 提出了一套完整的"LLM生成证据简报"评估方案,包括实验设计、工具配置和有效性保障措施。

- 开发并公开了可复用的工具(代码、提示词等),方便其他研究者跟进。

解决的关键问题是:手动生成证据简报效率低、难以推广,而本文探索了用LLM替代的可能性,为自动化知识转移提供了新思路。

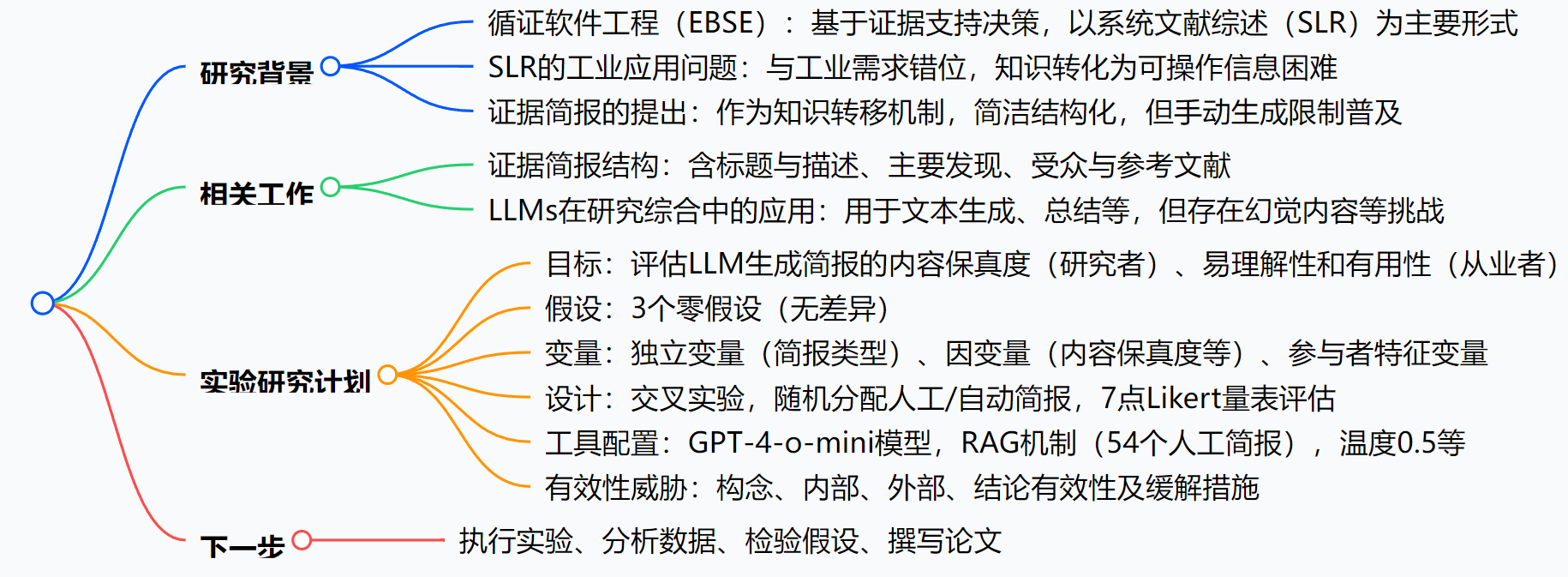

思维导图:

详细总结:

一、摘要

本文是一项注册报告,核心目标是通过实验评估LLM生成的证据简报与人工生成的在内容保真度、易理解性和有用性上的差异。研究开发了基于RAG的LLM工具生成自动简报,设计对照实验,结果和结论待实验后确定。

二、引言

- 循证软件工程(EBSE):由Kitchenham等人提出,强调系统收集、评估和综合实证证据支持决策,以SLR为主要形式。

- SLR的工业应用挑战:研究发现SLR在工业界影响有限,44名研究者中仅6人认为其工作影响工业实践,知识转移机制低效是重要原因。

- 证据简报的提出:Cartaxo等人提出,作为简洁、结构化的知识转移介质,但手动生成的工作量和认知负荷限制了其普及。

- LLMs的潜力:LLMs在文本总结等方面表现出色,已有在医学、政策领域的应用,但存在幻觉内容等挑战,本文探究其在软件工程证据简报生成中的适用性。

三、背景与相关工作

- 证据简报 :

- 定义:一页文档,总结实证研究关键发现,比SLR更实用高效。

- 结构:包括标题与描述(避免技术术语,简述目的)、主要发现(核心洞察)、受众与参考文献(目标群体及原始研究)。

- LLMs用于研究综合 :

- 应用:已有用于政策、医学领域的研究总结,可优化生成可靠、相关的摘要。

- 挑战:需有效提示工程、存在幻觉内容风险、难以捕捉语境细微差别。

四、实验研究计划

- 目标 :

- 目标1:从研究者角度,分析LLM生成简报的内容保真度。

- 目标2:从从业者角度,分析LLM生成简报的易理解性和有用性。

- 研究问题(RQ) :

- RQ1:研究者对人工与LLM生成简报的内容保真度感知差异?。

- RQ2:从业者对两者的易理解性感知差异?。

- RQ3:从业者对两者的有用性感知差异?。

- 假设 :

- HO₁:研究者对两者内容保真度的感知无差异。

- HO₂:从业者对两者易理解性的感知无差异。

- HO₃:从业者对两者有用性的感知无差异。

- 变量 :

- 独立变量:简报类型(LLM生成、人工生成);参与者特征(研究者:SLR熟悉度等;从业者:工作年限等)。

- 因变量:内容保真度(研究者评估)、易理解性(从业者评估)、有用性(从业者评估)。

- 实验设计 :

- 类型:交叉设计,参与者随机分配接收人工/LLM生成简报的顺序。

- 对象:研究者(评估2篇研究论文及对应随机简报的内容保真度)、从业者(评估1篇人工和1篇LLM简报的易理解性和有用性)。

- 评估工具:7点Likert量表(1-强烈反对,7-强烈同意),含开放文本框用于定性分析。

- LLM工具配置:

| 方面 | 详情 |

|---|---|

| 模型 | GPT-4-o-mini(gpt-4-0125-preview) |

| 提供者 | OpenAI API |

| 访问日期 | 2025年3月 |

| 温度 | 0.5 |

| Top-p | 1.0 |

| 最大令牌 | 1024(输出限制) |

| 提示策略 | 基于指令的提示 |

| RAG机制 | 通过ChromaDB检索 |

| 检索示例 | 54个人工生成的证据简报 |

- 有效性威胁及缓解 :

- 构念有效性:通过固定LLM参数、使用多项目测量因变量缓解。

- 内部有效性:采用平衡交叉设计、选择不同主题简报减少顺序和遗留效应。

- 外部有效性:选择方法严谨且与从业者相关的论文,但承认需在更多领域重复实验。

- 结论有效性:关注样本量和代表性以确保统计效力。

五、下一步

将按协议执行实验、分析数据、检验假设、撰写论文以传播结果。

-

关键问题:

-

问题:本研究中,证据简报的核心结构包含哪些部分?各部分的主要作用是什么?

答案:证据简报的核心结构包括标题与描述、主要发现、受众与参考文献。标题与描述需简洁,避免技术术语,简要说明简报目的以吸引从业者;主要发现是对研究关键结果的 concise 总结;受众与参考文献明确目标群体并提供原始研究来源供进一步阅读。

-

问题:实验中如何确保对LLM生成简报和人工生成简报的评估是公平的?

答案:实验通过随机分配简报类型(人工或LLM生成)给参与者,且参与者不知道简报的生成方式,避免主观偏向;采用交叉设计平衡顺序效应,并选择不同主题的简报减少遗留效应,同时对因变量使用多项目测量以提高可靠性,这些措施保障了评估的公平性。

-

问题:本研究使用的LLM工具在技术上有哪些关键配置?为何采用这些配置?

答案:关键配置包括模型为GPT-4-o-mini,温度0.5,采用基于指令的提示策略和RAG机制(使用54个人工证据简报作为检索源)。选择这些配置是为了生成结构化、符合从业者需求的简报:固定温度等参数确保输出稳定性,RAG机制提供人工简报示例以指导模型的内容结构和语言风格,基于指令的提示明确任务要求。