2025年7月28日晚,智谱AI正式发布GLM-4.5系列大模型,这款被定位为"Agent原生基础模型"的产品,在发布当晚就引发了AI开发者社区的热烈讨论。与以往单纯追求参数规模或某项单一能力突破不同,GLM-4.5选择了一条更加务实且具有前瞻性的技术路线:在单个模型中原生融合推理、编码和智能体等多项核心能力。

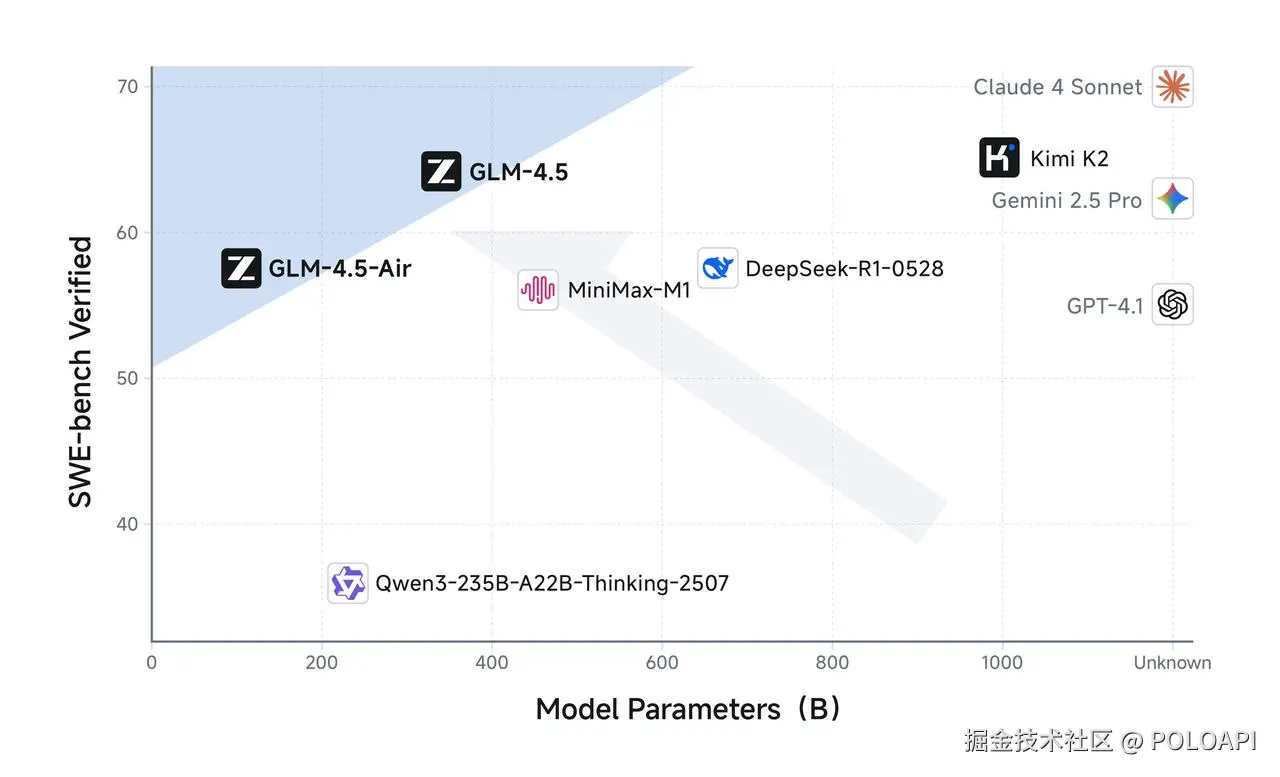

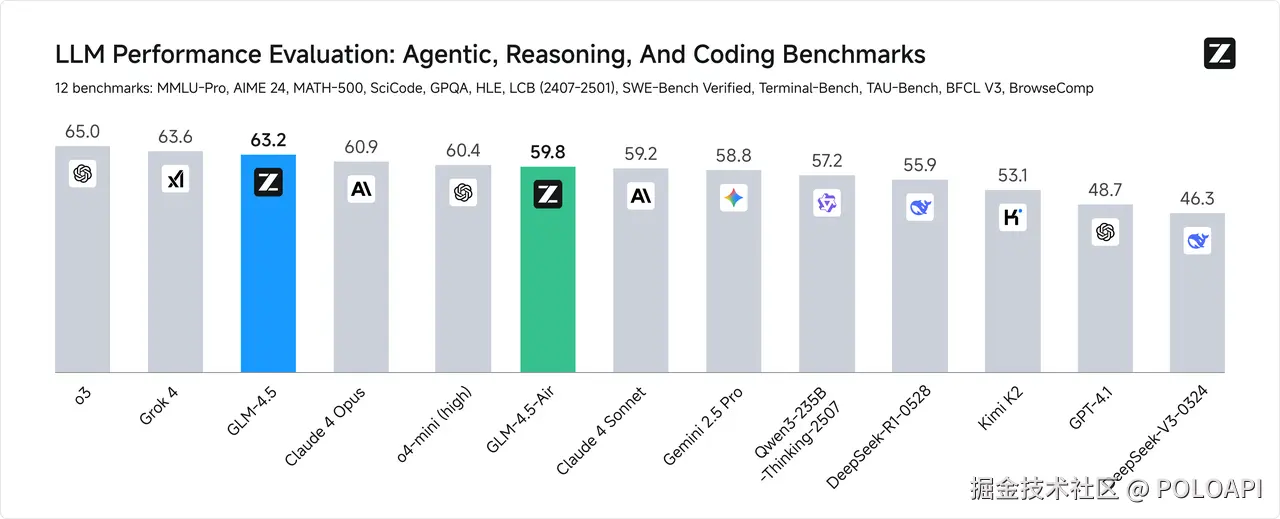

在12个国际权威评测基准中,GLM-4.5取得了全球第三的综合成绩,这一成绩的背后,折射出国产大模型技术实力的显著提升和技术路线的日趋成熟。

技术突破:首次实现多能力原生融合

MoE架构的工程智慧

GLM-4.5采用稀疏激活的混合专家(MoE)架构,通过智能的专家选择机制,实现了性能与效率的最优平衡:

GLM-4.5:

GLM-4.5-Air: 106B总参数 → 12B激活参数同时,GLM-4.5 引入了革命性的混合推理架构,如同为模型装上了 "双模式变速器":思考模式(Thinking Mode)和非思考模式(Non-Thinking Mode)。在思考模式下,模型会深度启动链式推理,自主将复杂任务分解为多个子任务,并通过调用各种工具完成多步操作,适合处理需要深度思考和复杂规划的任务;而在非思考模式下,模型能够极速响应即时需求,将对话延迟降至毫秒级,满足用户对于快速交互的需求。例如,当用户需要模型对一个复杂的科学问题进行深入分析时,思考模式能够充分发挥作用,提供全面而深入的解答;而当用户只是进行简单的日常闲聊时,非思考模式则能快速给出回应,保证交互的流畅性。

快速上手:3分钟部署GLM-4.5

#

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("THUDM/glm-4.5")

model = AutoModelForCausalLM.from_pretrained("THUDM/glm-4.5")

# 简单对话示例

inputs = tokenizer("写一个Python快速排序算法", return_tensors="pt")

outputs = model.generate(**inputs, max_length=200)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)API调用:成本优势明显

价格对比

GLM-4.5

- 输入:0.8元/百万tokens

- 输出:2.元/百万tokens

- 速度:>100 tokens/秒

对比主流模型:

- GPT-4:输入60元,输出120元/百万tokens

- Claude-4:输入45元,输出90元/百万tokens快速接入示例

#

import requests

import json

url = "https://open.bigmodel.cn/api/paas/v4/chat/completions"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "glm-4.5",

"messages": [

{"role": "user", "content": "帮我分析一下这段代码的时间复杂度"}

],

"temperature": 0.7

}

response = requests.post(url, headers=headers, json=data)

print(response.json())对于需要同时测试多个模型的开发者,PoloAPI这样的聚合服务提供了很好的解决方案。通过一个API密钥就能访问包括GLM-4.5在内的300+主流模型,特别适合模型选型和性能对比:

#

import openai

client = openai.OpenAI(

api_key="your_poloapi_key",

base_url="https://poloai.top/v1"

)

response = client.chat.completions.create(

model="glm-4.5",

messages=[{"role": "user", "content": "解释一下量子计算的原理"}]

)部署要求:门槛大幅降低

硬件配置

推荐配置:

- GPU:8块H20或同等算力

- 内存:128GB+

- 存储:2TB SSD

最低配置:

- GPU:4块RTX 4090

- 内存:64GB

- 存储:1TB SSD对国产大模型的重要意义

技术引领与示范

GLM-4.5 的出现,为国产大模型的发展提供了新的技术方向和成功范例。其在多能力融合、参数效率提升以及架构创新等方面的突破,为国内其他大模型研发团队提供了宝贵的借鉴经验。它证明了在大模型研发过程中,不一定要盲目追求参数量的增加,通过合理的架构设计和技术优化,同样能够实现性能的大幅提升。这将激励更多的国内团队在技术创新上投入更多精力,推动整个国产大模型技术水平的不断进步。

产业生态推动

随着 GLM-4.5 的开源,其将在产业生态方面发挥巨大的推动作用。开源意味着更多的开发者和企业可以基于该模型进行二次开发和应用创新,从而催生出丰富多样的 AI 应用。无论是在智能编程领域,帮助开发者更高效地编写代码;还是在智能体应用场景中,构建能够自主完成复杂任务的智能系统;亦或是在其他行业领域,如医疗、金融、教育等,GLM-4.5 都有望成为推动行业智能化升级的重要力量。众多基于 GLM-4.5 的创新应用不断涌现,将进一步完善国内 AI 产业生态,提升整个产业的竞争力。

降低应用门槛与成本

在成本方面,GLM-4.5 系列展现出了极大的优势。其 API 调用价格低至输入 0.8 元 / 百万 tokens、输出 2 元 / 百万 tokens,远低于目前主流的模型定价 。同时,高速版本实测生成速度最高可达 100 tokens / 秒,支持低延迟、高并发的实际部署需求。这种低成本、高速度的特性,使得更多的中小企业甚至个人开发者,都能够以较低的成本使用先进的大模型技术,将 AI 应用集成到自己的产品或服务中。这无疑降低了 AI 应用的开发门槛,促进了 AI 技术在更广泛领域的普及和应用,让更多的行业和人群能够享受到 AI 技术带来的便利和价值。

结合 PoloAPI 的应用拓展设想

PoloAPI 作为一款功能强大的 API 服务平台,与 GLM-4.5 的结合有望带来更多创新应用。例如,在智能数据分析场景中,PoloAPI 丰富的数据接口可以为 GLM-4.5 提供多样化的数据源,GLM-4.5 利用其强大的推理和分析能力,对这些数据进行深入挖掘和分析,为企业提供精准的市场洞察和决策建议。在自然语言处理任务方面,如智能客服,PoloAPI 可以负责处理与用户的通信连接、消息传递等基础服务,而 GLM-4.5 专注于理解用户问题,并生成高质量的回答,两者协同工作,能够为用户提供更优质、高效的客服体验。通过这种结合,开发者可以更轻松地构建出功能丰富、性能卓越的 AI 应用,进一步拓展 GLM-4.5 在不同领域的应用边界。

总结

综上所述,智谱 GLM-4.5 作为新一代开源大模型,凭借其在技术上的多项突破和卓越的综合性能,在国产大模型发展历程中具有里程碑式的重要意义。其不仅提升了国产大模型在全球的竞争力,更为国内大模型技术发展、产业生态建设以及应用普及带来了新的机遇和动力。随着 GLM-4.5 的持续优化和广泛应用,我们有理由期待它在未来为 AI 领域带来更多的惊喜和变革。

更多AI大模型信息,请关注PoloAPI.com,无论是技术小白还是技术大咖,都能够在这里找到你所要的AI大模型