坐姿检测技术是计算机视觉与健康监测交叉融合的前沿应用领域,它通过分析人体在座椅上的姿态特征来实时监测和评估坐姿质量。这项技术在健康办公、驾驶安全、康复医疗和教育领域具有广泛的应用前景。

实现方案

方案一:基于 MediaPipe Pose(推荐)

实现原理:

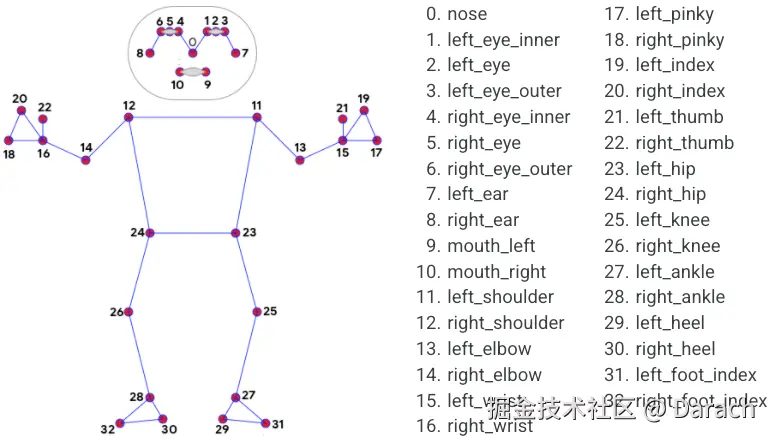

Google 的 MediaPipe Pose 提供了人体 33 个骨骼关键点坐标,包括:

头部:鼻子、眼睛、耳朵

上肢:肩膀、手肘、手腕

躯干:脊椎、胯部

下肢:膝盖、脚踝等

我们可以通过分析这些关键点的空间位置关系(x, y, z)来判断姿势是否异常

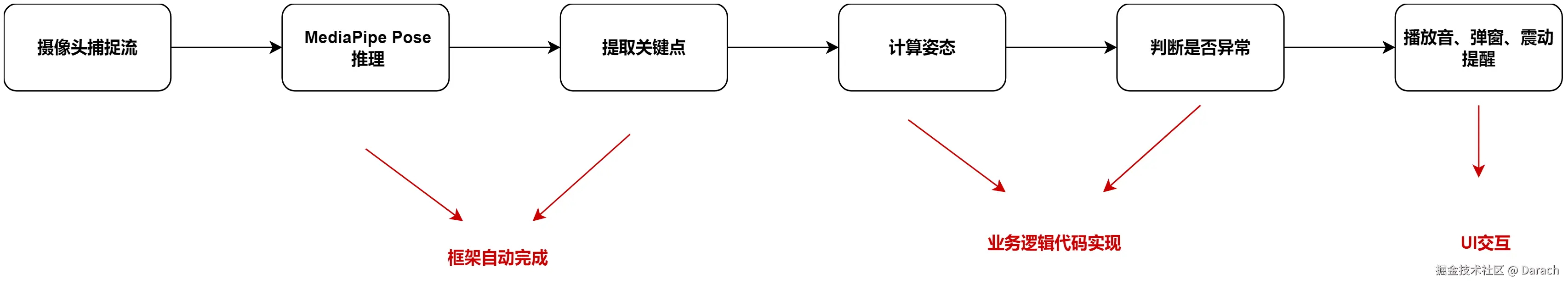

流程图:

代码示例:

- 头部前倾 / 驼背

判断依据:鼻子(NOSE)在 z 轴上的值(靠近镜头 z 更大)

python

# 取出重要关键点,如鼻子、肩膀、背部

nose_z = results.pose_landmarks.landmark[mp_pose.PoseLandmark.NOSE].z

# 判断

if nose_z > 0.3:

print("驼背或头部前倾")- 左右倾斜(肩膀不对称)

判断依据:左右肩膀在 y 轴方向高度差(正常坐姿高度接近)

python

# 取出重要关键点,如鼻子、肩膀、背部

left_shoulder = results.pose_landmarks.landmark[mp_pose.PoseLandmark.LEFT_SHOULDER]

right_shoulder = results.pose_landmarks.landmark[mp_pose.PoseLandmark.RIGHT_SHOULDER]

# 判断

shoulder_diff = abs(left_shoulder.y - right_shoulder.y)

if shoulder_diff > 0.05: # 阈值可调整

print("身体左右倾斜")- 身体前倾靠近桌面

判断依据:鼻子与臀部的 y 值差异(身体整体向前探)

python

# 取出重要关键点,如鼻子、肩膀、背部

nose_y = results.pose_landmarks.landmark[mp_pose.PoseLandmark.NOSE].y

hip_y = results.pose_landmarks.landmark[mp_pose.PoseLandmark.LEFT_HIP].y

# 判断

if (nose_y - hip_y) < -0.15:

print("身体前倾")硬件要求:

OpenGL ES 3.1+ 支持的设备(MediaPipe 要求)

官方文档:

ai.google.dev/edge/mediap...

方案二:基于YOLOv8-pose

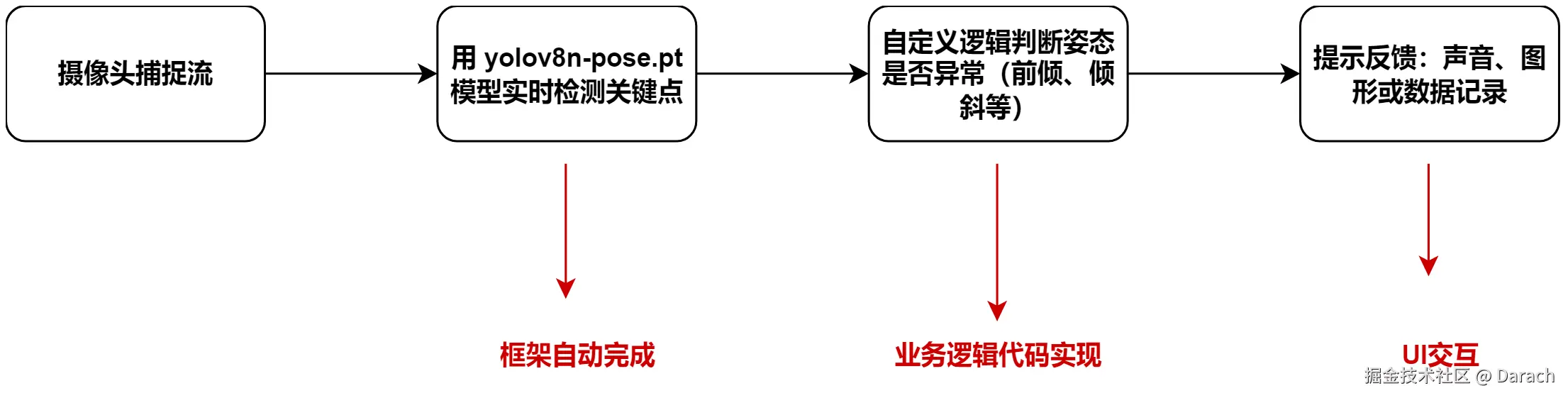

流程图:

示例代码:

python

from ultralytics import YOLO

import cv2

# 加载YOLOv8 pose模型(可用 v8m-pose.pt,精度和速度平衡)

model = YOLO('yolov8n-pose.pt') # 也可以用 yolov8s/m/l/x-pose.pt

cap = cv2.VideoCapture(0)

while True:

ret, frame = cap.read()

if not ret:

break

# 推理

results = model(frame)

# 可视化检测结果

annotated_frame = results[0].plot()

# 关键点坐标提取

keypoints = results[0].keypoints # shape: [num_people, 17, 3]

if keypoints is not None and len(keypoints) > 0:

pose = keypoints[0].cpu().numpy() # 只取第一个人

# 示例:提取鼻子、肩膀坐标

nose = pose[0] # [x, y, conf]

left_shoulder = pose[5]

right_shoulder = pose[6]

# 判断:左右肩是否高度差大

shoulder_diff = abs(left_shoulder[1] - right_shoulder[1])

if shoulder_diff > 30:

print("身体倾斜")

# 判断:头部是否低于一定阈值

if nose[1] > left_shoulder[1] + 50:

print("驼背 / 头前倾")

cv2.imshow("Pose Detection", annotated_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()微调(Fine-tuning):

微调就是"用你自己的坐姿数据,教会 YOLOv8-pose 更好识别特殊坐姿"的过程,大致步骤如下:

- 收集/标注数据:关键点标注

- 按 YOLO-pose 格式准备数据集

- 配置训练文件(模型结构、类别数、关键点数量等)

- 使用 yolo train 命令进行训练

- 导出成TFLite 模型,部署到手机/平板中

官方文档:

docs.ultralytics.com/zh/tasks/po...

YOLOv8-pose vs MediaPipe Pose

| 对比项 | YOLOv8-pose | MediaPipe Pose |

|---|---|---|

| 准确性 | 高(可训练、支持多骨架) | 中(预训练模型) |

| 模型大小 | 大(yolov8m-pose 约40MB+) | 小(适合移动端) |

| 开发语言 | Python为主,ONNX/TFLite需转换 | 原生支持 Android(Java/C++) |

| 自定义能力 | 强,可训练自己的姿态模型 | 弱,不能微调 |

✅ 建议:

- 如果你要快速在 Android 本地部署,MediaPipe 更适合

- 如果你要构建高精度、可训练的系统,YOLOv8-pose 更灵活