作者:靖苏

在 AI 与云原生协同创新的浪潮下,多模型、多场景智能应用日益普及。开发者面临的首要挑战,是如何实现模型之间、服务之间的高效协同,以及如何便捷地将自主研发能力拓展到云端,形成灵活可扩展的智能服务。MCP 即模型上下文协议(Model Context Protocol) ,其提供了一套通用的上下文管理和交互规范,帮助开发者聚焦于模型推理及业务创新,同时解决模型集成、通讯、调度和上下文共享等复杂问题。开发者可以根据自身业务场景,自主开发符合 MCP 协议的服务代码,并通过简单配置,一键部署至 Function AI 平台,并通过平台提供的访问地址提供给你进行调用,实现与模型服务的快速开发与集成。

Function AI 提供 MCP 代码一键上云的全流程能力

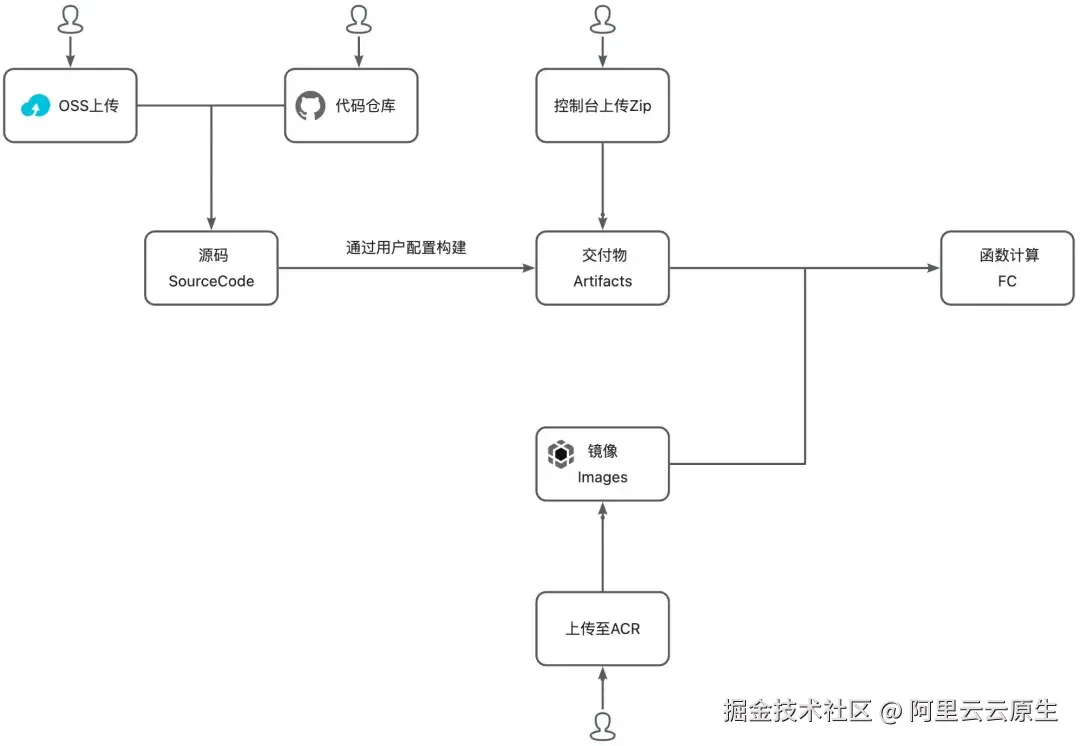

为了让开发者更高效地将自主实现的 MCP 协议代码构建、部署到云端服务,Function AI 针对开发阶段,提供了如下图所示的多途径的便捷构建和部署能力。

开发者可以将源码、交付物或镜像上传或托管至 Function AI 平台,通过修改构建配置和运行配置,点击部署后,便可将你的 MCP 服务源码部署至平台,平台提供公网访问地址可以连接你云端部署的 MCP 服务。

1. 绑定代码仓库,自动拉取代码进行构建部署

Function AI 提供了 Github、Gitee、Gitlab 和 Codeup 源码仓库代码一键构建部署的能力。MCP 服务的代码开发者只需将 MCP 代码托管到源码仓库,Function AI 支持仓库绑定获取源码,自动触发构建和一键部署。每一次提交后,平台都能持续集成,使云端部署与本地开发同步,适合团队协作及敏捷交付。

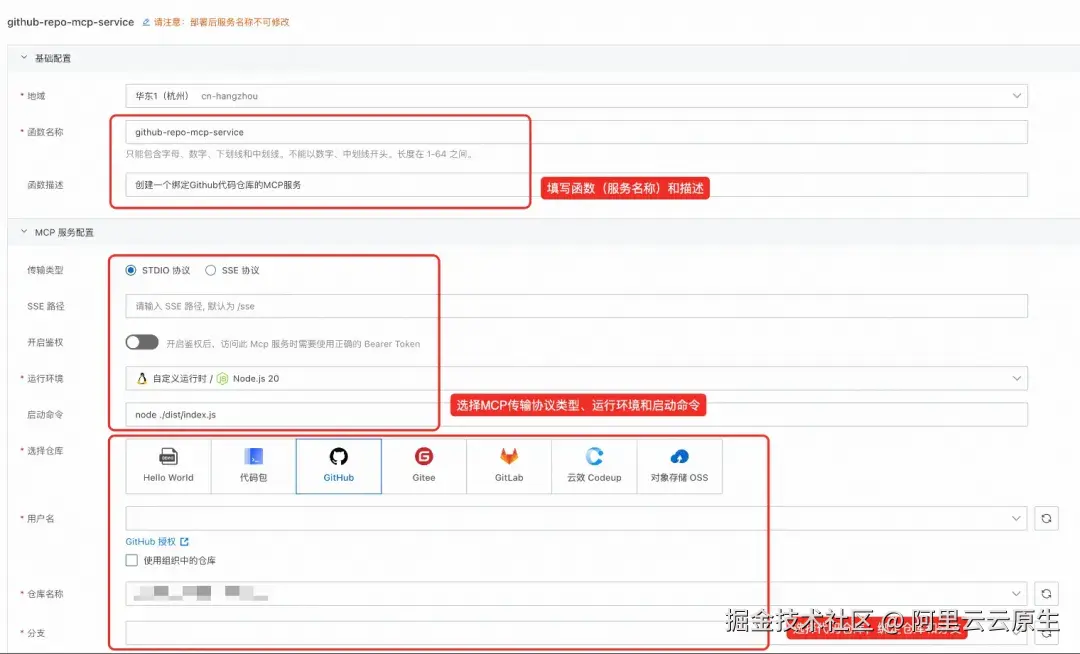

首先登录 Function AI 平台【1】,点击创建项目,在项目下创建一个 MCP 服务。

进入基础配置,可以定义你的 MCP 服务(函数)名称和描述。进入下面的 MCP 服务配置,选择你想绑定的代码仓库(Github、Gitee、Gitlab 或 Codeup)。点击"授权",跳转到代码仓库的页面,将你的账号授权给平台,获取你的仓库和分支信息。授权完毕后,选择你想绑定的代码仓库和分支。

绑定完成后,需要选择你的代码运行环境和运行启动命令。Function AI 支持 NodeJS、Python、Java 等多个 MCP 服务依赖运行时,你可以选择相应的运行时,并填写代码的启动命令启动代码。Function AI 支持 MCP STDIO 协议和 SSE 协议,你可以选择你 MCP 服务中的对应协议类型。

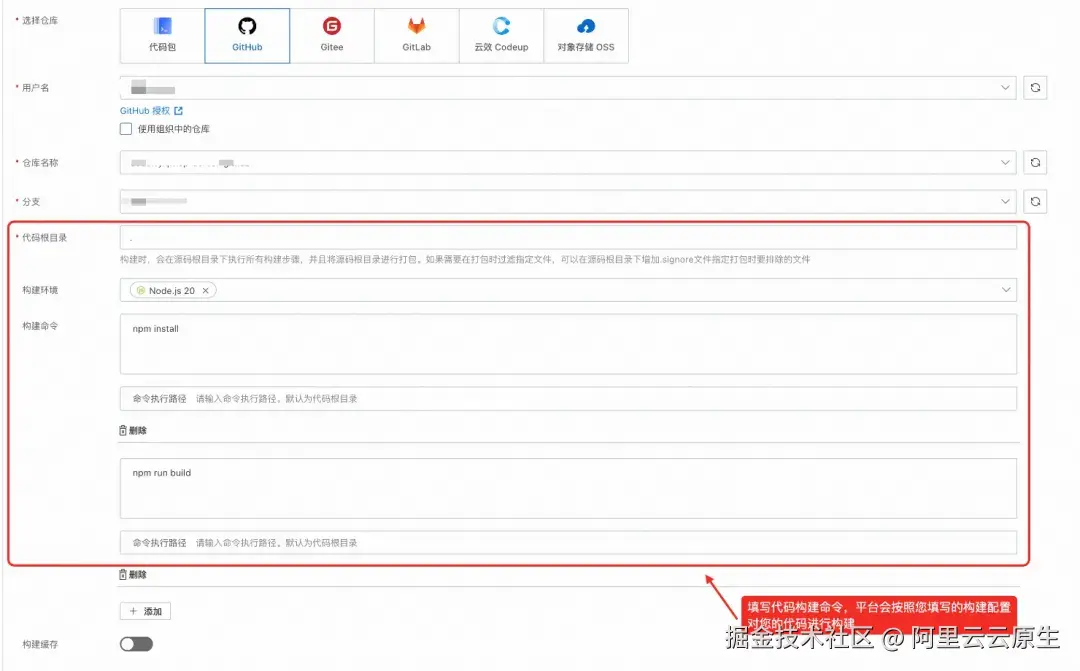

下一步是填写构建配置:首先填写代码根目录,平台会将你填写的代码根目录下的代码上传到平台进行构建。此外,需要你填写代码的构建环境和构建命令。

例如,我想部署一个 Nodejs 代码开发的 MCP 服务,在这里要填写对应的构建环境和构建命令(在对应的路径下执行相应的构建命令),一般来说,构建的命令用于帮助你的代码安装相关环境依赖。

在这里:

- 示例中代码根目录填写的是.,平台将上传代码仓库的源码,其根目录就是运行时的根目录;

- 示例中的 MCP 服务是基于 Nodejs 进行开发的,因此选择了 Node.js20 作为构建环境;

- 代码首选需要通过 npm install 安装相关依赖,随后执行 npm run build 编译相关源码,在构建命令中填写相应命令,命令执行路径不填,默认会使用代码根目录,即在代码仓库的根目录下执行此条命令;

- 如你需要在构建阶段使用缓存,可打开缓存开关配置缓存路径,详细见:缓存路径配置【2】

随后,你可以按需选择此 MCP 服务需要的资源配置和网络配置。资源配置决定了你的服务是否需要开启极速模式预留实例快照以及此服务需要的 CPU 和内存规格。网络配置决定了你的 MCP 服务是否要绑定 VPC 进行内网访问以及是否禁用公网 URL。

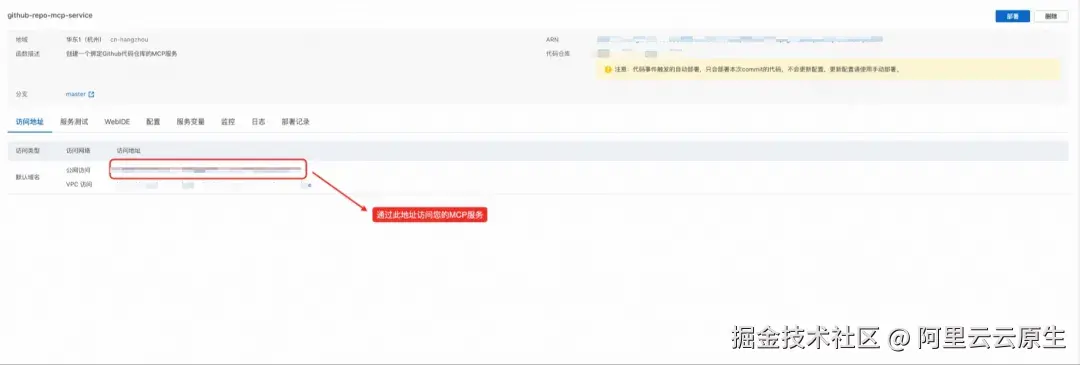

在配置好以上信息后,点击部署服务,即可将服务构建并部署至 Function AI 平台上。你可以点击部署记录查看构建和部署日志(包含安装代码依赖、部署程序至函数计算服务中)。

部署成功后,你可以点击"访问地址"查看公网访问地址和私网访问地址,你可以根据此地址,将此 MCP 服务注册到百炼等第三方模型服务提供平台,提供给大模型进行调用。

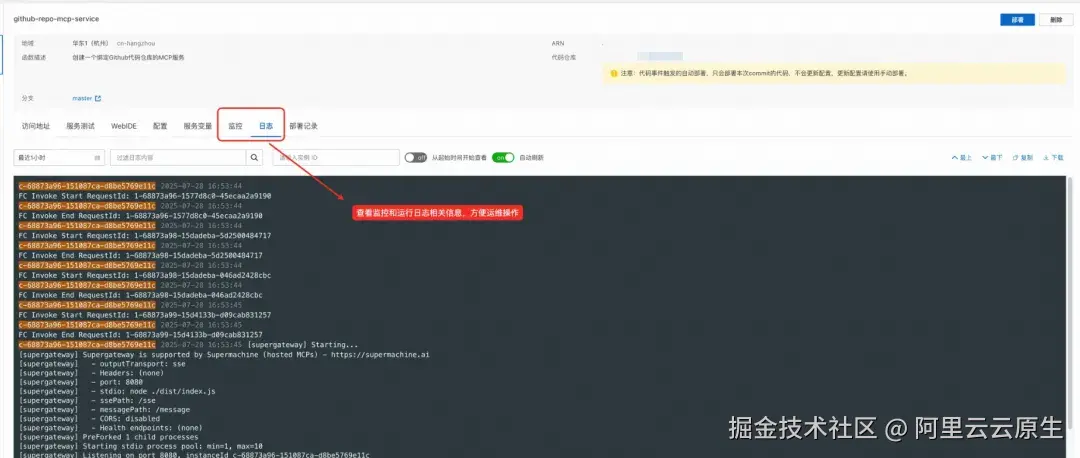

后期你可以点击监控和日志,查看当前 MCP 服务运行的日志和指标情况,方便你进行后续运维。

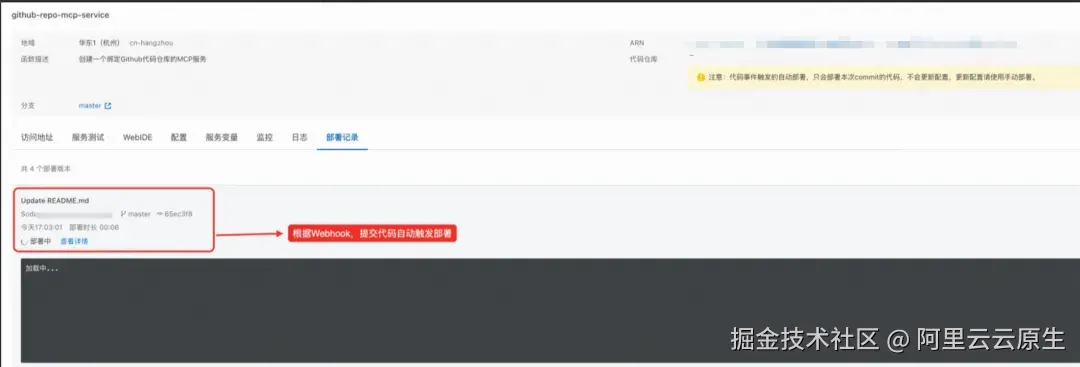

若你选择通过绑定代码仓库,获取源码构建部署 MCP 服务,平台会自动创建 Webhook 至你的代码仓库,后续该绑定分支的提交操作,将自动触发构建部署流程,使每一次代码更新都能够实时集成并快速上线,无需手动干预,大幅提升开发效率与发布频率,保障你的服务持续迭代与高效交付。

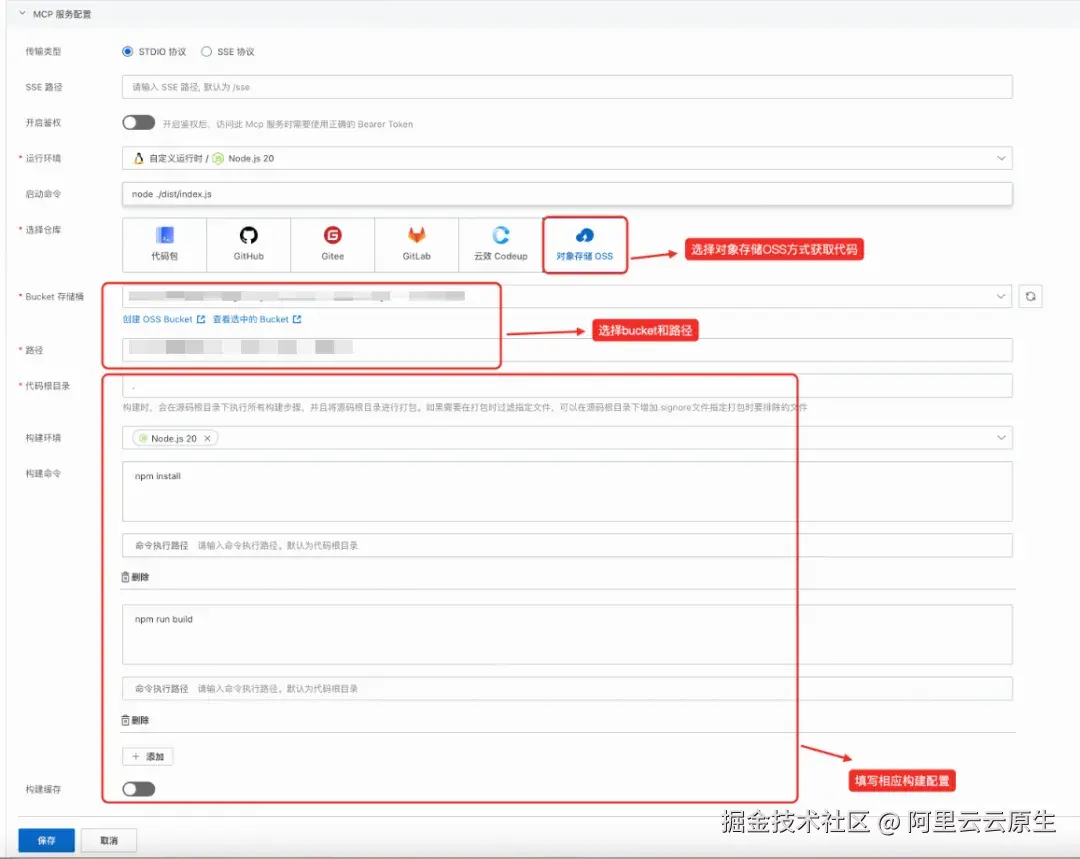

2. 上传源码包到 OSS 构建

如你或团队已开通对象存储(OSS)服务,可将完整源码包上传至 OSS。Function AI 会自动拉取你上传到 OSS 的源码,按照配置高效完成构建和部署,帮你助你实现资源管理与交付流程的统一。

新建 MCP 服务,点击 OSS 上传,你可以选择你当前账号下的 Bucket 和 Object 目录,如果上传的 Object 为 ZIP 压缩文件,平台会自动帮你解压缩,在代码根目录下执行构建命令,同样填写运行配置、资源配置和网络配置后(步骤与第一节相同),点击部署,便可将你的代码部署至 Function AI 平台。

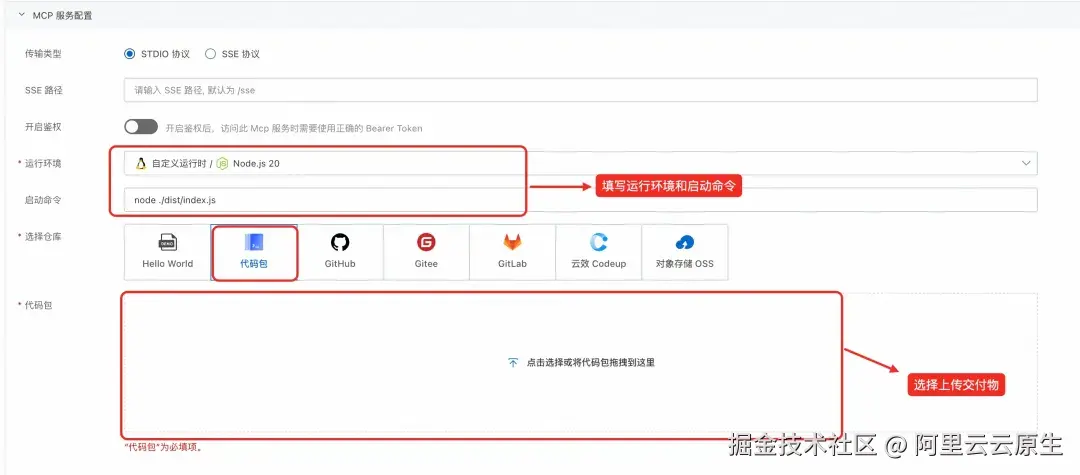

3. 上传本地构建交付物

如果你觉得在本地构建的方式更加自由和灵活,Function AI 提供了上传本地交付物直接进行部署的能力。你可以本地编译、打包好可执行文件(例如二进制文件、JAR 包、安装好依赖的解释性语言包等)后,即可通过 ZIP 压缩包上传至 Function AI,由平台自动完成部署,无需平台端二次构建,大幅缩短部署周期。

新建 MCP 服务,点击代码包上传,你可以将你本地的构建好的交付物压缩为 ZIP 文件,拖拽至控制台进行上传。平台会自动帮你解压缩。由于你上传的是交付文件,平台将不为你进行代码构建,在填写运行配置、资源配置和网络配置后(步骤与第一节相同),点击部署,便可将你的交付物部署至 Function AI 平台。

4. 镜像上传至 ACR,平台自动部署

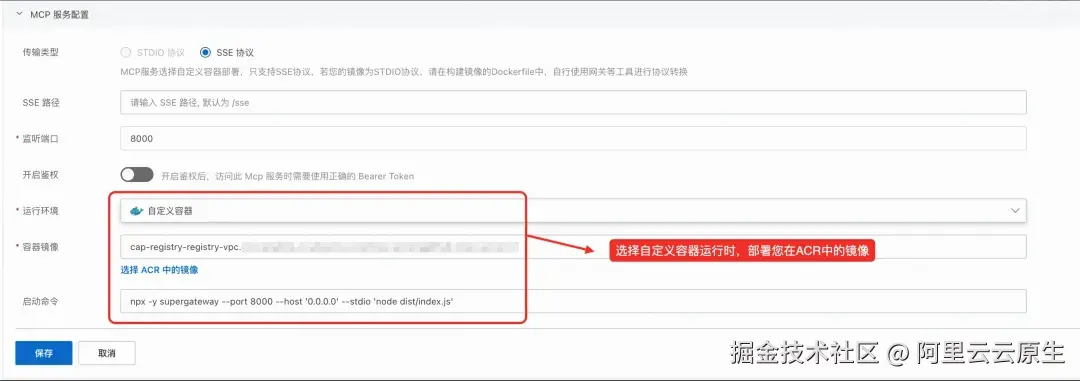

考虑到 MCP 服务的定制遇到复杂运行环境时,传统的基于程序语言的运行时可能不能满足你的需求,Function AI 提供了容器化的部署方式。

新建 MCP 服务,选择自定义容器作为运行环境,将本地构建的 MCP 服务的 Docker 镜像上传至阿里云 ACR 镜像仓库,填写监听端口和启动命令。Function AI 平台拉取镜像后立即部署,兼容 DevOps 流程,保障一致性与可控性。

注:MCP 服务镜像部署只支持 SSE 协议,你可以使用相应开源 Proxy,完成 STDIO 协议和 SSE 协议的转换。

面向未来,打造开放且高效的 Serverless AI 应用开发平台

Function AI 致力于支持 MCP 服务开发的每一个阶段,无论你是独立开发者还是企业技术团队,使用 MCP 协议自研代码,都可凭借 Function AI 平台,享受:

- 一键式 MCP 代码部署体验

- 灵活适配不同需求研发流程

- 快速联通云端 AI 资源

- 版本管理与可追踪上线

让每一次本地创新,都能自在上云,融入智能生态。现在就来体验 Function AI 的强大云端部署能力,让你的 MCP 服务模型更快、更安全、更智能地服务业务创新!

【1】Function AI 平台

cap.console.aliyun.com/explore

【2】使用OSS缓存插件加速构建

help.aliyun.com/zh/function...

点击此处,立即体验 Function AI 的强大云端部署能力