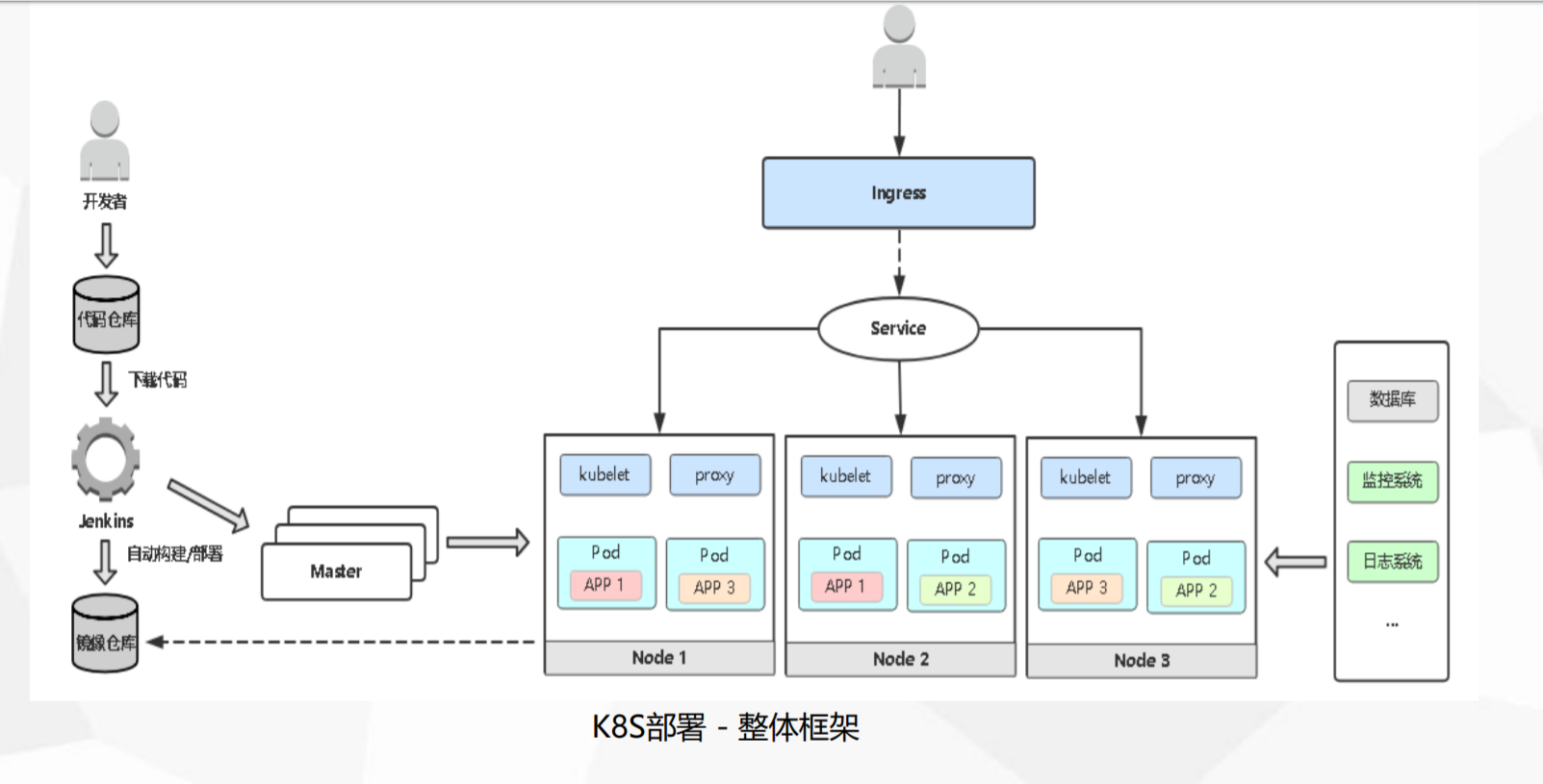

Kubernetes(简称K8s)作为当前最流行的容器编排平台,在企业生产环境中的部署需要综合考虑高可用性、安全性、性能优化等多方面因素。本文将详细介绍K8s生产环境部署的最佳实践方案,并针对常见问题提供解决方案,帮助您构建稳定可靠的生产级K8s集群。

一、生产环境K8s部署架构设计

1.1 高可用架构设计

生产环境K8s集群必须采用高可用(HA)架构,确保关键组件无单点故障。典型的高可用架构包含以下核心组件:

(示意图展示控制平面与工作节点的高可用部署)

控制平面高可用:

- kube-apiserver:至少部署3个实例,通过负载均衡对外提供服务

- etcd集群:采用3或5个节点组成分布式集群,跨可用区(AZ)部署

- 调度器与控制器:通过Leader选举机制确保只有一个活跃实例

工作节点高可用:

- 采用多节点分布,建议至少3个通用Worker节点和专用GPU节点(如AI负载)

- 通过Pod反亲和性策略分散应用副本到不同节点

- 配置PodDisruptionBudget(PDB)控制维护期间受影响Pod数量

1.2 节点规划与资源配置

生产环境节点应分层规划,典型配置如下:

| 节点类型 | 数量 | 配置示例 | 用途说明 |

|---|---|---|---|

| Control节点 | 3 | 4C8G,100GB SSD | 运行控制平面组件 |

| 通用Worker节点 | ≥3 | 16C32G,200GB SSD | 运行常规业务应用 |

| GPU Worker节点 | ≥2 | 16C64G+GPU,500GB | 运行AI/ML等GPU密集型工作负载 |

| 存储节点 | 3 | 8C32G,1TB NVMe | 提供分布式存储服务 |

表:生产环境K8s节点规划示例

1.3 网络与存储设计

网络方案:

- CNI插件选择:Calico(策略丰富)、Cilium(eBPF高性能)或Flannel(简单场景)

- 多网段隔离:建议分离K8s集群网络(如192.168.9.0/24)与存储网络(如192.168.10.0/24)

- Ingress控制器:推荐Ingress-Nginx(企业级)或Traefik(功能强大)

存储方案:

- 本地存储:OpenEBS LocalPV适合高性能需求

- 共享存储:Ceph或云厂商块存储(如AWS EBS、阿里云ESSD)

- 动态供给:通过StorageClass定义多种存储类型

二、生产环境部署步骤详解

2.1 基础环境准备

在所有节点上执行以下准备工作:

# 安装Docker容器运行时

sudo apt-get update

sudo apt-get install -y docker.io

sudo systemctl enable docker && sudo systemctl start docker

# 安装kubeadm/kubelet/kubectl

sudo apt-get install -y apt-transport-https curl

curl -s https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add -

echo "deb https://apt.kubernetes.io/ kubernetes-xenial main" | sudo tee /etc/apt/sources.list.d/kubernetes.list

sudo apt-get update

sudo apt-get install -y kubeadm kubelet kubectl代码:基础环境安装命令

2.2 控制平面初始化

在主节点上执行集群初始化:

# 使用kubeadm初始化HA控制平面

kubeadm init --control-plane-endpoint "LOAD_BALANCER_DNS:6443" \

--pod-network-cidr=192.168.0.0/16 \

--upload-certs

# 配置kubectl访问

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

# 安装Calico网络插件

kubectl apply -f https://docs.projectcalico.org/manifests/calico.yaml代码:控制平面初始化命令

2.3 工作节点加入集群

在每个工作节点上执行加入命令:

kubeadm join <控制平面负载均衡IP>:6443 \

--token <token> \

--discovery-token-ca-cert-hash sha256:<hash> \

--certificate-key <cert-key>代码:工作节点加入集群命令

2.4 关键组件部署

负载均衡配置:

- 使用HAProxy+Keepalived实现kube-apiserver负载均衡

- 配置TCP 6443端口的健康检查

存储配置:

# 创建StorageClass示例

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: fast

provisioner: kubernetes.io/gce-pd

parameters:

type: pd-ssd代码:存储类定义示例

监控告警部署:

# 安装Prometheus监控栈

kubectl apply -f https://raw.githubusercontent.com/coreos/kube-prometheus/main/manifests/setup

kubectl apply -f https://raw.githubusercontent.com/coreos/kube-prometheus/main/manifests/代码:监控系统安装命令

三、常见生产环境问题与解决方案

3.1 Pod启动异常

问题现象:

- Pod处于Pending状态

- CrashLoopBackOff错误

- 容器无法启动

解决方案:

-

检查资源配额:

kubectl describe pod <pod-name> | grep -A 10 Events

kubectl get nodes -o json | jq '.items[].status.allocatable' -

排查网络插件:

kubectl get pods -n kube-system | grep calico

kubectl logs <calico-pod-name> -n kube-system -

验证存储卷:

kubectl describe pvc <pvc-name>

kubectl get storageclass

排查流程参考

3.2 集群性能问题

常见性能瓶颈:

- etcd写入延迟高

- kube-apiserver过载

- 节点资源不足

优化方案:

-

etcd优化:

-

使用SSD磁盘,确保延迟<10ms

-

定期压缩历史数据:

etcdctl --endpoints=https://127.0.0.1:2379 defrag

-

-

kube-apiserver优化:

- 启用API优先级和公平性(APF)

- 配置--max-requests-inflight和--max-mutating-requests-inflight参数

-

节点优化:

-

配置合理的requests/limits

-

使用PodAntiAffinity分散负载:

affinity:

podAntiAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

- labelSelector:

matchExpressions:

- key: app

operator: In

values: [my-app]

topologyKey: "kubernetes.io/hostname"

-

3.3 网络问题排查

常见网络故障:

- Pod间无法通信

- 服务域名解析失败

- 外部访问异常

诊断步骤:

-

检查基础网络连通性:

kubectl run -it --rm --image=nicolaka/netshoot testnet -- /bin/bash

在测试容器中执行

ping <目标IP>

curl -v http://<service-name>.<namespace>.svc.cluster.local -

验证网络策略:

kubectl get networkpolicy -A

kubectl describe networkpolicy <policy-name> -

检查DNS解析:

kubectl get svc -n kube-system | grep kube-dns

kubectl run -it --rm --image=busybox:1.28 busybox -- nslookup kubernetes.default

3.4 安全加固措施

生产环境必备安全配置:

-

RBAC权限控制:

- 遵循最小权限原则

- 定期审计权限分配

-

Pod安全策略:

-

限制特权容器

-

启用安全上下文:

securityContext:

runAsNonRoot: true

allowPrivilegeEscalation: false

capabilities:

drop: ["ALL"]

-

-

网络策略:

- 默认拒绝所有流量

- 按需开放必要通信

-

镜像安全:

- 扫描镜像漏洞(使用Trivy、Clair等工具)

- 禁止使用latest标签

四、运维最佳实践

4.1 监控与日志

监控体系搭建:

- 指标监控:Prometheus+Granfana

- 日志收集:EFK(Elasticsearch+Fluentd+Kibana)栈

- 分布式追踪:Jaeger或Zipkin

关键监控指标:

- 节点:CPU/Memory/Disk使用率

- Pod:容器资源使用率、重启次数

- 控制平面:apiserver请求延迟、etcd写入延迟

4.2 备份与恢复

关键数据备份策略:

-

etcd备份:

ETCDCTL_API=3 etcdctl --endpoints=https://127.0.0.1:2379

--cacert=/etc/kubernetes/pki/etcd/ca.crt

--cert=/etc/kubernetes/pki/etcd/server.crt

--key=/etc/kubernetes/pki/etcd/server.key

snapshot save /var/lib/etcd/etcd-snapshot-$(date +%Y%m%d).db -

资源备份:

使用Velero备份集群资源

velero backup create <backup-name> --include-namespaces <namespaces>

4.3 升级策略

安全升级步骤:

- 备份etcd和关键资源

- 逐个升级控制平面节点

- 排空(drain)并升级工作节点

- 验证各组件兼容性

滚动升级示例:

kubectl drain <node-name> --ignore-daemonsets

sudo apt-get update && sudo apt-get upgrade -y kubeadm

sudo kubeadm upgrade apply v1.28.0

sudo apt-get upgrade -y kubelet kubectl

sudo systemctl restart kubelet

kubectl uncordon <node-name>五、典型生产场景解决方案

5.1 大规模集群部署(千节点级)

关键配置:

- 分离etcd集群与控制平面

- 使用分级API服务器

- 配置kubelet--max-pods参数(默认110)

- 优化CNI插件性能(如Cilium eBPF)

5.2 混合云/多云部署

实现方案:

- 使用KubeFed或多集群管理工具

- 统一认证授权体系

- 全局负载均衡(GLB)配置

5.3 有状态应用部署

最佳实践:

- 使用StatefulSet控制器

- 配置PodDisruptionBudget

- 选择适合的存储类

- 实现应用级数据备份

总结

生产环境K8s部署需要综合考虑架构设计、资源配置、安全合规和运维体系等多个维度。本文介绍的高可用架构、详细部署步骤以及常见问题解决方案,可以帮助您构建稳定可靠的企业级K8s平台。随着业务发展,建议持续优化集群配置,并关注K8s社区的最新动态和技术演进。

本文内容综合参考了CNCF官方文档及多家企业生产实践经验