Netty框架介绍、使用场景与教程

Netty是一个高性能、灵活可扩展的网络编程框架,专为构建高性能网络应用程序而设计。它基于Java NIO(非阻塞IO)技术,支持异步非阻塞通信和零拷贝特性,能显著提升网络应用的吞吐量和响应速度。Netty的核心优势在于其事件驱动模型和高度可定制的组件架构,开发者可以轻松实现自定义协议、编解码器和处理器,适用于各种复杂网络场景。Netty由社区维护,被广泛应用于生产环境,如阿里巴巴、Twitter等大型企业。接下来,我将从框架介绍、使用场景和教程三部分逐步解析,帮助您快速入门。

1. Netty框架介绍

Netty框架的核心组件包括:

- Channel:表示网络连接,用于数据传输。

- EventLoop:事件循环机制,处理IO事件和任务调度,实现异步非阻塞模型。

- ChannelHandler:处理器链,用于定义业务逻辑(如编解码、数据过滤)。

- Future和ChannelFuture:提供异步操作结果的处理机制,允许应用程序在操作完成后获取结果。

- ByteBuf:优化的字节缓冲区,支持零拷贝技术,减少内存开销。

Netty的设计目标是简化网络编程,开发者无需关注底层IO细节,只需专注于业务逻辑。例如,Netty的事件驱动模型能高效处理高并发连接,适用于需要低延迟的应用。框架还提供了丰富的编解码器(如HTTP、WebSocket支持),便于快速集成各种协议。Netty的异步特性使其在资源受限环境中表现优异,能有效避免线程阻塞问题。

2. Netty使用场景

Netty适用于需要高性能网络通信的各类应用场景,其灵活性和稳定性使其成为分布式系统的理想选择。主要应用包括:

-

游戏服务器开发 :Netty能处理大量实时连接,支持快速消息传递。例如,在MMORPG游戏中,Netty用于处理玩家位置同步和战斗逻辑。以下是一个简化的游戏服务器处理代码示例(基于Java):

javapublic class GameHandler extends ChannelInboundHandlerAdapter { @Override public void channelRead(ChannelHandlerContext ctx, Object msg) { GamePacket packet = (GamePacket) msg; processLogic(packet); // 业务逻辑处理 ctx.writeAndFlush(new ResponsePacket()); // 异步响应 } }此代码展示了Netty如何接收、处理和响应游戏数据包,实现高效通信。

-

分布式系统和大数据处理:在微服务架构中,Netty用于构建RPC框架(如Dubbo),支持服务间的高效通信。例如,大数据处理平台(如Spark)使用Netty处理节点间数据传输。

-

实时通信应用:如即时通讯(IM)系统或IoT设备管理,Netty的异步模型能处理海量并发连接,确保低延迟。

-

金融交易系统:高频交易平台依赖Netty的零拷贝特性,减少数据传输延迟,提升性能。

Netty在这些场景中表现出色,因为它能处理C10K问题(万级并发连接),并提供故障恢复机制,确保高可用性。

3. Netty教程入门

学习Netty的教程可以从基础开始,逐步深入。以下是简要指南:

- 基础学习 :首先理解Java NIO概念,然后通过Netty官方文档或在线教程实践。推荐资源:

-

官方文档:https://netty.io/wiki/ 提供完整API和示例。

-

入门示例:创建一个简单的Echo服务器,处理客户端消息。

javapublic class EchoServer { public static void main(String[] args) throws Exception { EventLoopGroup bossGroup = new NioEventLoopGroup(); EventLoopGroup workerGroup = new NioEventLoopGroup(); try { ServerBootstrap b = new ServerBootstrap(); b.group(bossGroup, workerGroup) .channel(NioServerSocketChannel.class) .childHandler(new ChannelInitializer<SocketChannel>() { @Override public void initChannel(SocketChannel ch) { ch.pipeline().addLast(new EchoServerHandler()); } }); ChannelFuture f = b.bind(8080).sync(); f.channel().closeFuture().sync(); } finally { bossGroup.shutdownGracefully(); workerGroup.shutdownGracefully(); } } }此代码启动一个服务器,监听8080端口,使用EchoServerHandler处理输入输出。

-

- 进阶实践:学习如何自定义编解码器(如Protobuf)、实现SSL/TLS加密,或集成Spring Boot。参考书籍如《Netty in Action》提供详细案例。

- 最佳实践:在项目中,确保使用线程池优化EventLoopGroup,避免资源泄露;监控性能指标(如吞吐量)以调优。社区资源如GitHub上的Netty示例项目(https://github.com/netty/netty/tree/4.1/example)是宝贵的学习材料。

总之,Netty是一个强大且易用的框架,通过系统学习,您可以快速构建高性能网络应用。实际开发中,建议结合具体场景选择合适的组件。

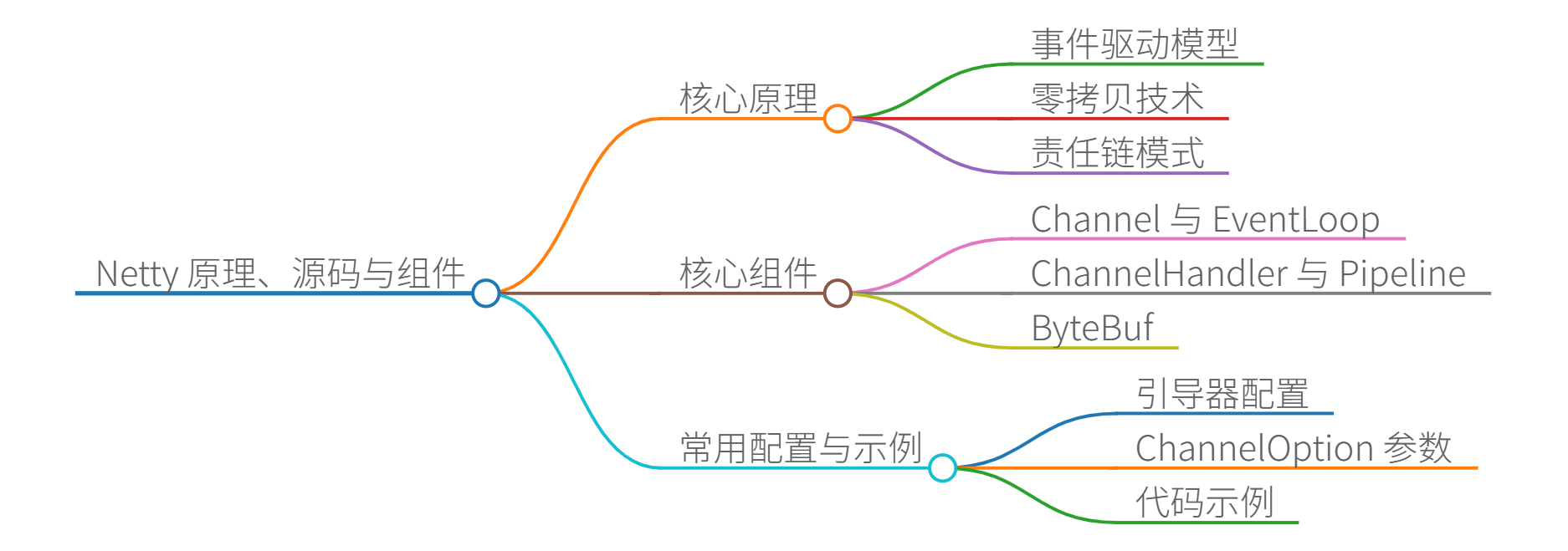

思维导图

Netty 原理详解、源码分析与核心组件

Netty 是一个基于 Java NIO 的高性能异步事件驱动框架,其核心设计围绕事件循环模型 和责任链模式实现高并发与低延迟。以下从原理、源码、组件和示例四方面深入解析。

一、核心原理详解

1. 事件驱动模型

Netty 通过 EventLoop 实现单线程处理多连接 。每个 EventLoop 绑定一个独立线程,内部采用 Selector 监听 I/O 事件(如连接建立、数据到达),事件触发后调用对应的 ChannelHandler 处理逻辑。

-

优势:避免线程频繁切换,减少资源竞争,提升吞吐量。

-

源码体现 :

io.netty.channel.nio.NioEventLoop#run中的事件循环逻辑:javaprotected void run() { for (;;) { // 1. 监听事件(select()) int selectedKeys = selector.select(timeout); // 2. 处理事件(processSelectedKeys()) processSelectedKeys(); // 3. 执行异步任务(runAllTasks()) runAllTasks(); } }

2. 零拷贝技术

- 原理 :通过

ByteBuf支持堆外内存直接操作,避免 JVM 堆与内核空间的冗余数据拷贝。 - 场景 :文件传输(

FileRegion)、网络数据聚合(CompositeByteBuf)。 - 源码关键 :

io.netty.buffer.ByteBufAllocator#directBuffer分配直接内存。

3. 责任链模式

通过 ChannelPipeline 将处理逻辑拆分为多个 ChannelHandler,形成处理链:

Inbound事件 Decoder 业务Handler Encoder Outbound事件

- Inbound:处理入站事件(如数据读取)

- Outbound:处理出站事件(如数据写入)

二、核心组件功能与源码分析

1. Channel 与 EventLoop

| 组件 | 功能说明 | 源码关键类 |

|---|---|---|

Channel |

网络连接抽象,封装 Socket 操作(读/写/连接) | NioServerSocketChannel |

EventLoop |

事件循环器,处理 I/O 事件和异步任务 | NioEventLoop |

EventLoopGroup |

管理多个 EventLoop,通常分 BossGroup(接收连接)和 WorkerGroup(处理连接) |

NioEventLoopGroup |

2. ChannelHandler 与 Pipeline

| 组件 | 功能说明 | 示例代码(引用[2]) |

|---|---|---|

ChannelHandler |

业务逻辑处理器(需实现 ChannelInboundHandler 或 ChannelOutboundHandler) |

见下方 HTTP 示例 |

ChannelPipeline |

处理器链容器,按顺序执行 Handler | ch.pipeline().addLast(...) |

源码分析:

ChannelPipeline内部使用DefaultChannelHandlerContext链表管理 Handler。- 事件传播:调用

ctx.fireChannelRead(msg)将事件传递给下一个 Handler。

3. ByteBuf

Netty 的自研字节容器,核心特性:

- 内存池化 :通过

PooledByteBufAllocator复用内存块,减少 GC 压力。 - 引用计数 :

ByteBuf.release()显式释放内存,避免泄露。 - 视图支持 :

slice()、duplicate()零拷贝拆分数据。

三、常用"注解"式配置

Netty 本身不依赖注解,但通过链式 API 实现类似注解的简洁配置:

1. 引导器配置(ServerBootstrap)

java

ServerBootstrap b = new ServerBootstrap();

b.group(bossGroup, workerGroup)

.channel(NioServerSocketChannel.class) // 指定 Channel 类型

.option(ChannelOption.SO_BACKLOG, 128) // TCP 参数

.childOption(ChannelOption.TCP_NODELAY, true) // 子 Channel 参数

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

public void initChannel(SocketChannel ch) {

// 责任链配置(类似注解式添加处理器)

ch.pipeline()

.addLast(new HttpServerCodec()) // HTTP 编解码

.addLast(new HttpObjectAggregator(65536)) // 聚合请求

.addLast(new CustomBusinessHandler()); // 业务逻辑

}

}); 2. ChannelOption 参数

| 参数 | 作用 |

|---|---|

SO_KEEPALIVE |

开启 TCP 心跳检测 |

SO_REUSEADDR |

允许端口复用 |

ALLOCATOR |

指定 ByteBuf 分配器(池化/非池化) |

四、代码示例

1. HTTP 服务器(基于引用[2]扩展)

java

public class HttpServer {

public static void main(String[] args) throws Exception {

EventLoopGroup bossGroup = new NioEventLoopGroup(1); // 接收连接

EventLoopGroup workerGroup = new NioEventLoopGroup(); // 处理连接

try {

ServerBootstrap b = new ServerBootstrap();

b.group(bossGroup, workerGroup)

.channel(NioServerSocketChannel.class)

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) {

ChannelPipeline p = ch.pipeline();

p.addLast(new HttpServerCodec()); // HTTP 编解码

p.addLast(new HttpObjectAggregator(65536)); // 聚合完整请求

p.addLast(new HttpServerHandler()); // 业务处理器

}

});

ChannelFuture f = b.bind(8080).sync();

f.channel().closeFuture().sync();

} finally {

bossGroup.shutdownGracefully();

workerGroup.shutdownGracefully();

}

}

}

// 业务处理器

public class HttpServerHandler extends SimpleChannelInboundHandler<FullHttpRequest> {

@Override

protected void channelRead0(ChannelHandlerContext ctx, FullHttpRequest req) {

// 1. 解析请求

String content = req.content().toString(CharsetUtil.UTF_8);

// 2. 处理业务逻辑

String response = "Response: " + content.toUpperCase();

// 3. 返回响应

FullHttpResponse res = new DefaultFullHttpResponse(

HttpVersion.HTTP_1_1, HttpResponseStatus.OK,

Unpooled.copiedBuffer(response, CharsetUtil.UTF_8)

);

res.headers().set(HttpHeaderNames.CONTENT_TYPE, "text/plain; charset=UTF-8");

ctx.writeAndFlush(res);

}

} 2. 自定义编解码器

java

// 解码器:将字节流转为自定义对象

public class MyDecoder extends ByteToMessageDecoder {

@Override

protected void decode(ChannelHandlerContext ctx, ByteBuf in, List<Object> out) {

if (in.readableBytes() < 4) return; // 等待足够数据

int length = in.readInt();

byte[] data = new byte[length];

in.readBytes(data);

out.add(new MyPacket(data)); // 构造业务对象

}

}

// 编码器:将对象转为字节流

public class MyEncoder extends MessageToByteEncoder<MyPacket> {

@Override

protected void encode(ChannelHandlerContext ctx, MyPacket packet, ByteBuf out) {

byte[] data = packet.getData();

out.writeInt(data.length); // 写入长度头

out.writeBytes(data); // 写入数据

}

} 五、性能优化实践

- 内存泄露检测 :

- 启用

-Dio.netty.leakDetectionLevel=PARANOID检测未释放的ByteBuf。

- 启用

- 线程模型优化 :

- I/O 密集型:

EventLoopGroup线程数 = CPU 核数 * 2 - 计算密集型:业务逻辑移交独立线程池处理。

- I/O 密集型:

- 对象池化 :

- 使用

Recycler复用ChannelHandler实例。

- 使用

学习路径建议(引用[1]):

- 入门:通过《Netty in Action》+官方示例实践。

- 进阶:阅读

EventLoop、ByteBuf、Pipeline源码。- 专家:参与 GitHub Issue 讨论,贡献代码。

思维导图