一、环境配置基础

在开始 Trae 开发之旅前,环境配置是必不可少的一步。以下是环境配置的基本步骤,结合实例分析进行详细讲解。

1.1 硬件要求

Trae 对硬件有一定要求,以保证开发过程的流畅性。以下是推荐的硬件配置:

| 配置项 | 推荐配置 | 最低配置 |

|---|---|---|

| CPU | Intel i5/i7 或同等性能处理器 | Intel i3 或同等性能处理器 |

| 内存 | 8GB 或以上 | 4GB |

| 显卡 | NVIDIA 独立显卡,显存 4GB | 集成显卡 |

| 硬盘 | SSD 128GB 可用空间 | HDD 50GB 可用空间 |

实例分析:以一台配备 Intel i5-8400、8GB 内存、NVIDIA GTX 1050Ti(4GB 显存)、256GB SSD 的电脑为例,该配置完全满足 Trae 开发的推荐要求,能够支持一般的 AI 模型训练和推理任务。

1.2 软件环境

软件环境的搭建包括操作系统、编程语言、相关库的安装等。

1.2.1 操作系统选择

Trae 支持 Windows、macOS 和 Linux 三大主流操作系统。对于初学者,推荐使用 Windows 或 macOS,因为它们的用户界面较为直观,便于操作。

- Windows:推荐 Windows 10 及以上版本,确保系统更新到最新状态。

- macOS:推荐 macOS 10.15(Catalina)及以上版本。

- Linux:对于有一定技术基础的开发者,可选择 Ubuntu 20.04 或 CentOS 7 等稳定版本。

1.2.2 Python 环境搭建

Trae 基于 Python 语言开发,因此需要搭建 Python 环境。

- 下载 Python 安装包:访问Python 官方网站,选择合适的版本进行下载。推荐使用 Python 3.8 及以上版本。

- 安装 Python:运行安装包,按照提示进行安装。确保在安装过程中勾选 "Add Python to PATH" 选项,以便在命令行中直接使用 Python。

- 验证安装:打开命令行(Windows 下为 cmd 或 PowerShell,macOS/Linux 下为 Terminal),输入以下命令,检查 Python 是否安装成功:

bash

python --version成功安装后,将显示已安装的 Python 版本号。

1.2.3 相关库安装

Trae 开发需要安装一些必要的 Python 库,如 NumPy、Pandas、Matplotlib 等。使用 pip 命令进行安装:

bash

pip install numpy pandas matplotlib以安装 NumPy 库为例,执行上述命令后,pip 将自动下载并安装 NumPy 及其依赖项。

1.3 GPU 加速配置

为了提高 AI 模型的训练速度,可以配置 GPU 加速。

1.3.1 安装 CUDA 和 cuDNN

CUDA 是 NVIDIA 推出的并行计算平台和编程模型,cuDNN 是 CUDA 深度神经网络库,它们共同为深度学习提供 GPU 加速支持。

- 下载 CUDA 和 cuDNN:访问 NVIDIA 官方网站,根据 GPU 型号和系统信息下载对应的 CUDA 和 cuDNN 版本。

- 安装 CUDA:运行 CUDA 安装包,按照提示进行安装。安装过程中可能需要重启计算机。

- 安装 cuDNN:将下载的 cuDNN 文件解压后,将其中的文件复制到 CUDA 安装目录下的相应文件夹中。

1.3.2 验证 GPU 加速

通过以下 Python 代码验证 GPU 加速是否配置成功:

python

import tensorflow as tf

# 检查是否启用 GPU 加速

if tf.test.is_gpu_available():

print("GPU 加速已启用")

else:

print("未启用 GPU 加速")运行上述代码,若输出 "GPU 加速已启用",则说明 GPU 加速配置成功。

1.4 环境配置总结(使用 mermaid 绘制思维导图)

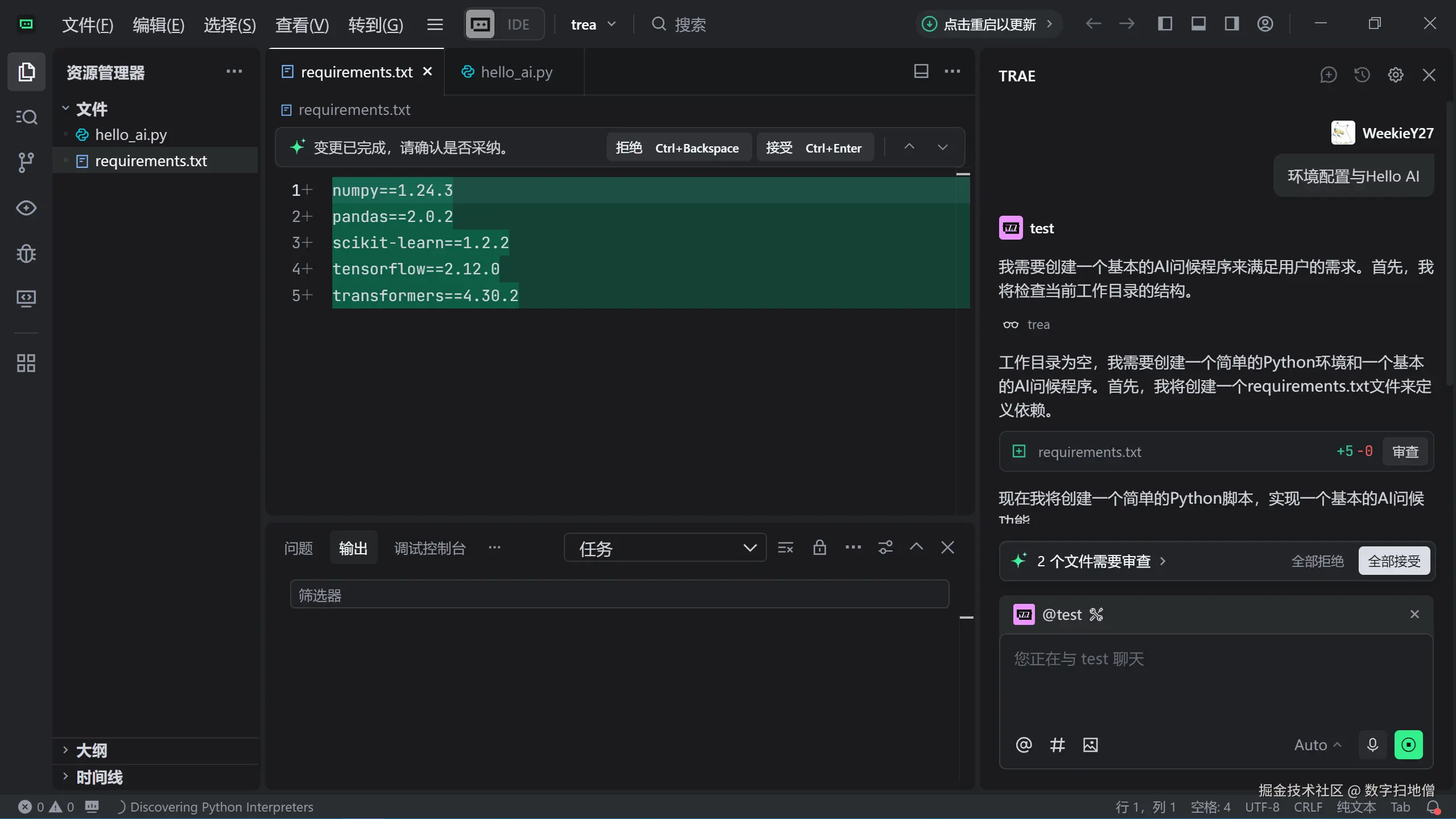

二、Hello AI 实现过程

在完成环境配置后,接下来将实现一个简单的 "Hello AI" 示例,帮助读者快速上手 Trae 开发。

2.1 创建第一个 AI 模型

我们将创建一个简单的神经网络模型,用于解决二分类问题。

2.1.1 数据集准备

使用 Python 的 scikit-learn 库生成一个简单的二分类数据集。

python

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

# 生成二分类数据集

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=42)

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)上述代码生成了一个包含 1000 个样本、20 个特征的二分类数据集,并将其划分为训练集(80%)和测试集(20%)。

2.1.2 模型构建

使用 Trae 提供的 API 构建神经网络模型。

python

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# 构建神经网络模型

model = Sequential()

model.add(Dense(64, activation='relu', input_shape=(20,))) # 输入层,20 个神经元

model.add(Dense(32, activation='relu')) # 隐藏层,32 个神经元

model.add(Dense(1, activation='sigmoid')) # 输出层,1 个神经元,使用 sigmoid 激活函数

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])模型构建过程如下:

- 创建一个 Sequential 模型,它是多个网络层的线性堆叠。

- 添加输入层,包含 64 个神经元,激活函数为 ReLU,输入形状为 20(与数据集特征数一致)。

- 添加隐藏层,包含 32 个神经元,激活函数为 ReLU。

- 添加输出层,包含 1 个神经元,激活函数为 sigmoid,适用于二分类问题。

- 编译模型,选择 Adam 优化器、二元交叉熵损失函数,并监控准确率指标。

2.1.3 模型训练

使用训练集对模型进行训练。

python

# 训练模型

history = model.fit(X_train, y_train, epochs=10, batch_size=32, validation_split=0.2)训练过程参数说明:

- epochs=10:训练 10 个周期,即整个训练集将被迭代 10 次。

- batch_size=32:每个批次使用 32 个样本进行训练。

- validation_split=0.2:从训练集中划分 20% 的数据作为验证集,用于监控模型在训练过程中的性能。

2.1.4 模型评估

在测试集上评估模型性能。

python

# 评估模型

loss, accuracy = model.evaluate(X_test, y_test)

print(f"测试集损失:{loss}, 测试集准确率:{accuracy}")输出测试集上的损失值和准确率,评估模型的泛化能力。

2.2 模型优化与调整

为了提高模型性能,可以从以下几个方面进行优化和调整。

2.2.1 调整模型结构

尝试增加神经网络的层数或神经元数量,以增强模型的表达能力。

python

# 调整后的模型结构

model = Sequential()

model.add(Dense(128, activation='relu', input_shape=(20,)))

model.add(Dense(64, activation='relu'))

model.add(Dense(32, activation='relu'))

model.add(Dense(1, activation='sigmoid'))增加神经元数量和层数后,模型可能具有更强的学习能力,但也可能导致过拟合。

2.2.2 调整超参数

超参数包括学习率、批次大小、正则化参数等,对模型性能有重要影响。

- 调整学习率:

python

from tensorflow.keras.optimizers import Adam

# 调整学习率

optimizer = Adam(learning_rate=0.001)

model.compile(optimizer=optimizer, loss='binary_crossentropy', metrics=['accuracy'])降低学习率有助于模型更稳定地收敛,但可能需要更多的训练周期。

- 调整批次大小:

python

# 调整批次大小

history = model.fit(X_train, y_train, epochs=10, batch_size=64, validation_split=0.2)增大批次大小可以提高训练速度,但可能会影响模型的泛化能力。

2.2.3 添加正则化

为防止模型过拟合,可以添加正则化项,如 L1 或 L2 正则化。

python

from tensorflow.keras.regularizers import l2

# 添加 L2 正则化

model = Sequential()

model.add(Dense(64, activation='relu', input_shape=(20,), kernel_regularizer=l2(0.01)))

model.add(Dense(32, activation='relu', kernel_regularizer=l2(0.01)))

model.add(Dense(1, activation='sigmoid'))L2 正则化通过在损失函数中添加权重的平方和项,限制模型的复杂度,从而减少过拟合。

2.3 Hello AI 实现总结(使用 mermaid 绘制流程图)

三、常见问题解答

在 Trae 开发过程中,可能会遇到一些常见问题,以下是针对这些问题的解答。

3.1 环境配置相关问题

3.1.1 Python 版本冲突

问题描述:安装 Trae 及其依赖库时,提示 Python 版本冲突。

解决方案:

- 确保 Python 版本符合要求(3.8 及以上)。

- 使用虚拟环境隔离不同项目的依赖。创建虚拟环境的命令如下:

bash

# 创建虚拟环境

python -m venv myenv

# 激活虚拟环境(Windows)

myenv\Scripts\activate

# 激活虚拟环境(macOS/Linux)

source myenv/bin/activate激活虚拟环境后,再安装相关库,可避免版本冲突问题。

3.1.2 CUDA 和 cuDNN 版本不匹配

问题描述:安装 CUDA 和 cuDNN 后,提示版本不匹配。

解决方案:

- 查看 TensorFlow 官方网站支持的 CUDA 和 cuDNN 版本,确保安装的版本与之匹配。

- 根据 TensorFlow 版本,下载对应的 CUDA 和 cuDNN 版本。例如,TensorFlow 2.x 可能需要 CUDA 11.x 和 cuDNN 8.x。

3.2 模型训练相关问题

3.2.1 模型训练缓慢

问题描述:模型训练速度过慢,耗费大量时间。

可能原因及解决方案:

- 硬件性能不足:检查 CPU、内存、显卡是否满足要求。若显卡支持 GPU 加速,确保已正确配置并启用。

- 数据集过大:尝试对数据集进行采样或使用数据生成器(Data Generator)逐步加载数据。

- 模型结构复杂:简化模型结构,减少神经元数量或层数。

3.2.2 模型过拟合

问题描述:模型在训练集上表现良好,但在测试集上性能较差,出现过拟合现象。

解决方案:

- 增加数据量:通过数据增强技术(如旋转、平移、缩放等)扩充数据集。

- 添加正则化:在模型中添加 L1 或 L2 正则化项。

- 采用早停法(Early Stopping):在训练过程中,当验证集性能不再提升时,提前停止训练。

python

from tensorflow.keras.callbacks import EarlyStopping

# 添加早停法

early_stopping = EarlyStopping(monitor='val_loss', patience=3)

history = model.fit(X_train, y_train, epochs=10, batch_size=32, validation_split=0.2, callbacks=[early_stopping])3.3 模型部署相关问题

3.3.1 模型部署到生产环境

问题描述:如何将训练好的模型部署到生产环境,供其他应用程序调用。

解决方案:

- 保存模型:训练完成后,使用以下代码保存模型:

python

# 保存模型

model.save('my_model.h5')- 加载模型:在生产环境中,使用以下代码加载保存的模型:

python

from tensorflow.keras.models import load_model

# 加载模型

model = load_model('my_model.h5')- 搭建 API 服务:使用 Flask 或 FastAPI 等框架,将模型封装为 RESTful API 服务。

python

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/predict', methods=['POST'])

def predict():

data = request.get_json()

input_data = data['input']

prediction = model.predict(input_data)

return jsonify({'prediction': prediction.tolist()})

if __name__ == '__main__':

app.run(host='0.0.0.0', port=5000)上述代码创建了一个简单的 Flask 应用,监听 5000 端口,接收 POST 请求并返回模型预测结果。

3.4 常见问题解答总结(使用 mermaid 绘制思维导图)

四、进阶技巧介绍

掌握基础知识后,可以学习一些进阶技巧,提升开发效率和模型性能。

4.1 数据增强技术

数据增强是一种通过生成新样本扩充数据集的技术,有助于提高模型的泛化能力。

4.1.1 图像数据增强

以图像分类任务为例,使用 TensorFlow 的 ImageDataGenerator 类进行数据增强。

python

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 图像数据增强

datagen = ImageDataGenerator(

rotation_range=20, # 随机旋转角度范围

width_shift_range=0.2, # 水平平移范围

height_shift_range=0.2, # 垂直平移范围

shear_range=0.2, # 剪切变换角度

zoom_range=0.2, # 随机缩放范围

horizontal_flip=True, # 水平翻转

fill_mode='nearest' # 填充模式

)

# 应用数据增强

datagen.fit(X_train)上述代码对训练集图像数据进行了多种增强操作,生成更多样化的训练样本。

4.1.2 文本数据增强

对于文本数据,可通过同义词替换、随机插入、随机交换等方法进行增强。

python

import numpy as np

import nltk

from nltk.corpus import wordnet

nltk.download('wordnet')

# 同义词替换

def synonym_replacement(text, n_replacements=1):

words = text.split()

for _ in range(n_replacements):

if len(words) == 0:

break

random_word = np.random.choice(words)

synonyms = get_synonyms(random_word)

if len(synonyms) > 0:

replacement = np.random.choice(synonyms)

text = text.replace(random_word, replacement)

return text

# 获取同义词

def get_synonyms(word):

synonyms = set()

for syn in wordnet.synsets(word):

for lemma in syn.lemmas():

synonyms.add(lemma.name().lower().replace('_', ' '))

return list(synonyms)上述代码实现了简单的同义词替换功能,对文本数据进行增强。

4.2 转移学习

转移学习是一种利用预训练模型解决新问题的技术,可显著减少训练数据量和计算资源。

4.2.1 加载预训练模型

使用 TensorFlow Hub 加载预训练模型,并进行微调(Fine-tuning)。

python

import tensorflow_hub as hub

# 加载预训练模型

model_url = "https://tfhub.dev/google/tf2-preview/mobilenet_v2/feature_vector/4"

pretrained_model = hub.KerasLayer(model_url, input_shape=(224, 224, 3), trainable=False)

# 构建新模型

model = Sequential()

model.add(pretrained_model)

model.add(Dense(256, activation='relu'))

model.add(Dense(num_classes, activation='softmax'))

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])上述代码加载了一个预训练的 MobileNetV2 模型,将其作为特征提取器,并在其后添加新的分类层。

4.2.2 微调预训练模型

在新数据集上微调预训练模型,进一步提升性能。

python

# 解冻预训练模型的部分层进行微调

pretrained_model.trainable = True

for layer in pretrained_model.layers[:-4]:

layer.trainable = False

# 重新编译模型

model.compile(optimizer=tf.keras.optimizers.Adam(1e-5), loss='categorical_crossentropy', metrics=['accuracy'])

# 继续训练模型

history = model.fit(X_train, y_train, epochs=5, batch_size=32, validation_split=0.2)通过微调预训练模型的部分层,使模型更好地适应新数据集。

4.3 模型压缩与优化

为了在资源受限的设备上部署模型,可以对模型进行压缩和优化。

4.3.1 模型量化

将模型的权重从 32 位浮点数量化为 8 位整数,减小模型大小并提高推理速度。

python

import tensorflow as tf

# 加载模型

model = tf.keras.models.load_model('my_model.h5')

# 量化模型

converter = tf.lite.TFLiteConverter.from_keras_model(model)

converter.optimizations = [tf.lite.Optimize.DEFAULT]

quantized_model = converter.convert()

# 保存量化后的模型

with open('quantized_model.tflite', 'wb') as f:

f.write(quantized_model)量化后的模型文件大小显著减小,适合在移动设备或嵌入式系统上运行。

4.3.2 模型剪枝

通过移除模型中不重要的连接或神经元,减小模型规模。

python

import tensorflow_model_optimization as tfmot

# 应用模型剪枝

pruning_params = {

'pruning_schedule': tfmot.sparsity.keras.PolynomialDecay(initial_sparsity=0.0,

final_sparsity=0.5,

begin_step=0,

end_step=1000)

}

prune_low_magnitude = tfmot.sparsity.keras.prune_low_magnitude

pruned_model = prune_low_magnitude(model, **pruning_params)

# 编译剪枝后的模型

pruned_model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练剪枝后的模型

callbacks = [tfmot.sparsity.keras.UpdatePruningStep()]

history = pruned_model.fit(X_train, y_train, epochs=10, batch_size=32, validation_split=0.2, callbacks=callbacks)

# 去除剪枝包装器,得到最终剪枝模型

model_for_export = tfmot.sparsity.keras.strip_pruning(pruned_model)

# 保存剪枝后的模型

model_for_export.save('pruned_model.h5')剪枝后的模型在保持性能的同时,减少了参数数量和计算量。