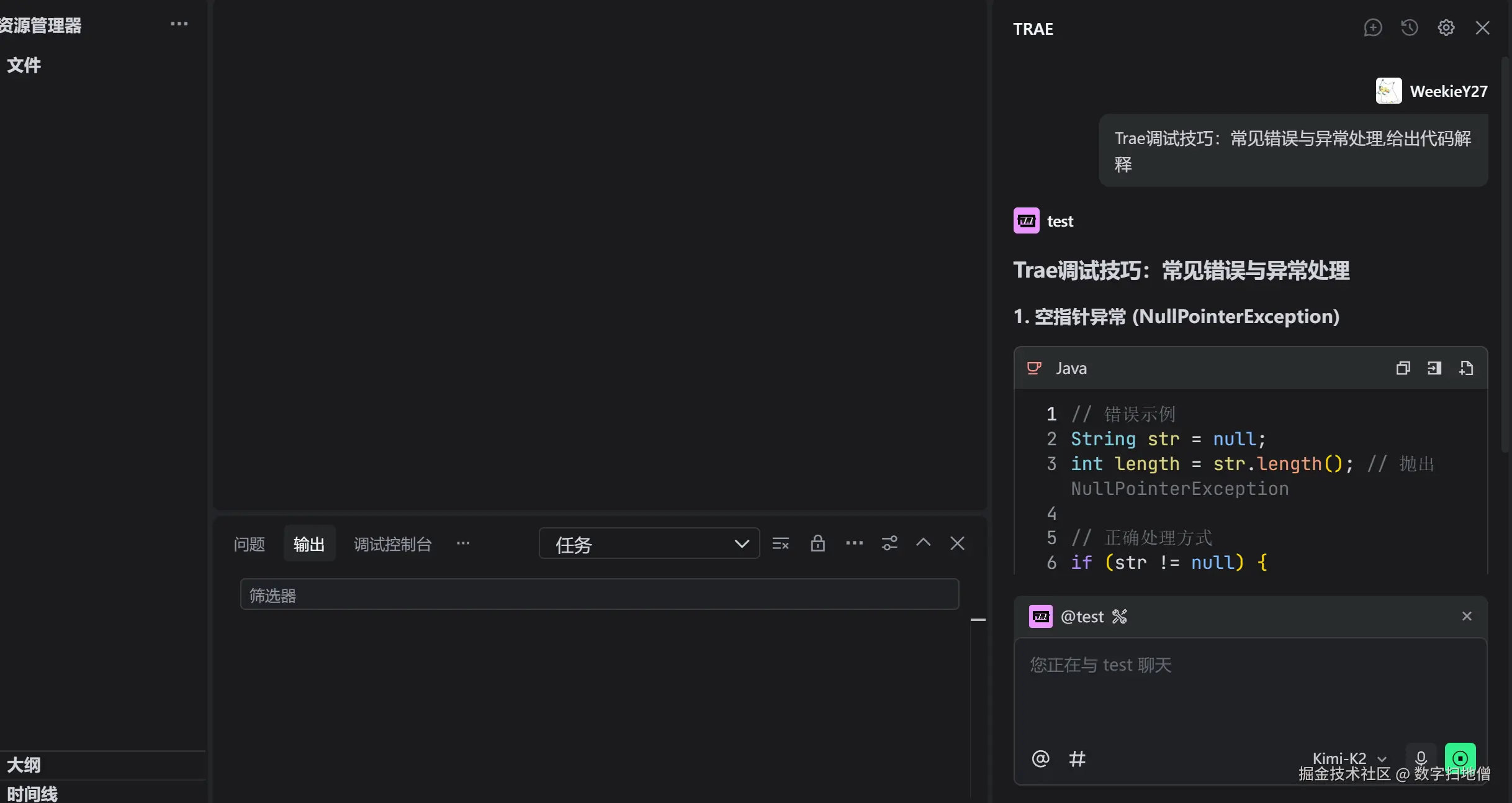

I. 引言

在深度学习模型开发过程中,调试是不可或缺的一部分。无论是初学者还是经验丰富的开发者,都可能在使用 Trae 框架时遇到各种错误和异常。本文将深入探讨 Trae 中常见的错误类型及其处理方法,通过实际案例分析,帮助读者快速定位和解决问题,提高开发效率。

在深度学习模型开发过程中,调试是不可或缺的一部分。无论是初学者还是经验丰富的开发者,都可能在使用 Trae 框架时遇到各种错误和异常。本文将深入探讨 Trae 中常见的错误类型及其处理方法,通过实际案例分析,帮助读者快速定位和解决问题,提高开发效率。

II. 常见错误分类与处理

2.1 环境配置错误

环境配置错误通常发生在项目初始化阶段,可能由于依赖版本不兼容、环境变量设置错误等原因引起。

2.1.1 版本兼容性问题

错误示例:安装了不兼容的 Trae 和 CUDA 版本,导致导入模块时出现错误。

解决方法:

- 查看 Trae 官方文档,确认兼容的 CUDA 和 cuDNN 版本。

- 使用虚拟环境隔离项目依赖,避免版本冲突。

bash

# 创建并激活虚拟环境

python -m venv trae_venv

source trae_venv/bin/activate # macOS/Linux

# 或

trae_venv\Scripts\activate # Windows

# 安装指定版本的 Trae 和 CUDA 工具包

pip install tensorflow==2.10.02.1.2 环境变量错误

错误示例:未正确设置 GPU 可见性环境变量,导致 Trae 无法识别 GPU。

解决方法:

- 在代码运行前设置环境变量,指定可用的 GPU 设备。

python

import os

os.environ["CUDA_VISIBLE_DEVICES"] = "0" # 仅使用第 1 块 GPU2.2 数据相关错误

数据相关错误通常发生在数据加载和预处理阶段,可能由于数据格式错误、数据管道配置不当等原因引起。

2.2.1 数据格式错误

错误示例:尝试加载损坏的图像文件或格式不支持的文件。

解决方法:

- 在数据加载前进行数据验证,跳过损坏的文件。

- 使用健壮的数据读取库,如 Pillow 或 OpenCV,并捕获异常。

python

from PIL import Image

def load_image(file_path):

try:

with Image.open(file_path) as img:

return np.array(img)

except IOError:

print(f"Error loading image: {file_path}")

return None2.2.2 数据管道配置错误

错误示例:数据管道批量化设置不当,导致维度不匹配错误。

解决方法:

- 确保数据管道的输出维度与模型输入维度一致。

- 使用

trae.data.Dataset的batch方法时,检查drop_remainder参数设置。

python

dataset = dataset.batch(32, drop_remainder=True)2.3 模型构建错误

模型构建错误通常发生在模型定义和编译阶段,可能由于层配置错误、输入输出形状不匹配等原因引起。

2.3.1 层配置错误

错误示例:使用了不正确的层参数,导致层输出形状不符合预期。

解决方法:

- 仔细查阅层的文档,确保参数设置正确。

- 使用

model.summary()检查模型各层的输入输出形状。

python

model = trae.keras.Sequential([

trae.keras.layers.Dense(64, activation='relu', input_shape=(20,)),

trae.keras.layers.Dense(32, activation='relu'),

trae.keras.layers.Dense(1, activation='sigmoid')

])

model.summary()2.3.2 输入输出形状不匹配

错误示例:模型输入形状与数据管道输出形状不一致,导致训练时出现错误。

解决方法:

- 确保模型的

input_shape参数与数据管道的输出形状匹配。 - 在模型编译前,验证数据批次的形状。

python

for batch in dataset.take(1):

print(f"Batch shape: {batch[0].shape}") # 检查输入数据形状

print(f"Label shape: {batch[1].shape}") # 检查标签形状2.4 训练过程错误

训练过程错误通常发生在模型训练阶段,可能由于优化器配置错误、损失函数选择不当等原因引起。

2.4.1 优化器配置错误

错误示例:设置了不合理的学习率,导致模型训练不稳定。

解决方法:

- 使用学习率调度器动态调整学习率。

- 尝试不同的优化器,如 Adam、RMSprop 等。

python

optimizer = trae.keras.optimizers.Adam(learning_rate=0.001)

# 或使用学习率指数衰减

lr_schedule = trae.keras.optimizers.schedules.ExponentialDecay(

initial_learning_rate=0.01,

decay_steps=10000,

decay_rate=0.96

)

optimizer = trae.keras.optimizers.SGD(learning_rate=lr_schedule)2.4.2 损失函数选择不当

错误示例:在多分类问题中使用了二元交叉熵损失函数,导致训练效果不佳。

解决方法:

- 根据问题类型选择正确的损失函数(如多分类使用稀疏分类交叉熵)。

- 确保标签格式与损失函数要求一致。

python

# 多分类问题应使用 SparseCategoricalCrossentropy

model.compile(

optimizer='adam',

loss=trae.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy']

)2.5 部署相关错误

部署相关错误通常发生在模型保存、加载和推理阶段,可能由于模型格式不兼容、依赖缺失等原因引起。

2.5.1 模型格式不兼容

错误示例:尝试加载使用不同框架保存的模型文件,导致格式错误。

解决方法:

- 统一模型保存和加载的框架,优先使用 Trae 的模型保存格式。

- 使用兼容的模型转换工具,如 ONNX。

python

# 保存模型

model.save('model.h5')

# 加载模型

loaded_model = trae.keras.models.load_model('model.h5')2.5.2 依赖缺失

错误示例:在部署环境中缺少运行推理所需的依赖库。

解决方法:

- 创建包含所有必要依赖的部署包。

- 使用容器化技术(如 Docker)确保环境一致性。

dockerfile

# Dockerfile 示例

FROM python:3.8-slim

WORKDIR /app

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

COPY . .

CMD ["python", "inference_script.py"]2.6 错误分类与处理总结(mermaid)

III. Trae调试工具与技巧

3.1 内置调试工具

Trae 提供了丰富的内置调试工具,帮助开发者快速定位问题。

3.1.1 TensorBoard

TensorBoard 是 Trae 的可视化工具,可用于监控训练指标、调试模型结构等。

python

# 启用 TensorBoard 回调

tensorboard_callback = trae.keras.callbacks.TensorBoard(log_dir='./logs')

model.fit(

train_dataset,

epochs=10,

validation_data=val_dataset,

callbacks=[tensorboard_callback]

)| TensorBoard 功能 | 说明 |

|---|---|

| 标量监控 | 可视化损失函数值、准确率等标量指标随训练进度的变化。 |

| 图模型结构 | 可视化模型的计算图,帮助检查层连接和数据流。 |

| 分布与直方图 | 监控模型权重和梯度的分布情况,识别潜在的训练问题(如梯度爆炸或消失)。 |

3.1.2 Debugger

Trae 提供了命令行调试器,可用于逐步执行代码、检查张量值等。

bash

# 启动调试器

trae --debug run your_script.py| 调试命令 | 说明 |

|---|---|

run |

运行程序直到断点或错误发生。 |

step |

逐行执行代码,进入函数调用。 |

next |

逐行执行代码,不进入函数调用。 |

break |

设置断点,指定在某一行暂停执行。 |

print |

打印张量或变量的值,检查中间结果。 |

3.2 自定义日志与断言

通过自定义日志和断言,可以在关键位置输出调试信息。

3.2.1 自定义日志

使用 Python 的 logging 模块记录调试信息。

python

import logging

logging.basicConfig(level=logging.DEBUG)

logger = logging.getLogger(__name__)

# 在关键位置添加日志

logger.debug("Input shape: %s", input_tensor.shape)

logger.info("Starting training loop...")3.2.2 断言检查

在代码中插入断言,验证关键条件是否满足。

python

# 断言检查输入数据形状

assert input_tensor.shape[1:] == (224, 224, 3), f"Invalid input shape: {input_tensor.shape}"3.3 梯度检查与调试

梯度问题是深度学习调试中的常见难题,以下是一些实用技巧。

3.3.1 检查梯度值

在训练循环中打印梯度值,检查是否存在异常。

python

with trae.GradientTape() as tape:

logits = model(inputs, training=True)

loss = loss_fn(labels, logits)

gradients = tape.gradient(loss, model.trainable_variables)

# 打印梯度信息

for var, grad in zip(model.trainable_variables, gradients):

print(f"{var.name} - Gradient Mean: {trae.reduce_mean(trae.abs(grad))}")3.3.2 梯度裁剪

为防止梯度爆炸,可应用梯度裁剪。

python

# 应用梯度裁剪

gradients, _ = trae.clip_by_global_norm(gradients, clip_norm=1.0)

optimizer.apply_gradients(zip(gradients, model.trainable_variables))3.4 调试工具与技巧总结(mermaid)

IV. 实战案例分析

通过实际案例展示如何应用上述调试技巧解决问题。

4.1 案例一:模型训练无收敛

4.1.1 问题描述

在训练一个图像分类模型时,损失函数不下降,准确率停滞在较低水平。

4.1.2 问题排查

- 检查数据管道:验证训练数据是否正确加载和预处理。

- 检查模型配置:确认模型架构和编译参数正确。

- 检查训练循环:确保优化器和损失函数配置正确。

4.1.3 解决方法

- 发现数据增强步骤中图像标准化方式与模型输入要求不一致,修正标准化参数。

- 将学习率从 0.1 降低到 0.001,并启用学习率衰减。

- 更换优化器为 Adam,提高训练稳定性。

python

# 修正后的训练代码

model.compile(

optimizer=trae.keras.optimizers.Adam(learning_rate=0.001),

loss=trae.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy']

)

# 使用学习率衰减

lr_scheduler = trae.keras.callbacks.ReduceLROnPlateau(

monitor='val_loss',

factor=0.5,

patience=3,

min_lr=1e-6

)

model.fit(

train_dataset,

epochs=50,

validation_data=val_dataset,

callbacks=[lr_scheduler]

)4.1.4 调试总结

通过系统性地检查数据、模型和训练配置,定位并解决了训练无收敛问题。强调了数据预处理和超参数调整的重要性。

4.2 案例二:模型推理结果不一致

4.2.1 问题描述

在不同环境下加载同一模型进行推理时,得到不同的结果。

4.2.2 问题排查

- 检查模型文件完整性:验证模型文件是否在传输过程中损坏。

- 检查依赖版本一致性:确认不同环境中的 Trae 和其他依赖库版本一致。

- 检查推理代码差异:对比不同环境中的推理代码实现。

4.2.3 解决方法

- 发现推理代码中未正确设置随机种子,导致部分操作(如 Dropout)行为不一致。

- 统一所有环境中的 Trae 版本为 2.10.0。

- 在推理代码中显式设置随机种子:

python

# 设置随机种子

import numpy as np

import random

import trae

SEED = 42

np.random.seed(SEED)

random.seed(SEED)

trae.random.set_seed(SEED)4.2.4 调试总结

推理结果不一致问题通常源于环境差异或代码实现细节,通过仔细对比和验证,确保了推理过程的确定性。

4.3 案例三:内存泄漏导致训练中断

4.3.1 问题描述

在长时间训练过程中,内存占用持续增加,最终导致内存不足错误。

4.3.2 问题排查

- 检查数据管道内存管理:验证数据加载和预处理是否释放了不必要的内存。

- 检查模型图构建:确认动态计算图中是否存在内存泄漏。

- 检查第三方库集成:排查集成的自定义层或回调函数是否存在内存管理问题。

4.3.3 解决方法

- 将数据管道的

prefetch缓冲区大小从 100 减小到 10,减少内存占用。 - 将动态计算图转换为静态计算图(使用

trae.function装饰器),优化内存管理。 - 在自定义回调函数中显式释放不再使用的资源。

python

# 优化后的数据管道

dataset = dataset.prefetch(buffer_size=10)

# 将训练步骤包装为静态计算图

@trae.function

def train_step(inputs, labels):

with trae.GradientTape() as tape:

logits = model(inputs, training=True)

loss = loss_fn(labels, logits)

gradients = tape.gradient(loss, model.trainable_variables)

optimizer.apply_gradients(zip(gradients, model.trainable_variables))

return loss4.3.4 调试总结

内存泄漏问题可能隐藏在多个环节中,通过调整数据管道配置、优化计算图和改进自定义代码,成功解决了内存泄漏问题。

4.4 实战案例分析总结(mermaid)

V. 调试最佳实践

5.1 防御性编程

采用防御性编程策略,提前预防常见错误。

5.1.1 输入验证

在函数和方法中添加输入参数验证。

python

def train_model(model, dataset, epochs, batch_size):

# 输入验证

if not isinstance(model, trae.keras.Model):

raise ValueError("model must be a trae.keras.Model instance")

if batch_size <= 0:

raise ValueError("batch_size must be a positive integer")5.1.2 容错处理

为可能失败的操作添加异常捕获和重试机制。

python

def load_data_with_retry(file_path, max_retries=3):

for attempt in range(max_retries):

try:

return np.load(file_path)

except IOError as e:

if attempt == max_retries - 1:

raise

print(f"Failed to load data (attempt {attempt + 1}), retrying...")

time.sleep(1)5.2 系统性调试流程

建立系统性的调试流程,提高问题定位效率。

| 步骤 | 说明 |

|---|---|

| 复现问题 | 确保能够在受控环境中稳定复现问题,这是调试的基础。 |

| 隔离问题 | 通过二分法或单元测试,逐步缩小问题范围,将问题隔离在特定模块或代码段。 |

| 分析症状 | 收集错误日志、堆栈跟踪、输入输出数据等信息,分析问题的根本原因。 |

| 验证假设 | 针对可能的原因提出假设,并通过实验验证假设是否成立。 |

| 修复与验证 | 实现修复方案,并通过全面测试验证问题是否彻底解决,避免引入新的问题。 |

5.3 调试资源与文档

充分利用官方文档和社区资源加速调试过程。

| 资源类型 | 链接或说明 |

|---|---|

| Trae 官方文档 | www.tensorflow.org/guide/debug... |

| Stack Overflow | 搜索功能搜索类似问题,或在 TensorFlow 标签 下提问。 |

| GitHub 社区 | 查看 Trae 项目 GitHub 问题页面,可能已有类似问题的解决方案。 |