引言

在人工智能的奇幻森林中,生成对抗网络(GANs)宛如一位神秘的魔法师,能够无中生有地创造出令人惊叹的图像、音乐甚至文本。而深度卷积生成对抗网络(DCGAN)则是 GAN 家族中的一颗璀璨明珠,凭借其强大的生成能力,让机器能够像艺术家一样创作出逼真的图像。今天,就让我们一起踏上这段奇妙的旅程,用 Trae(假设为深度学习框架或工具库)构建一个 DCGAN,从零开始生成酷炫的图像!

I. GAN 的理论基础与架构

GAN 的核心思想

生成对抗网络(GAN)由 Ian Goodfellow 等人在 2014 年提出,其核心思想是通过两个神经网络------生成器(Generator)和判别器(Discriminator)------的对抗博弈来生成数据。生成器 ( G ) 的任务是从随机噪声(通常是高斯分布)生成逼真的图像,而判别器 ( D ) 的任务是区分生成的图像和真实的图像。通过不断对抗,生成器逐渐学会生成越来越逼真的图像,判别器则越来越难以区分真假图像。

GAN 的数学原理

GAN 的训练过程可以看作是一个二元极小极大博弈。生成器 ( G ) 和判别器 ( D ) 的目标函数可以表示为:

\\min_G \\max_D \\mathbb{E}*{x \\sim p*{\\text{data}}(x)}\[\\log D(x)\] + \\mathbb{E}_{z \\sim p_z(z)}\[\\log(1 - D(G(z)))\]

其中,( p_{\text{data}}(x) ) 是真实数据的分布,( p_z(z) ) 是生成器的输入噪声分布。判别器 ( D ) 的目标是最大化对真实数据的正确分类概率,同时最小化对生成数据的错误分类概率;生成器 ( G ) 的目标是最小化判别器对生成数据的错误分类概率。

DCGAN 的创新点

深度卷积生成对抗网络(DCGAN)是 GAN 的一个改进版本,它引入了卷积神经网络(CNN)的架构,使得生成器和判别器能够更好地处理图像数据。DCGAN 的主要创新点包括:

- 使用卷积层代替全连接层,减少参数数量,提高计算效率。

- 在生成器中使用转置卷积(Transposed Convolution)来逐步上采样生成高分辨率图像。

- 在判别器中使用卷积层来提取图像特征。

- 使用批量归一化(Batch Normalization)来稳定训练过程。

- 使用 LeakyReLU 激活函数来避免梯度消失问题。

Mermaid 图形总结

GAN 与其他生成模型对比

| 模型类型 | GAN | VAE | PixelRNN |

|---|---|---|---|

| 生成方式 | 对抗博弈 | 变分自编码 | 自回归生成 |

| 优点 | 生成图像质量高 | 训练稳定,可变性好 | 生成图像连贯性好 |

| 缺点 | 训练不稳定,模式坍塌 | 生成图像模糊 | 训练复杂,生成速度慢 |

| 适用场景 | 高质量图像生成 | 数据压缩与重构 | 文本生成、图像分割 |

II. 构建 DCGAN 的生成器与判别器

生成器架构设计

生成器 ( G ) 的任务是从随机噪声 ( z ) 生成逼真的图像。我们设计的生成器包含以下几个部分:

- 输入噪声层:输入噪声 ( z ) 通常是一个高斯分布的向量。

- 全连接层:将输入噪声映射到一个高维空间,为后续的卷积层提供输入。

- 转置卷积层:逐步上采样生成高分辨率图像。

- 批量归一化层:稳定训练过程,避免梯度爆炸或消失。

- 激活函数:使用 ReLU 或 Tanh 激活函数,增加非线性。

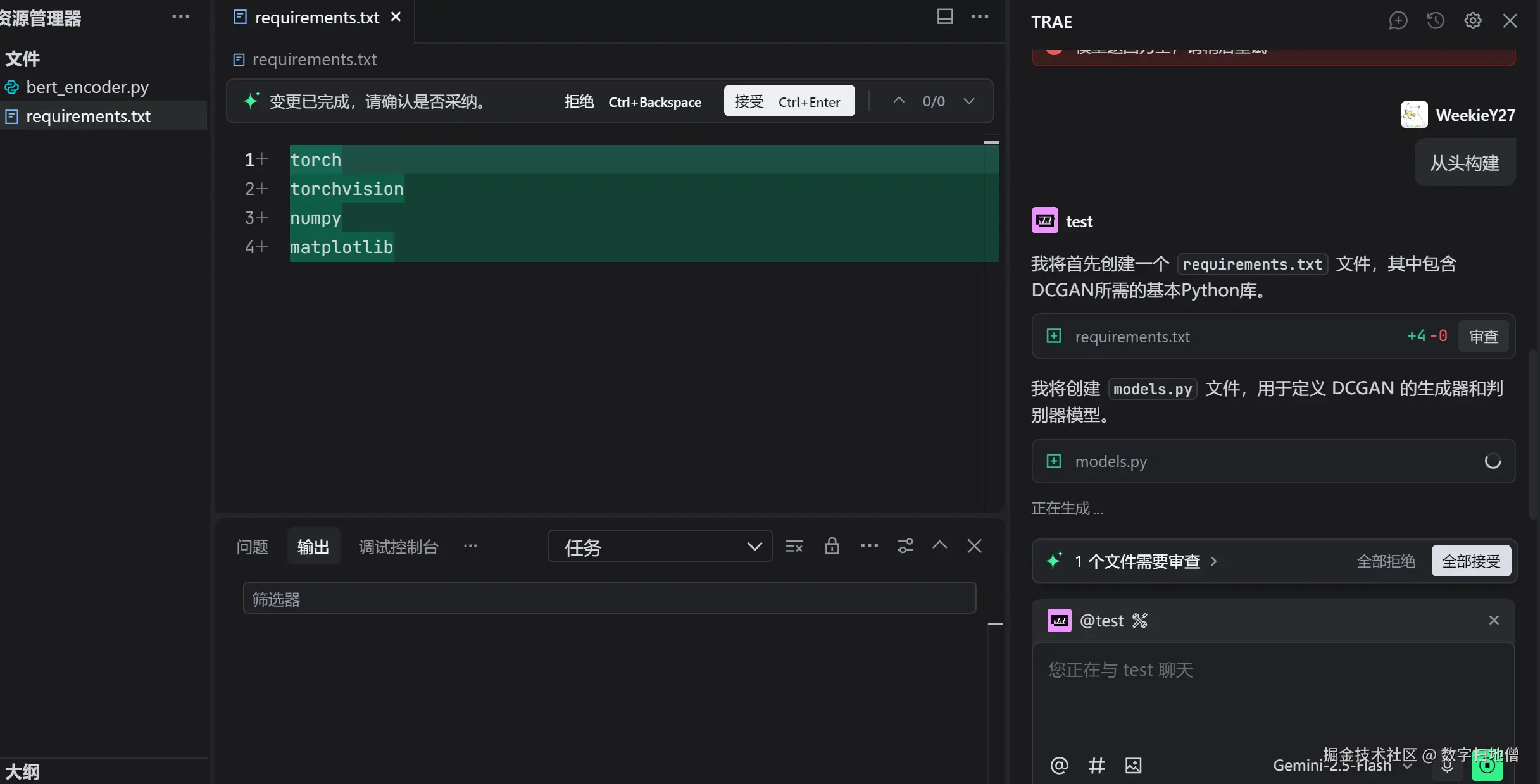

以下是生成器的代码实现:

python

import torch

import torch.nn as nn

class Generator(nn.Module):

def __init__(self, nz=100, ngf=64, nc=3):

super(Generator, self).__init__()

self.main = nn.Sequential(

# 输入噪声 z

nn.ConvTranspose2d(nz, ngf * 8, 4, 1, 0, bias=False),

nn.BatchNorm2d(ngf * 8),

nn.ReLU(True),

# 状态大小: ngf*8 x 4 x 4

nn.ConvTranspose2d(ngf * 8, ngf * 4, 4, 2, 1, bias=False),

nn.BatchNorm2d(ngf * 4),

nn.ReLU(True),

# 状态大小: ngf*4 x 8 x 8

nn.ConvTranspose2d(ngf * 4, ngf * 2, 4, 2, 1, bias=False),

nn.BatchNorm2d(ngf * 2),

nn.ReLU(True),

# 状态大小: ngf*2 x 16 x 16

nn.ConvTranspose2d(ngf * 2, ngf, 4, 2, 1, bias=False),

nn.BatchNorm2d(ngf),

nn.ReLU(True),

# 状态大小: ngf x 32 x 32

nn.ConvTranspose2d(ngf, nc, 4, 2, 1, bias=False),

nn.Tanh()

# 输出图像大小: nc x 64 x 64

)

def forward(self, input):

return self.main(input)判别器架构设计

判别器 ( D ) 的任务是区分真实图像和生成图像。我们设计的判别器包含以下几个部分:

- 输入图像层:接收输入图像。

- 卷积层:逐步提取图像特征。

- 批量归一化层:稳定训练过程。

- 激活函数:使用 LeakyReLU 激活函数,避免梯度消失。

- 输出层:输出一个概率值,表示输入图像是真实图像的概率。

以下是判别器的代码实现:

python

class Discriminator(nn.Module):

def __init__(self, ndf=64, nc=3):

super(Discriminator, self).__init__()

self.main = nn.Sequential(

# 输入图像大小: nc x 64 x 64

nn.Conv2d(nc, ndf, 4, 2, 1, bias=False),

nn.LeakyReLU(0.2, inplace=True),

# 状态大小: ndf x 32 x 32

nn.Conv2d(ndf, ndf * 2, 4, 2, 1, bias=False),

nn.BatchNorm2d(ndf * 2),

nn.LeakyReLU(0.2, inplace=True),

# 状态大小: ndf*2 x 16 x 16

nn.Conv2d(ndf * 2, ndf * 4, 4, 2, 1, bias=False),

nn.BatchNorm2d(ndf * 4),

nn.LeakyReLU(0.2, inplace=True),

# 状态大小: ndf*4 x 8 x 8

nn.Conv2d(ndf * 4, ndf * 8, 4, 2, 1, bias=False),

nn.BatchNorm2d(ndf * 8),

nn.LeakyReLU(0.2, inplace=True),

# 状态大小: ndf*8 x 4 x 4

nn.Conv2d(ndf * 8, 1, 4, 1, 0, bias=False),

nn.Sigmoid()

)

def forward(self, input):

return self.main(input).view(-1, 1).squeeze(1)Mermaid 图形总结

生成器与判别器参数对比

| 参数 | 生成器 | 判别器 |

|---|---|---|

| 输入维度 | ( z )(噪声向量) | ( nc \times 64 \times 64 )(图像) |

| 输出维度 | ( nc \times 64 \times 64 )(图像) | 1(概率值) |

| 卷积层数量 | 4(转置卷积) | 4(普通卷积) |

| 激活函数 | ReLU, Tanh | LeakyReLU, Sigmoid |

| 批量归一化 | 有 | 有 |

III. DCGAN 的训练过程

训练数据准备

为了训练 DCGAN,我们需要准备大量的真实图像数据。常用的数据集包括 CIFAR-10、CelebA 等。以 CelebA 数据集为例,它包含 20 万张人脸图像,每张图像大小为 64x64 像素。我们需要对图像进行预处理,包括归一化、裁剪等操作。

python

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 数据集路径

data_path = './data/celeba'

# 数据预处理

transform = transforms.Compose([

transforms.Resize(64),

transforms.CenterCrop(64),

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))

])

# 加载数据集

dataset = datasets.ImageFolder(root=data_path, transform=transform)

dataloader = DataLoader(dataset, batch_size=64, shuffle=True, num_workers=4)训练循环设计

训练 DCGAN 的核心是交替更新生成器和判别器。具体步骤如下:

- 更新判别器:判别器的目标是最大化对真实图像的正确分类概率,同时最小化对生成图像的错误分类概率。

- 更新生成器:生成器的目标是最小化判别器对生成图像的错误分类概率。

以下是训练循环的代码实现:

python

import torch.optim as optim

# 初始化生成器和判别器

generator = Generator()

discriminator = Discriminator()

# 定义优化器

lr = 0.0002

beta1 = 0.5

optimizer_G = optim.Adam(generator.parameters(), lr=lr, betas=(beta1, 0.999))

optimizer_D = optim.Adam(discriminator.parameters(), lr=lr, betas=(beta1, 0.999))

# 定义损失函数

criterion = nn.BCELoss()

# 训练循环

num_epochs = 50

fixed_noise = torch.randn(64, 100, 1, 1).to(device) # 固定噪声用于生成图像

for epoch in range(num_epochs):

for i, (real_images, _) in enumerate(dataloader):

# 训练判别器

real_images = real_images.to(device)

b_size = real_images.size(0)

label_real = torch.ones(b_size).to(device)

label_fake = torch.zeros(b_size).to(device)

# 真实图像

output_real = discriminator(real_images).view(-1)

loss_real = criterion(output_real, label_real)

loss_real.backward()

# 生成图像

noise = torch.randn(b_size, 100, 1, 1).to(device)

fake_images = generator(noise)

output_fake = discriminator(fake_images.detach()).view(-1)

loss_fake = criterion(output_fake, label_fake)

loss_fake.backward()

# 更新判别器

optimizer_D.step()

# 训练生成器

optimizer_G.zero_grad()

output_fake = discriminator(fake_images).view(-1)

loss_G = criterion(output_fake, label_real)

loss_G.backward()

optimizer_G.step()

# 打印训练信息

if i % 50 == 0:

print(f"Epoch [{epoch}/{num_epochs}] Batch {i}/{len(dataloader)} \

Loss D: {loss_real.item() + loss_fake.item():.4f}, Loss G: {loss_G.item():.4f}")

# 保存生成的图像

with torch.no_grad():

fake_images = generator(fixed_noise).detach().cpu()

save_image(fake_images, f"generated_images/epoch_{epoch}.png", normalize=True)训练过程中的常见问题与解决方法

| 问题 | 可能原因 | 解决方法 |

|---|---|---|

| 模式坍塌 | 生成器生成的图像多样性不足 | 增加噪声维度,使用 mini-batch discrimination |

| 训练不稳定 | 判别器过于强大或生成器过于弱 | 调整学习率,使用谱归一化 |

| 生成图像质量低 | 网络架构设计不合理 | 增加卷积层数量,调整激活函数 |

| 梯度消失或爆炸 | 网络过深或激活函数选择不当 | 使用批量归一化,调整激活函数 |

Mermaid 图形总结

IV. DCGAN 的性能评估与优化

性能评估指标

评估 DCGAN 的性能可以从以下几个方面入手:

- 生成图像质量:通过视觉检查生成的图像是否逼真、清晰。

- 多样性:生成的图像是否具有多样性,是否存在模式坍塌。

- Inception Score (IS):衡量生成图像的质量和多样性。

- Frechet Inception Distance (FID):衡量生成图像与真实图像的相似度。

优化方法

为了提升 DCGAN 的性能,可以尝试以下优化方法:

- 改进网络架构:增加卷积层数量,调整卷积核大小。

- 调整训练策略:使用 mini-batch discrimination 避免模式坍塌,调整学习率和优化器参数。

- 正则化技术:使用谱归一化(Spectral Normalization)稳定训练过程。

- 数据增强:对训练数据进行随机裁剪、旋转等操作,增加数据多样性。

Mermaid 图形总结

性能评估指标对比

| 指标 | 描述 | 典型值 |

|---|---|---|

| Inception Score (IS) | 衡量生成图像的质量和多样性 | 5.0 - 10.0 |

| Frechet Inception Distance (FID) | 衡量生成图像与真实图像的相似度 | 10 - 50 |

V. DCGAN 的部署与应用

推理服务架构设计

将训练好的 DCGAN 部署为推理服务,可以使用 Flask 或 FastAPI 构建 RESTful API。服务接收客户端发送的噪声向量,通过生成器生成图像并返回。以下是推理服务的代码实现:

python

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

import uvicorn

import torch

import numpy as np

from PIL import Image

from torchvision.utils import save_image

app = FastAPI()

# 加载生成器模型

generator = Generator()

generator.load_state_dict(torch.load("generator.pth"))

generator.eval()

class Noise(BaseModel):

noise: list

@app.post("/generate")

async def generate_image(noise: Noise):

try:

noise_tensor = torch.tensor(noise.noise, dtype=torch.float32).view(1, 100, 1, 1)

with torch.no_grad():

generated_image = generator(noise_tensor).detach().cpu()

save_image(generated_image, "generated_image.png", normalize=True)

return {"message": "Image generated successfully"}

except Exception as e:

raise HTTPException(status_code=500, detail=str(e))

if __name__ == "__main__":

uvicorn.run(app, host="0.0.0.0", port=8000)模型保存与加载

在训练完成后,保存生成器和判别器的模型权重。加载模型时,确保网络结构与训练时一致。

python

# 保存模型权重

torch.save(generator.state_dict(), "generator.pth")

torch.save(discriminator.state_dict(), "discriminator.pth")

# 加载模型权重

generator.load_state_dict(torch.load("generator.pth"))

discriminator.load_state_dict(torch.load("discriminator.pth"))推理延迟优化

为了提升推理速度,可以尝试以下优化方法:

- 模型量化:将模型中的浮点数量化为低精度表示,减少计算量。

- 减少卷积层数量:适当减少卷积层数量,降低模型复杂度。

- 使用 GPU 加速:确保推理在 GPU 上进行,提升计算效率。