元学习(Meta-Learning)是近年来深度学习领域的一个热门研究方向,它旨在让模型学会"如何学习"。与传统的机器学习方法不同,元学习的目标是让模型在面对新的任务时,能够快速适应并取得良好的性能,即使只有少量的样本。MAML(Model-Agnostic Meta-Learning)是元学习领域的一个经典算法,它通过优化模型的初始参数,使得模型在新的任务上只需要进行少量的梯度更新就能达到较好的性能。本文将详细介绍MAML算法的原理,并使用Trae框架实现MAML算法,带你走进元学习的世界。

I. 元学习与MAML算法

元学习的核心思想是让模型学会"如何学习",而不是仅仅学会一个特定的任务。在传统的机器学习中,模型通常需要大量的标注数据来学习一个任务。然而,在现实世界中,我们往往面临数据稀缺的问题,尤其是在一些新的任务中。元学习的目标就是让模型在面对新的任务时,能够快速适应并取得良好的性能,即使只有少量的样本。

(一)MAML算法简介

MAML算法是一种模型无关的元学习算法,它通过优化模型的初始参数,使得模型在新的任务上只需要进行少量的梯度更新就能达到较好的性能。MAML的核心思想是让模型的初始参数靠近多个任务的最优参数,从而使得模型在新的任务上能够快速收敛。

(二)MAML算法的数学原理

假设我们有一个模型 ( f_\theta ),其中 ( \theta ) 是模型的参数。MAML的目标是优化 ( \theta ),使得在新的任务 ( \mathcal{T}_i ) 上,模型能够快速适应。具体来说,MAML通过以下步骤实现:

-

内循环(Inner Loop):

- 对于每个任务 ( \mathcal{T}i ),使用少量的训练样本 ( \mathcal{D}i^{train} ) 更新模型参数: [ \theta_i' = \theta - \alpha \nabla\theta \mathcal{L} {\mathcal{D}i^{train}}(f\theta) ] 其中,( \alpha ) 是学习率,( \mathcal{L} ) 是损失函数。

-

外循环(Outer Loop):

- 使用更新后的参数 ( \theta_i' ) 在验证集 ( \mathcal{D}i^{val} ) 上计算损失,并更新全局参数 ( \theta ): [ \theta = \theta - \beta \nabla \theta \sum_{i} \mathcal{L}_{\mathcal{D}i^{val}}(f{\theta_i'}) ] 其中,( \beta ) 是外循环的学习率。

(三)MAML算法的优势

- 模型无关:MAML算法不依赖于特定的模型结构,适用于各种类型的模型。

- 快速适应:通过优化初始参数,模型在新的任务上只需要进行少量的梯度更新就能达到较好的性能。

- 灵活性高:MAML可以应用于多种任务,如分类、回归等。

(四)Mermaid总结

II. Trae框架简介

Trae是一个轻量级的深度学习框架,它提供了简洁的API和高效的计算性能。Trae支持多种深度学习任务,包括图像识别、自然语言处理和元学习。在本文中,我们将使用Trae来实现MAML算法。

(一)Trae的特点

- 简洁易用:Trae的API设计简洁,易于上手。

- 高效性能:Trae底层使用高效的计算引擎,支持GPU加速。

- 灵活扩展:Trae支持自定义层和损失函数,方便开发者实现自己的模型。

(二)安装Trae

在开始之前,我们需要安装Trae。可以通过以下命令安装:

bash

pip install trae(三)Trae的基本使用

Trae的基本使用包括定义模型、训练和评估。以下是一个简单的例子:

python

import trae as t

# 定义模型

model = t.Sequential(

t.Linear(10, 5),

t.ReLU(),

t.Linear(5, 2)

)

# 定义损失函数和优化器

criterion = t.CrossEntropyLoss()

optimizer = t.Adam(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(10):

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

print(f"Epoch {epoch+1}, Loss: {loss.item()}")(四)Mermaid总结

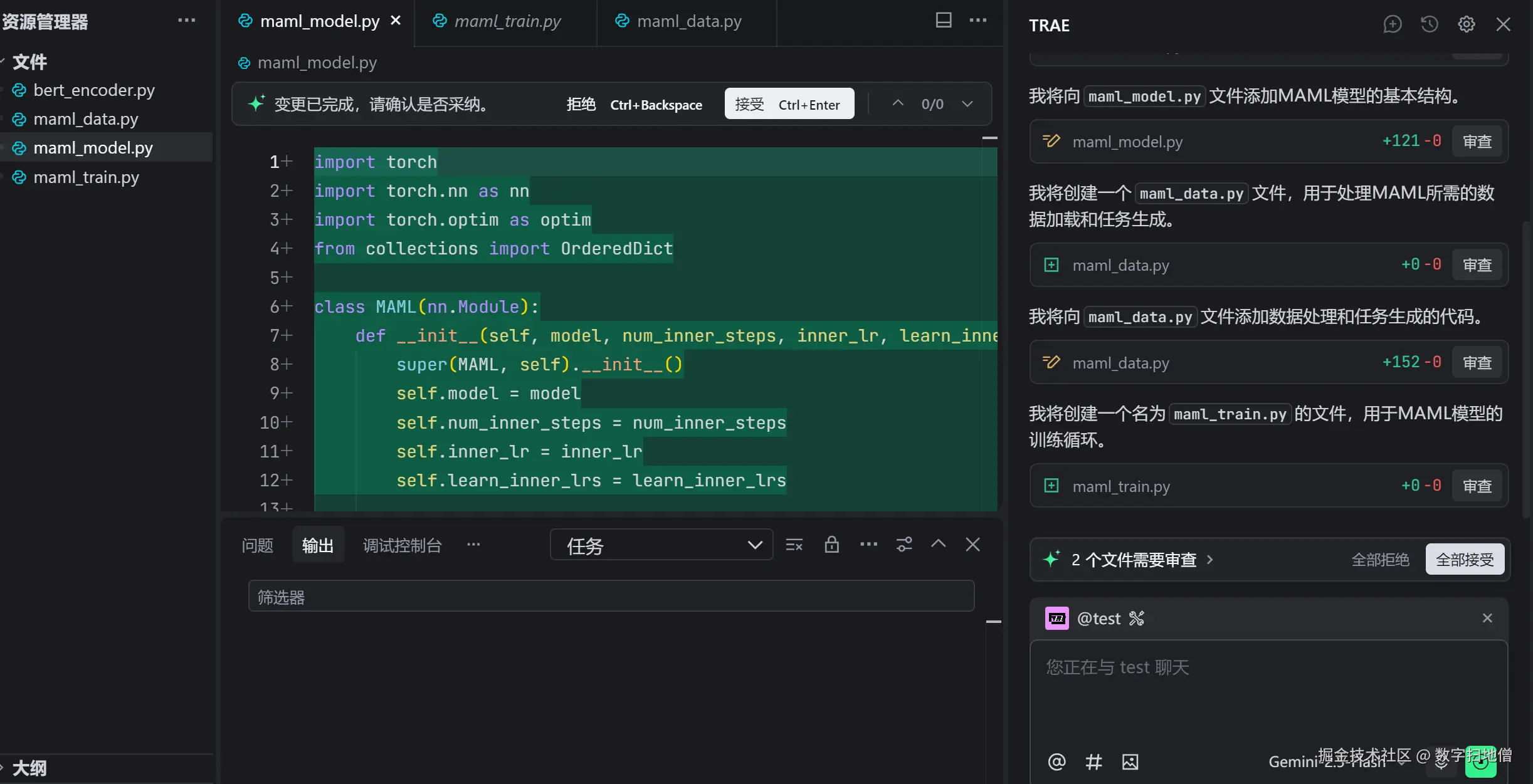

III. 实现MAML算法

在本节中,我们将详细介绍如何在Trae中实现MAML算法。我们将从数学原理出发,逐步实现MAML算法的内循环和外循环。

(一)定义MAML算法

MAML算法的核心是内循环和外循环。内循环负责在每个任务上更新模型参数,外循环负责更新全局参数。以下是MAML算法的实现代码:

python

import trae as t

import numpy as np

class MAML(t.Module):

def __init__(self, model, inner_lr, outer_lr, num_inner_steps):

super(MAML, self).__init__()

self.model = model

self.inner_lr = inner_lr

self.outer_lr = outer_lr

self.num_inner_steps = num_inner_steps

def forward(self, x_train, y_train, x_val, y_val):

"""

:param x_train: 训练集输入

:param y_train: 训练集标签

:param x_val: 验证集输入

:param y_val: 验证集标签

:return: 损失值

"""

# 内循环

for _ in range(self.num_inner_steps):

self.model.zero_grad()

outputs = self.model(x_train)

loss = self.model.loss(outputs, y_train)

loss.backward()

for param in self.model.parameters():

param.data -= self.inner_lr * param.grad

# 外循环

self.model.zero_grad()

outputs = self.model(x_val)

loss = self.model.loss(outputs, y_val)

loss.backward()

for param in self.model.parameters():

param.data -= self.outer_lr * param.grad

return loss(二)代码解释

-

内循环:

- 在每个任务的训练集上,使用内循环学习率 ( \alpha ) 更新模型参数。

- 通过多次梯度更新,模型参数逐渐靠近该任务的最优参数。

-

外循环:

- 在验证集上计算损失,并使用外循环学习率 ( \beta ) 更新全局参数。

- 通过外循环,模型的初始参数逐渐靠近多个任务的最优参数。

(三)Mermaid总结

IV. 构建元学习模型

在本节中,我们将使用Trae构建一个简单的元学习模型,并使用MAML算法进行训练。我们将以小样本分类任务为例,展示如何使用MAML算法实现快速适应。

(一)数据准备

元学习任务的数据通常包括多个任务,每个任务包含少量的训练样本和验证样本。以下是一个简单的数据加载器:

python

import numpy as np

class MetaDataset(t.Dataset):

def __init__(self, data, labels, num_classes, num_samples_per_class):

self.data = data

self.labels = labels

self.num_classes = num_classes

self.num_samples_per_class = num_samples_per_class

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

# 随机选择一个任务

task_data = []

task_labels = []

for _ in range(self.num_classes):

class_data = self.data[self.labels == _]

selected_indices = np.random.choice(len(class_data), self.num_samples_per_class, replace=False)

task_data.append(class_data[selected_indices])

task_labels.append(np.ones(self.num_samples_per_class) * _)

task_data = np.concatenate(task_data)

task_labels = np.concatenate(task_labels)

# 随机打乱顺序

indices = np.arange(len(task_data))

np.random.shuffle(indices)

task_data = task_data[indices]

task_labels = task_labels[indices]

return t.tensor(task_data, dtype=t.float32), t.tensor(task_labels, dtype=t.long)(二)定义模型

元学习模型通常包括特征提取层和分类层。在本文中,我们将使用一个简单的卷积神经网络作为特征提取层,一个全连接层作为分类层。以下是模型的定义:

python

class MetaModel(t.Module):

def __init__(self, input_dim, hidden_dim, num_classes):

super(MetaModel, self).__init__()

self.conv1 = t.Conv2d(1, 32, kernel_size=3, stride=1, padding=1)

self.conv2 = t.Conv2d(32, 64, kernel_size=3, stride=1, padding=1)

self.fc1 = t.Linear(hidden_dim, 128)

self.fc2 = t.Linear(128, num_classes)

def forward(self, x):

x = t.relu(self.conv1(x))

x = t.max_pool2d(x, kernel_size=2, stride=2)

x = t.relu(self.conv2(x))

x = t.max_pool2d(x, kernel_size=2, stride=2)

x = x.view(x.size(0), -1)

x = t.relu(self.fc1(x))

x = self.fc2(x)

return x

def loss(self, outputs, targets):

return t.CrossEntropyLoss()(outputs, targets)(三)训练模型

以下是使用MAML算法训练模型的代码:

python

# 定义模型

model = MetaModel(input_dim=1, hidden_dim=64, num_classes=5)

# 定义MAML算法

maml = MAML(model, inner_lr=0.01, outer_lr=0.001, num_inner_steps=5)

# 训练模型

for epoch in range(10):

for batch_idx, (x_train, y_train, x_val, y_val) in enumerate(train_loader):

loss = maml(x_train, y_train, x_val, y_val)

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item()}")(四)代码解释

-

数据加载:

- 每个任务包含多个类别,每个类别包含少量的样本。

- 随机选择样本并打乱顺序,模拟小样本分类任务。

-

模型定义:

- 使用卷积神经网络提取特征。

- 使用全连接层进行分类。

-

训练过程:

- 在每个任务的训练集上进行内循环更新。

- 在验证集上计算损失并进行外循环更新。

(五)Mermaid总结

V. 评估模型

在本节中,我们将评估训练好的元学习模型。评估指标通常包括准确率、召回率和F1分数。

(一)评估过程

评估元学习模型时,我们需要在新的任务上测试模型的性能。以下是评估模型的代码:

python

# 评估模型

model.eval()

total_correct = 0

total_samples = 0

with t.no_grad():

for x_test, y_test in test_loader:

outputs = model(x_test)

_, predicted = t.max(outputs, 1)

total_correct += (predicted == y_test).sum().item()

total_samples += y_test.size(0)

accuracy = total_correct / total_samples

print(f"Test Accuracy: {accuracy:.4f}")(二)代码解释

- 评估过程 :

- 在测试集上运行模型。

- 计算预测正确的样本数。

- 计算准确率。