目录

- 1、前言

-

- [Aurora 64B66B是啥?](#Aurora 64B66B是啥?)

- 官方有Example,为何要用你这个?

- 工程概述

- 免责声明

- 2、相关方案推荐

-

- 我已有的所有工程源码总目录----方便你快速找到自己喜欢的项目

- [我这里已有的 GT 高速接口解决方案](#我这里已有的 GT 高速接口解决方案)

- [本方案在Aurora 8B10B上的应用](#本方案在Aurora 8B10B上的应用)

- 3、工程详细设计方案

-

- 工程设计原理框图

- 输入Sensor之-->OV5640摄像头

- Native视频转AXIS流

- AXIS视频流重组

- [Aurora 64B66B视频传输传输架构](#Aurora 64B66B视频传输传输架构)

-

- [Aurora 64B66BIP核简介](#Aurora 64B66BIP核简介)

- [Aurora 64B66B 基本结构](#Aurora 64B66B 基本结构)

- [Aurora 64B66B 发送流程](#Aurora 64B66B 发送流程)

- [Aurora 64B66B 接收流程](#Aurora 64B66B 接收流程)

- [Aurora 64B66B 时钟架构](#Aurora 64B66B 时钟架构)

- [Aurora 64B66B IP核调用和使用](#Aurora 64B66B IP核调用和使用)

- AXIS视频流恢复

- AXIS视频流写缓存

- AXIS视频流读缓存

- HDMI视频输出架构

- 点对点视频发送端工程源码架构

- 点对点视频接收端工程源码架构

- 4、vivado工程源码1详解-->Kintex7--325T,点对点OV5640视频转SFP光口发送

- 5、vivado工程源码2详解-->Kintex7--325T,点对点SFP光口接收OV5640视频转HDMI

- 6、vivado工程源码3详解-->Zynq7100,点对点OV5640视频转SFP光口发送

- 7、vivado工程源码4详解-->Zynq7100,点对点SFP光口接收OV5640视频转HDMI

- 8、工程移植说明

- 9、上板调试验证

-

- 准备工作

- [Aurora 64B66B 视频点对点传输效果演示](#Aurora 64B66B 视频点对点传输效果演示)

- 10、工程代码的获取

FPGA实现Aurora 64B66B视频点对点传输,基于GTX高速收发器,提供4套工程源码和技术支持

FPGA实现Aurora 64B66B图像视频传输

1、前言

Aurora 64B66B是啥?

Aurora 64B/66B 是Xilinx(现AMD)开发的高性能链路层协议,专为超高带宽串行通信设计。它采用64B/66B编码方案,提供比传统8B/10B更高的有效带宽利用率(97% vs 80%),主要应用于数据中心、5G基础设施等需要100Gbps+传输的场景

Aurora 64B66B核心作用如下:

1、超高带宽传输:支持25Gbps至112Gbps线速率

2、低协议开销:仅3.125%的编码开销(对比8B/10B的25%)

3、多通道聚合:支持多达32通道绑定

4、前向纠错:集成Reed-Solomon FEC增强可靠性

5、灵活拓扑:支持点对点、环网和星型结构

Aurora 64B66B主要工程应用如下:

博主之前实现过Aurora 8B10B编解码,本博客用的则是Aurora 64B66B IP核,这两种方法编解码器区别如下:

Aurora 64B/66B vs 8B/10B 全面对比

官方有Example,为何要用你这个?

Xilinx官方的确有Aurora 64B66B IP核的Example例程;

然后呢?你看得懂吗?你会照着模仿做自己的项目吗?

如果你会,那么请划走;

如果你不会,不妨看看下面的聊天记录

这位朋友用了我的Aurora 64B66B数据回环传输工程,感觉少走了一年的弯路。。。

工程概述

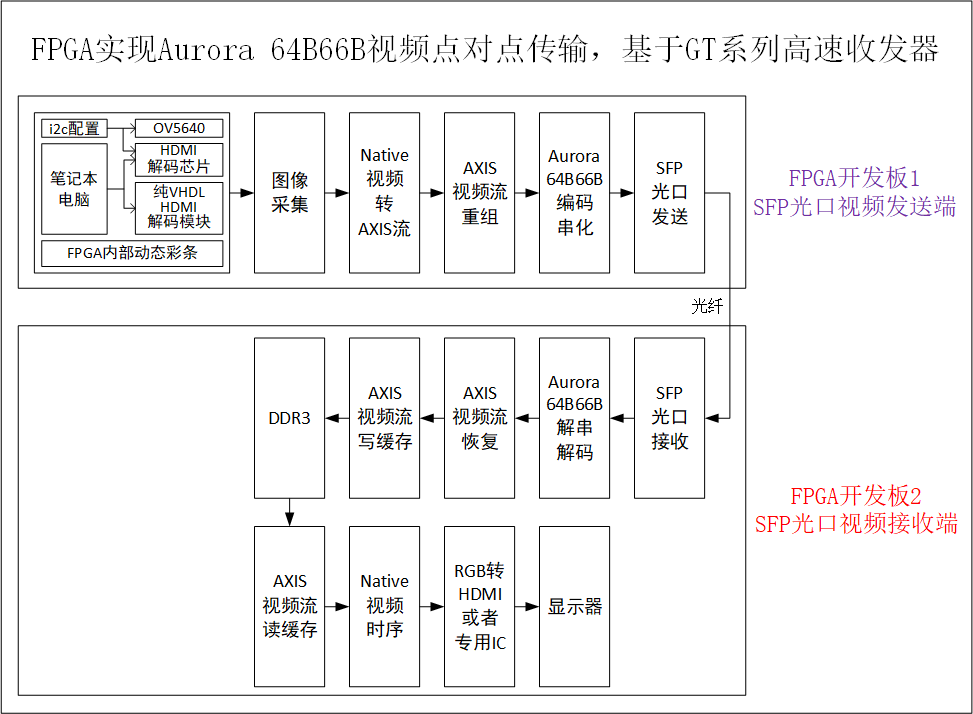

本设计使用Xilinx 7系列FPGA为平台,基于GTX高速收发器实现Aurora 64B66B视频点对点传输,所谓点对点传输,也就是两块FPGA开发板之间的相互传输;比如FPGA开发板1采集视频并通过SFP光口输出,FPGA开发板2通过SFP光口接收视频然后转HDMI输出给显示器;本设计旨在为读者提供一套精简版的、基于Aurora 64B66B编解码的视频点对点收发架构;

视频发送端处理流程如下:

FPGA开发板1的视频输入源有多种,一种是板载的HDMI输入接口,另一种是传统摄像头,包括OV7725、OV5640和AR0135;如果你的FPGA开发板没有视频输入接口,或者你的手里没有摄像头时,可以使用FPGA逻辑实现的动态彩条模拟输入视频,代码里通过parametr参数选择视频源,默认不使用动态彩条;FPGA首先对摄像头进行i2c初始化配置,然后采集摄像头视频;然后采集视频送入Xilinx官方的Video In To AXI4-Stream IP核实现Native视频转换到AXI4-Stream视频流;然后AXI4-Stream视频流再送入纯verilog代码实现的AXIS视频流重组模块实现信号重组,因为Aurora 64B66B发送接口不带tuser信号,所以需要将tuser嵌入到数据流中传输;然后视频流送入Xilinx官方的Aurora 64B66B IP核实现64B66B数据编码,数据以高速差分信号输出,经板载的SFP光口发送至远端节点;

视频接收端处理流程如下:

FPGA开发板2用板载的SFP光口的光纤接收视频,经SFP-RX接口输入高速差分信号再进入Xilinx官方的Aurora 64B66B IP核实现64B66B数据解码,输出AXI4-Stream视频流;AXI4-Stream视频流再送入纯verilog代码实现的AXIS视频流重组模块实现信号恢复,因为Aurora 64B66B接收接口不带tuser信号,所以需要在嵌入数据中的tuser恢复出来;然后AXI4-Stream视频流送入本博主自研的纯verilog实现的、AXI4-Stream接口的图像写缓存模块,实现视频写入DDR缓存操作;然后使用本博主自研的纯verilog实现的、AXI4-Stream接口的图像读缓存模块,实现视频从DDR读出操作;然后读出的视频送入纯verilog实现的Native视频时序模块实现视频同步;然后使用RGB转HDMI模块或者专用芯片实现RGB视频流转HDMI差分视频信号;最后用显示器显示视频即可;

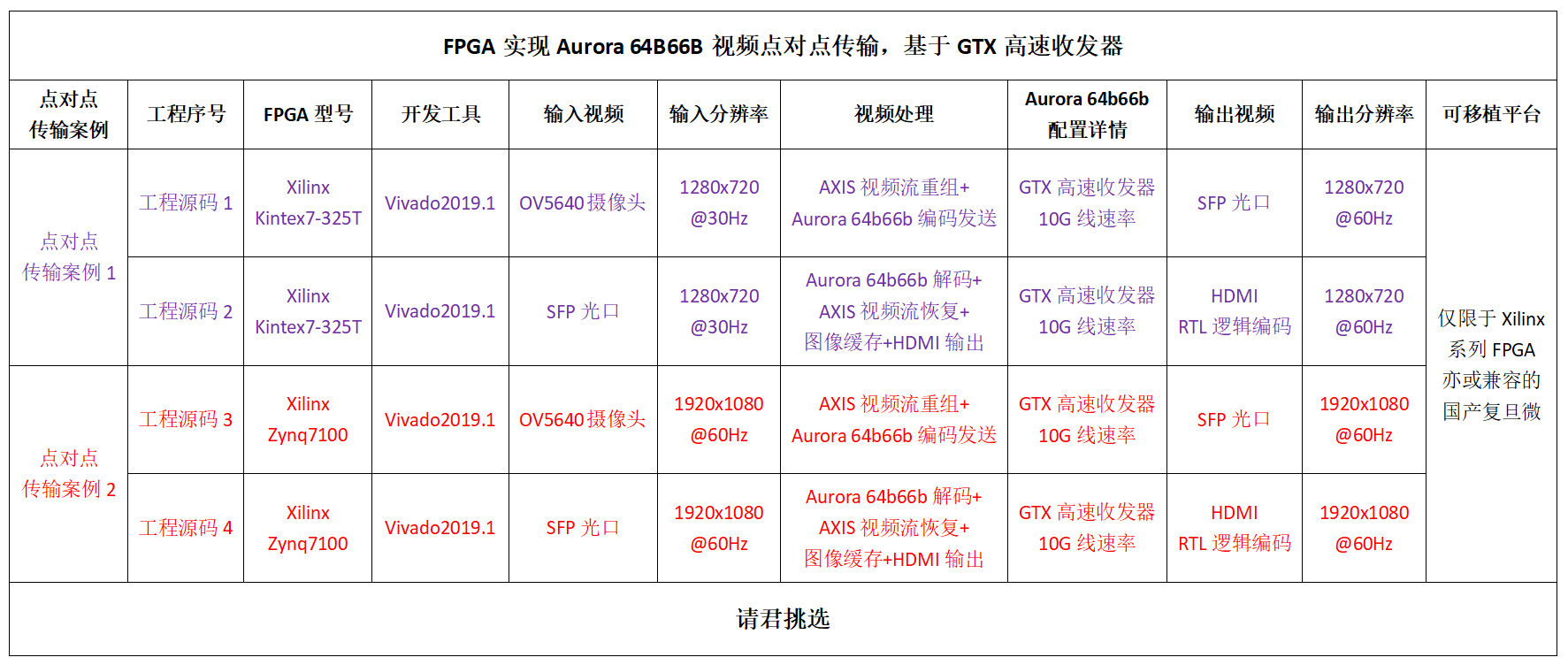

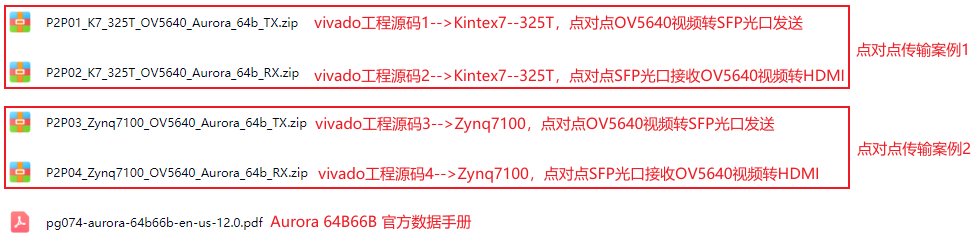

针对市场主流需求,本博客设计并提供4套工程源码,具体如下:

现对上述4套工程源码做如下解释,方便读者理解:

工程源码1:点对点传输案例1的视频发送端工程

开发板FPGA型号为Xilinx-->Kintex7--35T--xc7k325tffg676-2;此工程为点对点传输案例1的视频发送端工程,即视频Aurora 64B66B编码转SFP光口输出;FPGA开发板1的输入视频为OV5640摄像头或者动态彩条,默认使用OV5640;FPGA首先使用纯Verilog实现的i2c总线对摄像头进行初始化配置,分辨率配置为1280x720@30Hz;然后采集输入视频,将输入的两个时钟传输一个RGB565像素的视频采集为一个时钟传输一个RGB888像素的视频;然后采集视频送入Xilinx官方的Video In To AXI4-Stream IP核实现Native视频转换到AXI4-Stream视频流;然后AXI4-Stream视频流再送入纯verilog代码实现的AXIS视频流重组模块实现信号重组,因为Aurora 64B66B发送接口不带tuser信号,所以需要将tuser嵌入到数据流中传输;然后视频流送入Xilinx官方的Aurora 64B66B IP核实现64B66B数据编码,数据以高速差分信号输出,经板载的SFP光口发送至远端节点,输出分辨率为1280x720@60Hz;由此形成Sensor+64B66B编码+SFP光口的高端架构;该工程适用于视频转SFP光口光端机应用;

工程源码2:点对点传输案例1的视频接收端工程

开发板FPGA型号为Xilinx-->Kintex7--35T--xc7k325tffg676-2;此工程为点对点传输案例1的视频接收端工程,即SFP光口视频接收Aurora 64B66B解码转HDMI输出;FPGA开发板2用板载的SFP光口的光纤接收视频,经SFP-RX接口输入高速差分信号再进入Xilinx官方的Aurora 64B66B IP核实现64B66B数据解码,输出AXI4-Stream视频流;AXI4-Stream视频流再送入纯verilog代码实现的AXIS视频流重组模块实现信号恢复,因为Aurora 64B66B接收接口不带tuser信号,所以需要在嵌入数据中的tuser恢复出来;然后AXI4-Stream视频流送入本博主自研的纯verilog实现的、AXI4-Stream接口的图像写缓存模块,实现视频写入DDR缓存操作;然后使用本博主自研的纯verilog实现的、AXI4-Stream接口的图像读缓存模块,实现视频从DDR读出操作;然后读出的视频送入纯verilog实现的Native视频时序模块实现视频同步;然后使用RGB转HDMI模块或者专用芯片实现RGB视频流转HDMI差分视频信号;最后用显示器显示视频即可,输出分辨率为1280x720@60Hz;由此形成Sensor+64B66B编码+SFP光口的高端架构;该工程适用于视频转SFP光口光端机应用;

工程源码3:点对点传输案例2的视频发送端工程

开发板FPGA型号为Xilinx-->Zynq7100--xc7z100ffg900-2;此工程为点对点传输案例2的视频发送端工程,即视频Aurora 64B66B编码转SFP光口输出;FPGA开发板1的输入视频为OV5640摄像头或者动态彩条,默认使用OV5640;FPGA首先使用纯Verilog实现的i2c总线对摄像头进行初始化配置,分辨率配置为1280x720@30Hz;然后采集输入视频,将输入的两个时钟传输一个RGB565像素的视频采集为一个时钟传输一个RGB888像素的视频;然后采集视频送入Xilinx官方的Video In To AXI4-Stream IP核实现Native视频转换到AXI4-Stream视频流;然后AXI4-Stream视频流再送入纯verilog代码实现的AXIS视频流重组模块实现信号重组,因为Aurora 64B66B发送接口不带tuser信号,所以需要将tuser嵌入到数据流中传输;然后视频流送入Xilinx官方的Aurora 64B66B IP核实现64B66B数据编码,数据以高速差分信号输出,经板载的SFP光口发送至远端节点,输出分辨率为1280x720@60Hz;由此形成Sensor+64B66B编码+SFP光口的高端架构;该工程适用于视频转SFP光口光端机应用;

工程源码4:点对点传输案例2的视频接收端工程

开发板FPGA型号为Xilinx-->Zynq7100--xc7z100ffg900-2;此工程为点对点传输案例2的视频接收端工程,即SFP光口视频接收Aurora 64B66B解码转HDMI输出;FPGA开发板2用板载的SFP光口的光纤接收视频,经SFP-RX接口输入高速差分信号再进入Xilinx官方的Aurora 64B66B IP核实现64B66B数据解码,输出AXI4-Stream视频流;AXI4-Stream视频流再送入纯verilog代码实现的AXIS视频流重组模块实现信号恢复,因为Aurora 64B66B接收接口不带tuser信号,所以需要在嵌入数据中的tuser恢复出来;然后AXI4-Stream视频流送入本博主自研的纯verilog实现的、AXI4-Stream接口的图像写缓存模块,实现视频写入DDR缓存操作;然后使用本博主自研的纯verilog实现的、AXI4-Stream接口的图像读缓存模块,实现视频从DDR读出操作;然后读出的视频送入纯verilog实现的Native视频时序模块实现视频同步;然后使用RGB转HDMI模块或者专用芯片实现RGB视频流转HDMI差分视频信号;最后用显示器显示视频即可,输出分辨率为1280x720@60Hz;由此形成Sensor+64B66B编码+SFP光口的高端架构;该工程适用于视频转SFP光口光端机应用;

本博客详细描述了FPGA实现Aurora 64B66B视频点对点传输的设计方案,工程代码可综合编译上板调试,可直接项目移植,适用于在校学生、研究生项目开发,也适用于在职工程师做学习提升,可应用于医疗、军工等行业的高速接口或图像处理领域;

提供完整的、跑通的工程源码和技术支持;

工程源码和技术支持的获取方式放在了文章末尾,请耐心看到最后;

免责声明

本工程及其源码即有自己写的一部分,也有网络公开渠道获取的一部分(包括CSDN、Xilinx官网、Altera官网等等),若大佬们觉得有所冒犯,请私信批评教育;基于此,本工程及其源码仅限于读者或粉丝个人学习和研究,禁止用于商业用途,若由于读者或粉丝自身原因用于商业用途所导致的法律问题,与本博客及博主无关,请谨慎使用。。。

2、相关方案推荐

我已有的所有工程源码总目录----方便你快速找到自己喜欢的项目

其实一直有朋友反馈,说我的博客文章太多了,乱花渐欲迷人,自己看得一头雾水,不方便快速定位找到自己想要的项目,所以本博文置顶,列出我目前已有的所有项目,并给出总目录,每个项目的文章链接,当然,本博文实时更新。。。以下是博客地址:

点击直接前往

我这里已有的 GT 高速接口解决方案

我的主页有FPGA GT 高速接口专栏,该专栏有 GTP 、 GTX 、 GTH 、 GTY 等GT 资源的视频传输例程和PCIE传输例程,其中 GTP基于A7系列FPGA开发板搭建,GTX基于K7或者ZYNQ系列FPGA开发板搭建,GTH基于KU或者V7系列FPGA开发板搭建,GTY基于KU+系列FPGA开发板搭建;以下是专栏地址:

点击直接前往

本方案在Aurora 8B10B上的应用

本方案在Aurora 8B10B上也有应用应用,可以参考我之前发布的博客,链接如下:

点击直接前往

3、工程详细设计方案

工程设计原理框图

工程设计原理框图如下:

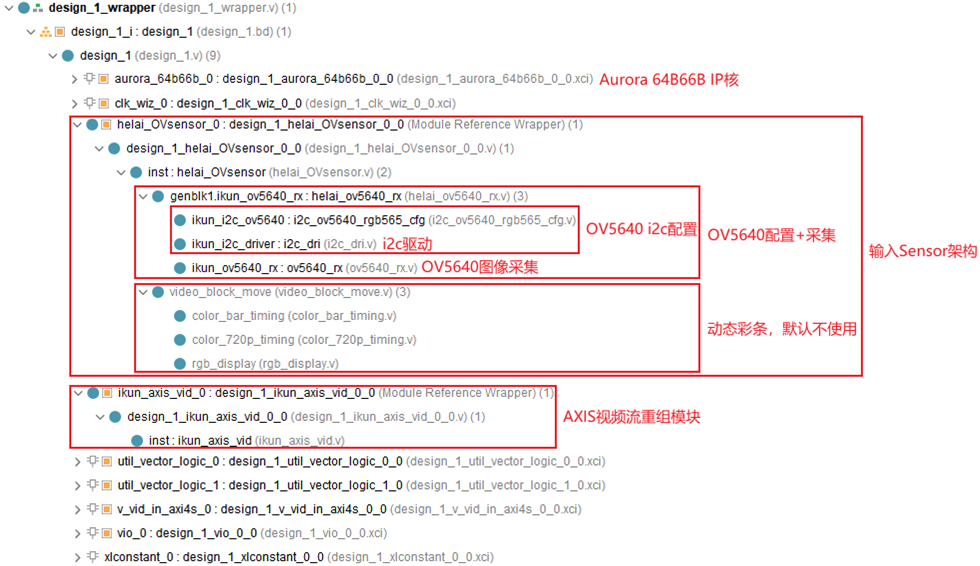

输入Sensor之-->OV5640摄像头

此模块为点对点视频发送端工程所独有;输入Sensor是本工程的输入设备,其一为OV5640摄像头,此外本博主在工程中还设计了动态彩条模块,彩条由FPGA内部逻辑产生,且是动态移动的,完全可模拟Sensor,输入源选择Sensor还是彩条,通过Sensor模块的顶层参数配置,默认选择Sensor输入;Sensor模块如下:

SENSOR_TYPE=0;则输出OV5640摄像头采集的视频;

SENSOR_TYPE=1;则输出动态彩条的视频;

OV5640摄像头需要i2c初始化配置,本设计配置为1280x720@30Hz分辨率,本设计提供纯verilog代码实现的i2c模块实现配置功能;此外,OV5640摄像头还需要图像采集模块实现两个时钟输出一个RGB565的视频转换为一个时钟输出一个RGB888视频,本设计提供纯verilog代码实现的图像采集模块实现配置功能;动态彩条则由FPGA内部逻辑实现,由纯verilog代码编写;将OV5640摄像头配置采集和动态彩条进行代码封装,形成helai_OVsensor.v的顶层模块,整个模块代码架构如下:

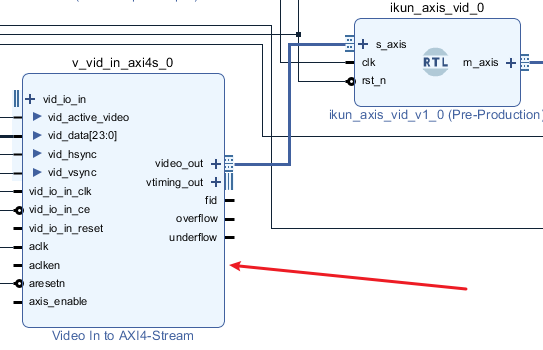

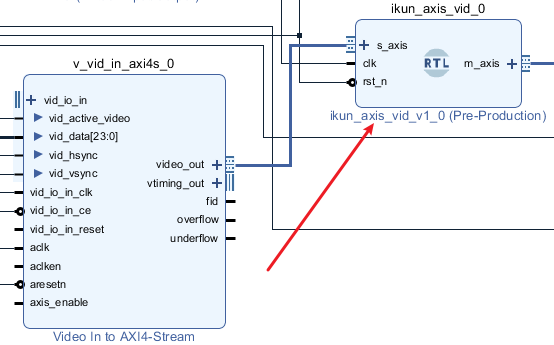

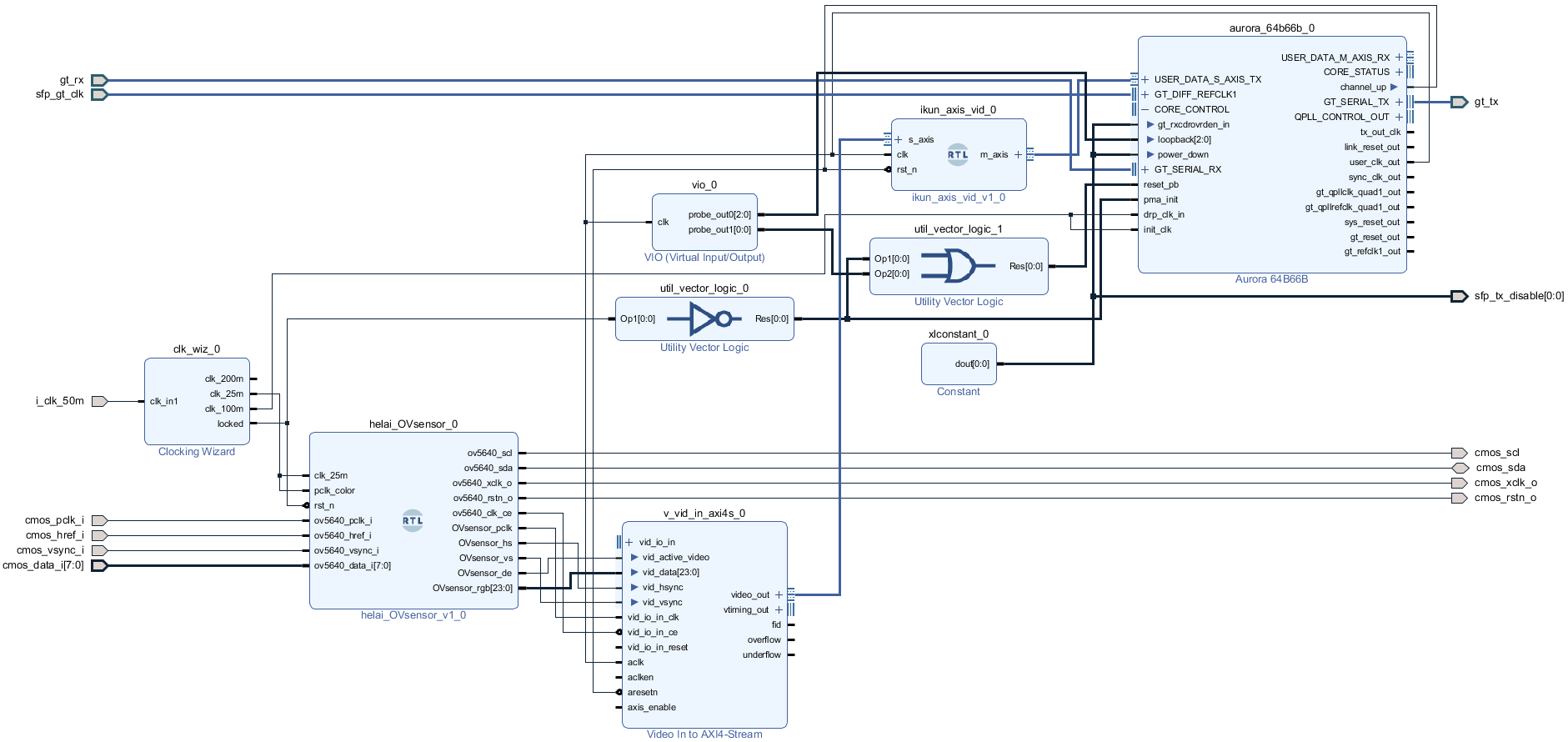

Native视频转AXIS流

此模块为点对点视频发送端工程所独有;然后采集视频送入Xilinx官方的Video In To AXI4-Stream IP核实现Native视频转换到AXI4-Stream视频流;如下:

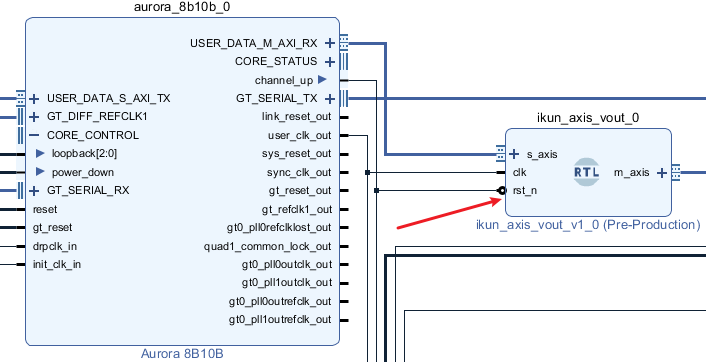

AXIS视频流重组

此模块为点对点视频发送端工程所独有;然后AXI4-Stream视频流再送入纯verilog代码实现的AXIS视频流重组模块实现信号重组,因为Aurora 8B10B发送接口不带tuser信号,所以需要将tuser嵌入到数据流中传输;将AXIS视频流重组模块直接拖入Block Design中,如下:

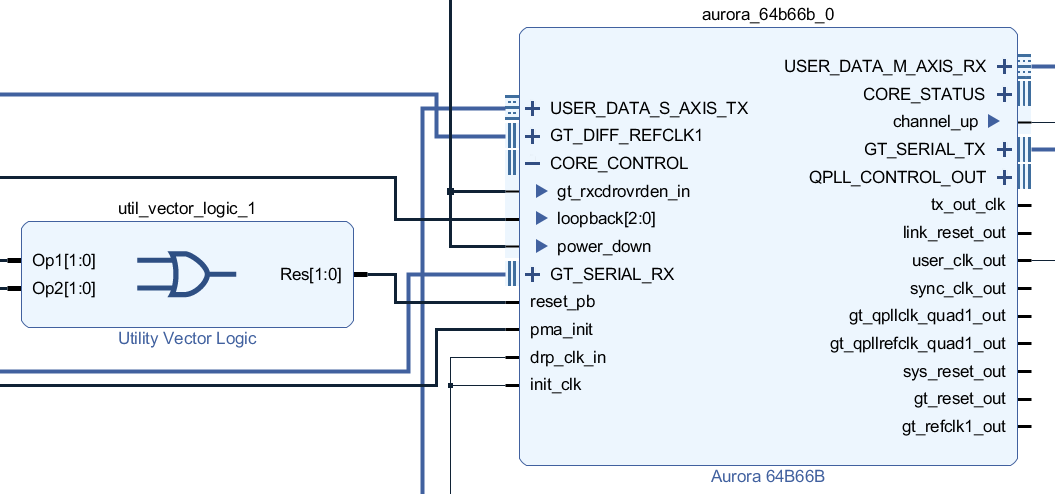

Aurora 64B66B视频传输传输架构

Aurora 64B66B视频传输传输架构在视频点对点传输发送端和接收端都用到了;

然后视频流送入Xilinx官方的Aurora 64B66B IP核实现64B66B数据编码,数据以高速差分信号输出,经板载的SFP光口进行回环传输;经SFP-RX接口输入高速差分信号再进入Xilinx官方的Aurora 64B66B IP核实现64B66B数据解码,输出AXI4-Stream视频流;本设计基于GTX高速收发器实现Aurora 64B66B图像视频传输,Aurora 64B66B在Block Design中如下:

Aurora 64B66B图像视频传输架构的核心是Aurora 64B66B IP核的例化和使用,所以本章节我们重点讲解这个IP;

Aurora 64B66BIP核简介

关于Aurora 64B66B IP核介绍最详细的肯定是Xilinx官方的《pg074_Aurora 64B/66B LogiCORE IP Product Guide》,我们以此来解读,《pg074》PDF文档我已放在了资料包里;我用到的开发板FPGA型号为Xilinx--7系列FPGA;带有多路GTX资源,每通道的收发速度为500 Mb/s到10.3125 Gb/s之间(GTX为例)。本设计使用的Aurora 64B66B IP核基于GTX高速收发器实现物理层和数据链路层;

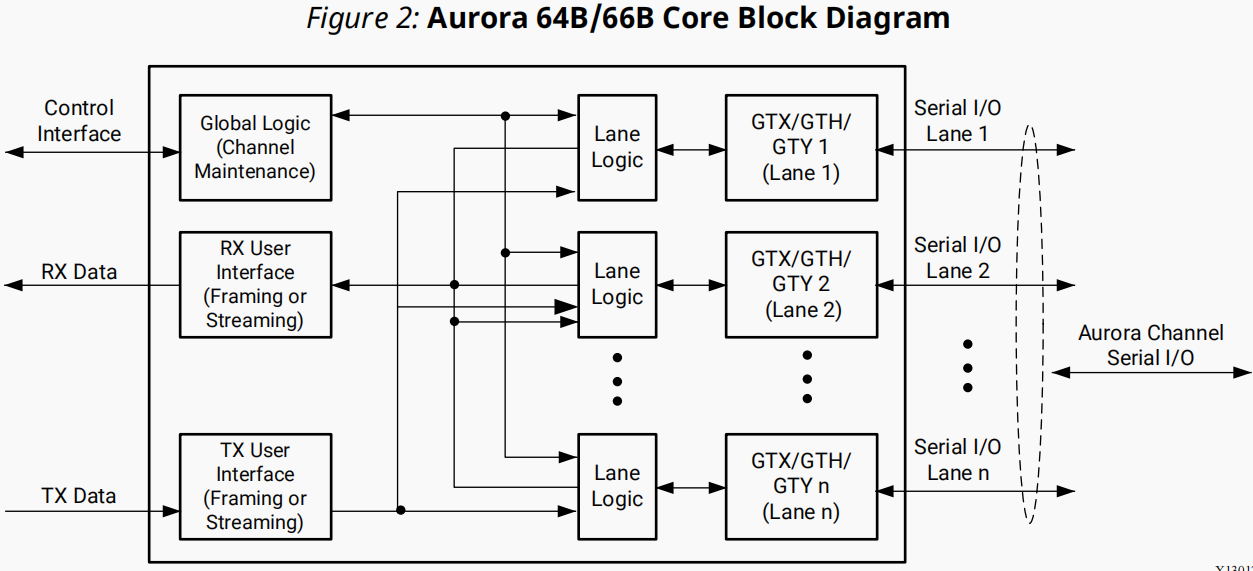

Aurora 64B66B 基本结构

根据《pg074_Aurora 64B/66B LogiCORE IP Product Guide》,Aurora 64B66B基本结构如下:

由上图可知,Aurora 64B66B IP核由四个核心模块构成,协同实现链路初始化、数据编解码及流控制:

通道逻辑(Lane Logic)

功能:驱动每个GT收发器(GTX/GTH/GTY),初始化收发器硬件,处理64B66B编解码、错误检测(如CRC校验)

关键操作:检测控制字符(如空闲符、时钟补偿符),确保数据对齐

全局逻辑(Global Logic)

功能:管理多通道绑定(Lane Bonding),验证通道同步状态,生成随机空闲字符维持链路活性,监控所有通道的错误(如hard_err硬件错误、soft_err位错误)

错误处理:检测到严重错误时自动复位并重新初始化通道

发送用户接口(TX User Interface)

接口类型:支持AXI4-Stream帧接口(带tlast/tkeep)或流接口(简化无帧控制)

功能:将应用层数据封装为Aurora帧(添加SCP/ECP控制符),插入时钟补偿序列(每10,000字节插入12字节开销)

接收用户接口(RX User Interface)

功能:解析输入数据流,剥离SCP/ECP控制符,恢复原始数据帧并通过AXI4-Stream输出;支持流量控制(如UFC/NFC)

特点:无弹性缓冲,依赖实时流控避免溢出

用户数据接口对比

Aurora 64B66B支持帧接口 (Framing) 流接口 (Streaming),对比如下:

Aurora 64B66B 发送流程

Aurora 64B66B用户发送数据使用帧接口(AXI4-Stream),包括以下流程:

用户发起传输

应用层置位s_axi_tx_tvalid并输出数据至s_axi_tx_tdata,同时用s_axi_tx_tlast标识帧结束,s_axi_tx_tkeep标记末尾有效字节

IP核组帧

当s_axi_tx_tready与s_axi_tx_tvalid同时有效时,IP核采样数据

组帧规则:

帧首添加2字节SCP(Start Channel Protocol)

帧尾添加2字节ECP(End Channel Protocol)

若数据字节数为奇数,末尾补PAD字符

插入控制序列

在数据间隙插入空闲字符或时钟补偿序列(CC),优先级高于数据传输

发送过程中可通过拉低s_axi_tx_tvalid暂停传输(流控)

串行化输出

数据经GT收发器进行64B66B编码,转为串行信号通过物理链路发送

使用总结

以上流程为Aurora 64B66B IP核内部实现,开发者只需了解即可,无需关心起具体实现细节,开发者只需把发送数据转换为AXI4-Stream数据流送入Aurora 64B66B用户发送接口即可;

Aurora 64B66B 接收流程

数据解析

GT收发器接收串行数据,进行字对齐和64B66B解码

通道逻辑检测并剥离SCP、ECP、PAD及空闲字符,提取有效负载

帧恢复与输出

恢复的数据通过AXI4-Stream接口输出:

m_axi_rx_tvalid标识有效数据

m_axi_rx_tlast标识帧结束

m_axi_rx_tkeep标记帧末有效字节(仅当tlast有效时)

无流控信号:接收端无tready,需应用层实时消费数据

错误检测

实时监测编解码错误(置位soft_err)或帧结构错误(如连续SCP,置位frame_err)

使用总结

以上流程为Aurora 64B66B IP核内部实现,开发者只需了解即可,无需关心起具体实现细节,开发者只需把Aurora 64B66B IP核输出的AXI4-Stream数据流送入自己的接收模块即可进行具体分析和处理;

Aurora 64B66B 时钟架构

Aurora 64B66B IP核涉及多时钟域协同,关键时钟信号如下:

时钟交互要点:

跨时钟域同步:INIT_CLK用于复位逻辑(gt_reset需同步至该时钟域),避免亚稳态

用户时钟生成:USER_CLK由GT收发器的CDR(时钟数据恢复)电路产生,确保与输入数据同步

抖动要求:参考时钟(GT_REFCLK)需满足严格抖动限制(通常<1 ps RMS),否则高线速下链路失锁

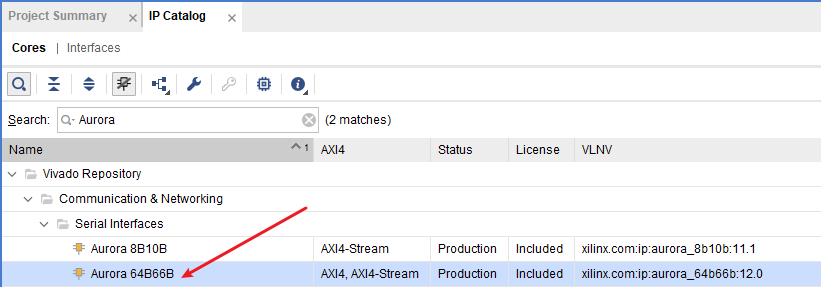

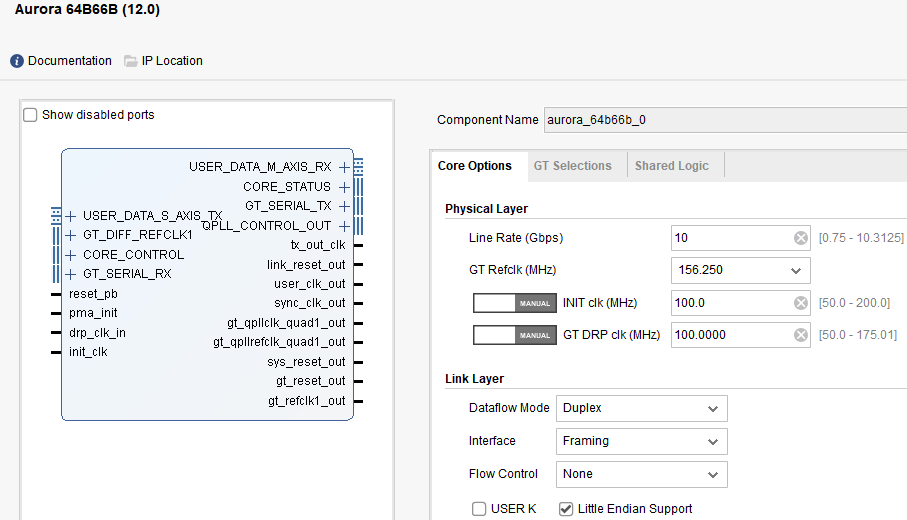

Aurora 64B66B IP核调用和使用

Aurora 64B66B IP核调用和使用很简单,通过vivado的UI界面即可完成,如下:

然后配置如下:

具体配置要根据自己的项目需求而定,上图只是博主的配置,仅供参考;

AXIS视频流恢复

此模块为点对点视频接收端工程所独有;AXI4-Stream视频流再送入纯verilog代码实现的AXIS视频流重组模块实现信号恢复,因为Aurora 8B10B接收接口不带tuser信号,所以需要在嵌入数据中的tuser恢复出来;将AXIS视频流恢复模块直接拖入Block Design中,如下:

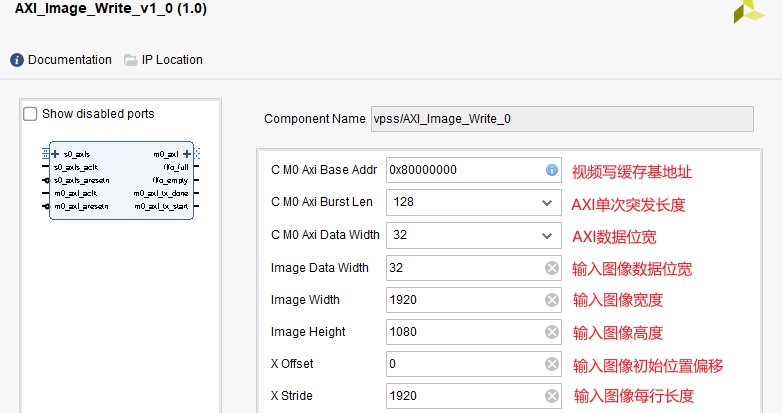

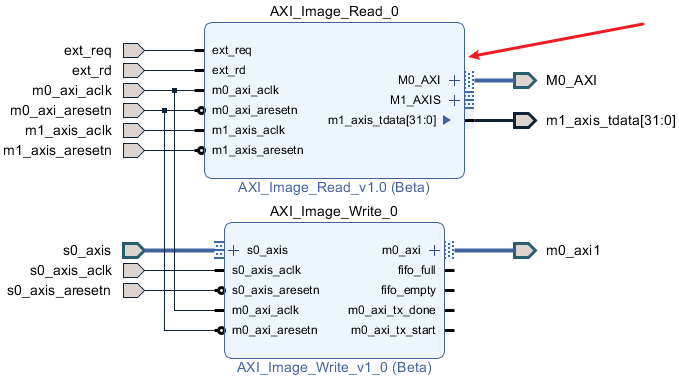

AXIS视频流写缓存

此模块为点对点视频接收端工程所独有;然后AXI4-Stream视频流送入本博主自研的纯verilog实现的、AXI4-Stream接口的图像写缓存模块,实现视频写入DDR缓存操作;AXIS视频流写缓存模块代码架构如下:

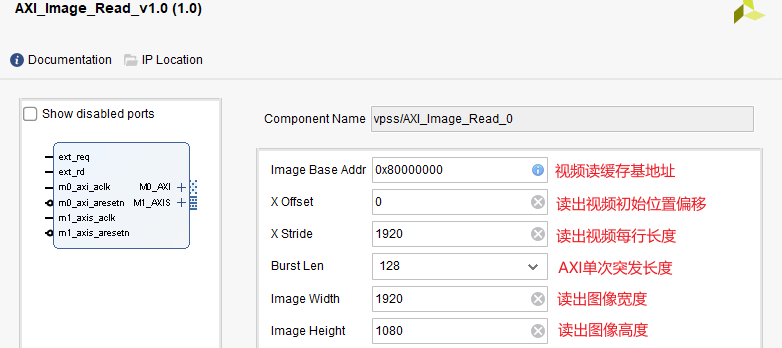

AXIS视频流写缓存模块配置项如下:

AXIS视频流写缓存模块配置在Block Design中如下:

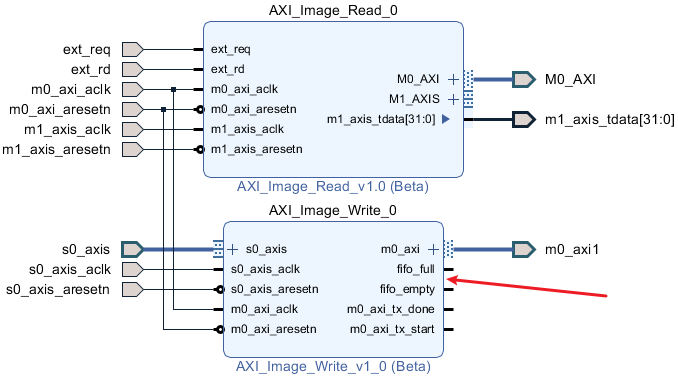

AXIS视频流读缓存

此模块为点对点视频接收端工程所独有;然后使用本博主自研的纯verilog实现的、AXI4-Stream接口的图像读缓存模块,实现视频从DDR读出操作;AXIS视频流写缓存模块代码架构如下:

AXIS视频流读缓存模块配置项如下:

AXIS视频流读缓存模块配置在Block Design中如下:

HDMI视频输出架构

此模块为点对点视频接收端工程所独有;缓存图像从DDR3读出后经过Native时序生成模块输出标准的VGA时序视频,然后经过纯verilog显示的RGB转HDMI模块输出HDMI差分视频;最后送显示器显示即可;代码例化如下:

点对点视频发送端工程源码架构

提供1套工程源码,以工程源码1为例,工程Block Design设计如下:

提供4套工程源码,以工程源码1为例,综合后的工程源码架构如下:

点对点视频接收端工程源码架构

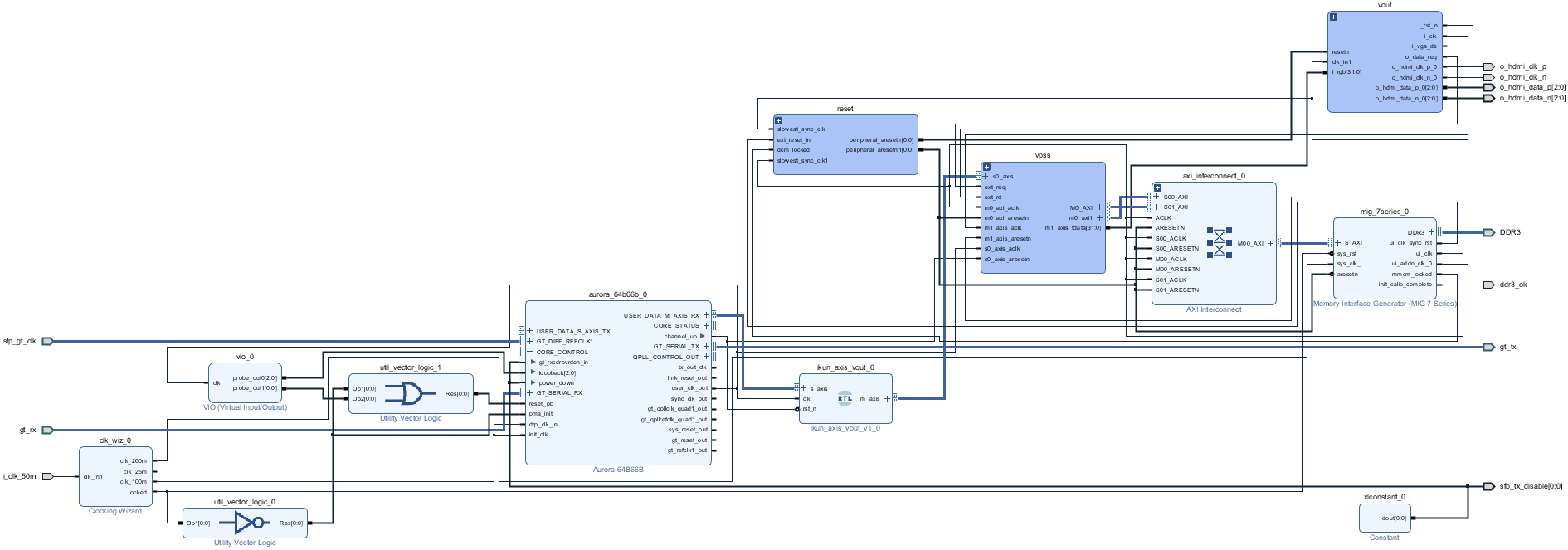

提供4套工程源码,以工程源码2为例,工程Block Design设计如下:

提供4套工程源码,以工程源码2为例,综合后的工程源码架构如下:

工程源码3、4使用了Zynq7100;PL端时钟由Zynq软核提供,所以需要运行运行SDK以启动Zynq,所以需要在SDK里运行一个简单的hello world程序,SDK软件代码架构如下:

4、vivado工程源码1详解-->Kintex7--325T,点对点OV5640视频转SFP光口发送

开发板FPGA型号:Kintex7--325T--xc7k325tffg676-2;

FPGA开发环境:Vivado2019.1;

输入:OV5640摄像头或动态彩条,分辨率1280x720@30Hz;

输出:SFP光口,分辨率1280x720@60Hz;

光编码方案:Xilinx Aurora 64B66B IP核;

回环光口类型:1路SFP光口;

高速收发器类型:GTX,线速率10Gbps;

Aurora 64B66B用户数据位宽:64 bit;

实现功能:FPGA实现Aurora 64B66B图像视频传输;

工程作用:此工程目的是让读者掌握FPGA实现Aurora 64B66B图像视频传输的设计能力,以便能够移植和设计自己的项目;

工程Block Design和工程代码架构请参考第3章节的《工程源码架构》小节内容;

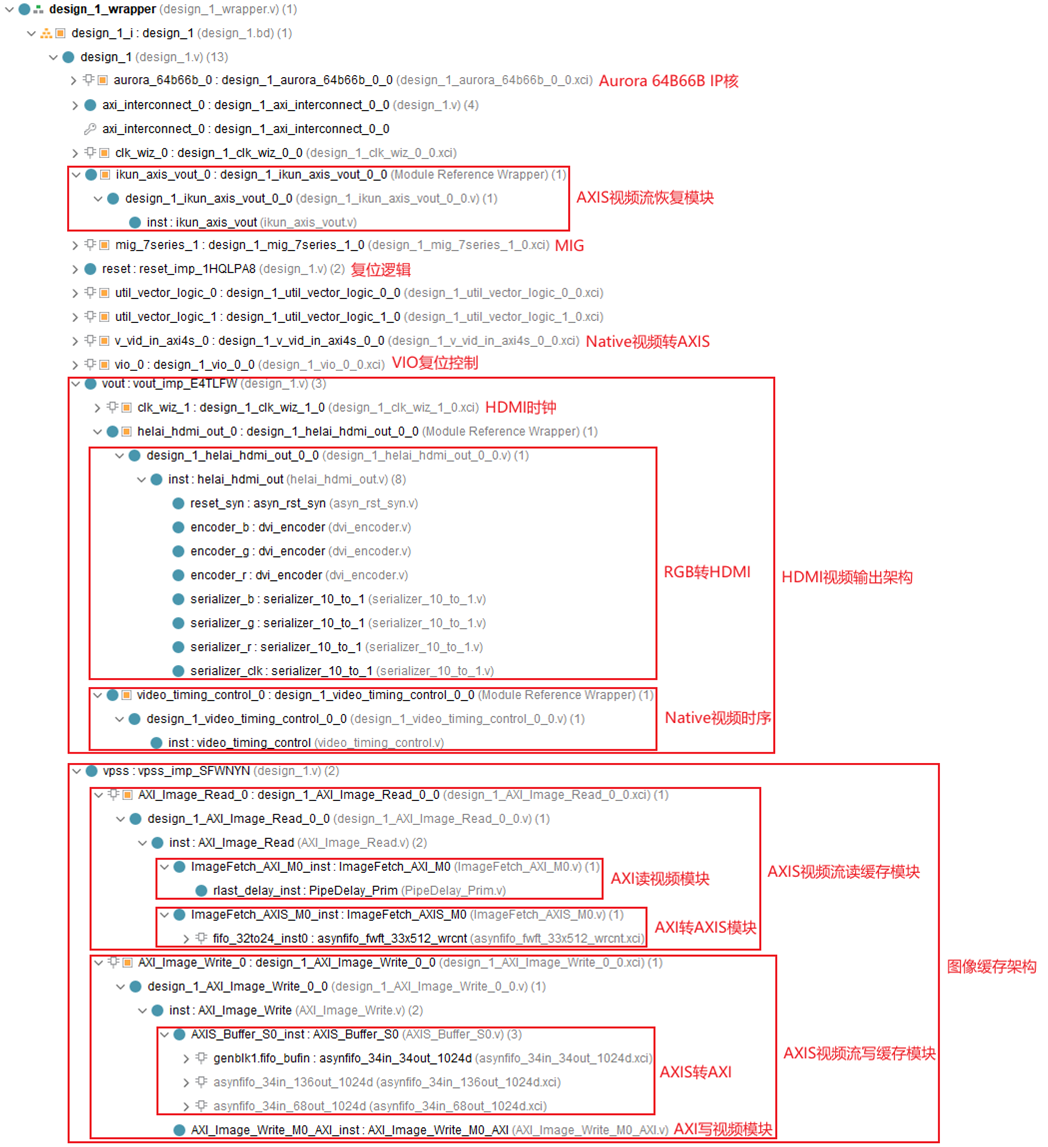

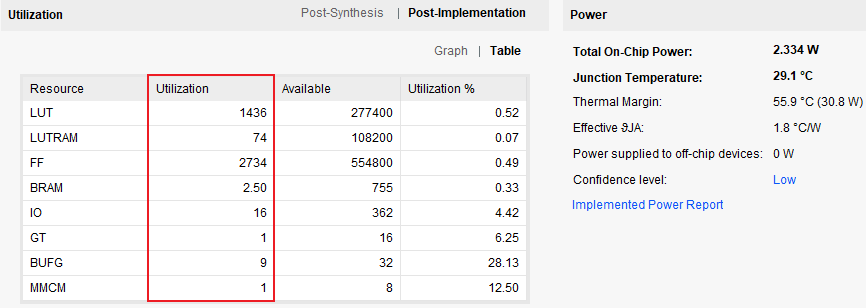

工程的资源消耗和功耗如下:

5、vivado工程源码2详解-->Kintex7--325T,点对点SFP光口接收OV5640视频转HDMI

开发板FPGA型号:Kintex7--325T--xc7k325tffg676-2;

FPGA开发环境:Vivado2019.1;

输入:SFP光口,分辨率1280x720@60Hz;

输出:HDMI,RTL逻辑编码,分辨率1280x720@60Hz;

光编码方案:Xilinx Aurora 64B66B IP核;

回环光口类型:1路SFP光口;

高速收发器类型:GTX,线速率10Gbps;

Aurora 64B66B用户数据位宽:64 bit;

实现功能:FPGA实现Aurora 64B66B图像视频传输;

工程作用:此工程目的是让读者掌握FPGA实现Aurora 64B66B图像视频传输的设计能力,以便能够移植和设计自己的项目;

工程Block Design和工程代码架构请参考第3章节的《工程源码架构》小节内容;

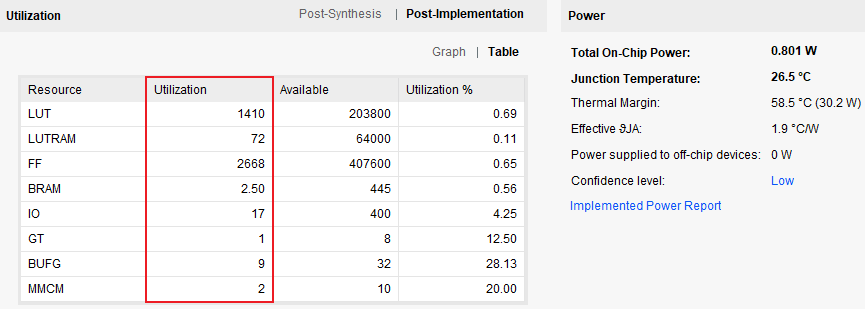

工程的资源消耗和功耗如下:

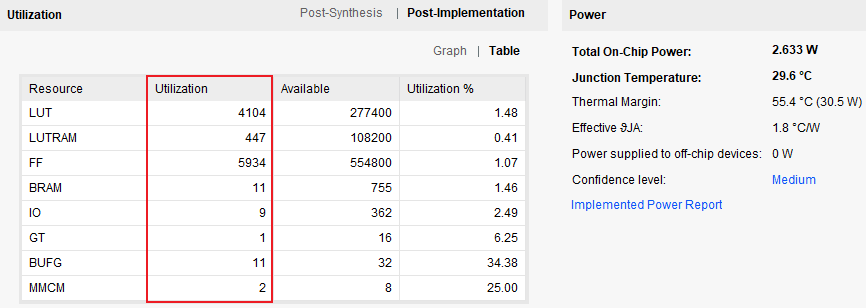

6、vivado工程源码3详解-->Zynq7100,点对点OV5640视频转SFP光口发送

开发板FPGA型号:Zynq7100--xc7z100ffg900-2;

FPGA开发环境:Vivado2019.1;

输入:OV5640摄像头或动态彩条,分辨率1280x720@30Hz;

输出:SFP光口,分辨率1280x720@60Hz;

光编码方案:Xilinx Aurora 64B66B IP核;

回环光口类型:1路SFP光口;

高速收发器类型:GTX,线速率10Gbps;

Aurora 64B66B用户数据位宽:64 bit;

实现功能:FPGA实现Aurora 64B66B图像视频传输;

工程作用:此工程目的是让读者掌握FPGA实现Aurora 64B66B图像视频传输的设计能力,以便能够移植和设计自己的项目;

工程Block Design和工程代码架构请参考第3章节的《工程源码架构》小节内容;

工程的资源消耗和功耗如下:

7、vivado工程源码4详解-->Zynq7100,点对点SFP光口接收OV5640视频转HDMI

开发板FPGA型号:Zynq7100--xc7z100ffg900-2;

FPGA开发环境:Vivado2019.1;

输入:SFP光口,分辨率1280x720@60Hz;

输出:HDMI,RTL逻辑编码,分辨率1280x720@60Hz;

光编码方案:Xilinx Aurora 64B66B IP核;

回环光口类型:1路SFP光口;

高速收发器类型:GTX,线速率10Gbps;

Aurora 64B66B用户数据位宽:64 bit;

实现功能:FPGA实现Aurora 64B66B图像视频传输;

工程作用:此工程目的是让读者掌握FPGA实现Aurora 64B66B图像视频传输的设计能力,以便能够移植和设计自己的项目;

工程Block Design和工程代码架构请参考第3章节的《工程源码架构》小节内容;

工程的资源消耗和功耗如下:

8、工程移植说明

vivado版本不一致处理

1:如果你的vivado版本与本工程vivado版本一致,则直接打开工程;

2:如果你的vivado版本低于本工程vivado版本,则需要打开工程后,点击文件-->另存为;但此方法并不保险,最保险的方法是将你的vivado版本升级到本工程vivado的版本或者更高版本;

3:如果你的vivado版本高于本工程vivado版本,解决如下:

打开工程后会发现IP都被锁住了,如下:

此时需要升级IP,操作如下:

FPGA型号不一致处理

如果你的FPGA型号与我的不一致,则需要更改FPGA型号,操作如下:

更改FPGA型号后还需要升级IP,升级IP的方法前面已经讲述了;

其他注意事项

1:由于每个板子的DDR不一定完全一样,所以MIG IP需要根据你自己的原理图进行配置,甚至可以直接删掉我这里原工程的MIG并重新添加IP,重新配置;

2:根据你自己的原理图修改引脚约束,在xdc文件中修改即可;

3:纯FPGA移植到Zynq需要在工程中添加zynq软核;

9、上板调试验证

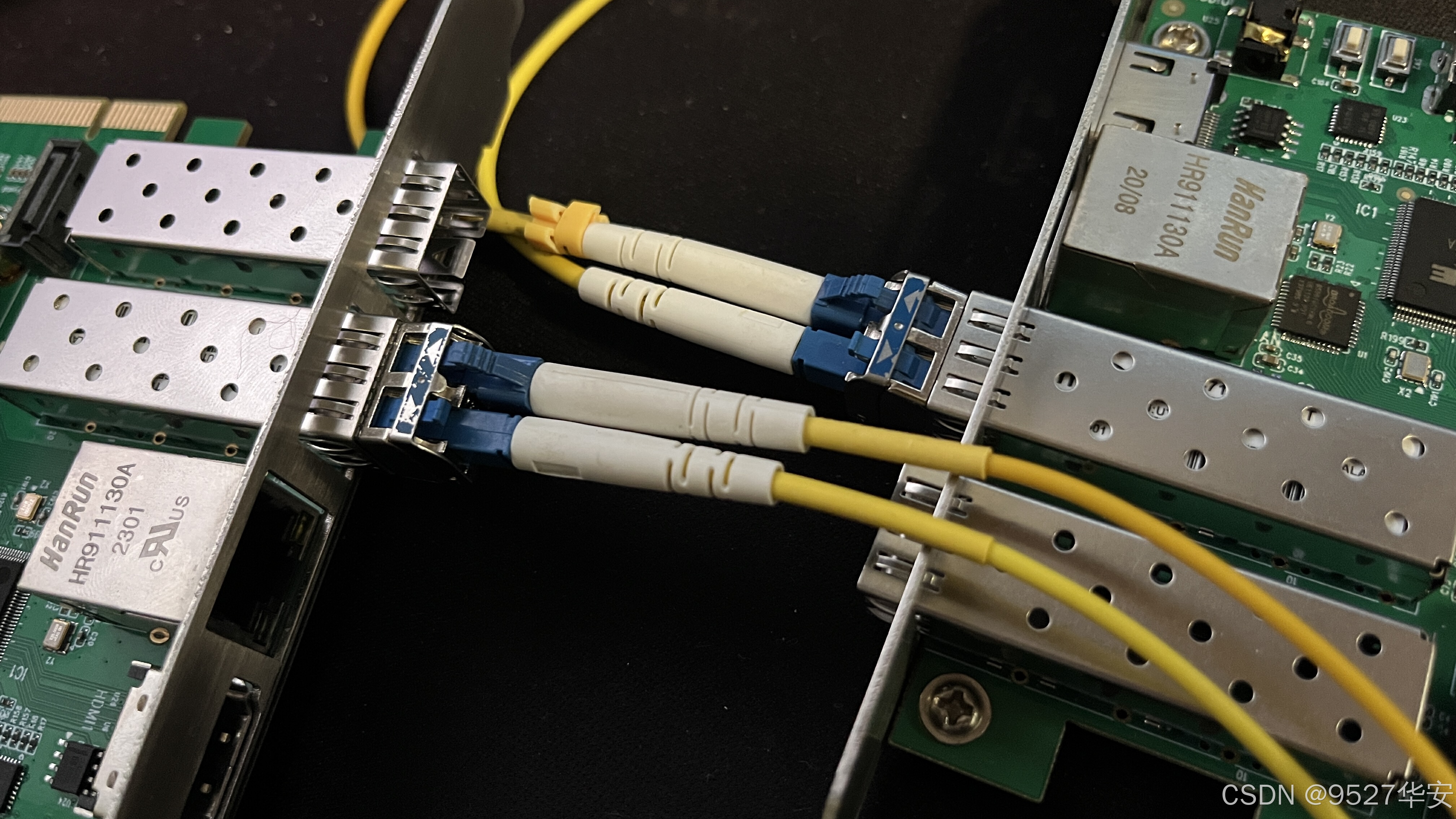

准备工作

需要准备的器材如下:

FPGA开发板,没有开发板可以找本博提供;

SFP光模块和光纤;

我的开发板了连接如下:

Aurora 64B66B 视频点对点传输效果演示

Aurora 64B66B光口视频点对点传输效果演示如下:

FPGA实现Aurora 64B66B图像视频传输

10、工程代码的获取

代码太大,无法邮箱发送,以某度网盘链接方式发送,

资料获取方式:文章末尾的V名片。

网盘资料如下:

此外,有很多朋友给本博主提了很多意见和建议,希望能丰富服务内容和选项,因为不同朋友的需求不一样,所以本博主还提供以下服务: