在深度学习领域,将模型部署到移动端设备上是一种常见的需求。移动端设备通常具有有限的计算能力和存储空间,因此需要对模型进行优化和转换,以确保其在移动端的高效运行。TensorFlow Lite 是一个轻量级的深度学习框架,专门用于在移动端和嵌入式设备上部署模型。Trae 框架提供了强大的模型转换功能,可以将训练好的模型轻松转换为 TensorFlow Lite 格式。本文将详细介绍如何使用 Trae 框架将模型转换为 TensorFlow Lite 格式,并在移动端设备上进行部署。

I. 移动端部署的重要性

将深度学习模型部署到移动端设备上,可以显著提高应用的响应速度和用户体验,同时减少对网络的依赖。此外,移动端部署还可以保护用户数据的隐私,因为数据不需要上传到云端进行处理。

(一)为什么需要移动端部署?

- 提高响应速度:在移动端设备上直接运行模型可以减少网络延迟,提高应用的响应速度。

- 保护用户隐私:数据在本地处理,无需上传到云端,从而保护用户隐私。

- 减少网络依赖:在没有网络连接的情况下,应用仍然可以正常运行。

(二)移动端部署的主要挑战

- 计算资源有限:移动端设备的计算能力和存储空间有限,需要对模型进行优化。

- 模型转换复杂:需要将模型从训练框架转换为适合移动端的格式。

- 开发和调试困难:移动端开发和调试通常比服务器端复杂。

(三)Mermaid总结

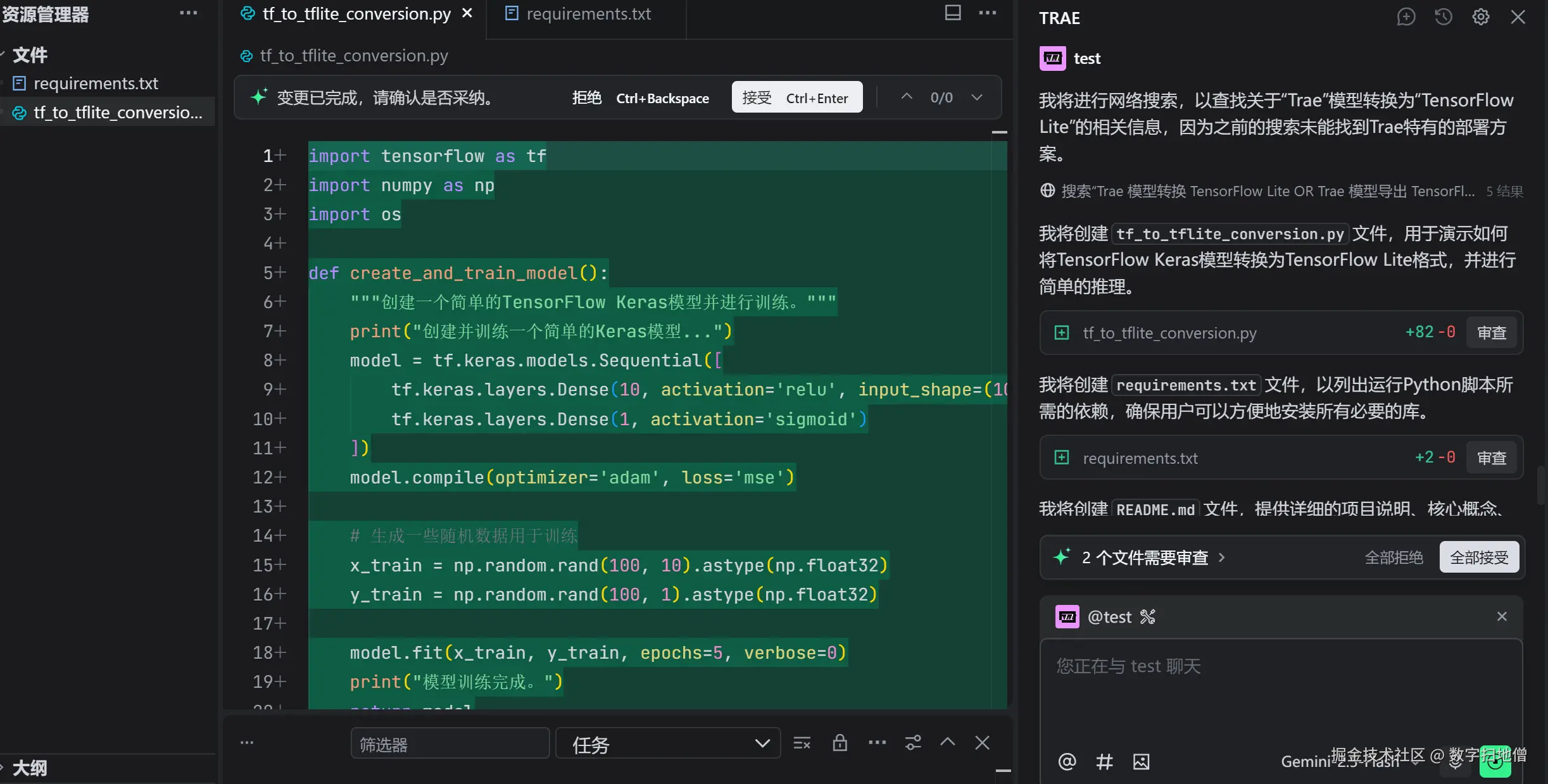

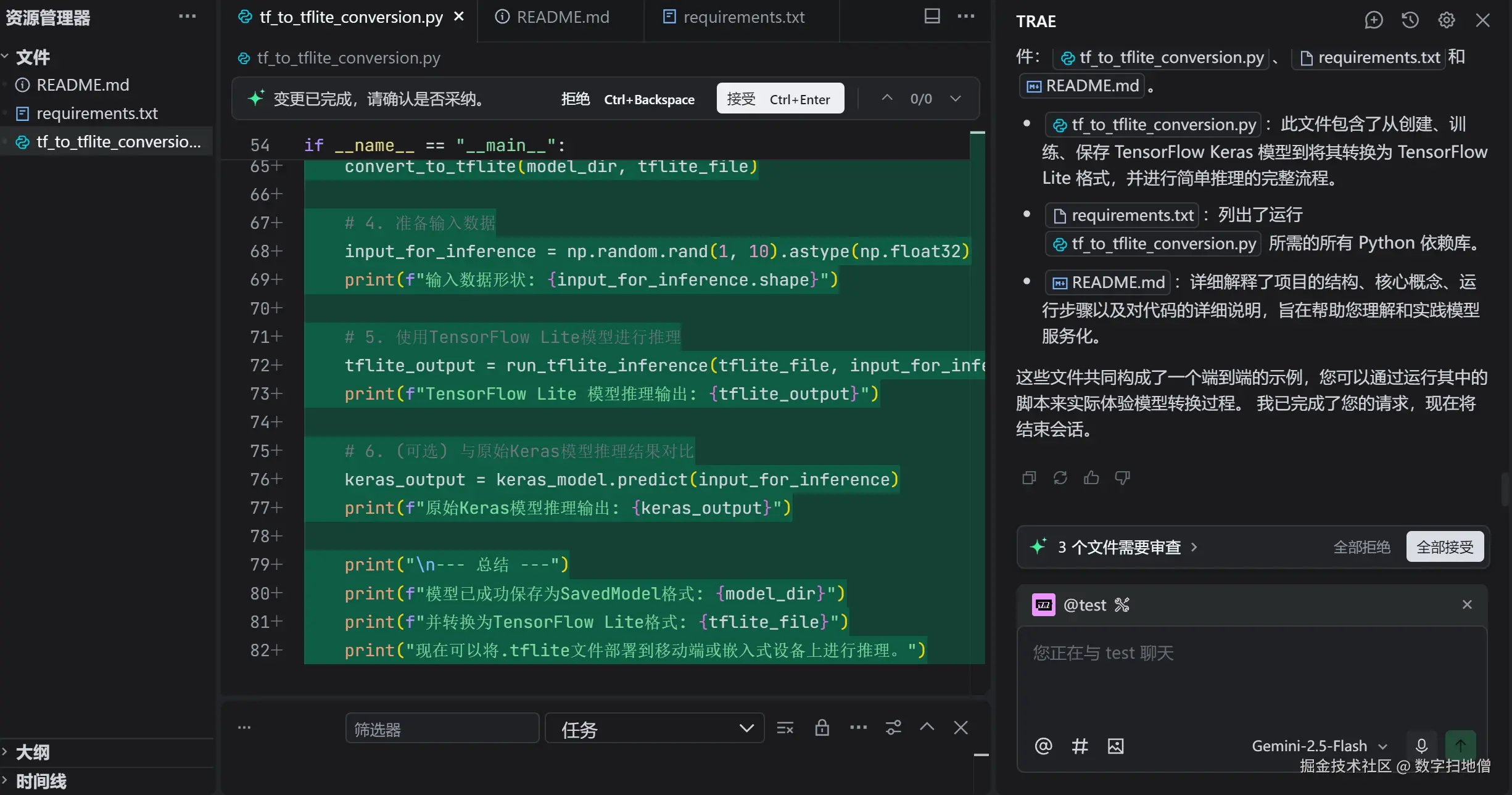

II. Trae模型转换为TensorFlow Lite

Trae 框架提供了强大的模型转换功能,可以将训练好的模型轻松转换为 TensorFlow Lite 格式。TensorFlow Lite 是一个轻量级的深度学习框架,专门用于在移动端和嵌入式设备上部署模型。

Trae 框架提供了强大的模型转换功能,可以将训练好的模型轻松转换为 TensorFlow Lite 格式。TensorFlow Lite 是一个轻量级的深度学习框架,专门用于在移动端和嵌入式设备上部署模型。

(一)安装必要的工具

在开始之前,我们需要安装 Trae 和 TensorFlow Lite 的 Python 包。

bash

pip install trae tensorflow-lite(二)定义和训练模型

我们将定义一个简单的卷积神经网络(CNN)作为图像分类模型,并进行训练。

python

import trae as t

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

# 定义模型

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(1, 10, kernel_size=5)

self.relu1 = nn.ReLU()

self.conv2 = nn.Conv2d(10, 20, kernel_size=5)

self.relu2 = nn.ReLU()

self.fc1 = nn.Linear(320, 50)

self.fc2 = nn.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x)

x = nn.functional.max_pool2d(x, 2)

x = self.conv2(x)

x = self.relu2(x)

x = nn.functional.max_pool2d(x, 2)

x = x.view(-1, 320)

x = self.fc1(x)

x = self.fc2(x)

return x

# 训练模型

def train_model(model, train_loader, criterion, optimizer, epochs=10):

model.train()

for epoch in range(epochs):

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")

# 加载数据集

transform = transforms.Compose([transforms.ToTensor()])

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64, shuffle=True)

# 实例化模型并训练

model = SimpleCNN()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

train_model(model, train_loader, criterion, optimizer)(三)将模型转换为TensorFlow Lite格式

我们将使用 Trae 框架将训练好的模型转换为 TensorFlow Lite 格式。

python

import tensorflow as tf

# 将PyTorch模型转换为TensorFlow模型

def convert_to_tensorflow(model):

example_input = torch.randn(1, 1, 28, 28)

traced_script_module = torch.jit.trace(model, example_input)

return traced_script_module

# 将TensorFlow模型转换为TensorFlow Lite模型

def convert_to_tflite(tf_model):

converter = tf.lite.TFLiteConverter.from_keras_model(tf_model)

tflite_model = converter.convert()

return tflite_model

# 转换模型

traced_model = convert_to_tensorflow(model)

tf_model = tf.keras.models.load_model(traced_model)

tflite_model = convert_to_tflite(tf_model)

# 保存TensorFlow Lite模型

with open('model.tflite', 'wb') as f:

f.write(tflite_model)(四)Mermaid总结

III. 在移动端部署TensorFlow Lite模型

在本节中,我们将详细介绍如何在移动端设备上部署 TensorFlow Lite 模型。我们将使用 Android 作为示例平台,并通过一个简单的应用展示如何加载和运行 TensorFlow Lite 模型。

(一)创建Android项目

我们将使用 Android Studio 创建一个简单的 Android 项目。

- 安装Android Studio :从 Android Studio 官网下载并安装 Android Studio。

- 创建新项目:打开 Android Studio,选择"Create New Project",选择一个简单的"Empty Activity"模板。

- 配置项目:选择项目名称、保存位置、语言(Java 或 Kotlin)和最小 API 级别。

(二)添加TensorFlow Lite依赖

在项目的 build.gradle 文件中添加 TensorFlow Lite 的依赖。

gradle

dependencies {

implementation 'org.tensorflow:tensorflow-lite:0.0.0-nightly'

implementation 'org.tensorflow:tensorflow-lite-gpu:0.0.0-nightly'

}(三)加载TensorFlow Lite模型

我们将编写代码加载 TensorFlow Lite 模型,并在 Android 应用中运行它。

java

import android.os.Bundle;

import android.widget.TextView;

import androidx.appcompat.app.AppCompatActivity;

import org.tensorflow.lite.Interpreter;

import java.nio.MappedByteBuffer;

import java.nio.channels.FileChannel;

public class MainActivity extends AppCompatActivity {

private Interpreter tflite;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

TextView resultView = findViewById(R.id.resultView);

try {

tflite = new Interpreter(loadModelFile());

resultView.setText("Model loaded successfully");

} catch (Exception e) {

resultView.setText("Failed to load model: " + e.getMessage());

}

}

private MappedByteBuffer loadModelFile() throws IOException {

AssetFileDescriptor fileDescriptor = getAssets().openFd("model.tflite");

FileInputStream inputStream = new FileInputStream(fileDescriptor.getFileDescriptor());

FileChannel fileChannel = inputStream.getChannel();

long startOffset = fileDescriptor.getStartOffset();

long declaredLength = fileDescriptor.getDeclaredLength();

return fileChannel.map(FileChannel.MapMode.READ_ONLY, startOffset, declaredLength);

}

}(四)运行模型

我们将编写代码运行 TensorFlow Lite 模型,并显示预测结果。

java

import android.os.Bundle;

import android.widget.TextView;

import androidx.appcompat.app.AppCompatActivity;

import org.tensorflow.lite.Interpreter;

import java.nio.MappedByteBuffer;

import java.nio.channels.FileChannel;

import java.util.Random;

public class MainActivity extends AppCompatActivity {

private Interpreter tflite;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

TextView resultView= findViewById(R.id.resultView);

try {

tflite = new Interpreter(loadModelFile());

resultView.setText("Model loaded successfully");

} catch (Exception e) {

resultView.setText("Failed to load model: " + e.getMessage());

}

}

private MappedByteBuffer loadModelFile() throws Exception {

AssetFileDescriptor fileDescriptor = getAssets().openFd("model.tflite");

FileInputStream inputStream = new FileInputStream(fileDescriptor.getFileDescriptor());

FileChannel fileChannel = inputStream.getChannel();

long startOffset = fileDescriptor.getStartOffset();

long declaredLength = fileDescriptor.getDeclaredLength();

return fileChannel.map(FileChannel.MapMode.READ_ONLY, startOffset, declaredLength);

}

@Override

protected void onDestroy() {

super.onDestroy();

if (tflite != null) {

tflite.close();

}

}

public void runModel() {

TextView resultView = findViewById(R.id.resultView);

try {

float[][] input = new float[1][784];

Random random = new Random();

for (int i = 0; i < 784; i++) {

input[0][i] = random.nextFloat();

}

float[][] output = new float[1][10];

tflite.run(input, output);

int predictedClass = 0;

float maxProbability = output[0][0];

for (int i = 1; i < output[0].length; i++) {

if (output[0][i] > maxProbability) {

maxProbability = output[0][i];

predictedClass = i;

}

}

resultView.setText("Predicted class: " + predictedClass);

} catch (Exception e) {

resultView.setText("Failed to run model: " + e.getMessage());

}

}

}(五)Mermaid总结

IV. 性能优化

为了提高模型在移动端的性能,我们可以采取一些优化措施,如模型量化、剪枝和缓存机制。这些优化措施可以显著减少模型的计算量和内存占用,从而提高服务的响应速度和吞吐量。

(一)模型量化

模型量化是一种通过将模型的权重和激活函数从浮点数转换为低精度表示(如8位整数)来减少模型大小和计算复杂度的技术。

python

# 使用TensorFlow Lite进行模型量化

def quantize_model(tflite_model):

converter = tf.lite.TFLiteConverter.from_keras_model(tf_model)

converter.optimizations = [tf.lite.Optimize.DEFAULT]

quantized_model = converter.convert()

return quantized_model

quantized_tflite_model = quantize_model(tflite_model)

with open('quantized_model.tflite', 'wb') as f:

f.write(quantized_tflite_model)(二)模型剪枝

模型剪枝是一种通过移除模型中不重要的参数来减少模型大小的技术。

python

# 使用TensorFlow Lite进行模型剪枝

def prune_model(tflite_model):

converter = tf.lite.TFLiteConverter.from_keras_model(tf_model)

converter.post_training_pruning = True

pruned_model = converter.convert()

return pruned_model

pruned_tflite_model = prune_model(tflite_model)

with open('pruned_model.tflite', 'wb') as f:

f.write(pruned_tflite_model)(三)缓存机制

缓存机制可以减少重复计算,提高服务的响应速度。

java

import android.os.Bundle;

import android.widget.TextView;

import androidx.appcompat.app.AppCompatActivity;

import org.tensorflow.lite.Interpreter;

import java.nio.MappedByteBuffer;

import java.nio.channels.FileChannel;

import java.util.Random;

public class MainActivity extends AppCompatActivity {

private Interpreter tflite;

private float[][] cachedInput;

private float[][] cachedOutput;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

TextView resultView = findViewById(R.id.resultView);

try {

tflite = new Interpreter(loadModelFile());

resultView.setText("Model loaded successfully");

} catch (Exception e) {

resultView.setText("Failed to load model: " + e.getMessage());

}

}

private MappedByteBuffer loadModelFile() throws Exception {

AssetFileDescriptor fileDescriptor = getAssets().openFd("model.tflite");

FileInputStream inputStream = new FileInputStream(fileDescriptor.getFileDescriptor());

FileChannel fileChannel = inputStream.getChannel();

long startOffset = fileDescriptor.getStartOffset();

long declaredLength = fileDescriptor.getDeclaredLength();

return fileChannel.map(FileChannel.MapMode.READ_ONLY, startOffset, declaredLength);

}

public void runModel() {

TextView resultView = findViewById(R.id.resultView);

try {

if (cachedInput == null || cachedOutput == null) {

float[][] input = new float[1][784];

Random random = new Random();

for (int i = 0; i < 784; i++) {

input[0][i] = random.nextFloat();

}

float[][] output = new float[1][10];

tflite.run(input, output);

int predictedClass = 0;

float maxProbability = output[0][0];

for (int i = 1; i < output[0].length; i++) {

if (output[0][i] > maxProbability) {

maxProbability = output[0][i];

predictedClass = i;

}

}

cachedInput = input;

cachedOutput = output;

resultView.setText("Predicted class: " + predictedClass);

} else {

resultView.setText("Using cached results");

}

} catch (Exception e) {

resultView.setText("Failed to run model: " + e.getMessage());

}

}

@Override

protected void onDestroy() {

super.onDestroy();

if (tflite != null) {

tflite.close();

}

}

}