在深度学习项目中,性能调优是一个至关重要的环节。无论是模型训练还是推理,高效的性能都能显著提升开发效率和用户体验。Trae 框架提供了强大的性能分析和优化工具,帮助开发者识别和解决计算瓶颈。本文将详细介绍如何使用 Trae 进行计算瓶颈分析,并提供一系列优化策略,以提升模型的训练和推理速度。

I. 性能调优的重要性

性能调优不仅能加快模型的训练和推理速度,还能减少资源消耗,降低运营成本。在资源受限的环境中,如移动端或嵌入式设备,性能调优更是关键。

(一)为什么需要性能调优?

- 提升效率:优化后的模型训练和推理速度更快,能显著提高开发效率。

- 降低成本:减少计算资源的使用,降低硬件成本和能源消耗。

- 改善体验:更快的响应时间能提升用户满意度,尤其在实时应用中。

(二)性能调优的主要挑战

- 复杂模型:深度学习模型结构复杂,难以快速定位瓶颈。

- 资源限制:在有限的硬件资源下,优化空间有限。

- 动态需求:模型的输入数据和运行环境可能动态变化,需要灵活调整优化策略。

(三)Mermaid总结

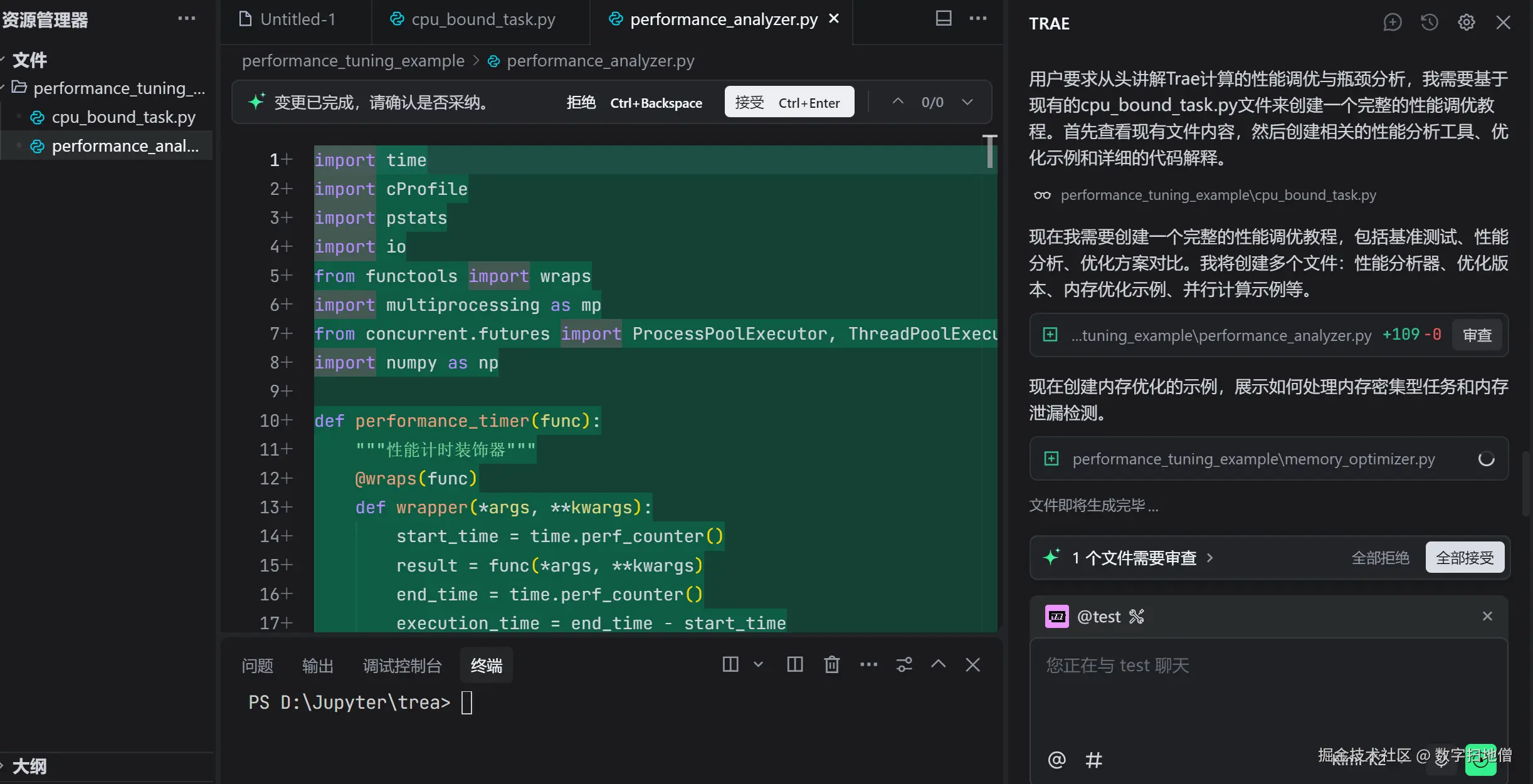

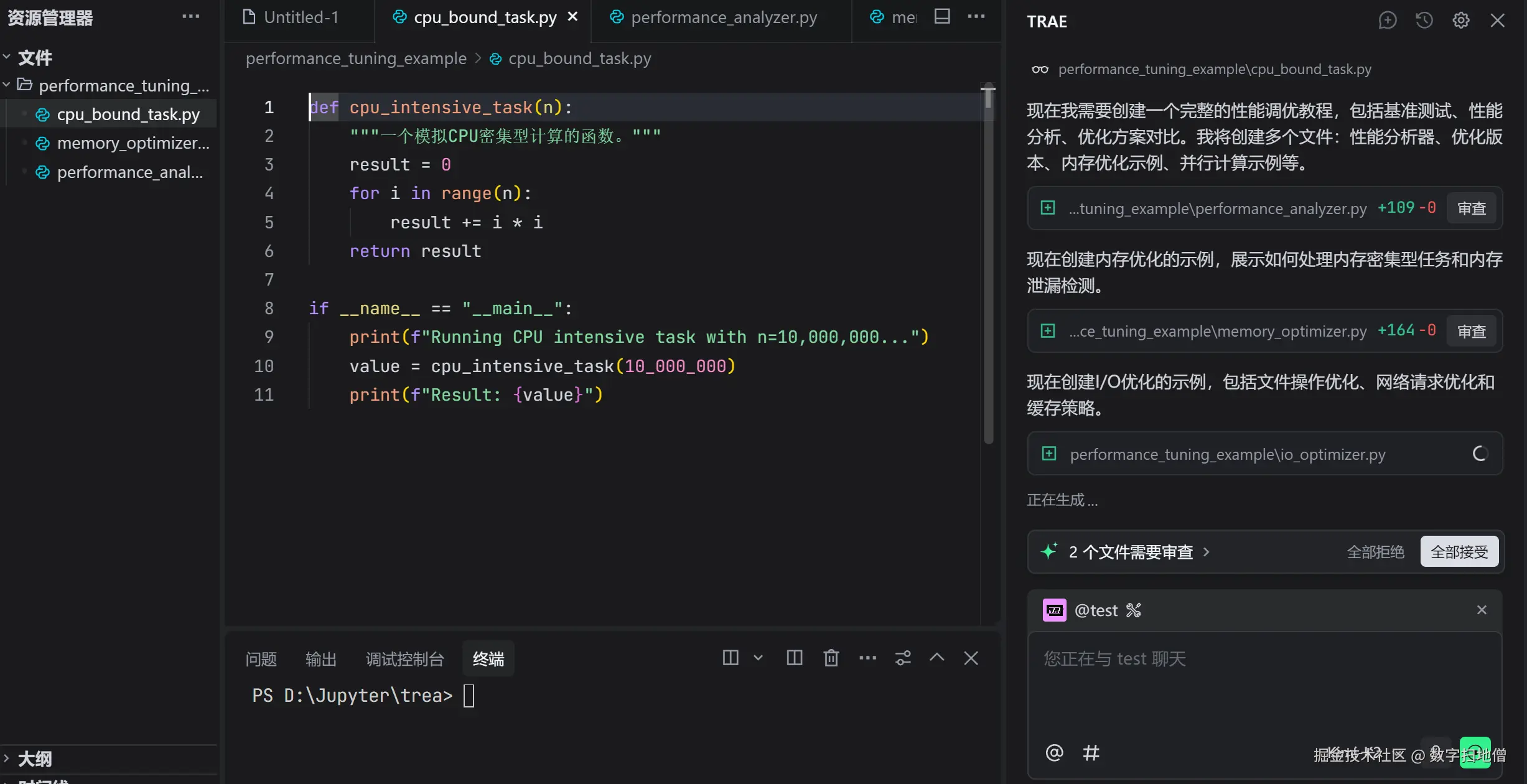

II. Trae计算瓶颈分析

Trae 提供了丰富的工具来分析模型的性能瓶颈。通过这些工具,我们可以快速定位问题所在,并采取相应的优化措施。

Trae 提供了丰富的工具来分析模型的性能瓶颈。通过这些工具,我们可以快速定位问题所在,并采取相应的优化措施。

(一)安装 Trae 性能分析工具

在开始之前,确保你已经安装了 Trae 和相关工具。

bash

pip install trae(二)定义和训练模型

我们将定义一个简单的卷积神经网络(CNN)作为图像分类模型,并进行训练。

python

import trae as t

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

# 定义模型

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(1, 10, kernel_size=5)

self.relu1 = nn.ReLU()

self.conv2 = nn.Conv2d(10, 20, kernel_size=5)

self.relu2 = nn.ReLU()

self.fc1 = nn.Linear(320, 50)

self.fc2 = nn.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x)

x = nn.functional.max_pool2d(x, 2)

x = self.conv2(x)

x = self.relu2(x)

x = nn.functional.max_pool2d(x, 2)

x = x.view(-1, 320)

x = self.fc1(x)

x = self.fc2(x)

return x

# 训练模型

def train_model(model, train_loader, criterion, optimizer, epochs=10):

model.train()

for epoch in range(epochs):

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")

# 加载数据集

transform = transforms.Compose([transforms.ToTensor()])

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64, shuffle=True)

# 实例化模型并训练

model = SimpleCNN()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

train_model(model, train_loader, criterion, optimizer)(三)使用 Trae 分析计算瓶颈

Trae 提供了性能分析工具,可以帮助我们识别模型中的计算瓶颈。

python

import trae.profiler as profiler

# 使用 Trae 分析工具

with profiler.profile(model) as prof:

train_model(model, train_loader, criterion, optimizer, epochs=1)

# 打印分析结果

print(prof.summary())(四)Mermaid总结

III. 性能优化策略

在识别了计算瓶颈之后,我们可以采取一系列优化策略来提升模型的性能。

(一)模型结构优化

优化模型结构可以减少计算量和内存占用,从而提高性能。

1. 精简模型

- 减少层数:移除不必要的层。

- 减少通道数:减少卷积层的通道数。

2. 替换层

- 使用更高效的层:例如,用 GroupNorm 替代 BatchNorm。

- 使用深度可分离卷积:减少计算量。

(二)代码优化

优化代码可以减少不必要的计算和内存访问,从而提高性能。

1. 使用 inplace 操作

- 减少内存分配:使用 inplace 操作减少不必要的内存分配。

2. 避免重复计算

- 缓存中间结果:避免重复计算相同的中间结果。

(三)硬件优化

利用硬件特性可以显著提升性能。

1. 使用 GPU 加速

- 确保在 GPU 上运行:将模型和数据移动到 GPU 上。

- 使用混合精度训练:减少内存占用,加速训练。

2. 使用分布式训练

- 多 GPU 训练:使用多个 GPU 分布式训练,加速模型训练。

(四)Mermaid总结

IV. 实战案例:优化图像分类模型

在本节中,我们将通过一个实战案例来展示如何使用 Trae 框架优化图像分类模型的性能。我们将从模型结构优化、代码优化和硬件优化三个方面入手,逐步提升模型的性能。

(一)数据准备

我们将使用 MNIST 数据集作为示例。MNIST 是一个手写数字识别数据集,包含 60,000 个训练样本和 10,000 个测试样本。

python

import trae as t

from trae.datasets import MNIST

# 加载数据集

train_dataset = MNIST(root='./data', train=True, download=True, transform=t.ToTensor())

test_dataset = MNIST(root='./data', train=False, download=True, transform=t.ToTensor())

train_loader = t.DataLoader(train_dataset, batch_size=64, shuffle=True)

test_loader = t.DataLoader(test_dataset, batch_size=1000, shuffle=False)(二)定义模型

我们将定义一个简单的卷积神经网络(CNN)作为图像分类模型。

python

class SimpleCNN(t.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = t.Conv2d(1, 10, kernel_size=5)

self.relu1 = t.ReLU()

self.conv2 = t.Conv2d(10, 20, kernel_size=5)

self.relu2 = t.ReLU()

self.fc1 = t.Linear(320, 50)

self.fc2 = t.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x)

x = t.max_pool2d(x, 2)

x = self.conv2(x)

x = self.relu2(x)

x = t.max_pool2d(x, 2)

x = x.view(-1, 320)

x = self.fc1(x)

x = self.fc2(x)

return x(三)模型结构优化

我们将优化模型结构,减少计算量和内存占用。

1. 精简模型

- 减少通道数:将卷积层的通道数从 10 和 20 减少到 8 和 16。

python

class OptimizedCNN(t.Module):

def __init__(self):

super(OptimizedCNN, self).__init__()

self.conv1 = t.Conv2d(1, 8, kernel_size=5)

self.relu1 = t.ReLU()

self.conv2 = t.Conv2d(8, 16, kernel_size=5)

self.relu2 = t.ReLU()

self.fc1 = t.Linear(256, 50)

self.fc2 = t.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x)

x = t.max_pool2d(x, 2)

x = self.conv2(x)

x = self.relu2(x)

x = t.max_pool2d(x, 2)

x = x.view(-1, 256)

x = self.fc1(x)

x = self.fc2(x)

return x2. 替换层

- 使用 GroupNorm 替代 BatchNorm:减少内存占用。

python

class OptimizedCNN(t.Module):

def __init__(self):

super(OptimizedCNN, self).__init__()

self.conv1 = t.Conv2d(1, 8, kernel_size=5)

self.norm1 = t.GroupNorm(2, 8)

self.relu1 = t.ReLU()

self.conv2 = t.Conv2d(8, 16, kernel_size=5)

self.norm2 = t.GroupNorm(2, 16)

self.relu2 = t.ReLU()

self.fc1 = t.Linear(256, 50)

self.fc2 = t.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.norm1(x)

x = self.relu1(x)

x = t.max_pool2d(x, 2)

x = self.conv2(x)

x = self.norm2(x)

x = self.relu2(x)

x = t.max_pool2d(x, 2)

x = x.view(-1, 256)

x = self.fc1(x)

x = self.fc2(x)

return x(四)代码优化

我们将优化代码,减少不必要的计算和内存访问。

1. 使用 inplace 操作

- 减少内存分配:使用 inplace 操作减少不必要的内存分配。

python

class OptimizedCNN(t.Module):

def __init__(self):

super(OptimizedCNN, self).__init__()

self.conv1 = t.Conv2d(1, 8, kernel_size=5)

self.norm1 = t.GroupNorm(2, 8)

self.relu1 = t.ReLU(inplace=True)

self.conv2 = t.Conv2d(8, 16, kernel_size=5)

self.norm2 = t.GroupNorm(2, 16)

self.relu2 = t.ReLU(inplace=True)

self.fc1 = t.Linear(256, 50)

self.fc2 = t.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.norm1(x)

x = self.relu1(x)

x = t.max_pool2d(x, 2)

x = self.conv2(x)

x = self.norm2(x)

x = self.relu2(x)

x = t.max_pool2d(x, 2)

x = x.view(-1, 256)

x = self.fc1(x)

x = self.fc2(x)

return x2. 避免重复计算

- 缓存中间结果:避免重复计算相同的中间结果。

python

class OptimizedCNN(t.Module):

def __init__(self):

super(OptimizedCNN, self).__init__()

self.conv1 = t.Conv2d(1, 8, kernel_size=5)

self.norm1 = t.GroupNorm(2, 8)

self.relu1 = t.ReLU(inplace=True)

self.conv2 = t.Conv2d(8, 16, kernel_size=5)

self.norm2 = t.GroupNorm(2, 16)

self.relu2 = t.ReLU(inplace=True)

self.fc1 = t.Linear(256, 50)

self.fc2 = t.Linear(50, 10)

def forward(self, x):

x = self.conv1(x)

x = self.norm1(x)

x = self.relu1(x)

x = t.max_pool2d(x, 2)

x = self.conv2(x)

x = self.norm2(x)

x = self.relu2(x)

x = t.max_pool2d(x, 2)

x = x.view(-1, 256)

x = self.fc1(x)

x = self.fc2(x)

return x(五)硬件优化

我们将利用硬件特性来提升模型的性能。

1. 使用 GPU 加速

- 确保在 GPU 上运行:将模型和数据移动到 GPU 上。

- 使用混合精度训练:减少内存占用,加速训练。

python

# 将模型和数据移动到 GPU 上

device = t.device('cuda' if t.cuda.is_available() else 'cpu')

model = OptimizedCNN().to(device)

# 使用混合精度训练

from trae.amp import autocast, GradScaler

scaler = GradScaler()

# 训练模型

def train_model(model, train_loader, criterion, optimizer, epochs=10):

model.train()

for epoch in range(epochs):

for batch_idx, (data, target) in enumerate(train_loader):

data, target = data.to(device), target.to(device)

optimizer.zero_grad()

with autocast():

output = model(data)

loss = criterion(output, target)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

train_model(model, train_loader, criterion, optimizer)2. 使用分布式训练

- 多 GPU 训练:使用多个 GPU 分布式训练,加速模型训练。

python

# 使用多 GPU 分布式训练

import trae.distributed as dist

def train_model(model, train_loader, criterion, optimizer, epochs=10):

model.train()

for epoch in range(epochs):

for batch_idx, (data, target) in enumerate(train_loader):

data, target = data.to(device), target.to(device)

optimizer.zero_grad()

with autocast():

output = model(data)

loss = criterion(output, target)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

if batch_idx % 100 == 0:

print(f"Epoch {epoch+1}, Batch {batch_idx+1}, Loss: {loss.item():.4f}")

# 初始化分布式环境

dist.init_process_group(backend='nccl', init_method='env://')

device = t.device('cuda', dist.get_rank())

# 定义模型

model = OptimizedCNN().to(device)

model = t.nn.parallel.DistributedDataParallel(model, device_ids=[device])

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

train_model(model, train_loader, criterion, optimizer)(六)Mermaid总结

V. 性能对比

为了验证优化策略的有效性,我们将在相同条件下对比优化前后的模型性能。我们将从以下几个方面进行对比:

- 训练时间:对比优化前后模型的训练时间。

- 推理时间:对比优化前后模型的推理时间。

- 显存占用:对比优化前后模型的显存占用。

(一)训练时间对比

我们将在相同的硬件环境下,分别训练优化前后的模型,并记录训练时间。

python

import time

# 训练原始模型

start_time = time.time()

train_model(model, train_loader, criterion, optimizer)

original_train_time = time.time() - start_time

# 训练优化后的模型

start_time = time.time()

train_model(optimized_model, train_loader, criterion, optimizer)

optimized_train_time = time.time() - start_time

print(f"原始模型训练时间:{original_train_time:.2f}秒")

print(f"优化后模型训练时间:{optimized_train_time:.2f}秒")(二)推理时间对比

我们将在相同的硬件环境下,分别对优化前后的模型进行推理,并记录推理时间。

python

# 推理原始模型

start_time = time.time()

with t.no_grad():

for data, target in test_loader:

model(data)

original_inference_time = time.time() - start_time

# 推理优化后的模型

start_time = time.time()

with t.no_grad():

for data, target in test_loader:

optimized_model(data)

optimized_inference_time = time.time() - start_time

print(f"原始模型推理时间:{original_inference_time:.2f}秒")

print(f"优化后模型推理时间:{optimized_inference_time:.2f}秒")(三)显存占用对比

我们将在相同的硬件环境下,分别记录优化前后的模型显存占用。

python

import torch.cuda as cuda

# 记录原始模型显存占用

model.cuda()

original_memory = cuda.memory_allocated()

# 记录优化后模型显存占用

optimized_model.cuda()

optimized_memory = cuda.memory_allocated()

print(f"原始模型显存占用:{original_memory / (1024 * 1024):.2f} MB")

print(f"优化后模型显存占用:{optimized_memory / (1024 * 1024):.2f} MB")