引言

当在企业应用中的关系型数据库的数据量从百万级攀升至千万甚至亿级时,要如何对这些海量数据进行高效、精准且功能丰富的查询?

传统的数据库查询方式比如通过 LIKE '%keyword%' 实现的模糊匹配,数据量激增后性能会急剧下降,甚至导致数据库服务宕机。其根本原因在于关系型数据库的索引(如 B-Tree)主要是为精确匹配和范围查询设计的,而非为非结构化的文本内容检索优化。这会导致几个核心问题:

- 性能瓶颈:全表扫描或索引失效,查询耗时随数据量线性增长。

- 功能局限:无法实现分词、同义词、相关性排序、高亮显示等现代搜索应用的基本功能。

- 业务影响:缓慢的查询严重影响用户体验,制约了业务功能的创新与发展。

为了解决这个问题,第一个想到的方案是引入专业的全文搜索引擎,将关系型数据库中的数据同步至搜索引擎中,由后者专门负责处理复杂的文本检索需求。这种"数据库 + 搜索引擎"的异构架构,能够充分发挥两者各自的优势,实现高性能、功能丰富的查询体验。

根据我个人的调研,本文将围绕这一核心思想展开探索。将从:

- 核心原理:说明倒排索引、分词、相关性评分等全文检索背后的关键技术。

- 对比主流平台:对 Elasticsearch、OpenSearch、Solr 和 Meilisearch 进行技术选型与横向对比。

- 数据同步:重点研究讨论 Logstash JDBC 方案,同时分析其他多种数据同步方案的利弊。

- 构建完整架构:展示最终的系统架构图,并讨论部署和运维中的关键考量。

因当前处于技术选型阶段,文中内容都处于研究阶段,在具体实践中不保证完全生效,具体实施还需之后进一步深入实践。本人也是搜索引擎初学者,会继续研究相关内容。

2. 技术背景 - 全文检索的核心概念

在深入探讨具体的搜索引擎技术之前,有必要先理解支撑所有现代搜索引擎高效运作的几个核心概念。

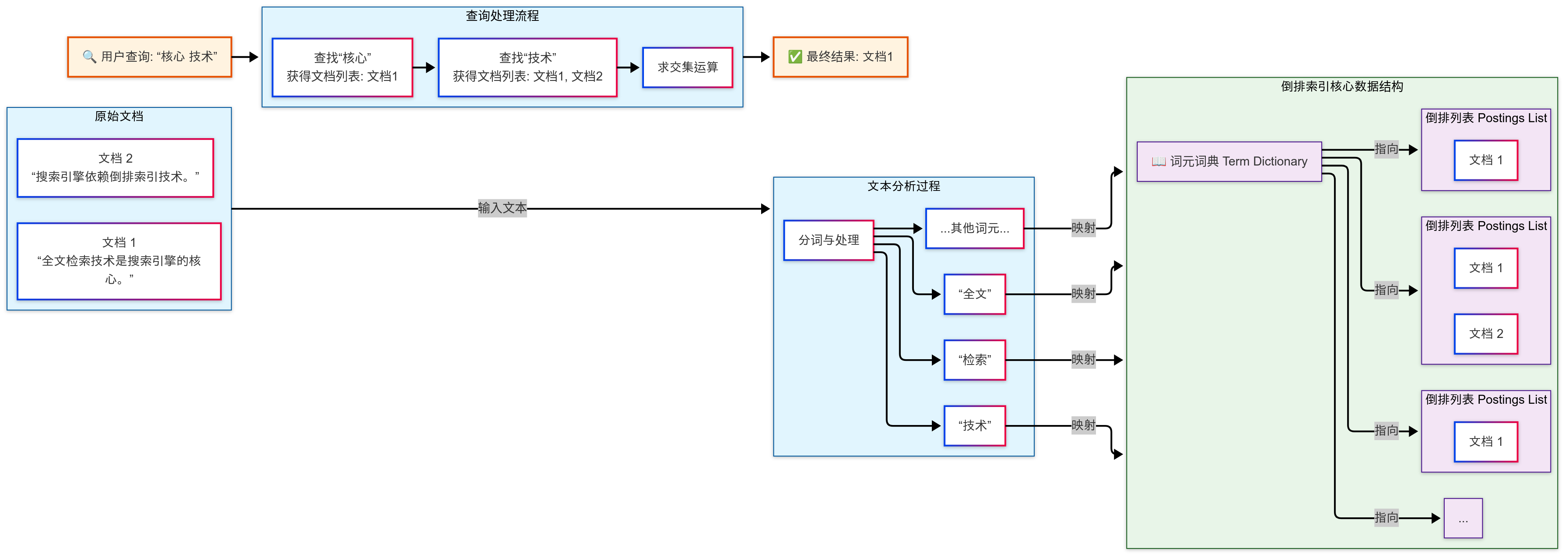

2.1. 核心数据结构:倒排索引 (Inverted Index)

关系型数据库为了加速查询,通常会为特定列创建比如 B-Tree 索引,这是一种"正向索引",即从"文档 ID"映射到"文档内容"。而全文搜索引擎的核心数据结构恰恰相反,采用的是倒排索引(Inverted Index)。

倒排索引的核心思想是建立从"词元(Term)"到"包含该词元的文档列表"的映射。一个典型的倒排索引包含两个主要部分:

- 词元词典 (Term Dictionary):包含了文档中出现过的所有不重复的词元。为了快速查找,这个词典通常会使用 B-Tree 或哈希表等高效的数据结构进行存储。

- 倒排列表 (Postings List):对于词元词典中的每一个词元,都有一个与之关联的列表,该列表记录了所有包含这个词元的文档 ID。此外,为了进行相关性计算,这个列表通常还会存储词元在每个文档中出现的频率、位置等信息。

下面是倒排索引工作原理的示意图:

根据以上图表举个例子

假设我们有以下两个中文文档:

- 文档 1: "全文检索技术是搜索引擎的核心。"

- 文档 2: "搜索引擎依赖倒排索引技术。"

经过中文分词和处理后,生成的简化的倒排索引可能如下:

| 词元 (Term) | 倒排列表 (Postings List) |

|---|---|

| "全文" | [文档 1] |

| "检索" | [文档 1] |

| "技术" | [文档 1, 文档 2] |

| "是" | [文档 1] |

| "搜索" | [文档 1, 文档 2] |

| "引擎" | [文档 1, 文档 2] |

| "核心" | [文档 1] |

| "依赖" | [文档 2] |

| "倒排" | [文档 2] |

| "索引" | [文档 2] |

当用户搜索 "核心 技术" 时,搜索引擎会:

- 查找 "核心" 的倒排列表:

[文档 1] - 查找 "技术" 的倒排列表:

[文档 1, 文档 2] - 对两个列表进行交集运算,得到结果:

[文档 1]

通过这种方式,搜索引擎避免了对所有文档进行全量扫描,而是直接定位到包含查询词的文档,从而实现了毫秒级的查询响应。

2.2. 文本处理核心:分词与分析 (Tokenization and Analysis)

原始的文本数据是无法直接用于构建倒排索引的,必须经过一个称为分析(Analysis) 的过程。分析过程将一段文本转换成一系列可供索引的标准化词元(Tokens) 。这个过程通常由一个**分析器(Analyzer)**完成,而分析器又由以下三个组件按顺序构成:

- 字符过滤器 (Character Filters):在文本被分词之前对其进行预处理。例如,去除 HTML 标签,或者将特定字符进行替换。

- 分词器 (Tokenizer) :将连续的文本流切分成独立的词元。例如,一个标准的分词器会根据空格和标点符号将 "powerful search engine" 切分为

powerful,search,engine。对于中文等语言,则需要更复杂的、基于词典或机器学习模型的分词器(如 IK Analyzer, Jieba)。 - 词元过滤器 (Token Filters) :对分词器输出的词元进行进一步的加工和标准化。常见的操作包括:

- 转为小写 (Lowercase):将所有词元统一转为小写,使得搜索不区分大小写。

- 去除停用词 (Stop Words Removal):移除如 "a", "is", "the" 等常见但对搜索意义不大的词语。

- 词干提取 (Stemming):将单词还原为其基本形式(词干)。例如,'''searches''', '''searching''', '''searched''' 都会被还原为 '''search'''。

- 同义词处理 (Synonym Expansion):将一个词元扩展为其同义词,以扩大搜索范围。例如,搜索"笔记本"时,也能匹配到包含"手提电脑"的文档。

通过精心的分词与分析策略,搜索引擎能够极大地提升搜索的准确性(Precision)和召回率(Recall)。

2.3. 结果排序的艺术:相关性评分 (Relevance Scoring)

全文检索的另一个核心优势在于它能够根据查询的相关性对结果进行排序,而不仅仅是返回匹配的文档。这种排序能力是通过相关性评分算法实现的。

早期的搜索引擎广泛使用 TF-IDF (Term Frequency-Inverse Document Frequency) 模型。其核心思想是:

- 词频 (TF):一个词元在单个文档中出现的频率越高,该文档与该词元的相关性就越强。

- 逆文档频率 (IDF):一个词元在整个文档集合中出现的频率越低(即越罕见),它对区分文档的重要性就越大,权重也应该越高。

现代搜索引擎,如 Elasticsearch 和 Solr,默认使用一种更先进的模型,称为 BM25 (Best Match 25)。BM25 是 TF-IDF 的一种改进,它解决了 TF-IDF 中词频对评分影响无限增长的问题(即一个词出现 100 次不应该比出现 50 次重要两倍),并引入了对文档长度的考量,使得评分更加合理。

这些复杂的评分模型使得搜索引擎能够返回最符合用户查询意图的结果,这是 SQL LIKE 查询完全无法企及的。

3. 搜索引擎对比分析

简单的聊了一下搜索引擎原理之后,看看当前市场上常用的搜索引擎。有多种成熟的搜索引擎可供选择,选择以下四种进行性对比:Elasticsearch 、OpenSearch 、Apache Solr 和 Meilisearch。它们各自在不同的场景下具有独特的优势和劣势。

3.1. 方案概述

- Elasticsearch: 当今最流行和功能最丰富的搜索引擎之一,基于 Apache Lucene 构建。它以其强大的分布式特性、易于使用的 RESTful API 和庞大的生态系统(特别是 ELK Stack:Elasticsearch, Logstash, Kibana,现还包括 Beats)而闻名,广泛应用于日志处理、应用程序性能监控(APM)、安全分析(SIEM)和复杂的全文检索场景。

- OpenSearch : 由亚马逊云科技(AWS)牵头,从 Elasticsearch 7.10.2 版本分叉出来的开源项目。OpenSearch 旨在提供一个完全开放、由社区驱动、且遵循宽松的 Apache 2.0 许可的替代方案。其核心目标是保持与上游分叉版本的高度 API 兼容性,确保用户能够无缝迁移,并在此基础上独立发展其特性和生态系统。

- Apache Solr: 同样基于 Apache Lucene,是 Elasticsearch 出现之前最主流的开源搜索引擎。它是一个非常成熟、稳定且功能强大的平台,在企业级搜索领域拥有深厚的积累,适合需要高度定制化和复杂查询的传统企业搜索应用,如电子商务、内容管理系统(CMS)和大规模数据目录。

- Meilisearch : 一个相对较新的轻量级、开源搜索引擎,使用 Rust 语言编写,主打开发者体验 、易用性 和极致的即时搜索性能 。它被设计为"开箱即用",无需复杂的配置或运维,提供了极快的查询速度(通常 < 50ms)和对开发者极其友好的体验。专注于为终端用户提供搜索界面的应用程序提供极简的安装和集成体验,尤其适合中小型网站、移动应用、电子商务店铺和需要快速原型设计的场景。

3.2. 方案对比

| Elasticsearch | OpenSearch | Apache Solr | Meilisearch | |

|---|---|---|---|---|

| 核心架构 | 分布式,面向文档 | 分布式,面向文档 | 分布式,面向文档/集合 | 单体式 |

| 核心优势 | 强大的生态系统 (ELK),丰富的功能,大规模数据处理能力 | 真正的 Apache 2.0 许可,完全开源,社区驱动,与 AWS 生态深度集成 | 成熟稳定,高度可配置和可扩展,强大的文本分析功能 | 极致的性能和易用性,开箱即用的相关性与拼写纠错 |

| 易用性 | 相对容易上手,Kibana 提供了强大的 UI | 与 Elasticsearch 类似,OpenSearch Dashboards 功能对等 Kibana | 学习曲线较陡峭,配置相对复杂,管理界面功能较弱 | 极其简单,API 设计友好,几分钟内即可搭建并运行 |

| 性能 | 非常高,尤其擅长聚合和分析查询 | 与同版本的 Elasticsearch 性能相当 | 非常高,在某些特定场景下(如静态数据)可能优于 ES | 极高,专为"按键式"即时搜索优化,亚秒级响应 |

| 可扩展性 | 极佳,专为水平扩展设计,可轻松扩展至数百个节点 | 与 Elasticsearch 相同,具备优秀的水平扩展能力 | 极佳,通过 SolrCloud 模式支持大规模集群部署 | 有限,当前版本主要为单机部署,扩展性是其短板 |

| 生态与工具 | 极其丰富,拥有 Logstash, Beats, Kibana 等完整工具链 | 正在快速发展,兼容大部分 Elasticsearch 工具,拥有自己的生态项目 | 丰富,拥有众多第三方集成,但不如 ELK Stack 整合度高 | 正在增长,提供了多种语言的 SDK,但整体生态较小 |

| 社区与支持 | 庞大且活跃的社区,Elastic 公司提供商业支持 | 快速增长的社区,由 AWS 和多个合作伙伴支持 | 非常成熟的社区,由 Apache 软件基金会支持 | 活跃且友好的社区,Meilisearch 公司提供商业支持 |

| 许可协议 | SSPL + Elastic License (双重许可),对云服务商不友好 | Apache License 2.0 (ALv2),完全开源 | Apache License 2.0 (ALv2),完全开源 | MIT License,非常宽松的开源许可 |

| 理想用例 | 日志分析、企业级搜索、业务智能 (BI)、安全分析等复杂场景 | 需要完全开源的 Elasticsearch 替代方案,尤其是在 AWS 上部署 | 传统的企业搜索、文档检索、需要深度定制化的搜索应用 | 前端应用搜索框、移动应用、需要极低延迟和良好用户体验的场景 |

3.3. 选型决策

结合"海量关系型数据"和"企业级应用"场景,最终选择使用 Elasticsearch。决策点如下:

-

十分完备的生态系统集成 :解决方案需要一个强大的数据同步工具。Logstash 作为 ELK Stack 的核心组件,与 Elasticsearch 的集成是无缝且经过最广泛验证的。使用 Logstash JDBC 插件可以极大地简化从关系型数据库抽取数据的过程,其丰富的过滤器插件也为数据清洗和转换提供了便利。这种"全家桶"式的集成优势是其他方案难以比拟的。

-

成熟的大规模部署能力:Elasticsearch 从设计之初就是为了处理 PB 级数据和大规模集群而生。其自动分片、副本和故障转移机制非常成熟,能够保证系统在高并发、大数据量下的高可用性和水平扩展能力,这对于需要处理千万甚至亿级数据的企业级应用至关重要。

-

丰富的功能集与灵活性 :除了核心的全文检索,Elasticsearch 还提供了强大的**聚合(Aggregations)**功能,可以轻松实现复杂的数据分析和 BI 报表,这为未来的业务扩展提供了可能。其灵活的 DSL (Domain-Specific Language) 查询语言也使得实现各种复杂的业务查询逻辑成为可能。

-

广泛的社区和商业支持:庞大的用户基础意味着遇到问题时,可以轻松地在社区论坛、博客找到解决方案。同时,Elastic 公司提供的商业支持也为企业在关键时刻提供了保障。

关于其他方案的考量:

- OpenSearch 是一个非常有力的竞争者,特别是对于希望避免 Elastic 许可风险或在 AWS 上深度使用的用户。在技术功能上,它与 Elasticsearch 非常接近。但在当前时间点,Elasticsearch 的生态成熟度和社区知识沉淀仍然略胜一筹。如果许可问题是首要考虑因素,OpenSearch 是最佳替代方案。我个人认为使用 OpenSearch 是很不错的替代方案,毕竟是完全开源的平台,在业务场景不复杂、用不到完整 ES 功能的情况下,OpenSearch 不失为一种很好的替代。当然当下场景下,就选择以 ES 为核心的场景进行研究与搭建。

- Apache Solr 同样强大,但在易用性、API 设计和生态工具的整合度上,相比 Elasticsearch 稍显逊色。对于一个新项目而言,选择 Elasticsearch 通常能获得更快的开发效率和更现代的运维体验。且 Apache Solr 似乎在学习曲线上也更加陡峭,增添了很多学习成本,在从零开始搭建且考虑项目的时间成本,Apache Solr 选择还是靠后。

- Meilisearch 性能惊艳,但其设计哲学和功能集更偏向于"小而美"的搜索体验,而非处理复杂分析和海量数据聚合的企业级平台。其当前的单体架构和有限的扩展性使其不适合大规模场景。

从功能、生态、扩展性和成熟度这几个方面来考虑,需要在这几个指标质检之间取得最佳平衡,选择 Elasticsearch 作为构建这套端到端全文检索架构的基石。

4. 数据同步:构建实时、可靠的数据管道

选择了 Elasticsearch 作为搜索引擎平台后,面临下一个核心挑战:如何将关系型数据库中的数据高效、可靠且低延迟地同步到 Elasticsearch 中。

数据同步是整个解决方案的生命线,其设计的优劣直接决定了最终用户搜索到的信息的时效性和准确性。一个优秀的数据同步方案须满足以下几个关键要求:

- 可靠性:保证数据不重、不漏,即使在源数据库或目标引擎发生故障时也能恢复。

- 时效性:从数据在源数据库中创建或更新,到它可以在 Elasticsearch 中被检索到,这个延迟应该尽可能短。

- 性能:同步过程不能对源数据库造成过大的压力,影响线上业务的正常运行。

- 可维护性:配置、监控和故障排查应该相对简单直观。

本章首先详细介绍基于 Logstash JDBC 插件的同步机制,然后会继续将其与 Flink CDC、Beats/Fluentd 以及自定义 ETL 等其他主流方案进行深入对比。

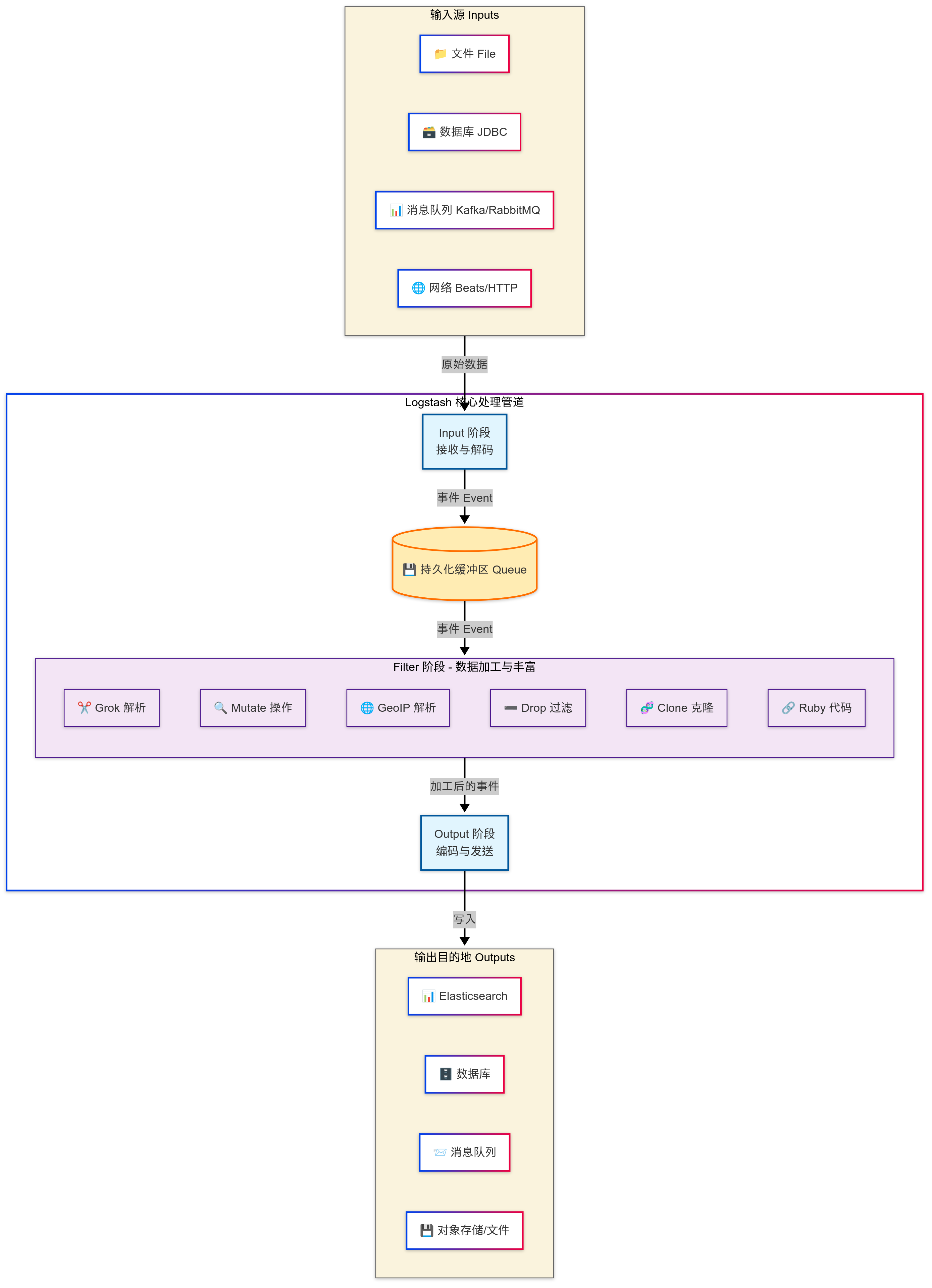

4.1. 核心方案:使用 Logstash 和 JDBC 插件

Logstash 是 ELK 技术栈中负责数据处理和传输的强大引擎。它通过插件化的架构,可以从各种数据源(Inputs)读取数据,经过一系列的转换和处理(Filters),最终发送到各种目标(Outputs)。对于从关系型数据库同步数据的场景,Logstash JDBC 输入插件 (logstash-input-jdbc) 是最常用和成熟的官方解决方案。

核心思路是:Logstash 定期轮询(Poll)源数据库的表,拉取(Pull)发生变化的数据,然后将其推送到 Elasticsearch。

4.1.1. 全量同步 (Full Synchronization)

在系统首次上线或进行数据迁移时,需要将数据库中的存量数据一次性全部导入到 Elasticsearch。这通过一个简单的 Logstash 管道配置即可实现。

工作原理:配置 Logstash 执行一个 SQL 查询,该查询会选取表中的所有记录。Logstash 会将查询结果分批次地从数据库中拉取出来,转换为 JSON 文档,然后批量写入到 Elasticsearch 中。

关键配置示例 (full-sync.conf):

ruby

input {

jdbc {

# JDBC 连接信息

jdbc_driver_library => "/path/to/mysql-connector-java.jar"

jdbc_driver_class => "com.mysql.cj.jdbc.Driver"

jdbc_connection_string => "jdbc:mysql://db.example.com:3306/my_database"

jdbc_user => "logstash_user"

jdbc_password => "password"

# 执行全量查询的 SQL 语句

statement => "SELECT id, title, content, author, created_at, updated_at FROM articles"

# 分页设置,防止一次性加载过多数据到内存

jdbc_paging_enabled => true

jdbc_page_size => 100000

# 设置一个计划,让任务只执行一次

schedule => "* * * * *"

}

}

filter {

# 可选的数据转换,例如重命名字段、转换数据类型等

mutate {

rename => { "id" => "[@metadata][document_id]" }

}

}

output {

elasticsearch {

hosts => ["http://es.example.com:9200"]

index => "articles"

document_id => "%{[@metadata][document_id]}"

}

}执行与控制 :这个任务通常是一次性的。我们可以通过设置 schedule => "* * * * *" 让它在启动后立刻执行,并在完成后手动停止 Logstash 进程。为了避免对生产数据库造成冲击,全量同步通常选择在业务低峰期进行。

4.1.2. 增量同步 (Incremental Synchronization)

全量同步完成后,需要一个持续运行的任务来捕捉数据库中后续发生的新增和修改,并将其同步到 Elasticsearch。这同样可以通过 Logstash JDBC 插件实现,但需要依赖数据库表中的一个时间戳 或自增 ID作为更新标记。

工作原理 :增量同步依赖于一个不断更新的"检查点"。Logstash 会记录下上次同步到的位置(例如,最大的 updated_at 时间戳或最大的 id)。在下一次轮询时,SQL 查询会使用这个检查点作为 WHERE 条件,只拉取比该检查点更新的记录。

关键配置示例 (incremental-sync.conf):

ruby

input {

jdbc {

# ... (JDBC 连接信息与全量同步相同)

# 增量查询的 SQL 语句

# :sql_last_value 是 Logstash 内置的参数,用于存储上次的跟踪值

statement => "SELECT id, title, content, author, created_at, updated_at FROM articles WHERE updated_at > :sql_last_value ORDER BY updated_at ASC"

# 开启跟踪,并指定用于跟踪的列

use_sql_last_value => true

tracking_column => "updated_at"

tracking_column_type => "timestamp"

# 将上次跟踪的值存储在文件中,以便 Logstash 重启后能继续

last_run_metadata_path => "/path/to/logstash_jdbc_last_run"

# 设置轮询计划,例如每分钟执行一次

schedule => "* * * * *"

}

}

filter {

# ... (与全量同步类似的转换)

}

output {

elasticsearch {

# ... (与全量同步相同的输出配置)

action => "index" # "index" 操作会覆盖已存在的同 ID 文档,实现更新

}

}处理数据删除 :

Logstash JDBC 插件本身无法直接感知数据库中的 DELETE 操作。处理删除通常有以下几种策略:

- 逻辑删除 :在数据库表中不进行物理删除,而是增加一个

is_deleted标志位。增量同步任务会同步这个状态到 Elasticsearch,应用程序在查询时需要过滤掉is_deleted: true的文档。 - 定期全量比对:定期(如每天凌晨)运行一个脚本,比对数据库和 Elasticsearch 中的文档 ID,找出并删除在 ES 中存在但在数据库中不存在的文档。但这种方式有延迟且开销较大。

- 删除日志表 :在数据库中创建一个

deletions表,当应用程序执行删除操作时,除了删除主表记录,还在该表中插入被删除记录的 ID。然后创建一个单独的 Logstash 管道来同步这个删除日志。

在大多数场景下,逻辑删除是侵入性最小且最容易实现的方案。

4.2. 其他备选数据同步方案对比

虽然 Logstash JDBC 是一个可靠且易于上手的方案,但在某些特定场景下,其他工具可能提供更高的性能或更低的数据延迟。对几个主流的备选方案进行对比。

| 方案 | 类型 | 工作模式 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|---|

| Logstash JDBC | ETL 工具 | 拉取 (Pull) | 生态成熟、配置简单、功能灵活,与 ES 无缝集成,支持复杂数据转换。 | 准实时 ,延迟取决于轮询频率;对源数据库有轮询压力;无法直接处理 DELETE。 |

对实时性要求不高(秒级到分钟级延迟可接受),希望快速实现、简化运维的通用场景。 |

| Kettle (PDI) | ETL 工具 | 拉取 (Pull) | 功能极其强大且专业 ,提供可视化界面(Spoon),对复杂 SQL 和 ETL 流程支持最好;具有完善的作业调度、日志、错误处理和性能监控;社区版免费。 | 资源消耗较大;通常以批量 (Batch) 处理为主,实时性较差;部署和配置相对复杂。 | 传统数据仓库构建、海量历史数据迁移、需要复杂多步骤数据清洗和业务逻辑转换 的批处理场景。 |

| Flink CDC | 流处理引擎 | 推送 (Push) | 实时性极高(毫秒级) ,基于 Binlog/WAL,对源库性能影响小,能捕获 DELETE,提供端到端的数据一致性保证。 |

架构复杂,需要额外部署和维护 Flink 集群,开发和配置门槛较高。 | 对数据时效性有严苛要求的金融、电商、监控等场景,需要进行复杂流式计算。 |

| Beats / Fluentd | 数据采集器 | 推送 (Push) | 轻量级,资源占用少。Beats 与 ELK 生态集成紧密。Fluentd 插件生态丰富。 | 主要设计用于日志文件 、指标等非结构化数据采集,不直接支持 JDBC。需要与其他组件(如 Kafka)配合才能用于数据库同步。 | 主要用于采集应用日志、系统日志、Metrics 等,不适合作为数据库同步的主力方案。 |

| 自定义 ETL | 自研脚本/应用 | 拉取或推送 | 灵活性最高,可完全根据业务逻辑定制,能实现最复杂的转换和集成逻辑。 | 开发和维护成本极高,需要自行处理可靠性、并发、错误恢复等所有问题,容易产生技术债务。 | 有非常特殊的业务需求,且现有工具无法满足,同时拥有强大的研发团队。 |

4.3. 数据同步决策分析:为什么使用 Logstash JDBC?

Logstash JDBC 方案在功能、成本和复杂度之间取得了一个比较好的平衡,适合在当前场景下作为数据同步的工具。

-

满足核心需求:对于我们这种面向 ToG 业务场景的应用需求,秒级甚至是分钟的的同步延迟已经可以满足业务需求。Logstash 的轮询机制虽然不是严格意义上的实时,但足以保证用户在创建或修改数据后的短时间内就能搜索到结果。

-

运维成本低:作为 ELK 的一部分,Logstash 的部署和运维与 Elasticsearch 一脉相承,相比引入一个全新的、重量级的 Flink 集群,使用 Logstash 可以显著降低整个系统的架构复杂度和维护成本。

-

灵活性与扩展性 :Logstash 强大的 Filter 插件(如

grok,mutate,json,ruby)使得在数据进入 Elasticsearch 之前进行清洗、充实和转换变得非常容易,这对于保持索引数据的高质量至关重要。

但其实这种选择不是一成不变的,架构应该具备演进的能力。可以从 Logstash JDBC 开始,快速搭建起整个系统。如果未来业务发展对数据同步的实时性提出了更高的要求(例如,需要毫秒级的延迟),届时再考虑升级到其他方案,比如 Flink CDC 这种更复杂的方案,当目标端(Elasticsearch)和核心业务逻辑已经稳定时,切换数据同步方案的风险和成本将是可控的。

5. 更多的实施细节与架构考量

理论方案的确立只是第一步,要能成功落地实施需要对架构中的每一个环节进行更深入细致的考量。本章将深入探讨从系统宏观架构到微观索引设计的具体实施细节,确保方案的健壮性、可扩展性和可维护性。

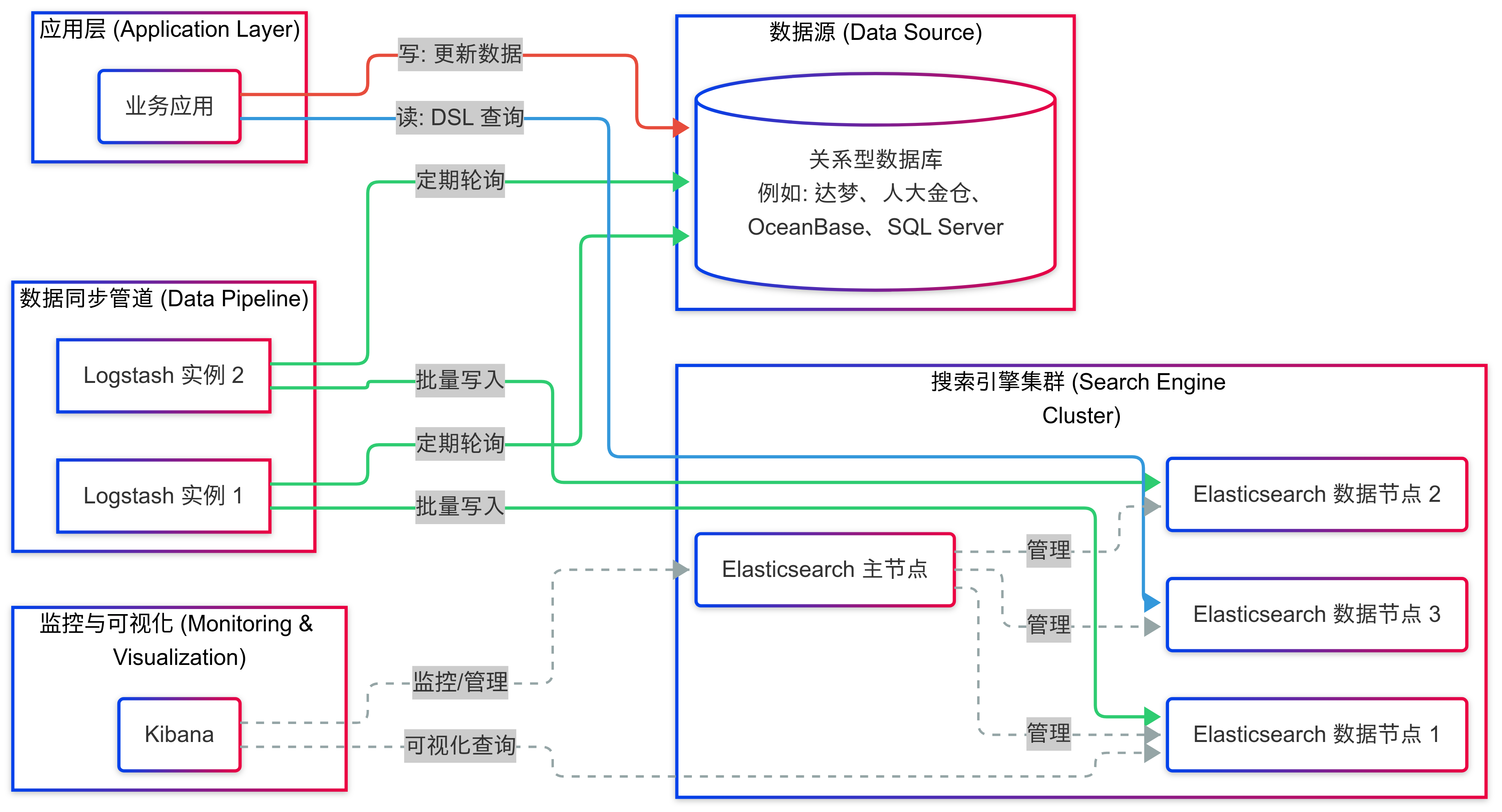

5.1. 端到端系统架构图

下图展示了整个解决方案的数据流和组件交互:

架构分析:

- 写路径:业务应用的所有写操作(增、删、改)仍然直接作用于关系型数据库,确保其作为"事实孤本 (Single Source of Truth)"的地位。

- 同步路径:Logstash 集群通过 JDBC 输入插件,以负载均衡的方式轮询数据库中的业务表。为了高可用可考虑部署多个 Logstash 实例,它们拉取增量数据、进行处理后,批量写入 Elasticsearch 集群。

- 读路径:对于全文检索类的查询需求,业务应用不再查询数据库,而是构建 Elasticsearch 的 DSL (Domain-Specific Language) 查询请求,直接发送给 Elasticsearch 集群。ES 返回查询结果后,应用进行处理和展现。

- 管理与监控:利用 Kibana 进行管理与监控,Kibana 不仅为开发和运维人员提供了强大的数据探索和可视化工具,还承担了对整个 Elasticsearch 集群的管理和监控职责。

5.2. Elasticsearch 索引设计

索引设计是 Elasticsearch 性能优化的核心。一个好的 Mapping 设计能够节省存储空间、提升索引和查询效率。

核心原则:只索引需要被搜索的字段,并为每个字段选择最恰当的数据类型。重点考虑当前跨多字段的全文搜索的场景。

示例:articles 索引的 Mapping 设计

假设有一个数据量极大的 articles 表,搜索需求是输入一个关键词,在 title(标题)、content(内容)、甚至 tags(标签)等多个字段中进行全文检索。

常规的做法是使用 multi_match 查询,同时搜索这些字段。但在数据量巨大、查询并发高的情况下,这种方式的性能可能不是最优的。

可以利用 copy_to 功能来创建一个聚合的搜索专用字段。

json

{

"settings": {

"number_of_shards": 3,

"number_of_replicas": 1,

"analysis": {

"analyzer": {

"default": {

"type": "ik_max_word"

},

"default_search": {

"type": "ik_smart"

}

}

}

},

"mappings": {

"properties": {

"id": {

"type": "keyword"

},

"title": {

"type": "text",

"analyzer": "ik_max_word",

"search_analyzer": "ik_smart",

"copy_to": "full_text_search",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"content": {

"type": "text",

"analyzer": "ik_max_word",

"search_analyzer": "ik_smart",

"copy_to": "full_text_search"

},

"author": {

"type": "keyword"

},

"tags": {

"type": "keyword",

"copy_to": "full_text_search"

},

"full_text_search": {

"type": "text",

"analyzer": "ik_max_word",

"search_analyzer": "ik_smart"

},

"created_at": {

"type": "date"

},

"updated_at": {

"type": "date"

},

"is_deleted": {

"type": "boolean"

}

}

}

}设计解读:

-

分片与副本 (

settings) :number_of_shards(主分片数) 决定了索引的最大容量和并行处理能力,一旦设定不能修改。这里设为 3,意味着数据将被水平切分到 3 个分片上。number_of_replicas(副本数) 决定了数据的冗余备份数量,可以随时修改,用于高可用和提升读性能。1 个副本意味着每个主分片都有一个备份。 -

分词器 (

analysis) :针对中文场景,配置了ik_max_word作为默认的索引分词器(最大限度地切分词语,提高召回率),ik_smart作为搜索分词器(更智能地切分,提高准确率)。 -

字段类型 (

mappings):id和author使用keyword类型,因为它们通常用于精确匹配、排序或聚合,不需要分词。title和content使用text类型,因为它们是需要进行全文检索的核心字段,会经过分词器处理。title还额外配置了一个fields.keyword多字段,允许我们同时对标题进行不分词的精确匹配。created_at和updated_at使用date类型,以便进行日期范围查询。is_deleted使用boolean类型,用于实现逻辑删除。

-

多字段全文搜索优化 (

copy_to):-

功能说明 :

copy_to是 Elasticsearch 提供的一个强大功能,它允许将一个或多个字段的值,在索引时自动复制到一个新的、统一的字段中。这个新字段会包含所有源字段的内容,并按照自己的映射规则进行索引。 -

应用场景 :在上述例子中,我们希望用户输入一个关键词就能同时搜索

title、content和tags。我们通过在title、content和tags字段中设置"copy_to": "full_text_search",将这三个字段的值全部复制到了名为full_text_search的新字段中。 -

优势:

- 简化查询 :在查询时不再需要执行

multi_match来搜索三个独立的字段,只需针对full_text_search这一个字段进行简单的match查询即可。这使得查询语句更简洁,意图更明确。 - 提升性能 :对于数据量极大的表,针对单个字段的查询通常比在多个字段上进行联合查询更快。因为 Elasticsearch 只需在一个字段的倒排索引中进行查找,减少了查询协调的开销,尤其是在计算相关性分数

_score时,针对单个字段的词频/文档频率计算会更高效。 - 灵活控制 :

full_text_search作为一个独立字段,可以拥有自己的分词器、权重等设置,而不会影响源字段。

- 简化查询 :在查询时不再需要执行

-

查询方式对比:

-

未使用

copy_to:JSONGET articles/_search { "query": { "multi_match": { "query": "Elasticsearch 性能优化", "fields": ["title", "content", "tags"] } } } -

使用

copy_to后:JSONGET articles/_search { "query": { "match": { "full_text_search": "Elasticsearch 性能优化" } } }

注意事项 :

copy_to会增加索引的存储开销,因为它实际上是存储了额外的数据。但在"以空间换时间"的性能优化策略中,对于读多写少的超大数据量场景,这种开销通常是值得的。 -

-

5.3. Logstash 部署与高可用

部署单个 Logstash 实例,系统的可能会有单点故障风险,为了确保数据管道的健壮性,可以考虑高可用部署。

-

多实例部署 :启动多个 Logstash 实例,并让它们运行相同的管道配置。由于 JDBC 输入插件会记录

sql_last_value到共享文件或数据库中,它们可以协同工作而不会重复拉取数据(需要确保last_run_metadata_path指向一个共享存储或每个实例有独立但同步的跟踪机制)。 -

持久化队列 (Persistent Queue) :默认情况下,Logstash 的事件队列是基于内存的。如果 Logstash 进程意外崩溃,内存中的数据将会丢失。为了防止数据丢失,可以启用持久化队列。它会将事件缓存在磁盘上,直到它们被成功发送到 Elasticsearch。在

logstash.yml中配置:yamlqueue.type: persisted path.queue: /path/to/logstash/queue

5.4. 应用层集成

应用层需要进行改造,以将搜索流量导向 Elasticsearch。

-

引入客户端 :在应用中添加对应语言的 Elasticsearch 官方客户端库,如

elasticsearch-java或elasticsearch-py。 -

双写/切换逻辑:在改造初期,可以采用"双写"模式,即写操作同时更新数据库和 Elasticsearch,用于验证新系统的稳定性。稳定后,切换为"只写数据库,由 Logstash 同步"的模式。

-

查询构建 :将原有的 SQL

LIKE查询改造为 Elasticsearch 的 DSL 查询。例如,一个简单的关键字查询:Python 示例 (

elasticsearch-py)pythonfrom elasticsearch import Elasticsearch es = Elasticsearch(hosts=["http://es.example.com:9200"]) def search_articles(query_string): response = es.search( index="articles", body={ "query": { "bool": { "must": [ { "multi_match": { "query": query_string, "fields": ["title", "content"] } } ], "filter": [ { "term": { "is_deleted": False } } ] } } } ) return response['hits']['hits'] -

故障降级 :在应用层面实现一个简单的降级策略。比如当检测到 Elasticsearch 集群无法连接时,可以临时切换回使用数据库的

LIKE查询(即使性能较差),以保证核心功能的可用性,同时触发告警。

6. 性能评估与监控

6.1. 关键性能指标 (KPIs)

可以关注以下几类核心指标:

- 数据同步延迟 (Data Freshness):从一条记录在数据库中被修改,到它可以在 Elasticsearch 中被搜索到的端到端时间。这是衡量系统"近实时"能力的关键。根据业务需求设定目标同步延迟时间。

- 索引吞吐率 (Indexing Throughput):Elasticsearch 每秒能够索引的文档数量(docs/sec)。这反映了数据写入的能力。目标:根据业务增量预估,通常需达到峰值增量的 2-3 倍。

- 查询延迟 (Query Latency):搜索请求的响应时间。通常关注平均值、P95(95% 的请求耗时)和 P99(99% 的请求耗时)。目标:P95 < 200ms。

- 查询吞吐量 (Query Throughput):系统每秒能够处理的查询请求数(QPS)。

6.2. 性能压测与调优

- 压测工具 :

- Elasticsearch Rally: Elastic 官方的宏观基准测试工具,用于模拟真实负载对集群进行压测。

- JMeter/Gatling: 通用的压力测试工具,可用于模拟应用层的搜索请求。

- 常见瓶颈及调优策略 :

- Logstash : 如果同步延迟过高,可能是 Logstash 处理能力不足。可以增加

pipeline.workers的数量(通常等于 CPU 核数),调整pipeline.batch.size来优化写入效率。 - Elasticsearch - 写入优化 : 调整索引的

refresh_interval(例如从默认的1s延长到30s),可以显著降低写入时的资源消耗,提升吞吐率。在全量同步期间,甚至可以暂时将其设置为-1关闭自动刷新,并在结束后手动刷新。 - Elasticsearch - 查询优化: 优化 DSL 查询,避免使用开销大的查询类型(如脚本查询、通配符查询)。确保 JVM 堆内存设置合理(通常是物理内存的一半,且不超过 30GB)。

- 硬件资源: 监控节点的 CPU、内存、磁盘 I/O。使用 SSD 是保证 Elasticsearch 高性能的基础。

- Logstash : 如果同步延迟过高,可能是 Logstash 处理能力不足。可以增加

6.3. 监控与告警

利用 ELK 技术栈自身,可以构建强大的监控系统。

- 监控方案 :使用 Metricbeat 来收集 Elasticsearch、Logstash、Kibana 以及操作系统的性能指标,将这些数据发送到专门的监控 Elasticsearch 集群中,然后通过 Kibana 创建仪表盘进行可视化。

- 关键监控项 :

- 集群健康状态 (Cluster Health) :

green,yellow,red。红色状态是最高级别的告警,意味着有主分片丢失,数据不完整。 - JVM 堆内存使用率 (JVM Heap Usage): 持续高于 85% 是一个危险信号,可能导致频繁的垃圾回收和性能下降。

- CPU 使用率 (CPU Usage): 持续高位可能意味着查询压力大或存在低效查询。

- 磁盘空间 (Disk Space): 必须监控磁盘使用率,防止因磁盘写满导致索引无法写入。

- 集群健康状态 (Cluster Health) :

- 告警集成 :利用 Elasticsearch 的 Watcher 功能(商业特性)或开源的 ElastAlert 工具,可以针对上述关键指标设置阈值,当满足告警条件时,通过邮件、Slack 或其他方式发送通知给运维团队。

7. 结论与展望

7.1. 方案总结

本文系统性、概括性的研究了一个特定场景下的全文检索方案:如何为存储在关系型数据库中的海量数据提供高性能、功能丰富的全文检索能力。以 Elasticsearch 为搜索引擎核心、以 Logstash 为数据同步管道的端到端解决方案来进行说明。

该方案的核心优势在于:

- 专业性:将检索任务从不擅长此道的数据库中剥离,交由专业的搜索引擎处理。

- 生态整合:依托于成熟的 ELK 技术栈,在数据同步、查询、监控和管理等各个环节都能无缝集成,并得到强大的功能支持。

- 可扩展性:架构基于分布式组件构建,无论是数据量增长还是查询并发量提升,都可以通过水平扩展节点来应对。

7.2. 潜在挑战

- 数据一致性:基于轮询的异步同步机制存在最终一致性的窗口期。应对策略是通过缩短轮询间隔来降低延迟,并通过完善的监控确保同步任务的健康运行。

- 运维复杂度:引入 ELK 技术栈确实增加了系统的运维复杂度。应对策略是加强自动化运维建设(如使用 Ansible/SaltStack 进行部署配置),并建立起标准化的监控和应急响应流程。

7.3. 未来展望

若要继续升级,该架构可以向以下方向发展:

- 实时同步 :若业务对数据同步的延迟有毫秒级要求时,可以考虑将数据同步策略升级,比如将数据管道从 Logstash JDBC(Pull 模式)升级为 Flink CDC + Kafka(Push 模式),但会涉及到更复杂的维护和技术与学习成本问题。需要多方面综合考虑。

- 智能化探索 :在拥有了海量高质量的索引数据后,可以利用 Elasticsearch 的机器学习功能进行异常检测、日志模式分析等 AIOps 探索。也可以集成向量搜索(Vector Search)能力,实现更智能的语义搜索或以图搜图等应用。

- 多数据中心容灾 :对于可用性要求极高的关键业务,可以部署跨数据中心的 Elasticsearch 集群,并启用跨集群复制 (Cross-Cluster Replication, CCR) 功能,实现机房级别的容灾能力。