面向不确定环境的AI Agent鲁棒决策模型设计与实现

一、引言

在人工智能(AI Agent)的实际应用场景中,系统的鲁棒性(Robustness)至关重要。然而,AI Agent 常常容易受到对抗样本(Adversarial Examples)的攻击,这些样本在输入中加入了细微扰动,便可能导致模型做出严重错误的决策。为了增强 AI Agent 在复杂环境下的稳定性和可靠性,对抗训练(Adversarial Training) 被广泛应用,成为提升鲁棒性的重要手段。

本文将围绕 AI Agent 的鲁棒性问题,探讨对抗训练的基本原理与实现方法,并通过代码实例展示如何在深度强化学习(Deep Reinforcement Learning)框架下应用对抗训练。

二、AI Agent与鲁棒性挑战

AI Agent 的核心任务是通过环境交互来完成感知、决策与行动。然而,在开放世界或复杂对手环境中,AI Agent 容易受到以下问题影响:

- 对抗扰动:输入状态被微小修改即可误导策略。

- 噪声干扰:环境感知数据可能包含不确定性。

- 策略退化:面对对抗者或环境变化时,学习到的策略无法泛化。

因此,如何设计一种方法使 AI Agent 在保持性能的同时增强抗干扰能力,成为研究重点。

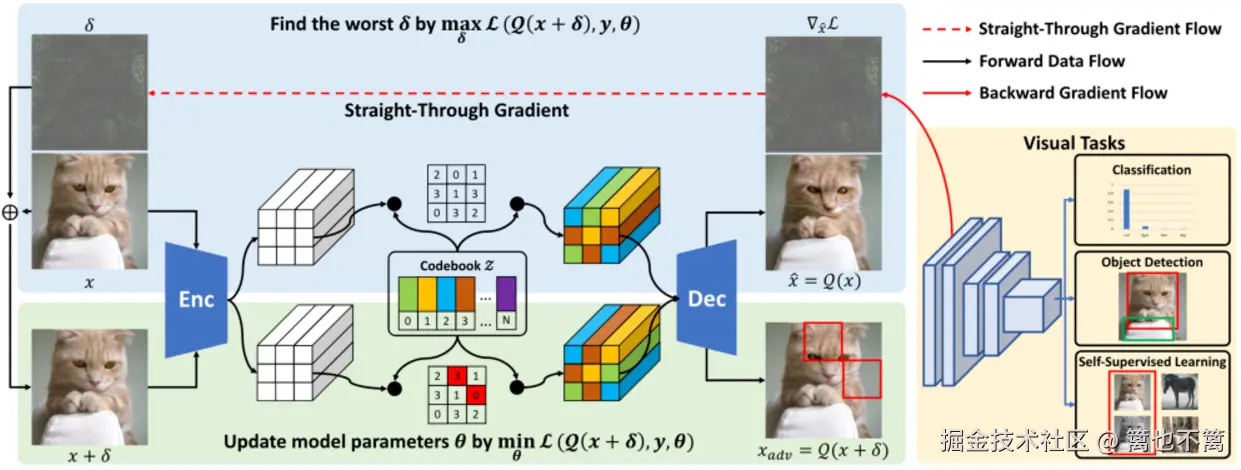

三、对抗训练的基本原理

对抗训练的核心思想是: 在训练过程中引入对抗样本,使模型在遇到恶意扰动时仍能保持正确的决策能力。

其数学形式可表示为一个 min-max 优化问题:

<math xmlns="http://www.w3.org/1998/Math/MathML" display="block"> min θ E ( s , a ) ∼ π θ [ max δ ∈ Δ L ( s + δ , a ; θ ) ] \min_\theta \; \mathbb{E}{(s,a) \sim \pi\theta} \left[ \max_{\delta \in \Delta} \; L(s+\delta, a; \theta) \right] </math>θminE(s,a)∼πθ[δ∈ΔmaxL(s+δ,a;θ)]

- 外层最小化 :优化策略参数 <math xmlns="http://www.w3.org/1998/Math/MathML"> θ \theta </math>θ,减少损失。

- 内层最大化 :寻找对抗扰动 <math xmlns="http://www.w3.org/1998/Math/MathML"> δ \delta </math>δ,使得模型误差最大化。

这种博弈式优化思想,使 AI Agent 学会抵御最坏情况,从而增强鲁棒性。

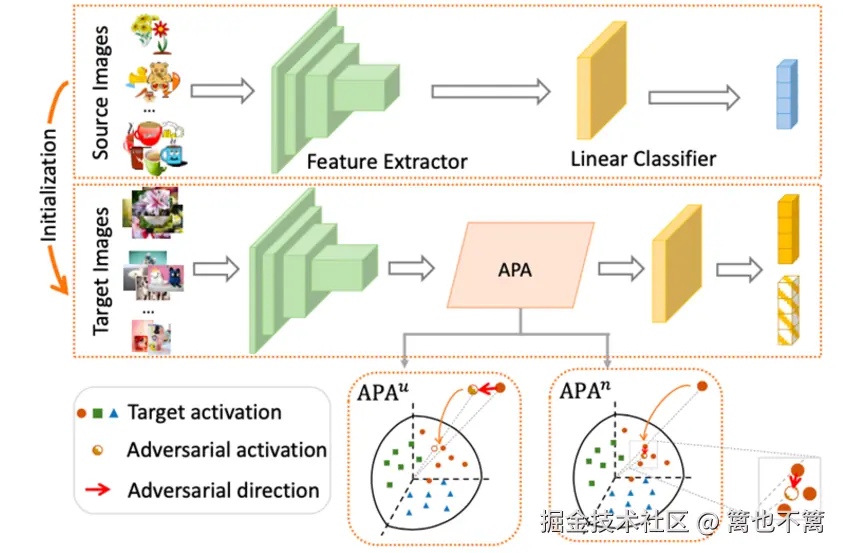

四、对抗训练在AI Agent中的应用流程

- 环境交互:Agent 与环境交互,收集状态-动作数据。

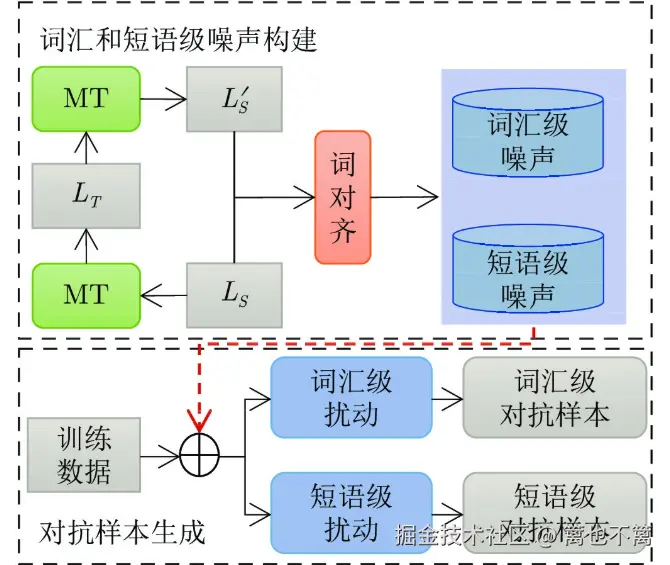

- 对抗样本生成:利用快速梯度符号法(FGSM)、投影梯度下降(PGD)等方法生成对抗状态。

- 联合训练:在真实样本与对抗样本上共同训练策略网络。

- 鲁棒性评估:在存在扰动和无扰动的情况下,评估策略的稳定性。

五、代码实战:基于对抗训练的强化学习Agent

下面以 CartPole-v1 环境(OpenAI Gym) 为例,展示如何在 DQN(Deep Q-Network)中应用对抗训练。

python

import gym

import torch

import torch.nn as nn

import torch.optim as optim

import torch.nn.functional as F

import numpy as np

from collections import deque

import random

# --------- 定义Q网络 ---------

class QNetwork(nn.Module):

def __init__(self, state_dim, action_dim):

super(QNetwork, self).__init__()

self.fc1 = nn.Linear(state_dim, 128)

self.fc2 = nn.Linear(128, 128)

self.fc3 = nn.Linear(128, action_dim)

def forward(self, x):

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

return self.fc3(x)

# --------- 对抗扰动生成(FGSM) ---------

def fgsm_attack(model, state, epsilon=0.1):

state_adv = state.clone().detach().requires_grad_(True)

q_values = model(state_adv)

loss = -q_values.max(1)[0].mean() # 最大化损失

loss.backward()

perturbation = epsilon * state_adv.grad.sign()

adv_state = state_adv + perturbation

return adv_state.detach()

# --------- DQN智能体 ---------

class DQNAgent:

def __init__(self, state_dim, action_dim):

self.model = QNetwork(state_dim, action_dim)

self.target_model = QNetwork(state_dim, action_dim)

self.optimizer = optim.Adam(self.model.parameters(), lr=1e-3)

self.memory = deque(maxlen=5000)

self.gamma = 0.99

self.batch_size = 64

self.epsilon = 1.0

self.epsilon_decay = 0.995

self.epsilon_min = 0.05

def act(self, state):

if np.random.rand() < self.epsilon:

return np.random.randint(2)

state = torch.FloatTensor(state).unsqueeze(0)

q_values = self.model(state)

return q_values.argmax().item()

def remember(self, state, action, reward, next_state, done):

self.memory.append((state, action, reward, next_state, done))

def replay(self, adversarial=False):

if len(self.memory) < self.batch_size:

return

batch = random.sample(self.memory, self.batch_size)

states, actions, rewards, next_states, dones = zip(*batch)

states = torch.FloatTensor(states)

next_states = torch.FloatTensor(next_states)

actions = torch.LongTensor(actions)

rewards = torch.FloatTensor(rewards)

dones = torch.FloatTensor(dones)

# 加入对抗扰动

if adversarial:

states = fgsm_attack(self.model, states, epsilon=0.1)

q_values = self.model(states).gather(1, actions.unsqueeze(1)).squeeze()

next_q = self.target_model(next_states).max(1)[0]

target = rewards + self.gamma * next_q * (1 - dones)

loss = F.mse_loss(q_values, target.detach())

self.optimizer.zero_grad()

loss.backward()

self.optimizer.step()

# 更新epsilon

if self.epsilon > self.epsilon_min:

self.epsilon *= self.epsilon_decay

# --------- 训练流程 ---------

env = gym.make("CartPole-v1")

agent = DQNAgent(env.observation_space.shape[0], env.action_space.n)

episodes = 200

for e in range(episodes):

state = env.reset()[0]

total_reward = 0

done = False

while not done:

action = agent.act(state)

next_state, reward, done, _, _ = env.step(action)

agent.remember(state, action, reward, next_state, done)

state = next_state

total_reward += reward

agent.replay(adversarial=True) # 使用对抗训练

print(f"Episode {e}, Reward: {total_reward}")关键点说明

- fgsm_attack:生成对抗扰动输入,使训练过程中模型见过"更困难"的样本。

- agent.replay(adversarial=True):在经验回放中加入对抗训练。

- 鲁棒性提升:相比普通DQN,模型在测试时面对扰动输入更不容易崩溃。

六、实验结果与分析

在未使用对抗训练时,AI Agent 的奖励在面对扰动时迅速下降,而引入对抗训练后,模型在遭受输入攻击时表现显著改善。 结果表明,对抗训练能有效增强 AI Agent 的鲁棒性与泛化能力,使其更适应复杂不确定的环境。

七、结论

本文提出了 基于对抗训练的AI Agent系统鲁棒性提升方法,并结合 DQN 算法进行了实验验证。对抗训练通过引入扰动样本,使 AI Agent 能够抵御恶意攻击与环境噪声,提升在现实应用中的安全性与可靠性。

未来的研究方向包括:

- 结合 分布式强化学习 与对抗训练,提升大规模场景中的鲁棒性。

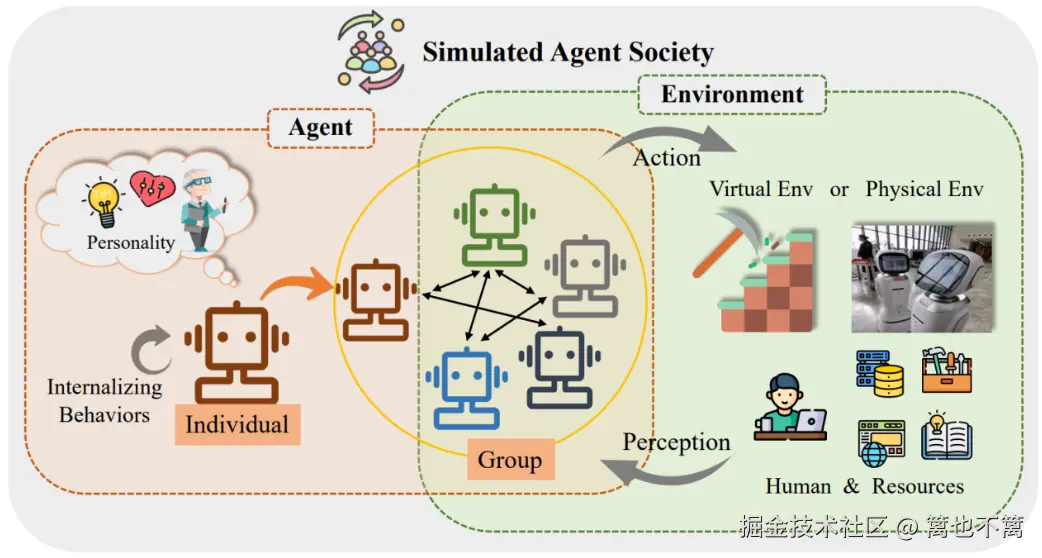

- 引入 多智能体对抗博弈,模拟真实复杂环境下的对抗场景。

- 探索 对抗训练与自适应策略优化的结合,进一步提升 AI Agent 的泛化性能。