上次用 OpenWebUI 搭了个聊天机器人。

虽然能用,但界面没法自定义。试了试 Dify,发现更灵活,果断决定把原来的知识库搬过来啦!

本文以 Dify 的流程为主,如果你用 Coze,流程大差不差,根据实际情况调整即可。

一、Dify/Coze 部署

- 找一台装了 Docker 的电脑

- 配个国内镜像源(你懂的)

- 从 GitHub 把 Dify/Coze 项目拉下来

- 一行

docker compose up,等着自动装好就行

Dify 的大模型配置

Dify 还需要进行如下配置:

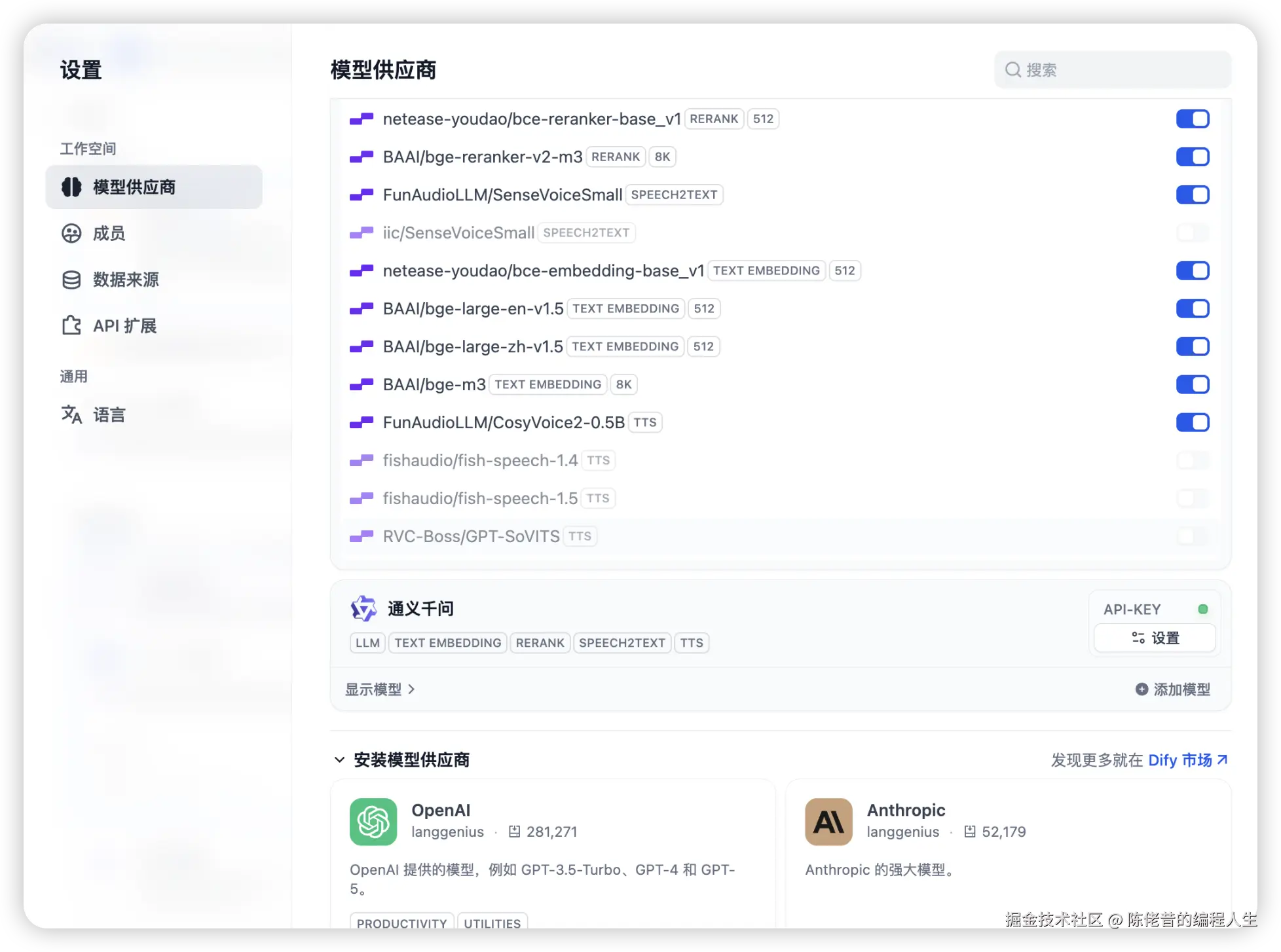

点个人头像 → 设置 → 模型提供商,这里可以加本地 Ollama/LM Studio 或者第三方平台(比如硅基流动)。

如果用本地 Ollama,除了基础大模型,还要配个嵌入模型和倒排模型。直接在 Ollama/LM Studio 里搜 "embed" 和 "rerank" 就能找到,推荐用中文模型,效果更好些~像智源的 bge、阿里的 gte 都不错。

二、创建知识库

选"知识库",导入数据。不用像 OpenWebUI 那样非得拆成问答文件,直接扔个大文件进去就行!推荐 .md 或 .txt 格式,分段更顺滑。

进设置页面,选项超多~

如果没啥特殊要求,预览分块结果看着顺眼就直接用吧。

- 分段标识符、最大长度、重叠长度可以按自己原文的格式进行调整。(Coze 选择自定义分段,可以出现此配置)

- 如果想用 Q&A 模式记得勾选,不过会多花点 token。

- 好的分块结果,相关联的内容保持在一个块内。

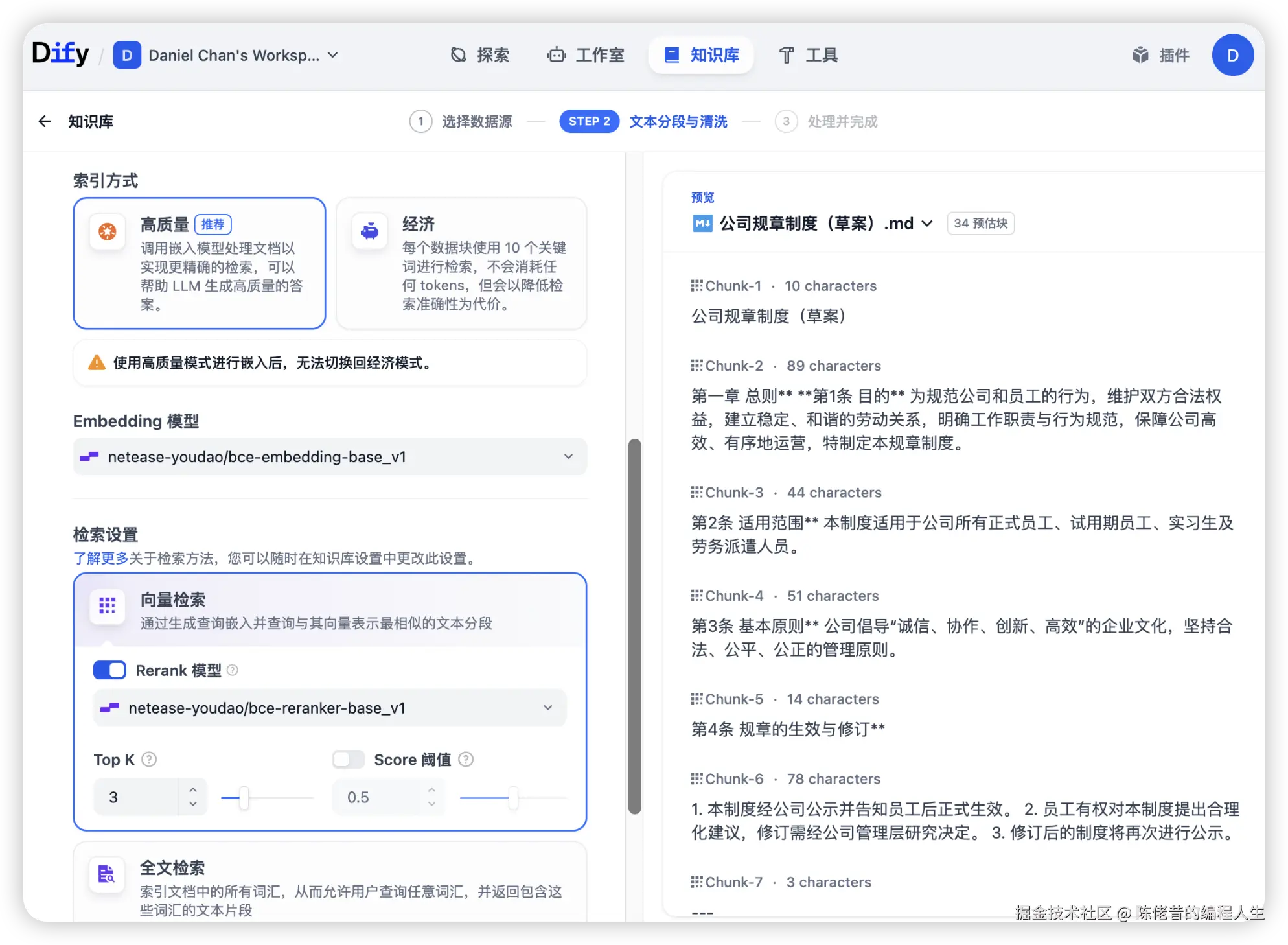

检索方式有两种:高质量及经济。

- 经济模式:本地跑,不花 token,但效果一般般

- 高质量模式:效果杠杠的,token 花得也不多,本地和线上都能用。注意选了之后就改不回"经济模式"啦。

刚开始可以两个都试试,看哪个更顺手。如果文档较小,高质量对 token 消耗也不多,即使调用线上模型也烧不了几毛钱,可以放心使用。

检索设置,有向量检索、全文检索和混合检索。

- 内容简单的话,直接选向量检索就好。要求高的话,可以选择混合检索。

- 这里的模型就要选择前面提到的倒排(rerank)模型了。

- topK,是返回检索的数量,可以按需求填写。

提交之后嵌入模型就开始对文档向量化了,小文件几秒,大文件几分钟,起身动动,喝杯咖啡就好。

虽然知识库创建完成后还能改分块,不过建议一开始就调到位,在这一步耗多点时间比后面再来修改好~

三、工作流搭建

知识库搞定,接下来搭个问答小助手!

进工作室,创建空白应用,选 Chatflow,起个好听的名字就能开始搭工作流啦。这个界面玩过流程图的小伙伴肯定秒懂~

Chatflow 一开始给了个直接问答的机器人模板。我们只要"开始"和"直接回复",其他先删掉。

这个 AI 问答助手主要用到两个节点:LLM 和知识检索。

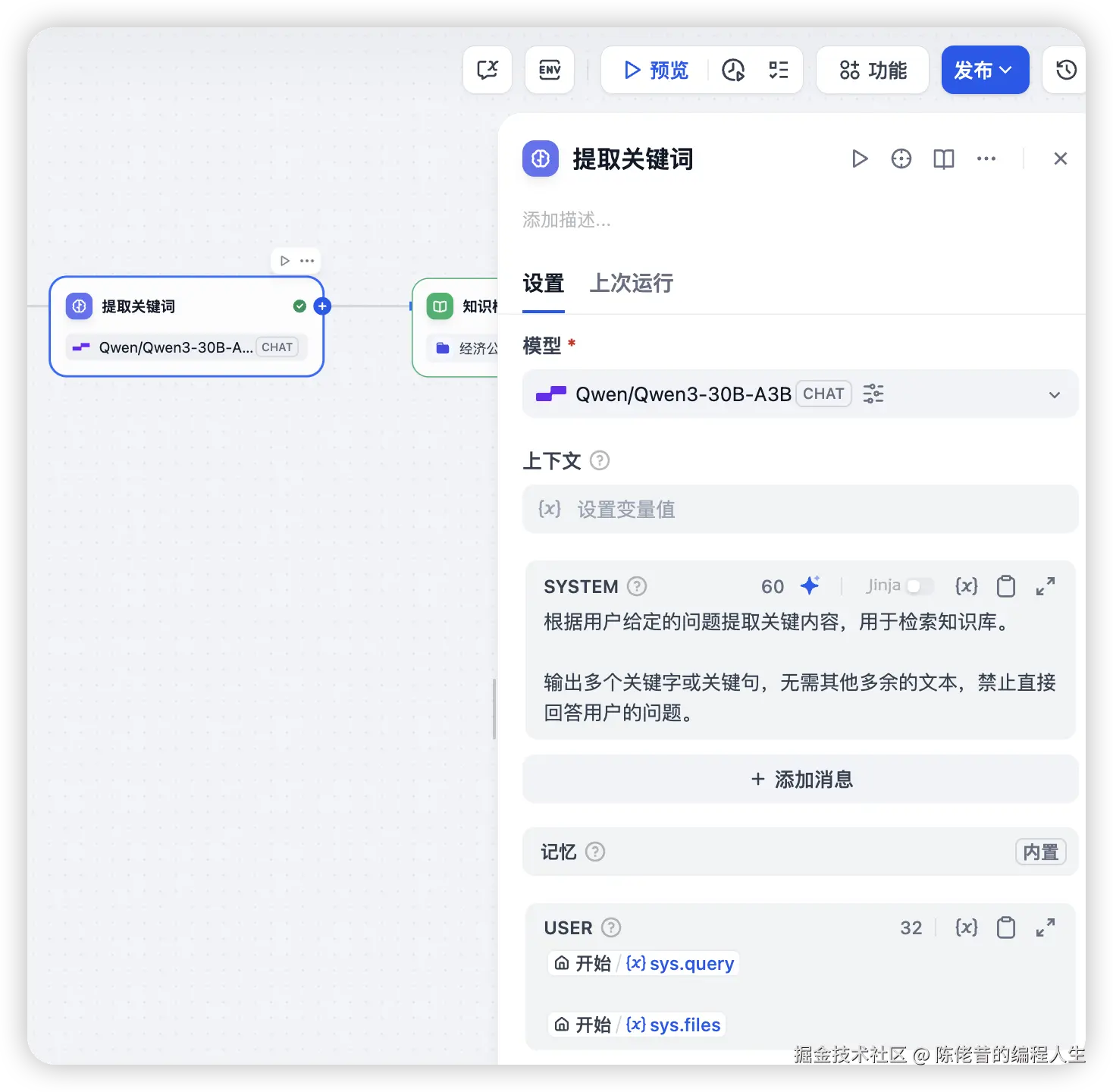

- 开始后面接个 LLM 节点(用来提取关键词),提示词可以这样写:

txt

根据用户问题提取关键内容,用来检索知识库。

输出几个关键词或关键句就行,别多写,也别直接回答问题哦~不会写提示词?点旁边的✨让 AI 帮你优化,魔法打败魔法!

- 接着接知识检索节点,查询变量选上一步输出的 text,知识库选刚建好的那个。

- 再接个 LLM 节点整理文档,输出最终回答。提示词大概如下:

txt

你是一个专业的HR,请根据知识库的内容,对用户的问题进行解答。

严格根据知识库内容回答,请勿添加格外的信息。如果知识库没有的内容,直接回答"知识库没有相关知识。"

用户的问题是:开始/(x)sys.query

知识库是:/上下文注意要把上下文和变量带上。

- 结束的"直接回复"节点里,把回复内容设成上一步输出的 text。

搞定!点预览测试一下,看它聪不聪明~

四、发布工作流

点发布,成功后下面几个按钮就能用啦:

- 运行:直接在网站里用

- 嵌入网站:用 iframe 嵌到自己网站里

- 探索:带侧边栏和导航的酷炫版本

- 访问 API:想二次开发?API 随便调!

在成品上,Dify 真的比 OpenWebUI 灵活太多,想咋玩咋玩~

总结

总的来说,Dify 让搭建知识库和聊天机器人变得超简单:部署一键搞定,知识库支持直接导入大文件,工作流拖拽就能搭,发布方式还多种多样。

不管是自己用还是集成到网站,都超级方便!

如果你也想搞个智能小助手,Dify 绝对值得一试~

类似的平台 Coze 也能用这套流程,举一反三超简单!