摘要

在云计算技术飞速演进的今天,服务器的管理与运维正经历着从传统手动操作、脚本自动化到智能化、对话式交互的深刻变革。本文将系统性地、全流程地展示如何将腾讯云 Lighthouse 轻量应用服务器与尖端的 AI 编程助手 Codebuddy CLI 进行深度集成。我们将从服务器的基础选购与配置出发,详细阐述 MCP (Model Context Protocol) 服务的激活与授权机制,并深入探讨在本地环境中配置 Codebuddy CLI 及其依赖项(如 Node.js)的全过程,包括常见环境问题的排查与解决。最终,我们将通过实际操作案例,展示如何利用自然语言指令,通过 Codebuddy CLI 调用 Lighthouse MCP 的核心功能,实现对服务器生命周期、网络安全策略以及状态监控的全面、高效、智能化管理,从而为开发者和系统管理员揭示一种全新的、以 AI 为核心的云端基础设施交互模式。

第一章:奠定基础------Lighthouse 服务器的战略性选择与配置

一切强大的上层应用都源于一个稳定而高效的基础设施平台。在这个集成方案中,我们的起点是腾讯云 Lighthouse 轻量应用服务器。它以其高性价比、易于上手的特性,成为众多开发者和中小型应用的理想选择。

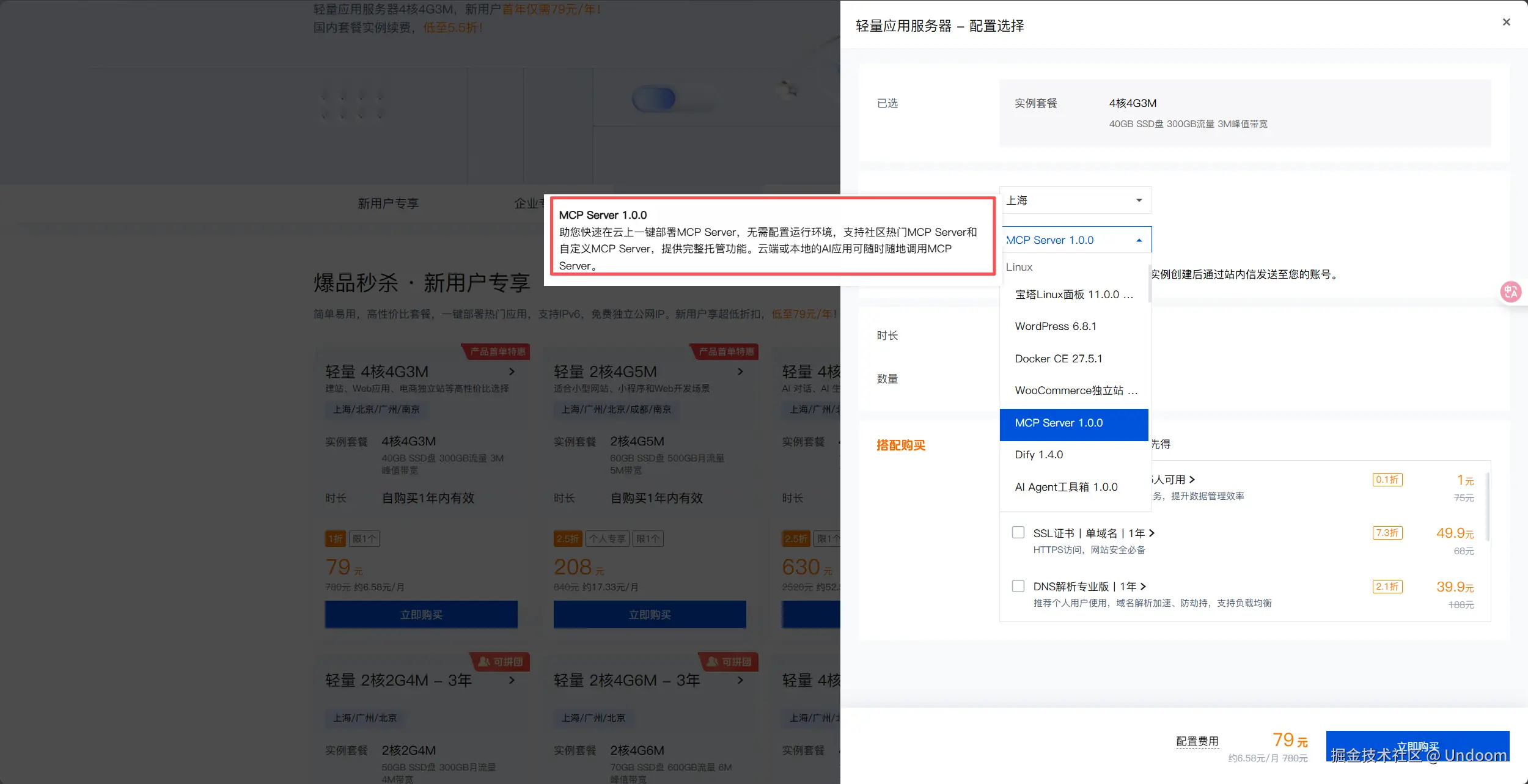

1.1 实例规格的选定

我们的实践始于一个具体的选择:一台配置为 4核 CPU 与 4GB 内存的 Lighthouse 服务器。

1.2 MCP Server 1.0.0 镜像的深层解析

在操作系统层面,我们选择了一个具有特定目的的镜像:MCP Server 1.0.0。这并非一个常规的通用操作系统镜像(如 Ubuntu 或 CentOS)。选择此镜像的背后,是前瞻性的架构考量。MCP,即模型上下文协议(Model Context Protocol),是实现 AI 模型与外部工具(如云服务 API)进行交互的核心。

"MCP Server 1.0.0" 镜像预装并配置了与 Lighthouse 服务进行 MCP 通信所需的基础环境和代理服务。使用该镜像的优势是显而易见的:

- 开箱即用:免去了手动安装和配置 MCP 相关服务的复杂过程,极大地缩短了部署时间。

- 环境一致性:确保了运行环境的标准化,避免了因软件版本或配置差异导致的潜在兼容性问题。

- 优化性能:镜像内的服务经过专门优化,能够与 Lighthouse 底层 API 实现最高效的通信。

从本质上讲,选择此镜像,就等于为服务器预装了一个能够被 AI "理解"和"操作"的官方驱动程序。

第二章:激活智能核心------MCP 服务的配置与授权

服务器实例创建成功后,我们便进入了整个流程中最关键的一环:激活并配置 MCP 服务,建立 Codebuddy AI 与 Lighthouse 服务器之间的通信链路。

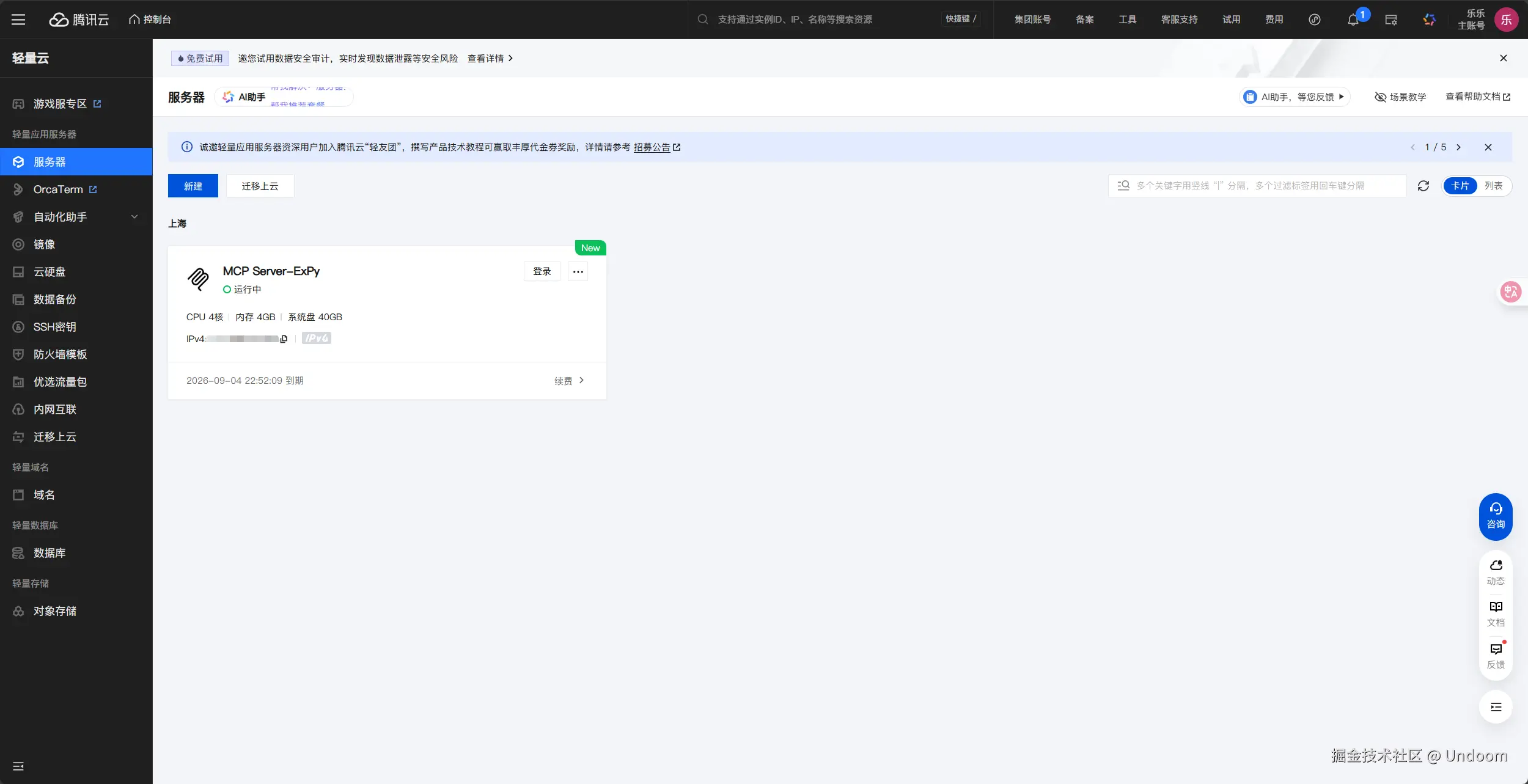

2.1 进入 MCP Server 管理界面

购买并成功启动服务器后,我们登录到腾讯云 Lighthouse 的控制台。这里提供了对服务器实例的全面可视化管理。

在服务器的详情页面中,我们找到并点击顶部导航栏的 MCP Server 管理 选项。这是一个专门为管理和配置 MCP 服务而设的入口。

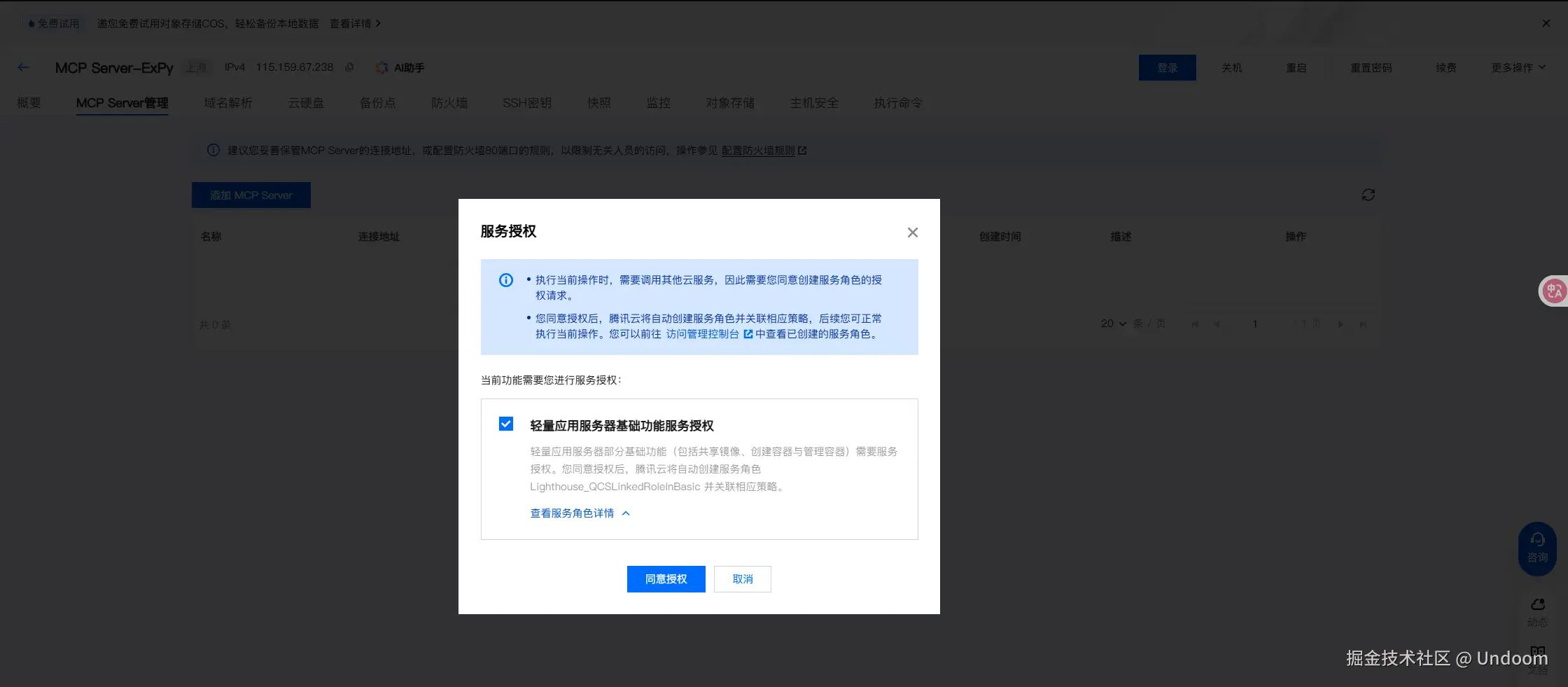

2.2 服务授权流程

首次进入该界面时,系统会提示进行服务授权。这是一个基于角色的访问控制(RBAC)流程,其核心是确保 MCP 服务拥有合法的、最小化的权限来代表用户执行操作。点击"同意授权",即表示我们允许 MCP 服务在我们的账户权限范围内,对 Lighthouse 资源进行程序化调用。这是保障账户安全的重要前提。

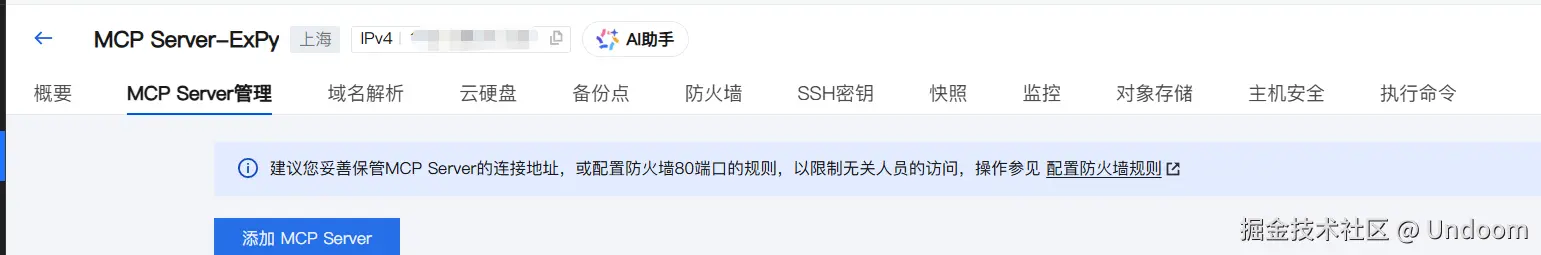

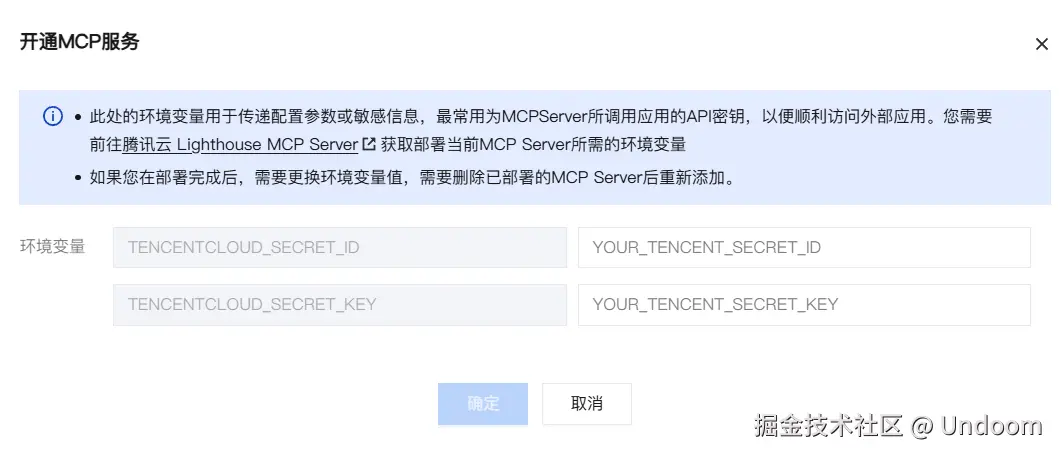

2.3 添加 MCP Server 实例并生成 API 密钥

授权完成后,我们点击"添加 MCP Server"按钮,正式开始配置过程。

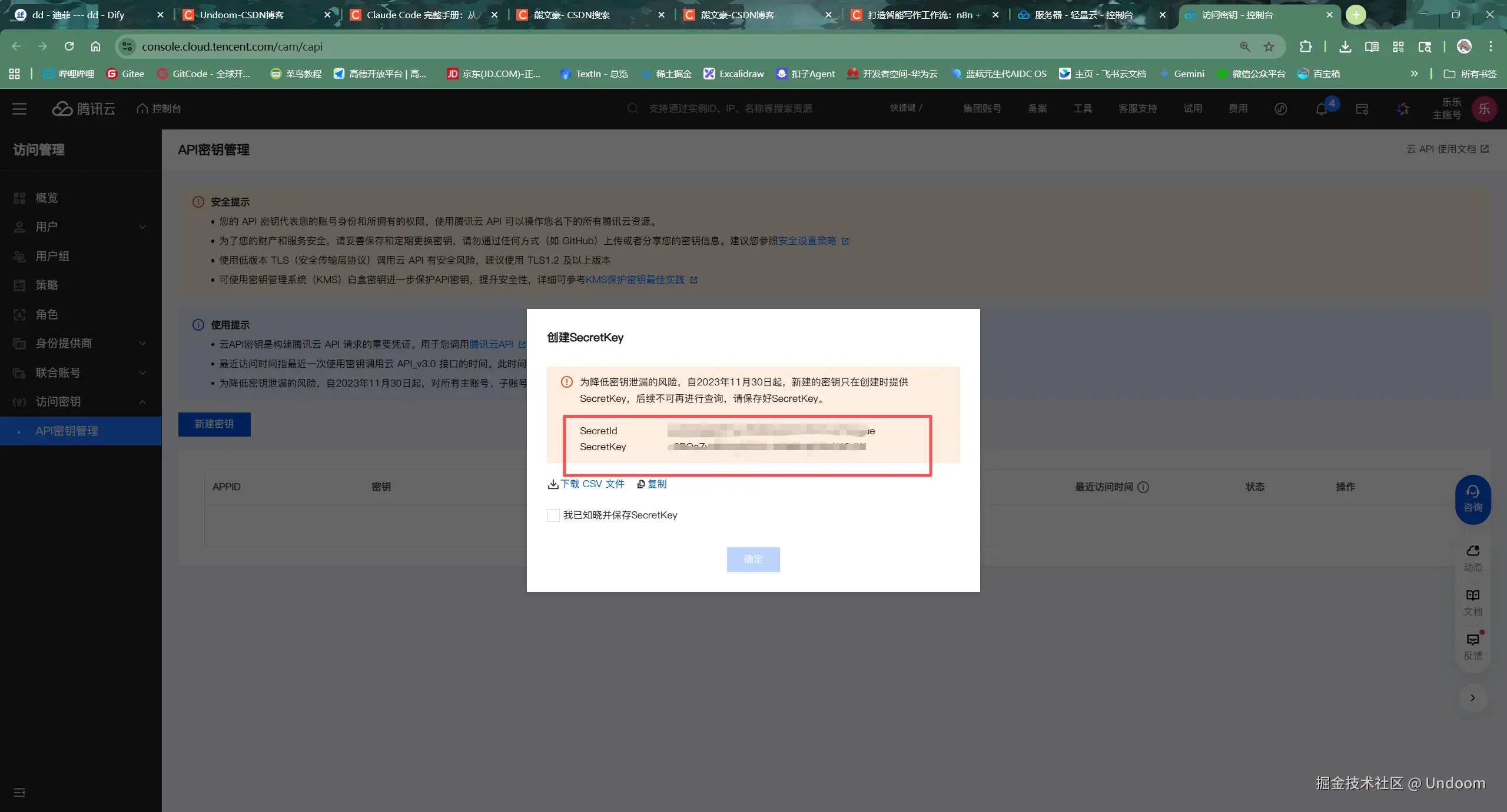

系统会弹出一个配置窗口,要求我们提供关键的身份验证信息:SecretId 和 SecretKey。

这对密钥是腾讯云访问管理(CAM)系统中的核心概念,它们是用于程序化访问腾讯云 API 的永久凭证,其作用等同于账户的用户名和密码。我们必须前往 腾讯云 CAM 控制台 进行创建和管理。

在 CAM 控制台生成密钥后,务必妥善保管。我们将获取到的 SecretId 和 SecretKey 分别复制并粘贴到 Lighthouse 控制台的相应输入框中。

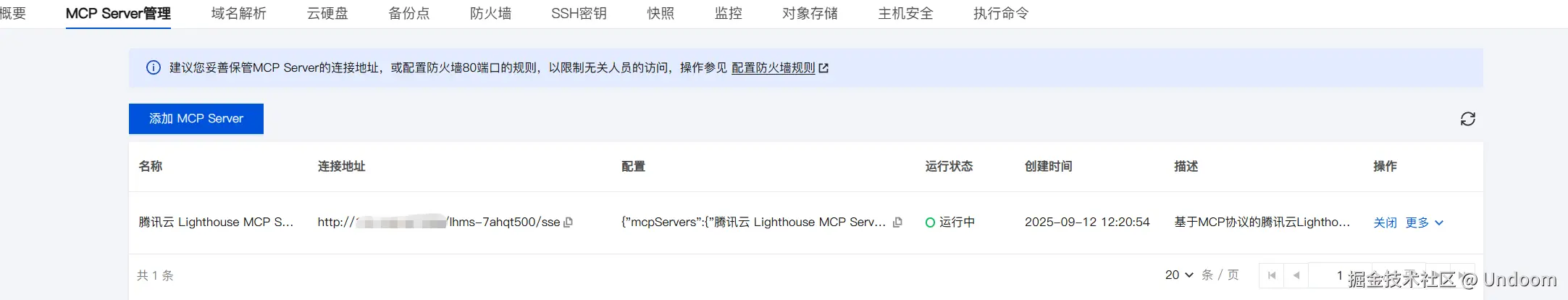

2.4 完成部署并获取连接端点

点击"确定"后,系统后台将完成一系列自动化部署操作,将我们提供的 API 密钥与服务器上的 MCP 服务进行绑定。配置成功后,界面上会显示出 MCP 服务的关键信息,最重要的是连接地址 (Connection Address)。

这个地址,例如 http://115.159.67.238/lhms-7ahqt500/sse,是一个 SSE (Server-Sent Events) 端点。SSE 是一种基于 HTTP 的轻量级推送技术,允许服务器向客户端单向、持续地发送数据流。在这里,它将作为 Codebuddy CLI 与 Lighthouse MCP 服务之间进行实时通信的通道。

第三章:构建本地操作终端------Codebuddy CLI 的安装与环境配置

在云端配置就绪后,我们需要在本地或操作终端上安装 Code-buddy CLI,这是我们与 AI 进行交互的入口。

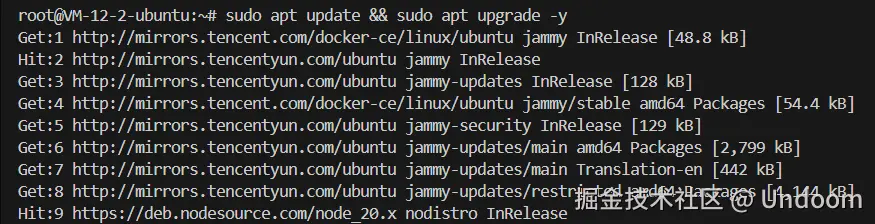

3.1 基础环境准备与系统更新

一个稳定、纯净的运行环境是成功安装软件的前提。我们通过 SSH 登录到将要安装 Codebuddy CLI 的服务器(可以是任意一台 Linux 服务器,甚至是本地的 WSL 环境),首先执行系统更新操作。

bash

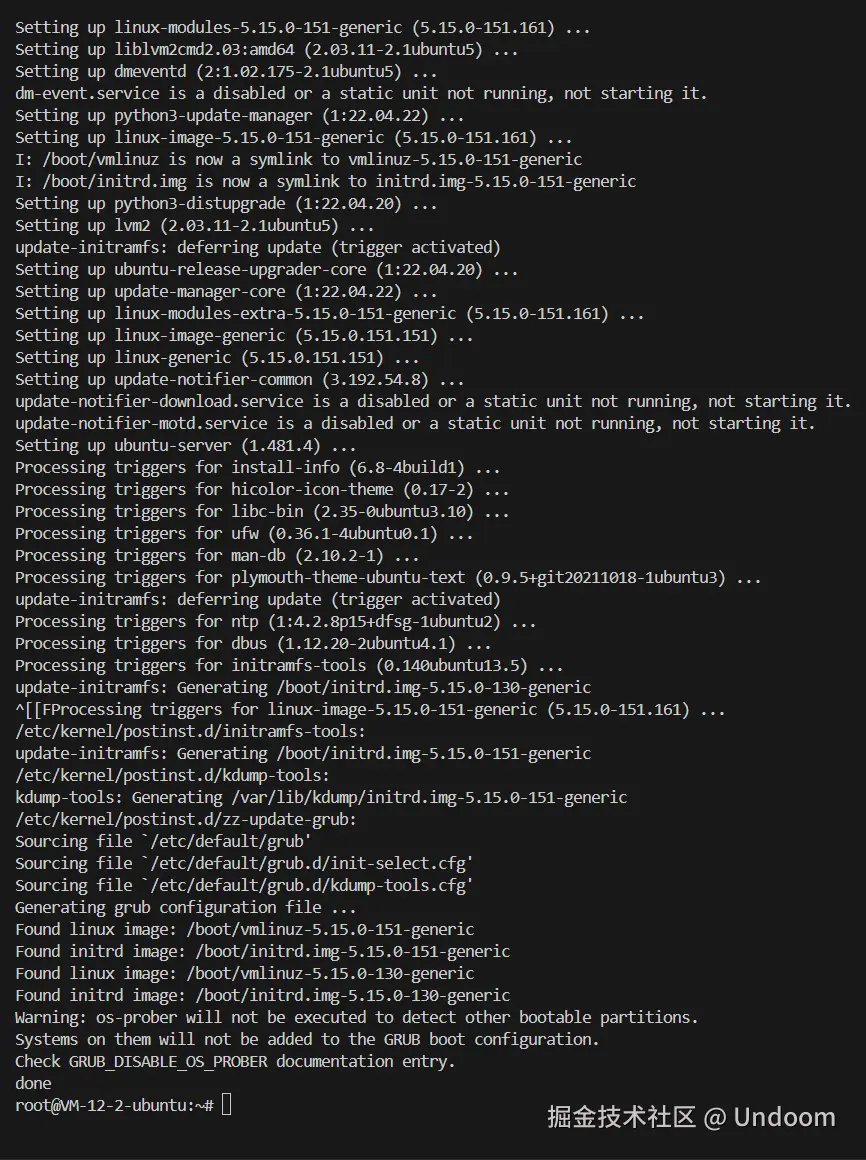

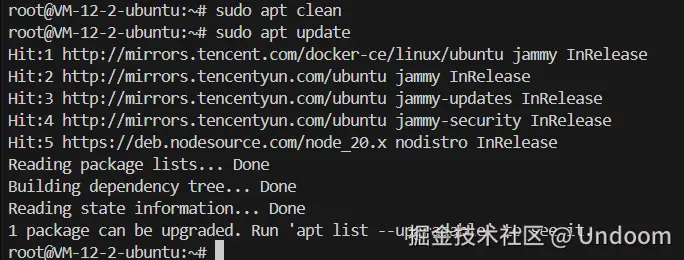

sudo apt update && sudo apt upgrade -yapt update 命令用于同步本地软件包索引,确保我们获取到的是最新的软件版本信息。apt upgrade 则会将所有已安装的软件包升级到最新版本。

在某些情况下,系统可能存在依赖关系破损的软件包。这时,直接更新可能会失败。此时需要执行修复命令:

bash

sudo apt --fix-broken install此命令会尝试自动修复这些损坏的依赖关系,是 Linux 系统维护中非常实用的一个工具。

修复完成后,再次执行系统更新,确保环境的健康状态。

3.2 Node.js 环境的安装与故障排除

Codebuddy CLI 是一个基于 Node.js 开发的工具,因此 Node.js 和其包管理器 npm 是其核心依赖。

3.2.1 标准安装尝试

通常,我们可以使用 apt 直接安装:

bash

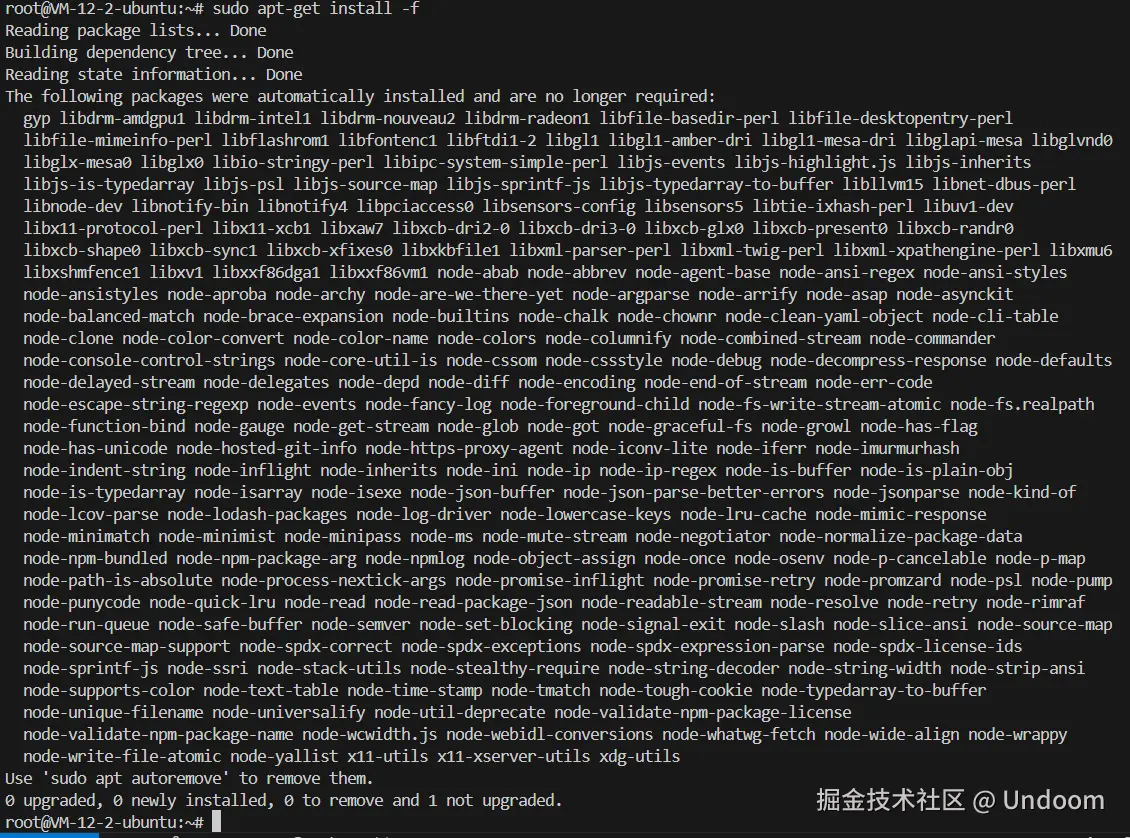

sudo apt-get install -f

sudo apt-get install nodejs npm

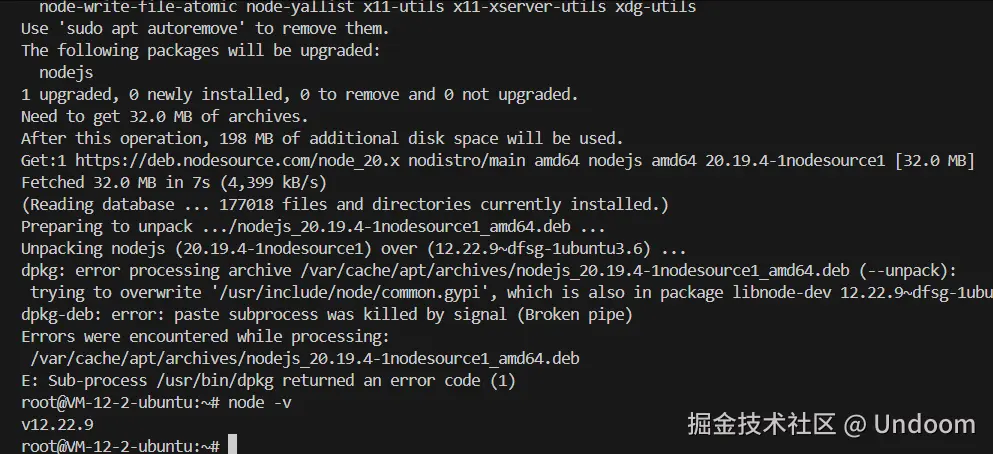

然而,在某些 Linux 发行版的官方源中,nodejs 包可能会与 libnode-dev 等其他开发包产生文件冲突,导致安装失败,并出现 dpkg: error processing 的错误。

3.2.2 冲突解决与版本优化安装

面对这种包冲突问题,最佳实践是彻底清理旧版本,并从更可靠的、官方推荐的软件源进行安装。

第一步:彻底卸载冲突包 使用 --purge 参数可以确保在卸载软件包的同时,删除其相关的配置文件。

bash

sudo apt-get remove --purge nodejs libnode-dev第二步:清理系统残留依赖 执行 autoremove 和 clean,确保系统中没有无用的依赖包和缓存文件。

bash

sudo apt-get autoremove -y

sudo apt-get clean第三步:从 NodeSource 安装 NodeSource 维护着包含最新 Node.js 版本的可靠软件源。我们通过 curl 下载其设置脚本并执行,将 NodeSource 的源添加到我们的系统中。这里我们选择安装 Node.js 20.x 版本。

bash

curl -sL https://deb.nodesource.com/setup_20.x | sudo -E bash -

sudo apt-get install -y nodejs这种方法不仅解决了冲突问题,还能确保我们安装的是一个稳定且较新的 Node.js 版本,这对于运行现代化的 CLI 工具至关重要。

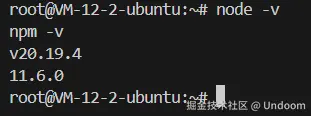

第四步:验证安装 安装完成后,通过检查版本号来确认 Node.js 和 npm 是否已成功安装并可用。

bash

node -v

npm -v

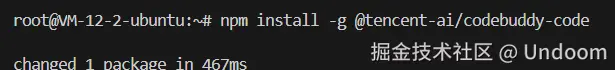

3.3 安装并启动 Codebuddy CLI

万事俱备,现在我们可以使用 npm 来全局安装 Codebuddy CLI。-g 标志表示将该软件包安装在系统范围内,使其 codebuddy 命令可以在任何路径下被调用。

bash

npm install -g @tencent-ai/codebuddy-code

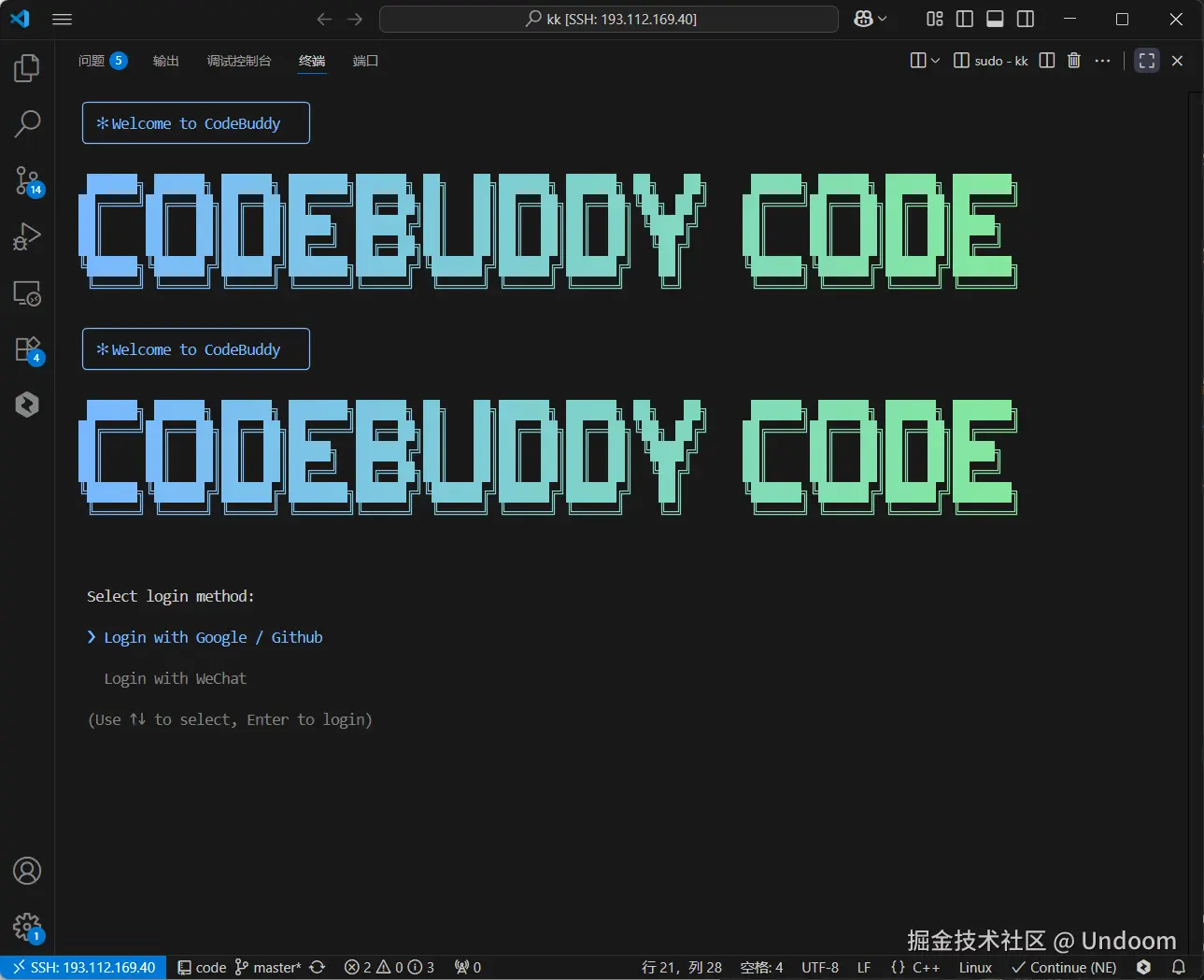

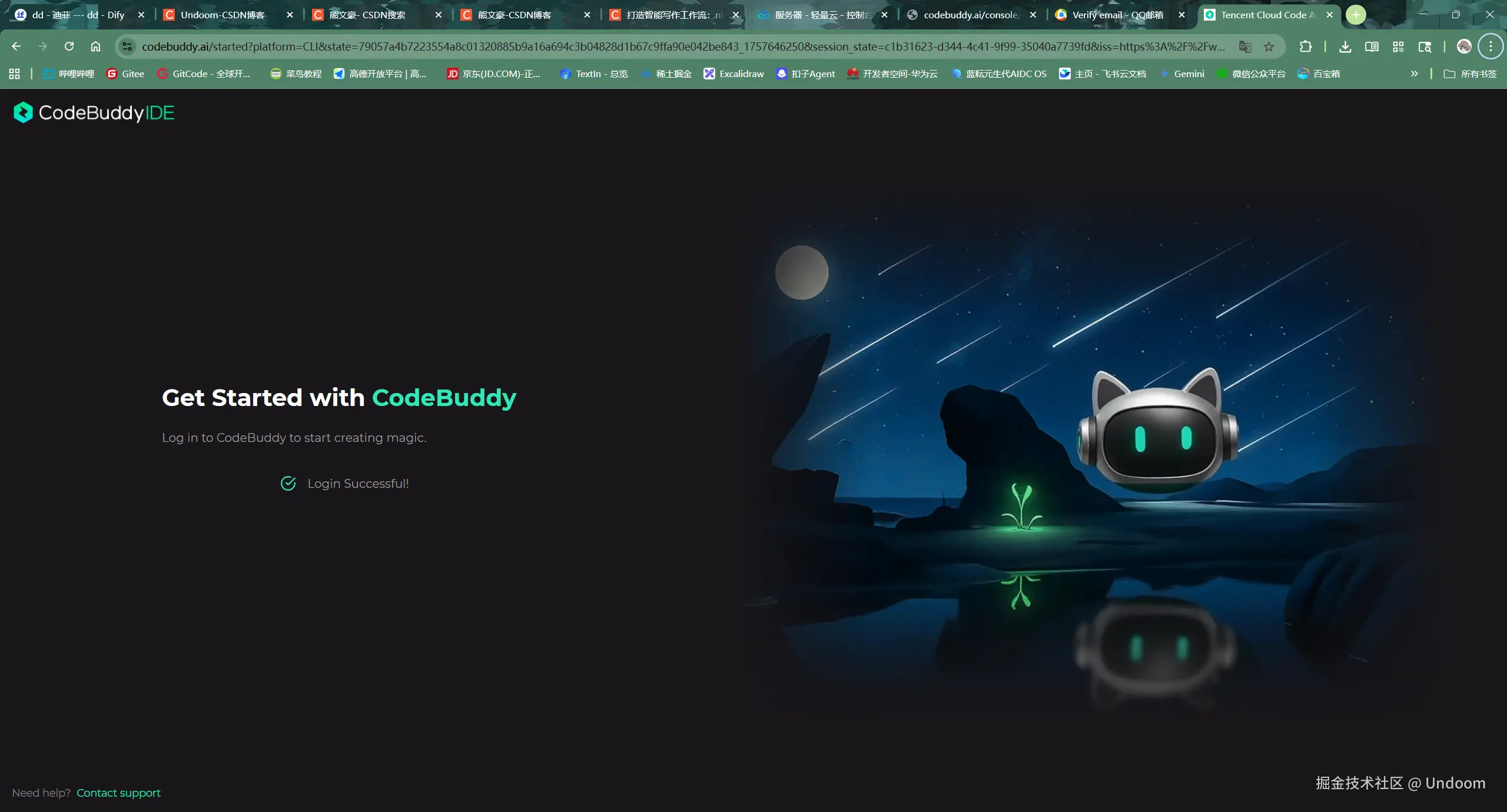

安装完成后,在终端直接输入 codebuddy 即可启动这个强大的 AI 命令行工具。

bash

codebuddy

首次启动后,CLI 会引导用户进行登录授权,支持 Google、GitHub、微信等多种方式,以同步用户配置和上下文。

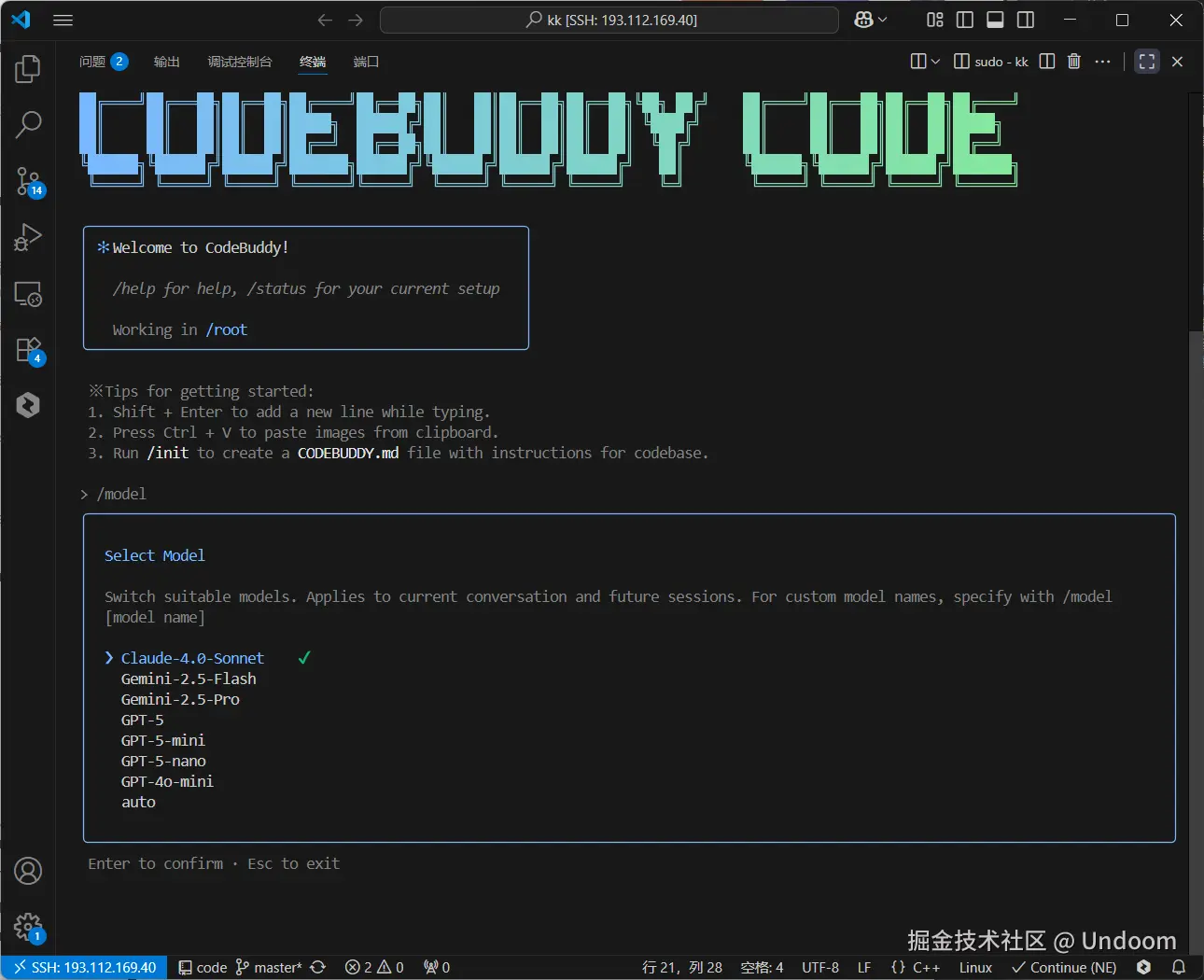

登录后,我们还可以使用 model 命令来选择或切换背后驱动的 AI 模型,以适应不同的任务需求。

第四章:终极链接------将 Lighthouse MCP 集成至 Codebuddy

现在,我们将云端的 MCP 服务端点与本地的 Codebuddy CLI 客户端连接起来,完成整个闭环。

4.1 MCP 的连接机制:Server-Sent Events (SSE)

正如前面提到的,Lighthouse MCP 服务提供的是一个 SSE 端点。Codebuddy CLI 通过其文档明确支持以 SSE 作为传输方式来添加 MCP。这种机制非常适合于 AI 助手接收来自外部工具的流式响应和状态更新。

4.2 执行集成命令

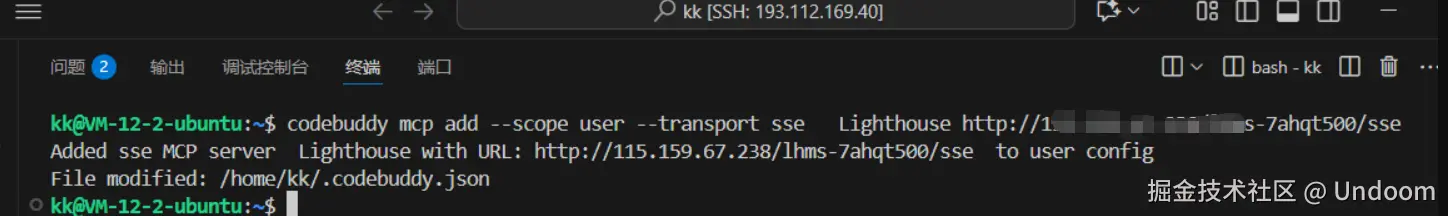

我们在 Codebuddy CLI 中执行 mcp add 命令,将之前获取到的 Lighthouse MCP 连接地址添加进去。

bash

codebuddy mcp add --scope user --transport sse Lighthouse http://xxxxxxxxxx/lhms-7ahqt500/sse这条命令的参数分解如下:

mcp add: 添加一个新的 MCP 服务。--scope user: 将此配置保存在用户级别的配置文件中,对该用户全局有效。--transport sse: 明确指定通信协议为 Server-Sent Events。Lighthouse: 为这个 MCP 服务指定一个易于记忆的别名。http://.../sse: 从 Lighthouse 控制台获取的完整 SSE 连接地址。

4.3 验证集成结果

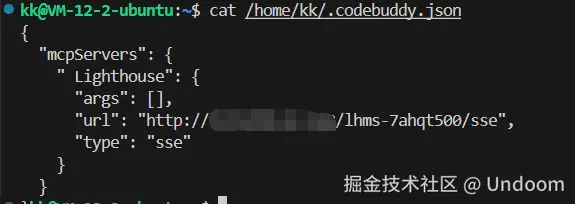

命令执行成功后,Codebuddy CLI 会将该配置写入其本地的 JSON 配置文件中。我们可以通过 cat 命令查看该文件,以从底层确认配置已生效。

bash

cat /home/kk/.codebuddy.json

在 JSON 文件中,我们可以清晰地看到名为 "Lighthouse" 的 MCP 条目及其对应的 URL 和传输协议,这表明集成已在技术层面完成。

同时,在 Codebuddy CLI 内部,我们可以使用 /mcp 命令来列出当前所有已连接的 MCP 服务,从应用层面再次确认。

第五章:智能化运维实践------通过自然语言管理服务器

集成完成后,我们便开启了全新的服务器管理模式。Lighthouse MCP 向 Codebuddy Cli 暴露了一系列强大的功能,使其具备了直接操作我们服务器的能力。

5.1 Lighthouse MCP 的功能矩阵

下表系统性地梳理了 Lighthouse MCP 提供的核心功能:

| 功能类别 | 函数名 | 核心功能描述 | 主要应用场景 |

|---|---|---|---|

| 实例生命周期管理 | start_instance |

开启(启动)一台已关机的轻量应用服务器。 | 当服务器处于关机状态时,通过此命令启动它以恢复服务。 |

stop_instance |

关闭(关机)一台正在运行的轻量应用服务器。 | 在进行维护、快照备份前或为了节省成本时,安全地关闭服务器。 | |

reboot_instance |

重启一台正在运行的轻量应用服务器。 | 当服务器响应缓慢、应用更新或系统配置变更后,需要重启来使之生效。 | |

| 信息与监控查询 | get_instances |

获取当前账户下所有轻量应用服务器的实例列表。 | 批量管理服务器前,先列出所有资源,了解整体情况。 |

get_instance_info |

根据指定的实例ID,获取该台服务器的详细信息。 | 查询特定服务器的IP地址、配置(CPU、内存、带宽)、状态等详细数据。 | |

get_monitor_data |

获取指定服务器的监控数据,如CPU、内存、网络流量等。 | 诊断服务器性能问题,查看资源使用率是否过高。 | |

get_regions |

获取所有可用于创建轻量应用服务器的地域列表。 | 在创建新服务器时,查询有哪些可用区(如上海、北京、硅谷)可供选择。 | |

| 网络与安全 | set_firewall |

为指定的服务器实例新增一条防火墙规则。 | 开放特定端口(如为网站开放80/443端口)或限制特定IP的访问。 |

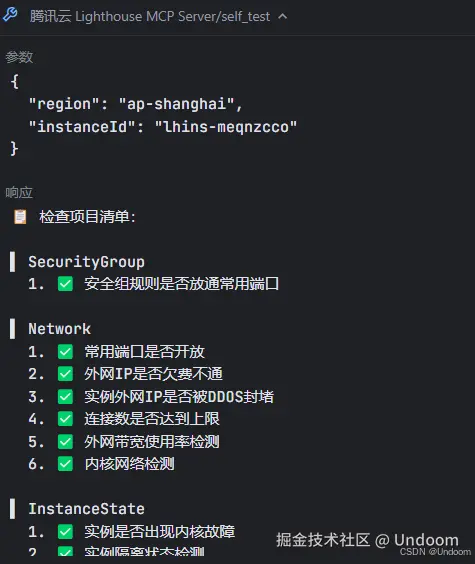

| 自我检测 | self_test |

服务器自检,用于检测本地网络配置或连通性。 | 当服务器无法访问时,运行自检以快速排查是网络问题还是服务问题。 |

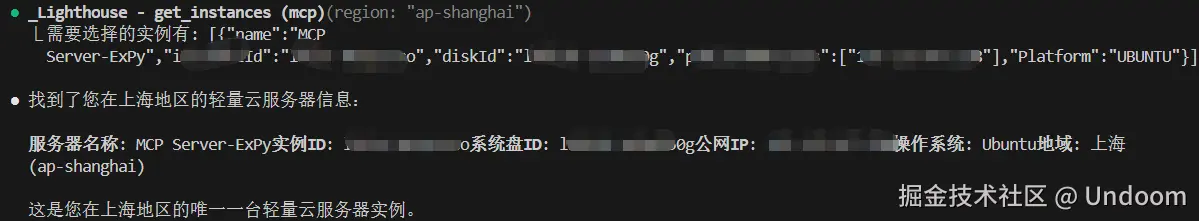

5.2 实践案例一:自然语言查询实例信息

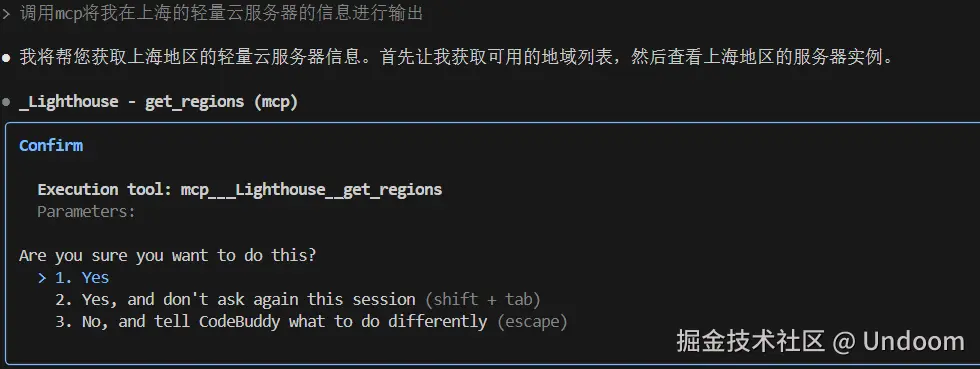

现在,我们可以直接在 Codebuddy CLI 中使用自然语言下达指令。例如,我们想要查询位于上海地域的服务器信息:

调用mcp将我在上海的轻量云服务器的信息进行输出。

Codebuddy AI 接收到指令后,会进行如下处理:

- 意图识别:理解用户的意图是"查询服务器信息"。

- 实体提取:抽取出关键信息"上海"。

- 函数映射 :将该意图映射到 Lighthouse MCP 提供的

get_instances或get_instance_info函数。 - 参数构建 :构建调用参数,可能包含一个

region过滤器,其值为"上海"。 - MCP 调用:通过已建立的 SSE 连接,向 Lighthouse MCP 发送调用请求。

- 结果呈现:接收到 MCP 返回的结构化数据(如 JSON),并将其格式化为人类可读的文本,呈现在终端上。

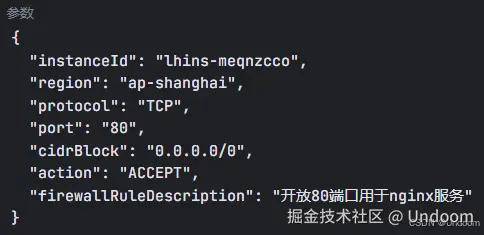

5.3 实践案例二:自动化防火墙策略管理

假设我们正在服务器上部署一个 Nginx Web 服务,该服务需要监听 80 端口。传统上,我们需要登录腾讯云控制台,找到防火墙设置,手动添加入站规则。现在,这个过程可以被一条指令替代:

调用mcp请你帮我 将80端口进行开放

Codebuddy AI 会将这个指令精确地映射到 set_firewall 函数,并自动构建出类似 { "Port": "80", "Protocol": "TCP", "Action": "ACCEPT" } 这样的参数,然后通过 MCP 执行。这个操作的效率和便捷性远超传统的手动点击方式。

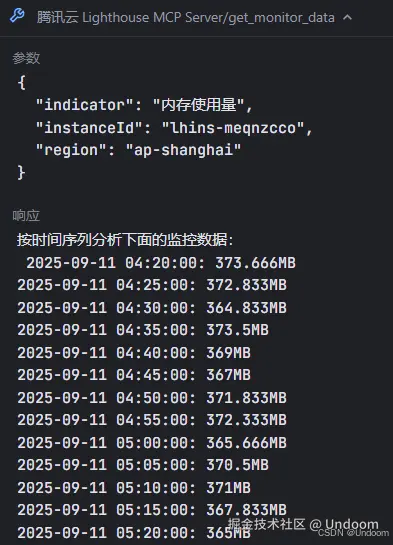

5.4 实践案例三:一键式全面信息获取

我们还可以提出更宽泛的请求,以获取服务器的全面信息。

Codebuddy 会智能地调用多个信息获取类函数,如 get_instance_info, get_monitor_data 等,并将结果汇总,提供一个关于服务器状态的完整视图,包括 IP 地址、实例状态、配置详情、创建时间等。

结论

通过本文详尽的步骤拆解和实践展示,我们完成了一次从零开始的、将传统云服务器管理模式升级为 AI 驱动的对话式管理的完整流程。我们不仅成功地将腾讯云 Lighthouse 服务器的功能接口通过 MCP 协议暴露给了 Codebuddy AI,还解决了在此过程中可能遇到的环境配置、软件依赖和网络通信等一系列技术挑战。

这一集成方案的实现,其意义远不止于提升了单次操作的效率。它标志着一种全新的人机交互范式的到来:

- 降低了技术门槛:非专业的云服务使用者也能够通过自然语言完成复杂的服务器配置和管理任务。

- 提升了运维效率:将原本需要在多个控制台界面之间跳转的复杂操作,简化为单一终端内的对话交互。

- 增强了自动化潜力:通过将 Codebuddy CLI 集成到更广泛的自动化脚本或 CI/CD 流程中,可以构建出更为智能和强大的自动化运维系统。

腾讯云 Lighthouse 与 Codebuddy Cli的结合,为我们描绘了未来云端管理的蓝图------一个更加智能、高效、且极具创造力的工作空间。这不仅仅是技术的叠加,更是对开发者和系统管理员工作流程的深刻重塑。