前言

随着 ChatGPT、Bard、Claude 等生成式 AI 工具的普及,我们正步入生成式引擎优化(GEO)的新时代。在这个 AI 主导的信息检索时代,用户习惯于直接向 AI 提问而非搜索引擎获取答案。这意味着内容创作者和营销人员必须重新思考如何让自己的内容被看见、被引用、被推荐。GEO 并非传统 SEO 的简单延伸,而是一种全新的内容优化思维:要求我们以更自然、权威且结构清晰的方式创作内容,以确保在 AI 模型训练和回答生成过程中脱颖而出。

当前,AI 驱动的搜索流量呈爆发式增长:ChatGPT 月活跃用户已超 1.8 亿,AI 搜索引擎 Perplexity 的使用量同比激增 858%,达到千万级。有预测显示,到 2028 年 AI 搜索将占据约14%的搜索市场份额。面对这股趋势,如果品牌内容无法被 AI 模型"看见",就仿佛从搜索结果中消失 。因此,我们亟需掌握 GEO 策略,让企业知识成为 AI 的"优先记忆",实现在 AI 答案中的无点击曝光。

本文将深入阐述 GEO 的定义和现状,比较 SEO 与 GEO 的联系区别,并提供面向 SEO 从业者和技术写作者的实用优化策略和案例,帮助大家在生成式引擎优化时代保持竞争优势。

GEO 的定义、发展背景与现状

什么是 GEO?

GEO(Generative Engine Optimization,生成式引擎优化)是一种专为AI 驱动的生成式搜索引擎 量身打造的内容优化策略。其核心目标是在 AI 模型生成回答时,让您的网站内容更频繁、更优先地被引用或推荐 。简单来说,GEO 关注的不是网页在搜索结果中的排名高低,而是当用户向 AI 提问时,AI 会主动引用您的品牌内容作为答案来源。

发展背景:

传统 SEO(搜索引擎优化)诞生于上世纪 90 年代末,此后经历了关键词堆砌、内容为王、用户体验优先等阶段的演进。而近年来,大型语言模型(LLM)的崛起改变了信息获取模式------用户不再满足于点击多个网页寻找答案,而是希望由 AI 直接给出精确且个性化的解答。这种行为转变催生了 GEO 这一新概念,它可被视为 SEO 在 AI 时代的延续和升级。

现状:

目前市面上涌现出多种生成式 AI 引擎,例如 OpenAI 的 ChatGPT、Anthropic 的 Claude、Microsoft Bing Chat(集成 GPT-4 模型)、Google 即将推出的 Gemini,以及主打实时引用的 Perplexity AI 等。这些工具在用户查询时往往直接给出融合了多个来源的信息答案。例如,Perplexity AI 会实时搜索互联网并引用网页链接 来回答用户问题;微软新版必应(Bing Chat)每句话后都会标注来源,用户悬停引用即可看到完整链接。甚至 ChatGPT 本身在引入联网搜索功能后,也开始在回答中附上来源链接,方便用户了解 AI 输出背后的依据。可以说,搜索引擎正在从"链接列表"演变为"整合答案",而 GEO 正是帮助内容适应这一演变的关键策略。

SEO 与 GEO:区别与联系

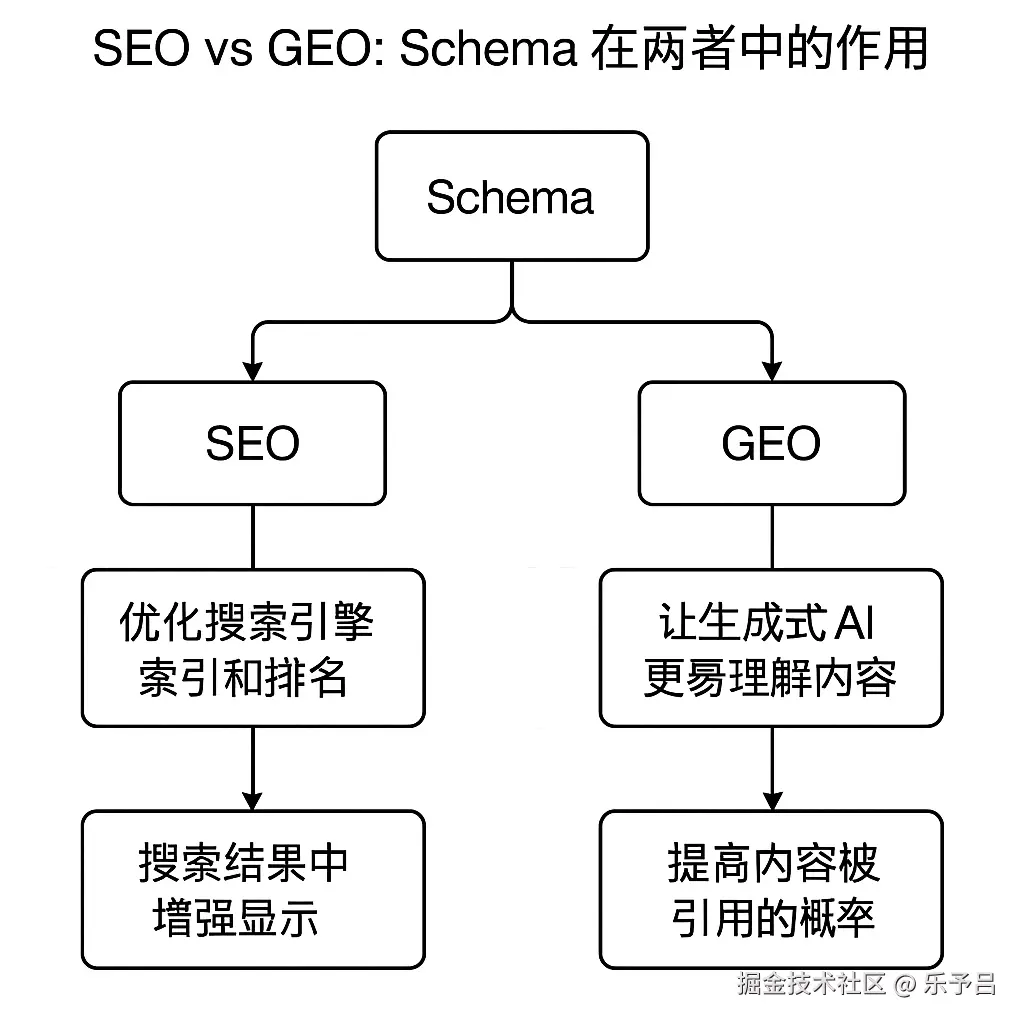

GEO 与传统 SEO 密切相关又有所不同。两者的共同点在于:没有良好的 SEO 基础,GEO 无从谈起 。因为如果网页不能被爬取和索引,AI 根本无法检索或引用你的内容 。实际上,AI 型搜索依然依赖搜索引擎抓取海量网页作为候选资料,因此GEO 以 SEO 为前提 。正如公式所示:GEO = SEO + RAG(检索增强生成)。第一步要通过传统 SEO 让搜索引擎"找到你",第二步再通过内容优化让 AI 在生成答案时"选中你"。

尽管联系紧密,GEO 与 SEO 的目标和策略仍存在显著区别。下面将两者核心差异进行对比:

| 对比维度 | 传统 SEO 优化目标 | GEO 优化目标 |

|---|---|---|

| 优化目标 | 提升网站在搜索引擎结果页的排名 | 让企业信息在 AI 生成的答案中优先出现 |

| 关注重点 | 关键词匹配、外部链接数量等技术指标 | 语义理解、内容权威性和结构化数据 |

| 用户交互 | 用户点击搜索结果进入网站获取信息 | AI 直接在回答中呈现品牌内容,无需点击 |

| 技术手段 | 关键词布局、链接建设等传统手段 | 语义优化、权威内容构建、结构化数据标注 |

可以看出,SEO 更关注被搜索引擎"看到",GEO 则关注被 AI "说到" 。SEO追求的是排名和点击流量,而GEO追求的是内容在AI答案中的出现频率和权威性。这导致评价标准的变化:SEO 看重流量、点击率;GEO 则关注 AI 对内容的引用次数、品牌在对话中的被提及率等新指标。

生成式 AI 引擎如何"引用"网络内容

生成式 AI 引擎(如 ChatGPT、Perplexity、Claude、Gemini 等)的工作方式一般包括两个阶段:

-

信息检索阶段

当用户提出问题时,AI 系统会先从互联网或自身知识库中搜索相关内容。例如,Bing Chat 背后依托必应搜索;ChatGPT 的浏览模式调用的是 Bing 的结果;Perplexity 则有自建的搜索索引来实时查询网页。

-

内容生成阶段

AI 模型读取检索到的内容,将其中的关键信息综合、重组并生成答案。为提高可信度,不少 AI 引擎会在回答中附上来源引用。例如,新版必应在回答每句话后添加脚注,标明信息来源;Perplexity 明确展示相关网页链接;ChatGPT 在联网模式下也会附上引用链接。

从技术角度看,大部分生成式AI搜索采用了 RAG(Retrieval-Augmented Generation,检索增强生成) 架构。即:模型先检索文档,再将结果与用户问题一起输入大模型生成答案。这样可以避免模型胡乱编造,提高答案的实时性和准确性。

因此,GEO 的任务,就是让您的内容既能进入 AI 的视野(被检索到),又能顺利融入它的回答(被引用)。

GEO 实践策略:让内容更适合 AI 引擎

1. 内容结构优化

- 使用清晰的标题层级(H1-H3) 这种清晰且富有逻辑的 Heading 标签结构有助于 AI 理解内容组织

- 利用列表、表格展示要点 使用列表、表格等形式展示要点,使信息更加一目了然

- 在开头给出结论或定义,在结尾做总结 良好的内容结构不仅提升用户阅读体验,也方便 AI 抓取和提炼重点。

例如:

markdown

# TCP 与 QUIC 的区别(结论:QUIC 更适合现代网络)

# TCP 的特点

- 面向连接,依赖三次握手

- 容易出现队头阻塞

- 缺乏原生加密

# QUIC 的特点

- 基于 UDP,减少握手延迟

- 支持多路复用,解决队头阻塞

- 内置加密,更适合移动端

# 对比总结

| 协议 | 建立连接 | 队头阻塞 | 移动端支持 |

| ---- | -------- | -------- | ---------- |

| TCP | 三次握手 | 存在 | 较差 |

| QUIC | 0-RTT | 已解决 | 较好 |

# 总结

QUIC 在延迟、安全性和移动性上更优,是未来互联网传输的趋势。👉 开头给出结论,分点介绍,再用表格总结,最后收尾。结构清晰,AI 易于抓取要点。

2. FAQ 式写作风格

采用问答形式组织内容,例如:

markdown

# 常见问题(FAQ)

Q: TCP 和 QUIC 的最大区别是什么?

A: TCP 需要三次握手建立连接,而 QUIC 基于 UDP,可以实现 0-RTT 连接,减少延迟。

Q: QUIC 为什么能避免队头阻塞?

A: QUIC 支持多路复用,一个流阻塞不会影响其他流,因此解决了 TCP 的队头阻塞问题。

Q: QUIC 更适合哪些场景?

A: 移动网络、视频流媒体和在线游戏,因为它支持连接迁移和更低延迟。这种 "开门见山" 的回答方式非常契合 AI 摘取信息的逻辑,可显著提高内容被AI选中的机会。此外,配合使用 FAQPage 模式的 Schema 标记,向搜索引擎和AI明确标识问答对的结构,效果更佳。

3. 结构化数据与 Schema 标注

利用结构化数据(Structured Data)向搜索引擎和AI提供内容的机器可读语义信息。例如,在网页中嵌入 JSON-LD Schema,例如 FAQPage、HowTo、Article 等,帮助 AI 更好识别网页信息。

markdown

<script type="application/ld+json">

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"name": "TCP 和 QUIC 的最大区别是什么?",

"acceptedAnswer": {

"@type": "Answer",

"text": "TCP 需要三次握手建立连接,而 QUIC 基于 UDP,可以实现 0-RTT 连接,减少延迟。"

}

},

{

"@type": "Question",

"name": "QUIC 为什么能避免队头阻塞?",

"acceptedAnswer": {

"@type": "Answer",

"text": "QUIC 支持多路复用,一个流阻塞不会影响其他流,因此解决了 TCP 的队头阻塞问题。"

}

}

]

}

</script>4. 内容更新与时效性

定期更新文章(年份、数据、案例),保持内容新鲜度。 👉 通过更新年份和应用场景,让 AI 更倾向引用你的页面,而不是引用过时资料。

5. 引用引导(外链与锚点优化)

- 获取权威网站的反向链接

- 在文章中合理使用内部链接与锚点

- 在内容中主动注明出处与数据来源

markdown

根据 [IETF QUIC 标准草案](https://datatracker.ietf.org/doc/html/rfc9000),

QUIC 在传输层引入了多路复用和 0-RTT 握手设计。👉 外链提升权威性,内部锚点建立知识网络,AI 在引用时更容易"选中你"的文章。

LLM.txt:AI 时代的 robots.txt

在 SEO 时代,robots.txt 控制爬虫抓取范围;在 GEO 时代,出现了新尝试:LLM.txt。

什么是 LLM.txt?

LLM.txt 是一种新兴规范,旨在让网站管理员决定 AI 模型是否、以及如何使用网站内容。它相当于 AI 版的 robots.txt。

功能示例

txt

# 允许 AI 模型引用博客内容

Allow: /blog/

# 禁止使用内部资料

Disallow: /internal/

# 要求引用时必须加来源

Attribution: requiredGEO 与 RAG 结合:技术写作者与企业内容开发者的对策

-

构建专属的 RAG 知识库

将文档存入向量数据库,结合 Embedding + GPT 接口,打造企业专属聊天机器人。

-

开放接口和插件

开发 ChatGPT 插件或开放 API,让 AI 工具直接访问你的知识库。

-

主动融入大模型训练集

将高质量数据集开放给 AI 训练社区,提高在模型中的"内置引用"概率。

-

利用 OpenAI API 进行内容测试

使用 GPT-4 模拟用户提问,测试 AI 是否会引用你的文章,迭代优化。

未来畅想:搜索的下一个十年

随着生成式 AI 的快速演进,我们正处于搜索方式彻底重构的前夜。

1. 搜索的未来形态

未来的搜索,可能不再是"输入关键词 → 点击链接 → 获取答案",而是更接近 个性化顾问 的模式:

- 用户用自然语言直接提问,AI 会结合 实时互联网 + 私有知识库 给出答案;

- 搜索不再是"十个蓝色链接",而是一个 对话持续、动态追问 的过程;

- 每个人看到的结果都高度定制化,甚至同一问题,不同用户会得到完全不同的回答。

2. 对服务厂商的挑战

这对现有面向 C 端用户的厂商提出了前所未有的挑战:

- 流量入口被重构:传统的 SEO 流量红利逐渐消失,品牌如何在 AI 对话中被"提及",成为新的生存问题。

- 商业模式变化:广告和推荐位如何融入 AI 答案?如果用户停留在对话界面,厂商可能失去流量分发的主导权。

- 技术适配成本:企业需要维护开放 API、RAG 知识库、LLM.txt 等基础设施,才能被 AI 平台持续"看见"。

3. 对用户的变化

用户的体验也会发生质变:

- 更少点击:未来用户可能很少需要打开多个网页比对答案,AI 会直接给出最优解释。

- 更强信任:如果 AI 能提供透明引用和解释链路,用户会把它当作"第一问答入口"。

- 更多个性化:AI 会结合用户的历史行为、上下文语境,给出高度定制化的答案,这会让信息检索更高效。

📌 总结畅想 未来的搜索可能会变成 "AI 伴随式信息获取":

- 用户只需要提出问题,AI 就会主动结合公开知识和私有上下文,给出答案和下一步建议;

- 品牌和内容提供者必须思考如何在这种对话里 被引用、被信任、被推荐;

- 对用户来说,信息更快、更准,但也带来"答案是否被 AI 垄断"的新挑战。

可以说,SEO 到 GEO 的转变只是开始。真正的挑战,是当搜索彻底对话化、场景化之后,我们该如何让内容和品牌继续被用户看见。