三、策略二:分布式内存溢出(OOM)排查------跨节点问题定位方法论

3.1 分布式 OOM 的 2 大典型场景

3.1.1 场景 1:堆内存溢出(java.lang.OutOfMemoryError: Java heap space)

案例背景:某金融支付集群(6 节点),用户支付后触发"订单对账"任务,高峰期部分节点抛出 OOM,且故障节点逐渐增多(1→3→5)。

3.1.2 场景 2:元空间溢出(java.lang.OutOfMemoryError: Metaspace)

案例背景:某微服务网关集群(8 节点),使用 Spring Cloud Gateway + 动态路由(每 10 分钟更新一次路由规则),运行 72 小时后所有节点陆续抛出元空间 OOM。

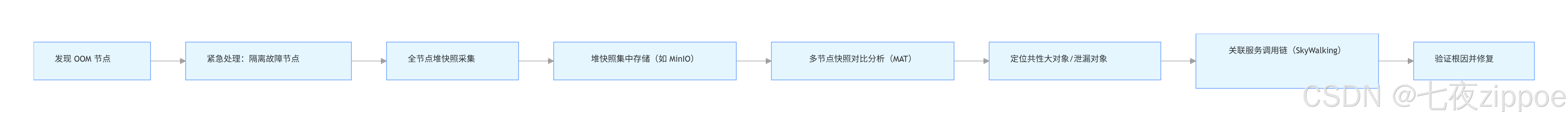

3.2 实战:堆内存溢出(OOM)跨节点排查流程

3.2.1 排查架构图

3.2.2 分步操作(附工具命令)

-

第一步:紧急隔离,避免故障扩散

通过 Kubernetes 或服务注册中心(Nacos/Eureka)将 OOM 节点下线,避免负载均衡将流量继续导向故障节点:

bash# 若使用 Nacos,下线节点命令 curl -X PUT "http://nacos-server:8848/nacos/v1/ns/instance?serviceName=payment-service&ip=192.168.1.105&port=8080&enabled=false" -

第二步:全节点堆快照采集(关键!跨节点对比需多快照)

在所有节点(包括正常节点)采集堆快照,用于后续对比分析:

bash# 1. 先查看 JVM 进程 ID jps -l | grep payment-service # 输出示例:12345 com.xxx.PaymentApplication # 2. 采集堆快照(-dump:format=b 生成二进制 hprof 文件,-live 只保留存活对象) jmap -dump:format=b,file=/data/dump/payment-heap-$(date +%Y%m%d%H%M)-$(hostname).hprof -live 12345 # 3. 压缩快照(减少传输体积) gzip /data/dump/payment-heap-202405201530-node105.hprof -

第三步:集中存储快照,使用 MAT 对比分析

将所有节点的堆快照上传至 MinIO,通过 Eclipse MAT(Memory Analyzer Tool)打开多个快照进行对比:

- 关键操作 1:查找"共性大对象"

在 MAT 中使用「Compare Heap Dumps」功能,对比正常节点(node101)和 OOM 节点(node105)的对象分布:- 发现 OOM 节点中

com.xxx.ReconciliationTask类实例数量达 5000+,单个实例占用 200KB,总占用 1G 内存; - 正常节点中该类实例仅 100+,总占用 20MB。

- 发现 OOM 节点中

- 关键操作 2:分析对象引用链

通过 MAT 的「Path to GC Roots」功能,发现ReconciliationTask被ThreadPoolExecutor的任务队列持有,且任务执行完成后未被回收(线程池核心线程数设置过大,任务堆积)。

- 关键操作 1:查找"共性大对象"

-

第四步:关联服务调用链,验证根因

通过 SkyWalking 查看 OOM 节点的服务调用记录:

- 发现高峰期"订单对账"接口调用量从 100 QPS 升至 500 QPS;

- 服务使用的线程池配置为

corePoolSize=20,maximumPoolSize=20(固定线程数),任务队列无界(LinkedBlockingQueue),导致大量任务堆积在队列中,ReconciliationTask对象无法被 GC 回收。

-

解决方案:

-

调整线程池配置,使用有界队列+拒绝策略(避免任务无限堆积):

java@Configuration public class ThreadPoolConfig { @Bean("reconciliationThreadPool") public ExecutorService reconciliationThreadPool() { // 核心线程数=CPU核心数*2,最大线程数=CPU核心数*4 int corePoolSize = Runtime.getRuntime().availableProcessors() * 2; int maxPoolSize = Runtime.getRuntime().availableProcessors() * 4; // 有界队列,容量=200(根据业务压测结果调整) BlockingQueue<Runnable> queue = new ArrayBlockingQueue<>(200); // 拒绝策略:提交任务的线程自己执行(避免任务丢失) RejectedExecutionHandler handler = new ThreadPoolExecutor.CallerRunsPolicy(); return new ThreadPoolExecutor( corePoolSize, maxPoolSize, 60L, TimeUnit.SECONDS, queue, handler, new ThreadFactoryBuilder().setNameFormat("reconciliation-thread-%d").build() ); } } -

增加"订单对账"任务的异步化+分片处理(将大任务拆分为 100 条/片,避免单任务占用过多内存);

-

配置堆内存监控告警(通过 Prometheus + Grafana 监控

jvm_memory_used_bytes{area="heap"},使用率>85% 触发告警)。

-

-

优化效果:

- 集群运行 72 小时无 OOM 节点;

- 线程池任务队列最大堆积数控制在 150 以内;

- 对账接口平均响应时间从 800ms 降至 200ms。

3.3 实战:元空间 OOM 排查(动态代理类泄漏)

3.3.1 核心问题:元空间存储什么?

元空间(Metaspace)用于存储类的元信息(如类名、方法、字段、注解等),JDK 8 后替代永久代(PermGen),默认无固定大小(受限于本地内存),但大量动态生成的类未被回收会导致元空间溢出。

3.3.2 排查步骤与解决方案

-

问题现象 :网关集群节点元空间使用率从 30% 持续升至 95%,最终抛出

OutOfMemoryError: Metaspace。 -

第一步:分析元空间占用情况

使用

jstat查看元空间使用趋势,通过jmap导出类加载信息:bash# 1. 查看元空间使用率(每 5 秒输出一次,共输出 10 次) jstat -gcmetacap <pid> 5000 10 # 关键指标:MCMN(最小元空间)、MCMX(最大元空间)、MC(当前使用)、MU(使用率) # 输出示例:MCMN=262144K, MCMX=1048576K, MC=1024000K, MU=97.66% # 2. 导出类加载信息(查看哪些类数量异常) jmap -clstats <pid> > /data/class-stats-$(hostname).txt -

第二步:定位异常类加载器

分析

class-stats.txt,发现com.netflix.client.config.DynamicPropertyFactory相关的动态代理类(如$Proxyxxxx)数量达 10000+(正常节点仅 500+),且持续增长。 -

根因 :Spring Cloud Gateway 动态路由更新时,每次都会通过

Cglib动态生成代理类,但旧的代理类未被卸载(类加载器URLClassLoader被DynamicPropertyFactory持有,无法回收)。 -

解决方案:

-

优化动态路由更新逻辑,避免频繁生成代理类(将路由规则缓存至本地,仅当规则发生变化时才更新代理);

-

配置元空间内存限制与回收策略(避免元空间无限制占用本地内存):

bash# JVM 启动参数添加元空间配置 -XX:MetaspaceSize=512m -XX:MaxMetaspaceSize=1024m \ -XX:+UseCompressedClassPointers -XX:+UseCompressedOops \ -XX:+MetaspaceReclaimPolicy=Aggressive # 主动回收未使用的元空间 -

定期重启网关节点(通过 Kubernetes 滚动更新,每 24 小时重启一次,避免类堆积)。

-

-

优化效果:

- 元空间使用率稳定在 40%-60%;

- 动态代理类数量控制在 1000 以内;

- 集群运行 30 天无元空间 OOM。

四、策略三:JVM 参数的集群差异化调优------拒绝"一刀切"

4.1 分布式集群的节点角色分类与资源需求

不同角色的节点(网关、业务服务、数据处理服务)对 JVM 资源的需求差异极大,需针对性配置参数:

| 节点角色 | 核心业务场景 | JVM 资源瓶颈 | 调优重点 |

|---|---|---|---|

| 网关节点 | 路由转发、鉴权、限流 | 直接内存(Netty 网络通信) | 增大直接内存、优化 GC 停顿时间 |

| 业务节点 | 订单处理、用户服务(CRUD) | 堆内存(对象频繁创建/销毁) | 优化堆内存分配、选择合适 GC 算法 |

| 数据节点 | 大数据处理、报表生成 | CPU(并行计算)、堆内存 | 启用并行 GC、增大新生代、优化线程 |

4.2 实战:基于 Kubernetes 的差异化参数配置

通过 Kubernetes 的 ConfigMap 为不同角色节点配置独立 JVM 参数,实现"按需分配"。

4.2.1 第一步:创建差异化参数 ConfigMap

yaml

# jvm-config.yaml

apiVersion: v1

kind: ConfigMap

metadata:

name: jvm-config

namespace: prod

data:

# 网关节点 JVM 参数(重点优化直接内存和 GC 停顿)

gateway-jvm-opts: |

-Xms4g -Xmx4g -Xmn2g

-XX:MetaspaceSize=256m -XX:MaxMetaspaceSize=512m

-XX:DirectMemorySize=2g # 增大直接内存(Netty 使用)

-XX:+UseG1GC -XX:MaxGCPauseMillis=50 # G1 GC,目标停顿 50ms

-XX:+ParallelRefProcEnabled # 并行处理引用

-XX:+UnlockExperimentalVMOptions -XX:G1NewSizePercent=30 # 新生代占比 30%

# 业务节点 JVM 参数(重点优化堆内存和吞吐量)

business-jvm-opts: |

-Xms8g -Xmx8g -Xmn4g

-XX:MetaspaceSize=512m -XX:MaxMetaspaceSize=1024m

-XX:+UseParallelGC -XX:+UseParallelOldGC # 并行 GC,追求吞吐量

-XX:ParallelGCThreads=8 # 并行 GC 线程数=CPU核心数

-XX:MaxTenuringThreshold=6 # 对象晋升老年代阈值

# 数据节点 JVM 参数(重点优化并行计算和大堆内存)

data-jvm-opts: |

-Xms16g -Xmx16g -Xmn8g

-XX:MetaspaceSize=1g -XX:MaxMetaspaceSize=2g

-XX:+UseZGC # ZGC,支持大堆内存(16g+)且停顿时间短(<10ms)

-XX:ZGCParallelGCThreads=16 # ZGC 并行线程数

-XX:+UnlockExperimentalVMOptions -XX:ZGCHeapRegionSize=32m # 堆区域大小 32m4.2.2 第二步:在 Deployment 中引用对应参数

网关节点 Deployment 示例:

yaml

# gateway-deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: gateway-service

namespace: prod

spec:

replicas: 8

template:

spec:

containers:

- name: gateway-service

image: registry.xxx.com/gateway:v1.0.0

ports:

- containerPort: 8080

env:

# 引用网关节点的 JVM 参数

- name: JAVA_OPTS

valueFrom:

configMapKeyRef:

name: jvm-config

key: gateway-jvm-opts

resources:

requests:

cpu: "4"

memory: "8Gi"

limits:

cpu: "8"

memory: "12Gi"业务节点 Deployment 示例 (仅需修改 JAVA_OPTS 引用的 key):

yaml

env:

- name: JAVA_OPTS

valueFrom:

configMapKeyRef:

name: jvm-config

key: business-jvm-opts4.3 案例:物流调度系统的差异化调优效果

某物流调度系统包含 3 类节点(网关 4 节点、业务 6 节点、数据 2 节点),优化前使用统一参数(-Xms8g -Xmx8g -XX:+UseParallelGC),存在以下问题:

- 网关节点:直接内存不足,Netty 频繁抛出

OutOfDirectMemoryError; - 业务节点:Full GC 每小时 3 次,每次停顿 1.5s,影响订单处理;

- 数据节点:堆内存 8g 不足,大数据报表生成时频繁 OOM。

4.3.1 优化前后指标对比

| 节点角色 | 优化前问题 | 调优参数(核心) | 优化后效果 |

|---|---|---|---|

| 网关 | 直接内存溢出、GC 停顿 1s+ | -XX:DirectMemorySize=2g -XX:+UseG1GC |

无直接内存溢出,GC 停顿 <50ms |

| 业务 | Full GC 频繁(3 次/小时) | -Xms8g -Xmx8g -XX:+UseParallelGC |

Full GC 降至 1 次/3 小时,停顿 500ms |

| 数据 | 报表生成 OOM、堆内存不足 | -Xms16g -Xmx16g -XX:+UseZGC |

无 OOM,报表生成时间从 10min 降至 3min |

五、实战总结:分布式 JVM 调优的"三板斧"

5.1 核心原则:从"被动救火"到"主动预防"

- 日志集中化是基础:没有统一的 GC 日志分析平台,分布式 JVM 问题排查效率会下降 80%,优先搭建 ELK 或 Loki 日志体系;

- 问题定位分层化:先通过监控(Prometheus/Grafana)定位异常节点,再通过堆快照/GC 日志分析节点内部问题,最后关联服务调用链(SkyWalking)验证根因;

- 参数配置差异化:根据节点角色(网关/业务/数据)制定个性化参数,避免"一刀切",同时通过压测验证参数有效性(推荐工具:JMeter、Gatling)。

5.2 避坑指南:分布式调优的 4 个常见误区

-

误区 1:盲目调大堆内存

某业务节点将堆内存从 8g 调至 16g,但未修改 GC 算法,导致 Full GC 停顿从 1s 增至 3s(大堆内存下 Parallel GC 回收效率下降)。

正确做法 :大堆内存(>8g)优先选择 G1 或 ZGC,同时调整新生代占比(如 G1 中G1NewSizePercent=30)。 -

误区 2:忽略直接内存监控

网关节点仅监控堆内存,未监控直接内存,导致 Netty 抛出

OutOfDirectMemoryError时无法快速定位。

正确做法 :通过jstat -gcmetacap监控直接内存,或在 Prometheus 中添加jvm_buffer_memory_used_bytes{id="direct"}指标告警。 -

误区 3:GC 日志配置不规范

各节点 GC 日志格式不统一,缺少节点 IP、服务名等标识,导致跨节点分析时无法关联。

正确做法 :所有节点统一 GC 日志格式,强制包含node.ip、service.name等字段(参考 2.2.2 节配置)。 -

误区 4:未隔离故障节点

发现 OOM 节点后未及时下线,导致负载均衡将流量转移至其他节点,引发"连锁 OOM"。

正确做法:配置自动下线机制(如 Kubernetes liveness 探针检测 JVM 内存使用率,>90% 自动重启节点)。

5.3 进阶方向:智能化调优与可观测性融合

- AI 辅助调优:通过阿里 Arthas 或字节跳动 Byteman 采集 JVM 运行数据,结合机器学习模型(如 XGBoost)预测最优参数(如根据 QPS 自动调整堆内存大小);

- 可观测性平台整合 :将 JVM 指标(Prometheus)、GC 日志(Loki)、链路追踪(Jaeger)、容器监控(Prometheus Node Exporter)整合至 Grafana,实现"一站式"监控(示例仪表盘见下图):

JVM 指标 Grafana 统一仪表盘 GC 日志 链路追踪 容器监控 智能告警 自动调优建议

六、附录:分布式 JVM 调优必备工具清单

| 工具类型 | 工具名称 | 核心用途 | 关键命令/配置示例 |

|---|---|---|---|

| 日志采集 | Filebeat + Logstash | GC 日志集中采集与解析 | filebeat.yml 配置日志路径与自定义字段 |

| 日志存储分析 | Elasticsearch + Kibana | 日志检索、可视化仪表盘 | Kibana 中创建 Full GC 频率趋势图 |

| JVM 监控 | Prometheus + Grafana | 堆内存、元空间、GC 指标监控与告警 | 监控指标 jvm_memory_used_bytes{area="heap"} |

| 堆分析 | MAT(Memory Analyzer Tool) | 堆快照分析、内存泄漏定位 | 「Compare Heap Dumps」对比多节点快照 |

| JVM 诊断 | Arthas | 在线排查(无需重启)、查看对象分布 | dashboard 查看实时指标,heapdump 生成快照 |

| 容器编排 | Kubernetes | 差异化参数配置、故障节点隔离 | 通过 ConfigMap 配置 JVM 参数 |

通过本文的实战策略与案例,可系统性解决分布式场景下的 JVM 调优难题,从"被动排查"转变为"主动掌控",让集群 JVM 性能始终保持最优状态。