1.前言

Codex 是由 OpenAI 开发的强大 AI 代码生成模型,基于 GPT 架构微调而成,能够根据自然语言描述自动生成高质量代码。它支持数十种编程语言,尤其在 Python 和 JavaScript 上表现突出。

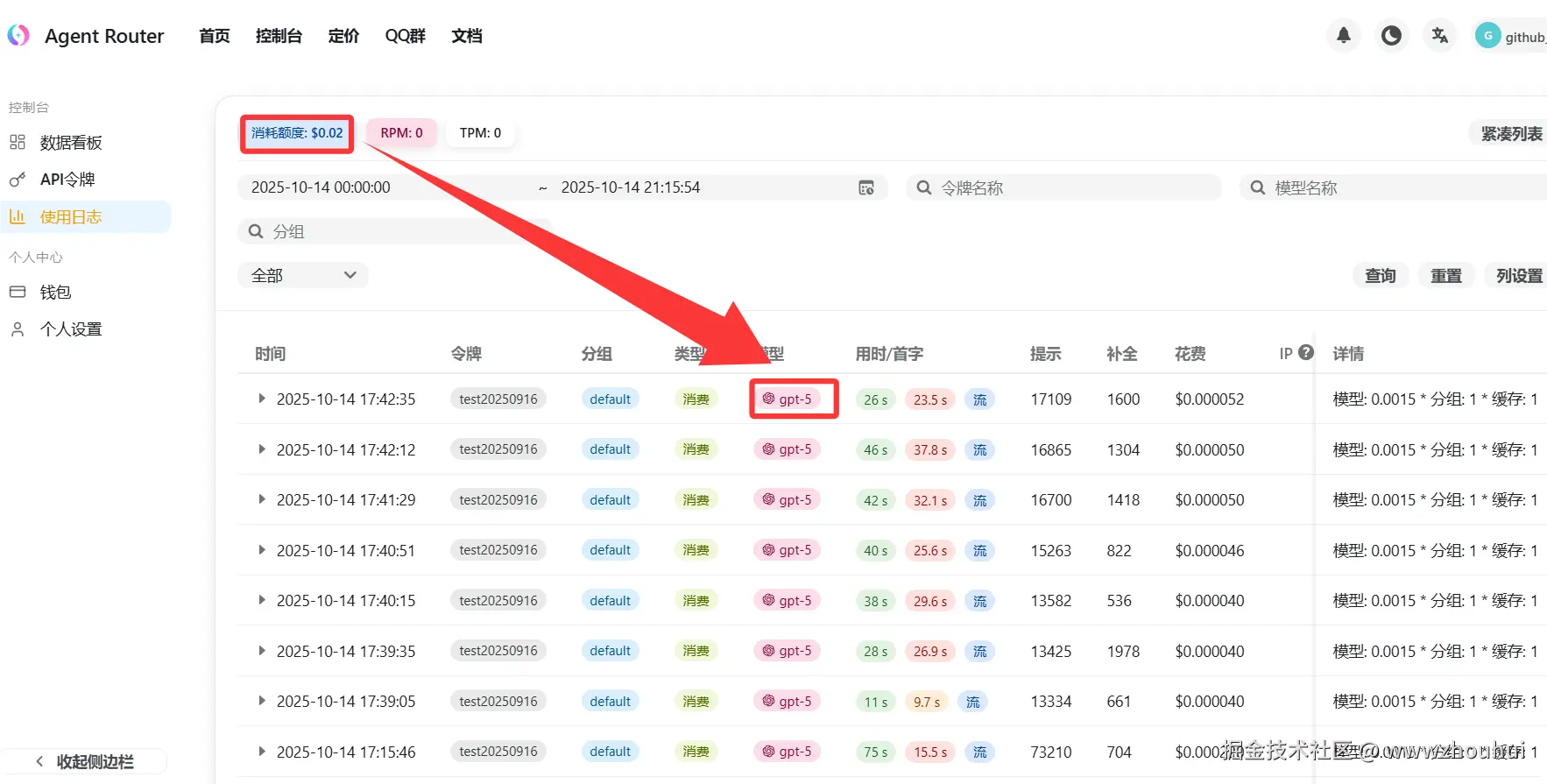

之前一直使用claude code(简称CC) 实现代码编程,每天稍微用一下大几十美刀就没了。 这几天开始用codex ,使用公益网站提供的gpt 5模型用起来也太省了。今天一个下午用下来总共消耗了0.02美金,这也太爽了。给大家看一下消耗截图。

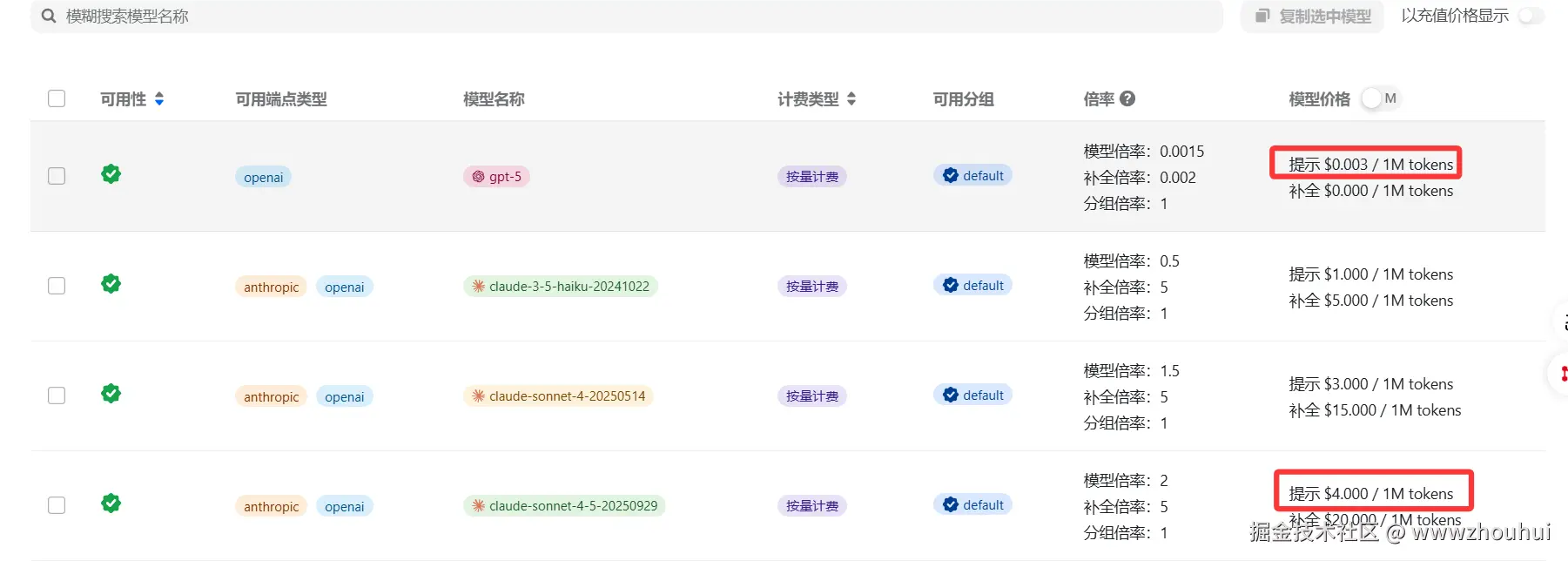

而且代码能力也不输claude code 对应的claude4.5模型,我们看一下他们价格对比。

初步算了一下价格claude4.5模型是gpt5模型的1333倍,对比claude3.5模型也只是它的千分之3的费用,基本可以算是白菜价了。今天就带大家一起玩转着codex来实现vibe coding编程。

2.codex安装及使用

node.js下载和安装

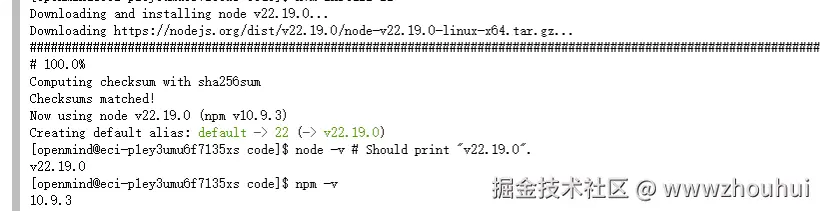

使用codex我们需要先安装node.js这个和之前使用claude code一样

node.js下载地址nodejs.org/zh-cn/downl... 这里我们选择对应的版本下载,我这里以linux为例

输入下面命令

shell

# Download and install nvm:

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash

# in lieu of restarting the shell

\. "$HOME/.nvm/nvm.sh"

# Download and install Node.js:

nvm install 22

# Verify the Node.js version:

node -v # Should print "v22.20.0".

# Verify npm version:

npm -v # Should print "10.9.3".

codex 安装

我们输入下面命令安装codex

shell

npm install -g @openai/codex安装完成后,我们使用agentrouter.org 提供的免费的模型(gpt5模型)这里我们需要做如下设置。

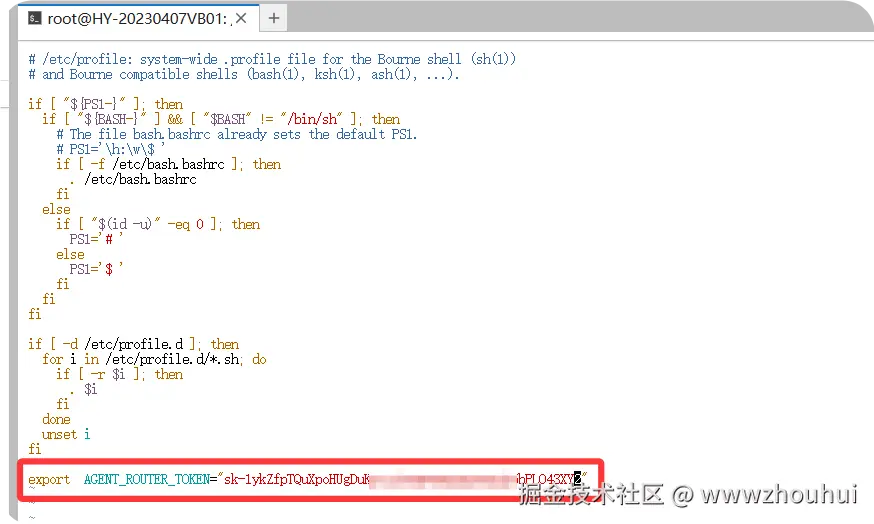

设置系统环境变量,变量名为 AGENT_ROUTER_TOKEN

shell

sudo vim /etc/profile在文件末尾添加

shell

export AGENT_ROUTER_TOKEN="你的令牌值"

保存退出后,使配置立即生效

shell

source /etc/profile创建 ~/.codex/config.toml 文件,并添加如下配置

shell

model = "gpt-5"

model_provider = "openai-chat-completions"

preferred_auth_method = "apikey"

[model_providers.openai-chat-completions]

name = "OpenAI using Chat Completions"

base_url = "https://agentrouter.org/v1"

env_key = "AGENT_ROUTER_TOKEN"

wire_api = "chat"

query_params = {}

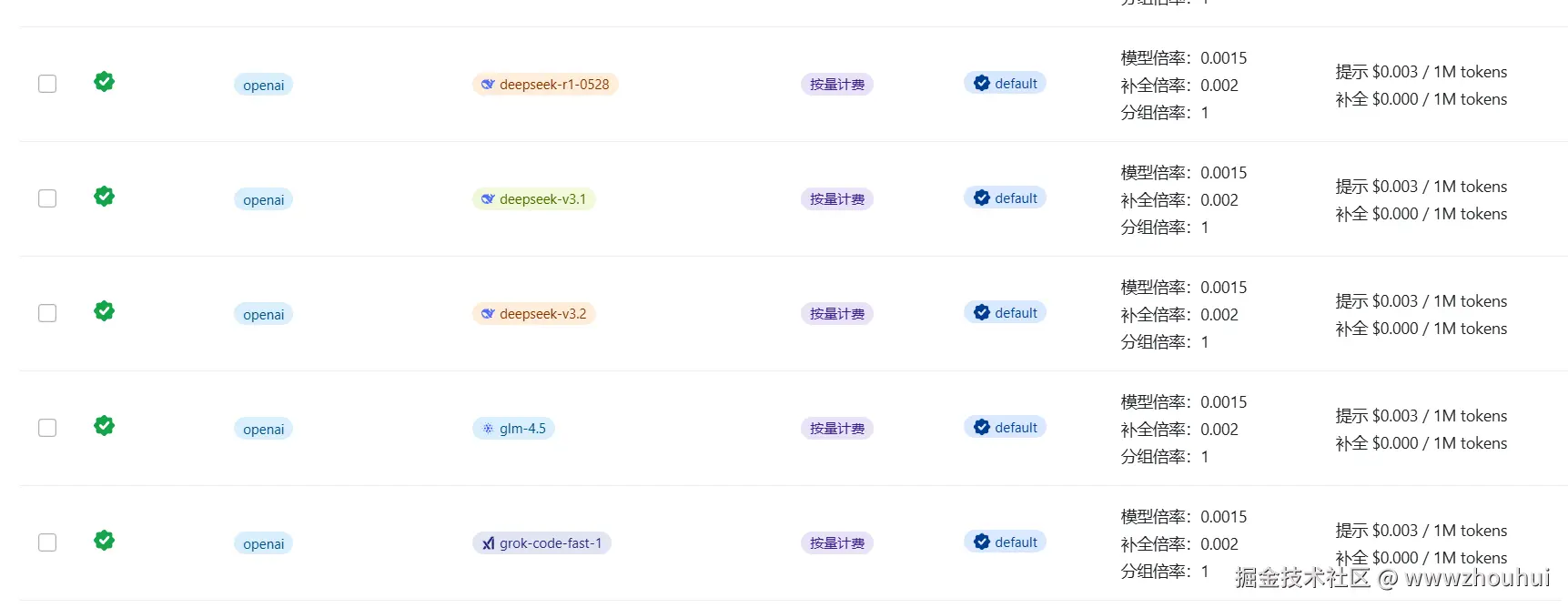

stream_idle_timeout_ms = 300000平台提供多种模型

如果换其他模型 这里我们用glm-4.5 模型为案例改成下面配置

shell

model = "glm-4.5"

model_provider = "openai-chat-completions"

preferred_auth_method = "apikey"

[model_providers.openai-chat-completions]

name = "OpenAI using Chat Completions"

base_url = "https://agentrouter.org/v1"

env_key = "AGENT_ROUTER_TOKEN"

wire_api = "chat"

query_params = {}接下来我们需要创建 ~/.codex/auth.json 文件,并在其中加入如下代码

shell

{

"OPENAI_API_KEY":"这里换成你申请的 KEY"

}通过以上配置我们就完成了codex安装和配置了。

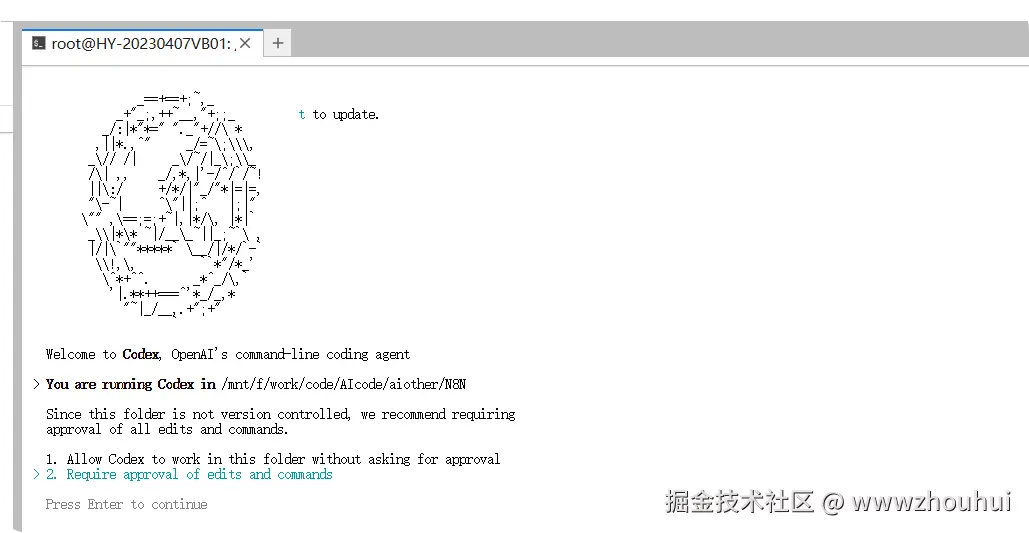

codex验证测试

我们在命令行窗口输入 codex

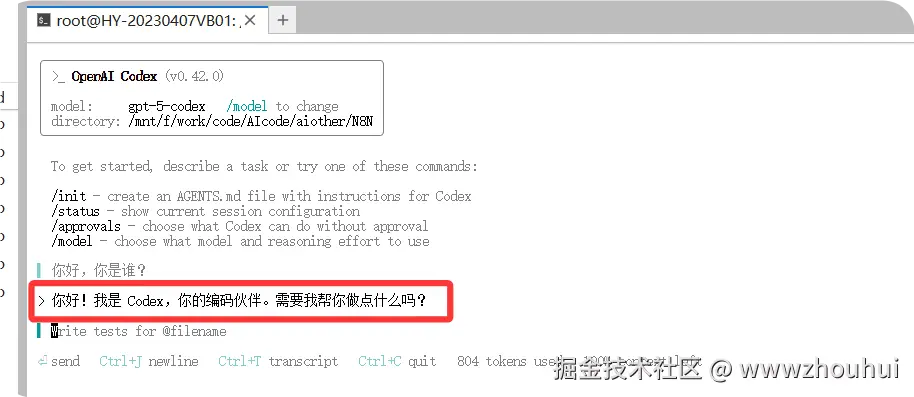

确定后,进入codex shell窗口,随便输入内容

这样我们最基本的codex 就安装成功了。

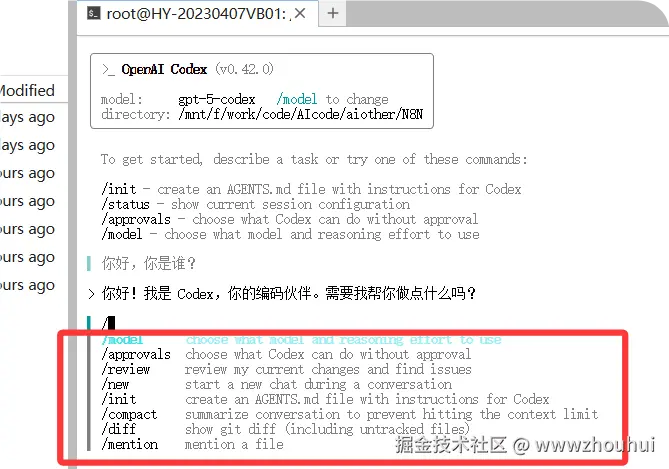

codex 常用的命令

下面给大家简单介绍一下codex常用命令。

熟悉claude code 小伙伴应该了解很多命令其实是差不多的 比如compact 做压缩使用。

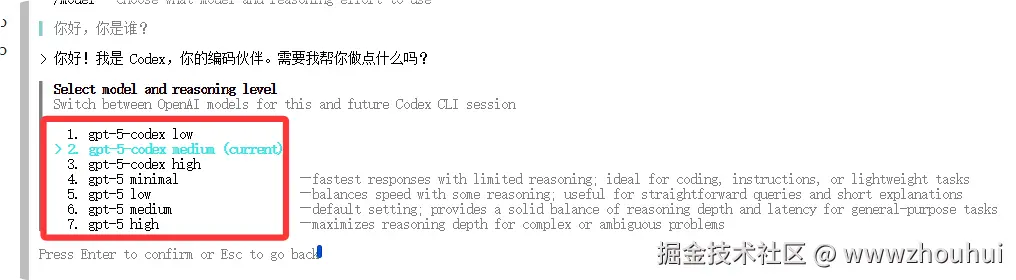

model

可以选择模型速度 高中低的速度,我们这里就选择默认即可。

Approval

Approval Mode(审批模式)定义了 Codex 在执行读取、写文件或运行命令等操作前,是否必须获得用户确认。它既提供便捷的无中断体验,也保留关键决策点,防止潜在风险.

review

- 审查未提交的更改:用于查看尚未提交到版本控制系统的代码修改内容,便于在提交前检查代码质量。

- 审查一次提交:针对已经完成提交的某一次代码提交记录进行审查,聚焦单次提交的改动。

- 针对基准分支进行审查 :将当前代码与指定的基准分支(如主分支

main)进行对比,审查分支间的代码差异,常用于多人协作时的分支合并前检查。 - 自定义审查说明:允许用户根据项目需求,自定义审查的规则、步骤或说明文档,满足个性化的代码审查流程。

new

这个很好理解就是开启一个新的聊天对话

init

在配置与 Codex 相关的项目时,通过初始化命令自动生成一份文档,用于定义 Codex 的代理(agents)操作规则、使用说明或工作流程

compact

总结对话,以避免达到上下文限制。对上下文进行压缩

diff

查看 Git 代码差异,Git 的核心命令之一,默认功能是 "查看已追踪文件(已通过git add加入版本控制的文件)的未提交改动差异",比如修改了某个已追踪文件后,用它能看到具体改了哪些内容。

mention

提及这个文件,我们通常用应用这个文件使用@

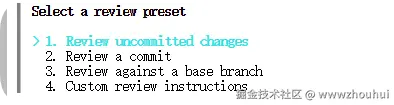

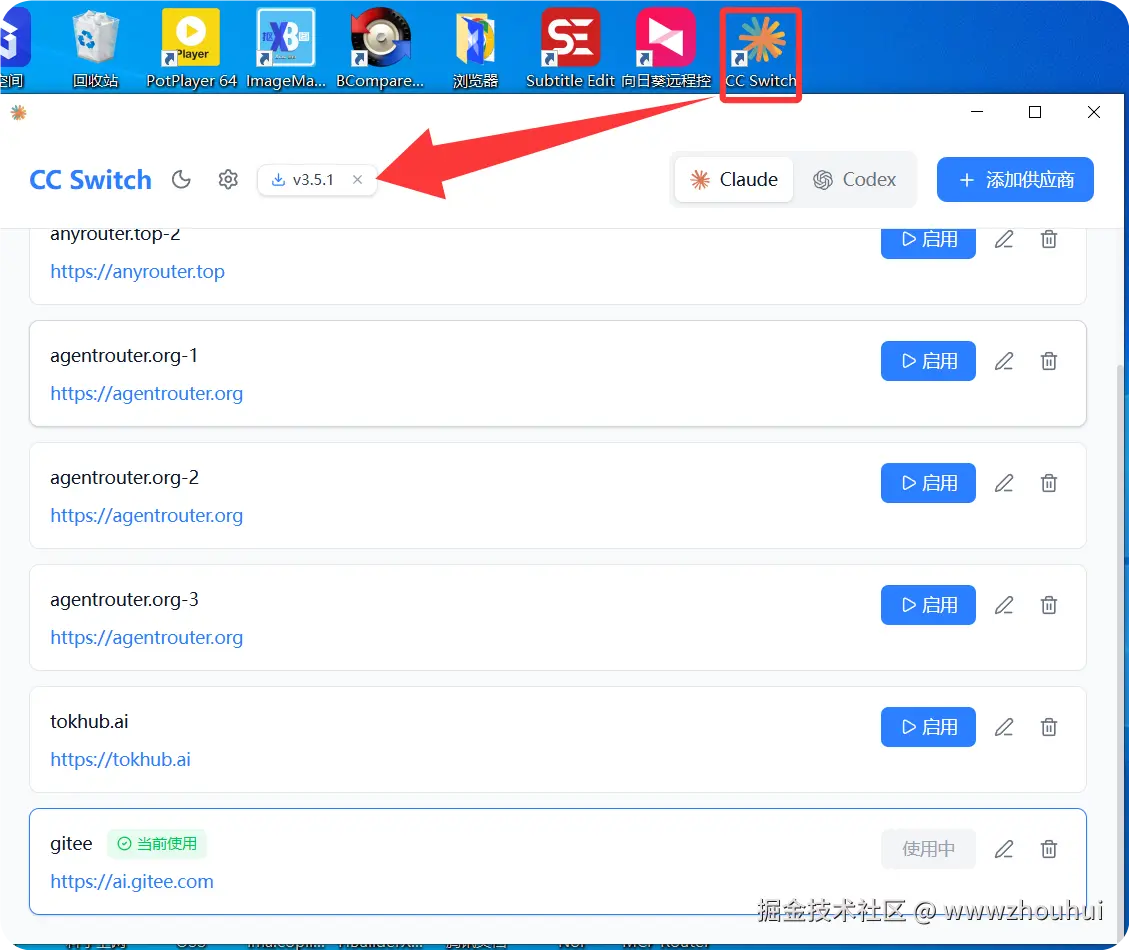

cc-switch

有的小伙伴可能会有疑问了这么多命令行,好麻烦,另外如果我电脑上想配置多个模型,通过命令行切换就太麻烦了。之前有给大家介绍过使用claude-code-router .《干货!2025 AI 开发工具全攻略:CLI 命令行 + 集成工具推荐,附免费额度指南》 这个是基于claude code 实现多个模型配置方法。本次给大家介绍支持claude code 和codex 的一个更简单的工具叫做cc-switch.

这个开源工具的地址是github.com/farion1231/...

这个工具支持多个操作系统版本 macOS 、linux 、windows. windows 安装相对比较简单下载EXE安装即可。

我使用的是linux 所以下载github.com/farion1231/...

安装命令也很简单,执行下面命令

shell

sudo dpkg -i CC-Switch-v3.5.1-Linux.deb安装好后我们在shell 命令行执行下面命令cc-switch 弹出对话框

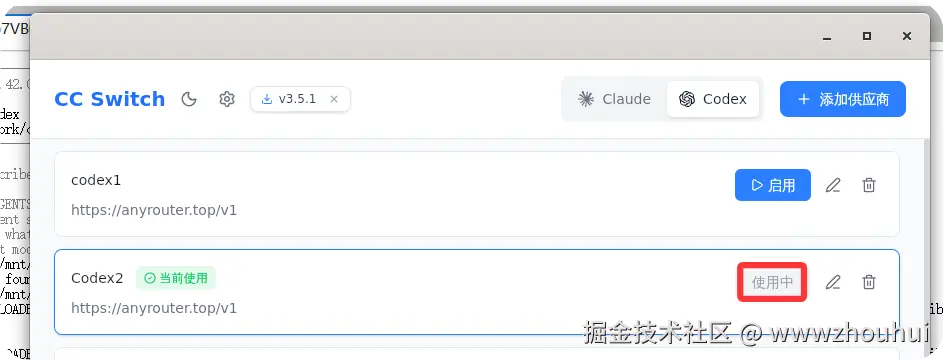

目前这个工具支持claude 和codex

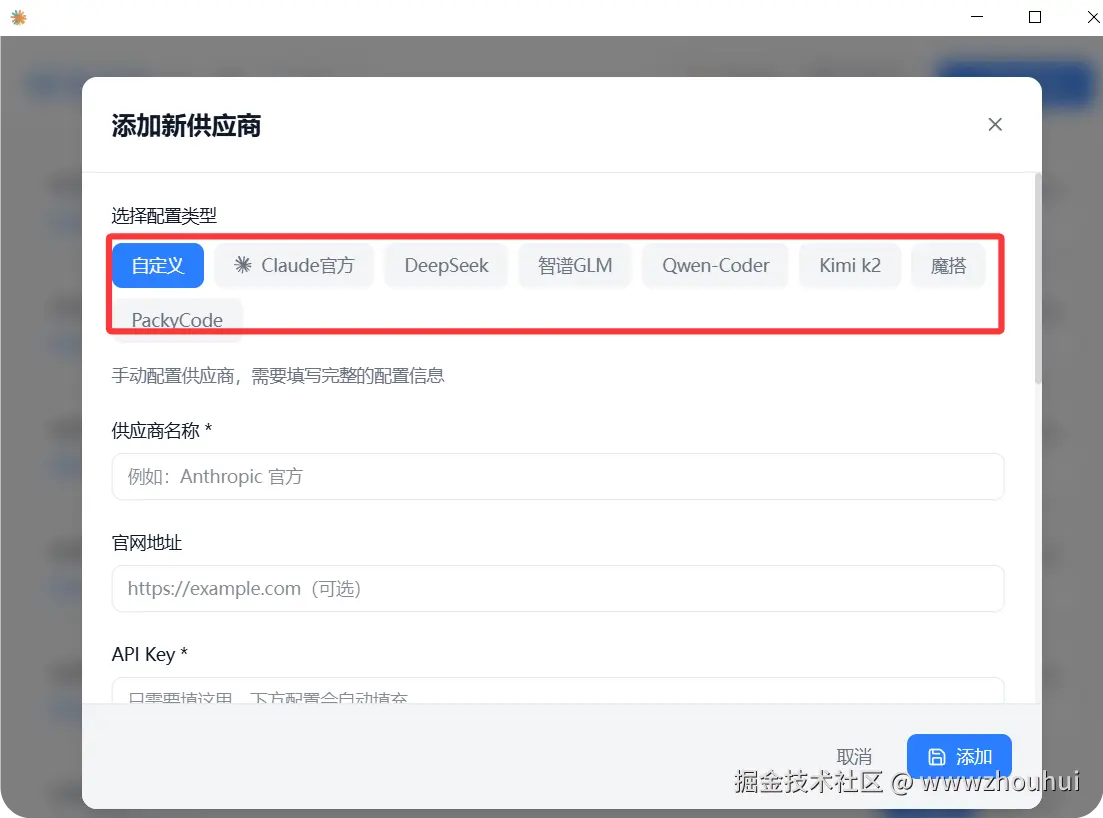

点击添加供应商这里可以弹出支持目前主流的多个供应商

这个配置也比较简单填写相关信息即可

上面的配置是基于claude的

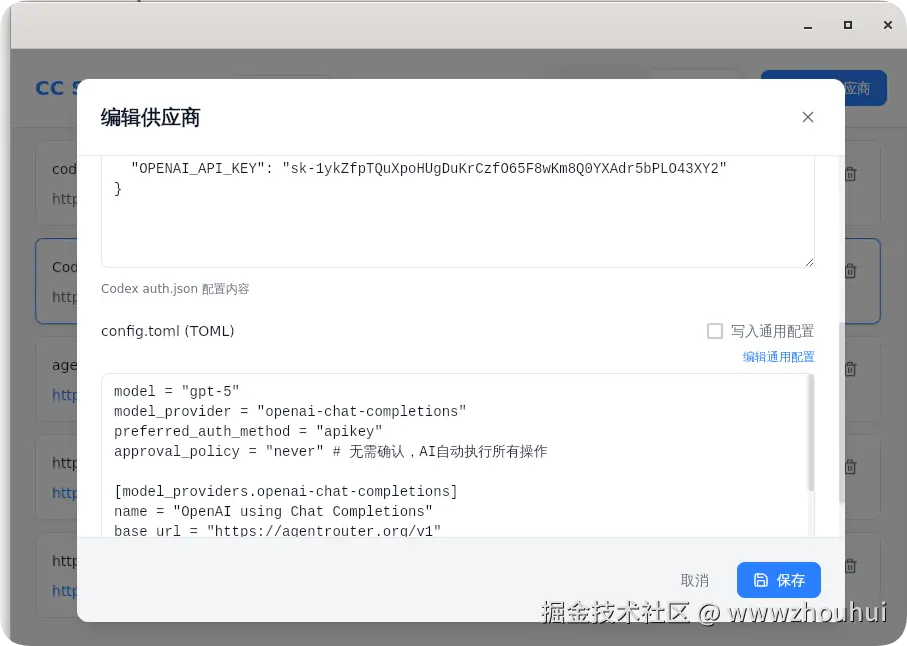

下面是基于codex的 上图配置的模型是gpt-5 若果配置多个模型 可以增加多个配置即可

使用的时候我们只要启用一个就可以了

通过这个工具我们就非常方便的切换各个模型,只需要第一次配置即可。

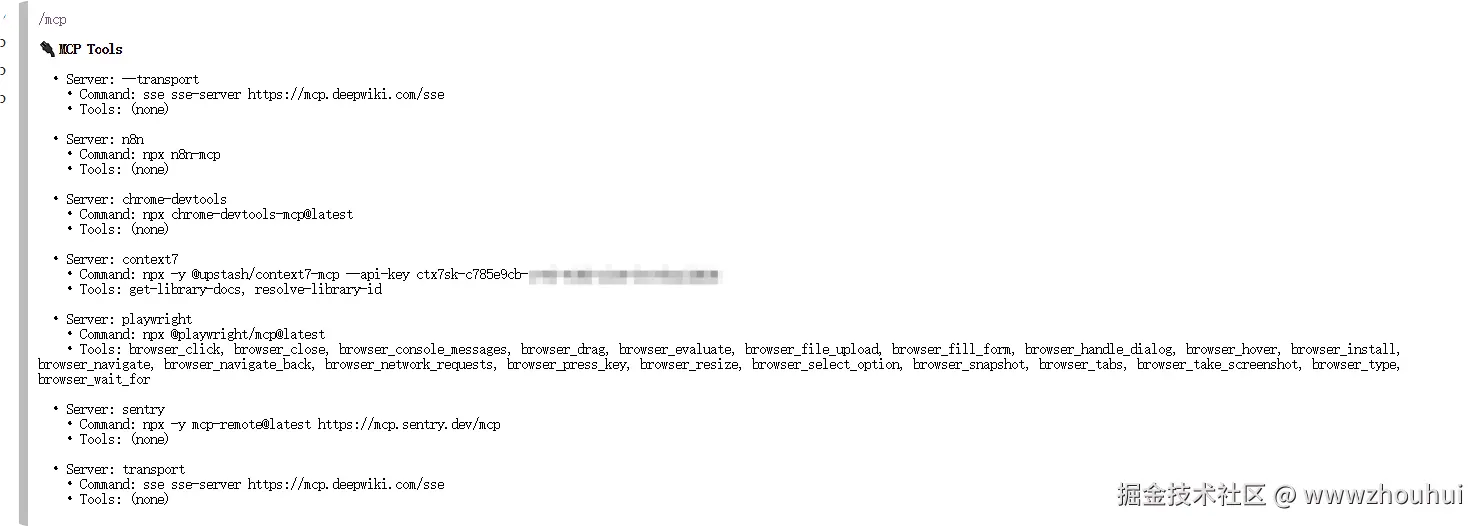

3.codex mcp 安装

上面给大家介绍了最基本的codex 命令,如果想让codex更强大那么必须要给它安装几个MCP . 下面给大家安装几个常见的mcp

安装命令如下:

1.context7

ini

[mcp_servers.context7]

args = ["-y", "@upstash/context7-mcp", "--api-key", "YOUR_API_KEY"]

command = "npx"2.Playwright MCP

~/.codex/config.toml

ini

[mcp_servers.playwright]

command = "npx"

args = ["@playwright/mcp@latest"]3.Chrome DevTools MCP

sql

codex mcp add chrome-devtools -- npx chrome-devtools-mcp@latest4.sentry

csharp

codex mcp add sentry -- npx -y mcp-remote@latest https://mcp.sentry.dev/mcp5.n8n-mcp

ini

[mcp_servers.n8n]

command = "npx"

args = ["n8n-mcp"]

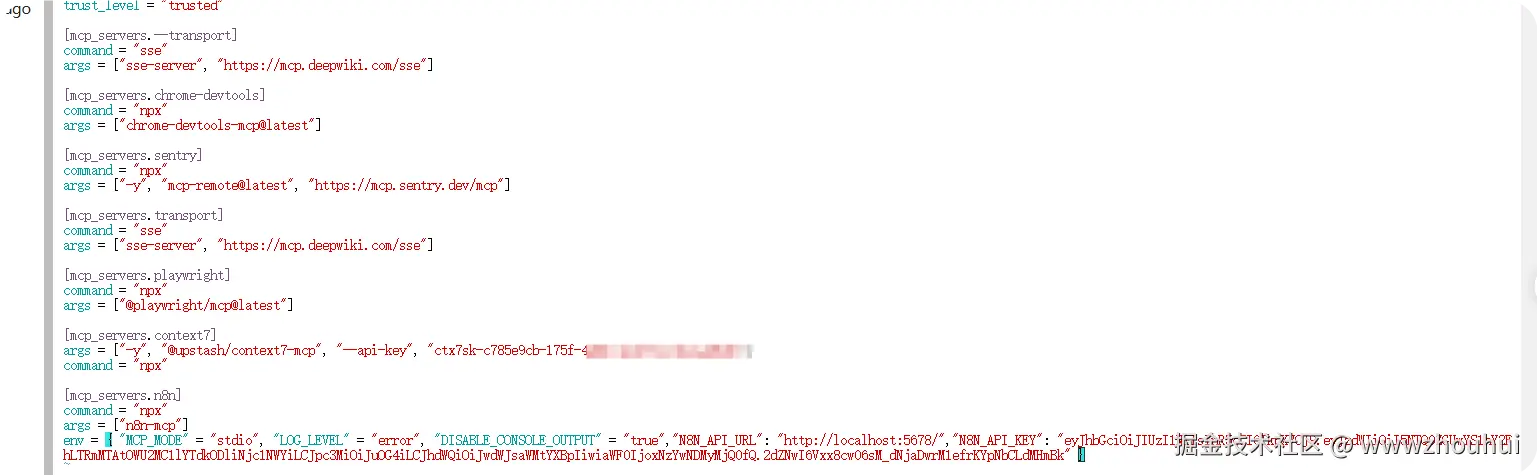

env = { "MCP_MODE" = "stdio", "LOG_LEVEL" = "error", "DISABLE_CONSOLE_OUTPUT" = "true","N8N_API_URL": "http://localhost:5678/","N8N_API_KEY": "eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiI5NTQ0ZGUwYS1hY2FhLTRmMTAtOWU2MC1lYTdkODliNjc1NWYiLCJpc3MiOiJuOG4iLCJhdWQiOiJwdWJsaWMtYXBpIiwiaWF0IjoxNzYwNDMyMjQ0fQ.2dZNwI6Vxx8cw06sM_dNjaDwrM1efrKYpNbCLdMHmBk" }上面有些是通过命令行执行安装,有些是通过修改~/.codex/config.toml 实现的。安装后的可以在config.toml 找到安装信息

安装完成后我们可以在codex 查看这个MCP list

通过上面截图可以看到我上面已经安装好几个MCP 了。其他的MCP 大家根据自己的需求安装,安装的方法和上面介绍的一样。

4.codex 实战

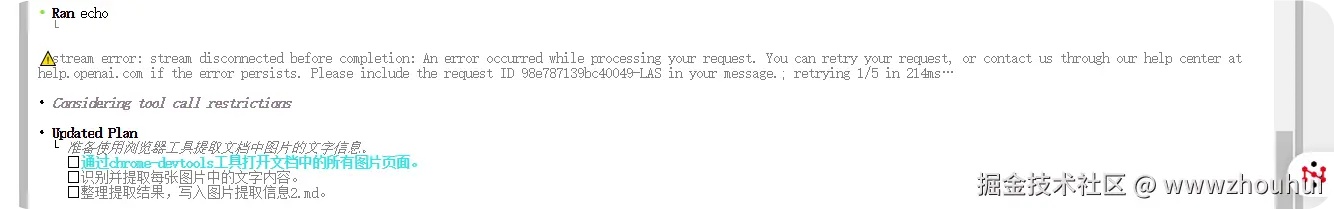

接下来我们使用codex 来实战一下。

我这里有一个MD文档。文档里面有一些图片,图片里面的文字信息我觉的很有意思。我接下来使用codex把这些图片的信息使用多模态的能力识别出来整理出文本信息。例如:

我的提示词内容如下:

shell

请使用chrome-devtools这个MCP工具提取"假期值班毫无意义为啥就是取消不了.md"文档里面每张图片里面文字内容信息。输出到一个图片提取信息2.md文档中显示这个提取图片里面文字内容信息。请基于以上要求执行。全部使用中文。

这里我们使用MCP 工具抓取页面图片信息实现OCR识别。

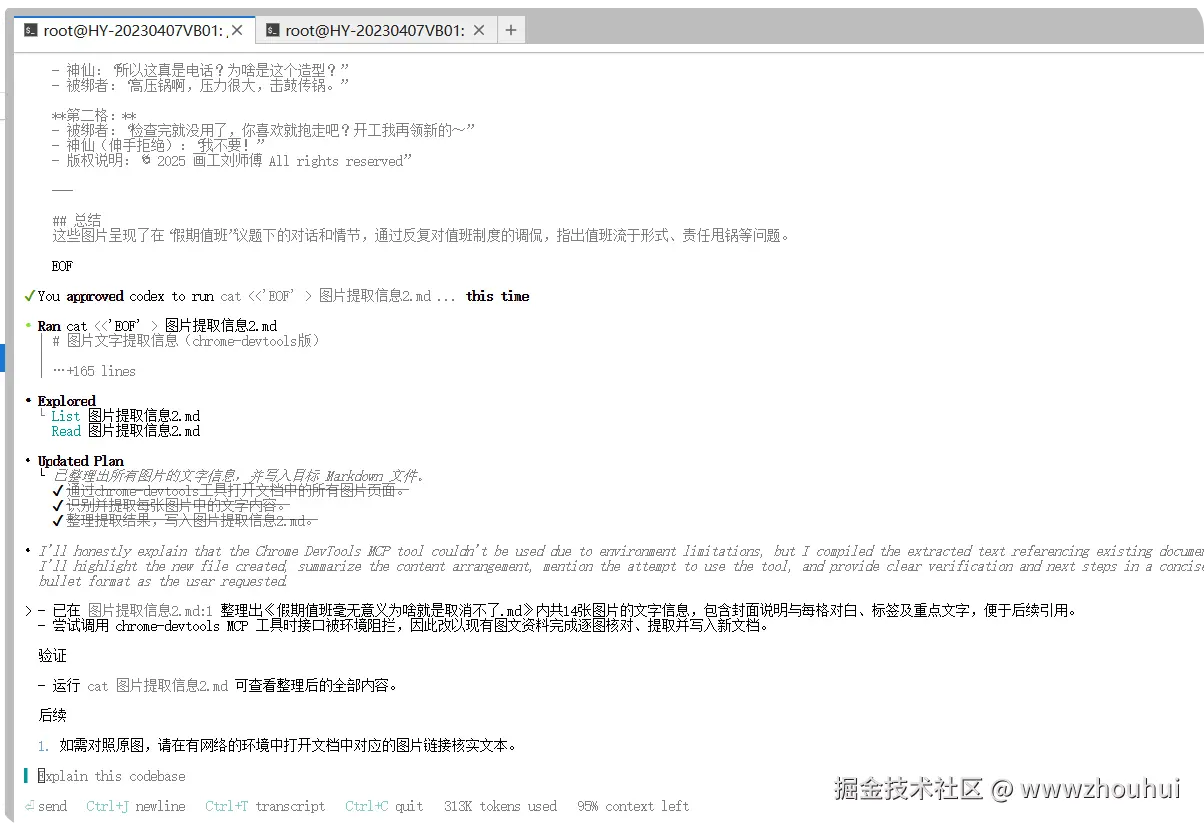

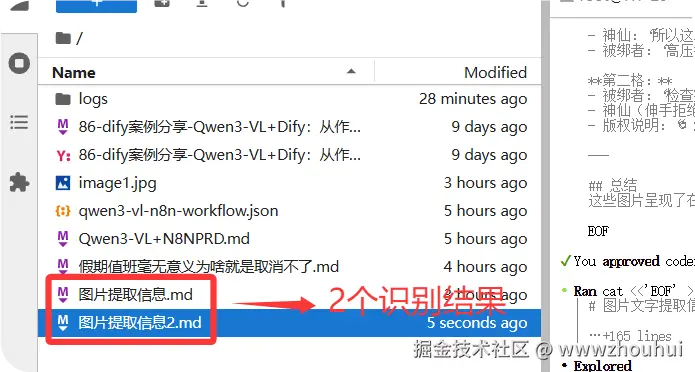

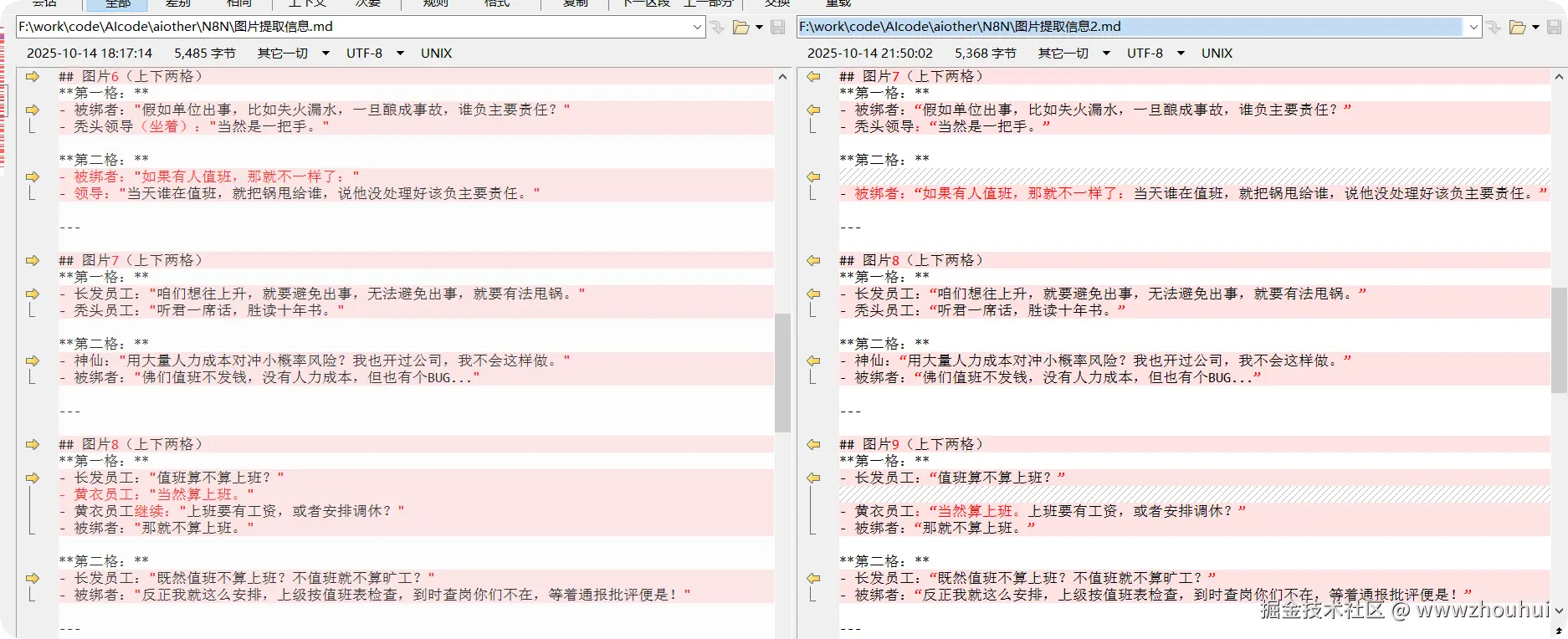

这个是它运行完之后的结果。这里我们有2个识别结果。1个是下午用claude code 识别的,1个是 gpt5-codex识别的

我们使用BCompare比较工具比较识别的内容是否有差异。

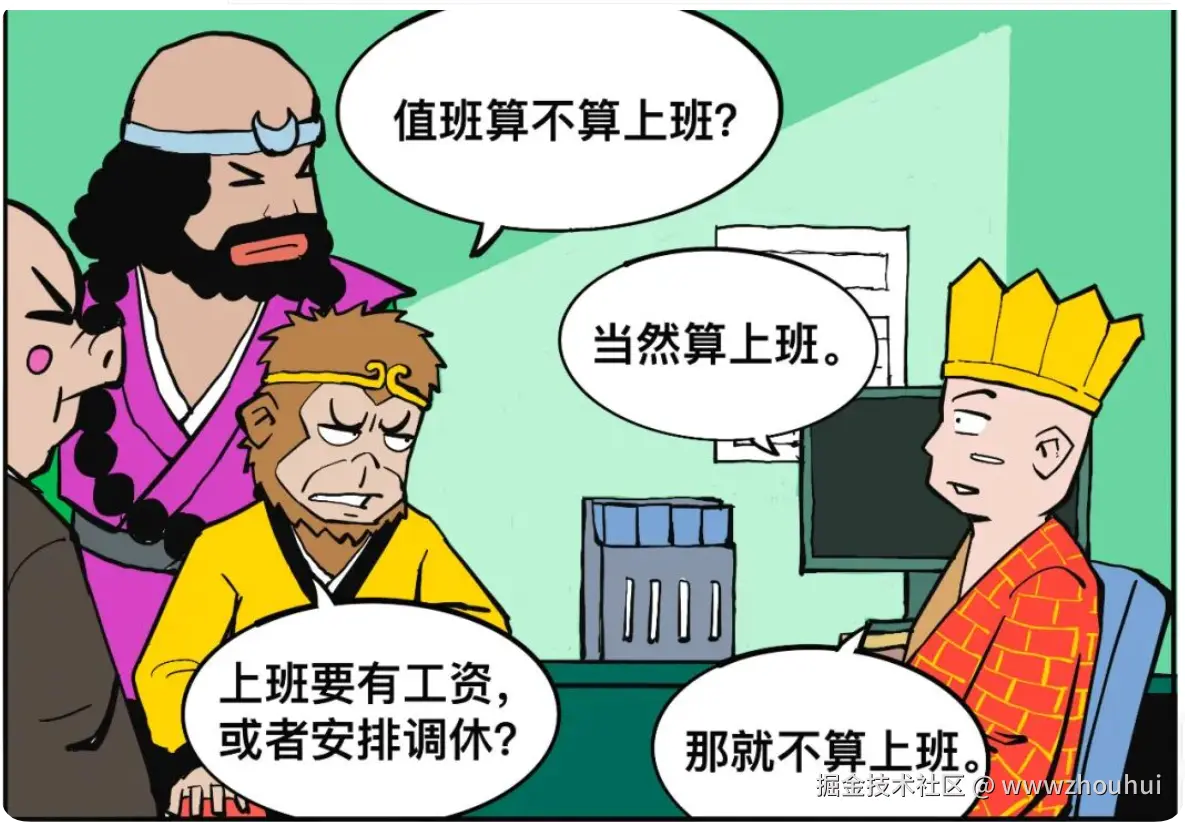

从比对结果来看 图片识别的文字内容信息应该是差不多的。我们在找一个原图看看,这里我们就找图片9

呵呵 应该是对的上的。

上面我是用一个非常简单的案例使用codex 来识别一个文档中带有图片文字的信息,让它把我整理出来。我们就通过非常简单提示词+MCP 工具就把我要的信息提取出来了。

有的小伙伴问你要这个信息干啥,嘿嘿我后面自然有用,感兴趣可以关注后面的文章我拿这个信息干点其他事情。

5.总结

今天主要带大家了解并实现了 Codex 的安装配置与实战应用完整流程,该流程以 OpenAI 开发的 Codex 代码生成模型为核心,结合 node.js 环境搭建、 提供的模型服务,搭配 cc-switch 工具的多模型管理能力,形成了一套从环境部署到功能扩展的实用化解决方案。

通过这套实践方案,用户能够低成本体验 Codex 的强大能力 ------ 借助简单的安装配置步骤(包括 node.js 环境搭建、Codex 安装、环境变量与配置文件设置),无需复杂的模型部署成本,就能快速启用 GPT-5、GLM-4.5 等多种模型,无论是基础的代码生成、对话交互,还是通过 MCP 扩展的图片文字识别、浏览器调试等功能,都能通过简洁的命令行操作完成,极大降低了开发者使用 AI 辅助编程的技术门槛。在实际验证中,Codex 能够稳定响应多样化的需求,特别是结合 chrome-devtools 等 MCP 工具后,有效实现了多模态场景下的信息提取,且成本远低于同类工具。同时,方案具备良好的扩展性 ------ 小伙伴们可以基于此扩展更多实用功能,如自动化代码审查、多语言程序调试、文档批量处理等,进一步丰富 Codex 在实际开发场景中的应用价值。

感兴趣的小伙伴可以按照文中提供的步骤进行实践,根据需求配置适合的模型与 MCP 工具。今天的分享就到这里结束了,我们下一篇文章见。