Wan

Wan

阿里巴巴通义实验室推出的 Wan 系列模型凭借突破性的技术架构与卓越的生成能力,成为行业关注的焦点。为助力开发者与创作者深挖视频生成技术潜力,魔多 AI 社区正式宣布全面支持通义万相 Wan2.1 与 Wan2.2 两款重磅视频模型的训练服务,为不同场景的创作需求提供专业级技术支撑。

在线训练支持 Wan 系列  Wan2.1

Wan2.1

Wan2.1 采用自研高效变分自编码器(VAE)与扩散时间变换器(DiT)的组合架构,创新性引入视频分块(Chunk)缓存机制,取代传统长视频端到端编解码模式,使显存占用与视频长度解耦,为无限长 1080P 视频的高效处理提供可能。DiT 架构中的时空全注意机制与参数共享策略,在精准捕捉复杂动态的同时,有效降低训练成本与计算需求,提升文本指令的理解精度。

Wan2.1 支持中文文字生成能力的视频模型,同时兼容中英文文字特效生成,视觉文字准确率达 92%。在动态模拟方面,模型突破传统视频生成的肢体扭曲问题,能稳定展现花样滑冰、跳水等复杂肢体运动,同时精准还原碰撞、反弹、流体流动等物理规律,雨滴溅落、物体切割等场景的真实感显著提升。在 VBench 基准测试中,其运动生成与视频准确度得分达 84.7%,彰显技术领先性。 Wan 2.2

Wan 2.2

继 Wan2.1 奠定基础后,通义实验室于 2025 年 7 月推出升级版本 Wan2.2,作为业界首个采用混合专家(MoE)架构的开源视频生成模型,全面接入通义 APP 并开放训练支持,将视频生成品质推向电影级水准。

训练数据集在 Wan2.1 基础上大幅扩容,图像数量增加 65%,视频片段数量增加 83%,且每个视频片段配备 20 余个电影级控制标签,涵盖照明条件、相机运动、颜色分级等专业维度,为精准控制提供数据支撑。

Wan2.2 的电影级品质使其在高端内容创作领域具备显著优势:影视行业可用于预可视化与场景扩展,快速生成符合导演风格的镜头素材;广告领域能通过精准美学控制打造品牌专属视觉语言;短视频创作者借助手机端通义 APP 即可化身 "AI 导演",生成具有专业质感的创意内容。此外,游戏 CG 制作、文化 IP 动态化等场景也能通过其复杂动态处理能力实现高效创新。

在线训练支持 Wan 系列  在线训练

在线训练

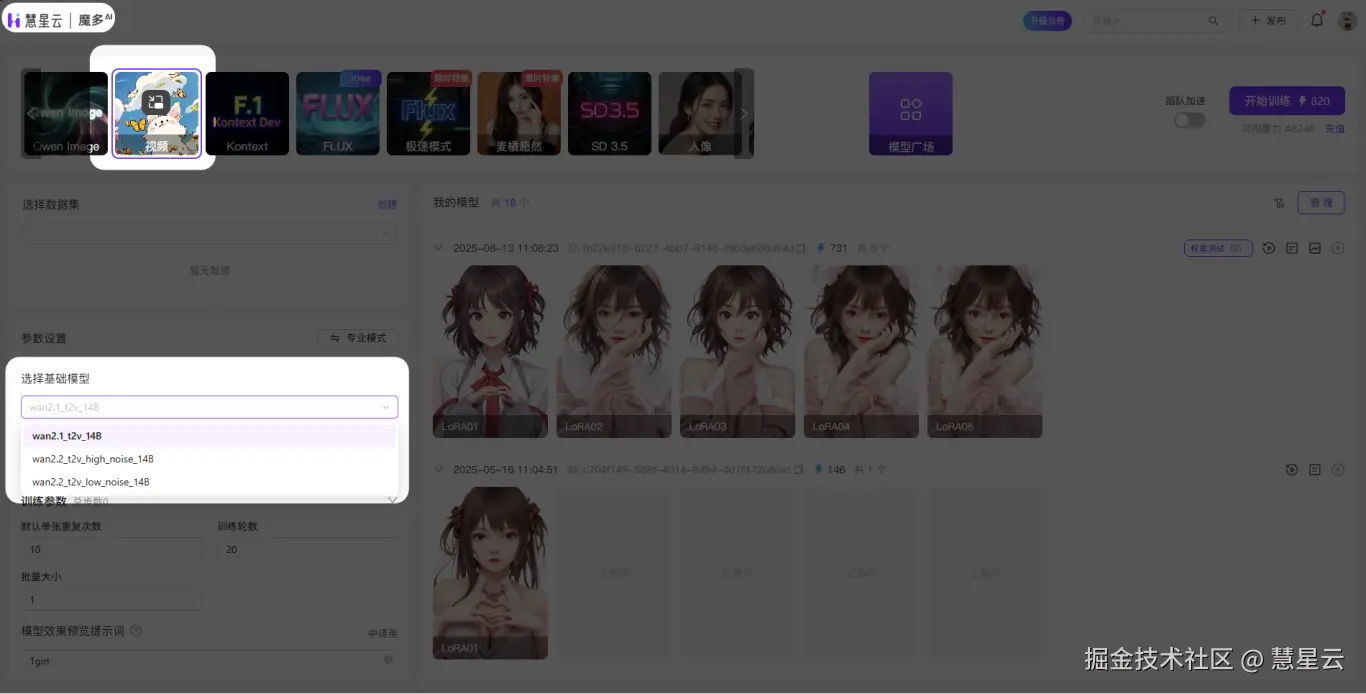

魔多 AI 社区依托成熟的算力调度体系与专业技术支持,为 Wan2.1 与 Wan2.2 模型提供全流程训练保障。

训练的步骤也十分简单。只需要在在线训练中选择好数据集再设置想要的训练步数后,你就可以训练出独属于你自己的Wan系列模型。

魔多 AI 社区将持续为开发者与创作者搭建高效技术桥梁,让 AI 视频创作的创意边界不断延伸。欢迎登录社区官网,解锁更多模型训练与应用可能!

魔多AI

专业AI创作平台,打通AI穿这个到商业变现全链路,赋能个人与企业级数字内容生产。