在云原生与智能化融合的进程中,越来越多的企业和开发者希望具备一套 自主可控、可离线运行的 AI 平台,能够本地运行大语言模型(LLM),并与企业内部系统安全集成。

现在,Open WebUI 扩展 已正式登陆 KubeSphere AI Labs。通过该扩展,用户可在 KubeSphere 环境中一键部署并运行 可完全自托管的智能对话与交互平台 ,打造安全可控的 AI 使用体验。无论是本地 Ollama 模型,还是远程 API 服务(如 OpenAI),都能统一管理和接入,为云原生场景提供灵活的智能化入口。

Open WebUI 简介

Open WebUI 是一个开源、功能丰富且用户友好的 自托管 AI 界面(User-friendly AI Interface)。

它支持多种 LLM 运行后端,如 Ollama 、OpenAI API 等,并内置 RAG(检索增强生成)引擎,让模型具备文档问答与知识增强能力。

简单来说,Open WebUI 是你的「私有 ChatGPT 界面」,帮助你在本地或云原生环境中轻松使用、集成和扩展大语言模型。

核心特性:

- 💻 离线可运行,完全自托管

- 🔌 支持 Ollama、本地模型与 OpenAI API

- 🧠 支持知识库与 RAG 检索增强

- 🧩 插件扩展体系(Tools / Functions)

- 🔐 多用户登录与 SSO 支持

- ⚡ 现代化界面设计,支持移动端访问

在 KubeSphere 中快速部署 Open WebUI

Open WebUI 已正式上架 KubeSphere 扩展中心(AI Labs) ,用户可通过控制台快速部署并体验。使用 KubeSphere 企业版 或 KubeSphere 社区版 ,均可通过控制台完成 Open WebUI 的快速安装部署。

值得一提的是,KubeSphere 社区版与企业版之间支持平滑迁移。用户在完成社区版部署后,仅需更换 License 即可升级为企业版,无需重新安装或中断现有服务。

通过 KubeSphere 控制台,你可以实现:

- ✅ 一键部署 Open WebUI 与 Ollama

- ✅ 支持 KubeSphere 账户登录(OIDC 集成)

- ✅ 无需命令行,开箱即用的 AI 体验

在正式部署 Open WebUI 前,请确保已部署可用的 KubeSphere 环境(详细安装文档请参考:👉 KubeSphere 安装指南)

一键安装步骤

1.快速部署 AI Labs

参考 AI Labs 快速开始指南 进行安装和初始化配置。

2.安装 Open WebUI 扩展

打开 KubeSphere 扩展中心,在控制台中搜索 Open WebUI,进入详情页后点击安装,根据提示完成初始化部署。

3.配置运行参数

配置 open-webui service 的暴露方式及访问地址

受限于本地环境,测试验证仅使用 deepseek-r1:1.5b 轻量本地模型,您可以根据环境规格借助 ollama 自行选择模型部署。

yaml

open-webui-helper:

openWebUIUrl: "http://172.31.19.4:32678" # Open WebUI 访问地址

open-webui:

ollama:

enabled: true

ollama:

models:

pull:

- deepseek-r1:1.5b

run:

- deepseek-r1:1.5b

service:

type: NodePort # 服务暴露方式,即 Open WebUI 访问地址

nodePort: "32678"⚠️ 注意:

- Open WebUI 扩展 v0.6.18 存在兼容问题,不支持 KubeSphere v4.1.x 。 请使用 v0.6.34 版本进行部署。

- 镜像与模型拉取速度较慢时,若安装失败,可等待完成后更新扩展配置以重新触发。

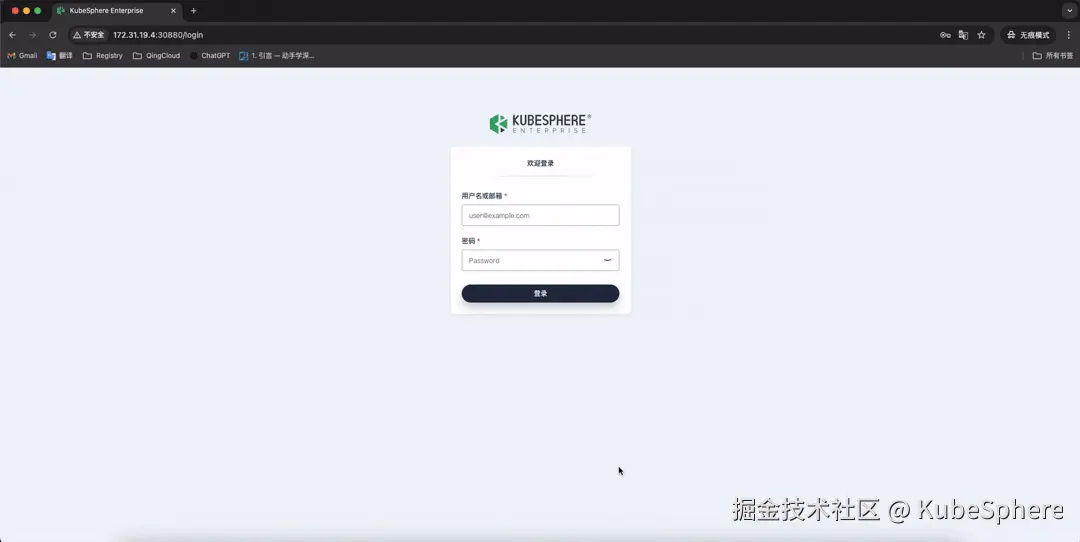

使用 KubeSphere 账户登录

Open WebUI 原生支持 OIDC(OpenID Connect) 协议,可与 KubeSphere 身份服务无缝集成,实现单点登录(SSO) 与多用户访问控制。

用户可通过配置使用 KubeSphere 账户登录,统一身份体系,简化管理流程。详细配置可查看 接入 KubeSphere 账户

Ollama 模型部署

Ollama 是一个开源的本地大语言模型(LLM)运行平台,可以轻松运行、管理和调用各种主流模型。常用模型包括 llama2/llama3、gemma、qwen2、deepseek 等。

通过在 Open WebUI 扩展组件中集成 Ollama,用户可直接在 KubeSphere 一键部署本地大模型服务,实现模型的私有化运行与灵活管理。

总结

Open WebUI 扩展 是一个开源、自托管的智能对话平台,支持本地模型(如 Ollama)与远程 API 接入。通过该扩展,用户可在 KubeSphere 环境中快速部署并构建安全可控的 ChatGPT 界面,实现灵活的 AI 应用与集成。

关于 KubeSphere AI Labs

本文是 KubeSphere AI Labs 推出的第二篇内容。AI Labs 是面向 KubeSphere 平台的智能扩展实验计划,致力于探索 "AI × 云原生" 的新边界,助力云原生智能化。