注:本文为 "线性代数 | 要义 / 本质" 相关重排增版。

如有内容异常,请看原文。

线性代数的本质(篇 2)

五、向量的点积和叉积

1. 点积

(1)代数定义

点积(Dot Product)适用于 n n n 维向量。设 n n n 维向量 u ⃗ = [ u 1 u 2 ... u n ] \vec{u} = \begin{bmatrix} u_1 \\ u_2 \\ \dots \\ u_n \end{bmatrix} u = u1u2...un 与 v ⃗ = [ v 1 v 2 ... v n ] \vec{v} = \begin{bmatrix} v_1 \\ v_2 \\ \dots \\ v_n \end{bmatrix} v = v1v2...vn ,其点积定义为:

u ⃗ ⋅ v ⃗ = u 1 v 1 + u 2 v 2 + ⋯ + u n v n \vec{u} \cdot \vec{v} = u_1v_1 + u_2v_2 + \dots + u_nv_n u ⋅v =u1v1+u2v2+⋯+unvn

以二维向量为例,若 v ⃗ = [ a b ] \vec{v} = \begin{bmatrix} a \\ b \end{bmatrix} v =[ab]、 w ⃗ = [ c d ] \vec{w} = \begin{bmatrix} c \\ d \end{bmatrix} w =[cd],则 v ⃗ ⋅ w ⃗ = a c + b d \vec{v} \cdot \vec{w} = ac + bd v ⋅w =ac+bd。

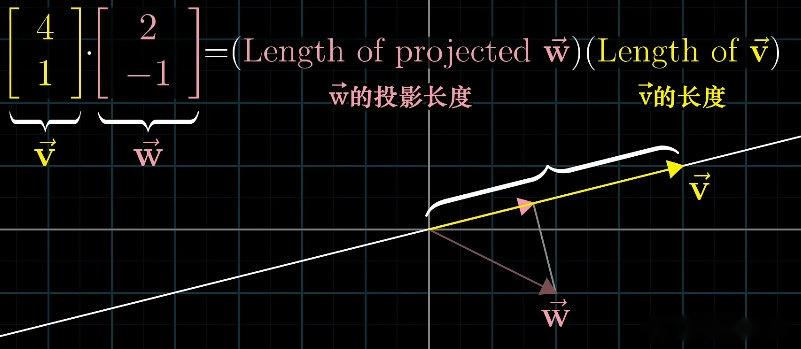

(2)几何意义

在二维或三维空间中,点积的几何意义可通过模长与夹角关联,公式为:

u ⃗ ⋅ v ⃗ = ∥ u ⃗ ∥ ⋅ ∥ v ⃗ ∥ ⋅ cos θ \vec{u} \cdot \vec{v} = \|\vec{u}\| \cdot \|\vec{v}\| \cdot \cos\theta u ⋅v =∥u ∥⋅∥v ∥⋅cosθ

其中 ∥ u ⃗ ∥ \|\vec{u}\| ∥u ∥、 ∥ v ⃗ ∥ \|\vec{v}\| ∥v ∥ 分别为 u ⃗ \vec{u} u 、 v ⃗ \vec{v} v 的模长, θ \theta θ 为两向量的夹角。

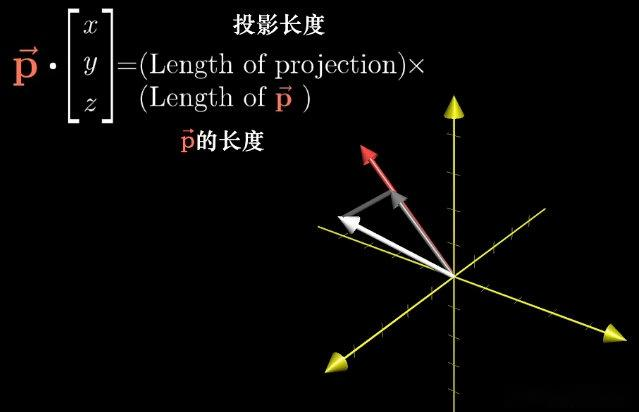

- 若 ∥ u ⃗ ∥ = 1 \|\vec{u}\| = 1 ∥u ∥=1(单位向量),则 u ⃗ ⋅ v ⃗ \vec{u} \cdot \vec{v} u ⋅v 等于 v ⃗ \vec{v} v 在 u ⃗ \vec{u} u 方向上的正交投影长度;

- 点积符号反映向量方向关系: θ < 9 0 ∘ \theta < 90^\circ θ<90∘ 时为正, θ = 9 0 ∘ \theta = 90^\circ θ=90∘ 时为 0 0 0(垂直), θ > 9 0 ∘ \theta > 90^\circ θ>90∘ 时为负。

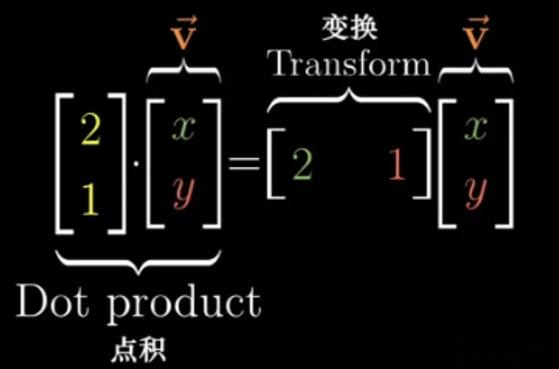

(3)与线性变换的关系

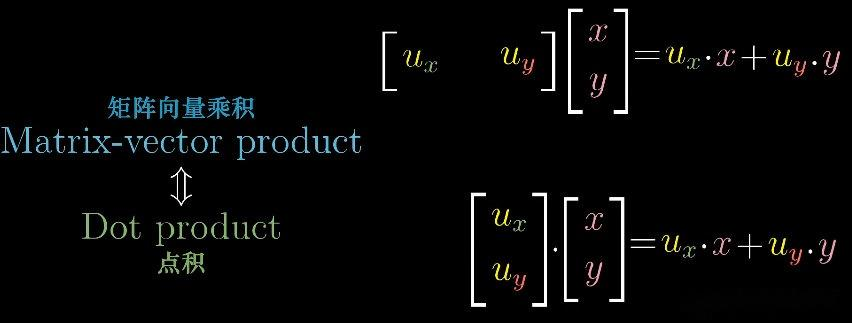

点积等价于" n n n 维向量到一维标量"的线性变换:

- 对固定向量 u ⃗ \vec{u} u ,定义变换 L ( v ⃗ ) = u ⃗ ⋅ v ⃗ L(\vec{v}) = \vec{u} \cdot \vec{v} L(v )=u ⋅v ,该变换满足线性性(可加性、齐次性);

- 变换对应的矩阵为 1 × n 1 \times n 1×n 矩阵 [ u 1 u 2 ... u n ] \begin{bmatrix} u_1 & u_2 & \dots & u_n \end{bmatrix} [u1u2...un],即 L ( v ⃗ ) = [ u 1 u 2 ... u n ] [ v 1 v 2 ... v n ] L(\vec{v}) = \begin{bmatrix} u_1 & u_2 & \dots & u_n \end{bmatrix} \begin{bmatrix} v_1 \\ v_2 \\ \dots \\ v_n \end{bmatrix} L(v )=[u1u2...un] v1v2...vn 。

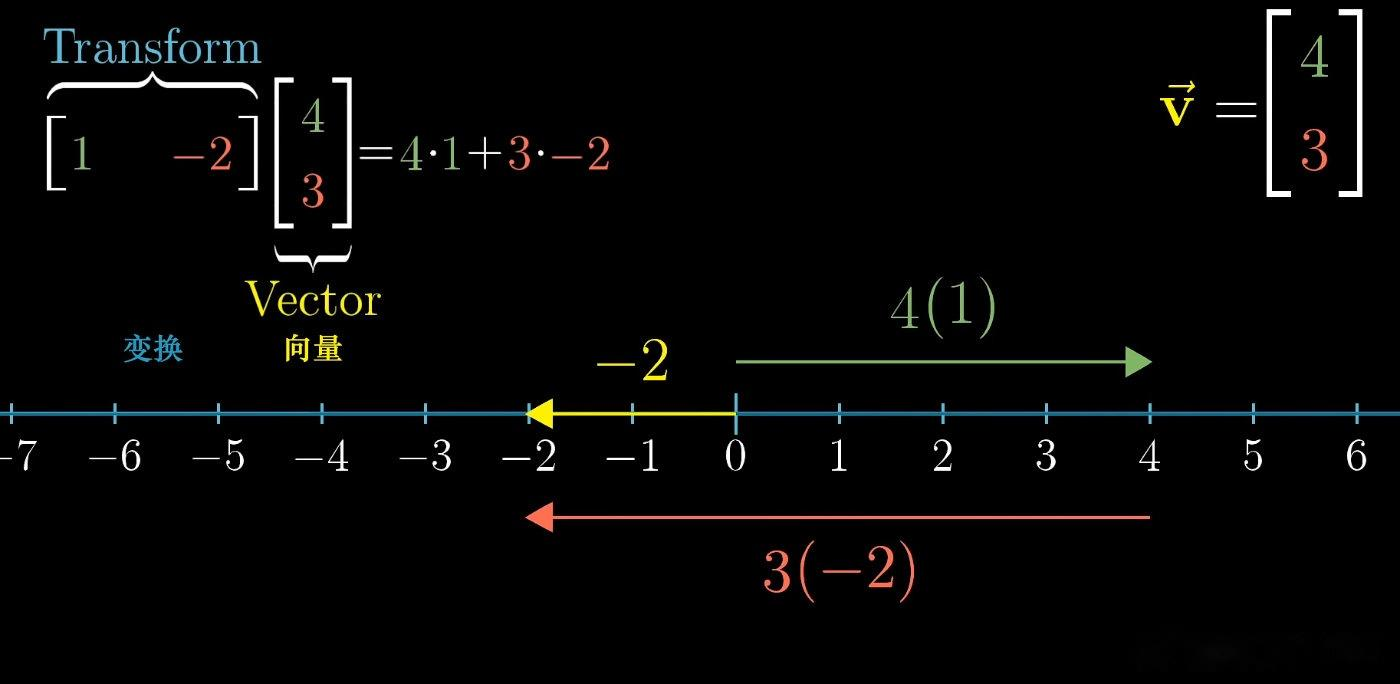

示例:设线性变换 L L L 将二维基向量 i ⃗ \vec{i} i 映射到 1 1 1、 j ⃗ \vec{j} j 映射到 − 2 -2 −2,则变换矩阵为 [ 1 − 2 ] \begin{bmatrix} 1 & -2 \end{bmatrix} [1−2];对向量 [ 4 3 ] \begin{bmatrix} 4 \\ 3 \end{bmatrix} [43],变换结果为 4 × 1 + 3 × ( − 2 ) = − 2 4 \times 1 + 3 \times (-2) = -2 4×1+3×(−2)=−2,与点积 [ 1 − 2 ] ⋅ [ 4 3 ] \begin{bmatrix} 1 & -2 \end{bmatrix} \cdot \begin{bmatrix} 4 \\ 3 \end{bmatrix} [1−2]⋅[43] 一致。

点积等同于特定形式的矩阵向量乘积:

u ⋅ v = u T v = s \mathbf{u} \cdot \mathbf{v} = \mathbf{u}^T \mathbf{v} = s u⋅v=uTv=s

s s s 是一个标量。

需将其中一个 n n n 维列向量转置为 1 × n 1 \times n 1×n 矩阵,此时二者的矩阵乘法结果与点积结果一致,可将 n n n 维向量变换为一维标量,该变换矩阵(即转置后的 1 × n 1 \times n 1×n 矩阵)为非方阵。

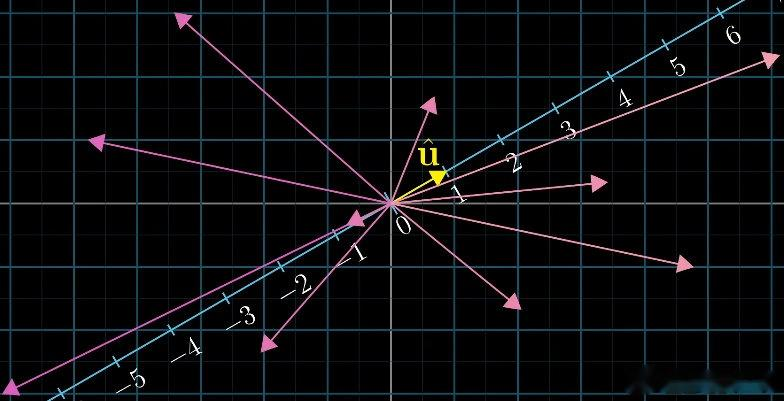

2. 投影变换与对偶性

(1)投影变换的定义与矩阵构造

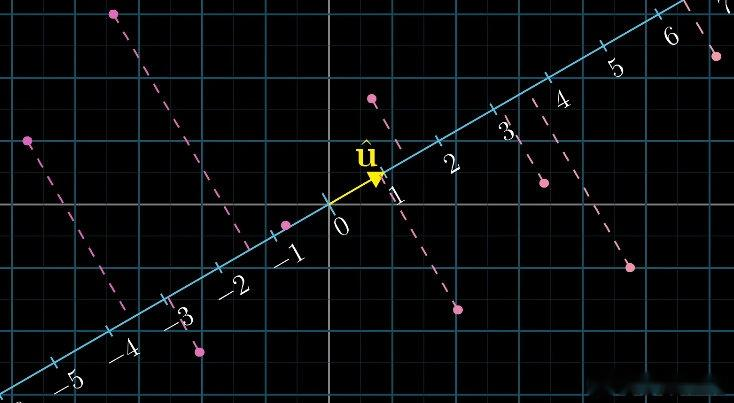

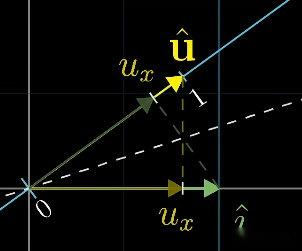

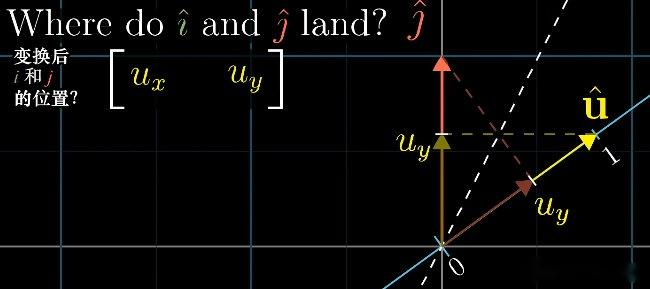

二维空间中,若数轴方向与单位向量 u ⃗ = [ u x u y ] \vec{u} = \begin{bmatrix} u_x & u_y \end{bmatrix} u =[uxuy] 一致,将二维向量投影到该数轴的操作称为投影变换,对应的矩阵为 1 × 2 1 \times 2 1×2 非方阵。

设投影矩阵为 P = [ a b ] P = \begin{bmatrix} a & b \end{bmatrix} P=[ab],其中 a a a、 b b b 分别为基向量 i ⃗ \vec{i} i 、 j ⃗ \vec{j} j 投影到数轴后的数值;

由对称性可知, i ⃗ \vec{i} i 在 u ⃗ \vec{u} u 上的投影等于 u ⃗ \vec{u} u 的横坐标 u x u_x ux, j ⃗ \vec{j} j 的投影等于 u ⃗ \vec{u} u 的纵坐标 u y u_y uy;

因此投影矩阵 P = [ u x u y ] P = \begin{bmatrix} u_x & u_y \end{bmatrix} P=[uxuy],投影变换为 P v ⃗ = u x x + u y y P\vec{v} = u_x x + u_y y Pv =uxx+uyy。

(2)对偶性的含义

对偶性(Duality)指"多维空间到一维空间的线性变换"与"多维空间中的向量"存在自然对应关系:

-

投影变换的结果( P v ⃗ P\vec{v} Pv )与向量 v ⃗ \vec{v} v 与 u ⃗ \vec{u} u 的点积( v ⃗ ⋅ u ⃗ = u x x + u y y \vec{v} \cdot \vec{u} = u_x x + u_y y v ⋅u =uxx+uyy)完全一致;

-

对任意 n n n 维到一维的线性变换 L L L,存在唯一 n n n 维向量 u ⃗ \vec{u} u ,使得 L ( v ⃗ ) = u ⃗ ⋅ v ⃗ L(\vec{v}) = \vec{u} \cdot \vec{v} L(v )=u ⋅v ( u ⃗ \vec{u} u 称为变换的对偶向量);

-

示例:"二维到一维的投影变换"的对偶向量为投影方向的单位向量 u ⃗ \vec{u} u ,若 u ⃗ \vec{u} u 为非单位向量,投影结果则等同于向量与 u ⃗ \vec{u} u 的点积(先投影再按 u ⃗ \vec{u} u 长度缩放)。

3. 叉积

(1)代数定义与记忆方式

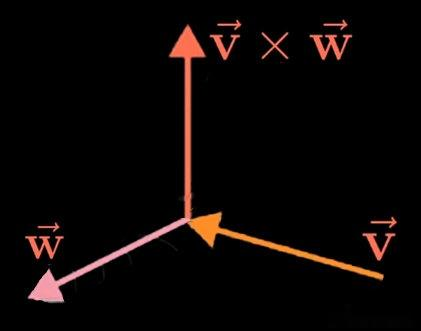

叉积(Cross Product)适用于三维向量。设三维向量 v ⃗ = [ v 1 v 2 v 3 ] \vec{v} = \begin{bmatrix} v_1 \\ v_2 \\ v_3 \end{bmatrix} v = v1v2v3 与 w ⃗ = [ w 1 w 2 w 3 ] \vec{w} = \begin{bmatrix} w_1 \\ w_2 \\ w_3 \end{bmatrix} w = w1w2w3 ,其叉积定义为:

v ⃗ × w ⃗ = [ v 2 w 3 − v 3 w 2 v 3 w 1 − v 1 w 3 v 1 w 2 − v 2 w 1 ] \vec{v} \times \vec{w} = \begin{bmatrix} v_2 w_3 - v_3 w_2 \\ v_3 w_1 - v_1 w_3 \\ v_1 w_2 - v_2 w_1 \end{bmatrix} v ×w = v2w3−v3w2v3w1−v1w3v1w2−v2w1

可通过三阶行列式辅助记忆,其中 i ⃗ \vec{i} i 、 j ⃗ \vec{j} j 、 k ⃗ \vec{k} k 为三维标准基向量:

v ⃗ × w ⃗ = ∣ i ⃗ j ⃗ k ⃗ v 1 v 2 v 3 w 1 w 2 w 3 ∣ \vec{v} \times \vec{w} = \begin{vmatrix} \vec{i} & \vec{j} & \vec{k} \\ v_1 & v_2 & v_3 \\ w_1 & w_2 & w_3 \end{vmatrix} v ×w = i v1w1j v2w2k v3w3

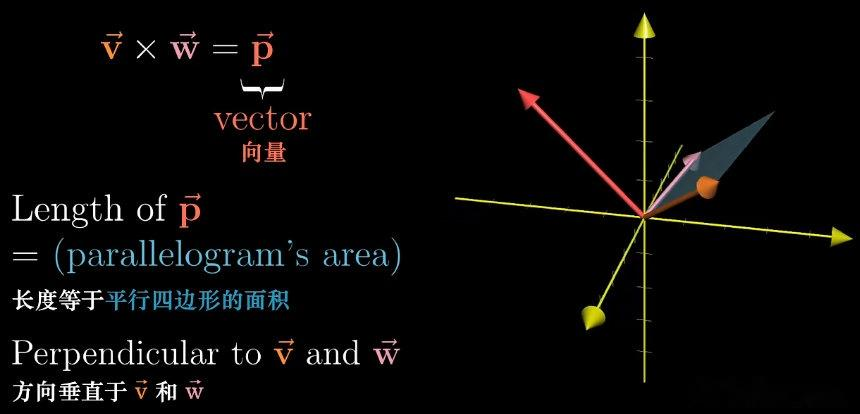

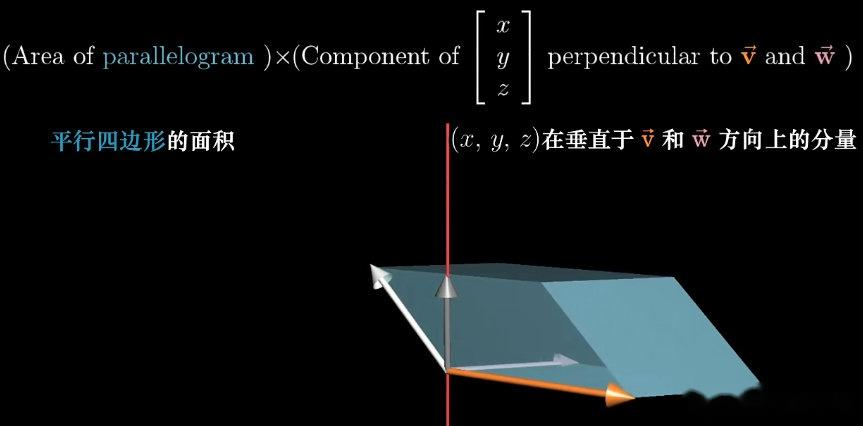

(2)几何意义

-

叉积结果为向量,且该向量垂直于 v ⃗ \vec{v} v 与 w ⃗ \vec{w} w 所构成的平面;

-

叉积向量的模长等于 v ⃗ \vec{v} v 与 w ⃗ \vec{w} w 所构成平行四边形的面积,公式为 ∥ v ⃗ × w ⃗ ∥ = ∥ v ⃗ ∥ ⋅ ∥ w ⃗ ∥ ⋅ sin θ \|\vec{v} \times \vec{w}\| = \|\vec{v}\| \cdot \|\vec{w}\| \cdot \sin\theta ∥v ×w ∥=∥v ∥⋅∥w ∥⋅sinθ( θ \theta θ 为两向量夹角)。

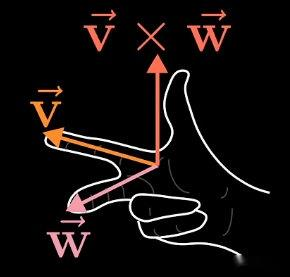

(3)方向判断与运算性质

-

方向判断:采用右手定则,右手食指指向 v ⃗ \vec{v} v 方向,中指指向 w ⃗ \vec{w} w 方向,大拇指指向即为 v ⃗ × w ⃗ \vec{v} \times \vec{w} v ×w 的方向;

-

运算性质:不满足交换律,即 v ⃗ × w ⃗ = − w ⃗ × v ⃗ \vec{v} \times \vec{w} = -\vec{w} \times \vec{v} v ×w =−w ×v ;满足线性性,如 k v ⃗ × w ⃗ = k ( v ⃗ × w ⃗ ) k\vec{v} \times \vec{w} = k(\vec{v} \times \vec{w}) kv ×w =k(v ×w )、 ( u ⃗ + v ⃗ ) × w ⃗ = u ⃗ × w ⃗ + v ⃗ × w ⃗ (\vec{u} + \vec{v}) \times \vec{w} = \vec{u} \times \vec{w} + \vec{v} \times \vec{w} (u +v )×w =u ×w +v ×w ;

-

共线条件: v ⃗ × w ⃗ = 0 ⃗ \vec{v} \times \vec{w} = \vec{0} v ×w =0 的充要条件为 v ⃗ \vec{v} v 与 w ⃗ \vec{w} w 共线( θ = 0 ∘ \theta = 0^\circ θ=0∘ 或 18 0 ∘ 180^\circ 180∘)。

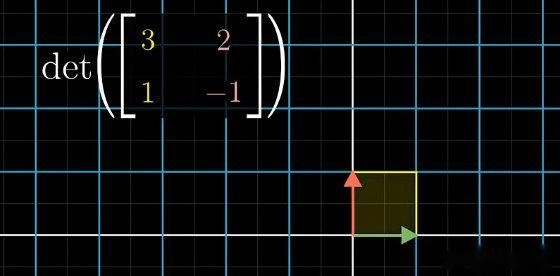

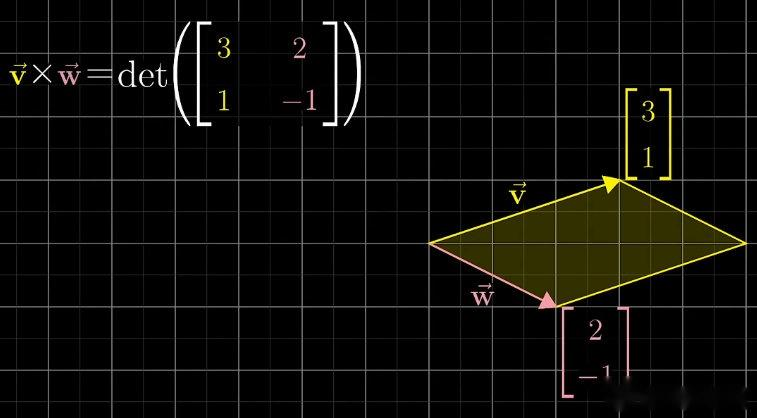

(4)与行列式的关系

-

二维向量 v ⃗ = [ a b ] \vec{v} = \begin{bmatrix} a \\ b \end{bmatrix} v =[ab] 与 w ⃗ = [ c d ] \vec{w} = \begin{bmatrix} c \\ d \end{bmatrix} w =[cd] 构成矩阵 [ a c b d ] \begin{bmatrix} a & c \\ b & d \end{bmatrix} [abcd],其行列式 det ( [ a c b d ] ) = a d − b c \det\left( \begin{bmatrix} a & c \\ b & d \end{bmatrix} \right) = ad - bc det([abcd])=ad−bc,绝对值等于两向量构成平行四边形的面积,符号反映空间定向;

-

三维向量的叉积模长,可通过"将 v ⃗ \vec{v} v 、 w ⃗ \vec{w} w 视为基向量构成矩阵,其行列式绝对值即为平行四边形面积"理解。

-

叉积不满足交换律,即 v ⃗ × w ⃗ = − w ⃗ × v ⃗ \vec{v} \times \vec{w} = -\vec{w} \times \vec{v} v ×w =−w ×v 。

4. 叉积与体积(混合积)

(1)平行六面体体积的计算

三个三维向量 u ⃗ \vec{u} u 、 v ⃗ \vec{v} v 、 w ⃗ \vec{w} w 所构成平行六面体的体积,等于这三个向量构成的三阶矩阵的行列式绝对值,也等于混合积 u ⃗ ⋅ ( v ⃗ × w ⃗ ) \vec{u} \cdot (\vec{v} \times \vec{w}) u ⋅(v ×w ) 的绝对值:

体积 = ∣ det ( [ u 1 v 1 w 1 u 2 v 2 w 2 u 3 v 3 w 3 ] ) ∣ = ∣ u ⃗ ⋅ ( v ⃗ × w ⃗ ) ∣ \text{体积} = \left| \det\left( \begin{bmatrix} u_1 & v_1 & w_1 \\ u_2 & v_2 & w_2 \\ u_3 & v_3 & w_3 \end{bmatrix} \right) \right| = \left| \vec{u} \cdot (\vec{v} \times \vec{w}) \right| 体积= det u1u2u3v1v2v3w1w2w3 =∣u ⋅(v ×w )∣

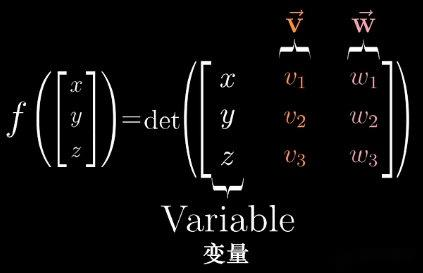

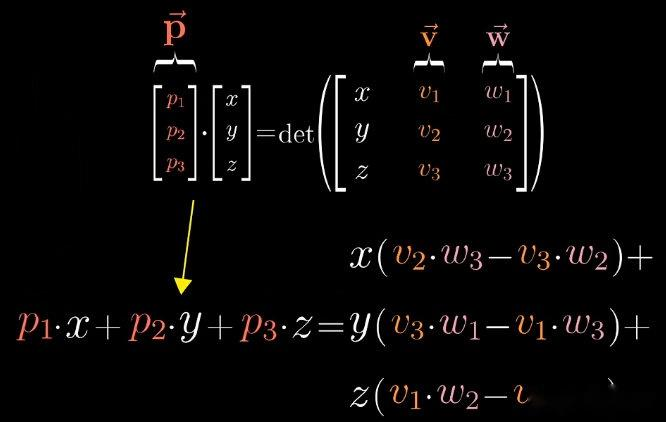

(2)结合对偶性的解释

- 定义线性变换 L ( x ⃗ ) = det ( x ⃗ , v ⃗ , w ⃗ ) L(\vec{x}) = \det(\vec{x}, \vec{v}, \vec{w}) L(x )=det(x ,v ,w )( x ⃗ \vec{x} x 为三维向量),该变换将三维向量映射到一维标量,且满足线性性;

- 根据对偶性,存在对偶向量 p ⃗ \vec{p} p ,使得 L ( x ⃗ ) = p ⃗ ⋅ x ⃗ L(\vec{x}) = \vec{p} \cdot \vec{x} L(x )=p ⋅x ,计算可得 p ⃗ = v ⃗ × w ⃗ \vec{p} = \vec{v} \times \vec{w} p =v ×w ;

- 因此 det ( x ⃗ , v ⃗ , w ⃗ ) = ( v ⃗ × w ⃗ ) ⋅ x ⃗ \det(\vec{x}, \vec{v}, \vec{w}) = (\vec{v} \times \vec{w}) \cdot \vec{x} det(x ,v ,w )=(v ×w )⋅x ,该式表明: v ⃗ × w ⃗ \vec{v} \times \vec{w} v ×w 与 x ⃗ \vec{x} x 的点积,等于 x ⃗ \vec{x} x 、 v ⃗ \vec{v} v 、 w ⃗ \vec{w} w 构成平行六面体的有向体积(符号反映空间定向)。

六、特征向量与特征值

1. 特征向量与特征值的几何释义

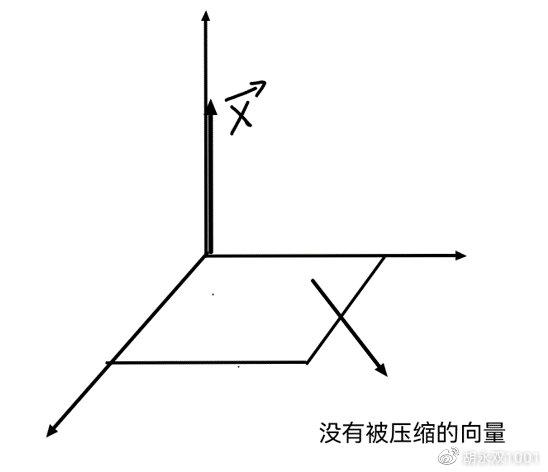

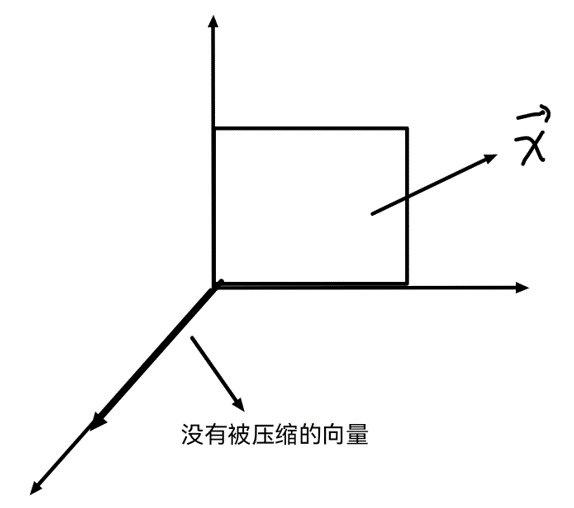

在线性变换过程中,多数向量经过变换后会离开其所张成的空间。然而,部分向量会保留在其所张成的空间内,线性变换对这些向量仅产生伸缩效应。

|

|

|---|---|

线性变换后仍保留在自身张成空间中的向量,定义为特征向量 。特征向量经过线性变换后不发生旋转,仅发生伸缩。衡量特征向量在变换中伸缩比例的因子,即为特征值。当特征值为负时,表示向量被反向伸缩。

若属于同一特征值的任意 n n n 个向量线性无关,则它们张成的空间中的任意向量均为该特征值的特征向量,且在变换中仅发生缩放。

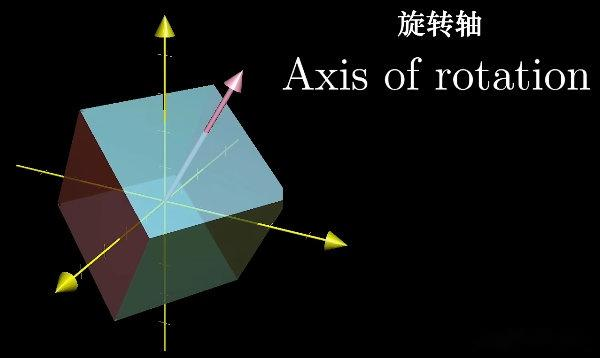

对于三维空间中的旋转变换,若能找到对应的特征向量,则该特征向量即为旋转轴 。这意味着一个三维旋转变换可被视为绕该特征向量旋转特定角度,此解释比直接分析相应的 3 × 3 3 \times 3 3×3 变换矩阵更为直观。此时对应的特征值为 1 1 1,因为旋转不改变向量的长度。

2. 特征向量与特征值的计算

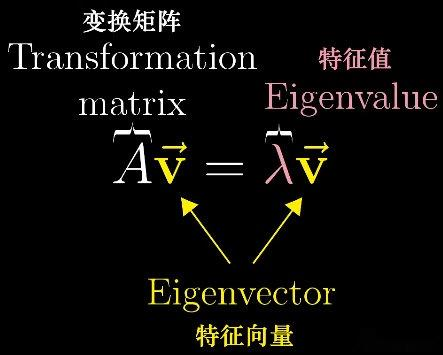

在数学符号中,特征向量的概念可表示为 A v = λ v A\mathbf{v} = \lambda \mathbf{v} Av=λv。此表达式表明,向量 v \mathbf{v} v 经过矩阵 A A A 变换后,结果等同于向量 v \mathbf{v} v 的标量乘法。标量乘法不改变向量的方向,因此符合特征向量的定义。

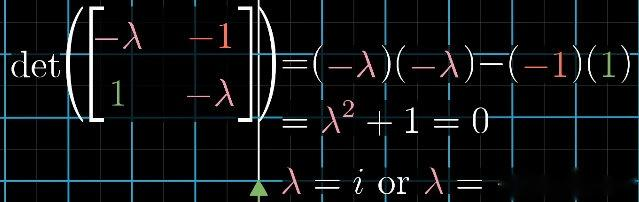

向量的标量乘法等价于使用一个对角线上元素均为 λ \lambda λ 的对角矩阵进行变换。因此, A v = λ v A\mathbf{v} = \lambda \mathbf{v} Av=λv 可改写为 A v = λ I v A\mathbf{v} = \lambda I\mathbf{v} Av=λIv,其中 I I I 为单位矩阵。将等式移项,得到 ( A − λ I ) v = 0 (A - \lambda I)\mathbf{v} = \mathbf{0} (A−λI)v=0。为获得有意义的非零特征向量(零向量总是满足此方程但无实际意义),当且仅当矩阵 ( A − λ I ) (A - \lambda I) (A−λI) 将空间压缩至更低维度时,才存在非零向量 v \mathbf{v} v 经变换后变为零向量。因此,其行列式必须为零,即 det ( A − λ I ) = 0 \det(A - \lambda I) = 0 det(A−λI)=0。通过求解此特征方程,可确定特征值 λ \lambda λ。

二维线性变换不一定存在实特征向量。例如,逆时针旋转 9 0 ∘ 90^\circ 90∘ 的变换矩阵 [ 0 − 1 1 0 ] \begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix} [01−10] 不存在实特征向量,因为变换后所有向量均发生旋转并离开其所张成的空间。求解其特征方程会发现 λ \lambda λ 没有实数解。

在复平面中,与 i i i 相乘表示 9 0 ∘ 90^\circ 90∘ 旋转,而 i i i 是该二维实向量旋转变换的特征值,这与特征值出现复数通常对应于变换中的某种旋转现象相吻合。

矩阵 [ 2 0 0 2 ] \begin{bmatrix} 2 & 0 \\ 0 & 2 \end{bmatrix} [2002] 将所有向量伸长两倍,其唯一特征值为 2 2 2。在此情况下,平面内所有非零向量均为该特征值的特征向量。

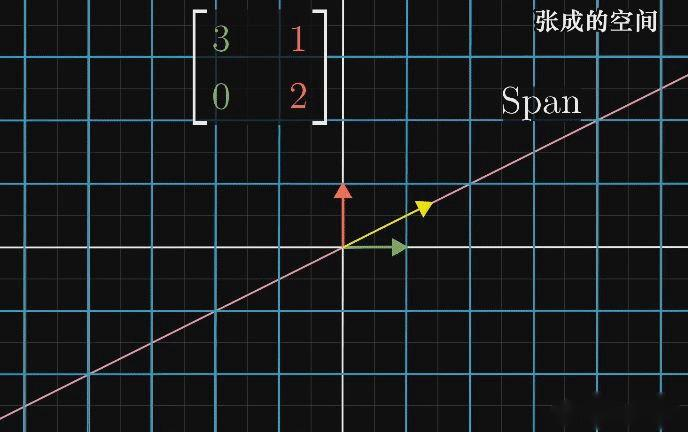

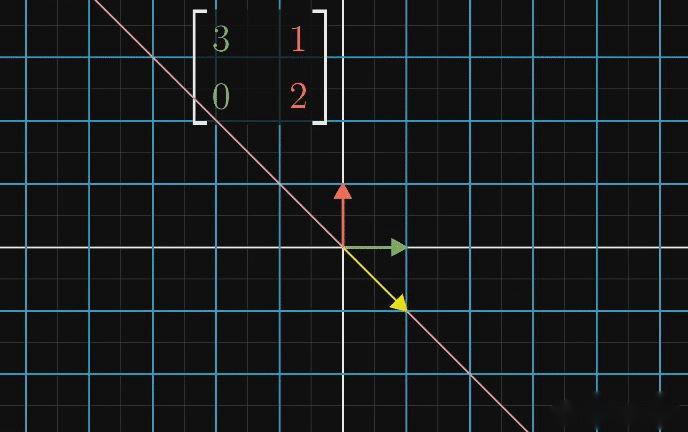

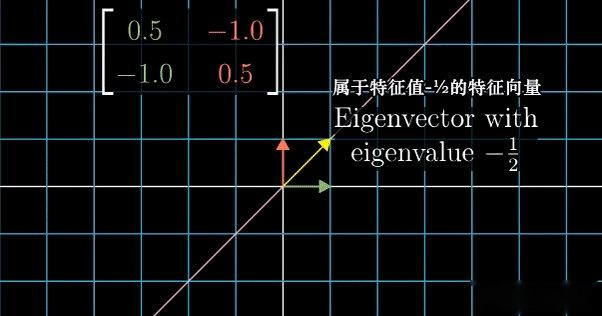

3. 特征基与对角化

特征基是指构成矩阵所有基向量均为特征向量的基。在以特征向量为基向量的坐标系中,矩阵的变换表现为基向量的缩放。对角矩阵的所有基向量均为特征向量,其对角线元素即为对应的特征值。

若一个变换矩阵具有足够多的特征向量,以至于能够选取一个张成整个空间的集合,则当基向量为特征向量时,可以通过基变换将该变换矩阵从特征向量坐标系转换至标准坐标系。

例如,对于矩阵 [ 3 1 0 2 ] \begin{bmatrix} 3 & 1 \\ 0 & 2 \end{bmatrix} [3012],其特征值分别为 2 2 2 和 3 3 3,对应的特征向量分别为 [ 1 0 ] \begin{bmatrix} 1 \\ 0 \end{bmatrix} [10] 和 [ 1 1 ] \begin{bmatrix} 1 \\ 1 \end{bmatrix} [11]。在以向量 [ 1 0 ] \begin{bmatrix} 1 \\ 0 \end{bmatrix} [10] 和 [ 1 1 ] \begin{bmatrix} 1 \\ 1 \end{bmatrix} [11] 为基向量的坐标系中,变换矩阵 [ 3 1 0 2 ] \begin{bmatrix} 3 & 1 \\ 0 & 2 \end{bmatrix} [3012] 实质上是对基向量的缩放变换。将这些特征向量作为新基向量,构成基变换矩阵 P = [ 1 1 0 1 ] P = \begin{bmatrix} 1 & 1 \\ 0 & 1 \end{bmatrix} P=[1011]。然后,通过计算 P − 1 A P P^{-1}AP P−1AP,其中 A = [ 3 1 0 2 ] A = \begin{bmatrix} 3 & 1 \\ 0 & 2 \end{bmatrix} A=[3012]。

这样计算得到的新矩阵 P − 1 A P P^{-1}AP P−1AP 与矩阵 A A A 代表的是同一个线性变换,但新矩阵是在由特征向量构成的新坐标系中表达的。这个新矩阵必定是对角矩阵,且其对角线元素为对应的特征值,因为其所处的坐标系的基向量在变换中只发生缩放。

矩阵相似的本质:矩阵 M M M 与 P − 1 M P P^{-1}MP P−1MP 是相似的。矩阵相似性表明两个矩阵表示同一线性变换,但分别在两个不同的坐标系(即不同的基)下。矩阵 P P P 的列向量即为在 M M M 所在坐标系中表示的 P − 1 M P P^{-1}MP P−1MP 所在坐标系的基向量。

对角化的条件:矩阵对角化是将特征向量作为基向量,通过基变换将该变换矩阵转换到标准坐标系中。从计算角度看,一个 n n n 阶矩阵能否对角化,关键在于它是否存在 n n n 个线性无关的特征向量。从基变换角度看,能否对角化,关键在于能否将特征向量作为基向量。对于 n n n 阶矩阵的变换必然发生在 n n n 维空间,因此需要 n n n 个基向量。若矩阵没有 n n n 个可作为基向量的特征向量(即 n n n 个线性无关的特征向量,因为基向量必须线性无关),则该矩阵不可对角化。

七、解空间

1. 解判定的实质

线性方程组 A x = b A\mathbf{x} = \mathbf{b} Ax=b 和 A x = 0 A\mathbf{x} = \mathbf{0} Ax=0 求解的实质,就是寻找一个向量 x \mathbf{x} x,使它经过 A A A 变换后,与向量 b \mathbf{b} b 重合或者落在零向量上。

对于非齐次线性方程组 A x = b A\mathbf{x} = \mathbf{b} Ax=b:

- 当矩阵 A A A 为 n n n 阶满秩方阵时, A A A 变换没有发生维度变化,向量 b \mathbf{b} b 一定位于 A A A 的列空间中,因此只存在唯一的向量 x \mathbf{x} x 经过 A A A 变换后与向量 b \mathbf{b} b 重合,所以只有唯一解。此时, rank ( A ) = rank ( A , b ) = n \text{rank}(A) = \text{rank}(A,\mathbf{b}) = n rank(A)=rank(A,b)=n。

- 当矩阵 A A A 为 n n n 阶非满秩方阵时, A A A 变换将空间压缩为一个小于 n n n 维的空间( A A A 的列空间),只有当向量 b \mathbf{b} b 位于这个小于 n n n 维的空间时,向量 x \mathbf{x} x 经过 A A A 变换后才会与其重合,空间压缩必然会导致多个不同的向量 x \mathbf{x} x 被压缩到同一个向量上,所以会有无数解。此时, rank ( A ) = rank ( A , b ) < n \text{rank}(A) = \text{rank}(A,\mathbf{b}) < n rank(A)=rank(A,b)<n。

- 当 m × n m \times n m×n 矩阵 A A A 行数大于列数( m > n m > n m>n)时, A A A 变换将向量 x \mathbf{x} x 映射到更高维度, A A A 的列空间维度没有改变,即 m m m 维空间中的 n n n 维子空间,只有当向量 b \mathbf{b} b 位于这个 n n n 维子空间时,向量 x \mathbf{x} x 经过 A A A 变换后才会与 b \mathbf{b} b 重合,由于 A A A 变换没有发生压缩,所以只存在唯一的向量 x \mathbf{x} x。此时, rank ( A ) = rank ( A , b ) = n \text{rank}(A) = \text{rank}(A,\mathbf{b}) = n rank(A)=rank(A,b)=n。

- 当 m × n m \times n m×n 矩阵 A A A 行数小于列数( m < n m < n m<n)时, A A A 变换将向量 x \mathbf{x} x 降低到 m m m 维, A A A 的列空间被压缩到 m m m 维,所以 m m m 维向量 b \mathbf{b} b 一定位于 A A A 的列空间中,向量 x \mathbf{x} x 经过 A A A 变换后一定会与向量 b \mathbf{b} b 重合,由于 A A A 变换发生压缩,所以存在无数的向量 x \mathbf{x} x。此时, rank ( A ) = rank ( A , b ) = m < n \text{rank}(A) = \text{rank}(A,\mathbf{b}) = m < n rank(A)=rank(A,b)=m<n。

对于齐次线性方程组 A x = 0 A\mathbf{x} = \mathbf{0} Ax=0:

- 当矩阵 A A A 为 n n n 阶满秩方阵时, A A A 变换没有发生维度变化,因此没有非零向量经过 A A A 变换后落到零向量,所以只有零解。此时, rank ( A ) = n \text{rank}(A) = n rank(A)=n。

- 当矩阵 A A A 为 n n n 阶非满秩方阵时, A A A 变换将空间压缩为一个小于 n n n 维的空间,此过程必然存在非零向量 x \mathbf{x} x 被压缩为零向量,所以有非零解。此时, rank ( A ) < n \text{rank}(A) < n rank(A)<n。

- 当 m × n m \times n m×n 矩阵 A A A 行数大于列数( m > n m > n m>n)时, A A A 的列空间维度没有改变,因此没有非零向量经过 A A A 变换后落到零向量,所以只有零解。此时, rank ( A ) = n \text{rank}(A) = n rank(A)=n。

- 当 m × n m \times n m×n 矩阵 A A A 行数小于列数( m < n m < n m<n)时, A A A 的列空间被压缩到 m m m 维,此时必然存在非零向量 x \mathbf{x} x 被压缩为零向量,所以有非零解。此时, rank ( A ) < n \text{rank}(A) < n rank(A)<n。

以上就是线性方程组解判定的实质,以下还有几点需要注意:

- 线性变换向量的维度可以升高或降低,但向量张成的空间不会升高。

- 向量张成的空间的维度一定不超过向量的维度。

- 若向量的维度与空间的维度相同,则这个向量一定位于这个空间中。

- 对于非齐次线性方程组,如果系数矩阵是压缩变换,则有无数解(向量 b \mathbf{b} b 位于 A A A 的列空间中);对于齐次线性方程组,如果系数矩阵是压缩变换,则有非零解。

2. 基础解系与通解

当齐次线性方程组的系数矩阵是压缩变换时,必然存在无数个非零向量被压缩成零向量,因此存在无数非零解。这些向量张成的空间称为解空间,解空间的基称为基础解系。

若 A x = 0 A\mathbf{x} = \mathbf{0} Ax=0 且 A A A 为 n n n 阶矩阵、向量 x \mathbf{x} x 为三维向量。知道,矩阵的秩表示经过矩阵变换后的空间的维度。若 A A A 对一个三维空间进行变换,当 rank ( A ) = 3 \text{rank}(A) = 3 rank(A)=3 时, A A A 变换没有改变维度,没有向量被压缩为零向量;当 rank ( A ) = 2 \text{rank}(A) = 2 rank(A)=2 时,经过 A A A 变换后有两个维度的向量没有被压缩,所以就有一个维度的向量落到了零向量,此时方程 A x = 0 A\mathbf{x} = \mathbf{0} Ax=0 的基础解系有一个基向量,所以解空间是一条直线;当 rank ( A ) = 1 \text{rank}(A) = 1 rank(A)=1 时,此时落到零向量的向量张成的空间就是一个二维平面,也就是解空间,此时方程 A x = 0 A\mathbf{x} = \mathbf{0} Ax=0 的基础解系有两个基向量。

由此可以看出,被压缩向量张成空间的维度与没有被压缩向量张成空间的维度的和就是原始向量所在空间的维度。因此可以得出解空间的维数就是 n − rank ( A ) n - \text{rank}(A) n−rank(A),也就是基础解系的个数。把所有基础解系的线性组合称为齐次线性方程组的通解。

若 A A A 为 m × n m \times n m×n( m < n m < n m<n)非方阵时只有压缩变换才有解,向量张成空间,所以只讨论 m < n m < n m<n。原始向量所在空间的维度为 n n n(即变换前向量 x \mathbf{x} x 是 n n n 维),若 A A A 的秩为 rank ( A ) \text{rank}(A) rank(A),则解空间的维度也为 n − rank ( A ) n - \text{rank}(A) n−rank(A)。

来考虑非齐次线性方程组 A x = b A\mathbf{x} = \mathbf{b} Ax=b 解的结构。若矩阵 A A A 没有发生压缩变换,则方程只有唯一解,因此没有基础解系。当矩阵 A A A 发生压缩变换时,必然存在多个不同向量被压缩后位于同一向量上。

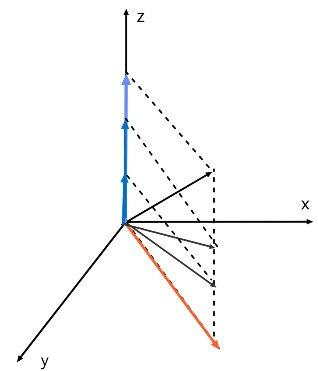

若 rank ( A ) = 2 \text{rank}(A) = 2 rank(A)=2,则经过 A A A 变换后有两个维度的向量没有被压缩。假设矩阵 A A A 变换是将三维空间的向量压缩至 x o y xoy xoy 平面,图中三个黑色向量变换后均与红色向量(红色向量就是向量 b \mathbf{b} b)重合。将这三个黑色向量分别沿 x o y xoy xoy 平面和 z z z 轴方向分解,可以发现在 x o y xoy xoy 平面方向的分量与红色向量相同。对这三个向量变换,也就是对两个分量变换,而变换后 z z z 轴方向的蓝色分量落到零向量,而 x o y xoy xoy 平面上的分量没有变且与红色向量相同,因此方程的解就是落到零向量的蓝色分量与红色向量的和,此时基础解系只有一个。因此通解为 n 0 + k n 1 \mathbf{n}_0 + k\mathbf{n}_1 n0+kn1, n 1 \mathbf{n}_1 n1 为基础解系, n 0 \mathbf{n}_0 n0 为非齐次线性方程组的特解。

若 rank ( A ) = 1 \text{rank}(A) = 1 rank(A)=1,则经过 A A A 变换后有一个维度的向量没有被压缩。假设矩阵 A A A 变换是将三维空间的向量压缩至 z z z 轴,如下图,将两个黑色向量分别沿 x x x、 y y y、 z z z 轴方向分解,可以发现 z z z 轴上的分量在变换后没有改变且与红色向量相同,而在 x x x、 y y y 轴上的蓝色分量都不相同且在变换后都落到了零向量,因此,方程的解就是落到零向量的两个蓝色分量与红色向量的和,此时基础解系有两个。因此通解为 n 0 + k 1 n 1 + k 2 n 2 \mathbf{n}_0 + k_1\mathbf{n}_1 + k_2\mathbf{n}_2 n0+k1n1+k2n2, n 1 \mathbf{n}_1 n1、 n 2 \mathbf{n}_2 n2 为基础解系, n 0 \mathbf{n}_0 n0 为非齐次线性方程组的特解。

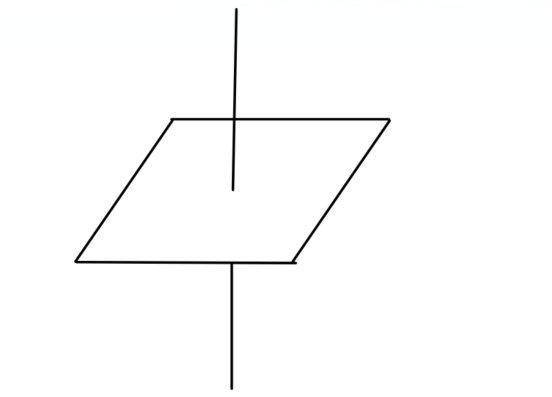

从上面的讨论可以看出非齐次线性方程组的通解等于非齐次线性方程组的特解加上齐次线性方程组的通解。在上图中,发现,平面 α \alpha α 代表的就是对应齐次线性方程组的通解,而平面 β \beta β 代表的就是非齐次线性方程组的通解,这里注意,平面 β \beta β 并不过原点,因此它的解不能构成向量空间。

3. 解空间与行空间

对于方程 A x = 0 A\mathbf{x} = \mathbf{0} Ax=0,解空间的维度为 n − r n - r n−r, r r r 为 A A A 的秩。

我们对上面矩阵 A 行分块,与列空间相同,矩阵的行空间就是所有行向量 α i T x ⃗ \alpha_i^T \vec{x} αiTx 的线性组合得到的向量集合,所以就有 α i T x ⃗ = 0 \alpha_i^T \vec{x} = 0 αiTx =0,因此向量 α i T \alpha_i^T αiT 与向量 x \mathbf{x} x 正交,向量 α i T \alpha_i^T αiT,与向量 x 所在的空间分别是 A 的行空间和方程的解空间,所以,行空间与解空间是正交的。

对上面矩阵 A A A 行分块,与列空间相同,矩阵的行空间就是所有行向量 α \mathbf{\alpha} α 的线性组合得到的向量集合。所以就有 α i T x ⃗ = 0 \alpha_i^T \vec{x} = \mathbf{0} αiTx =0,因此向量 α i \mathbf{\alpha}_i αi 与向量 x \mathbf{x} x 正交,向量 α i \mathbf{\alpha}_i αi 与向量 x \mathbf{x} x 所在的空间分别是 A A A 的行空间和方程的解空间,所以,行空间与解空间是正交的。

在三维空间中,若行空间的维度为 2 2 2(向量在一个二维平面上),则与它正交的向量只能在垂直于这个平面的直线上,所以解空间维度为 1 1 1;而当行空间的维度为 3 3 3 的,在三维空间中就没有与它正交的向量了,所以解空间维度为 0 0 0。所以,在 n n n 维空间中,行空间与解空间维度的和等于 n n n,即 rank ( 行 ) + rank ( 解 ) = n \text{rank}(\text{行}) + \text{rank}(\text{解}) = n rank(行)+rank(解)=n,所以就有: rank ( 行 ) = n − rank ( 解 ) = n − ( n − r ) = r \text{rank}(\text{行}) = n - \text{rank}(\text{解}) = n - (n - r) = r rank(行)=n−rank(解)=n−(n−r)=r,因此行空间与列空间维度相等,即行秩等于列秩。

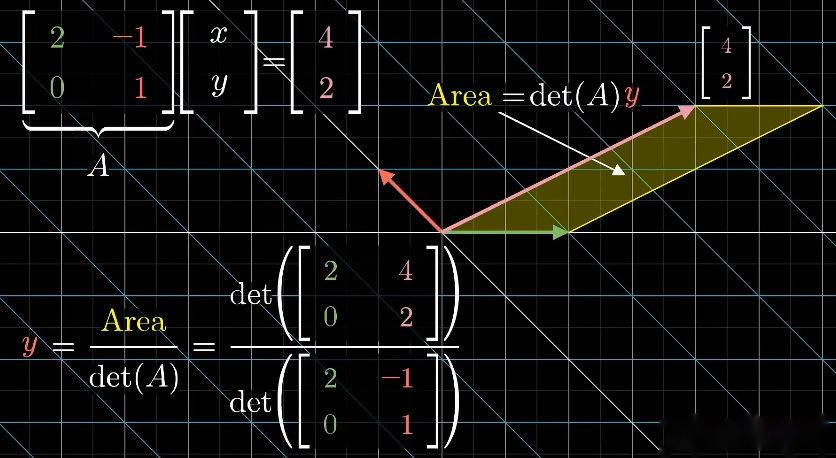

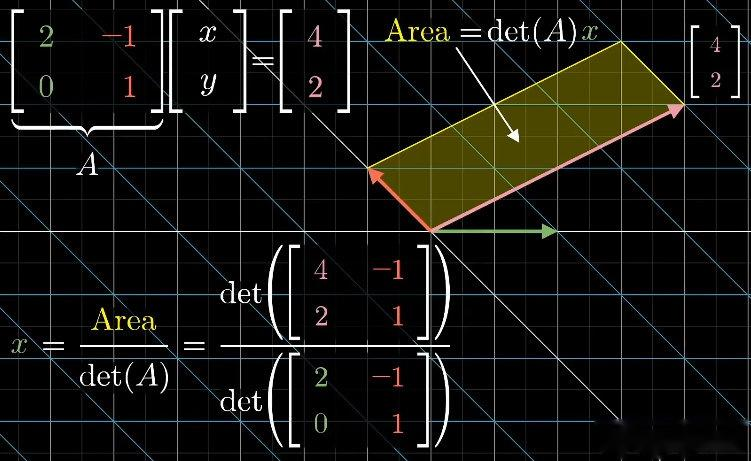

4. 克莱姆法则的几何解释

当线性方程组有唯一解且系数矩阵为方阵时,可以用克莱姆法则通过计算行列式来求解方程组,具体过程如下:

设有线性方程组:

{ a 11 x 1 + a 12 x 2 + ⋯ + a 1 n x n = D 1 a 21 x 1 + a 22 x 2 + ⋯ + a 2 n x n = D 2 ⋮ a n 1 x 1 + a n 2 x 2 + ⋯ + a n n x n = D n \begin{cases} a_{11}x_1 + a_{12}x_2 + \cdots + a_{1n}x_n = D_1 \\ a_{21}x_1 + a_{22}x_2 + \cdots + a_{2n}x_n = D_2 \\ \vdots \\ a_{n1}x_1 + a_{n2}x_2 + \cdots + a_{nn}x_n = D_n \end{cases} ⎩ ⎨ ⎧a11x1+a12x2+⋯+a1nxn=D1a21x1+a22x2+⋯+a2nxn=D2⋮an1x1+an2x2+⋯+annxn=Dn

系数行列式为:

D = ∣ a 11 a 12 ⋯ a 1 n a 21 a 22 ⋯ a 2 n ⋮ ⋮ ⋱ ⋮ a n 1 a n 2 ⋯ a n n ∣ D = \begin{vmatrix} a_{11} & a_{12} & \cdots & a_{1n} \\ a_{21} & a_{22} & \cdots & a_{2n} \\ \vdots & \vdots & \ddots & \vdots \\ a_{n1} & a_{n2} & \cdots & a_{nn} \end{vmatrix} D= a11a21⋮an1a12a22⋮an2⋯⋯⋱⋯a1na2n⋮ann

线性方程组有且仅有唯一解:

x j = D j D ( j = 1 , 2 , ... , n ) x_j = \frac{D_j}{D} \quad (j = 1,2,\dots,n) xj=DDj(j=1,2,...,n)

其中 D j D_j Dj( j = 1 , 2 , ... , n j = 1,2,\dots,n j=1,2,...,n)是把系数行列式 D D D 中的第 j j j 列元素用常数项 D j D_j Dj 代替后得到的 n n n 阶行列式,即

D j = ∣ a 11 ⋯ a 1 , j − 1 D 1 a 1 , j + 1 ⋯ a 1 n a 21 ⋯ a 2 , j − 1 D 2 a 2 , j + 1 ⋯ a 2 n ⋮ ⋱ ⋮ ⋮ ⋮ ⋱ ⋮ a n 1 ⋯ a n , j − 1 D n a n , j + 1 ⋯ a n n ∣ D_j = \begin{vmatrix} a_{11} & \cdots & a_{1,j-1} & D_1 & a_{1,j+1} & \cdots & a_{1n} \\ a_{21} & \cdots & a_{2,j-1} & D_2 & a_{2,j+1} & \cdots & a_{2n} \\ \vdots & \ddots & \vdots & \vdots & \vdots & \ddots & \vdots \\ a_{n1} & \cdots & a_{n,j-1} & D_n & a_{n,j+1} & \cdots & a_{nn} \end{vmatrix} Dj= a11a21⋮an1⋯⋯⋱⋯a1,j−1a2,j−1⋮an,j−1D1D2⋮Dna1,j+1a2,j+1⋮an,j+1⋯⋯⋱⋯a1na2n⋮ann

接下来从线性变换角度来解释这个法则。

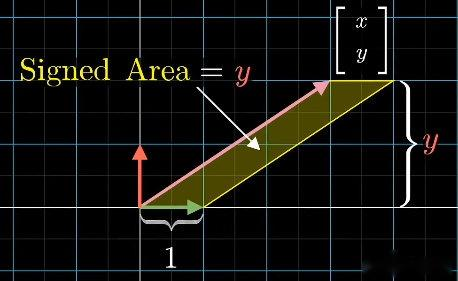

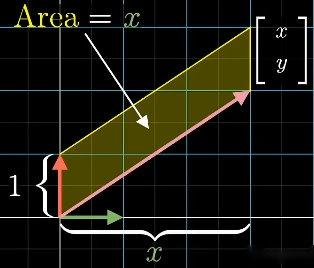

对于任意向量 [ x y ] \begin{bmatrix} x \\ y \end{bmatrix} [xy],可以将它与 x x x 轴上的基向量 i \mathbf{i} i 构成的平行四边形的面积表示为 y y y 值,准确来说,应该是有向面积,因为 y y y 值有正负情况。同样,将它与 y y y 轴上的基向量 j \mathbf{j} j 构成的平行四边形的面积表示为 x x x 值。

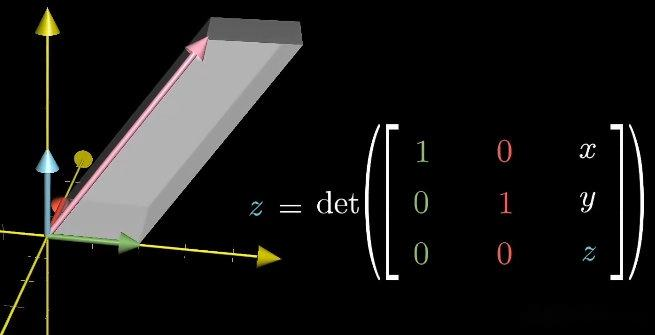

对于三维空间,同样可以将一个三维向量与 x x x、 y y y 轴上的基向量 i \mathbf{i} i、 j \mathbf{j} j 构成的平行六面体的体积表示为 z z z 值。

在变换前后,平行四边形的面积不一定保持不变,但面积的伸缩比例却是不变的,且等于变换矩阵的行列式。

若有线性方程组 [ 1 2 0 1 ] [ x y ] = [ 4 2 ] \begin{bmatrix} 1 & 2 \\ 0 & 1 \end{bmatrix}\begin{bmatrix} x \\ y \end{bmatrix} = \begin{bmatrix} 4 \\ 2 \end{bmatrix} [1021][xy]=[42],经过矩阵 [ 1 2 0 1 ] \begin{bmatrix} 1 & 2 \\ 0 & 1 \end{bmatrix} [1021] 变换后平行四边形的面积就等于变换前的面积 y y y 值乘以行列式,而变换后平行四边形的面积就是向量 [ 4 2 ] \begin{bmatrix} 4 \\ 2 \end{bmatrix} [42] 与基向量 i \mathbf{i} i 变换后的向量 [ 1 0 ] \begin{bmatrix} 1 \\ 0 \end{bmatrix} [10] 构成的平行四边形的面积,即 det ( [ 1 2 0 1 ] ) × y = det ( [ 4 1 2 0 ] ) \text{det}\left(\begin{bmatrix} 1 & 2 \\ 0 & 1 \end{bmatrix}\right) \times y = \text{det}\left(\begin{bmatrix} 4 & 1 \\ 2 & 0 \end{bmatrix}\right) det([1021])×y=det([4210])。所以 y y y 值就是变换后平行四边形面积与行列式的比值,即

y = det ( [ 4 1 2 0 ] ) det ( [ 1 2 0 1 ] ) y = \frac{\text{det}\left(\begin{bmatrix} 4 & 1 \\ 2 & 0 \end{bmatrix}\right)}{\text{det}\left(\begin{bmatrix} 1 & 2 \\ 0 & 1 \end{bmatrix}\right)} y=det([1021])det([4210])

同样,也能求出 x x x 值。

八、抽象向量空间

为了直观地理解各种概念,通常用坐标对向量进行表示。但实际上很多核心概念是脱离于坐标系的,例如行列式、特征向量等,均与所选的坐标系无关。行列式代表一个变换对面积的缩放比例,而特征向量则是在变换过程中留在它所张成空间的向量。

如果向量根本不是一个数组,它们的本质其实更具有空间性,因此可以从更空间化的角度看待向量。

1. 函数与向量

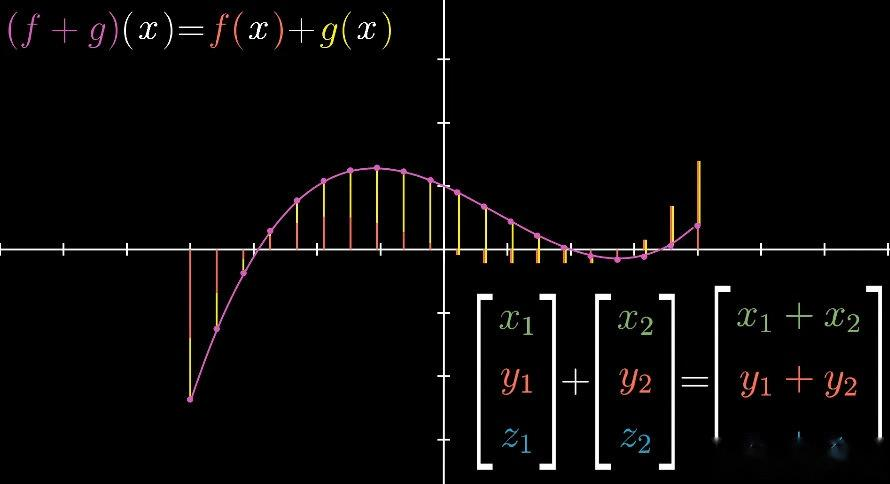

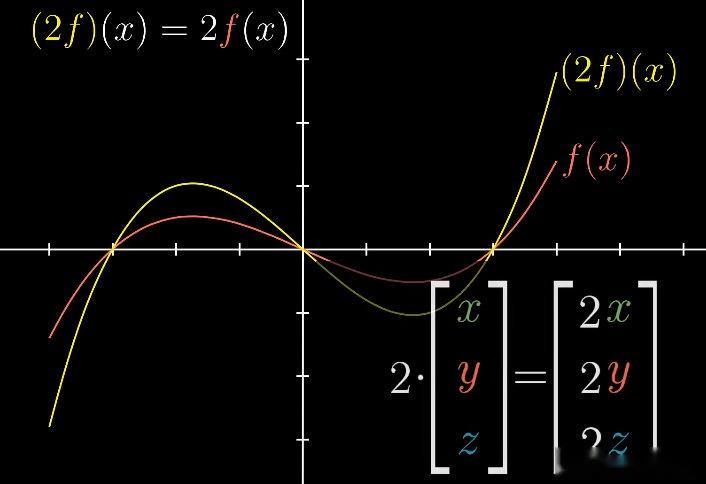

来讨论一种同样具有向量特性的东西------函数。从某种意义上讲,函数也是一种向量。函数的加减和数乘与向量的加减和数乘相似:

- ( 2 f ) ( x ) = 2 f ( x ) (2f)(x) = 2f(x) (2f)(x)=2f(x)

- ( f + g ) ( x ) = f ( x ) + g ( x ) (f + g)(x) = f(x) + g(x) (f+g)(x)=f(x)+g(x)

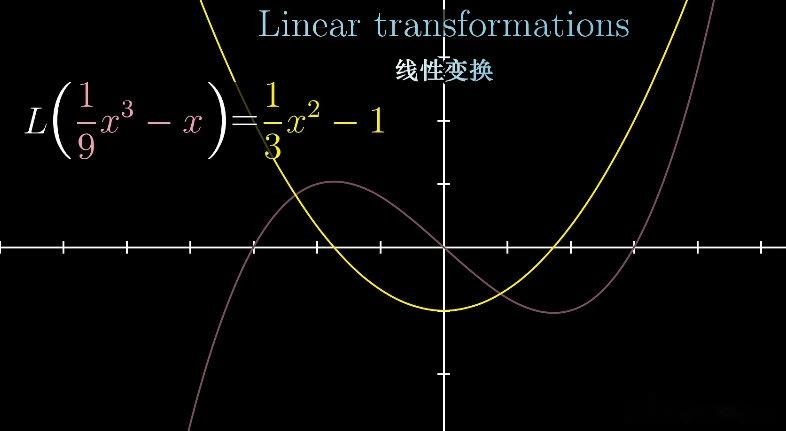

向量的其他特性对于函数也应该满足,例如线性变换。线性变换的定义:

- 可加性: L ( u + v ) = L ( u ) + L ( v ) L(\mathbf{u} + \mathbf{v}) = L(\mathbf{u}) + L(\mathbf{v}) L(u+v)=L(u)+L(v)

- 成比例(一阶齐次): L ( c v ) = c L ( v ) L(c\mathbf{v}) = cL(\mathbf{v}) L(cv)=cL(v)

对于向量来说, L L L 代表矩阵;对于函数来说, L L L 代表函数。对于线性变换而言,从函数的角度理解就是线性变换输入一个函数,然后输出另一个函数。

2. 求导矩阵

若存在一个函数的变换是接收一个函数并把它变成另一个函数。

这是微积分中一个常见的例子------导数,它将一个函数变换到另一个函数。对于函数求导,有以下两个性质:

-

两个函数先相加再求导,等同于先对两个函数求导再相加:

d d x ( f ( x ) + g ( x ) ) = d d x f ( x ) + d d x g ( x ) \frac{d}{dx}(f(x) + g(x)) = \frac{d}{dx}f(x) + \frac{d}{dx}g(x) dxd(f(x)+g(x))=dxdf(x)+dxdg(x) -

函数和数先相乘再求导,等同于先对函数求导再乘以数:

d d x ( c f ( x ) ) = c d d x f ( x ) \frac{d}{dx}(cf(x)) = c\frac{d}{dx}f(x) dxd(cf(x))=cdxdf(x)

与向量的线性变换相似,求导变换满足"可加性"和"成比例",所以它是线性的。

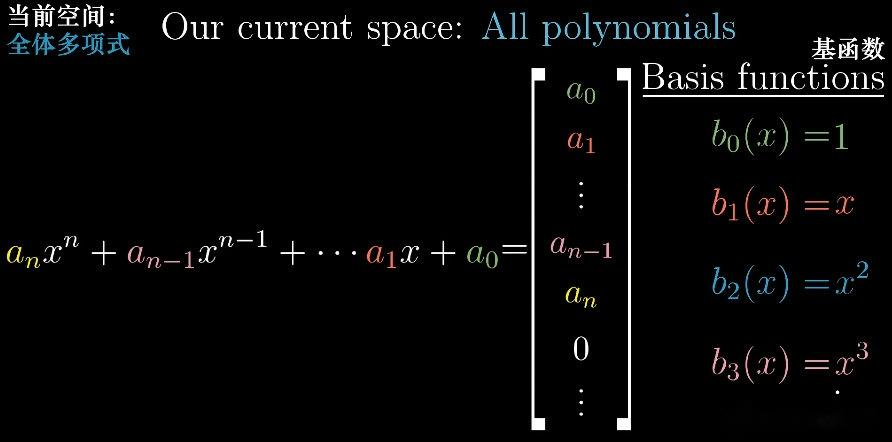

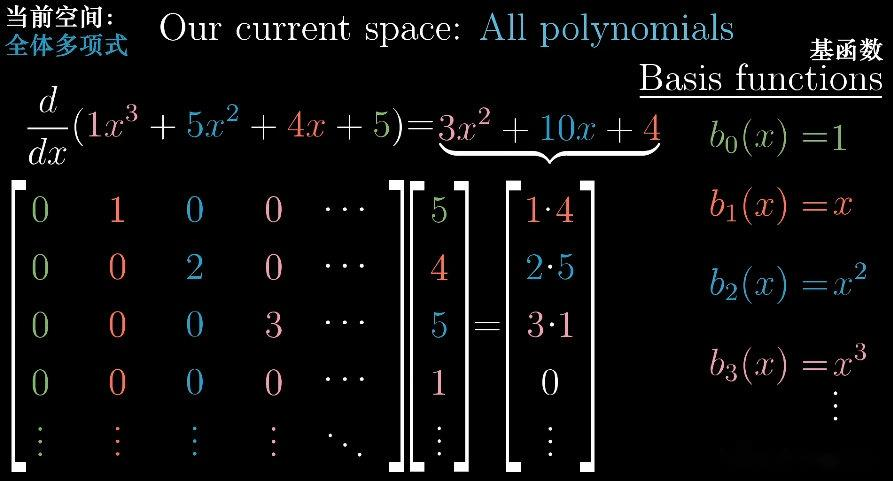

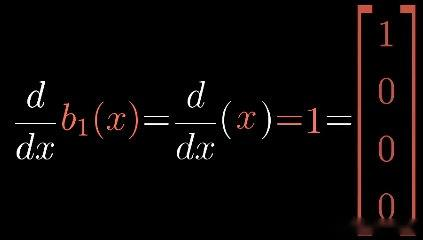

用矩阵来表示多项式函数的求导变换。首先给这个空间赋予坐标的含义,所以要选取基。由于多项式已经是数乘 x x x 的不同次幂再求和的形式,所以可以选取不同次幂的 x x x 为基。不同次幂的 x x x 就相当于基向量 i \mathbf{i} i、 j \mathbf{j} j、 k \mathbf{k} k。每个多项式的坐标就是不同次幂的 x x x 的系数,在这个坐标系中,求导是用一个无限矩阵来描述的。

例如,对于多项式 1 + 5 x 2 1 + 5x^2 1+5x2,基函数为:

- b 0 ( x ) = 1 b_0(x) = 1 b0(x)=1

- b 1 ( x ) = x b_1(x) = x b1(x)=x

- b 2 ( x ) = x 2 b_2(x) = x^2 b2(x)=x2

- b 3 ( x ) = x 3 b_3(x) = x^3 b3(x)=x3

- ... \dots ...

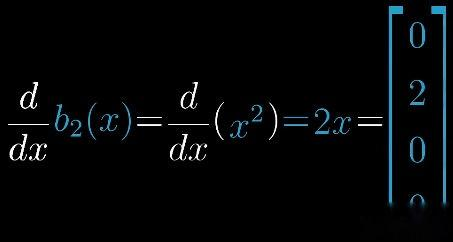

可以通过这个方法构建一个矩阵,求每一个基函数的导数并把结果放在对应列,求导矩阵就是对每个基函数求导后作为列向量得到的。

最终得到求导矩阵:

d d x = [ 0 1 0 0 ... 0 0 2 0 ... 0 0 0 3 ... ⋮ ⋮ ⋮ ⋮ ⋱ ] \frac{d}{dx}=\begin{bmatrix} 0 & 1 & 0 & 0 & \dots \\ 0 & 0 & 2 & 0 & \dots \\ 0 & 0 & 0 & 3 & \dots \\ \vdots & \vdots & \vdots & \vdots & \ddots \end{bmatrix} dxd= 000⋮100⋮020⋮003⋮.........⋱

- 线性代数 | 要义 / 本质(增篇 1)-CSDN博客

https://blog.csdn.net/u013669912/article/details/153641546

- 线性代数 | 要义 / 本质 (上篇)-CSDN博客

https://blog.csdn.net/u013669912/article/details/153110982 - 线性代数 | 要义 / 本质 (下篇)_行列式的定义-CSDN博客

https://blog.csdn.net/u013669912/article/details/153215664

via:

- 线性代数的本质(完整版) - 知乎

https://zhuanlan.zhihu.com/p/629986822