提前须知

本博客专门针对南昌航空大学数据科学与大数据处理专业的同学们,帮助大家轻松愉快地实现flink实验三的内容,以下是我总结的踩坑点,希望大家提前避免,以免来来回回修改与运行。

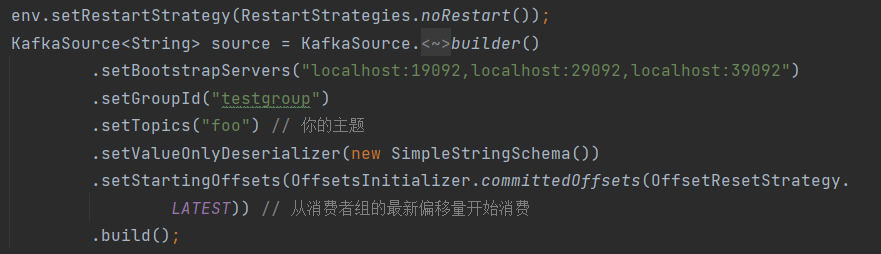

本地flink测试时设置BootstrapServers服务地址

也就是这部分的代码,在老师给我们的代码中只有几处需要大家进行修改,这里就是最关键的地方,这个服务器是指的我们在docker中运行的kafka的地址,由于是本地测试的,所以直接写localhost就可以,而后面的端口号并不是运行的时候设置的那个,而是需要我们知道外部的那个端口号,所以需要我们在docker中运行docker ps,查看kafka容器的外接端口。

具体内容大家可以查看解决博客

同时这里解释一下后面两个设置,groupid是消费组,我最开始会很疑惑这个是怎么得到的,后面查阅资料发现是我们去给我们这个消费者一个唯一的id,所以写什么都可以,后面这个话题是实验二创建的,所以只要同名就可以。

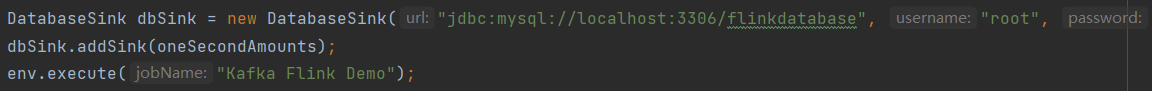

本地flink测试时连接mysql数据库

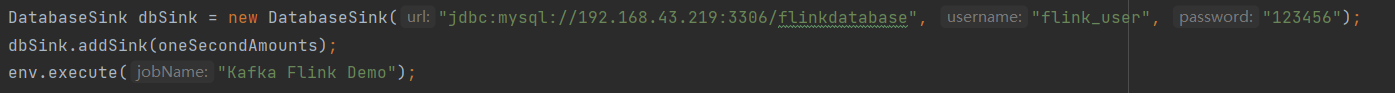

实话说,本地测试里面就需要修改这两个部分就能实现,将3306/后面改为自己的数据库,修改用户名和密码。

版本问题(核心重点)

这部分会有两次版本问题,一个是flink版本,一个是java版本

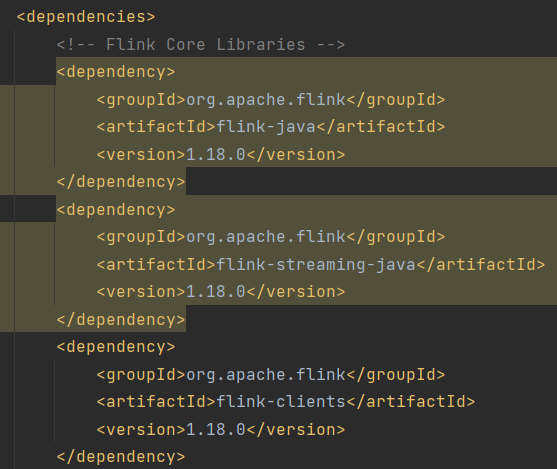

flink版本

老师发的maven环境的配置中的flink是1.18.0,而如果我们直接docker拉取镜像,大概率拉取的是最新版本的镜像,这会导致两个版本不匹配,所以在compose中就需要指定1.18.0版本,compose文件我后续会给出。(头铁者也可以尝试修改代码中的版本)

java版本

这个问题因人而易,每个人用的java版本不一样,但是如果你用的版本与flink镜像的默认版本不一致的话后续也会出现问题,而1.18.0的默认java版本是11,所以解决方法有两个:1.你跑的java代码用java11;2.你给flink升级java版本,这里介绍一下第二种方法,因为我是java17。

解决方法

创建一个Dockerfile文件,名字叫Dockerfile,并且不要后缀,写入以下内容,可以根据自己的java版本修改。将这个文件与compose文件放在一个目录下。

powershell

# 使用官方 Flink 镜像作为基础镜像

FROM flink:1.18.0

# 安装 Java 17

RUN apt-get update && apt-get install -y openjdk-17-jdk

# 设置 JAVA_HOME 环境变量,确保 Flink 使用 Java 17

ENV JAVA_HOME=/usr/lib/jvm/java-17-openjdk-amd64

ENV PATH=$JAVA_HOME/bin:$PATH

# 设置 Flink 默认启动命令

CMD ["jobmanager"]compose内容

如果不需要修改java版本,删除build那一行,networks根据自己设置的网络名进行修改,最好跟kafka在一个网络下。

yaml

services:

jobmanager1:

build: . # 使用当前目录中的 Dockerfile

ports:

- "8085:8081"

command: jobmanager

environment:

- JOB_MANAGER_RPC_ADDRESS=jobmanager1

- FLINK_ENV_JAVA_OPTS=--add-opens java.base/java.util=ALL-UNNAMED --add-opens java.base/java.lang=ALL-UNNAMED

networks:

- netkafka

jobmanager2:

build: . # 使用当前目录中的 Dockerfile

command: jobmanager

environment:

- JOB_MANAGER_RPC_ADDRESS=jobmanager2

- FLINK_ENV_JAVA_OPTS=--add-opens java.base/java.util=ALL-UNNAMED --add-opens java.base/java.lang=ALL-UNNAMED

networks:

- netkafka

taskmanager1:

build: . # 使用当前目录中的 Dockerfile

depends_on:

- jobmanager1

command: taskmanager

environment:

- JOB_MANAGER_RPC_ADDRESS=jobmanager1

- FLINK_ENV_JAVA_OPTS=--add-opens java.base/java.util=ALL-UNNAMED --add-opens java.base/java.lang=ALL-UNNAMED

networks:

- netkafka

taskmanager2:

build: . # 使用当前目录中的 Dockerfile

depends_on:

- jobmanager1

command: taskmanager

environment:

- JOB_MANAGER_RPC_ADDRESS=jobmanager1

- FLINK_ENV_JAVA_OPTS=--add-opens java.base/java.util=ALL-UNNAMED --add-opens java.base/java.lang=ALL-UNNAMED

networks:

- netkafka

taskmanager3:

build: . # 使用当前目录中的 Dockerfile

depends_on:

- jobmanager1

command: taskmanager

environment:

- JOB_MANAGER_RPC_ADDRESS=jobmanager1

- FLINK_ENV_JAVA_OPTS=--add-opens java.base/java.util=ALL-UNNAMED --add-opens java.base/java.lang=ALL-UNNAMED

networks:

- netkafka

networks:

netkafka:

name: netkafka

driver: bridge

ipam:

driver: default

config:

- subnet: 172.23.0.0/25

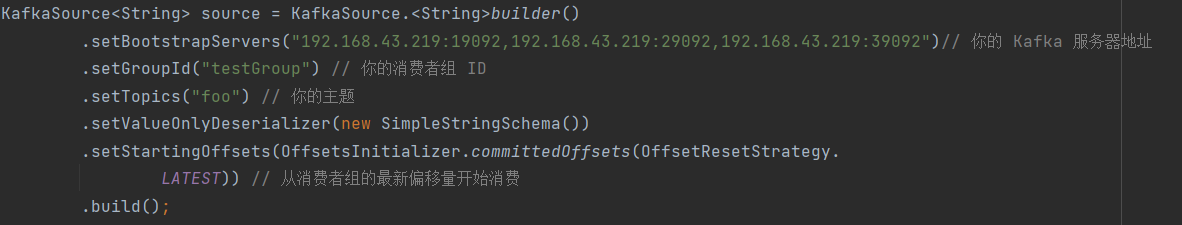

gateway: 172.23.0.1部署flink测试时设置BootstrapServers服务地址

这个地方将原来的localhost改为你电脑的ip地址即可

部署flink测试时连接mysql数据库

这里需要注意的地方有两点,一是跟上面一样要修改ip地址,二是部署是不能使用root用户,需要创建新的用户,并且赋予其一定的权力。

sql

mysql -u root -p

CREATE USER 'flink_user'@'%' IDENTIFIED BY '123456';

-- 授予对特定数据库的权限

GRANT ALL PRIVILEGES ON flinkdatabase.* TO 'flink_user'@'%';这里要记得修改为自己数据库的名字哦!

整体流程

写到这里有点微微累了哈哈,所以就直接借用前辈的博客

我写这个实验的时候就是参考的这篇博客,所以跟我写的是能对应上的,只不过多了部分踩坑经验。