目录

API

独立消费者案例

- 订阅主题

java

public class CustomConsumer {

public static void main(String[] args) {

// 1.创建消费者的配置对象

Properties properties = new Properties();

// 2.给消费者配置对象添加参数

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

// 配置消费者组(组名任意起名) 必须

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test");

// 创建消费者对象

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<String, String>(properties);

// 注册要消费的主题(可以消费多个主题)

ArrayList<String> topics = new ArrayList<>();

topics.add("first");

kafkaConsumer.subscribe(topics);

// 拉取数据打印

while (true) {

// 设置 1s 中消费一批数据

ConsumerRecords<String, String> consumerRecords = kafkaConsumer.poll(Duration.ofSeconds(1));

// 打印消费到的数据

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord);

}

}

}

}- 订阅分区

java

public class CustomConsumerPartition {

public static void main(String[] args) {

Properties properties = new Properties();

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

// 配置消费者组(必须),名字可以任意起

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test");

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<>(properties);

// 消费某个主题的某个分区数据

ArrayList<TopicPartition> topicPartitions = new ArrayList<>();

topicPartitions.add(new TopicPartition("first", 0));

kafkaConsumer.assign(topicPartitions);

while (true) {

ConsumerRecords<String, String> consumerRecords = kafkaConsumer.poll(Duration.ofSeconds(1));

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord);

}

}

}

}消费者组案例

一个消费者组消费一个主题里的消息

java

public class CustomConsumer1 {

public static void main(String[] args) {

// 1.创建消费者的配置对象

Properties properties = new Properties();

// 2.给消费者配置对象添加参数

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

// 配置消费者组 必须

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test");

// 创建消费者对象

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<String, String>(properties);

// 注册主题

ArrayList<String> topics = new ArrayList<>();

topics.add("first");

kafkaConsumer.subscribe(topics);

// 拉取数据打印

while (true) {

// 设置 1s 中消费一批数据

ConsumerRecords<String, String> consumerRecords = kafkaConsumer.poll(Duration.ofSeconds(1));

// 打印消费到的数据

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord);

}

}

}

}分区分配与再平衡

消费者通过分区分配策略分配各自消费的分区。

Kafka有四种主流的分区分配策略: Range、RoundRobin、Sticky、CooperativeSticky。默认策略是Range + CooperativeSticky。Kafka可以同时使用多个分区分配策略。

Range

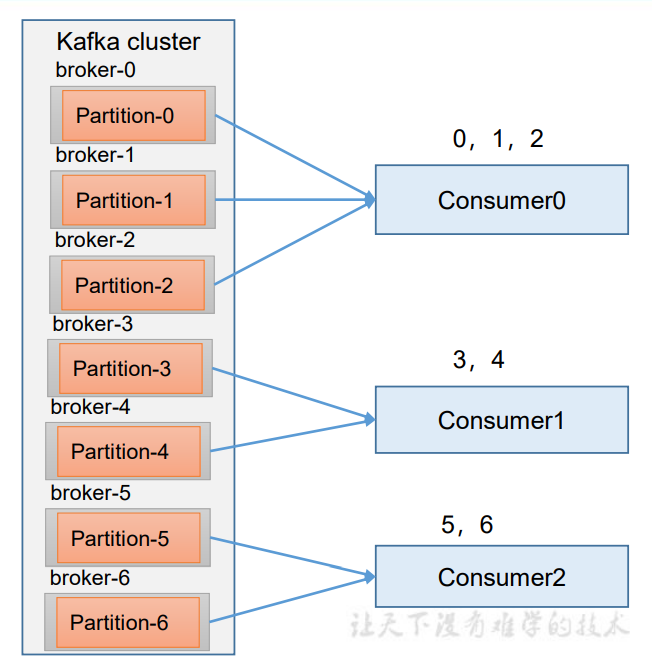

Range分配是对 一个topic 而言的。首先对同一个 topic 里面的分区按照序号进行排序 ,并对消费者按照字母顺序进行排序。

通过 partitions / consumer 来决定每个消费者应该消费几个分区。如果除不尽,那么前面几个消费者将会多消费 1 个分区。

优点:

- 分区有序性:每个消费者分配的分区是连续的编号范围,便于追踪和管理。

- 实现简单:逻辑直观,计算成本低,适合大规模分区场景。

缺点:

容易产生数据倾斜。针对一个topic而言,除不尽的情况消费者多消费一个影响不大。如果是n个topic,前面的消费者容易多出很多需要消费的消息,导致数据倾斜。

再平衡:

以上图为例子,假设Consumer0挂了,等待45s后消费者组确定其已经退出,其分配的任务会再以Range的策略整体重新被分配到 Consumer1 和Consumer2 。 再次重新发送消息观看结果: Consumer1:消费到 0、1、2、3 号分区数据。 Consumer2:消费到 4、5、6 号分区数据。

RoundRobin

RoundRobin是对 集群中所有的topic 而言的。 RoundRobin 轮询分区策略,是把所有的 partition 和所有的 consumer 都列出来,然后按照 hashcode 进行排序 ,最后通过轮询算法来分配 partition 给到各个消费者。

优点:

分配更均衡:无论分区数是否能被消费者数整除,分区都会均匀分散到各个消费者,避免单个消费者负载过高。

缺点:

- 分区无序性:消费者分配的分区编号不连续(如消费者 1 可能负责分区 0、2、4),不便于按分区号追踪数据。

- 计算成本略高:需要对所有分区排序后再轮询,在分区数量极多时,效率略低于 Range 策略。

Sticky

初次分配类似 RoundRobin 策略,优先保证分区分配的均衡性(尽可能让每个消费者分配到数量接近的分区)。

再平衡:

当消费者组发生变化(如消费者加入 / 离开),优先保留当前分配中仍有效的部分(即未受影响的分区 - 消费者映射),仅对 "需要重新分配的分区"(因消费者变动而释放的分区)进行二次分配,且新分配仍遵循均衡性原则。

优点:

- 减少再平衡开销:通过最小化分区迁移,降低消费者重新加载状态的成本。

- 兼顾均衡性:初次分配和再平衡时均保证分区数量尽可能均衡,避免个别消费者负载过高。

- 兼容性好:支持单主题和多主题场景,无需像 RoundRobin 那样要求所有消费者订阅相同主题。

缺点:

- 分区有序性差:分配结果的分区编号可能不连续。

- 极端情况可能出现数据倾斜。

offset

存储位置

Kafka0.9版本之前, consumer默认将offset 保存在Zookeeper中。 从0.9版本开始,consumer默认将offset保存在Kafka一个内置的topic中,该topic为__consumer_offsets。

__consumer_offsets 主题里面采用 key 和 value 的方式存储数据。key 是 group.id+topic+ 分区号,value 就是当前 offset 的值。每隔一段时间,kafka 内部会对这个 topic 进行 compact压缩,也就是每个 group.id+topic+分区号就保留最新数据。

offset的提交

自动提交

自动提交offset的相关参数:

- enable.auto.commit:是否开启自动提交offset功能,默认是true

- auto.commit.interval.ms:自动提交offset的时间间隔,默认是5s

流程:

消费者不断地向分区中拉取数据,记录当前的消费offset,然后每隔5s 向__consumer_offsets中提交offset。

手动提交

Kafka还提供了手动提交offset的API。 手动提交offset的方法有两种:分别是commitSync(同步提交)和commitAsync(异步提交)。两者的相同点是,都会将本次提交的一批数据最高的偏移量提交 ;不同点是,同步提交阻塞当前线程,一直到提交成功,并且会自动失败重试 ;而异步提交则没有失败重试机制,故有可能提交失败。

- commitSync(同步提交):必须等待offset提交完毕,再去消费下一批数据。

- commitAsync(异步提交) :发送完提交offset请求后,就开始消费下一批数据了。

此外,Kafka还提供了指定offset,指定时间的消费,这里不过多阐述。

消费者事务

重复消费:已经消费了数据,但是 offset 没提交。

漏消费:先提交 offset 后消费,有可能会造成数据的漏消费。

如何避免?这就需要消费者事务。Kafka消费端将消费过程和提交offset过程做原子绑定。

数据积压

- 如果是Kafka消费能力不足,则可以考虑增加Topic的分区数,并且同时提升消费组的消费者数量,消费者数 = 分区数。(两者缺一不可)

- 如果是下游的数据处理不及时:提高每批次拉取的数量。批次拉取数据过少(拉取数据/处理时间 < 生产速度), 使处理的数据小于生产的数据,也会造成数据积压。