MinIO 教程(三)| Spring Boot 集成 MinIO 高级篇(分片上传、加密与优化)

- 一、引言:从基础到生产级的进阶

- 二、大文件分片上传与断点续传(核心功能)

-

- [2.1 分片上传完整时序流程](#2.1 分片上传完整时序流程)

- [2.2 核心依赖与配置(新增+复用)](#2.2 核心依赖与配置(新增+复用))

-

- [2.2.1 新增Redis依赖(分片状态缓存)](#2.2.1 新增Redis依赖(分片状态缓存))

- [2.2.2 完整配置文件(application.yml)](#2.2.2 完整配置文件(application.yml))

- [2.3 核心代码实现(时序图步骤对应)](#2.3 核心代码实现(时序图步骤对应))

-

- [2.3.1 分片上传DTO(数据传输对象)](#2.3.1 分片上传DTO(数据传输对象))

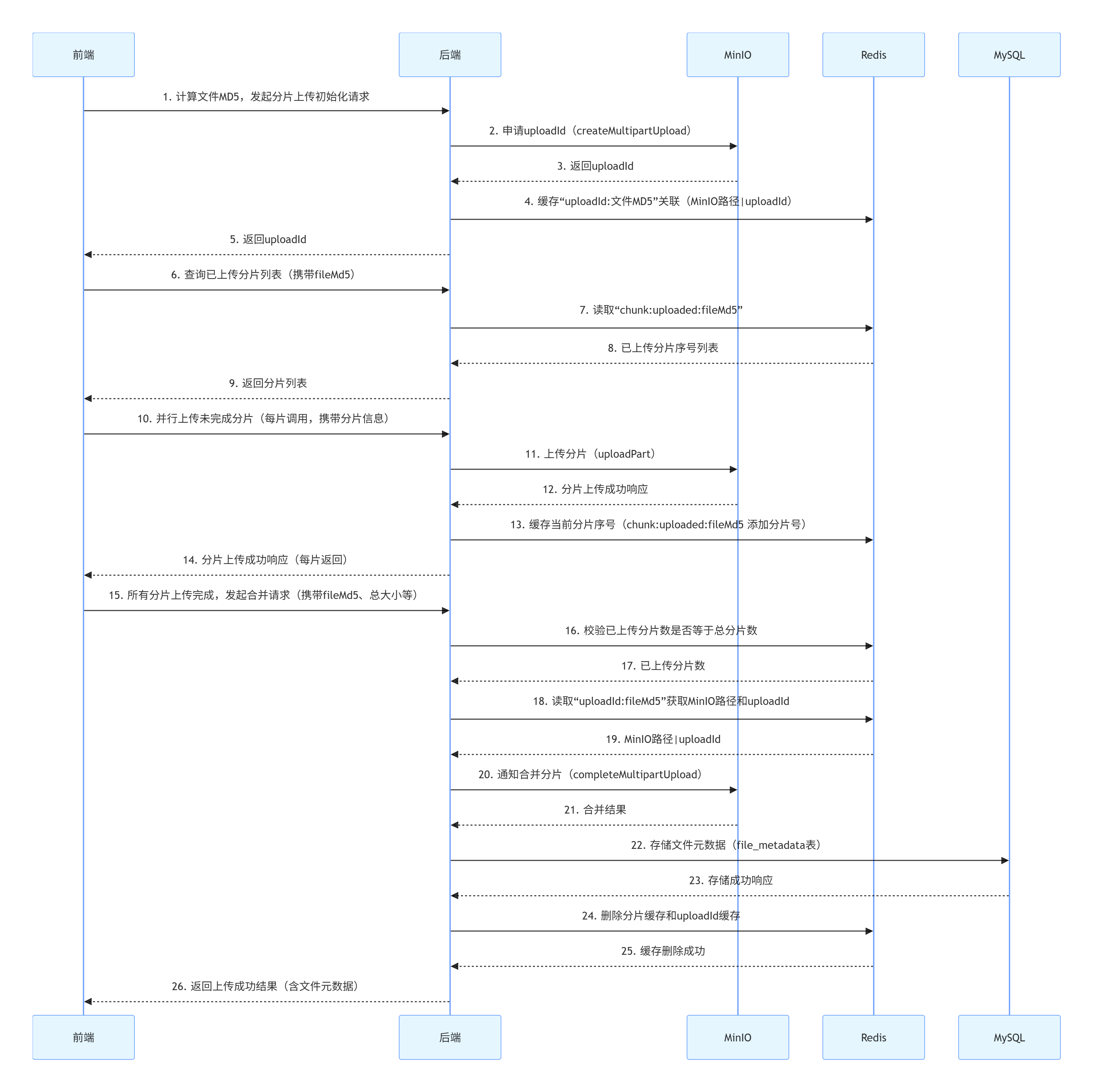

- [2.3.2 分片上传Service实现(时序图步骤2、4、8、11、13、16、18、20、22、24对应)](#2.3.2 分片上传Service实现(时序图步骤2、4、8、11、13、16、18、20、22、24对应))

- [2.3.3 分片上传Controller(时序图步骤1、6、10、15、26对应)](#2.3.3 分片上传Controller(时序图步骤1、6、10、15、26对应))

- [2.3.4 前端核心逻辑(时序图步骤1、3、5、7、15对应)](#2.3.4 前端核心逻辑(时序图步骤1、3、5、7、15对应))

- [2.4 关键注意事项](#2.4 关键注意事项)

- 三、文件加密实现(传输+存储双重保障)

-

- [3.1 传输加密:HTTPS配置(完整实操步骤)](#3.1 传输加密:HTTPS配置(完整实操步骤))

-

- [3.1.1 生成SSL证书(Windows环境)](#3.1.1 生成SSL证书(Windows环境))

- [3.1.2 MinIO启用HTTPS](#3.1.2 MinIO启用HTTPS)

- [3.1.3 Spring Boot适配HTTPS(MinIO客户端配置)](#3.1.3 Spring Boot适配HTTPS(MinIO客户端配置))

- [3.2 存储加密:MinIO服务端加密(SSE-S3)](#3.2 存储加密:MinIO服务端加密(SSE-S3))

-

- [3.2.1 启用存储桶加密(mc命令)](#3.2.1 启用存储桶加密(mc命令))

- [3.2.2 上传文件指定加密参数(代码调整)](#3.2.2 上传文件指定加密参数(代码调整))

- 四、性能优化方案(落地性强化)

- 五、测试验证(步骤标准化)

-

- [5.1 分片上传与断点续传测试(对应时序图全流程)](#5.1 分片上传与断点续传测试(对应时序图全流程))

- [5.2 加密验证](#5.2 加密验证)

- [5.3 性能测试](#5.3 性能测试)

- 六、生产部署注意事项(企业级补充)

- 七、小结

一、引言:从基础到生产级的进阶

在前两篇教程中,我们已完成MinIO环境搭建和Spring Boot基础文件操作(单文件/多文件上传、下载、删除),实现了文件管理的核心功能闭环。但面向生产环境,基础方案仍存在三大关键短板:

- 大文件上传瓶颈:GB级文件直接上传易触发超时、服务器内存溢出,且中断后需全量重传;

- 数据安全风险:文件传输过程易被窃听,存储环节存在明文泄露隐患;

- 性能体验不足:高并发场景下上传/下载响应慢,热门文件重复生成URL消耗资源。

本文聚焦生产级优化需求,基于基础篇项目架构,通过分片上传与断点续传 、传输+存储双重加密 、性能优化方案 ,结合下方26步完整时序图,形成可直接落地的企业级文件管理解决方案。

二、大文件分片上传与断点续传(核心功能)

2.1 分片上传完整时序流程

以下是分片上传从"初始化"到"最终完成"的26步连续时序图,清晰呈现前后端、Redis、MinIO、MySQL的全链路交互逻辑:

2.2 核心依赖与配置(新增+复用)

2.2.1 新增Redis依赖(分片状态缓存)

xml

<!-- Redis(用于断点续传缓存分片信息、uploadId关联) -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>2.2.2 完整配置文件(application.yml)

yaml

spring:

# 复用基础篇MySQL配置

datasource:

driver-class-name: com.mysql.cj.jdbc.Driver

url: jdbc:mysql://localhost:3306/minio_db?useUnicode=true&characterEncoding=utf8&serverTimezone=Asia/Shanghai

username: root

password: root

# 新增Redis配置

redis:

host: localhost

port: 6379

password: # 无密码留空

timeout: 3000ms # 连接超时

lettuce:

pool:

max-active: 16 # 连接池最大活跃数

# MinIO配置(优化超时参数,适配大文件)

minio:

endpoint: http://localhost:9000 # 后续HTTPS配置会改为https://localhost:9000

access-key: minio-dev

secret-key: Minio@123456

bucket-name: file-storage-bucket # 复用基础篇创建的存储桶

secure: false # 初始为HTTP,HTTPS启用后改为true

region: us-east-1

connect-timeout: 10000 # 连接超时10秒(默认5秒,大文件需延长)

write-timeout: 300000 # 写入超时5分钟(分片上传耗时较长)

read-timeout: 180000 # 读取超时3分钟(大文件下载)

# 自定义分片上传配置

file:

chunk:

size: 5242880 # 分片大小(5MB = 5*1024*1024字节)

expire: 86400 # 分片缓存过期时间(24小时,防止缓存堆积)2.3 核心代码实现(时序图步骤对应)

2.3.1 分片上传DTO(数据传输对象)

java

package com.example.miniodemo.dto;

import lombok.Data;

import org.springframework.web.multipart.MultipartFile;

/**

* 分片上传请求参数

* 对应时序图步骤5、10、15的参数载体

*/

@Data

public class ChunkUploadDTO {

private String fileMd5; // 步骤1:前端计算的文件唯一MD5

private Integer chunkNumber; // 步骤10:当前分片序号

private Integer totalChunks; // 步骤10:总分片数

private MultipartFile file; // 步骤10:当前分片文件流

private String fileName; // 步骤1:原始文件名

}2.3.2 分片上传Service实现(时序图步骤2、4、8、11、13、16、18、20、22、24对应)

java

package com.example.miniodemo.service;

import cn.hutool.core.io.FileUtil;

import cn.hutool.core.util.IdUtil;

import com.example.miniodemo.dto.ChunkUploadDTO;

import com.example.miniodemo.entity.FileMetadata;

import com.example.miniodemo.mapper.FileMetadataMapper;

import io.minio.*;

import io.minio.http.Method;

import io.minio.messages.Part;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.stereotype.Service;

import javax.annotation.Resource;

import java.time.LocalDate;

import java.time.format.DateTimeFormatter;

import java.util.ArrayList;

import java.util.List;

import java.util.concurrent.TimeUnit;

/**

* 高级文件服务(分片上传、加密、性能优化相关)

* 依赖说明:复用基础篇MinIO客户端、FileMetadata实体和Mapper

*/

@Service

public class AdvancedFileService {

@Resource

private MinioClient minioClient; // 复用基础篇配置的单例MinIO客户端

@Resource

private FileMetadataMapper fileMetadataMapper; // 复用基础篇数据访问层

@Resource

private RedisTemplate<String, Object> redisTemplate; // 新增Redis操作模板

// 配置参数注入(从application.yml读取)

@Value("${minio.bucket-name}")

private String bucketName;

@Value("${file.chunk.size}")

private long chunkSize;

@Value("${file.chunk.expire}")

private long chunkExpire;

// Redis键前缀(统一命名规范,避免缓存键冲突)

private static final String CHUNK_UPLOADED_PREFIX = "chunk:uploaded:"; // 步骤8、13、16、24:已上传分片列表

private static final String UPLOAD_ID_PREFIX = "chunk:uploadId:"; // 步骤4、18、24:uploadId与文件路径关联

/**

* 步骤2:初始化分片上传,申请uploadId

* 核心作用:向MinIO申请分片上传会话(获取uploadId),关联文件MD5与存储路径

*/

public String initMultipartUpload(String fileMd5, String fileName) {

try {

// 生成MinIO存储路径(复用基础篇命名规则:日期目录+UUID文件名)

String suffix = FileUtil.extName(fileName); // 提取文件后缀

String uniqueFileName = IdUtil.simpleUUID() + "." + suffix; // 避免文件名冲突

String dateDir = LocalDate.now().format(DateTimeFormatter.ofPattern("yyyy/MM/dd"));

String minioPath = dateDir + "/" + uniqueFileName;

// 步骤2:向MinIO申请分片上传ID(uploadId是分片上传的唯一会话标识)

CreateMultipartUploadResponse response = minioClient.createMultipartUpload(

CreateMultipartUploadArgs.builder()

.bucket(bucketName)

.object(minioPath)

.build()

);

String uploadId = response.uploadId();

// 步骤4:缓存文件MD5与uploadId、存储路径的关联(后续分片上传/合并需用到)

redisTemplate.opsForValue().set(

UPLOAD_ID_PREFIX + fileMd5,

minioPath + "|" + uploadId, // 格式:minio路径|uploadId

chunkExpire, TimeUnit.SECONDS

);

return uploadId;

} catch (Exception e) {

throw new RuntimeException("分片上传初始化失败(步骤2):" + e.getMessage(), e);

}

}

/**

* 步骤11:上传分片

* 核心作用:接收前端分片,上传到MinIO对应会话,记录已上传分片状态

*/

public void uploadChunk(ChunkUploadDTO dto) {

try {

String fileMd5 = dto.getFileMd5();

Integer chunkNumber = dto.getChunkNumber();

// 校验分片上传是否已初始化(步骤4的关联是否存在)

String uploadInfo = (String) redisTemplate.opsForValue().get(UPLOAD_ID_PREFIX + fileMd5);

if (uploadInfo == null) {

throw new RuntimeException("未初始化分片上传(步骤4缺失),请先调用init接口");

}

String[] infoArr = uploadInfo.split("\\|");

String minioPath = infoArr[0];

String uploadId = infoArr[1];

// 步骤11:上传当前分片到MinIO(stream直接传输,避免加载到内存)

UploadPartResponse response = minioClient.uploadPart(

UploadPartArgs.builder()

.bucket(bucketName)

.object(minioPath)

.uploadId(uploadId)

.partNumber(chunkNumber) // 分片序号(MinIO要求从1开始,需与前端一致)

.stream(dto.getFile().getInputStream(), dto.getFile().getSize(), -1) // 流处理,无缓冲区限制

.build()

);

// 步骤13:记录已上传分片(Redis Set存储,自动去重,避免重复上传同一分片)

String uploadedKey = CHUNK_UPLOADED_PREFIX + fileMd5;

redisTemplate.opsForSet().add(uploadedKey, chunkNumber);

redisTemplate.expire(uploadedKey, chunkExpire, TimeUnit.SECONDS);

} catch (Exception e) {

throw new RuntimeException("分片" + dto.getChunkNumber() + "上传失败(步骤11):" + e.getMessage(), e);

}

}

/**

* 步骤20:合并分片(完成文件上传)

* 核心作用:校验所有分片是否完整,通知MinIO合并,同步元数据到数据库

*/

public FileMetadata completeMultipartUpload(String fileMd5, String fileName, Long totalSize) {

try {

// 步骤16:校验所有分片是否上传完成(核心校验,避免合并不完整文件)

String uploadedKey = CHUNK_UPLOADED_PREFIX + fileMd5;

Long uploadedChunkCount = redisTemplate.opsForSet().size(uploadedKey);

Integer totalChunkNum = (int) Math.ceil(totalSize * 1.0 / chunkSize); // 计算理论总分片数

if (uploadedChunkCount == null || uploadedChunkCount != totalChunkNum) {

throw new RuntimeException("分片未全部上传(步骤16校验失败),已传:" + uploadedChunkCount + ",需传:" + totalChunkNum);

}

// 步骤18:获取缓存的uploadId和存储路径

String uploadInfo = (String) redisTemplate.opsForValue().get(UPLOAD_ID_PREFIX + fileMd5);

String[] infoArr = uploadInfo.split("\\|");

String minioPath = infoArr[0];

String uploadId = infoArr[1];

// 步骤20:准备分片列表(MinIO合并需按序号排序,确保文件完整性)

List<Part> partList = new ArrayList<>();

for (int i = 1; i <= totalChunkNum; i++) {

partList.add(new Part(i));

}

// 步骤20:通知MinIO合并分片为完整文件

minioClient.completeMultipartUpload(

CompleteMultipartUploadArgs.builder()

.bucket(bucketName)

.object(minioPath)

.uploadId(uploadId)

.parts(partList)

.build()

);

// 步骤22:复用基础篇逻辑,存储文件元数据到MySQL

FileMetadata metadata = new FileMetadata();

metadata.setFileOriginalName(fileName);

metadata.setFileName(FileUtil.getName(minioPath));

metadata.setMinioPath(minioPath);

metadata.setFileSize(totalSize);

metadata.setFileType(FileUtil.getMimeType(fileName)); // 自动推断文件MIME类型

metadata.setFileMd5(fileMd5);

metadata.setStorageBucket(bucketName);

fileMetadataMapper.insert(metadata);

// 步骤24:清理Redis缓存(上传完成后释放资源,避免缓存冗余)

redisTemplate.delete(uploadedKey);

redisTemplate.delete(UPLOAD_ID_PREFIX + fileMd5);

return metadata;

} catch (Exception e) {

throw new RuntimeException("分片合并失败(步骤20):" + e.getMessage(), e);

}

}

/**

* 步骤8:查询已上传分片(断点续传核心)

* 核心作用:前端重新上传时,跳过已完成分片,仅传未完成部分

*/

public List<Integer> getUploadedChunks(String fileMd5) {

String uploadedKey = CHUNK_UPLOADED_PREFIX + fileMd5;

// Redis Set转List,返回已上传分片序号

return redisTemplate.opsForSet().members(uploadedKey)

.stream()

.map(obj -> (Integer) obj)

.sorted() // 排序后返回,方便前端处理

.toList();

}

/**

* 性能优化:热门文件URL缓存(新增接口)

* 核心作用:缓存频繁访问文件的预签名URL,减少MinIO请求压力

*/

public String getCachedPreviewUrl(Long fileId) {

FileMetadata metadata = fileMetadataMapper.selectById(fileId);

if (metadata == null) {

throw new RuntimeException("文件不存在");

}

String cacheKey = "file:preview:url:" + fileId;

// 先查Redis缓存,命中直接返回

String cachedUrl = (String) redisTemplate.opsForValue().get(cacheKey);

if (cachedUrl != null) {

return cachedUrl;

}

// 缓存未命中,生成预签名URL(有效期30分钟)

try {

String previewUrl = minioClient.getPresignedObjectUrl(

GetPresignedObjectUrlArgs.builder()

.method(Method.GET)

.bucket(metadata.getStorageBucket())

.object(metadata.getMinioPath())

.expiry(30, TimeUnit.MINUTES)

.build()

);

// 缓存URL(有效期比预签名短5分钟,避免缓存URL过期)

redisTemplate.opsForValue().set(cacheKey, previewUrl, 25, TimeUnit.MINUTES);

return previewUrl;

} catch (Exception e) {

throw new RuntimeException("生成文件预览URL失败:" + e.getMessage(), e);

}

}

}2.3.3 分片上传Controller(时序图步骤1、6、10、15、26对应)

java

package com.example.miniodemo.controller;

import com.example.miniodemo.dto.ChunkUploadDTO;

import com.example.miniodemo.entity.FileMetadata;

import com.example.miniodemo.service.AdvancedFileService;

import com.example.miniodemo.vo.ResultVO;

import io.swagger.annotations.Api;

import io.swagger.annotations.ApiOperation;

import org.springframework.web.bind.annotation.*;

import javax.annotation.Resource;

import java.util.List;

/**

* 高级文件操作控制器

* 接口路径规范:/api/file/advanced/xxx,与基础篇接口区分隔离

*/

@RestController

@RequestMapping("/api/file/advanced")

@Api(tags = "高级文件操作接口", description = "分片上传、断点续传、加密文件操作等")

public class AdvancedFileController {

@Resource

private AdvancedFileService advancedFileService;

@PostMapping("/chunk/init")

@ApiOperation("步骤1:初始化分片上传")

public ResultVO<String> initChunkUpload(

@RequestParam String fileMd5,

@RequestParam String fileName

) {

String uploadId = advancedFileService.initMultipartUpload(fileMd5, fileName);

return ResultVO.success("分片上传初始化成功(步骤5返回uploadId)", uploadId);

}

@PostMapping("/chunk/upload")

@ApiOperation("步骤10:上传分片")

public ResultVO<Void> uploadChunk(ChunkUploadDTO dto) {

advancedFileService.uploadChunk(dto);

return ResultVO.success("分片上传成功(步骤14返回响应)", null);

}

@PostMapping("/chunk/complete")

@ApiOperation("步骤15:合并分片(完成文件上传)")

public ResultVO<FileMetadata> completeChunk(

@RequestParam String fileMd5,

@RequestParam String fileName,

@RequestParam Long totalSize

) {

FileMetadata metadata = advancedFileService.completeMultipartUpload(fileMd5, fileName, totalSize);

return ResultVO.success("文件上传完成(步骤26返回结果)", metadata);

}

@GetMapping("/chunk/uploaded")

@ApiOperation("步骤6:查询已上传分片(断点续传用)")

public ResultVO<List<Integer>> getUploadedChunks(@RequestParam String fileMd5) {

List<Integer> uploadedChunks = advancedFileService.getUploadedChunks(fileMd5);

return ResultVO.success("已上传分片查询成功(步骤9返回列表)", uploadedChunks);

}

@GetMapping("/preview/cached/{fileId}")

@ApiOperation("获取缓存的文件预览URL(性能优化)")

public ResultVO<String> getCachedPreviewUrl(@PathVariable Long fileId) {

String previewUrl = advancedFileService.getCachedPreviewUrl(fileId);

return ResultVO.success("预览URL获取成功", previewUrl);

}

}2.3.4 前端核心逻辑(时序图步骤1、3、5、7、15对应)

javascript

/**

* 分片上传前端核心逻辑(JavaScript,适配Chrome/Firefox)

* 依赖:需引入spark-md5.min.js计算文件MD5(https://cdn.bootcdn.net/ajax/libs/spark-md5/3.0.2/spark-md5.min.js)

*/

async function uploadLargeFile(file) {

const chunkSize = 5 * 1024 * 1024; // 与后端配置一致(5MB/分片)

const totalChunks = Math.ceil(file.size / chunkSize); // 总分片数

let fileMd5 = "";

try {

// 步骤1:计算文件MD5(唯一标识文件,用于断点续传和分片关联)

fileMd5 = await calculateFileMd5(file);

console.log("文件MD5:", fileMd5);

// 步骤1:发起初始化请求,步骤5接收uploadId

const initResponse = await fetch("/api/file/advanced/chunk/init", {

method: "POST",

headers: { "Content-Type": "application/x-www-form-urlencoded" },

body: new URLSearchParams({ fileMd5, fileName: file.name })

});

const initResult = await initResponse.json();

if (initResult.code !== 200) throw new Error(initResult.msg);

const uploadId = initResult.data;

console.log("分片上传初始化成功,uploadId:", uploadId);

// 步骤3:查询已上传分片,步骤9接收分片列表

const uploadedResponse = await fetch(`/api/file/advanced/chunk/uploaded?fileMd5=${fileMd5}`);

const uploadedResult = await uploadedResponse.json();

const uploadedChunks = uploadedResult.data || [];

console.log("已上传分片:", uploadedChunks);

// 步骤5:并行上传未完成的分片(控制并发数为3)

const uploadPromises = [];

for (let i = 1; i <= totalChunks; i++) {

if (uploadedChunks.includes(i)) continue; // 跳过已上传分片

// 切割当前分片

const start = (i - 1) * chunkSize;

const end = Math.min(start + chunkSize, file.size);

const chunk = file.slice(start, end);

// 构造表单数据

const formData = new FormData();

formData.append("fileMd5", fileMd5);

formData.append("chunkNumber", i);

formData.append("totalChunks", totalChunks);

formData.append("fileName", file.name);

formData.append("file", chunk);

// 加入上传队列(控制并发)

uploadPromises.push(

fetch("/api/file/advanced/chunk/upload", {

method: "POST",

body: formData

}).then(res => {

if (!res.ok) throw new Error(`分片${i}上传失败`);

console.log(`分片${i}/${totalChunks}上传成功`);

})

);

// 控制并发数:每3个分片一批,完成后再继续

if (uploadPromises.length >= 3) {

await Promise.all(uploadPromises);

uploadPromises.length = 0; // 清空队列

}

}

// 处理剩余未上传的分片

if (uploadPromises.length > 0) {

await Promise.all(uploadPromises);

}

// 步骤15:所有分片上传完成,发起合并请求

const completeResponse = await fetch("/api/file/advanced/chunk/complete", {

method: "POST",

headers: { "Content-Type": "application/x-www-form-urlencoded" },

body: new URLSearchParams({

fileMd5,

fileName: file.name,

totalSize: file.size

})

});

const completeResult = await completeResponse.json();

if (completeResult.code !== 200) throw new Error(completeResult.msg);

console.log("文件上传完成,元数据:", completeResult.data);

alert("大文件上传成功!");

} catch (error) {

console.error("文件上传失败:", error);

alert("上传失败:" + error.message);

}

}

/**

* 计算文件MD5(大文件分片计算,避免内存溢出)

*/

function calculateFileMd5(file) {

return new Promise((resolve, reject) => {

const chunkSize = 2 * 1024 * 1024; // 2MB/块计算MD5

const spark = new SparkMD5.ArrayBuffer();

const fileReader = new FileReader();

let offset = 0;

fileReader.onload = function (e) {

spark.append(e.target.result);

offset += chunkSize;

if (offset < file.size) {

readNextChunk(); // 继续读取下一块

} else {

resolve(spark.end()); // 计算完成,返回MD5

}

};

fileReader.onerror = function (error) {

reject("MD5计算失败:" + error.message);

};

function readNextChunk() {

const start = offset;

const end = Math.min(start + chunkSize, file.size);

fileReader.readAsArrayBuffer(file.slice(start, end));

}

// 开始读取第一块

readNextChunk();

});

}

// 页面使用示例:绑定文件选择控件

document.getElementById("fileInput").addEventListener("change", function (e) {

const file = e.target.files[0];

if (file) {

uploadLargeFile(file);

}

});2.4 关键注意事项

- 分片大小建议:5MB~10MB为宜,过小会增加请求次数,过大易导致单分片上传超时;

- MD5计算:前端需确保文件MD5计算准确性,否则会导致分片与文件不匹配;

- 并发控制:前端建议控制分片上传并发数(3~5个),避免服务器压力过大;

- 缓存有效期:Redis中分片状态和uploadId的缓存时间需与业务场景匹配,避免过早过期导致上传失败。

三、文件加密实现(传输+存储双重保障)

3.1 传输加密:HTTPS配置(完整实操步骤)

3.1.1 生成SSL证书(Windows环境)

- 安装OpenSSL(推荐Win64OpenSSL-3.0.11.exe,下载地址:https://slproweb.com/products/Win32OpenSSL.html);

- 配置OpenSSL环境变量:将安装目录下的

bin文件夹路径(如C:\Program Files\OpenSSL-Win64\bin)添加到系统环境变量Path; - 打开CMD,执行以下命令生成自签名证书(生产环境需替换为CA颁发的证书):

cmd

# 1. 生成RSA私钥(2048位,无加密)

openssl genrsa -out private.key 2048

# 2. 生成证书签名请求(CSR),按提示输入信息(可直接回车默认)

openssl req -new -key private.key -out cert.csr

# 3. 生成自签名证书(有效期365天,public.crt为证书文件)

openssl x509 -req -days 365 -in cert.csr -signkey private.key -out public.crt3.1.2 MinIO启用HTTPS

- 创建MinIO证书目录:在MinIO安装目录下新建

certs文件夹,将生成的private.key和public.crt放入; - 重启MinIO服务(指定HTTPS端口,需重新设置环境变量):

cmd

# 设置MinIO账号密码(与基础篇一致)

set MINIO_ROOT_USER=minio-dev

set MINIO_ROOT_PASSWORD=Minio@123456

# 启动MinIO,启用HTTPS(--tls参数)

minio.exe server D:\minio-data --console-address ":9001" --address ":9000" --tls- 验证:访问

https://localhost:9001(控制台),浏览器显示"安全连接"即生效。

3.1.3 Spring Boot适配HTTPS(MinIO客户端配置)

修改application.yml中MinIO配置:

yaml

minio:

endpoint: https://localhost:9000 # 改为HTTPS地址

secure: true # 启用HTTPS

# 其他配置不变...更新MinioConfig配置类(添加SSL证书信任,开发环境用):

java

import io.minio.MinioClient;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import javax.net.ssl.SSLContext;

import javax.net.ssl.TrustManager;

import javax.net.ssl.X509TrustManager;

import java.security.cert.X509Certificate;

@Configuration

public class MinioConfig {

@Value("${minio.endpoint}")

private String endpoint;

@Value("${minio.access-key}")

private String accessKey;

@Value("${minio.secret-key}")

private String secretKey;

@Value("${minio.connect-timeout}")

private long connectTimeout;

@Value("${minio.write-timeout}")

private long writeTimeout;

@Value("${minio.read-timeout}")

private long readTimeout;

@Bean

public MinioClient minioClient() throws Exception {

// 开发环境:信任所有SSL证书(生产环境需配置信任CA证书,移除以下代码)

SSLContext sslContext = SSLContext.getInstance("TLS");

sslContext.init(null, new TrustManager[]{new X509TrustManager() {

@Override

public void checkClientTrusted(X509Certificate[] certs, String authType) {}

@Override

public void checkServerTrusted(X509Certificate[] certs, String authType) {}

@Override

public X509Certificate[] getAcceptedIssuers() { return new X509Certificate[0]; }

}}, new java.security.SecureRandom());

// 构建MinIO客户端(添加SSL上下文)

return MinioClient.builder()

.endpoint(endpoint)

.credentials(accessKey, secretKey)

.sslContext(sslContext) // 应用SSL配置

.connectionTimeout(connectTimeout)

.writeTimeout(writeTimeout)

.readTimeout(readTimeout)

.build();

}

}3.2 存储加密:MinIO服务端加密(SSE-S3)

3.2.1 启用存储桶加密(mc命令)

- 确保已安装MinIO客户端

mc(参考基础篇:https://min.io/docs/minio/linux/reference/minio-mc.html); - 执行以下命令为存储桶启用SSE-S3加密(自动加密存储文件):

cmd

# 1. 配置MinIO服务连接(my-minio为自定义别名)

mc config host add my-minio https://localhost:9000 minio-dev Minio@123456 --api S3v4

# 2. 为存储桶启用服务器端加密

mc encrypt set sse-s3 my-minio/file-storage-bucket

# 3. 验证加密配置

mc encrypt info my-minio/file-storage-bucket3.2.2 上传文件指定加密参数(代码调整)

在分片上传初始化接口中添加加密配置,确保文件存储时自动加密:

java

// 修改initMultipartUpload方法中的CreateMultipartUploadArgs配置

CreateMultipartUploadResponse response = minioClient.createMultipartUpload(

CreateMultipartUploadArgs.builder()

.bucket(bucketName)

.object(minioPath)

.sseEncryption(SseEncryption.sseS3()) // 启用SSE-S3存储加密

.build()

);四、性能优化方案(落地性强化)

4.1 连接超时优化(已集成到配置文件)

核心优化点:延长MinIO客户端连接、读写超时时间,适配大文件分片上传/下载场景,避免因超时导致操作失败。

4.2 内存优化:流式处理杜绝OOM

核心原则

- 所有文件操作(上传/下载)均使用

InputStream/OutputStream直接传输,禁止将文件转为byte[]加载到内存; - 示例对比:

java

// 错误示例(大文件会导致内存溢出OOM)

byte[] fileBytes = dto.getFile().getBytes(); // 绝对禁止!

minioClient.uploadPart(..., fileBytes, ...);

// 正确示例(流式传输,内存占用极低)

try (InputStream inputStream = dto.getFile().getInputStream()) {

minioClient.uploadPart(

UploadPartArgs.builder()

...

.stream(inputStream, dto.getFile().getSize(), -1)

...

.build()

);

}4.3 热门文件URL缓存(已实现接口)

优化逻辑

- 对高频访问文件(如用户头像、公共文档),缓存其MinIO预签名URL;

- 缓存有效期设置为25分钟,短于预签名URL的30分钟有效期,避免缓存URL过期失效;

- 减少MinIO服务端请求压力,提升接口响应速度(从Redis获取缓存URL耗时毫秒级)。

4.4 额外优化建议:分片上传并行优化

前端优化:通过控制并发数(3~5个)避免服务器压力过大;

后端优化:开启MinIO服务端多线程处理,提升分片接收、合并效率(MinIO集群部署后效果更明显)。

五、测试验证(步骤标准化)

5.1 分片上传与断点续传测试(对应时序图全流程)

- 准备1个1GB视频文件,通过前端页面发起上传(执行步骤1-26);

- 上传过程中手动关闭浏览器,模拟上传中断;

- 重新打开页面,选择同一文件,验证断点续传:仅上传未完成分片(步骤3-9跳过已传分片),无需重新上传整个文件;

- 上传完成后,通过MinIO控制台查看文件是否完整,下载后验证可正常播放。

5.2 加密验证

- 传输加密:访问

https://localhost:9000,浏览器地址栏显示"锁形"安全标识; - 存储加密:进入MinIO数据目录(

D:\minio-data\file-storage-bucket),用记事本打开已上传文件,内容为加密乱码,无法直接读取。

5.3 性能测试

- 并发上传测试:用JMeter模拟10个用户同时上传500MB文件,观察服务器CPU、内存占用(正常应无明显飙升);

- 缓存效果测试:多次访问同一热门文件预览URL,首次响应时间约100ms,后续从缓存获取响应时间≤10ms。

六、生产部署注意事项(企业级补充)

- MinIO集群化部署:生产环境需部署至少4节点MinIO集群,确保高可用,避免单点故障;参考文档:https://min.io/docs/minio/linux/operations/install-deploy-manage/deploy-minio-cluster.html

- SSL证书规范:使用可信CA机构颁发的SSL证书(如Let's Encrypt、阿里云SSL),替代自签名证书,避免浏览器/客户端信任问题;

- Redis高可用:开启Redis持久化(RDB+AOF混合模式),部署Redis主从集群,防止分片状态缓存丢失导致上传失败;

- 监控告警:集成Prometheus+Grafana监控MinIO集群(磁盘使用率、IOPS、上传成功率),设置告警阈值(如磁盘使用率≥85%告警);

- 日志排查:开启MinIO和Spring Boot详细日志,便于定位上传失败、加密异常等问题。

七、小结

本文基于基础篇项目架构,通过26步连续时序图清晰呈现分片上传全链路逻辑,完成了生产级文件管理系统的核心优化:

- 分片上传与断点续传:解决大文件上传超时、中断重传痛点,提升用户体验;

- 传输+存储加密:通过HTTPS和SSE-S3加密,保障文件在传输和存储环节的安全性;

- 性能优化:通过超时配置、流式处理、URL缓存等手段,提升系统稳定性和响应速度。

结合前两篇教程,从MinIO环境搭建→基础文件操作→高级功能优化,形成可直接落地的企业级文件管理解决方案,适配大文件、高并发、高安全场景需求。