作者:孙玉梅

注:本文数据都为模拟生成。

引言

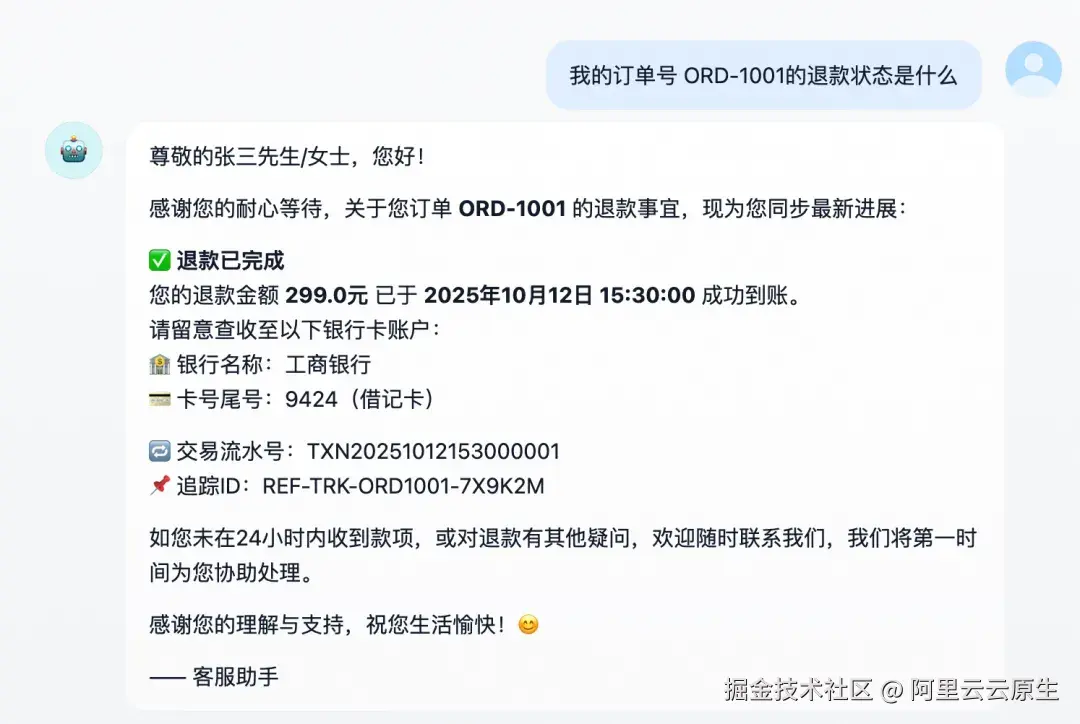

过去两年,电商客服、工单、物流等环节的自动化正急速推进。一个智能助手可以同时处理上百条退款请求、物流查询、账单追踪;它不知疲倦地与用户对话,也在后台不停调用接口、记录日志、汇总报表。在这些自动化交互中,隐藏着大量敏感数据:

- 用户咨询里可能出现手机号、订单号、收货地址;

- 后端业务日志中常常包含银行卡号、接口 IP、账户 ID;

- 工单流转过程中甚至会附带内部 Token、用户名。

这些信息若在系统内未经处理地流转、存储或导出,不仅违反数据最小化原则,更可能在调试、共享或导出日志时意外泄露。然而,现实场景中我们又无法简单地"少打日志"或"去掉字段"。日志是运维排障的工具,是运营分析的基础,也是安全审计的依据。

本文将以一个电商 Copilot Demo 为例,展示如何借助阿里云日志服务(SLS)的脱敏函数,在不改变业务逻辑的前提下,确保系统中的敏感数据隐私安全。

方案全景:智能化与数据安全的融合

整体设计

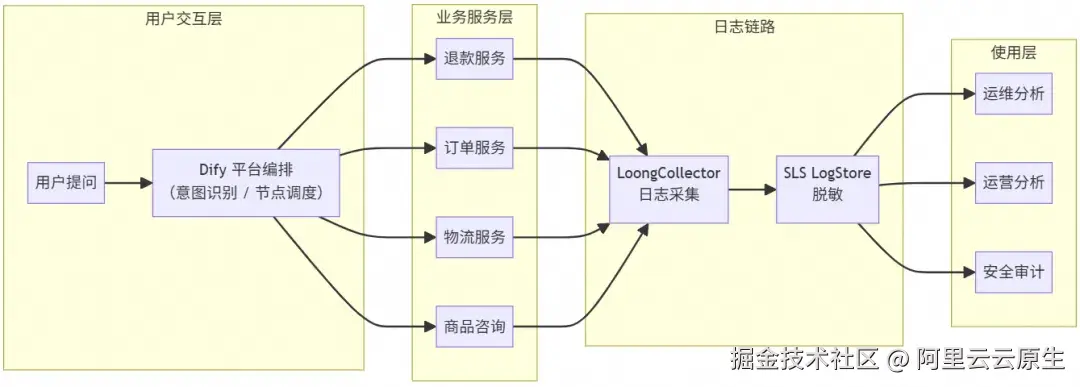

系统的上层编排由 Dify 平台完成,Dify 负责协调用户输入、意图识别、调用后端服务以及生成回复,是整个 Copilot 系统的中枢。

但在实践中发现一个关键问题,Dify 自身的数据链路观测并不细粒度,主要体现在:

- 平台主要提供节点级执行日志;

- 但对下游 API 调用、异常堆栈、耗时分布的观测有限;

- 出现故障时,Dify 内置日志往往不足以支撑排障与审计。

因此,选择在 Dify 服务部署侧通过 LoongCollector 采集服务日志,通过 LoongCollector 将日志统一推送到 SLS LogStore。

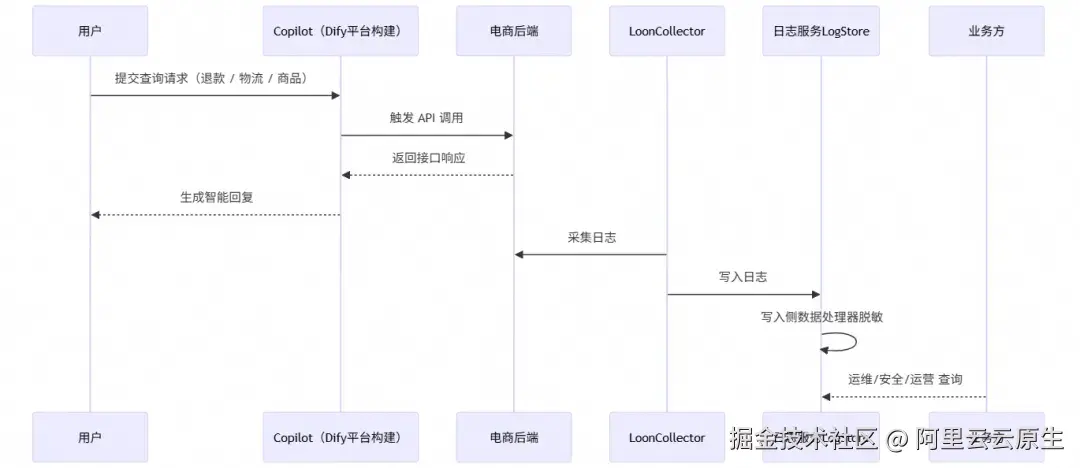

- 数据流: 采集来源统一,同时采集 Dify 编排日志、后端服务日志、系统标准输出,并以固定的日志格式输出,完整的数据流转时序图如下:

- 写入脱敏: 通过写入处理器配置 SPL 脱敏(mask)函数,确保敏感字段在入库时已被打码。

- 使用层: 不管是运维、运营或者安全同学,都可以基于脱敏的 Logstore 数据做可以做相关业务分析。

日志链路

数据采集

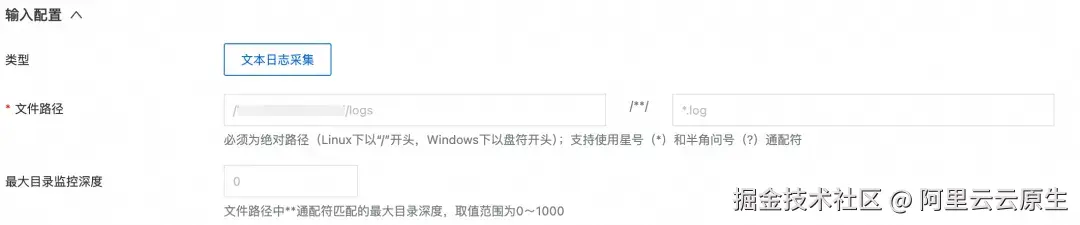

LoongCollector [ 1] 作为一款轻量级日志采集工具,支持采集主机文本日志、Kubernetes 集群容器日志、HTTP 数据等不同的数据源,当前 Copilot Demo 日志以 JSON 格式打印在主机日志目录中,此处接入单行文本日志即可:

配置日志所在的文件路径:

写入脱敏

SLS 提供的 mask(脱敏)函数,支持内置和关键字匹配两种模式,能高效、精准地识别并脱敏日志中的敏感信息:

- 内置匹配(buildin): mask 函数开箱即用,内置了对常见 6 种敏感信息(如手机号、身份证、邮箱、IP 地址、座机电话、银行卡号)的识别能力。

- 关键字匹配(keyword): 智能识别任意文本中符合 "key":"value"、'key':'value' 或 key=value 等常见 KV 对格式的敏感信息。

针对文中电商 copilot 日志,在对应的 project 中新建数据处理器(配置下图 SPL 配置),即可智能识别并对 IP 地址、邮箱等敏感内容进行脱敏。其中手机号、身份证号、信用卡号、姓名以及地址信息,定制化地保留前后缀。详细配置介绍可参见《无需复杂正则:SLS 新脱敏函数让隐私保护更简单高效》。

- 配置写入处理器使任务生效:选择待应用的 logstore,在写入处理器 tab 中应用上面新建的处理任务。

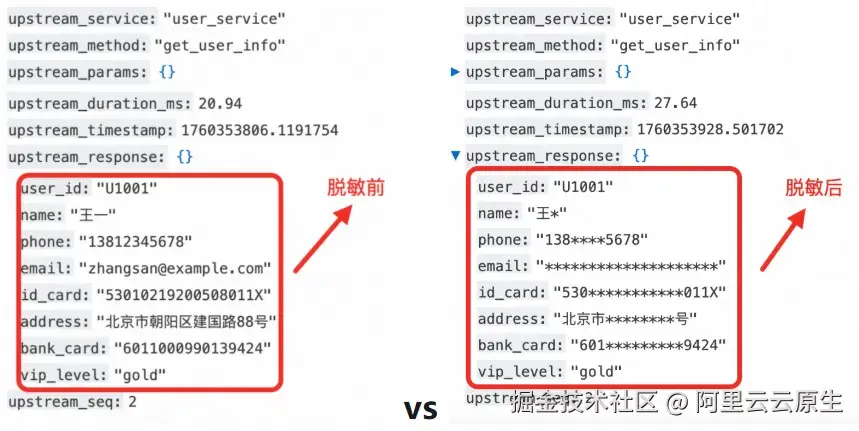

脱敏前后日志对比

对比脱敏前的数据可以看到:

- 按需保留,安全与可用性兼顾: 针对不同敏感字段,可定制化保留前后缀字符。手机号保留前三后四位,既保护了用户隐私,又方便运维人员进行问题排查和用户身份核验,在保障安全的同时兼顾了数据可用性。

- 配置极简,无需正则: 关键字匹配模式下,即使数据嵌套多层 JSON 结构,也只需配置最内层的 Key 即可精准匹配 Value 进行脱敏,同时无需编写复杂的正则表达式来兼容各种 key:value 对格式,大大降低了配置难度。

- 中文精准脱敏: 姓名与地址精确按照配置的规则进行打码,避免因编码问题导致脱敏失效。

此外,mask 函数相较于使用正则表达式进行脱敏,在性能上具有显著优势,可有效降低日志处理延迟,提升整体性能。尤其是在复杂或者数据量巨大的场景下,性能优势更为明显。

使用层日志分析

数据脱敏让同一份日志呈现出三种"视角":

- 运维看到调用链与性能瓶颈,却看不到隐私;

- 运营看到趋势、效率与体验,却看不到个体;

- 安全看到策略执行与留痕证据,却无需担心遗漏。

在这套体系中,数据不再是一座孤岛,而是一套有边界的智能资产,数据合规、分析、排障三者可以并行。

运维工程师:定位

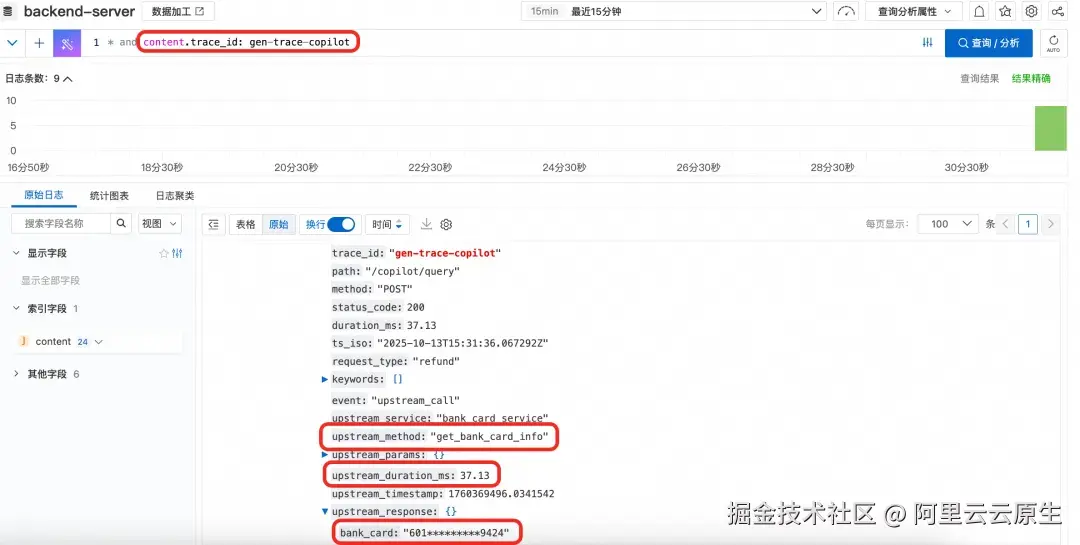

对于运维团队来说,以往排障往往依赖包含用户手机号、地址、账户号的明文日志,这在合规上存在高风险。现在,脱敏后的日志让这一过程从源头安全化,在问题定位场景中通过 trace_id 检索即可复原整个调用链:

- 从 Copilot 的意图识别开始;

- 到订单服务 → 退款服务 → 第三方支付网关;

- 再到返回结果与耗时。

需要核对用户身份时,日志里只保留了脱敏后的银行卡号、手机号等信息,足以和业务侧"同一用户"比对,而不会暴露原值。即便是跨团队协查,也能直接在脱敏日志上定位问题,避免泄露风险。

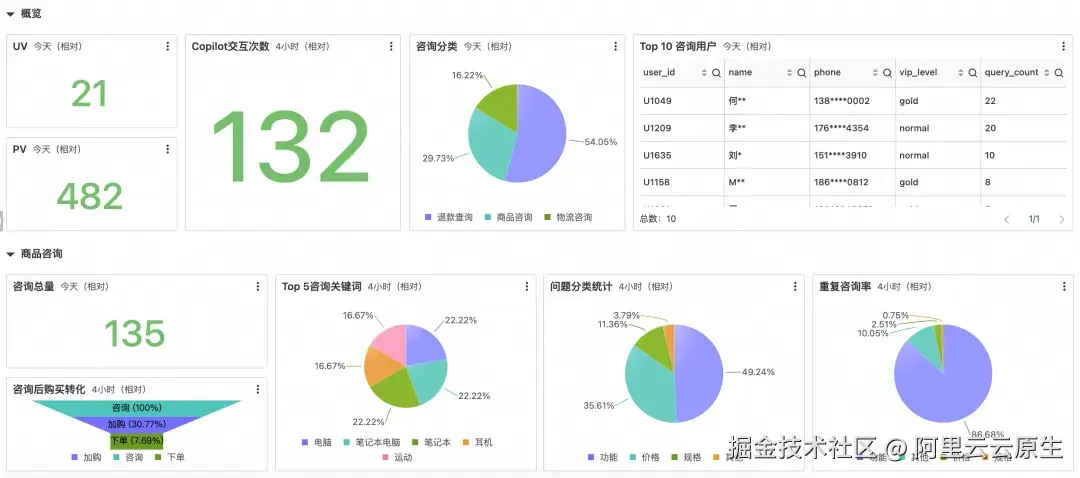

运营团队:分析

报表的价值在于发现整体趋势,而非窥探个人信息。在脱敏运营报表中,用户信息已匿名化处理,仅保留关键业务指标,助力团队从数据中挖掘洞察。

从这份报表中,运营团队可以快速了解:

- 整体概况:UV、PV 等关键指标,Copilot 交互次数,以及咨询总量,快速掌握运营概况。

- 咨询分类:退款、商品、物流咨询占比,清晰了解用户关注点。

- 问题分类:掌握用户提问的侧重点,如功能、价格、规格等。

- 重复咨询率:衡量服务质量,快速定位需要优化的环节。

- 用户行为:咨询后购买转化漏斗,以及热门咨询关键词,助力优化产品和营销策略。

- 重点用户:Top 10 咨询用户,虽然用户信息脱敏,但可通过 VIP 等级和咨询次数,制定差异化服务策略。

此外,报表中所有用户信息都经过脱敏处理,电话号码、姓名等个人信息均被掩码,确保无法反推到具体用户,充分保障用户隐私。

安全与合规团队:审计

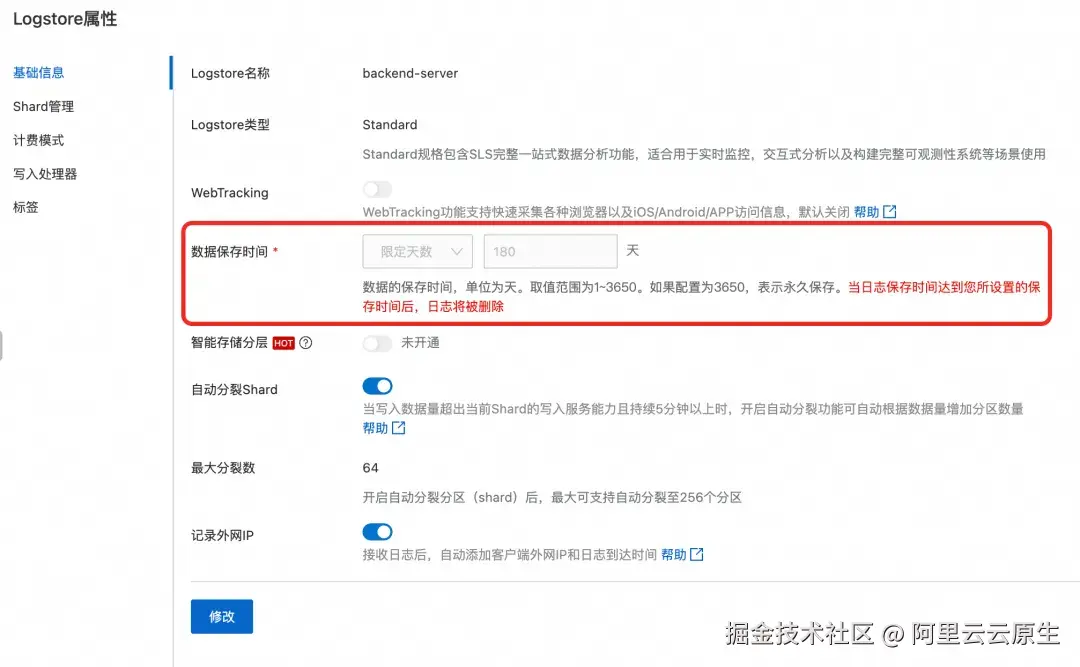

对安全与合规团队而言,日志的最大风险在于"存量明文"。本文中的脱敏方案将脱敏前置:数据在写入前已被处理,这从根本上消除了敏感数据脱敏覆盖不全与导出明文数据的可能。此外,SLS 还提供完善的合规支撑能力:

- 数据存储:支持自定义日志存储时间,对网络审计相关日志设置>180 天的存储天数,满足安全审计要求。

- 数据操作审计:日志使用过程中会存在用户级操作行为,这些不管是管控层面的控制台操作、OpenAPI 调用,或者数据面的业务日志使用,任何人查看、分析、导出日志,都只在授权范围内看到应当看到的内容。同时 CloudLens for SLS [ 2] 还提供 Project、Logstore 的资产使用监控。

小结

当 LoongCollector 的日志采集与 LogStore 的数据脱敏连成闭环,日志在落库同时完成安全转化。运维能定位,运营能分析,安全能审计。这不是一次性的加固,而是一条可复用的路径:写入侧脱敏 + 默认脱敏落库 + 角色化访问。以此为基线,企业能放心扩展 Copilot 的业务覆盖,让"效率红利"与"合规确定性"并行存在。

相关链接:

1\] LoongCollector [help.aliyun.com/zh/sls/what...](https://link.juejin.cn?target=https%3A%2F%2Fhelp.aliyun.com%2Fzh%2Fsls%2Fwhat-is-sls-loongcollector "https://help.aliyun.com/zh/sls/what-is-sls-loongcollector") \[2\] CloudLens for SLS [help.aliyun.com/zh/sls/clou...](https://link.juejin.cn?target=https%3A%2F%2Fhelp.aliyun.com%2Fzh%2Fsls%2Fcloudlens-for-sls%2F "https://help.aliyun.com/zh/sls/cloudlens-for-sls/")