音视频开发全景图:播放器是怎样炼成的

🎬 开场:点击播放按钮,究竟发生了什么?

想象一下,你打开一个视频播放器,点击播放按钮:

你点击 ▶️ → 等待 0.5 秒 → 画面出现 + 声音响起 ✨这 0.5 秒内,计算机做了什么?让我们揭开这层神秘面纱。

📦 第一站:视频文件里藏着什么?

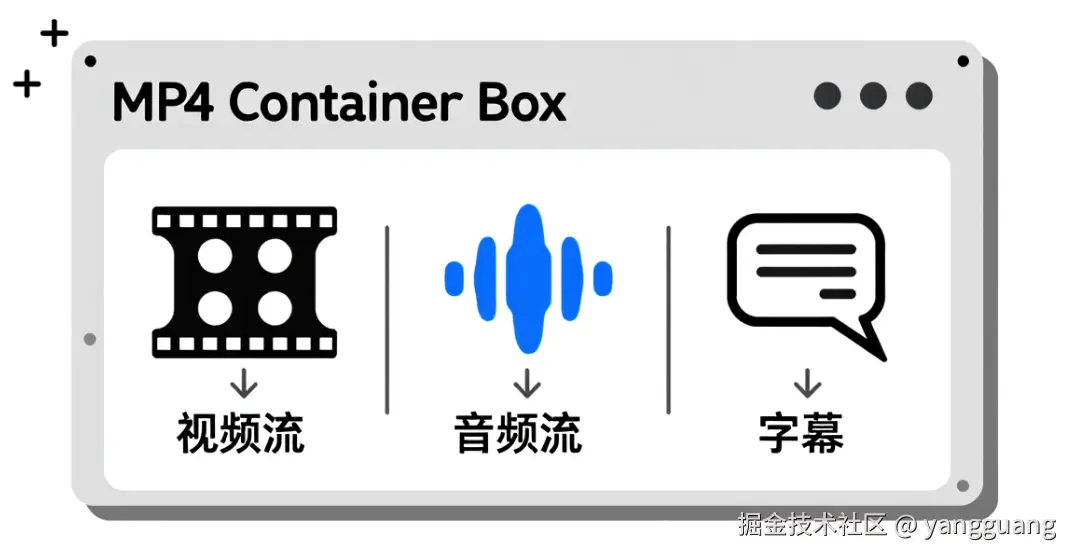

视频文件 ≠ 视频

关键认知 :一个 movie.mp4 文件,其实是一个"容器"(Container),里面装着:

- 🎥 视频流:一堆连续的图片(帧)

- 🔊 音频流:一段声音数据

- 📝 字幕流:文字信息(可选)

- ℹ️ 元数据:标题、作者、时长等

容器 vs 编码:两个容易混淆的概念

| 概念 | 作用 | 常见格式 | 类比 |

|---|---|---|---|

| 容器(Container) | 把视频、音频、字幕打包在一起 | MP4, MKV, AVI, FLV | 快递盒子 📦 |

| 编码(Codec) | 压缩视频/音频数据,减小体积 | H.264, H.265, AAC, MP3 | 压缩袋 🗜️ |

举个例子:

movie.mp4= MP4 容器 + H.264 视频编码 + AAC 音频编码video.mkv= MKV 容器 + H.265 视频编码 + FLAC 音频编码

为什么需要编码?

yaml

1 小时未压缩视频 = 1920×1080 × 30fps × 24bit × 3600s ≈ 500 GB 😱

1 小时 H.264 编码 = 1-2 GB ✅(压缩 250-500 倍!)🎞️ 第二站:播放器的完整管线

现在揭秘播放器的工作流程,一共 5 个关键步骤:

📊播放器管线流程图

graph LR A[视频文件

movie.mp4] --> B[解封装

Demuxer] B --> C[解码器

Decoder] C --> D[音视频同步

AVSync] D --> E[渲染显示

Renderer] style A fill:#e1f5ff style B fill:#fff3e0 style C fill:#f3e5f5 style D fill:#e8f5e9 style E fill:#fce4ec

步骤 1️⃣:解封装(Demux)

目标:把容器拆开,分离出视频流和音频流。

类比:把快递盒子拆开,把视频和音频分别取出来。

ini

输入: movie.mp4(容器)

输出:

- AVPacket(视频)[编码数据]

- AVPacket(音频)[编码数据]关键 API:

cpp

AVFormatContext* format_ctx; // 格式上下文

avformat_open_input(&format_ctx, "movie.mp4", NULL, NULL); // 打开文件

avformat_find_stream_info(format_ctx, NULL); // 探测流信息

av_read_frame(format_ctx, packet); // 读取数据包步骤 2️⃣:解码(Decode)

目标:把压缩的数据包解码成原始的图像/音频。

类比:把压缩袋里的衣服拿出来展开。

makefile

输入: AVPacket(H.264 编码数据,几 KB)

输出: AVFrame(YUV 图像,几 MB)为什么需要解码?

- 编码数据:无法直接显示,是一堆数学变换后的数字

- 解码数据:YUV/RGB 图像,可以直接渲染到屏幕

关键 API:

cpp

AVCodecContext* codec_ctx; // 解码器上下文

avcodec_send_packet(codec_ctx, packet); // 送入编码数据包

avcodec_receive_frame(codec_ctx, frame); // 接收解码后的帧📊 解码前后对比

步骤 3️⃣:音视频同步(A/V Sync)

目标:让画面和声音对得上。

类比:配音演员对口型,差一点都不行。

为什么会不同步?

- 视频解码快,音频解码慢 → 画面跑到前面了

- 视频帧率不稳定 → 有时快有时慢

解决方案 :以音频时钟为准(人耳对声音延迟更敏感)。

视频帧的 PTS(显示时间戳)= 2.5 秒

当前音频时钟 = 2.3 秒

→ 结论:这一帧太早了,等 0.2 秒再显示 ⏱️

步骤 4️⃣:渲染(Render)

目标:把 YUV 图像转换成 RGB,显示到屏幕。

类比:把胶片放到放映机,投影到银幕上。

makefile

输入: AVFrame(YUV420P 格式)

处理: YUV → RGB 颜色空间转换

输出: 屏幕显示(GPU 渲染)步骤 5️⃣:循环播放

播放器不是只播一帧就结束,而是不断循环:

cpp

while (playing) {

packet = demuxer.ReadPacket(); // 1. 读取数据包

frame = decoder.Decode(packet); // 2. 解码

sync.WaitUntilTime(frame.pts); // 3. 等待正确时机

renderer.Display(frame); // 4. 渲染显示

// 继续下一帧...

}graph TD

A[开始播放] --> B[读取数据包]

B --> C{解码成功?}

C -->|是| D[计算显示时机]

C -->|否| B

D --> E[渲染到屏幕]

E --> F{继续播放?}

F -->|是| B

F -->|否| G[停止]

🔍 实战:用 FFprobe 分析视频文件

FFprobe 是 FFmpeg 自带的工具,可以查看视频文件的详细信息。

安装 FFmpeg(如果未安装)

bash

# macOS

brew install ffmpeg

# Ubuntu

sudo apt install ffmpeg

# Windows

# 下载:https://ffmpeg.org/download.html命令 1:查看文件基本信息

bash

ffprobe -hide_banner movie.mp4输出示例:

less

Input #0, mov,mp4,m4a,3gp,3g2,mj2, from 'movie.mp4':

Duration: 00:02:15.50, start: 0.000000, bitrate: 2500 kb/s

Stream #0:0[0x1](und): Video: h264 (High) (avc1), yuv420p, 1920x1080, 2000 kb/s, 30 fps

Stream #0:1[0x2](und): Audio: aac (LC) (mp4a), 48000 Hz, stereo, fltp, 128 kb/s解读:

- 容器格式:MP4

- 时长:2 分 15 秒

- 视频流:H.264 编码,1920×1080 分辨率,30 fps

- 音频流:AAC 编码,48kHz 采样率,立体声

命令 2:查看详细流信息(JSON 格式)

bash

ffprobe -v quiet -print_format json -show_streams movie.mp4输出示例(节选):

json

{

"streams": [

{

"index": 0,

"codec_name": "h264",

"codec_type": "video",

"width": 1920,

"height": 1080,

"r_frame_rate": "30/1",

"avg_frame_rate": "30/1",

"time_base": "1/15360",

"duration_ts": 2073600,

"duration": "135.000000"

},

{

"index": 1,

"codec_name": "aac",

"codec_type": "audio",

"sample_rate": "48000",

"channels": 2,

"channel_layout": "stereo"

}

]

}关键字段:

codec_name:编码格式(h264 = H.264)time_base:时间基(用于计算 PTS)r_frame_rate:真实帧率(30 fps)sample_rate:音频采样率(48000 Hz = 48 kHz)

命令 3:提取第一帧图像

bash

ffmpeg -i movie.mp4 -vframes 1 -f image2 first_frame.jpg这会保存视频的第一帧为 first_frame.jpg,你可以打开看看解码后的图像长什么样。

🎯 小结:从点击到播放的完整旅程

让我们回顾一下完整流程:

markdown

1. 点击播放按钮

↓

2. Demuxer 打开文件,分离视频流和音频流

↓

3. VideoDecoder 解码视频包 → YUV 帧

AudioDecoder 解码音频包 → PCM 音频

↓

4. AVSyncController 对比音频时钟,决定何时显示视频帧

↓

5. Renderer 渲染 YUV 帧到屏幕

AudioPlayer 播放 PCM 音频到扬声器

↓

6. 循环步骤 2-5,直到文件播放完毕📊 完整流程时序图

sequenceDiagram participant User as 用户 participant Player as 播放器 participant Demuxer as 解封装 participant Decoder as 解码器 participant Sync as 同步器 participant Render as 渲染器 User->>Player: 点击播放 Player->>Demuxer: 打开文件 Demuxer-->>Player: 流信息 loop 每一帧 Player->>Demuxer: 读取 Packet Demuxer-->>Decoder: AVPacket Decoder->>Decoder: 解码 Decoder-->>Sync: AVFrame Sync->>Sync: 计算显示时机 Sync-->>Render: 显示帧 Render->>User: 画面+声音 end

📚 下一篇预告

下一篇《视频编码原理:为什么 1 小时电影只有几百 MB》,我们将深入探讨:

- 视频压缩的数学原理

- I/P/B 帧的含义

- GOP(关键帧间隔)的作用

- 码率与画质的平衡

敬请期待!🎬

🔗 相关资源

- ZenPlay 源码 :GitHub - zenplay

- FFmpeg 官方文档 :ffmpeg.org/documentati...

- 推荐阅读:雷霄骅的博客 - FFmpeg 源码分析系列