一、引子:直播,不只是传输

在绝大多数开发者眼中,"直播协议"意味着推流、播放、延迟与带宽。但从系统工程的视角看,协议并不仅仅是一个传输通道,而是 描述时间、状态与控制逻辑的系统契约。

每一种实时音视频协议,本质上都在回答三个底层问题:

-

时间如何被定义与同步 ------ RTP/RTCP 如何确保音视频帧的时序一致性;

-

数据如何被组织与传输 ------ Chunk、Interleaved RTP、PS 流等封装格式如何映射到不同的网络栈;

-

行为如何被协同与控制 ------ 握手、心跳、控制命令(如 RTSP 的 PLAY、RTMP 的 Command Message、GB28181 的 SIP INVITE)如何驱动系统的生命周期。

因此,协议不仅是"数据的语法",更是 系统行为的语义 :

它决定了一个实时视频系统在面对抖动、丢包、NAT、时钟漂移等复杂条件下,如何在混乱的网络世界中仍然保持逻辑上的"时间连续性"。

在这个意义上,RTSP、RTMP 与 GB28181 并非简单的传输方式之别,而代表着三种体系的设计哲学:

-

RTSP(Real-Time Streaming Protocol) 以"会话控制"为核心,建立在 RTP/RTCP 的时间语义之上,追求实时、精确、可控;

-

RTMP(Real-Time Messaging Protocol) 以"流的稳定传输"为目标,依托 TCP 的可靠性和 Chunked Message 机制,强调带宽适配与播放连续性;

-

GB28181 则是中国特有的行业标准,在 SIP/PS 流基础上加入设备目录、信令注册与控制体系,形成了"可监管、可接入、可回放"的安防级传输语义。

这三者分别服务于不同层级的系统需求:

-

RTSP 面向实时控制与点对点反馈;

-

RTMP 面向广域分发与跨终端兼容;

-

GB28181 面向组织化的视频接入与管控。

它们的技术栈各不相同------UDP vs TCP、RTP vs Chunk、SIP vs Command Message------

但都在解决同一个核心命题:

如何在不确定的网络环境下,保持确定性的时间秩序。

SmartMediaKit 的出现,正是将这些分散在不同体系中的协议能力,以模块化方式重新整合成一个 系统级实时视频内核 。从 RTSP 的实时控制、RTMP 的分发传输,到 GB28181 的国标信令协同,

它不仅实现了协议层面的互通,更在系统层实现了"时间逻辑的一致性"。

换言之,SmartMediaKit 的意义不仅在于"会说多种协议",而在于它让视频流成为系统中的一等公民------视频不再只是被传输的数据,而是系统行为与智能决策的时间基准。

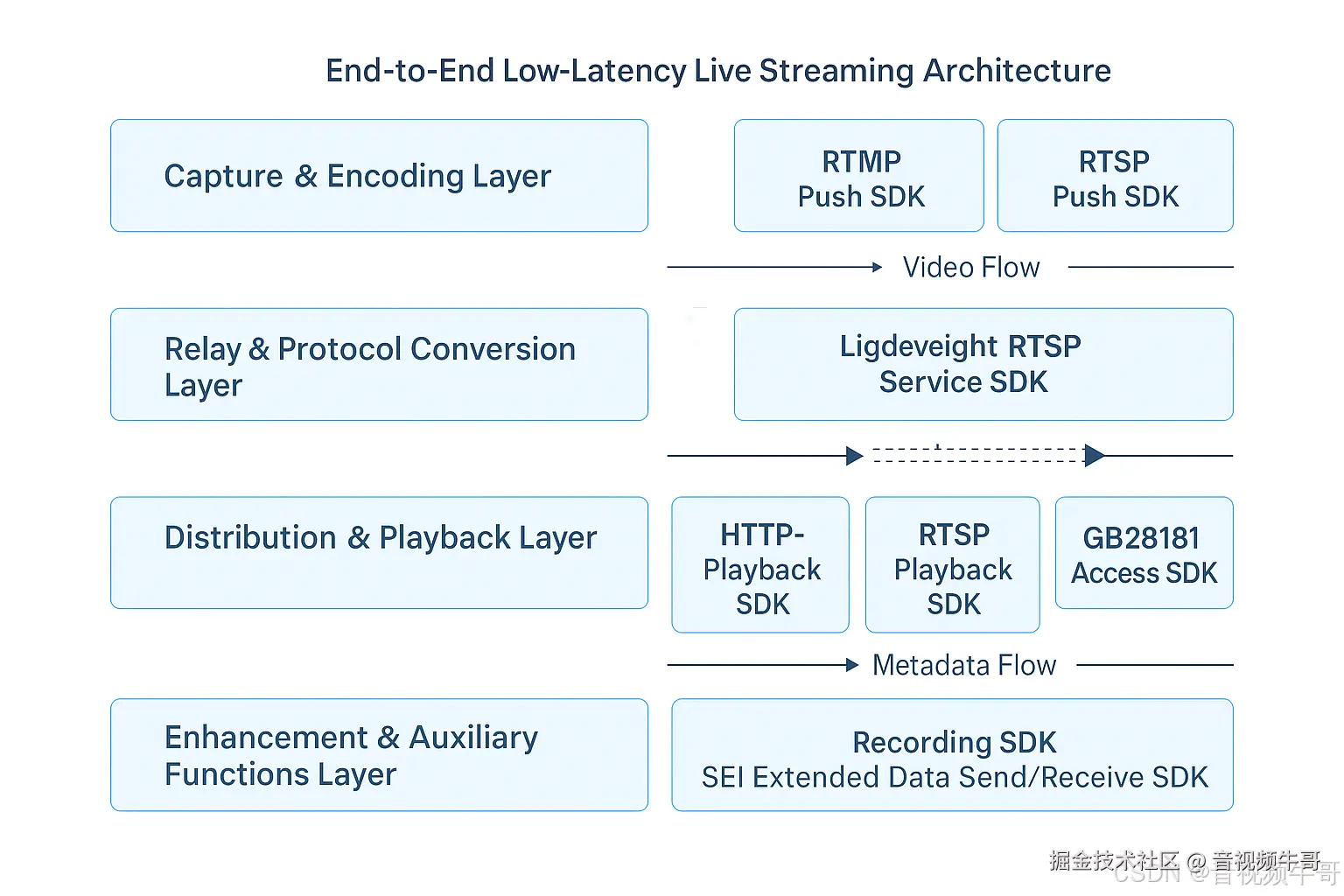

编辑

编辑

二、RTSP:实时流的会话语言

1. 协议规范与设计初衷

RTSP(Real-Time Streaming Protocol)最早由 IETF 在 RFC 2326 中定义,是一种 面向流媒体控制的应用层协议 。

它本身并不负责传输媒体数据,而是作为 控制通道(control plane) ,通过一组标准化命令(DESCRIBE / SETUP / PLAY / PAUSE / TEARDOWN)管理媒体流的生命周期。

在底层,RTSP 通常与 RTP(Real-time Transport Protocol) 和 RTCP(RTP Control Protocol) 配合使用:

-

RTP 负责音视频帧的实际传输;

-

RTCP 负责统计、同步与控制反馈;

-

RTSP 负责建立、控制、终止整个会话。

这种三层结构的设计,使 RTSP 成为一种非常"工程化"的协议:它为每一路流提供独立的 时钟、端口、传输模式(UDP/TCP),并允许客户端在任意时刻调整状态。因此,RTSP 不仅能满足实时播放,也能精确控制点播、回放、倍速、Seek 等操作。

从协议角度看,RTSP 是一个"状态机驱动"的体系。

每一次请求都带有明确的会话标识(Session:),

每一帧媒体都受时间戳(RTP Timestamp)与序号(Seq)约束。

这种设计使得它天然适合 高实时性、低延迟、可交互 的系统场景------

比如监控、工业检测、无人机回传、远程控制等。

2. 实现逻辑:从握手到时钟

在具体实现上,RTSP 是典型的 C/S 模型 + 状态同步协议 。

一个完整的 RTSP 会话包含如下阶段:

1️⃣ Session Discovery :

客户端通过 DESCRIBE 请求获取 SDP 描述,确认媒体类型、编码方式、端口与传输模式。

2️⃣ Session Setup :

使用 SETUP 命令为每一路流分配会话 ID、RTP/RTCP 端口及传输参数(Transport: 字段)。

3️⃣ Session Control :

客户端使用 PLAY / PAUSE / TEARDOWN 控制播放状态。

RTP 流在此阶段通过 UDP(或 TCP interleaved)持续传输。

4️⃣ Clock Synchronization :

RTCP 定期反馈统计包(包括 jitter、lost rate、timestamp offset),

以此维持音视频同步与链路健康度。

从工程实现角度看,RTSP 的核心难点集中在三个方面:

-

多线程同步:在接收、解析、RTP 解复用之间需要严格的锁与时间戳管理;

-

UDP/TCP 模式兼容:在不同网络条件下自动选择传输模式并维持流畅性;

-

跨时钟同步:RTSP/RTP/RTCP 三者时间基不同,需要动态校正与重采样。

这也解释了为什么在很多通用播放器中,RTSP 延迟和稳定性往往不如 HTTP 或 RTMP:

协议本身要求高、容错逻辑复杂,真正的性能瓶颈往往在时钟控制与缓冲策略上。

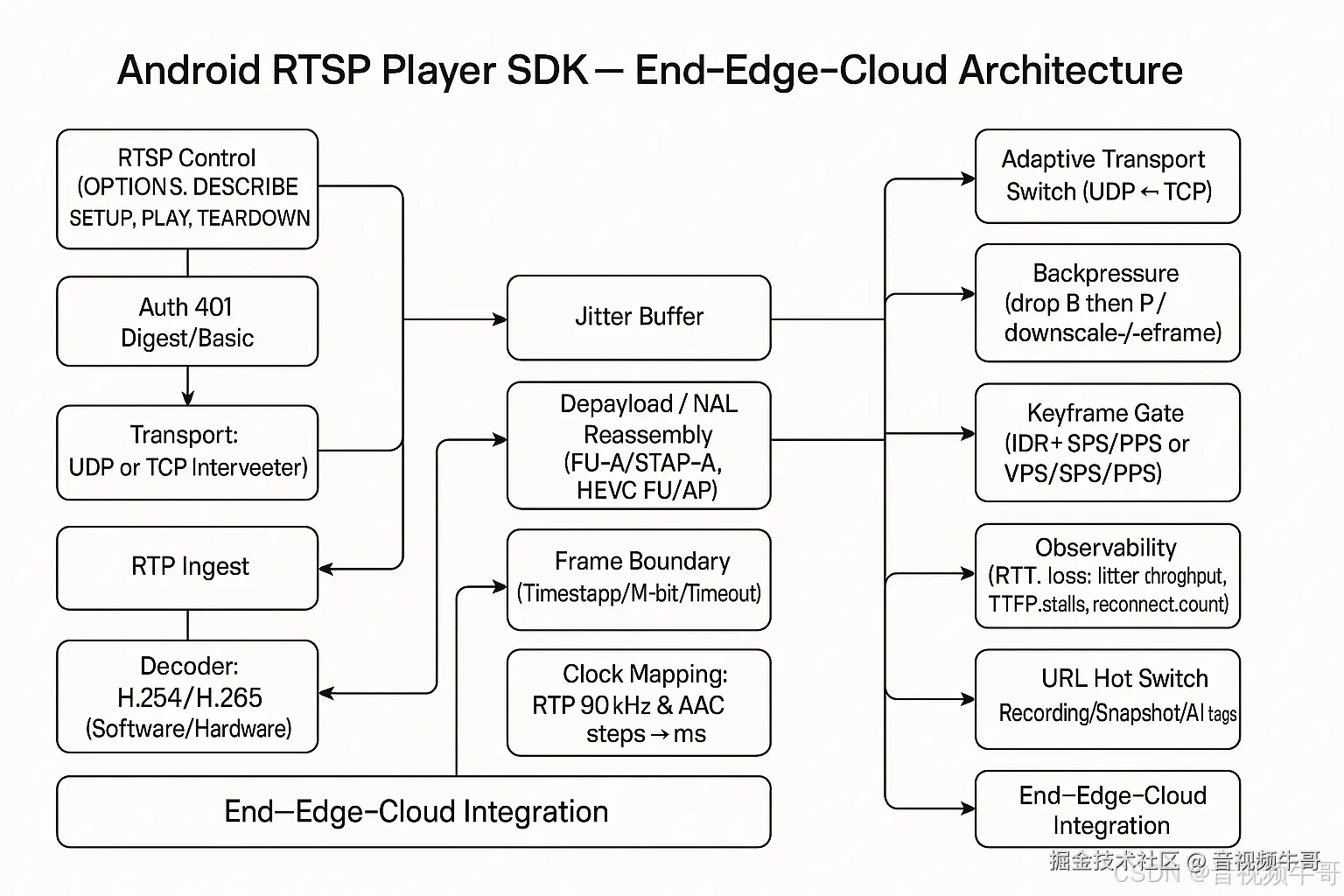

3. SmartMediaKit 模块实现

编辑

编辑

SmartMediaKit 将 RTSP 模块定义为整个系统的"实时输入层(Real-Time Input Layer) ",

负责从设备端、摄像头或外部网络接入原始实时流,并提供统一的媒体缓存与分发能力。

(1) 协议栈实现

-

自研 RTSP 解析引擎:采用有限状态机(FSM)实现命令处理,兼容 RFC 2326 全指令集;

-

独立 RTP/RTCP 模块:支持动态端口绑定、Seq 丢包检测、时间戳对齐、同步校正;

-

双模式传输支持:自动识别并切换 UDP 与 TCP interleaved 模式,提升穿透率与稳定性;

-

SDP 解析与动态协商:支持多路媒体协商与 H.264、H.265、AAC、G711、PCM 等编码类型。

(2) 缓冲与同步机制

SmartMediaKit 内部实现了一套基于 RingBuffer + 时间戳索引 的零拷贝缓存机制。

每个 RTP 包在进入缓冲区后会立即进行时序标定,并在解码线程中按时间顺序分发:

-

有效减少线程竞争与内存复制;

-

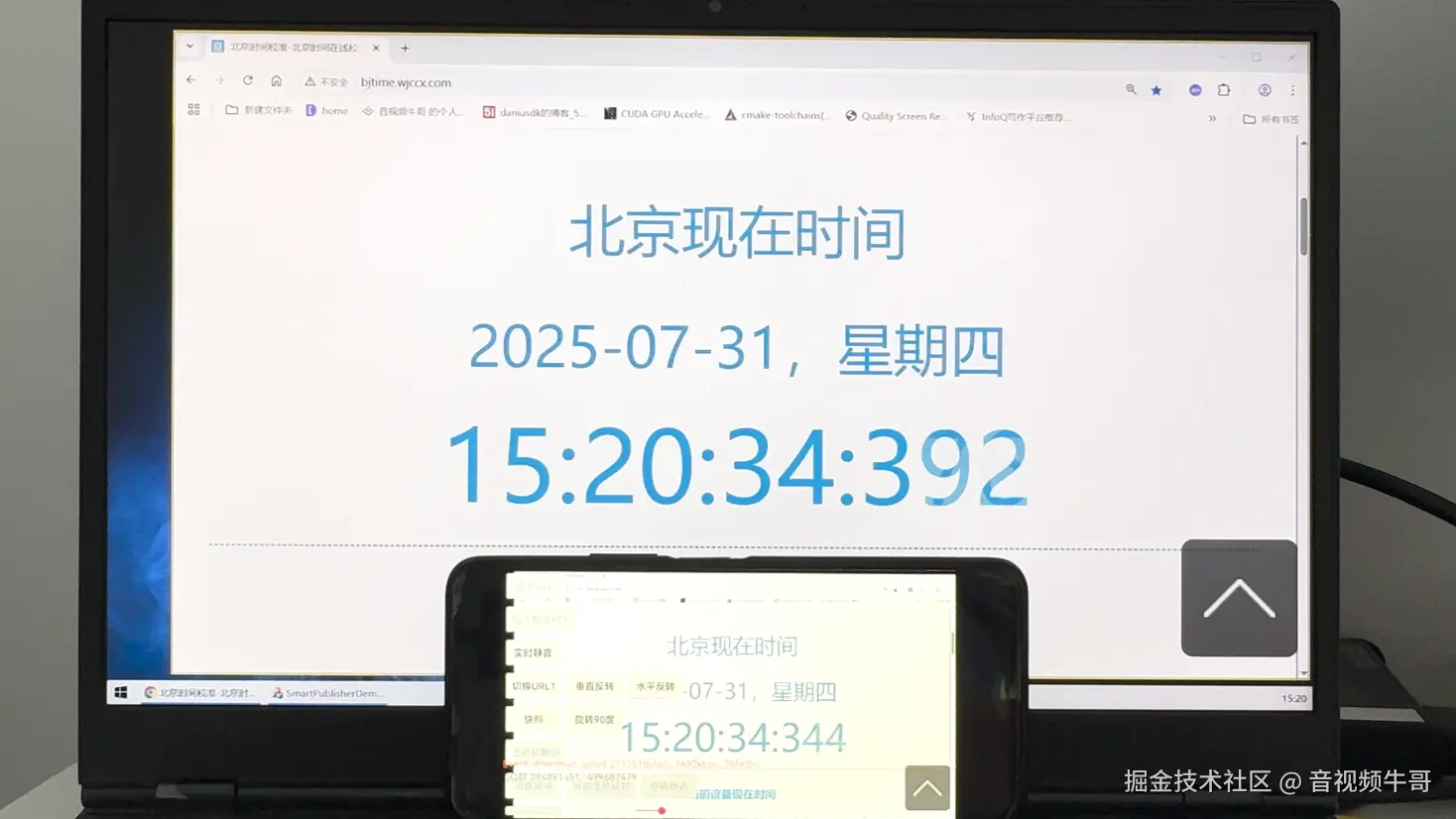

动态调整播放缓冲深度(默认 100--150 ms);

-

实现 端到端延迟控制在 100--200 ms 之间。

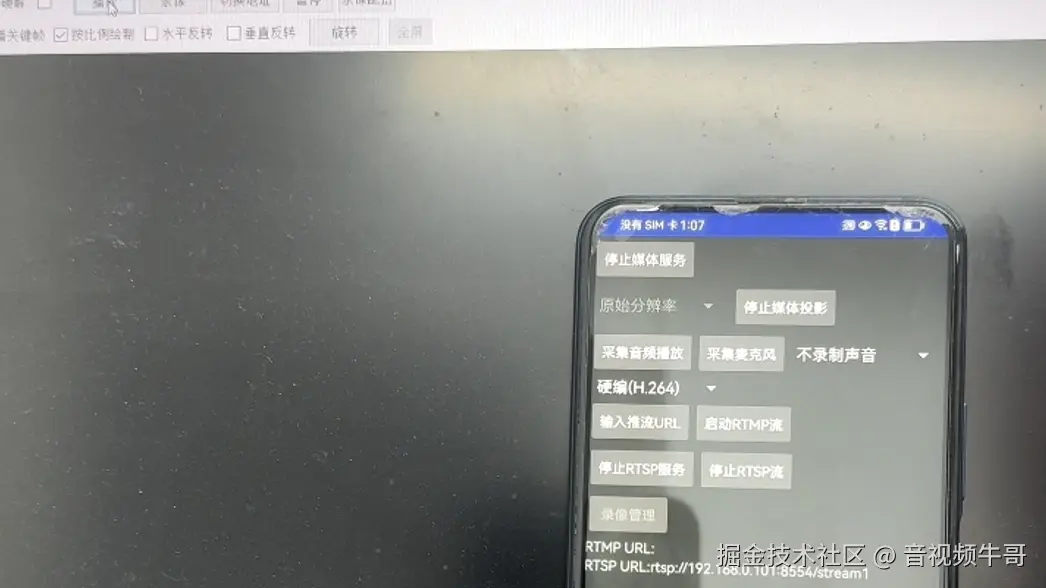

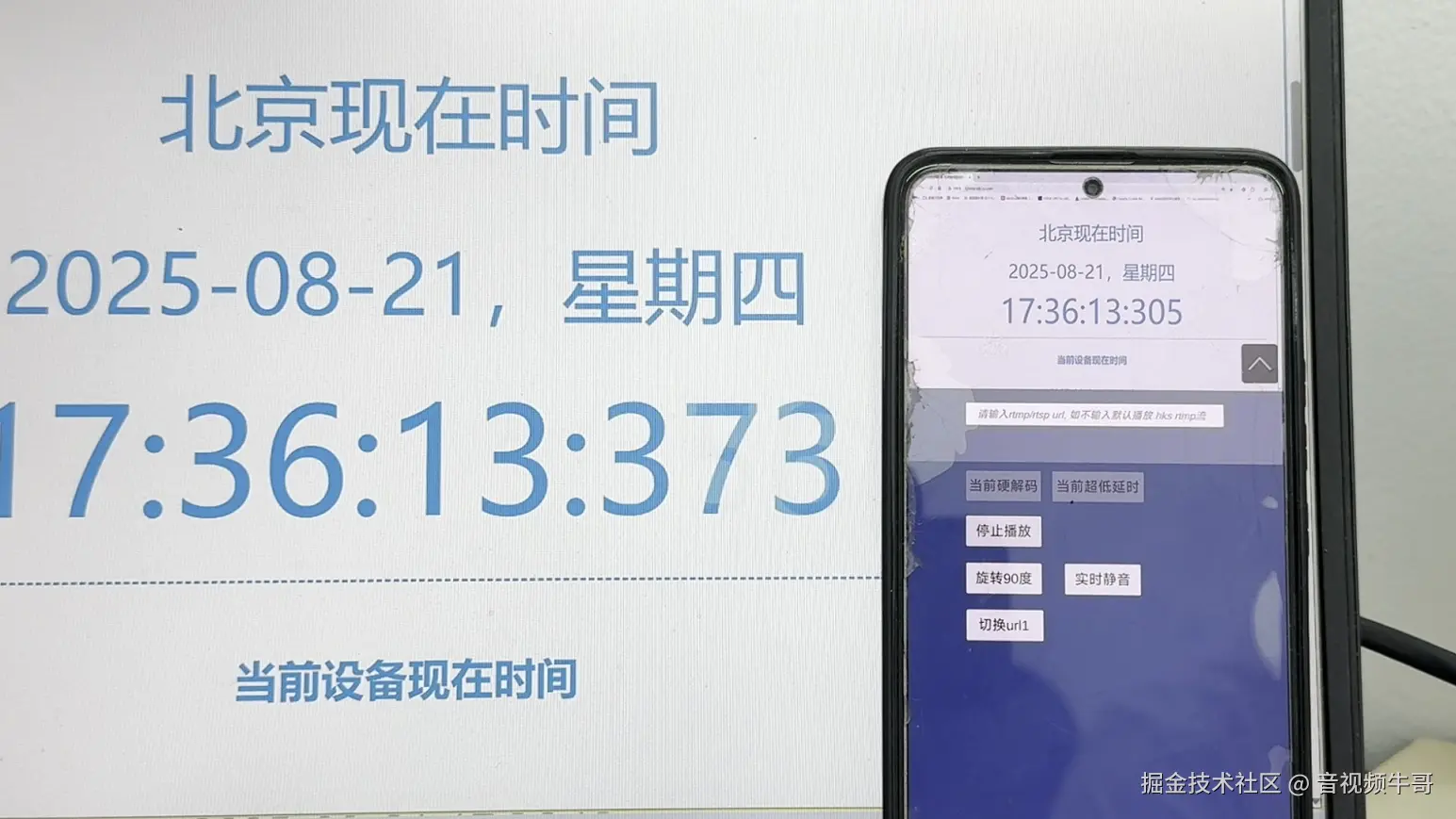

安卓无纸化同屏延迟测试之轻量级RTSP方案

(3) 服务端模块

除客户端功能外,SmartMediaKit 还内置 轻量级 RTSP Server 模块 ,

允许开发者在 Android、Linux、Windows 等平台直接启动 RTSP 服务。

该模块使用相同的 RTP/RTCP 栈与调度层,

可快速实现"设备侧本地分发 "与"边缘节点推送 ",

大幅降低传统中心化服务器的转发压力。

(4) 与其他模块的协同

-

与 RTMP 推流模块 联动:RTSP 拉流 → 编码 → RTMP 推送,实现实时转发;

-

与 GB28181 接入模块 联动:将 RTSP 源自动注册为国标通道,实现协议桥接;

-

与 录像模块 联动:通过 RTP 缓冲直接生成 MP4/FLV 文件,实现边看边录。

这种模块化设计,使 RTSP 不再是单一协议组件,而成为 SmartMediaKit 的 系统入口协议层 。

它不仅提供视频数据,更定义了系统"时间的起点"------所有下游模块的同步与调度,都以 RTSP 的时钟为基准。

Android平台RTSP播放器时延测试

三、RTMP:直播的兼容标准

1. 协议规范与设计哲学

RTMP(Real-Time Messaging Protocol)最初由 Macromedia(后被 Adobe 收购)于 2002 年提出,用于 Flash Player 的流式播放与交互。

尽管起源于 Flash 时代,但 RTMP 的结构设计远超当年的网络需求,它以 流控制 + 持久连接 + 分片传输 的方式,为后续所有互联网直播协议奠定了基础。

RTMP 的核心理念是:

保持流的连续性,而不是帧的实时性。

换句话说,RTMP 不追求极限延迟,而追求"稳定传输与播放无感"。这使它在当时的 CDN 直播架构中极具优势:TCP 保证可靠传输,Chunk 流保证边接收边解码,配合 H.264 + AAC 的压缩格式,形成了长达十余年的"黄金标准"。

编辑

编辑

在协议结构上,RTMP 由三部分组成:

1️⃣ 握手阶段(Handshake)

通过 C0/C1/C2 和 S0/S1/S2 三次交换,完成协议版本与时间同步;

2️⃣ 消息分片层(Chunk Stream)

将音视频与控制消息打包为分片块(Chunk),支持多路流并行传输;

3️⃣ 命令消息层(Command Message)

基于 AMF(Action Message Format)序列化,实现控制与元数据交互。

通过这三层结构,RTMP 实现了:

-

持久 TCP 连接(保证丢包重传与顺序);

-

Chunk 化传输(支持流式播放);

-

事件驱动控制(播放、暂停、Seek、发布、订阅)。

虽然 Flash 已退出历史舞台,但 RTMP 的工程思想仍被广泛继承:

SRS、Nginx-RTMP、FFmpeg、OBS、甚至 WebRTC 的数据通道中,都能看到它的影子。

2. 实现逻辑:从握手到分发

RTMP 在工程实现中是一个 长连接 + 有状态的会话协议 。

一个完整的 RTMP 推流/播放过程通常包含以下阶段:

1️⃣ 握手(Handshake)

客户端(C)与服务器(S)通过三次交互(C0C1C2 / S0S1S2)完成版本确认与时间戳同步。

2️⃣ 连接建立(Connect)

客户端发送 connect 命令,附带应用名与认证参数;服务器返回确认包(_result/_error)。

3️⃣ 流创建(CreateStream / Publish / Play)

客户端发送 createStream、publish(推流)或 play(拉流)命令,确定流方向与名称。

4️⃣ 消息传输(Message Chunking)

数据层采用 Chunk 分片机制,每个 Chunk 包含消息头(timestamp、streamID、typeID)与负载数据。

服务器通过 window acknowledgement size 与 set chunk size 控制流量窗口,实现带宽调度。

5️⃣ 控制与状态同步(Control Message / Ping)

RTMP 定期发送 Ping/Pong 心跳,维持长连接并监控延迟。

从工程角度看,RTMP 的挑战主要在于:

-

TCP 队头阻塞:丢包时全流停顿,影响实时性;

-

分片重组复杂:ChunkID、StreamID 与消息类型需严格对齐;

-

带宽自适应控制:不同客户端网络状态需要动态调整速率。

因此一个高性能 RTMP 实现,关键不在"是否能推流",而在"是否能在持续长会话下稳定推流"。

3. SmartMediaKit 模块实现

SmartMediaKit 将 RTMP 定位为系统的"分发与上行核心层(Distribution & Uplink Core) ",

其实现目标不是替代 RTMP,而是把 RTMP 内核重新工程化,使其具备可移植性、可控性与极低资源占用。

(1) 协议栈实现

-

自研 RTMP Chunk 引擎

实现完整的握手、命令与分片机制,完全独立于 FFmpeg 与 librtmp;

采用状态机 + 流缓冲结构,支持跨平台(Windows / Linux / Android / iOS / Unity3D)编译;

-

事件驱动式 I/O 线程模型

使用非阻塞 I/O 与消息队列解耦网络层与编码层;

实现 send queue / recv queue 独立调度,防止阻塞;

-

多流通道复用

支持同一 TCP 连接下的多路 StreamID,便于音视频与控制命令并行传输;

-

高性能 AMF 编解码器

优化了 AMF0/AMF3 的序列化流程,减少内存碎片与字符串拷贝开销。

(2) 网络与带宽控制

SmartMediaKit 内置带宽监测机制,利用 ACK 与窗口反馈动态调整发送速率:

-

当 ACK 间隔过长时自动降码率;

-

当接收端反馈良好时提升发送窗口;

-

在弱网场景下仍能维持 25~30fps 稳定推流。

这使得 SmartMediaKit 能在 移动网络(4G/5G/WiFi) 环境中保持极高稳定性。

(3) 推流端与播放端模块

-

推流端(Publisher):

-

支持摄像头、屏幕、文件、外部编码数据多源推流;

-

自动插入 Metadata(宽高、帧率、编码类型、音频采样率);

-

内置关键帧检测与重发机制,避免 GOP 错位。

-

-

播放端(Player):

-

支持自动识别音视频轨并异步解码;

-

内置帧缓存(FrameBufferPool),支持 I420、NV12、YV12、RGBA 输出;

-

延迟控制模块根据播放时间基调整缓冲区深度,避免卡顿。

-

(4) 与其他模块的协同

-

RTSP ↔ RTMP 转发:实现 RTSP 拉流 → 解码 → RTMP 推送,用于摄像头到云端中继;

-

RTMP ↔ GB28181 桥接:将 RTMP 输出转封装为 PS 流并通过 SIP INVITE 注册;

-

HTTP-FLV 输出:同一内核数据流可被实时封装为 FLV Tag,通过 HTTP/WS-FLV 分发到 Web。

这一整套机制,使 SmartMediaKit 能同时支持 实时采集、低延迟推流、跨协议转发与云端分发 ,

从而形成真正意义上的"系统级媒体分发内核"。

Android平台Unity3D下RTMP播放器延迟测试

四、GB28181:视频系统的行业通用语

1. 协议规范与体系背景

GB28181,全称《安全防范视频监控联网系统 信息传输、交换、控制技术要求》,是中国安防视频监控领域的国家标准。不同于 RTSP 和 RTMP 的媒体传输导向,GB28181 的设计初衷是 监管导向的系统互联标准------它关注的不仅是"流怎么传",更是"设备如何被统一管理、控制与调度"。

GB28181 以 SIP(Session Initiation Protocol) 为信令核心,通过 SIP 协议实现设备注册、心跳、控制命令、目录查询、实时视音频传输的控制层语义。在媒体层,它使用 RTP over UDP 承载 PS(Program Stream) 格式的复合流(含音视频、时间戳与同步头),保证了媒体在不同厂商设备间的封装一致性。

其设计目标可以概括为三点:

-

统一管理:用标准信令描述设备、通道、目录、报警与录像资源;

-

可监管性:提供上级平台对下级设备的统一控制、心跳检测与录像调用;

-

可扩展性:支持语音对讲、语音广播、图像抓拍、历史回放等丰富交互命令。

从体系上看,GB28181 实际是一个"信令 + 传输 + 编解码"三层复合体系:

┌──────────────────────────────┐

│ 应用控制层:SIP/SDP/Message │

├──────────────────────────────┤

│ 媒体传输层:RTP/RTCP + PS Encapsulation │

├──────────────────────────────┤

│ 网络承载层:UDP/TCP/IP │

└──────────────────────────────┘与 RTSP 不同,GB28181 的核心优势在于 统一性与层级化:它不仅规范了设备接入,还定义了平台级的层次结构(上级平台、下级设备、信令代理、媒体中转等),使得整个系统具备可监管、可审计、可扩展的工业级特征。

2. 实现逻辑:从注册到媒体会话

GB28181 的协议工作流程可以分为两个主要通道:

信令通道(SIP) 与 媒体通道(RTP/PS)。

(1) 信令通道:SIP 状态机

GB28181 采用 SIP 协议作为控制信令,其核心状态机包括:

1️⃣ 注册(REGISTER)

设备(或客户端)通过 REGISTER 请求向上级平台注册,附带认证信息、设备ID(如34020000001320000001)与地址;

服务器返回 401 Unauthorized → 客户端重新提交带鉴权头的 REGISTER → 注册成功返回 200 OK。

2️⃣ 心跳(KeepAlive / MESSAGE)

设备定期发送 MESSAGE 类型心跳包,上级平台返回 200 OK;若长时间无响应则视为离线。

3️⃣ 目录查询(Catalog / DeviceInfo / RecordInfo)

上级平台可通过 MESSAGE 请求设备目录、通道信息或录像列表。

4️⃣ 媒体请求(INVITE / ACK / BYE)

当平台需要实时视频时,发起 INVITE 请求,设备应答 200 OK 并通过 SDP 协商传输参数;

随后媒体流以 RTP/PS 形式发送至平台;结束时由任意一方发送 BYE。

5️⃣ 控制指令与扩展命令

包括:PTZControl(云台控制)、DeviceControl(重启/配置)、Download(录像下载)、Broadcast(语音广播)、Talk(双向对讲)等。

整个 SIP 状态机需保证:

-

序列号(CSeq)递增且唯一;

-

对端

Call-ID一致; -

消息头中的

Via、From、To、Contact等字段正确回填。

(2) 媒体通道:RTP + PS

媒体层使用 RTP 封装 MPEG-PS 复合流(Program Stream),

相比纯 H.264/H.265 流,PS 包含时间基准、PES Header、系统时钟参考(SCR),便于同步与回放。

-

RTP Header:序列号、时间戳、SSRC;

-

PS Packet:系统头 + 音视频打包;

-

Transport Mode:UDP 单播为主,部分实现支持 TCP fallback。

GB28181 的流传输模型强调"平台拉流"而非"设备推流**"------上级平台控制 INVITE,设备在收到请求后才发 RTP 流,这符合政企安防对访问控制与带宽管理的要求。

3. SmartMediaKit 模块实现

SmartMediaKit 将 GB28181 定位为"国标接入与协议桥接层(GB Adapter Layer)",目标是让任何非国标终端(Android、无人机、边缘节点、工业摄像头等)具备完整的国标接入能力。

(1) 自研 SIP 协议栈

-

独立 SIP Parser 与 Transaction Manager

实现 INVITE / MESSAGE / REGISTER / BYE 全流程状态机;

兼容 GB28181-2011 与 GB28181-2016;

支持 UDP 与 TCP 两种传输模式;

-

REGISTER / KeepAlive 管理器

提供周期注册与心跳自动维持机制,支持鉴权重试与状态回调;

-

目录与控制模块

支持平台查询 Catalog、DeviceInfo、RecordInfo;

内置 PTZControl、DeviceControl、AlarmNotify 等控制命令处理。

(2) 媒体封装与流桥接

-

RTSP/RTMP→PS 转封装模块

从现有流(RTSP 拉流或 RTMP 推流)中提取音视频帧,重新封装为 PS 包;

自动插入 PSM/PES Header 与系统时钟(SCR),保证流合法性;

-

RTP 发送引擎

使用 UDP Socket 多线程发送,支持 RTP Header 递增与时间基同步;

具备动态 MTU 拆包与重发保护机制。

-

多通道 Session 管理

每个通道独立维护 Call-ID、Tag、SSRC 与状态;

支持并发数百路会话注册与媒体推送。

(3) 语音与交互能力

-

双向对讲(Talk) :

基于 SIP INVITE 双路会话实现,支持 G.711音频;

-

语音广播(Broadcast) :

设备接收上级平台发起的广播 INVITE 并自动播放音频流;

-

录像回放(Playback / Download) :

解析 RecordInfo 与 Download 命令,支持按时间段提取历史 MP4 文件并回传 RTP。

(4) 模块协同与场景化应用

-

与 RTSP 模块 协作:从摄像头拉流 → 转 PS → RTP 推送 → 注册平台;

-

与 RTMP 模块 协作:RTMP 推流 → 转 GB 通道 → 平台实时播放;

-

与 录像模块 协作:支持历史录像查询与远程下载;

-

与 SEI 扩展模块 协作:可嵌入 AI 元数据或 GPS 信息并随流回传。

通过这套模块化设计,SmartMediaKit 让"非国标设备"也能以标准身份被监管系统识别、控制与调用。

这在城市安防、无人机巡检、车载视频、应急指挥等场景中,极大降低了集成门槛与开发复杂度。

五、协议协同:系统级融合的关键

1. 设计初衷:从多协议到单体系

在多数实时视频系统中,RTSP、RTMP 与 GB28181 往往各自独立存在。RTSP 用于设备采集与控制、RTMP 用于推流分发、GB28181 则服务于政企平台接入。这三者在封装格式、时钟定义、传输通道乃至状态机上完全不同。

SmartMediaKit 的架构目标,是让这些协议在同一系统内协同运作,通过统一的媒体调度层,将它们组织为一个 共享时钟、统一缓存、协同调度 的体系。

在这一体系下:

-

RTSP 模块负责实时输入(数据采集端);

-

RTMP 模块负责稳定分发(上行推流与下行播放);

-

GB28181 模块负责信令与监管对接(系统接入与控制)。

三者在逻辑上相互独立,但在底层由同一时间基与缓存管理器维持同步,从而实现多协议共存的系统级一致性。

2. 架构核心:统一媒体调度层

SmartMediaKit 内部的 Unified Media Orchestrator(统一媒体调度层)

是整个协议体系的核心。它的任务是:

-

管理数据帧在不同模块之间的流向;

-

保证音视频帧的时间顺序一致;

-

提供线程与缓冲区管理,避免跨协议数据堆积。

(1) 数据通路模型

各协议模块的数据流向大致如下:

markdown

RTSP Reader → FrameBufferManager →

├─ RTMP Publisher

├─ GB28181 PS Sender

└─ Recorder (MP4)RTSP 负责采集原始数据帧,媒体调度层将帧存入统一的帧缓冲队列(FrameBufferManager)。

随后,RTMP、GB28181、录制模块分别从该缓冲区读取帧进行编码、打包或输出。

这种架构的核心优点不是"零拷贝",而是 统一的缓存管理与时间同步策略 :

不同协议模块在访问同一帧数据时,遵循统一的时间基准(timestamp),

从而保证在多输出路径下画面同步、延迟稳定。

(2) 时间基对齐机制

不同协议的时间定义存在差异:

-

RTSP / RTP 使用 90 kHz 时钟;

-

RTMP 使用毫秒时间基;

-

GB28181 / PS 使用系统时钟参考(SCR)。

SmartMediaKit 的调度层引入了 统一时间基(Unified Timebase) :

所有帧进入系统时都会被换算为微秒级基准时间(µs),

输出模块在发送时再按对应协议格式反向映射。

这使得系统可以在多协议共存时维持稳定的帧率与延迟,

避免跨协议转换中常见的时间漂移、丢帧或画面跳动。

3. 协议互转与并发输出

SmartMediaKit 支持多种协议互转路径,通过内部的 Relay 模块完成媒体数据重新封装与分发:

-

RTSP → RTMP:常用于摄像头或采集端到云端的推流中继;

-

RTSP → GB28181:将标准 RTSP 流重新打包为 PS 流,并通过 SIP/INVITE 注册上级平台;

-

RTMP → GB28181:适用于移动推流或自定义直播源纳入国标平台;

-

多协议并发输出:同一路视频流可同时分发至 RTMP、GB28181 与本地录像模块。

所有路径共享统一的时间基和缓存队列,因此多协议输出的帧间延迟差通常可控制在数十毫秒内。

4. 控制与状态反馈

SmartMediaKit 内部提供统一的 事件与状态总线(Event Bus) ,

用于协议模块之间传递控制命令和运行状态:

-

RTSP 模块在流建立后向上层发布

StreamReady事件; -

GB28181 模块收到上级平台的

BYE或控制命令后触发关闭或重连; -

RTMP 模块监测网络带宽变化时可通知采集端调整码率与 GOP。

这种事件驱动机制让不同协议模块能够在系统级保持一致的控制逻辑,例如:一旦流中断,所有关联通道都会同步清理状态,防止死连接与资源泄漏。

5. 工程收益

SmartMediaKit 的多协议协同带来了显著的工程优势:

-

单一内核,统一接口:减少第三方库依赖,简化集成。

-

统一时间与缓冲模型:跨协议延迟一致,避免额外抖动。

-

可扩展的模块框架:开发者可基于相同接口扩展新的协议或输出类型(如 HTTP-FLV、SRT)。

-

系统级稳定性:协议异常、断线、心跳均由调度层统一管理,提高运行可靠性。

通过这种体系化的协同机制,SmartMediaKit 实现了从"多协议支持"到"统一系统时序"的演进,

让开发者能在一个架构下同时满足设备接入、云端分发与平台监管的全链路需求。

6. 结语

RTSP、RTMP 与 GB28181 的协作并非简单的协议拼接,而是一次 时钟、状态与控制语义的整合。SmartMediaKit 的协议调度层并不追求理想化的"零拷贝"或"无损同步",而是在工程现实中,以统一时间管理、合理缓冲策略和明确模块边界的方式,实现了稳定、可预测、可维护的多协议实时视频系统。

六、工程演进:从单协议到系统中台

1. 背景:协议堆栈到系统能力的转化

在实时音视频系统的早期阶段,开发者往往以协议为单位实现功能:一个 RTSP 拉流器、一个 RTMP 推流器、一个 GB28181 适配器。

这类实现虽然能够"跑起来",但在规模化部署中会暴露出三个典型问题:

-

重复堆叠:每个协议独立维护线程、缓冲与解码,导致系统内存、CPU 占用翻倍;

-

时序割裂:不同模块的时钟定义与缓冲深度不同,无法在系统级保证延迟一致;

-

维护困难:一旦底层解码或缓存逻辑更新,所有协议实现都需要同步修改。

SmartMediaKit 的工程演进,正是为了解决这一类"协议型代码库"无法支撑系统化产品的问题。

它从 2015 年起经历多轮重构,从最初的多协议 SDK,逐步演化为可支撑 采集、分发、存储、监管 的完整实时视频中台。

2. 分层架构:从功能到系统

SmartMediaKit 的整体架构遵循"分层 + 模块化 + 可裁剪"的原则。整个系统被抽象为四个主要层级:

arduino

┌──────────────────────────────┐

│ Extension Layer --- AI / SEI / 控制事件扩展 │

├──────────────────────────────┤

│ Output Layer --- RTMP / GB28181 / HTTP-FLV / Recorder │

├──────────────────────────────┤

│ Core Layer --- 解复用 / 时间同步 / 编解码 / 调度 │

├──────────────────────────────┤

│ Input Layer --- RTSP / File / Camera / Mic / Capture │

└──────────────────────────────┘(1) 输入层(Input Layer)

负责媒体数据采集与输入,包括 RTSP、摄像头、麦克风、屏幕捕获、文件源等。

所有输入模块输出统一的媒体帧结构(MediaFrame),带有时间戳、通道ID与类型标识。

(2) 核心层(Core Layer)

核心层是整个系统的"时间与数据中枢",包含以下关键模块:

-

Demux / Mux:音视频帧的分离与重新封装;

-

Codec Engine:软硬编解码接口,支持 H.264/H.265/AAC/G711;

-

TimeSync Manager:跨通道时间对齐与延迟控制;

-

FrameBuffer Manager:帧缓冲管理与线程调度。

这一层实现了 SmartMediaKit 的核心抽象:统一时间流(Unified Timeline) 。

无论数据来自 RTSP、文件、摄像头还是麦克风,系统都会在这一层建立统一时间基。

(3) 输出层(Output Layer)

负责媒体流的输出与分发,包括:

-

RTMP 推流与播放模块;

-

GB28181 发送与注册模块;

-

HTTP-FLV / WebSocket-FLV 输出模块;

-

本地录像模块(MP4)。

输出层通过核心层提供的帧接口工作,因此可以实现多协议并发输出,而不会重复占用缓冲或编码线程。

(4) 扩展层(Extension Layer)

面向 AI 与系统控制扩展,包括:

-

SEI 数据封装(支持嵌入检测结果、GPS、传感器信息);

-

AI Adapter(与外部识别模块对接,如 YOLO / TensorRT);

-

Control Event Bus(统一事件调度与控制指令传递)。

这使 SmartMediaKit 不再只是"播放与推流",

而能与更高层的智能系统协同,例如视频识别、设备联动、告警策略等。

3. 模块解耦与可裁剪

在架构设计上,SmartMediaKit 所有模块均为独立组件,具备以下特性:

-

可选加载:编译时可按需开启 RTSP、RTMP、GB28181、Recorder、HTTP-FLV 等功能;

-

接口统一 :模块间通过标准接口交互(

Start(),Stop(),OnFrameCallback()),降低集成成本; -

线程隔离:各模块独立线程池,防止单一协议异常影响全局;

-

配置驱动:通过配置文件或 API 选择输入/输出协议、码率、GOP、封装格式等参数。

这种解耦结构使 SmartMediaKit 能适配多种运行形态:

-

在移动端,可仅保留 RTSP/RTMP 播放器功能;

-

在边缘节点,可启用 RTSP 服务 + RTMP 推流转发;

-

在中心服务器,可启用 GB28181 注册 + HTTP-FLV 输出。

开发者可像组装积木一样,根据应用场景搭建定制化系统。

4. 多角色部署能力

SmartMediaKit 的分层结构让它能灵活承担不同系统角色:

系统角色

功能特征

对应模块组合

播放器 SDK

低延迟播放、截图、录像

RTSP/RTMP → Core → Recorder

RTSP 服务节点

内网分发、实时转推

Input: RTSP → Core → Output: RTSP/RTMP

协议网关(RTSP↔RTMP↔GB28181)

协议桥接与中继

RTSP/RTMP/GB28181 + Core

国标终端节点

设备注册、语音对讲、回放

GB28181 + Recorder + Core

AI 感知节点

视频识别、数据嵌入

Input + Core + SEI/AI Adapter

这种多角色部署能力使 SmartMediaKit 不再只是 SDK,而是可被嵌入到任何系统中的 视频中台引擎(Video Middleware Engine)。

5. 工程价值:以系统为单位的可控性

SmartMediaKit 的架构演进带来了三个根本性变化:

-

开发视角:从"调用协议库"转变为"接入系统层能力";

-

维护模式:从"多模块维护"转变为"统一时间与线程管理";

-

产品价值:从"播放推流工具"转变为"可支撑上层业务的系统引擎"。

在这种体系下,开发者能以极小代价构建出完整的视频系统:

RTSP 摄像头采集 → RTMP 推流分发 → GB28181 监管接入 → HTTP-FLV 网页播放 → MP4 录制 → AI 识别嵌入,所有环节均基于统一 SDK 完成,无需额外依赖。

7. 结语:从模块到系统,从时间到智能

SmartMediaKit 的演进,实质是从"协议集"向"系统内核"的跨越。

它让实时视频系统具备了两种能力:

-

结构层面的统一(模块化、跨平台、可裁剪);

-

时间层面的自洽(统一时钟、延迟可控、同步精确)。

当实时视频成为系统神经的一部分,SmartMediaKit 不再只是推流与播放的工具,而是构成"时间秩序、系统智能与可控链路"的底层基石。

七、未来展望:从协议到智能

在实时音视频系统不断演进的今天,传输协议已不再只是"数据通道"。随着 WebTransport、SRT、QUIC、WHEP/WHIP 等新一代低延迟标准的成熟,行业正从"媒体传输"转向"系统协同"------

即音视频数据不仅要被播放,更要与 AI 感知、设备控制、状态同步 融为一体。

未来的实时视频系统,承担的不再是画面的传递,而是系统语义的传输:

-

传递语义:视频帧中包含检测结果、目标坐标、识别标签;

-

传递控制:视频链路与机器人、无人机、工业设备形成闭环交互;

-

传递状态:节点之间共享时钟、传感器与网络状态,实现协同决策。

这些能力的实现,离不开精确的时间基、可靠的链路与统一的系统接口。而 SmartMediaKit 正是在此方向上构建基础:

-

通过 SEI 扩展通道,在视频帧内嵌 AI 数据与控制信号;

-

通过 统一时间同步机制,让不同节点在毫秒级内保持一致;

-

通过 模块化架构,在 RTSP、RTMP、GB28181 等协议之上扩展智能层逻辑。

这意味着 SmartMediaKit 已不再只是多协议 SDK,而是一套可支撑 AI-Native、System Intelligence、低空经济与工业智联网 的视频基础设施。

当实时链路从"传输"迈向"理解",SmartMediaKit 的角色,也在从"视频系统工具"转变为"智能系统的时间骨架"。

八、结语:协议是秩序,系统是智能

RTSP 定义了实时控制的语法;RTMP 建立了稳定分发的秩序;GB28181 规范了行业级监管与互通。而 SmartMediaKit 所做的,是让这些"协议的语言"在同一个系统中共鸣。它把时间对齐、状态同步、事件分发与智能扩展融入同一架构,让视频链路从"数据流"演进为"系统流"。

在这个体系中,每一种协议都不再是孤立的指令集,而是系统时间语义的一部分------它们共同描述了系统如何观察世界、响应世界、理解世界。

SmartMediaKit 的意义,不在于支持了多少协议,而在于它让这些协议之间 拥有了逻辑关系与时间秩序。这种秩序,使"流"不再只是画面的连续,而是智能系统的感知延展,是机器理解世界的时间通道。