一、当智能开始"跟不上现实"

智能的本质,从来不仅是"知道",而是"反应"。在人与机器逐渐共享时空的时代,AI的挑战不再是能否理解世界,而是能否与世界同频。

在具身智能系统中,每一次"看见"、每一次"听到"、每一次"行动",都构成了时间链条上的一个节点。但当这些节点之间存在延迟、漂移或不同步时,系统的感知与反馈就会产生"错位感"------图像仍在更新,声音已延后;命令刚被识别,环境却已改变。智能体"明白了世界",却"跟不上世界"。

问题的根源不在模型,也不在算力,而在链路层的真实时间。感知、传输、处理与反馈之间的每一毫秒,都在决定智能系统是否真正"在线"。一旦这条路径被延迟、抖动或阻塞,AI的反应就不再是智能,而只是滞后的模拟。

大牛直播SDK(SmartMediaKit)正是为了解决这一"时间不自洽"的问题而生。它以统一的跨平台实时音视频架构为基础,在毫秒级时序精度下实现从采集、传输到反馈的端到端闭环。在它构建的体系中,AI不再是"等待数据"的算法,而是能与现实同频共振的"系统存在"。

二、当实时流媒体走出"工具时代":系统级智能的基石正在形成

过去五年,实时音视频技术完成了一次从"内容传递"到"系统支撑"的演变。

当RTSP、RTMP、HTTP-FLV、GB28181等协议被应用到工业、安防、无人机、机器人、医疗等领域后,它们不再只是"播放与推流工具",而成为智能系统与现实世界之间的时间桥梁。

在早期的应用中,实时流的目标是"看得见、听得到"。

而今天,AI系统的需求已升级为"看得准、反应快、能协同"。

延迟不再只是体验指标,而是系统能否"自洽"的关键变量。

任何一次时序漂移,都会导致控制错位、识别失效或状态不一致。

因此,实时流媒体的价值已不在"传输",而在"秩序"------

如何让画面、音频、命令与AI识别结果在同一时间域下运转。

这需要的不只是网络优化,而是一个具备时钟同步、低拷贝传输和可编排处理能力的系统级引擎。

大牛直播SDK(SmartMediaKit)正是在这样的工程逻辑下诞生的。

它以跨平台、模块化、低延迟为核心设计理念,通过RTSP、RTMP、HTTP-FLV、GB28181等协议栈的深度优化,构建了一条可嵌入、可编排、可自治的实时视频神经链路。

在这套体系中,

RTSP负责设备侧采集与回传,

RTMP连接分发与上层系统,

HTTP-FLV/WS-FLV提供轻量级实时播放,

GB28181则确保与安防标准体系的对接与调度。

这些模块并非彼此割裂,而是通过统一的时间控制与传输内核协同运行。

它们共同组成了智能系统的"感知脊柱",

让AI不仅能理解世界,更能在毫秒级精度下"对世界做出反应"。

三、SmartMediaKit 的三层系统架构:从数据流,到时间域,再到智能协同

如果说 AI 的"思考"依赖算力与模型,那么它的"感知"与"反应",则取决于时间链路的质量。

在复杂系统中,视频、音频、控制信号与AI结果之间的同步关系,决定了系统的真实度与稳定性。

SmartMediaKit 正是以此为核心目标构建了一套三层架构体系:

传输基座层 → 媒体管线层 → 感知协同层 。

这三层既相互独立,又在时间域中高度统一,构成了智能系统的"实时神经骨架"。

1️⃣ 传输基座层:稳定、统一、跨协议的时间基础

在最底层,SmartMediaKit 以跨协议的流媒体内核构建了系统的时间基线。

它深度支持 RTSP、RTMP、HTTP-FLV、WS-FLV、GB28181 等主流协议,

并在内部实现了统一的时钟管理与低拷贝传输机制,确保所有数据流在毫秒级同步。

-

统一时钟域:音视频与控制信号共享全局时间戳,消除多源时序漂移。

-

低拷贝数据路径:通过零拷贝和环形缓冲区,显著降低CPU与GPU负载。

-

自适应网络调度:JitterBuffer算法根据实时网络状况动态平衡延迟与稳定性。

-

多线程异步架构:采集、编码、分发模块独立运行,避免系统级阻塞。

在这一层,SmartMediaKit 并不追求"尽可能快",而是追求"始终稳定、持续可预测"。

它为上层媒体管线提供了一个精准、低抖动、具备时间秩序的传输基座。

2️⃣ 媒体管线层:结构化的处理与编排核心

在传输层之上,SmartMediaKit 提供了一个可插拔、可组合的媒体处理框架。它不仅是播放与推流的逻辑中枢,更是 AI 系统进行"视频理解"与"数据再利用"的关键枢纽。

-

编码与复用模块:支持 H.264/H.265、AAC、G711 等主流编码标准,保证广泛兼容性;

-

录像与回放(MP4):可同步录制实时流,实现本地缓存与云端归档;

-

协议桥接模块:RTSP→RTMP、RTSP→HTTP-FLV、GB28181→RTMP 等组合路径可灵活部署;

-

AI-YUV 回调接口:直接输出裸帧,供算法模型实时检测、识别、分割;

-

SEI 扩展与元数据注入:可在视频流中实时嵌入 AI 识别结果、状态信息或控制信号。

这一层将原本分散的媒体模块整合为可编排的"数据管线"。

它既能作为系统的数据中转核心,也能作为 AI 感知节点的输入层。

每一个模块的设计都强调独立性与协同性,像神经元一样有序运作。

安卓RTMP播放器同时播放4路RTMP流延迟测试

3️⃣ 感知协同层:让数据在时间中"有意义"

最上层的感知协同层,是 SmartMediaKit 真正区别于传统流媒体SDK的地方。

它关注的已不再是"流能否播放",而是流能否参与智能协同 。

在AI系统、机器人控制、无人机、工业检测、安防可视化等场景中,

这一层承担着"让机器看懂世界,并在同一时间域做出决策"的任务。

-

多通道时序融合:视频、音频、传感数据、AI事件在同一时钟下汇聚;

-

跨平台接口体系:Android、iOS、Windows、Linux、Unity3D 全平台统一调用;

-

轻量级实时分发:通过 HTTP-FLV / WS-FLV / RTMP 模块实现毫秒级回传与联控;

-

AI边缘协同接口:允许边缘节点在流处理过程中直接进行模型推理与回传;

-

系统级反馈闭环:结合GB28181与控制协议,实现监控、调度与自动响应。

这一层的目标,是让智能系统形成"时间闭环":

看到 → 判断 → 反馈 → 再看到。

每一环节都由 SmartMediaKit 的时间机制承载,使系统在毫秒尺度上实现协同自洽。

安卓RTSP播放器多实例播放时延测试

⏱ 一种新的系统秩序:时间先于智能

SmartMediaKit 的这三层架构,并不是松散的功能叠加,而是围绕"时间"展开的系统设计。

它让智能系统不再被动等待输入,而能在连续的时间流中做出实时反应。

在AI与具身智能的未来图景中,

谁能控制时间的精度,谁就能定义智能的边界。

而 SmartMediaKit,正是这条时间链上的"系统级引擎"。

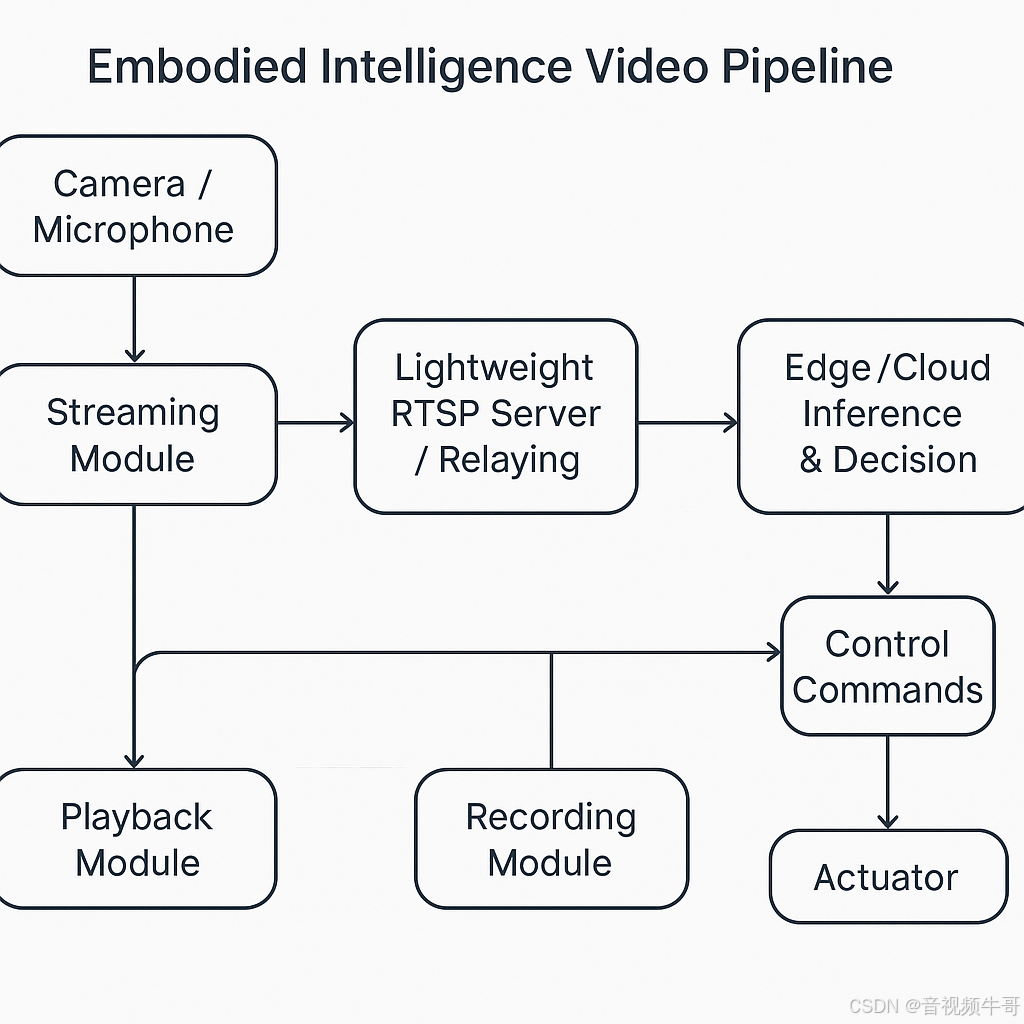

四、AI 的"感知鸿沟":从内容级理解到情境级同步

当前的多数 AI 系统,仍停留在"内容级理解"的层面。它们能分析语义、识别物体,却无法真正理解时间与情境的连续性。对于系统而言,"看到一帧画面"与"理解一个场景"之间,隔着的是完整的时间维度。

在现实世界中,感知并不是静态的识别,而是一种基于时间序列的认知 。

无人机在飞行中判断地面目标,安防系统分析异常行为,巡检机器人识别设备状态,这些都依赖于多帧画面的时序关联与延迟控制。

当时延过大或流不同步,AI 就会失去对场景的因果判断力------看到的已经不是"现在",而是几百毫秒前的"过去"。

SmartMediaKit 在此扮演的角色,是让这种"时间鸿沟"消失。

它通过统一的音视频时钟域与低延迟传输管线,让视觉、声音、控制指令、AI 推理结果都在同一时间线上运行。

-

实时音视频采集与降噪机制,确保输入信号清晰稳定,减少模型误判;

-

AI-YUV 数据接口,让算法在毫秒级帧间差异中进行分析与学习;

-

SEI 元数据通道,使识别结果与视频流同步返回,实现"边看边理解";

-

跨模块时间域一致性,让多节点系统(边缘端、云端、显示端)保持感知共振。

在这样的架构下,AI 不再只是被动处理输入,而是以"时间为坐标"参与世界。

它能够理解动作的节奏、语音的情绪、场景的连贯性------从"内容理解"走向"情境理解"。

SmartMediaKit 让智能系统拥有了真正的时间感 。

这是从工具到系统的转折点,也是在具身智能时代最被忽视、却最关键的能力。

Android平台Unity3D下RTMP播放器延迟测试

五、SmartMediaKit:AI系统的"神经基础设施"

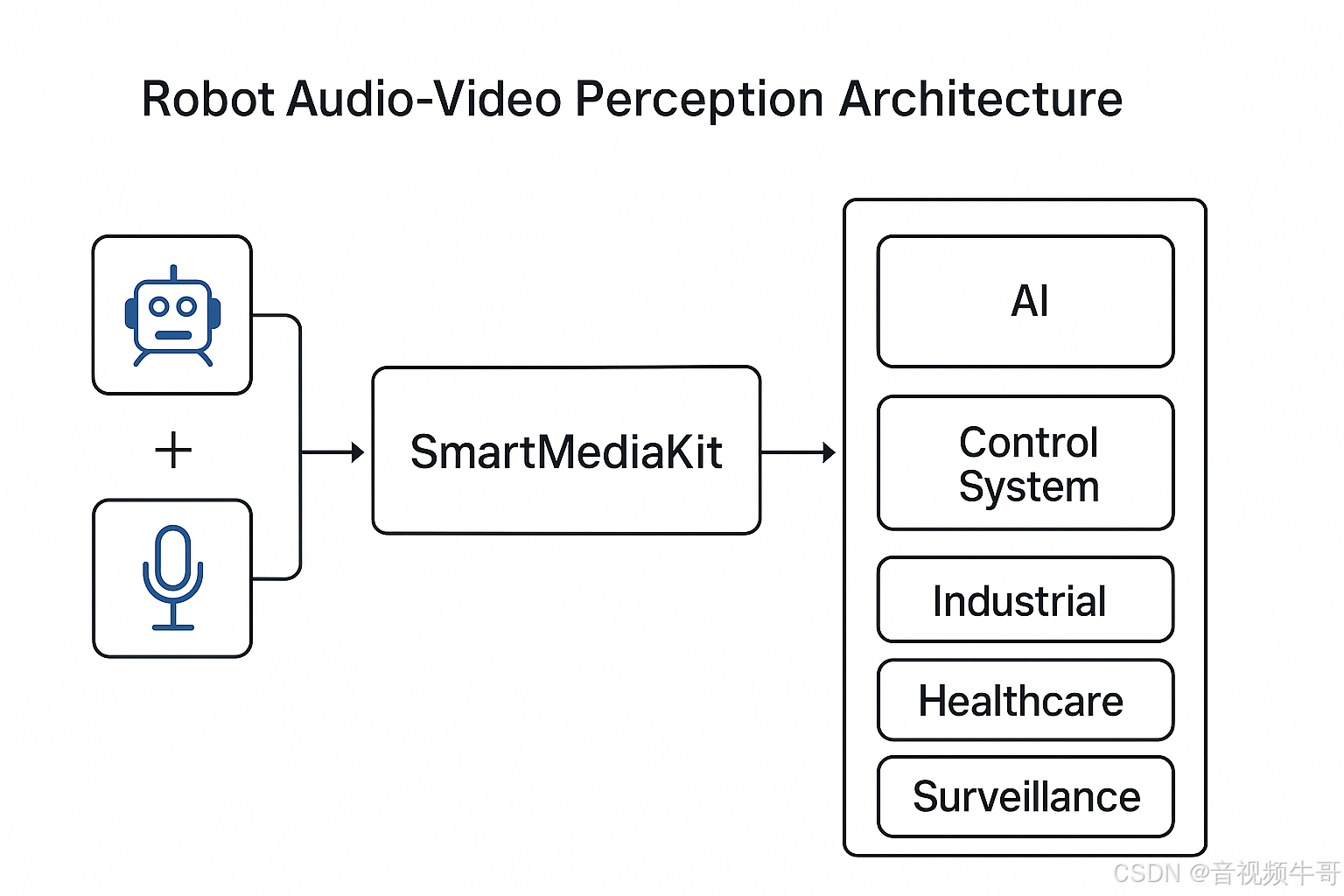

当AI系统能够在同一时间域中理解、判断并执行时,它就具备了"感知的连续性"。而这种连续性,正是智能从"推理"迈向"存在"的关键一步。SmartMediaKit的意义,正在于为这种连续性提供底层支撑。

在具身智能与实时视频系统的架构中,SmartMediaKit承担着与神经系统相似的角色:它让感知信号能够毫秒级流动,让反馈路径始终连通,让智能在时间中维持自洽。

在AI系统的层级结构中,可以将SmartMediaKit视作连接"计算"与"行动"的那一层:

| 层级 | 功能定位 | 系统类比 |

|---|---|---|

| 算力层(GPU/NPU) | 提供推理与训练能力 | 大脑皮层 |

| 算法层(大模型/AI框架) | 负责语义理解与决策生成 | 思维与逻辑中心 |

| SmartMediaKit层(实时流媒体内核) | 负责感知输入、时序同步与实时反馈 | 神经传导系统 |

| 执行层(机械臂/摄像机/显示端) | 负责动作与输出呈现 | 肢体与反射系统 |

这一层并不直接产生"智能",但决定了智能是否能及时显现 。

无论是机器人控制、远程诊断、无人机视频链、还是AI巡检系统,

都依赖SmartMediaKit提供的低延迟、跨平台、可编排的音视频通道。

-

在工业与安防系统中,它保证监控画面与决策指令的时序一致;

-

在无人机与低空应用中,它让"边看边控"成为可实现的实时闭环;

-

在AI推理与视觉计算场景中,它将YUV原始帧直接供模型读取,实现毫秒级响应;

-

在多节点协同系统中,它通过统一时间域与协议桥接,使多端AI具备"共同的现在"。

SmartMediaKit的核心价值,不在于提供播放或推流功能,而在于为AI系统建立一个可被信任的实时层 。

当算力、算法与感知在同一时间框架下协同工作时,智能就从静态推理变成了动态存在。

在这个意义上,SmartMediaKit不仅是一套SDK,更是一种系统哲学:

它以时间精度、结构秩序与稳定性 为核心设计原则,

让AI的反应具备物理上的确定性与工程上的可预测性。

智能的真正边界,不在算法的复杂度,而在系统对时间的掌控力。

SmartMediaKit,让时间成为智能的底座。

六、结语:时间秩序与智能的未来

智能系统的发展,最终会从算法的竞赛回归到系统的秩序。

算法定义了智能的"思维",而系统定义了智能的"存在"。

当一个系统能够在毫秒级时间内自洽地完成感知、判断与反馈,它所展现的,就不再是技术上的"功能",而是物理层面的"反应能力"。

时间,是智能的真正边界。

延迟不只是体验问题,它是系统能否保持与现实同步的门槛。

一个能稳定在时间中运作的系统,才具备理解和影响世界的基础。

在这一意义上,大牛直播SDK(SmartMediaKit)不仅是一套流媒体开发工具,而是一种系统思维的体现 。

它以时间为核心变量,以稳定为设计信条,让AI系统的每一帧画面、每一段音频、每一次反馈都处于同一时序中。这不是追求"更快",而是让"快"成为秩序的一部分。

随着具身智能、低空网络、工业自动化和AI感知节点的快速扩展,智能系统的连接密度正在指数级增长。在这种复杂结构中,只有具备稳定时间基准的架构,才能让AI协同而非冲突,让系统演化而非坍塌。

SmartMediaKit 正在构建的,正是一种新的系统基建范式------它不依附于特定模型,不追逐短期概念,而是在时间维度上,为智能的长期演进打下物理基础。

真正的智能,不是算得更多,而是反应得更准。

当时间成为系统的语言,

智能,才真正融入现实。

📎 CSDN官方博客:音视频牛哥-CSDN博客