传送锚点

-

- [专为真实图像优化的多语种 OCR](#专为真实图像优化的多语种 OCR)

- 多模态训练不等同于实际效果

- 准确率比肩顶级选手

- 推荐场景与使用方式

专为真实图像优化的多语种 OCR

NCSOFT 发布的 VARCO-VISION-2.0-1.7B-OCR,是当前视觉 OCR 模型里一个很值得关注的新成员。相较于那些动辄十几亿参数的多模态大家伙,这个模型只有 17 亿参数,但效果并没因为"瘦身"而缩水。

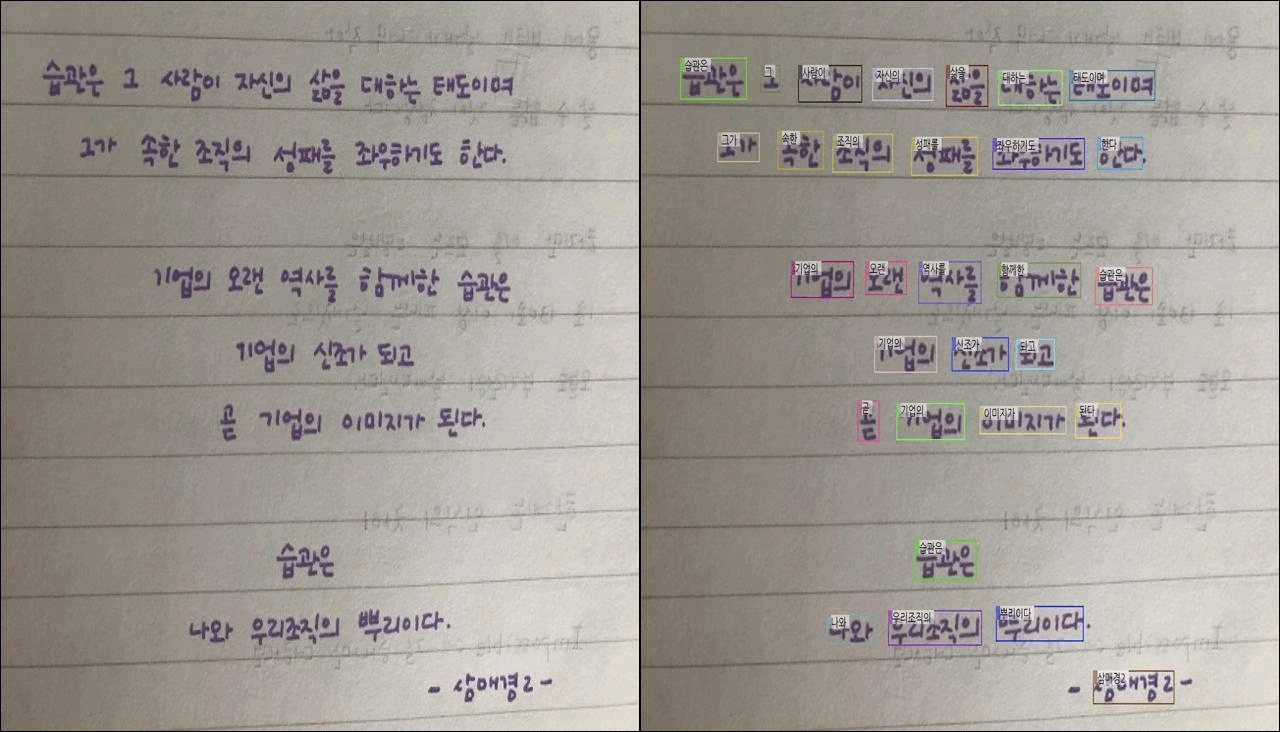

它不是普通的图文大模型(VLM),也不只是提取图片里的文字。它还有精确的字符定位能力,也就是说,不只是识别出"是什么字",还可以告诉你"在哪个地方"。输出直接给出每个字符和其边界框,这对于表单解析、票据采集或者文档重构这样对排版有需求的场景,是个工程师会喜欢的加分项。

多模态训练不等同于实际效果

很多多模态大模型看似能阅读图文,其实对正式的 OCR 工作并不友好。大模型容易"看懂但不准",特别是在分辨密集字符或检测视觉边角内容时表现不佳。而这种偏"轻"OCR 专用模型给出的结果恰恰更准确,响应更快,还少占内存,对资源控制严重的场合相当实用。

并且,一般 OCR 模型在英文文档和拉丁文本下没问题,但一遇韩语或中日韩混杂文本就经常抓瞎。VARCO-VISION-2.0-1.7B-OCR 明确支持韩语和英语,至少在亚洲场景中处理混合字体的实用性会比一票英语训练优先的模型更靠谱。

准确率比肩顶级选手

从多个标准数据集来看,它在 CORD、ICDAR2013、ICDAR2015 中的表现都很有竞争力。尤其在 CORD(文档场景)和 ICDAR2013(自然图像文字)中的准确率分别达到了 95.6 和 95.5 分,超过 PaddleOCR 和 EasyOCR,也胜过不少大模型。

NCSOFT 的策略其实很有意思。它们用 siglip2-so400m-patch16-384 作为视觉编码器,再结合 Qwen3-1.7B 语言基础模型做成这个低配高效的对照实验。从参数组合到最终配置,都是围绕"单一任务最大化"来设计的,这是一种比所谓通用大模型更聚焦也更节能的思路。

推荐场景与使用方式

这个模型非常适合跑在本地 GPU 设备上,不需要云端部署,不用额外爆显存。唯一需要注意的是,输入图片最好扩放到 2304 的长边分辨率,这样模型可以识别得更干净。

相关项目地址可见如下:

Hugging Face 模型页面:NCSOFT/VARCO-VISION-2.0-1.7B-OCR

https://huggingface.co/NCSOFT/VARCO-VISION-2.0-1.7B-OCR

完整论文报告已挂在 arXiv:

https://arxiv.org/abs/2509.10105

如果你正准备部署一个文件结构抽取系统、表格识别工具,或者移动 OCR 应用,重训练巨大模型不再必须。VARCO-VISION-2.0-1.7B-OCR 是个值得验证的替代方案。