目录

[2.1 "造梦师"------GigaWorld-0-Video:负责视觉的无限想象](#2.1 “造梦师”——GigaWorld-0-Video:负责视觉的无限想象)

[2.2 "物理法则守护者"------GigaWorld-0-3D:确保梦境的真实落地](#2.2 “物理法则守护者”——GigaWorld-0-3D:确保梦境的真实落地)

🎬 攻城狮7号 :个人主页

🔥 个人专栏 :《AI前沿技术要闻》

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 极佳视界开源具身世界模型GigaWorld-0

📚 本期文章收录在《AI前沿技术要闻》,大家有兴趣可以自行查看!

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

前言:机器人学习的"数据荒"困境

在语言和视觉大模型的领域,"大力出奇迹"的缩放定律(Scaling Law)早已被验证------只要数据量足够大,模型的能力就会持续涌现。然而,当AI试图从数字世界走向物理世界,为机器人赋予"身体"时,这条定律却遭遇了前所未有的挑战。

原因很简单:数据。

获取高质量的机器人交互数据,是一件极其昂贵、缓慢且充满不确定性的事情。在真实世界中,让机器人一遍遍地试错来采集数据,不仅成本高昂,而且永远无法覆盖所有可能遇到的边缘场景(比如一个从未见过的杯子,或一种奇怪的光照环境)。而传统的仿真环境虽然能快速生成数据,但其与真实世界之间存在着巨大的"次元壁"(Sim-to-Real Gap),用仿真数据训练出的模型,一到现实中往往就"水土不服"。

这种"数据荒",正是制约具身智能发展的核心瓶颈。

一、范式革命:从"数据采集"到"数据生成"

GigaWorld-0提出的解决方案,是一场彻底的范式革命。它不再执着于如何更高效地"采集"数据,而是转向了如何更高质量地"生成"数据。其核心理念是**"世界模型即数据引擎"**------构建一个对物理世界运行规律有深刻理解的AI模型,让它成为一座能够源源不断产出高质量训练数据的工厂。

这座"数据工厂"的目标,是生成兼具多样性、逼真度、物理一致性且可控的合成数据,从而彻底摆脱对物理采集的依赖。

二、探秘"数据工厂":GigaWorld-0的双流协同架构

为了实现这一宏伟目标,GigaWorld-0设计了一套精巧的双流协同架构,它像一个团队,由"造梦师"和"物理法则守护者"两个核心角色组成。

2.1 "造梦师"------GigaWorld-0-Video:负责视觉的无限想象

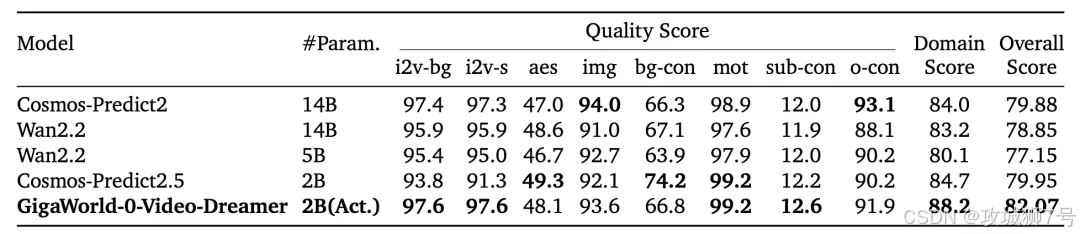

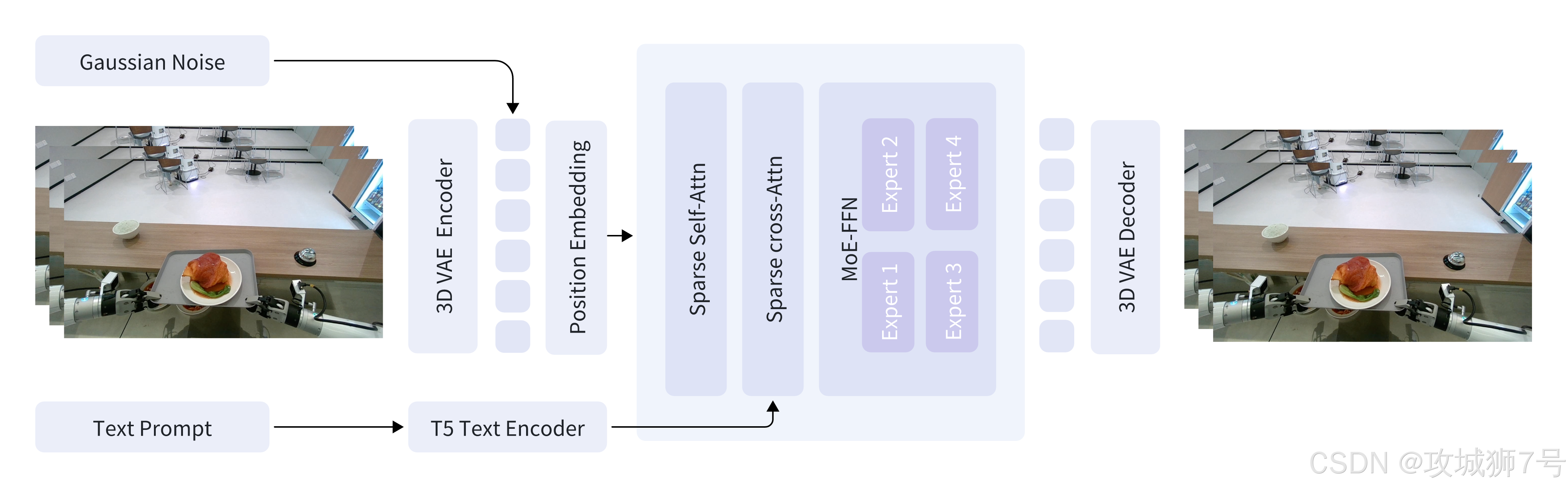

这一部分是数据工厂的创意核心,它基于强大的视频生成模型(Diffusion Transformer),负责生成视觉上丰富多彩、纹理逼真的机器人操作视频。它不仅能生成,更能"魔改"现实,为数据注入无穷的多样性。

(1)核心技术:为了在生成高清长视频时兼顾效率,它采用了稀疏注意力(Sparse Attention)和混合专家(MoE)架构。这相当于让模型在处理视频时能"抓住重点",只激活部分"专家"网络来处理特定区域,从而在保持巨大模型规模的同时,极大地降低了计算和显存开销。

(2)三大"魔法"能力:

*** 外观迁移(AppearanceTransfer):**这是解决视觉泛化问题的关键。它可以保持视频中机器人的动作不变,但将桌子的材质从木纹变成金属,或将苹果的颜色从红色变成绿色。这种"指鹿为马"的能力,让机器人在训练阶段就见识过千奇百怪的物体,从而在现实中遇到新东西时不再"少见多怪"。

*** 视角迁移(ViewTransfer):**解决空间泛化问题。它可以将一段从机器人头顶视角拍摄的视频,"重绘"成从侧面或斜前方观察的视角。这让模型学会了"物体恒常性",明白无论从哪个角度看,杯子依然是那个杯子。

*** 模仿迁移(MimicTransfer):**这是最具想象力的一招,它能将互联网上无穷无尽的人类操作视频(比如做饭、打扫卫生的视频),转换成机器人执行相同任务的视频。这相当于把YouTube变成了一座取之不尽的机器人训练数据金矿。

2.2 "物理法则守护者"------GigaWorld-0-3D:确保梦境的真实落地

如果只有"造梦师",生成的视频可能会出现物体穿模、悬空、违反力学定律等"灵异现象"。"物理法则守护者"的角色,就是为这些天马行空的梦境"接地气",确保每一帧画面都严格遵守几何与物理规律。

(1)构建逼真环境(背景重建): 它使用前沿的**3D Gaussian Splatting (3DGS)**技术,能够从几张照片中极速重建出照片级真实感的3D环境,无论是杂乱的厨房还是光影复杂的客厅,都能精准还原。

**(2)创造多样物体(前景生成):**利用3D生成模型,按需创造出各种形状、大小的交互物体,确保它们具有真实的3D几何结构。

**(3)赋予物理属性(物理参数辨识):**这是连接视觉与物理的关键桥梁。单纯的3D模型没有重量和摩擦力的概念。该组件利用强大的视觉语言模型(VLM)作为"物理专家",通过"看"一张图片就能推断出物体的物理属性(比如看到海绵就推断它很轻、很软),并将这些参数注入到仿真引擎中。

**(4)规划合理动作(运动规划):**最后,它会基于这个物理一致的环境,规划出机器人真实可行的运动轨迹,确保生成的动作符合机器人自身的运动学限制,杜绝"骨骼惊奇"的离奇动作。

通过"造梦师"和"守护者"的紧密协作,GigaWorld-0产出的数据,既拥有生成式AI带来的无穷视觉多样性,又具备物理引擎赋予的真实世界一致性。

三、高效的引擎:让"数据工厂"跑起来

如此宏大的架构,对算力是巨大的挑战。为此,极佳视界自研并开源了GigaTrain 高效训练框架。其核心突破在于,它是业内首个采用FP8混合精度进行端到端训练的世界模型。简单来说,就是用更低精度的数据格式进行计算,能将训练时的显存占用和计算成本降低近一半,同时几乎不损失模型性能。

这项工程上的突破,极大地降低了构建和使用世界模型的门槛,让这座"数据工厂"得以高效运转,也为社区的参与和发展铺平了道路。

四、终极考验:从虚拟梦境到真实世界

数据生成得再好,也要拿到真实世界里"是骡子是马,拉出来遛遛"。

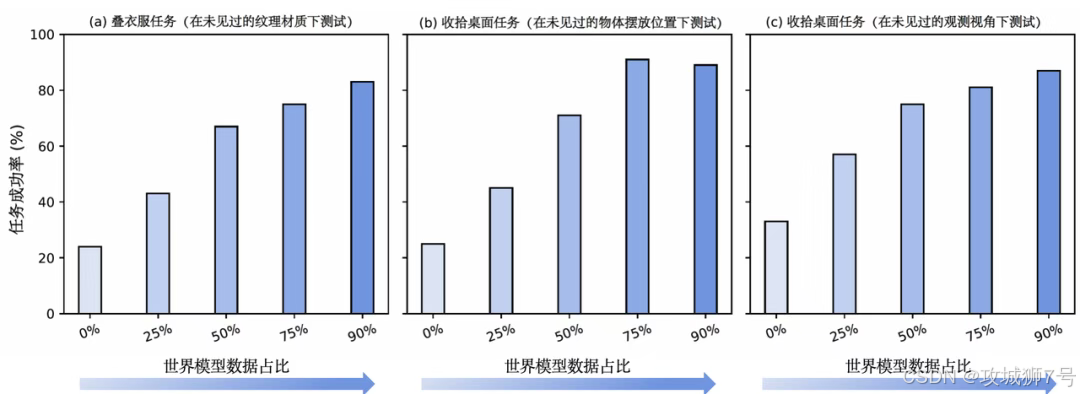

极佳视界用GigaWorld-0生成的数据,去训练一个名为GigaBrain-0的VLA(视觉-语言-动作)模型,也就是机器人的"大脑"。最惊人的实验结果是:

(1)90%的合成数据占比:在训练GigaBrain-0时,其中高达90%的数据都来自GigaWorld-0的生成,只有10%是真实数据。

(2)300%的性能飞跃:用这种混合数据训练出的GigaBrain-0,在部署到真实机器人上时,面对新纹理、新视角、新物体 位置这三大泛化挑战,其任务成功率比仅使用真实数据训练的模型提升了近 300%。

这意味着,GigaWorld-0生成的合成数据质量已经高到足以"以假乱真",能够让模型学到可泛化到真实世界的通用技能。这成功验证了"世界模型即数据引擎"这一范式的巨大潜力。

结论:开启具身智能的"工业化数据生产"时代

GigaWorld-0的发布和开源,其意义远不止于一个新模型。它为解决具身智能领域最核心的"数据瓶颈"问题,提供了一条清晰、可行的工程路径。它标志着机器人学习的模式,正从过去"手工作坊"式的被动数据采集,迈向"工业化"的主动数据生成时代。

背后的极佳视界,这家由顶尖学者创立、并获得华为等巨头投资的公司,正通过"世界模型平台GigaWorld"+"具身基础模型GigaBrain"+"通用本体Maker"的全栈布局,展现其构建物理世界通用智能的雄心。

随着GigaWorld-0这样的"数据引擎"变得越来越强大和易用,我们有理由相信,通往真正通用机器人的道路,将被极大地加速。

相关链接

* 项目主页: `https://giga-world-0.github.io/\`

* 代码链接: `https://github.com/open-gigaai/giga-world-0\`

* 训练框架: `https://github.com/open-gigaai/giga-train\`

* 论文链接: `https://arxiv.org/pdf/2511.19861\`

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!