拉斯维加斯的会展中心再度被全球科技目光聚焦------2025年亚马逊云科技(AWS)"AWS re:Invent 2025"12月1日正式启幕,超过6万人亲临现场,近200万观众在线接入,这场云与AI领域的年度盛会,正成为重塑互联网与云计算技术问世以来产业格局的关键场域。

当智能体AI逐步成为企业释放价值的核心引擎,其对产业的重塑力度,已不亚于当年互联网与云计算的诞生。

一边是微软Azure凭借与OpenAI的深度绑定,在生成式AI领域抢占先发声势;另一边是谷歌云依托Gemini生态,在AI原生基础设施赛道快速卡位,双重夹击下,亚马逊云科技此次并未止步于零散的技术迭代,而是直接亮出从AI基础设施、模型平台、企业数据管理,到智能体开发工具、前沿智能体应用的全链路布局,以"AI全栈能力"打响关键竞争。

亚马逊云科技首席执行官Matt Garman

这一布局的底气,在大会首日主题演讲中便清晰展现。亚马逊云科技首席执行官Matt Garman直言,AWS现已拥有全球规模最大、部署最广的AI云基础设施:当前其全球数据中心网络已覆盖38个区域、120个可用区,且已宣布规划新增三个区域;仅过去一年,便新增3.8GW的数据中心容量,规模稳居全球首位。

而Trainium 3芯片、AI工厂服务、Nova 2模型家族等重磅发布,则让这份"底气"落地为具体解决方案------既精准回应了行业对AI规模化落地的核心诉求,更以"算力+模型+生态"的协同优势,彰显出AWS在AI时代守住市场主导权的战略定力与技术硬实力。

主论坛开场的最重磅发布,直指自研AI芯片的迭代升级。在全球科技巨头对高性能、低成本算力的争夺进入白热化阶段,AWS Trainium系列AI训练芯片的每一次演进,都已成为影响行业格局的关键变量。

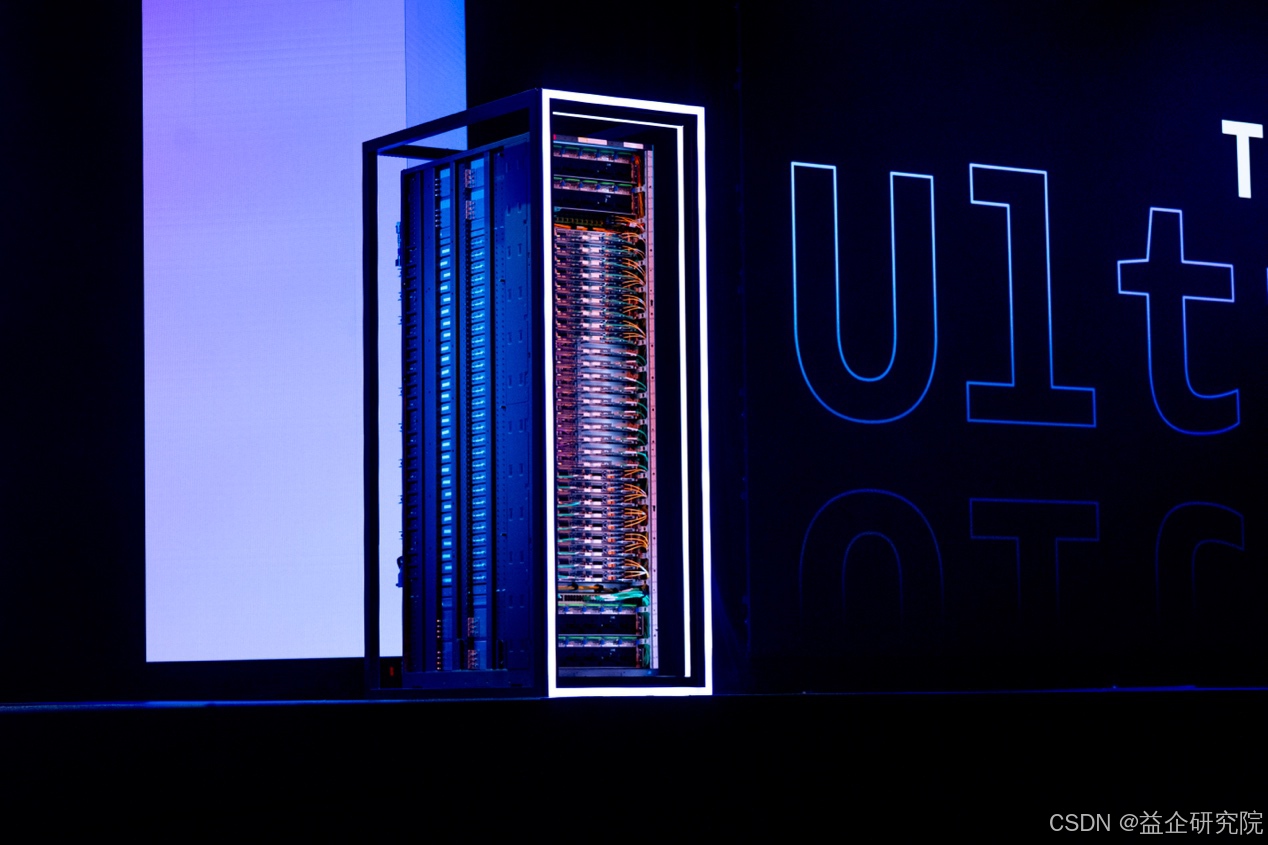

目前,AWS已部署超100万颗Trainium芯片(当前系列中速度最快型号),Amazon Bedrock平台上的大部分推理任务,均由该芯片驱动。而Matt Garman在演讲中官宣的Trainium 3 UltraServers,更是将算力竞争推向新高度------这款搭载AWS首款3纳米AI芯片的服务器,最大规格的EC2 Trn3 UltraServers可将144颗Trainium 3芯片整合为单一scale-up域,借助自研NeuronLink互连技术,单计算实例即可提供362 FP8 petaFLOPS算力与超700 TB/s聚合带宽。

相较于上一代Trainium 2,Trainium 3 UltraServers实现了全方位飞跃:计算能力提升4.4倍,内存带宽提升3.9倍,每兆瓦功耗可处理的AI tokens数量更是提升5倍。以OpenAI开源GPT-OSS模型的推理测试为例,在保持相同单用户延迟(即"交互性")的前提下,Trainium 3每兆瓦功耗输出的AI tokens数量,较Trainium 2提升超5倍,直观印证了其能效优势。

更具前瞻性的是,Matt Garman同步透露Trainium 4已进入深度设计阶段:与Trainium 3相比,其FP4计算性能将提升6倍、内存带宽提升4倍、高带宽内存容量提升2倍,专门为全球最大规模模型的训练需求打造。

这一系列迭代的意义远超"硬件升级"------它不仅帮助AWS大幅降低AI模型训练成本,更可能重塑云计算市场的竞争逻辑:通过算力性能与能效的双重突破,迫使竞争对手在定价策略与硬件性能上直面新的压力。

当微软仍依赖OpenAI的模型优势,谷歌聚焦Gemini的单模态突破时,AWS正以"垂直整合"重新定义竞争规则:它不追求某一环节的单点领先,而是通过端到端优化,让算力、平台、模型、数据管理、智能体开发工具形成的协同效应,最终形成对手难以复制的生态闭环。