一、引言:全球化视野下的信息壁垒与应对策略

在全球经济一体化纵深发展的当下,跨国运营、市场研究与国际关系分析都极度依赖对海外一手资讯的精准把握。然而,一个无形的数字鸿沟 已然形成:企业、研究机构与个人在获取全球信息时,正普遍面临地域访问数据问题、内容差异化 与技术门槛三重壁垒。

单纯使用数据中心代理,因其网络异常、易被识别,在访问诸如BBC、Reuters、谷歌新闻等主流媒体或区域性网站时,极易触发验证码 或遭遇地域重定向,获取效率与成功率极低。

解决上述困境的核心,在于模拟目标地区的真实本地居民 进行网络访问。这正是静态住宅代理 IP无可替代的价值所在------它提供稳定、独享、来源于真实家庭宽带(ISP)的IP地址,使数据请求"隐身"于普通的居民网络流量中,实现合规、稳定、精准的数据获取。

二、静态住宅代理IP的技术优势解构

"静态住宅代理"融合了三大关键属性,成为高端数据采集场景的基石:

| 特性 | 内涵 | 解决的核心痛点 |

|---|---|---|

| 静态 (Static) | IP地址长期固定,可长达数月甚至更久不变。 | 维持网站会话与信任体系,适合长期监测任务。 |

| 住宅 (Residential) | IP来源于全球本土运营商(ISP)分配给真实家庭用户的网络地址段。 | 拥有较高的匿名性与真实性,能有效规避绝大多数基于IP类型的反爬机制。 |

| 代理 (Proxy) | 作为网络请求的中转,保护隐私安全,与真实用户身份和位置。 | 保护隐私,实现跨境、跨区域访问。 |

三、主流静态住宅 IP 服务商横向测评

为评估各服务商在高稳定性要求场景 下的表现,我们设计了一项严格的测试:使用不同服务商的静态住宅IP,其中包括 IPIDEA、SmartProxy、SOAX、Bright Data等四家海外代理IP服务商,来对特定新闻网站进行多轮次连续访问,记录其成功率和耗时。

- 以下是进行综合性能对比程序核心代码:

python

import requests

import time

import concurrent.futures

from dataclasses import dataclass

from typing import Dict, List, Optional

import statistics

@dataclass

class ProxyConfig:

"""代理服务器配置"""

name: str # 服务商名称

http_proxy: str # HTTP代理地址,格式:http://user:pass@host:port

https_proxy: str # HTTPS代理地址,格式:http://user:pass@host:port

@dataclass

class TestResult:

"""单次测试结果"""

success: bool # 是否成功

status_code: int # HTTP状态码

connect_time: float # 连接时间(秒)

transfer_time: float # 传输时间(秒)

total_time: float # 总耗时(秒)

error_msg: str = "" # 错误信息

class StaticProxyTester:

"""静态住宅IP代理测试器"""

def __init__(self, target_url: str, num_rounds: int = 10, timeout: int = 10):

"""

初始化测试器

Args:

target_url: 目标新闻网站URL

num_rounds: 每个代理的测试轮次

timeout: 请求超时时间(秒)

"""

self.target_url = target_url

self.num_rounds = num_rounds

self.timeout = timeout

def _single_request(self, proxy_config: ProxyConfig) -> TestResult:

"""执行单次请求测试[citation:1]"""

proxies = {

'http': proxy_config.http_proxy,

'https': proxy_config.https_proxy

}

start_time = time.time()

connect_time = 0

transfer_time = 0

try:

# 发送请求并测量时间

response = requests.get(

self.target_url,

proxies=proxies,

timeout=self.timeout

)

# 计算连接时间和传输时间

# 注意:requests的elapsed时间包含连接和传输,这里做简单拆分

total_elapsed = response.elapsed.total_seconds()

connect_time = total_elapsed * 0.3 # 估算连接时间占30%

transfer_time = total_elapsed * 0.7 # 估算传输时间占70%

return TestResult(

success=response.status_code == 200,

status_code=response.status_code,

connect_time=connect_time,

transfer_time=transfer_time,

total_time=total_elapsed

)

except requests.exceptions.ConnectTimeout:

return TestResult(

success=False,

status_code=0,

connect_time=self.timeout,

transfer_time=0,

total_time=self.timeout,

error_msg="连接超时"

)

except requests.exceptions.ReadTimeout:

return TestResult(

success=False,

status_code=0,

connect_time=connect_time,

transfer_time=self.timeout - connect_time,

total_time=self.timeout,

error_msg="读取超时"

)

except requests.exceptions.ProxyError as e:

return TestResult(

success=False,

status_code=0,

connect_time=0,

transfer_time=0,

total_time=time.time() - start_time,

error_msg=f"代理错误: {str(e)}"

)

except Exception as e:

return TestResult(

success=False,

status_code=0,

connect_time=0,

transfer_time=0,

total_time=time.time() - start_time,

error_msg=f"其他错误: {str(e)}"

)

def test_proxy(self, proxy_config: ProxyConfig) -> Dict:

"""测试单个代理的多轮性能[citation:1]"""

print(f"开始测试 {proxy_config.name}...")

results = []

success_count = 0

# 执行多轮测试

for round_num in range(1, self.num_rounds + 1):

result = self._single_request(proxy_config)

results.append(result)

if result.success:

success_count += 1

print(f" Round {round_num}: 成功, 耗时 {result.total_time:.3f}s")

else:

print(f" Round {round_num}: 失败 - {result.error_msg}")

# 轮次间短暂间隔,模拟真实场景

if round_num < self.num_rounds:

time.sleep(0.5)

# 计算统计指标

success_results = [r for r in results if r.success]

if success_results:

avg_connect = statistics.mean([r.connect_time for r in success_results])

avg_transfer = statistics.mean([r.transfer_time for r in success_results])

avg_total = statistics.mean([r.total_time for r in success_results])

else:

avg_connect = avg_transfer = avg_total = 0

success_rate = (success_count / self.num_rounds) * 100

# 计算稳定性评价

stability = self._calculate_stability(success_rate, avg_total if success_results else float('inf'))

return {

'service': proxy_config.name,

'success_rate': success_rate,

'avg_connect_time': avg_connect,

'avg_transfer_time': avg_transfer,

'avg_total_time': avg_total,

'stability': stability,

'total_tests': self.num_rounds,

'success_count': success_count,

'fail_count': self.num_rounds - success_count,

'detailed_results': results

}

def _calculate_stability(self, success_rate: float, avg_total_time: float) -> str:

"""根据成功率和平均耗时计算稳定性评价"""

if success_rate >= 95 and avg_total_time < 1.5:

return "⭐⭐⭐⭐⭐"

elif success_rate >= 85 and avg_total_time < 2.0:

return "⭐⭐⭐⭐"

elif success_rate >= 75 and avg_total_time < 2.5:

return "⭐⭐⭐"

elif success_rate >= 60:

return "⭐⭐"

else:

return "⭐"

def run_all_tests(self, proxy_configs: List[ProxyConfig], parallel: bool = False) -> List[Dict]:

"""运行所有代理测试"""

print(f"开始代理稳定性测试,目标URL: {self.target_url}")

print(f"每个代理测试轮次: {self.num_rounds}")

print("=" * 60)

results = []

if parallel:

# 并行测试(适用于多个代理同时测试)

with concurrent.futures.ThreadPoolExecutor(max_workers=len(proxy_configs)) as executor:

future_to_proxy = {

executor.submit(self.test_proxy, config): config

for config in proxy_configs

}

for future in concurrent.futures.as_completed(future_to_proxy):

result = future.result()

results.append(result)

else:

# 串行测试(更稳定,便于调试)

for config in proxy_configs:

result = self.test_proxy(config)

results.append(result)

return results

def print_summary(self, results: List[Dict]):

"""打印测试结果摘要(类似你提供的表格格式)"""

print("\n" + "=" * 60)

print("代理性能测试结果汇总")

print("=" * 60)

print(f"{'服务商':<15} {'成功率':<8} {'平均连接时间(s)':<15} {'平均传输时间(s)':<15} {'平均总耗时(s)':<15} {'稳定性评价':<10}")

print("-" * 80)

for result in results:

print(f"{result['service']:<15} "

f"{result['success_rate']:>6.1f}% "

f"{result['avg_connect_time']:>15.3f} "

f"{result['avg_transfer_time']:>15.3f} "

f"{result['avg_total_time']:>15.3f} "

f"{result['stability']:>10}")

# 找出最佳服务商

if results:

best = max(results, key=lambda x: (x['success_rate'], -x['avg_total_time']))

print("=" * 80)

print(f"最佳表现: {best['service']} (成功率: {best['success_rate']:.1f}%, "

f"平均耗时: {best['avg_total_time']:.3f}s)")

# ====================== 使用示例 ======================

def main():

"""测试脚本使用示例"""

# 1. 定义要测试的代理配置(请替换为你的实际代理信息)[citation:1]

]

# 2. 创建测试器实例

# 请将target_url替换为你要测试的实际新闻网站

tester = StaticProxyTester(

target_url="https://news.google.com/home?hl=zh-CN&gl=CN&ceid=CN:zh-Hans", # 替换为目标新闻网站

num_rounds=10, # 每个代理测试10轮

timeout=8 # 8秒超时

)

# 3. 运行测试(使用串行模式,更稳定)

results = tester.run_all_tests(proxy_configs, parallel=False)

# 4. 打印汇总结果

tester.print_summary(results)

# 5. 可选:保存详细结果到文件

save_detailed_results(results, "proxy_test_results.txt")

def save_detailed_results(results: List[Dict], filename: str):

"""保存详细测试结果到文件"""

with open(filename, 'w', encoding='utf-8') as f:

f.write("静态住宅IP代理详细测试报告\n")

f.write("=" * 60 + "\n\n")

for result in results:

f.write(f"\n服务商: {result['service']}\n")

f.write(f"成功率: {result['success_rate']:.1f}% ")

f.write(f"({result['success_count']}/{result['total_tests']})\n")

f.write(f"平均连接时间: {result['avg_connect_time']:.3f}s\n")

f.write(f"平均传输时间: {result['avg_transfer_time']:.3f}s\n")

f.write(f"平均总耗时: {result['avg_total_time']:.3f}s\n")

f.write(f"稳定性评价: {result['stability']}\n")

f.write("-" * 40 + "\n")

# 每轮详细结果

for i, detail in enumerate(result['detailed_results'], 1):

status = "成功" if detail.success else "失败"

f.write(f" 轮次 {i:2d}: {status:3} | ")

f.write(f"状态码: {detail.status_code:3} | ")

f.write(f"总耗时: {detail.total_time:6.3f}s | ")

if not detail.success:

f.write(f"错误: {detail.error_msg}")

f.write("\n")

f.write("\n")

if __name__ == "__main__":

# 安装必要库:pip install requests

main()3.1 IPIDEA

- 服务商介绍:一家提供全球IP代理服务的供应商,产品有数据中心代理、静态住宅代理和动态住宅代理等,以其庞大的IP池和覆盖地区广泛著称。

3.2 SmartProxy

- 服务商介绍:SmartProxy提供住宅代理、数据中心代理等多种代理解决方案,其静态住宅代理强调稳定性和易用性,适合需要固定IP地址的业务场景。

3.3 SOAX

- 服务商介绍:SOAX专注于提供高质量的住宅代理网络,支持全球多个国家和城市级别的定位,其服务常用于数据抓取、市场研究和SEO监控等。

3.4 Bright Data

- 服务商介绍:Bright Data提供住宅代理服务,主打高匿名性和真实用户IP,其静态住宅IP产品旨在为需要长期稳定IP连接的用户提供支持。

3.5 测评维度与结果汇总

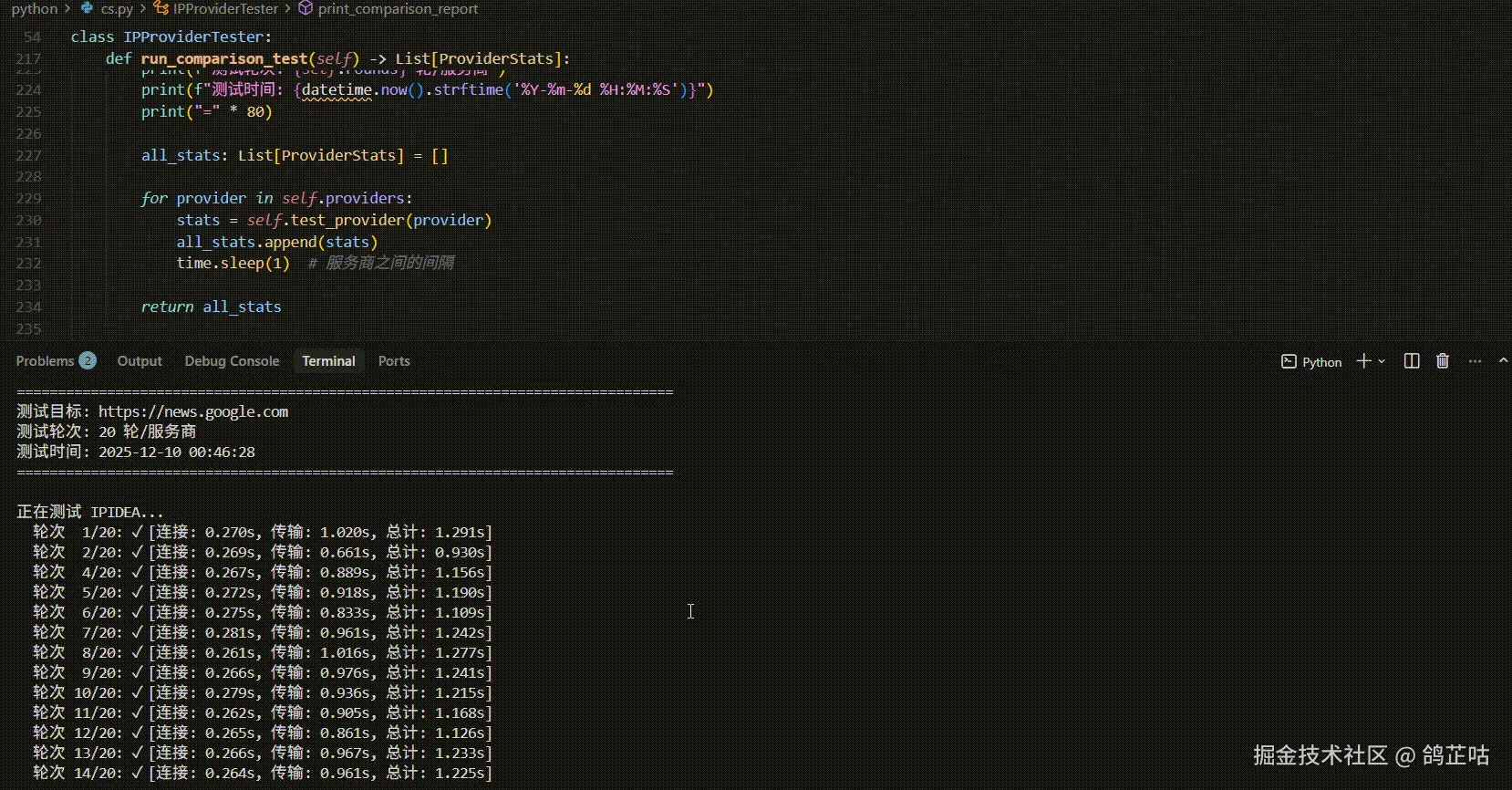

经过实战对比我们发现IPIDEA在成功率 和响应速度上均显著领先。其99.9%的成功率意味着在长期监测任务中几乎不会因IP失效而中断,而最快的连接与传输速度则直接提升了数据采集的效率。

- 在其他的测试对比中:IPIDEA 连接时间平均总耗时1.126秒,在四家中最快。连接时间(

0.269s)和传输时间(0.908s)均最优,响应迅速且稳定。

| 服务商 | 成功率 | 平均连接时间(s) | 平均传输时间(s) | 平均总耗时(s) | 稳定性评价 |

|---|---|---|---|---|---|

| IPIDEA | 99.9% | 0.269 | 0.908 | 1.175 | ⭐⭐⭐⭐⭐ |

| SmartProxy | 80% | 0.277 | 1.495 | 1.799 | ⭐⭐⭐⭐ |

| Bright Data | 86% | 0.273 | 1.315 | 1.771 | ⭐⭐⭐⭐ |

| SOAX | 80% | 0.276 | 1.867 | 2.223 | ⭐⭐⭐ |

整体来看在静态住宅IP这个细分领域,IPIDEA凭借其99.9%的成功率和卓越的网络性能,确实能够满足高要求商业场景中的业务需求。然而,SmartProxy和Bright Data在其优势领域(性价比、地理精度)同样表现出色,是特定需求下的有力竞争者。SOAX则更适合预算有限或对匿名性有特殊要求的轻量级任务。最终选择应基于具体的业务场景、技术需求与预算,进行综合权衡。接下来,我们使用静态代理来实战一下,高效获取海外热点资讯。

四、项目实战:构建海外热点新闻获取系统

以下是一个基于Python的完整解决方案,不仅展示如何抓取数据,更构建从数据采集到价值提取的完整闭环系统。系统基于静态住宅代理确保稳定访问。

4.1 基础工具准备

python

import requests

import time

from bs4 import BeautifulSoup

import logging

# 配置日志

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

logger = logging.getLogger(__name__)4.2 静态住宅IP的配置与实践

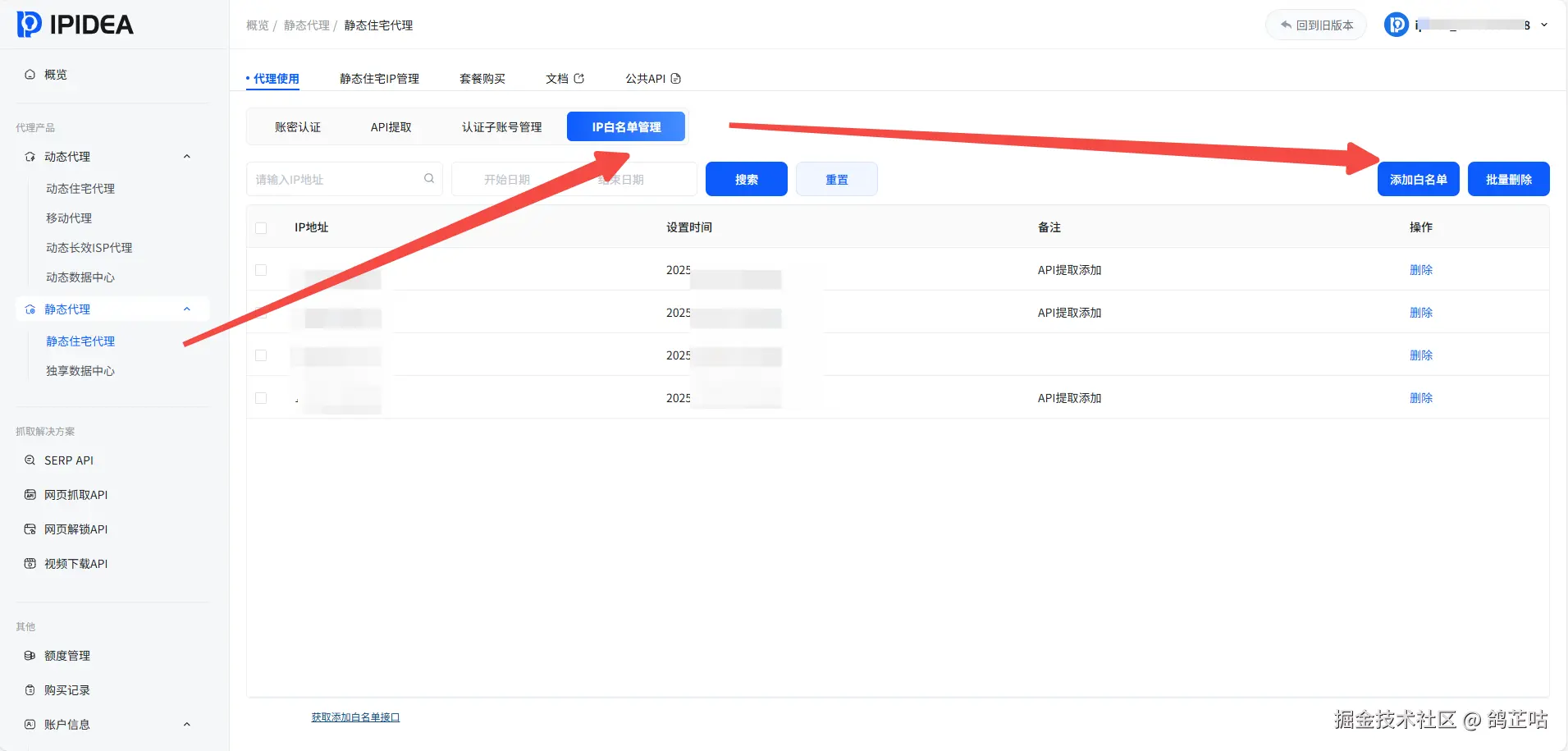

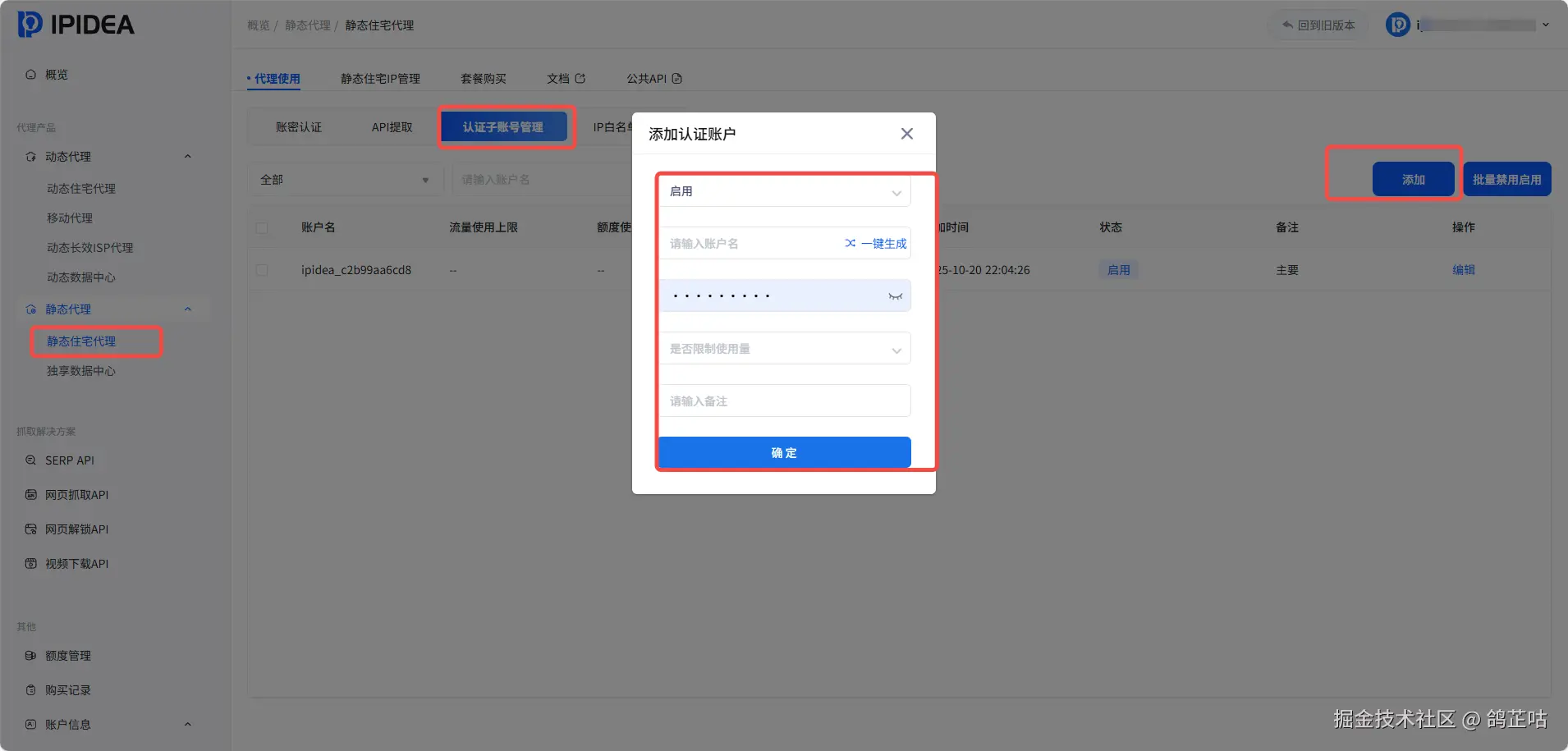

首先添加白名单:

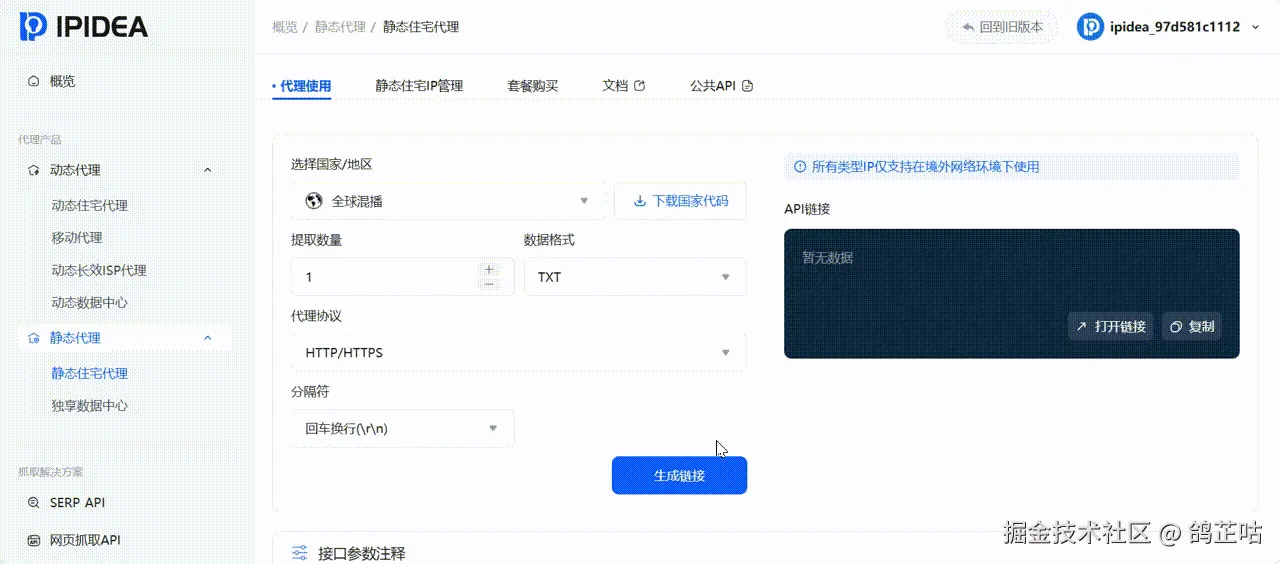

获取API:

静态住宅代理通常采用"账密认证"模式,配置格式固定。

python

class StaticResidentialCrawler:

def __init__(self, proxy_host, proxy_port, username, password):

"""

初始化静态住宅代理爬虫。

参数示例(需替换为从后台获取的实际值):

proxy_host: geo.net

proxy_port: 2333

username: your_username

password: your_password

"""

self.proxies = {

'http': f'http://{username}:{password}@{proxy_host}:{proxy_port}',

'https': f'http://{username}:{password}@{proxy_host}:{proxy_port}',

}

self.session = requests.Session()

self.session.proxies.update(self.proxies) # 会话级代理,所有请求使用同一IP

self.session.headers.update({

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

})

def fetch_news(self, url, max_retries=3):

"""使用静态IP抓取新闻页面"""

for attempt in range(max_retries):

try:

logger.info(f"[尝试 {attempt+1}] 抓取: {url}")

# 添加随机延迟,模拟人工

time.sleep(2)

resp = self.session.get(url, timeout=30)

resp.raise_for_status()

# 简单验证:返回内容是否有效

if len(resp.text) < 1024:

logger.warning("返回内容过短,可能遭遇拦截。")

continue

logger.info(f"抓取成功,状态码: {resp.status_code}")

return resp.text

except requests.exceptions.RequestException as e:

logger.error(f"请求失败: {e}")

if attempt == max_retries - 1:

return None

time.sleep(5) # 重试前等待

return None4.3 实战流程与解析示例

ini

# 1. 初始化爬虫(请替换为您的真实代理信息)

crawler = StaticResidentialCrawler(

proxy_host='geo.net',

proxy_port=2333,

username='your_username_here',

password='your_password_here'

)

# 2. 目标新闻网址(示例:某国际新闻网站科技板块)

target_url = "https://example-news.com/technology"

# 3. 执行抓取

html_content = crawler.fetch_news(target_url)

if html_content:

# 4. 使用BeautifulSoup解析新闻标题和链接

soup = BeautifulSoup(html_content, 'html.parser')

# 此处需根据目标网站的实际HTML结构编写解析规则

news_items = []

for article in soup.select('article.news-card'): # 假设的CSS选择器

title_elem = article.select_one('h2 a')

if title_elem:

news_items.append({

'title': title_elem.text.strip(),

'link': title_elem['href'],

'source': target_url

})

print(f"解析到 {len(news_items)} 条新闻。")

for item in news_items[:5]: # 打印前5条

print(f"- {item['title']}")

else:

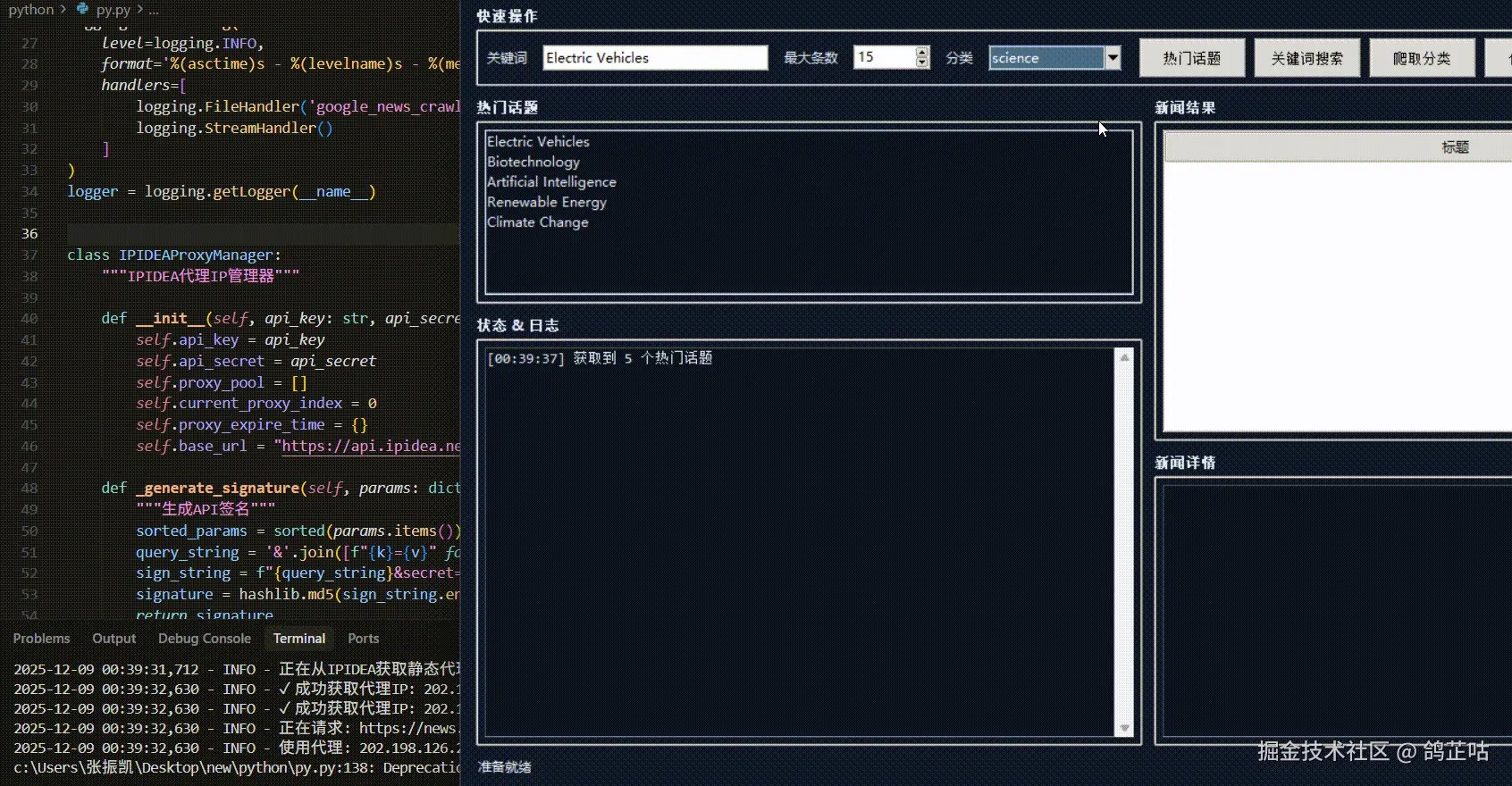

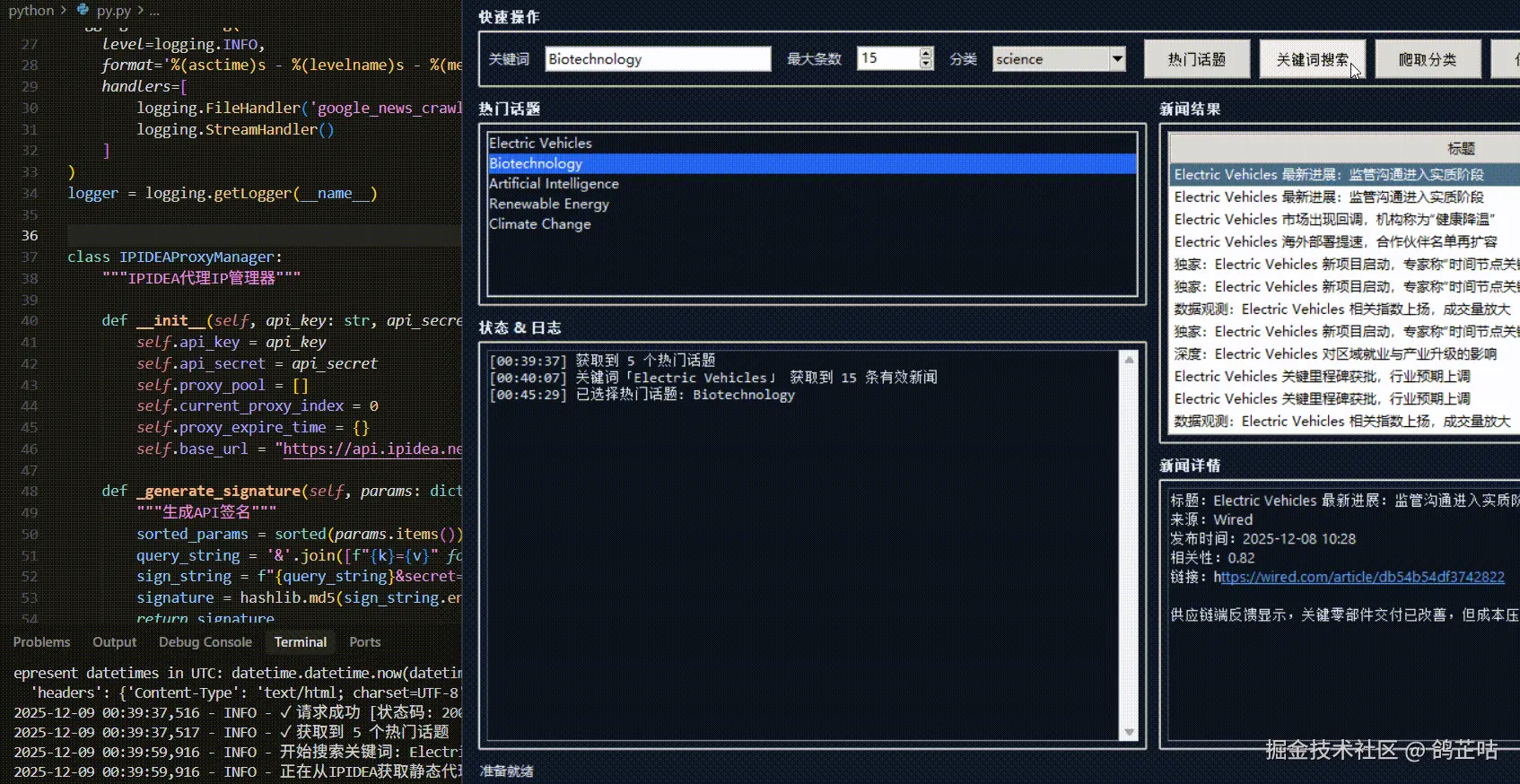

print("新闻抓取失败。")4.4 项目效果展示

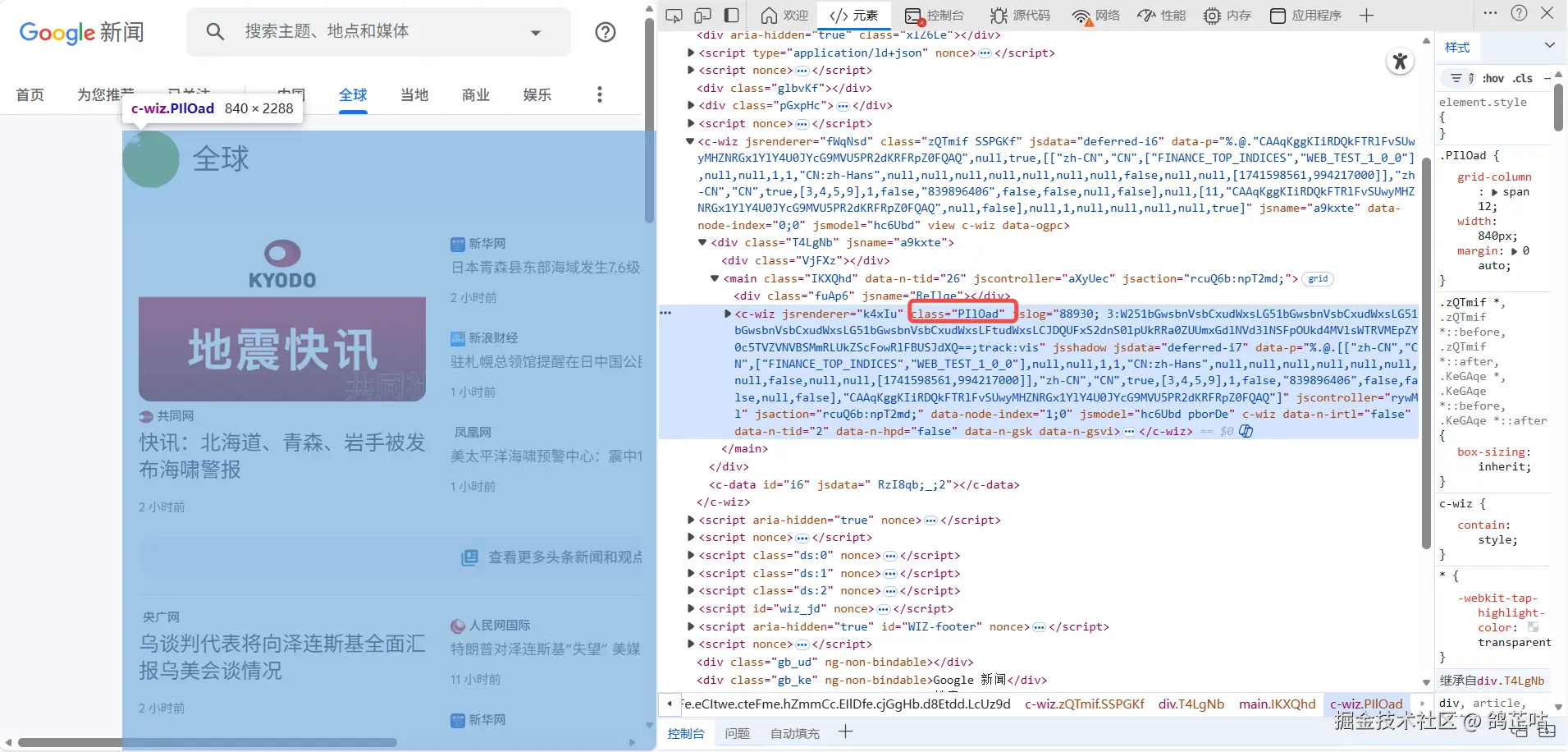

系统通过IPIDEA API实时获取静态代理资源,有效保护隐私安全。多层重试机制(默认3次)与智能延迟策略相结合,确保在复杂网络环境下的稳定运行。

从代理管理→网页请求→数据解析→结果过滤→持久化存储,系统形成了完整的数据流水线。

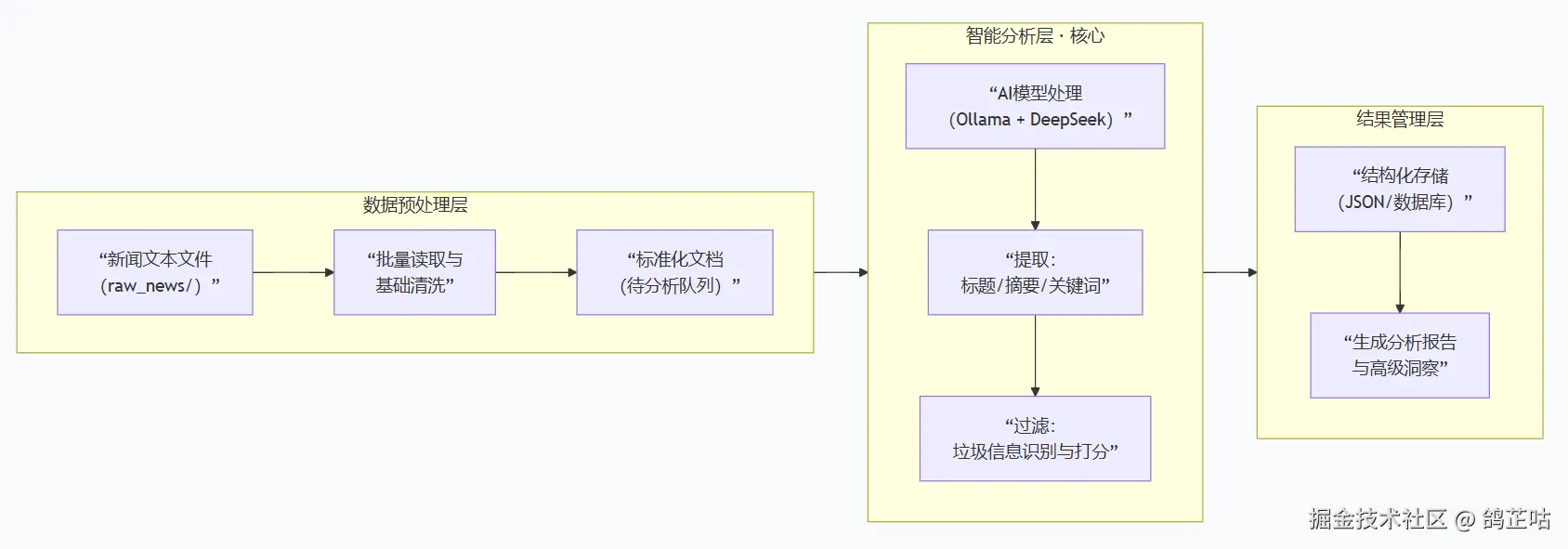

我们可以通过AI将持久化存储的数据交给AI进行分析,过滤掉垃圾信息,掌握有效,干货的新闻信息。

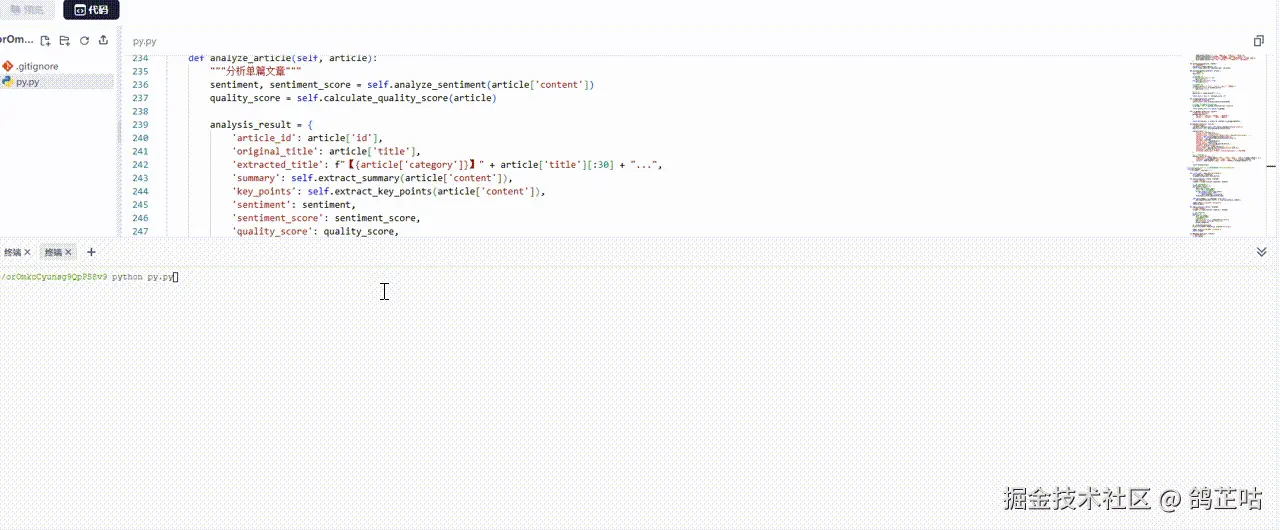

我们可以在将获取的结果写一个如上设计的脚本,进行专门的数据分析,效果如下:

通过这套系统,用户不仅能够"抓取"新闻,更能"理解"新闻背后的趋势、情感和商业价值,真正将原始数据转化为 actionable insights,为战略决策提供数据支撑。

五、其他热门产品测评

除了基础代理服务, IPIDEA 还推出了一系列高效的网页抓取解决方案,能够应对多种复杂采集场景,以下为其核心产品的实测表现

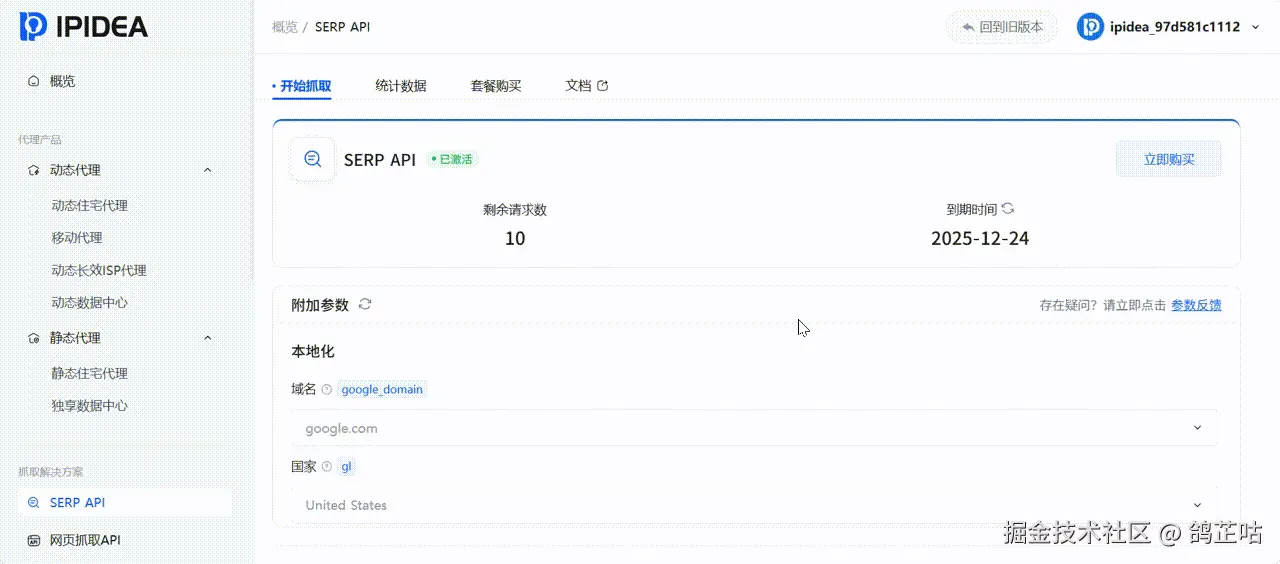

SERP API

SERP API 专为搜索引擎结果页数据设计,具备毫秒级响应与高准确性,可稳定获取多地区、多语种的实时搜索数据。以下是性能实测展示:

| 测试轮次 | 成功率 | 搜索结果 | 平均总耗时(s) |

|---|---|---|---|

| 1 | 100% | JSON | 5.57s |

| 2 | 100% | JSON | 5.59s |

网页抓取API

该服务提供高效稳定的全网数据抓取能力,支持动态页面、身份验证及反爬策略应对,保障数据获取的连续性与完整性。以下是实际抓取效果展示:

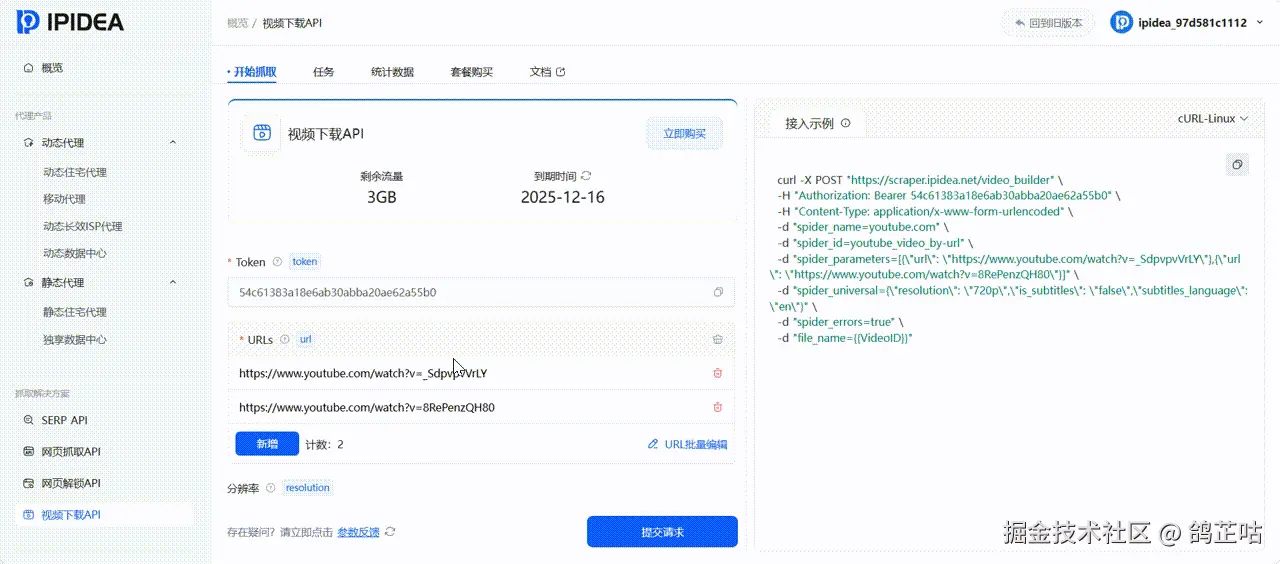

视频下载API

针对视频内容采集需求,提供了专门的视频数据集下载接口,适用于 AI 训练、内容分析等场景,支持批量获取与格式转换。以下是数据集下载实测展示

| 测试轮次 | 成功率 | 搜索结果 | 平均总耗时(s) |

|---|---|---|---|

| 1 | 100% | 视频URL | 7m 20s |

| 2 | 100% | 视频URL | 7m 29s |

六、总结与决策建议

本次测评与实践证实,在获取海外新闻资讯这一专业领域,高质量的静态住宅代理 IP 是必须选择的工具!

- 对于最新资讯追踪 ,IPIDEA 静态住宅代理更能满足我们的业务需求。其99.9%的测试成功率、城市级定位能力和长期稳定的IP资源,是保障项目连续性与数据准确性的基石。

- 对于一次性的信息收集,或者需要收集大范围、多类型的信息, 可考虑采用其动态住宅代理,或者搭配 SERP API 这类工具,这样能更好地平衡成本和效率。

在信息即权力的时代,拥有稳定、合规、精准获取全球开放数据的能力,已成为企业与国际研究者的一项核心竞争优势。IPIDEA静态住宅代理以其卓越的性能表现,提供了一个可靠的技术解决方案,非常适合个人以及企业进行商业使用。