今天给大家演示一个双人场景动作迁移的视频生成工作流。它把角色重绘、动作捕捉、图像编辑和视频生成串在一起,用一条完整链路实现从输入图像到最终双人舞蹈视频的效果。

整个流程依靠 Qwen Image Edit 系列模型和 WanVideo 视频生成体系,并结合多路图片编码、文本提示、姿态关键点与面部遮罩的综合处理,让角色既能保持风格,又能自然跟随目标动作。

文章目录

- 工作流介绍

-

- 核心模型

- [Node 节点](#Node 节点)

- 工作流程

- 大模型应用

-

- [TextEncodeQwenImageEditPlus 图像编辑语义控制编码](#TextEncodeQwenImageEditPlus 图像编辑语义控制编码)

- [WanVideoTextEncodeCached 视频语义文本编码](#WanVideoTextEncodeCached 视频语义文本编码)

- [WanVideoClipVisionEncode 多图视觉语义融合编码](#WanVideoClipVisionEncode 多图视觉语义融合编码)

- 使用方法

- 应用场景

- 开发与应用

工作流介绍

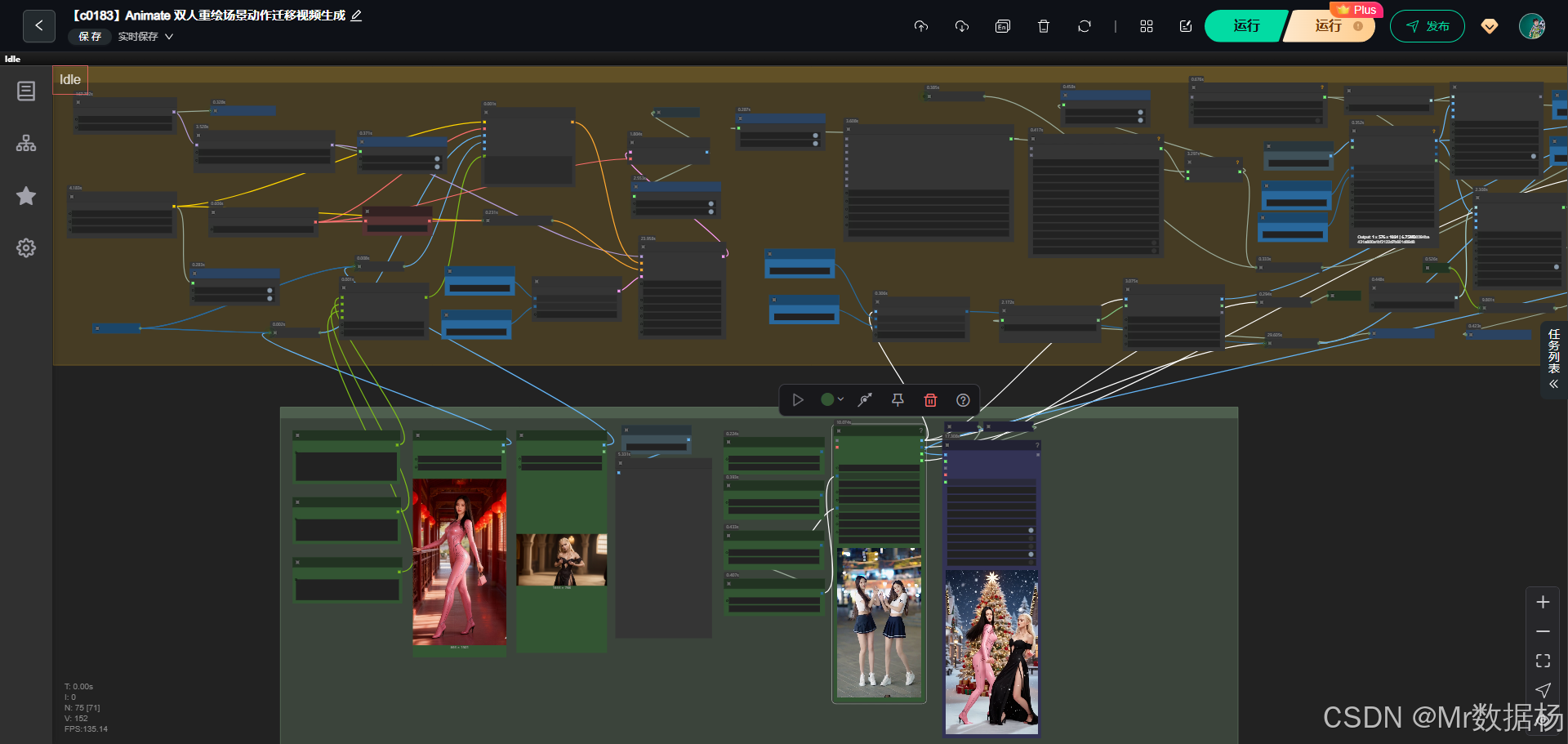

这个工作流基于 ComfyUI 搭建,核心思路是通过 Qwen Image Edit 模型完成场景与人物重绘,再用 WanVideo 的多模态编码器与视频生成模块进行动作迁移和最终视频输出。整套体系包含模型加载、文本与视觉编码、姿态关键点与面部遮罩生成、图像预处理、潜空间采样以及 WanVideo 视频渲染等环节。它通过多节点协作,把输入的两张人物图像转化为可控的动作视频。以上关键能力都来自模型和节点组合的共同作用。

核心模型

核心部分使用 Qwen Image Edit UNet 和其 Lightning 版本进行图像编辑,再结合 Wan2.1 系列 VAE、WanVideo 文本编码器和 CLIP Vision 编码器生成视频所需的多模态特征。模型之间通过 LoRA、采样器、潜空间等机制建立衔接,确保角色重绘精准、动作迁移自然。

| 模型名称 | 说明 |

|---|---|

| qwen_image_edit_2509_bf16.safetensors | 主体图像编辑 UNet 模型,用于重绘场景与角色风格保持 |

| Qwen-Image-Edit-Lightning-8steps-V1.0-bf16.safetensors | 快速推理版本,提高编辑与生成效率 |

| qwen_image_vae.safetensors | 图像编码/解码 VAE,负责潜空间转换 |

| Wan2_1_VAE_bf16.safetensors | 视频生成专用 VAE,提供更稳定的帧一致性 |

| clip_vision_h.safetensors | CLIP Vision 模型,用于图像特征提取与动作对齐 |

| umt5-xxl-enc-bf16.safetensors | WanVideo 文本编码模型,用于处理提示词 |

Node 节点

节点体系涵盖模型加载、图像预处理、参数管理、姿态与面部遮罩、文本与视觉编码、潜空间采样、视频渲染等多个维度。每个节点承担明确职责,像 ImageResizeKJv2 处理画幅、TextEncodeQwenImageEditPlus 负责融合图像与文本条件、KSampler 推动潜空间扩散、WanVideoClipVisionEncode 提取多图视觉特征等。节点之间的数据流让整个流程自动化、高度可控。

| 节点名称 | 说明 |

|---|---|

| UNETLoader | 加载 Qwen Image Edit 主模型 |

| LoraLoaderModelOnly | 注入 LoRA 权重增强风格特征 |

| VAELoader | 加载图像 VAE,负责编码解码 |

| ImageResizeKJv2 | 图像分辨率与裁切处理 |

| TextEncodeQwenImageEditPlus | 文本编码节点,用于图像编辑流程 |

| KSampler | 扩散采样器,生成潜空间内容 |

| EmptySD3LatentImage | 创建潜空间图像 |

| CLIPVisionLoader | 加载 CLIP Vision 模型 |

| WanVideoClipVisionEncode | 对输入图像生成视频视觉特征 |

| WanVideoVAELoader | 加载 WanVideo 的专用 VAE |

| WanVideoTextEncodeCached | 文本提示编码 |

| FaceMaskFromPoseKeypoints | 基于姿态关键点生成面部区域遮罩 |

| PixelPerfectResolution | 自适应分辨率计算 |

| PurgeVRAM | 模型缓存清理,避免显存堆积 |

工作流程

整个流程围绕人物图像的重绘、动作特征抽取、潜空间生成以及 WanVideo 的视频渲染展开。前期通过多路图像编码和分辨率处理,为后续动作迁移建立标准化输入。随后使用 Qwen Image Edit 的文本与视觉联合编码机制,把提示词和多张图像整合成一致的条件向潜空间传递。中段由 KSampler 在潜空间中完成扩散生成,确保角色外观、姿态、场景元素都能跟随目标动作。后段由 WanVideo 的视觉与文本编码器协同工作,将人物的视觉特征、视频风格需求和动作关键点整合,最终在专用 VAE 中渲染成多帧视频。整个链路从输入到视频导出完全自动化,保持角色一致性和动作自然衔接。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 输入预处理 | 将人物图像按视频需求调整尺寸与裁切,并生成面部遮罩等辅助数据 | ImageResizeKJv2、FaceMaskFromPoseKeypoints、PixelPerfectResolution |

| 2 | 模型加载 | 加载图像编辑 UNet、图像 VAE、WanVideo 专属 VAE 与 CLIP Vision | UNETLoader、VAELoader、WanVideoVAELoader、CLIPVisionLoader |

| 3 | 文本与图像编码 | 将提示词编码为文本特征,读取多张图像生成视觉特征,为重绘与动作迁移提供条件输入 | TextEncodeQwenImageEditPlus、WanVideoTextEncodeCached、WanVideoClipVisionEncode |

| 4 | 潜空间生成 | 创建空潜空间并通过扩散采样器生成核心图像潜变量 | EmptySD3LatentImage、KSampler |

| 5 | 角色重绘与风格融合 | 将视觉特征、提示词和动作信息整合到模型中完成角色外观与动作的统一 | LoraLoaderModelOnly、TextEncodeQwenImageEditPlus |

| 6 | 视频渲染 | 在 WanVideo 中依据视觉特征、文本特征与潜空间内容生成最终视频帧 | WanVideoVAELoader、WanVideoClipVisionEncode |

| 7 | 显存管理与输出 | 渲染结束后清理缓存并输出最终视频流 | PurgeVRAM |

大模型应用

TextEncodeQwenImageEditPlus 图像编辑语义控制编码

该节点承担图像编辑过程中的核心语义解析任务。它将用户输入的 Prompt 与多张图像特征一起编码成条件信息,驱动后续图像编辑模型在重绘时保持语义一致。Prompt 在此节点中扮演关键角色,负责控制人物动作、风格、表情以及整体画面的语义方向。用户通过调整 Prompt,可以影响编辑生成的精确度、视觉表现和细节质量。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| TextEncodeQwenImageEditPlus | 两个角色在跳舞 | 将文本提示与输入图像、VAE 编码共同处理,输出用于图像编辑的语义 Conditioning |

WanVideoTextEncodeCached 视频语义文本编码

此节点主要负责视频生成中的文本语义控制。它将 Prompt 编码为可被 WanVideo 模型理解的多模态文本特征。Prompt 在这里影响视频整体叙事倾向,包括人物动作节奏、表演风格以及镜头氛围。通过输入不同 Prompt,用户能让同一动作呈现完全不同的情绪和视觉语调,使视频生成更可控、更具表现力。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| WanVideoTextEncodeCached | 两个角色在跳舞 | 将 Prompt 文本编码成 WanVideo 格式的语义 Embedding,用于指导最终视频生成 |

WanVideoClipVisionEncode 多图视觉语义融合编码

该节点从多张输入图像中提取视觉特征,并将其编码为视频生成所需的视觉语义向量。Prompt 不直接写在节点中,但视觉 Embedding 会与 Prompt 所表达的语义共同决定最终视频的动作呈现方式。输入图像与 Prompt 的配合,帮助模型理解角色外观、动作趋势与整体视觉风格,从而实现视频中角色形象的一致性。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| WanVideoClipVisionEncode | (无文本 Prompt) | 编码输入角色图与动作图,形成视觉层面的潜变量语义,用于动作迁移与角色保持 |

使用方法

整个工作流在用户替换素材后可以自动完成从图像输入到视频渲染的完整链路。用户只需提供两类图像素材(角色图像与动作参考图)、可选音频以及文本 Prompt,系统就会根据这些信息自动处理分辨率、重绘、动作迁移、潜空间采样与最终视频生成。角色图决定人物外观,动作图负责提供动作结构,而 Prompt 则统领最终生成的风格、场景氛围与动作表现力度。完整工作流会自动串联各大模型节点,在不需要手动调整参数的前提下实现高质量的视频输出。

| 注意点 | 说明 |

|---|---|

| 角色图质量要高 | 清晰正面的角色图会带来更稳定的特征重建 |

| 动作参考要完整 | 动作图像越完整,动作迁移越顺畅自然 |

| Prompt 尽量明确 | 明确动作与风格描述能大幅提升生成一致性 |

| 分辨率需匹配工作流 | 图像过小可能导致细节缺失,需按工作流自动调整 |

| 避免多余背景干扰 | 清晰主体有助于视觉编码器稳定提取特征 |

| 不要频繁切换模型 | 频繁替换核心模型可能导致缓存错乱或显存占满 |

| 生成前检查节点连线 | 缺失连线会导致渲染中断或结果异常 |

应用场景

这个工作流适合所有需要把静态人物图像转化为动态动作视频的场景。它能把任意两个人物放入同一画面,让他们根据特定动作进行舞蹈或表演,同时保持角色外观一致。以 Qwen Image Edit 的风格稳定性结合 WanVideo 的动作逼真度,可以广泛用于创意内容制作、虚拟人视频生成、剧情分镜制作以及自媒体内容增强。其灵活的提示词系统和强大的多模态编码结构让用户可以轻松定义场景氛围、动作节奏以及镜头效果,从而快速生成可发布的视频内容。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 双人舞蹈视频生成 | 让两个人物在同一场景中跳舞并保持风格统一 | 自媒体创作者、短视频制作者 | 双人动作同步舞蹈视频 | 人物自然互动、动作连贯、风格统一 |

| 二次元角色动作迁移 | 让静态动漫角色完成动态动作 | 动画制作人、同人创作者 | 二次元角色表演视频 | 角色保持设定风格同时完成目标动作 |

| 虚拟人内容创作 | 生成多角色互动或表演类视频 | 虚拟主播、内容工作室 | 虚拟人舞蹈、对戏、展示片段 | 角色表情自然、动作真实、视频一致性高 |

| 影视分镜预演 | 快速制作动作示意视频 | 导演、分镜师 | 快速预演的动作镜头序列 | 提高创作效率,快速验证镜头结构 |

| 角色营销内容生成 | 为产品角色生成互动视频 | 品牌方、广告公司 | IP角色动作演示、互动短片 | 提升宣传吸引力与内容丰富度 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用