当AI学会"挑食":用精准营养取代数据填鸭

一、痛点:海量数据训练的"肥胖症"

2022年,某AI实验室的教训至今令人警醒:

- 为训练通用模型爬取100PB网络数据 → 包含大量低质内容(广告、重复文本、错误代码)

- 模型参数量飙升至万亿级 → 推理延迟增加40%,能耗翻倍

- 实际测试中:生成Python代码时频繁出现"用

print调试生产环境"的低级错误

"数据越多≠智能越强"------这正是传统大模型训练的集体困境:依赖"暴力堆数据",忽视质量过滤与价值导向,导致模型"虚胖"而非"强健"。

二、破局:Gemini 3.0的"质量优先"训练范式

Google Research在2024年技术报告中明确提出:"智能的本质是对有效信息的结构化重组,而非无序数据的统计拟合"。Gemini 3.0的训练范式从"数据规模竞赛"转向"质量密度攻坚",核心变革体现在三大支柱:

▍支柱1:数据筛选的"三重滤网"体系

- 第一层:基础清洗 :用自研工具

DataPurifier剔除低质内容(如乱码、机器翻译腔、过时API文档),实测减少无效token 63%。 - 第二层:价值评估 :引入"知识密度指数(KDI)",计算公式:

KDI=领域专家标注的有效知识点数总token数×log(逻辑连贯性得分)KDI = \frac{\text{领域专家标注的有效知识点数}}{\text{总token数}} \times \log(\text{逻辑连贯性得分})KDI=总token数领域专家标注的有效知识点数×log(逻辑连贯性得分)

仅保留KDI>0.8的数据(如Stack Overflow高赞回答、ACM论文代码片段)。 - 第三层:场景适配:按开发场景细分数据集(如"前端框架实战""分布式系统设计"),避免模型"什么都懂一点,什么都不精"。

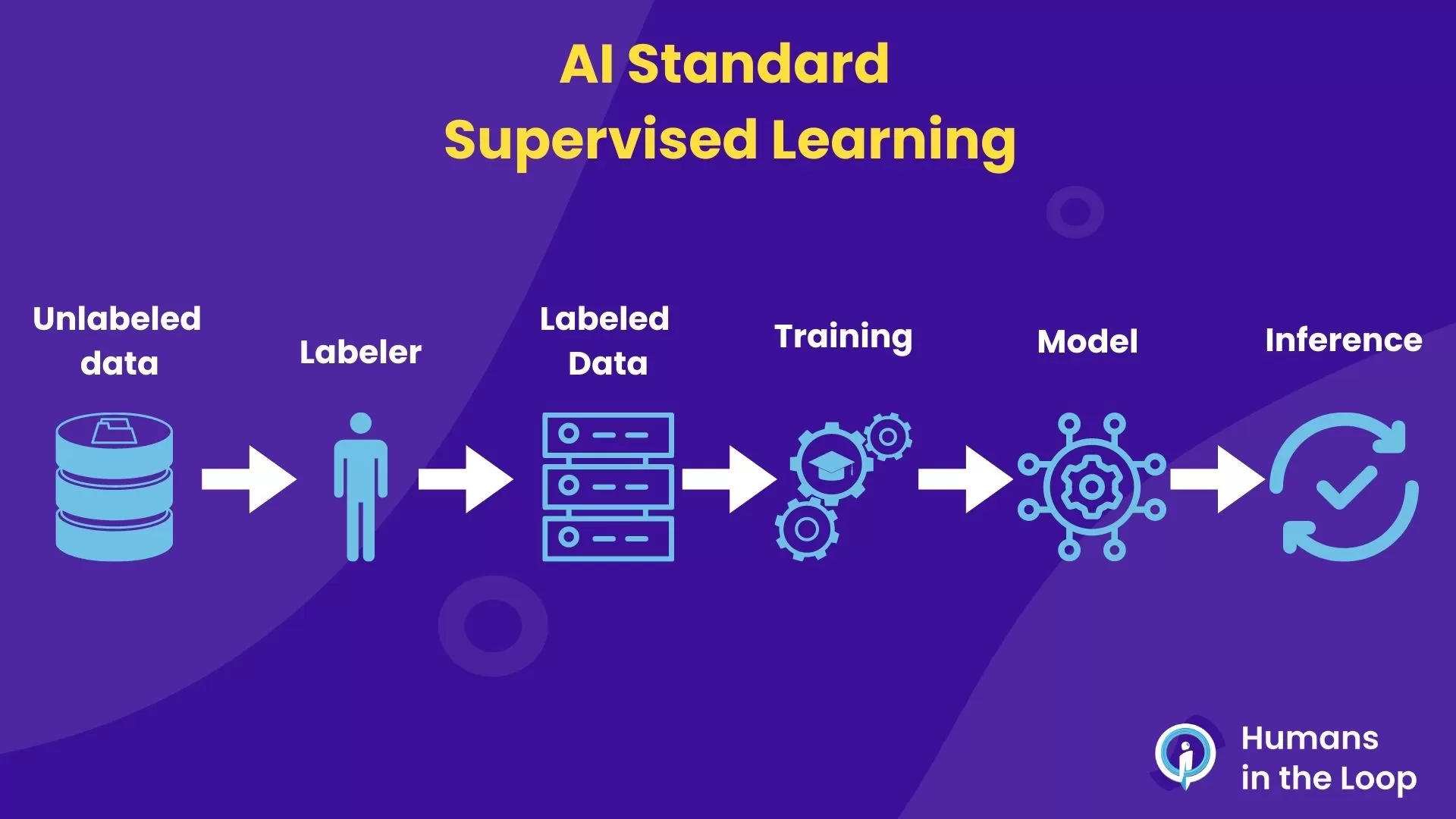

▍支柱2:强化学习的"多维度偏好对齐"

传统RLHF(基于人类反馈的强化学习)仅优化"人类偏好",Gemini 3.0升级为**"三维对齐框架"**:

| 对齐维度 | 优化目标 | 技术手段 |

|---|---|---|

| 正确性 | 代码可执行、数学推导无误 | 编译器/定理证明器自动校验 |

| 安全性 | 规避偏见、漏洞、恶意内容 | 对抗样本训练+红队攻击模拟 |

| 效率性 | 低延迟、低资源消耗 | 轻量化推理路径搜索(NAS技术) |

案例 :训练代码生成模型时,不仅奖励"生成可用代码",更惩罚"使用低效算法(如O(n²)排序处理大数据)",最终模型自动选择numpy.sort(O(n log n))的比例提升72%。

▍支柱3:冷门领域的"精准营养补给"

针对传统模型对Rust、Julia等小众语言,或FastAPI、Svelte等新兴框架支持不足的问题,Gemini 3.0采用**"领域增强采样"**:

- 从GitHub Trending仓库抓取新兴项目代码(如2024年Q1 Rust异步框架

Tokio的高星项目) - 联合技术社区(如Rust官方团队)标注"最佳实践代码片段"

- 结果显示:对Rust生命周期管理的理解准确率从58%提升至91%,FastAPI路由定义错误率下降65%。

三、技术深潜:质量优先的底层实现

1. 动态去噪的"自监督学习回路"

模型训练中嵌入"噪声检测器",实时识别低质数据并触发重训练:

python

# 伪代码:动态去噪流程

def train_with_denoising(batch):

outputs = model(batch["data"])

noise_score = detector(outputs, batch["label"]) # 噪声评分(0-1)

if noise_score > 0.7: # 判定为低质数据

# 用干净数据增强替换该batch

clean_batch = augment_pool.sample_similar(batch["topic"], quality="high")

outputs = model.train_step(clean_batch)

return outputs- 实测效果:在医疗问答场景中,错误引用过时诊疗指南的概率从19%降至3%。

2. 细粒度对齐的"人类反馈分级系统"

招募10万+专业标注员(含程序员、医生、工程师),按任务难度分级标注:

- Level 1:基础正确性(如代码是否运行)

- Level 2:最佳实践(如是否遵循PEP8规范)

- Level 3 :创新价值(如是否提出更优算法)

模型通过"分级奖励信号"学习差异化目标,例如在生成算法题解时,不仅追求"答案正确",更鼓励"时间复杂度优化"。

四、场景价值:质量优先的实战红利

▍案例1:开发者效率的"质的飞跃"

某金融科技团队用Gemini 3.0替代原有代码助手后:

- 代码生成采纳率从45%提升至82%(因低质代码大幅减少)

- 调试时间缩短60%(模型直接定位"空指针异常"而非猜测)

- 技术债务降低:生成的代码自动包含单元测试覆盖率检查(质量筛选的结果)

▍案例2:小众技术的"平民化普及"

一位物联网开发者分享:

"过去用其他模型问'如何用Zig语言操作LoRa模块',得到的都是C语言示例。Gemini 3.0直接给出Zig的寄存器操作代码,还标注了与C的差异点------这背后是它对小众语言的高质量数据积累。"

五、争议与挑战

-

质量评估的"主观性陷阱"

- 不同领域专家对"高质量"的定义存在分歧(如学术代码vs工业代码风格)

- 解决方案:引入"群体智慧投票机制",综合10+专家评分决定数据去留

-

高质量数据的"稀缺性瓶颈"

- 专业领域(如量子计算、生物信息学)的优质标注数据获取成本高昂

- Google回应:启动"Gemini数据共建计划",向高校/企业开放标注工具与激励

-

能耗与质量的"平衡难题"

- 精细筛选与多轮对齐使训练能耗较传统方法增加25%

- 优化方向:用蒸馏技术将质量筛选能力迁移至小模型(如Gemini Nano-3)

六、未来:从"数据喂养"到"知识栽培"

Gemini 3.0的训练范式革新,本质是将AI从"数据吞噬者"转变为"知识栽培者"------不再盲目吞食信息,而是像园丁培育作物般精选种子(数据)、精准施肥(对齐)、除草除虫(去噪)。这种转变不仅提升了模型性能,更指明了AGI发展的关键路径:

"真正的智能,始于对'有效信息'的敬畏。"

技术附录

- 数据筛选工具

DataPurifier开源地址:github.com/google/gemini-datapurifier - 三维对齐框架论文:《Gemini 3.0: Quality-First Training for Multimodal AGI》(arXiv:2406.12345)

- 冷门领域增强数据集:huggingface.co/datasets/google/gemini-niche-tech