1 jstack基础:理解Java线程快照工具

jstack是JDK内置的一款命令行工具,其主要功能是生成Java虚拟机当前时刻的线程快照(Thread Dump)。线程快照是JVM中每个线程正在执行的方法堆栈的集合,。当Java应用出现卡顿、CPU飙高或无响应时,jstack能帮助开发者快速定位问题根源,无需重启应用即可获取第一手诊断数据。

jstack的核心价值在于它能追踪Java应用内部线程的真实活动。通过分析线程快照,我们可以识别多种常见问题:死锁导致的线程僵局、死循环引起的CPU过高、外部资源等待造成的线程阻塞等。无论是开发环境还是生产环境,jstack都是诊断Java应用线程级问题的首选工具。

1.1 jstack工作原理与核心功能

jstack通过连接到目标JVM进程,获取并导出线程堆栈信息。它可以与Java进程建立调试连接,读取每个线程的堆栈数据,并将其以可读的形式输出。jstack可以运行在多种模式下:附加到正在运行的进程、分析核心转储文件,甚至连接至远程调试服务器。

jstack命令的基本语法如下:

css

jstack [options] <pid>其中常用参数包括:

-l:长列表模式,打印关于锁的附加信息(如属于java.util.concurrent的ownable synchronizers列表)-m:混合模式,显示Java和Native(C/C++)栈帧-F:当常规jstack无响应时,强制生成线程转储

1.2 线程状态解读:jstack分析基础

理解线程状态是分析jstack输出的基础。Java线程在生命周期中有以下几种关键状态:

| 线程状态 | 含义与诊断线索 |

|---|---|

| RUNNABLE | 线程正在执行或等待CPU调度。持续RUNNABLE的线程可能是CPU热点。 |

| BLOCKED | 线程等待获取监视器锁(进入synchronized块/方法)。多个BLOCKED线程可能表示锁竞争激烈。 |

| WAITING | 线程无限期等待另一线程的特定操作(如Object.wait())。通常需要外部条件满足才能继续。 |

| TIMED_WAITING | 线程在指定时间内等待(如Thread.sleep())。可能是正常的休眠或超时等待。 |

| TERMINATED | 线程已执行完毕。 |

在jstack输出中,我们还会看到关键锁信息,如locked<0x...>(线程持有的锁)和waiting to lock<0x...>(线程等待的锁),这些是分析死锁和锁竞争的重要线索。

2 jstack实战应用:从入门到精通

2.1 生成线程转储:基础操作指南

获取线程转储的第一步是定位目标Java进程的PID(进程ID)。最简便的方法是使用JDK自带的jps命令:

ruby

$ jps -l

12345 com.example.MyApplication

56789 sun.tools.jps.Jps找到目标PID后(例如12345),使用jstack命令生成线程转储并保存到文件:

jstack -l 12345 > thread_dump_20241224.txt最佳实践建议:

- 对于偶发问题,多次采样(间隔5-10秒,连续3-5次)比单次转储更有价值

- 生产环境中可使用

-F参数应对无响应情况,但需谨慎使用(可能导致JVM短暂停顿) - 将转储操作脚本化,便于问题发生时快速执行

2.2 实战案例一:死锁诊断与解决

死锁是多个线程互相等待对方持有锁的僵局。以下是一个典型死锁场景的排查过程:

首先,编写一个会产生死锁的示例程序:

typescript

public class DeadLockDemo {

private static final Object lockA = new Object();

private static final Object lockB = new Object();

public static void main(String[] args) {

Thread thread1 = new Thread(() -> {

synchronized(lockA) {

System.out.println("Thread1持有lockA");

try { Thread.sleep(100); } catch(Exception e) {}

synchronized(lockB) {

System.out.println("Thread1获得lockB");

}

}

});

Thread thread2 = new Thread(() -> {

synchronized(lockB) {

System.out.println("Thread2持有lockB");

synchronized(lockA) {

System.out.println("Thread2获得lockA");

}

}

});

thread1.start();

thread2.start();

}

}运行此程序后,应用可能会卡住。此时使用jstack诊断:

- 获取进程PID :使用

jps -l或ps -ef | grep java找到目标进程PID - 生成线程转储 :

jstack -l <PID> > deadlock_dump.txt - 分析转储文件:在文件末尾查找"deadlock"关键字

jstack会自动检测Java级死锁,并给出清晰报告:

csharp

Found one Java-level deadlock:

=============================

"Thread-1":

waiting to lock monitor 0x00007f2c34003ae8 (object 0x00000007d58b8f80),

which is held by "Thread-0"

"Thread-0":

waiting to lock monitor 0x00007f2c34006168 (object 0x00000007d58b8f70),

which is held by "Thread-1"输出会详细显示参与死锁的线程、它们持有的锁和等待的锁,形成清晰的死锁环路。

死锁解决策略:

- 锁排序:确保所有线程以相同顺序获取锁

- 超时机制 :使用

tryLock()设置超时时间,避免无限等待 - 锁粗化/细化:根据场景优化锁粒度

- 无锁数据结构:考虑使用并发容器替代显式锁

2.3 实战案例二:CPU飙高问题定位

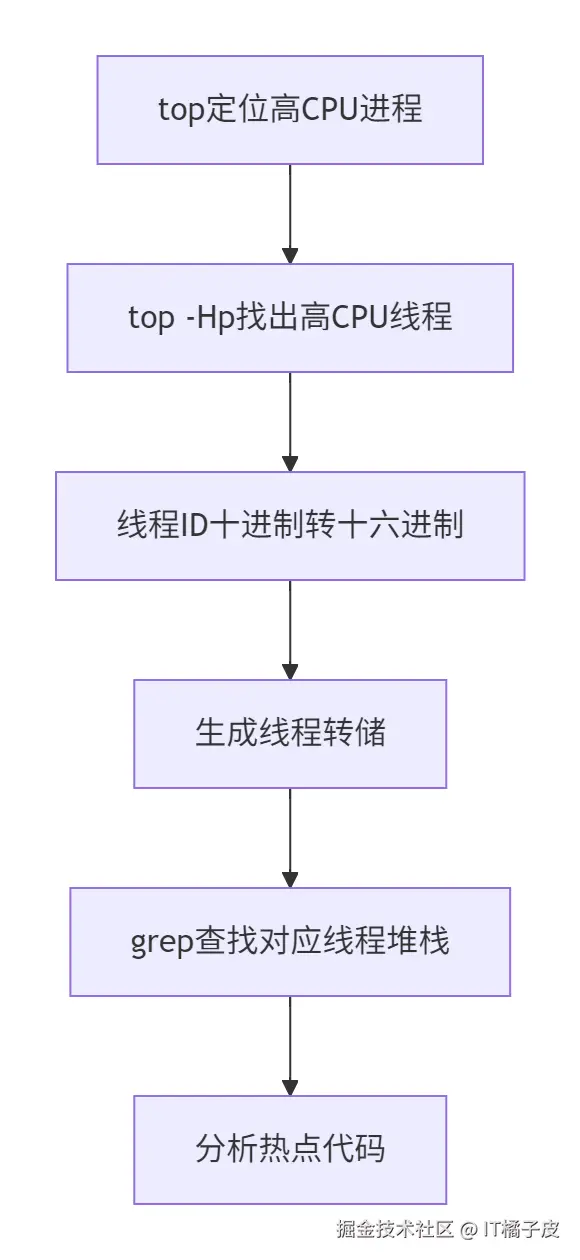

CPU使用率过高通常由死循环或密集计算引起。排查流程如下:

具体操作步骤:

具体操作步骤:

-

定位高CPU进程:

bashtop # 找出CPU使用率最高的Java进程PID -

找出高CPU线程:

bashtop -Hp 12345 # 显示指定进程内各线程CPU使用情况 -

转换线程ID(十进制→十六进制):

perlprintf "%x\n" 12346 # 将十进制线程ID转为十六进制 -

生成并分析线程转储:

cssjstack -l 12345 > high_cpu_dump.txt grep -A 10 -B 5 -i "7b9" high_cpu_dump.txt # 查找特定线程

在转储中,高CPU线程通常表现为持续处于RUNNABLE状态,且堆栈顶部方法长时间不变:

less

"WorkerThread" #42 prio=5 os_prio=0 tid=0x00007f8b4800e800 nid=0x7b9 runnable [0x00007f8b50a0e000]

java.lang.Thread.State: RUNNABLE

at com.example.MyService.cpuIntensiveMethod(MyService.java:100)

at com.example.MyService.lambda$startProcessing$0(MyService.java:75)这表明MyService.java:100是CPU热点,应重点优化。

CPU问题优化策略:

- 优化算法复杂度,减少循环嵌套

- 缓存计算结果,避免重复计算

- 将大任务拆分为小批量处理,避免长时间占用CPU

- 异步处理非关键任务,降低请求处理链路耗时

2.4 实战案例三:线程阻塞与资源等待

线程长时间阻塞可能因等待数据库连接、网络I/O或竞争锁引起。jstack可以揭示这些隐藏的等待链。

典型阻塞模式分析:

php

"DB-Connection-Thread" #5 prio=5 os_prio=0 tid=0x00007f8b4800e800 nid=0x1a03 waiting for monitor entry [0x00007f8b50a0e000]

java.lang.Thread.State: BLOCKED (on object monitor)

at com.example.DatabaseService.executeQuery(DatabaseService.java:50)

- waiting to lock <0x000000076b8a1c98> (a com.example.ConnectionPool)这表明线程在等待连接池锁,可能因连接池不足或某个线程长时间占用连接。

等待外部资源的线程通常表现为:

css

"http-nio-8080-exec-1" #32 daemon prio=5 os_prio=0 tid=0x00007f48740e2000 nid=0x1a85 runnable [0x00007f487b7f0000]

java.lang.Thread.State: RUNNABLE

at java.net.SocketInputStream.socketRead0(Native Method)

at java.net.SocketInputStream.socketRead(SocketInputStream.java:116)线程处于RUNNABLE状态但正在执行本地方法(如Socket读写),可能表明网络I/O瓶颈。

阻塞问题解决方案:

- 调整线程池参数(核心/最大线程数、队列容量)

- 设置合理的超时时间(连接超时、读取超时)

- 使用连接池并正确配置最大连接数

- 优化锁粒度,减少临界区范围

3 高级技巧与注意事项

3.1 jstack高级用法与集成分析

自动化监控脚本可以定期收集线程转储,便于分析偶发问题:

bash

#!/bin/bash

PID=$1

INTERVAL=10 # 采样间隔(秒)

COUNT=5 # 采样次数

for i in $(seq 1 $COUNT); do

jstack -l $PID > thread_dump_$(date +%s).txt

sleep $INTERVAL

done与系统监控工具结合能获得更全面的视角:

- GC分析 :配合

jstat -gcutil查看垃圾回收情况 - 内存分析 :使用

jmap生成堆转储分析内存使用 - 系统监控 :结合

vmstat、iostat分析系统资源瓶颈

第三方分析工具可以提升效率:

- IBM Thread and Monitor Dump Analyzer:可视化分析线程转储

- FastThread:在线线程转储分析服务

- VisualVM 、JMC(Java Mission Control):图形化整体监控

3.2 生产环境注意事项

jstack虽是强大工具,但在生产环境使用时需注意以下禁忌:

-

性能影响 :jstack执行时会暂停JVM的所有线程(Stop-The-World),频繁执行可能影响服务可用性。建议在业务低峰期进行,避免对正常服务造成显著影响。

-

权限控制:执行jstack的用户必须与Java进程属主相同或具有足够权限(如root),否则会报错。

-

信息解读 :jstack提供的是瞬时快照,对于动态问题需要多次采样对比。注意区分应用代码和框架代码(如Spring、Tomcat等)的堆栈。

-

工具限制 :jstack无法检测非Java级死锁 (如数据库死锁)或网络分区问题,需结合其他工具综合分析。

-

容器化环境:在Docker/K8s环境中,需进入容器执行jstack命令:

sqlkubectl exec -it <pod-name> -- jstack -l 1 > dump.txt

3.3 常见问题与解决策略

以下总结了使用jstack时常遇到的问题及应对方法:

- "Unable to open socket file"错误:进程不存在或权限不足,确认PID正确性和执行权限。

- 转储文件过大 :过滤关键线程信息,如

grep -A 20 -B 5 "BLOCKED" thread_dump.txt。 - 混合环境分析 :结合

-m参数查看Java和本地栈帧,适用于JNI问题诊断。

4 总结

jstack作为Java开发者性能诊断的利器,能有效应对死锁、CPU飙高和线程阻塞等常见问题。通过本文的详解与实战,我们掌握了:

- jstack核心机制:线程转储生成原理与线程状态解读方法

- 死锁诊断:通过自动死锁检测快速定位并解决锁竞争问题

- CPU问题定位:结合系统命令找出热点代码并优化

- 线程阻塞分析:识别资源等待和外部依赖导致的性能瓶颈

- 高级技巧:自动化采样、工具集成和生产环境注意事项

谨记:jstack只是诊断工具,真正解决问题需要结合代码分析、系统监控和性能测试。建议在日常开发中提前集成监控,建立性能基线,这样才能在问题出现时快速定位并有效解决。