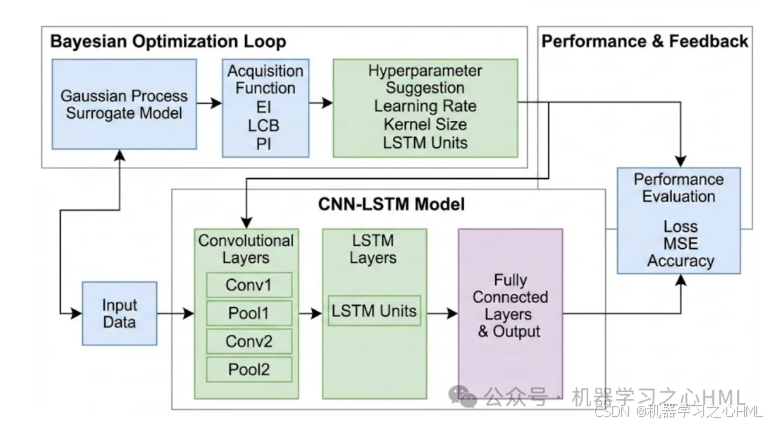

1. 模型结构分解

A. CNN 特征提取层 (Convolutional Neural Network)

这是模型的"眼睛",负责从原始输入数据中识别局部模式。

- 卷积层 (Conv1, Conv2): 通过卷积核(Filters)扫描数据,提取空间特征或短期的局部关联性。

- 池化层 (Pool1, Pool2): 压缩特征图的维度,减少计算量,并保留最显著的特征(如最大值或平均值)。

B. LSTM 时间序列层 (Long Short-Term Memory)

这是模型的"大脑",负责处理特征随时间的变化规律。

- 长短期记忆单元: 能够解决传统 RNN 的梯度消失问题。

- 门控机制: 通过"遗忘门"、"输入门"和"输出门"来决定哪些历史信息需要保留,哪些特征对预测当前时刻最重要。

C. 贝叶斯优化环路 (Bayesian Optimization Loop)

这是模型的"教练",负责寻找最优配置。

- 代理模型 (Surrogate Model): 通常使用高斯过程 (Gaussian Process)。它会根据已有的尝试结果,构建一个关于超参数与模型性能之间关系的概率模型。

- 采集函数 (Acquisition Function): 如 EI (期望改进),用于决定下一步该尝试哪组超参数(在"探索"未知领域和"利用"已知好区域之间取得平衡)。

2. 核心特点

| 特点 | 说明 |

|---|---|

| 时空融合 | 结合了 CNN 提取空间/局部特征的能力和 LSTM 处理长距离时间依赖的能力。 |

| 自动化调优 | 相比于传统的"网格搜索"或"随机搜索",贝叶斯优化能以更少的实验次数找到更优的超参数。 |

| 高效率 | 贝叶斯优化利用了先验知识,不会盲目尝试,特别适合训练耗时较长的深度学习模型。 |

| 端到端学习 | 整个系统从原始数据输入到最终预测输出是连贯的,减少了人工特征工程的干预。 |

3. 工作流程

- 输入数据: 将原始序列数据喂入 CNN。

- 特征压缩: CNN 提取特征后,将其转化为向量序列传递给 LSTM。

- 时间建模: LSTM 学习序列中的趋势、周期等时间特征。

- 性能反馈: 模型在验证集上计算损失函数(如 )。

- 贝叶斯迭代: 优化器根据当前的表现,建议下一组超参数(如:学习率、LSTM 隐藏单元数),并重新开始训练,直到找到最优解。

应用场景: 这种架构非常适合**股票预测、电力负荷预测等既有复杂空间特征又有强时间关联的任务。