文章目录

- 引言:从「对话式助手」到「通宵干活的编码工人」

- [Claude Code 与 Ralph Wiggum 的工作原理](#Claude Code 与 Ralph Wiggum 的工作原理)

-

- [Claude Code:面向工程的「智能体 IDE」](#Claude Code:面向工程的「智能体 IDE」)

- [Ralph Wiggum:把「一次任务」变成「死循环任务」](#Ralph Wiggum:把「一次任务」变成「死循环任务」)

- [Hook:如何「不让 Claude 下班」](#Hook:如何「不让 Claude 下班」)

- 典型工作流

-

- 步骤一:定义任务与完成信号

- [步骤二:让 Claude 辅助设计测试(TDD 推荐)](#步骤二:让 Claude 辅助设计测试(TDD 推荐))

- [步骤三:启动 Ralph 循环执行](#步骤三:启动 Ralph 循环执行)

- 步骤四:人工审查与合并

- 成本、收益与风险控制

-

- [成本视角:用 Token 换人力时间](#成本视角:用 Token 换人力时间)

- 风险一:无限循环与账单爆炸

- 风险二:测试不健全导致「假完成」

- 风险三:需求不清晰导致「反复瞎忙」

- 对开发者的影响:从「码农」到「闭环设计师」

- 实战建议

-

- [1. 从「单模块 Bug 修复」开始](#1. 从「单模块 Bug 修复」开始)

- [2. 建立最小 Hook 安全网](#2. 建立最小 Hook 安全网)

- [3. 引入 TDD 工作流](#3. 引入 TDD 工作流)

- [4. 逐步增大任务粒度](#4. 逐步增大任务粒度)

引言:从「对话式助手」到「通宵干活的编码工人」

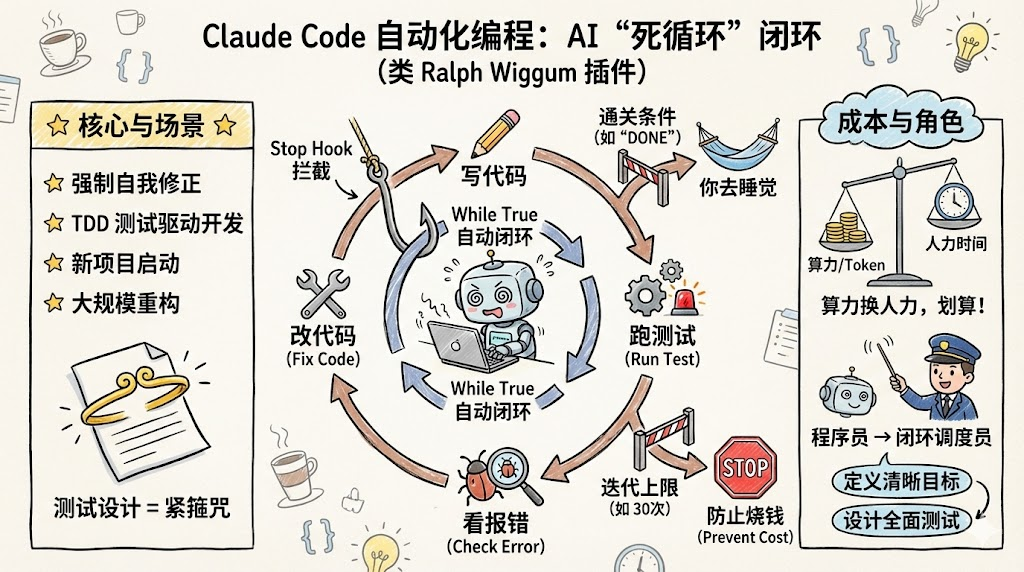

过去两年,大模型编程从「你一句我一句」的对话式辅助,逐步走向「给个任务,自动干一整晚」的全自动工作流。Claude Code 搭配官方插件 Ralph Wiggum,就是这一趋势的代表:你只需写清需求与验收标准,然后字面意义上关电脑睡觉,第二天回来直接看结果和代码变更历史。

接下来我将系统拆解这一组合背后的工作原理、适用场景、工程最佳实践以及潜在风险,帮助有工程背景的开发者把它真正变成生产力,而不是一次性「炫技」。

Claude Code 与 Ralph Wiggum 的工作原理

这一套方案的本质,是把「一次性对话」升级为「可控的自动循环」,并用测试与钩子(Hook)把循环约束在安全边界内。

Claude Code:面向工程的「智能体 IDE」

Claude Code 本身不仅是一个聊天界面,而是一个能读写代码仓库、运行命令、执行测试的智能开发环境。

典型能力包括:

- 直接在本地或远程代码仓库中创建/修改文件,查看 diff 与 git 历史。

- 调用命令行工具运行测试、构建、Lint 等命令,读取输出并据此继续修改代码。

- 支持 Hook 机制:在「执行工具前」「执行工具后」「准备停止时」插入自定义逻辑,用于安全校验或流程编排。

这意味着:只要能被命令行和文件系统描述的开发任务,理论上都可以交给 Claude Code 以「智能体」方式完成。

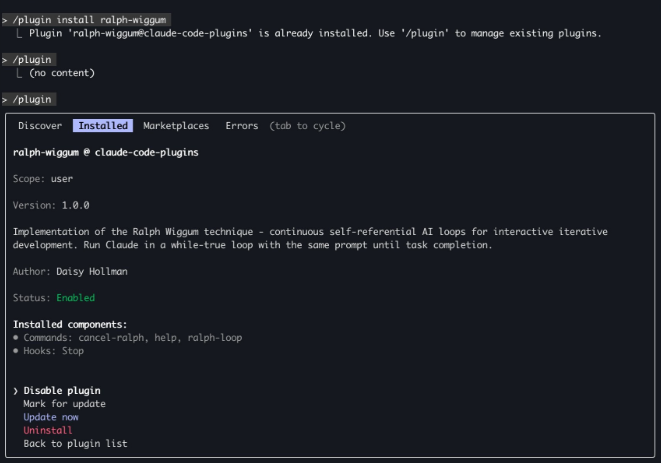

Ralph Wiggum:把「一次任务」变成「死循环任务」

Ralph Wiggum 是 Claude 官方插件之一,它的核心作用是:拦截 Claude 想要「结束对话」的时刻,然后根据预设规则决定------放它下班,还是再让它干一轮。

典型使用方式如下:

bash

/ralph-loop "你的任务描述" \

--completion-promise "DONE" \

--max-iterations 50Ralph 所做的事情,可以理解为一个受控的 while true 循环:

- 把同一份任务说明(Prompt 文件)一遍遍喂给 Claude。

- 每次执行时,Claude 都能看到自己之前生成的代码、测试结果、日志和 git 历史。

- 当 Claude 认为「差不多完成了」并尝试结束时,Stop Hook 介入检查当前状态。

- 如果尚未满足

completion-promise(例如输出中没有DONE),Hook 返回「阻止停止」的决策,并附上指导性原因,让 Claude 继续迭代。 - 循环一直持续到满足完成条件,或达到

--max-iterations上限强制熔断。[4][2]

用更工程化的伪代码描述就是:

bash

while (iterations < max_iterations) {

run_claude_with_same_prompt()

# Claude 读取最新代码 & 测试输出

if (output_contains(completion_promise)) break

}区别在于:循环体内的世界(代码库、测试状态)在持续演化,Claude 每一轮都在「看自己过去的工作」后继续改进,而不是从零开始。

Hook:如何「不让 Claude 下班」

Claude Code 的 Hook 系统允许在「准备停止」时执行一段逻辑,如果判断不该停止,就用 JSON 告诉系统:继续干活。

典型 Stop Hook 结构类似:

json

{

"decision": "block",

"reason": "测试仍然失败,请分析最新测试报告并修复所有失败用例后再尝试停止。"

}重要特性:

decision: "block":阻止停止,强制 Claude 继续思考和行动。reason:不是给人看的,而是给 Claude 的下一轮提示,用来明确「接下来应该做什么」。- 如果

decision为undefined,Claude 就会正常结束本轮工作。

Ralph 正是利用这一机制,在每次 Claude 想收尾时插入「自动验收逻辑」,从而实现真正的「任务级闭环」。

典型工作流

要把 Ralph 真正用到实际项目里,关键不是那行命令,而是「如何设计一个 AI 能跑得动、跑得稳的工作流」。

下面以「开发一个中小型功能」为例,给出一套实践路径。

步骤一:定义任务与完成信号

Claude 只对「可验证的、可量化的」目标真正擅长。一个好的任务描述至少包含:

- 功能目标:要给哪个项目增加什么能力,例如「为现有电商后端增加优惠券模块」。

- 约束条件:语言、框架、架构限制,例如「后端使用 Django,遵守现有分层架构」。

- 验收方式:哪一组测试全部通过才算完成,例如「所有

tests/coupons/下的用例必须通过」。 - 完成暗号:例如在任务全部完成后在最终输出中打印

DONE。

示例 Prompt(可存成 task.md):

markdown

你正在为现有的 Java (Spring Boot) 电商项目实现「优惠券系统」。

目标:

- 用户可以创建、领取、使用优惠券

- 支持满减 (Fixed Amount)、打折 (Percentage) 两种类型

- 所有新编写的业务逻辑必须有充分的测试覆盖(单元测试与集成测试,使用 JUnit 5)

验收条件:

- 针对优惠券模块的测试套件全部通过 (例如,运行 Maven 命令: `mvn test -Dtest="com.yourproject.coupon.**"`)

- 不得破坏项目中现有已通过的测试行为

- 完成所有任务后,在最终的输出中打印一行:DONE步骤二:让 Claude 辅助设计测试(TDD 推荐)

Ralph 的威力真正体现于「先有测试,再有实现」。测试越好,夜里跑的环越安全、越有价值。

推荐流程:

- 先用 Claude Code 生成测试计划:覆盖功能、边界条件与异常路径。

- 要求先写测试文件,禁止在通过前修改被测生产代码,这可以大幅降低「改坏旧功能」的风险。

- 测试写完后,本地或由 Claude 自动跑一遍,确认测试本身没有语法错误或明显问题。

这一阶段可以相对「短对话化」,确认测试设计合理后,再交给 Ralph 长时间跑。

步骤三:启动 Ralph 循环执行

测试准备妥当后,就可以用类似命令把长任务交给 Ralph:

bash

/ralph-loop "根据 task.md 完成优惠券系统实现,并在全部测试通过后输出 DONE。" \

--completion-promise "DONE" \

--max-iterations 40循环内部每一轮通常会做的事包括:

- 分析当前失败测试与错误栈。

- 定位对应代码模块,编写或修改实现。

- 再次运行对应测试命令(例如

pytest tests/coupons/)。 - 记录变更到 git 历史,方便事后审计。

- 直到测试全部通过,并在输出中打印

DONE。

不同项目的命令细节可以在 Prompt 中明确,例如需要先迁移数据库、再跑集成测试等。

步骤四:人工审查与合并

即便测试全绿,人工审查仍然不可或缺,尤其是在关键业务或高风险改动上。

审查重点可以包括:

- 设计是否符合你团队的编码规范与架构约束。

- 是否引入了隐形性能问题或安全隐患。

- 测试是否真的覆盖了关键路径,而不是只测「顺利场景」。

通常实践是:把夜间的变更 push 到一个单独分支,第二天在 MR/PR 中组织常规代码评审。

成本、收益与风险控制

自动循环听上去很酷,但无限循环、Token 烧穿、业务写歪都是现实风险。因此需要明确边界与治理思路。

成本视角:用 Token 换人力时间

已有的公开案例表明,这种模式在某些场景下非常「划算」:[8][2]

- 有团队在一夜内通过 Ralph 自动生成 6 个完整仓库,包括代码与测试。

- 某项目原本报价约 5 万美元,人力外包周期数周,而使用 Claude Code + Ralph 的实际 API 成本约 297 美元。

当然,这些案例通常具有以下前提:

- 需求边界清晰,不频繁变更。

- 测试驱动,验收标准明确可验证。

- 对 Token 成本相对不敏感,或采用订阅制。

因此,更合理的心态是:把它视为「高配版 CI 机器人」而不是「免费劳动力」。

风险一:无限循环与账单爆炸

Ralph 官方与社区实践都反复强调:--max-iterations 是刚需,而不是可选项。

推荐做法:

- 为不同任务类型设定合理上限,例如小功能 20 轮,中等任务 40--60 轮。

- 超过上限自动熔断,并输出当前失败点和调试建议,提醒人类介入。

- 可在 Hook 中加入对「测试一直未减少」「diff 持续变大」等异常模式的检测,提前终止。

这样可以避免「一觉醒来,账单爆炸」的情况。

风险二:测试不健全导致「假完成」

如果测试只覆盖主路径,Ralph 只会把「测试能看见的世界」打磨得很漂亮,而业务的灰暗角落可能完全没被触及。

缓解策略:

- 为关键业务路径设计更高强度的测试,例如边界条件、异常输入、并发场景。

- 定期用 Claude 帮忙「找测试盲点」,让它从需求文档和错误日志中反推缺失的测试用例。

- 对高风险变更引入人工 Exploratory Testing(探索式测试),不要完全依赖自动化。

风险三:需求不清晰导致「反复瞎忙」

自动循环并不能替代产品思考。如果需求模糊,Ralph 只会更高效地在错误方向上走得更远。

经验上,以下类型任务更适合交给 Ralph 通宵跑:

- 已有清晰输入输出规格的功能模块。

- Bug 修复(特别是可复现、有明确失败测试的 Bug)。

- 明确边界的重构与迁移,例如重构某一子模块或从一个库迁移到另一个库。

对于「打开一个全新领域」「探索性原型」,更适合白天人机协作,频繁迭代,而不是长时间无人值守循环。

对开发者的影响:从「码农」到「闭环设计师」

Ralph 让一个趋势变得更清晰:真正有价值的不是「谁手速快、谁会写更优雅的 for 循环」,而是谁能设计出安全、高效、可扩展的 AI 工作流。

能力重心正在迁移

在这类工具组合下,开发者的核心能力更侧重于:

- 需求建模:把模糊业务拆解为清晰的机器可执行目标和约束。

- 测试设计:用测试定义边界、风险点和验收标准。

- 工作流编排:利用 Hook、Agent、CI 等组件搭出稳定的自动循环体系。

- 结果审查:从代码、架构和业务角度判断「AI 交付物」是否真的可用、可维护。

这更像是一种「自动化系统设计」工作,而不是传统意义的「纯手写代码」。

团队协作模式的演化

在团队环境中,可以想象这样的角色分工:

- 有人专注于写高质量测试和规范。

- 有人专注于搭建和维护 Ralph/Hook/CI 等自动化基础设施。

- 每个业务小组都能在夜间排队提交任务,让 AI 帮忙跑一夜。

从结果上看,团队的「人类工作时间」更多集中在设计、评审和决策,而「机械重复劳动」尽可能外包给 AI 和算力。

实战建议

如果希望在自己的项目里尝试类似文章中的工作方式,可以按优先顺序考虑以下落地路径。

1. 从「单模块 Bug 修复」开始

- 选择一个有清晰失败测试的 Bug(或先让 Claude 帮你写复现测试)。

- 用 Ralph 配置小规模循环,只修复这一处问题,设置较小的

--max-iterations。 - 观察生成代码风格、对现有代码的侵入程度和测试稳定性。

这能帮你快速建立对系统行为的直观感受。

2. 建立最小 Hook 安全网

- 在 Stop Hook 中至少检查:测试状态、错误数是否减少、diff 体量是否异常膨胀等。

- 对「没有进展」的迭代给出明确指令,例如「请先最小化修改范围」「请只修改与失败测试直接相关的文件」。

这一步是从「玩具实验」走向「可控工具」的分水岭。

3. 引入 TDD 工作流

- 让团队习惯于「先写测试再实现」,至少在新功能或重构上坚持这一原则。

- 把「测试通过」作为 Ralph 的主要完成条件之一,而不是仅依赖输出里的

DONE。 - 在 CI 中集成「Ralph 夜间任务」流水线,统一跑长任务,避免个人本地环境差异。

随着测试质量提升,Ralph 带来的收益会呈现明显的复利效应。

4. 逐步增大任务粒度

- 从单一模块 → 子系统 → 端到端用户功能。

- 每扩大一次粒度,都要重新审视:测试覆盖是否足够、Hook 逻辑是否需要更精细的控制。

- 对特别关键的任务(例如涉及资金结算、权限系统),建议保留更多人工 review 阶段,不要追求「全自动」的浪漫。

通过 Claude Code 与 Ralph Wiggum,把「AI 帮写几行代码」升级为「AI 通宵完成一整个开发迭代」在 2026 年已经不再是科幻,而是越来越多团队日常开发的一部分。 对个人开发者而言,真正值得投入的,是如何写出更好的需求说明与测试,让这台自动化「夜班机」为你持续创造价值,而不是变成一个昂贵而危险的玩具。