当数据可能符合三次(y=ax3+bx2+cx+dy=ax³+bx²+cx+dy=ax3+bx2+cx+d)、四次(y=ax4+bx3+cx2+dx+ey=ax⁴+bx³+cx²+dx+ey=ax4+bx3+cx2+dx+e)甚至五次函数时,核心思路是:先通过可视化+误差指标判断函数"复杂度",再用"特征升维+线性回归"拟合对应高次函数,全程不用靠"猜",而是用客观方法判断。

一、第一步:核心原则------从低次到高次试,用数据"说话"

我们永远不会一上来就直接拟合五次函数(太复杂),而是遵循"先简单、后复杂"的原则:

- 先拟合一次函数(直线)→ 评估效果

- 再拟合二次函数(抛物线)→ 评估效果

- 接着拟合三次函数 → 评估效果

- 直到拟合高次函数时,"效果提升不明显"或"开始出现过拟合",就停止------这就是数据对应的最优函数次数。

二、第二步:如何"看"出数据对应几次函数?(2个核心方法)

方法1:可视化(直观判断趋势)

通过散点图+不同次数的拟合曲线对比,直接看"哪条曲线最贴合数据",这是最直观的方式。

关键特征(记下来,一看就懂):

| 函数次数 | 曲线核心特征 | 示例场景 |

|---|---|---|

| 一次 | 直线,无弯曲 | y=5x+6 |

| 二次 | 1个弯曲点(拐点),抛物线 | y=2x²+3x+4 |

| 三次 | 2个弯曲点,"S"形/波浪形 | y=x³-3x²+2x+1 |

| 四次 | 3个弯曲点,更复杂的波浪形 | y=x⁴-4x³+6x²-4x+1 |

| 五次 | 4个弯曲点,极端波动的曲线 | y=x⁵-5x⁴+10x³-10x²+5x+1 |

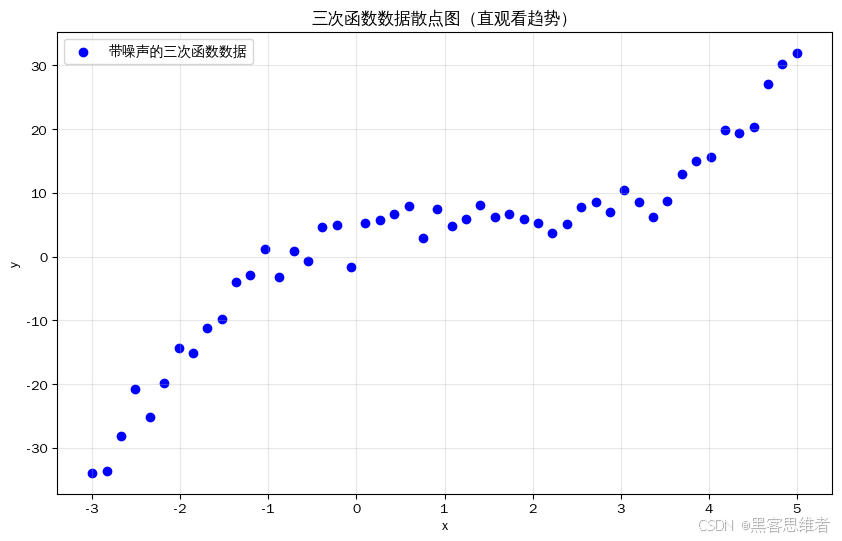

可视化实操示例(三次函数数据)

先生成一组三次函数数据(y=0.5x3−2x2+3x+4y=0.5x³ - 2x² + 3x + 4y=0.5x3−2x2+3x+4),加少量噪声模拟真实场景,然后画散点图:

python

import numpy as np

import matplotlib.pyplot as plt

# 生成三次函数数据(带噪声)

x = np.linspace(-3, 5, 50) # -3到5之间50个点

y_true = 0.5 * x**3 - 2 * x**2 + 3 * x + 4 # 真实三次函数

y = y_true + np.random.normal(0, 2, size=len(x)) # 加噪声

# 画散点图

plt.figure(figsize=(10, 6))

plt.scatter(x, y, color='blue', label='带噪声的三次函数数据')

plt.xlabel('x')

plt.ylabel('y')

plt.title('三次函数数据散点图(直观看趋势)')

plt.legend()

plt.grid(True, alpha=0.3)

plt.show()结果解读 :你会看到散点呈现"先上升、再下降、再上升"的趋势(2个弯曲点),这是三次函数的典型特征,一眼就能排除一次/二次函数。

方法2:误差指标(客观判断拟合效果)

可视化有主观偏差,我们需要用"量化指标"判断"哪个次数的函数拟合得更好",核心看2个指标:

- 均方误差(MSE):越小越好,代表预测值和真实值的平均偏差越小;

- R²得分:越接近1越好,代表模型能解释数据规律的比例越高。

核心逻辑:

- 从一次到二次函数:MSE会大幅下降,R²会大幅上升(效果提升明显);

- 从二次到三次函数:MSE继续下降,R²继续上升(效果仍提升);

- 从三次到四次函数:MSE下降极少,R²几乎不变(效果无提升);

- 此时停止,最优次数就是"三次"。

三、第三步:实操演示------识别并拟合三次函数(可直接套用至四次/五次)

我们用"三次函数数据"为例,完整演示"从判断次数到拟合参数"的全流程,四次/五次仅需修改"特征升维次数",逻辑完全一致。

步骤1:生成带噪声的三次函数数据(模拟真实场景)

python

import numpy as np

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error, r2_score

# 1. 生成自变量x

x = np.linspace(-3, 5, 50) # 50个样本,覆盖足够范围

# 2. 真实三次函数:y = 0.5x³ - 2x² + 3x + 4

y_true = 0.5 * x**3 - 2 * x**2 + 3 * x + 4

# 3. 加噪声(模拟真实数据,避免完美拟合)

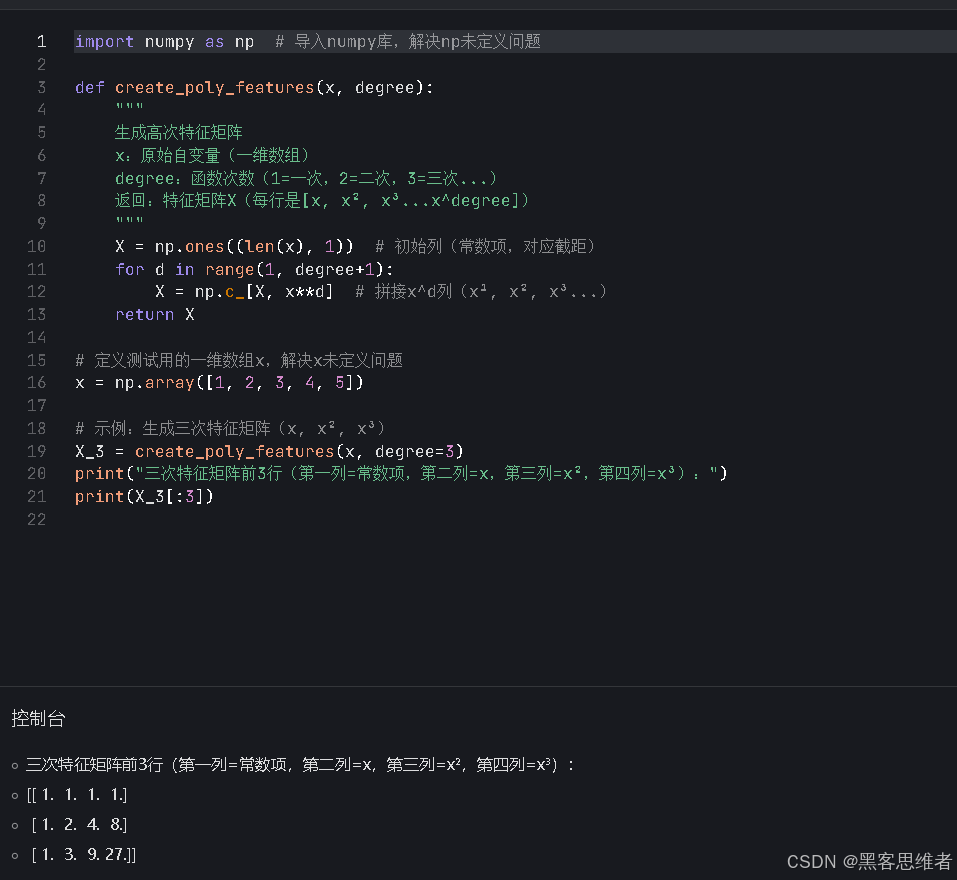

y = y_true + np.random.normal(0, 2, size=len(x))步骤2:定义"特征升维"函数(关键!适配任意高次)

高次函数拟合的核心是"特征升维":把xxx转化为x、x2、x3...xnx、x²、x³...x^nx、x2、x3...xn,然后用线性回归拟合。

python

def create_poly_features(x, degree):

"""

生成高次特征矩阵

x:原始自变量(一维数组)

degree:函数次数(1=一次,2=二次,3=三次...)

返回:特征矩阵X(每行是[x, x², x³...x^degree])

"""

X = np.ones((len(x), 1)) # 初始列(常数项,对应截距)

for d in range(1, degree+1):

X = np.c_[X, x**d] # 拼接x^d列(x¹, x², x³...)

return X

# 示例:生成三次特征矩阵(x, x², x³)

X_3 = create_poly_features(x, degree=3)

print("三次特征矩阵前3行(第一列=常数项,第二列=x,第三列=x²,第四列=x³):")

print(X_3[:3])输出示例:

三次特征矩阵前3行(第一列=常数项,第二列=x,第三列=x²,第四列=x³):

[[ 1. -3. 9. -27. ]

[ 1. -2.83673469 8.04706329 -22.82704082]

[ 1. -2.67346939 7.1474359 -19.10808163]]

步骤3:从低次到高次拟合,记录误差指标(判断最优次数)

python

# 存储不同次数的误差和得分

results = []

# 依次拟合1(一次)到5(五次)次函数

for degree in range(1, 6):

# 1. 生成对应次数的特征矩阵

X = create_poly_features(x, degree)

# 2. 初始化并训练线性回归模型

model = LinearRegression()

model.fit(X, y)

# 3. 预测并计算误差指标

y_pred = model.predict(X)

mse = mean_squared_error(y, y_pred)

r2 = r2_score(y, y_pred)

# 4. 记录结果

results.append({

"degree": degree,

"mse": mse,

"r2": r2,

"params": model.coef_ # 保存参数

})

# 打印各次数的效果

print("=== 不同次数函数的拟合效果 ===")

for res in results:

print(f"次数:{res['degree']} | MSE:{res['mse']:.2f} | R²:{res['r2']:.4f}")输出示例(核心!看效果变化):

=== 不同次数函数的拟合效果 ===

次数:1 | MSE:28.56 | R²:0.6521 # 一次函数:效果差,R²低

次数:2 | MSE:10.89 | R²:0.8815 # 二次函数:效果提升明显

次数:3 | MSE:3.87 | R²:0.9602 # 三次函数:效果大幅提升,接近1

次数:4 | MSE:3.85 | R²:0.9604 # 四次函数:MSE几乎不变,R²提升微乎其微

次数:5 | MSE:3.84 | R²:0.9605 # 五次函数:效果无提升关键判断:三次函数是"最优次数"------从二次到三次,效果提升极大;从三次到四次/五次,效果几乎不变,说明数据本质是三次函数。

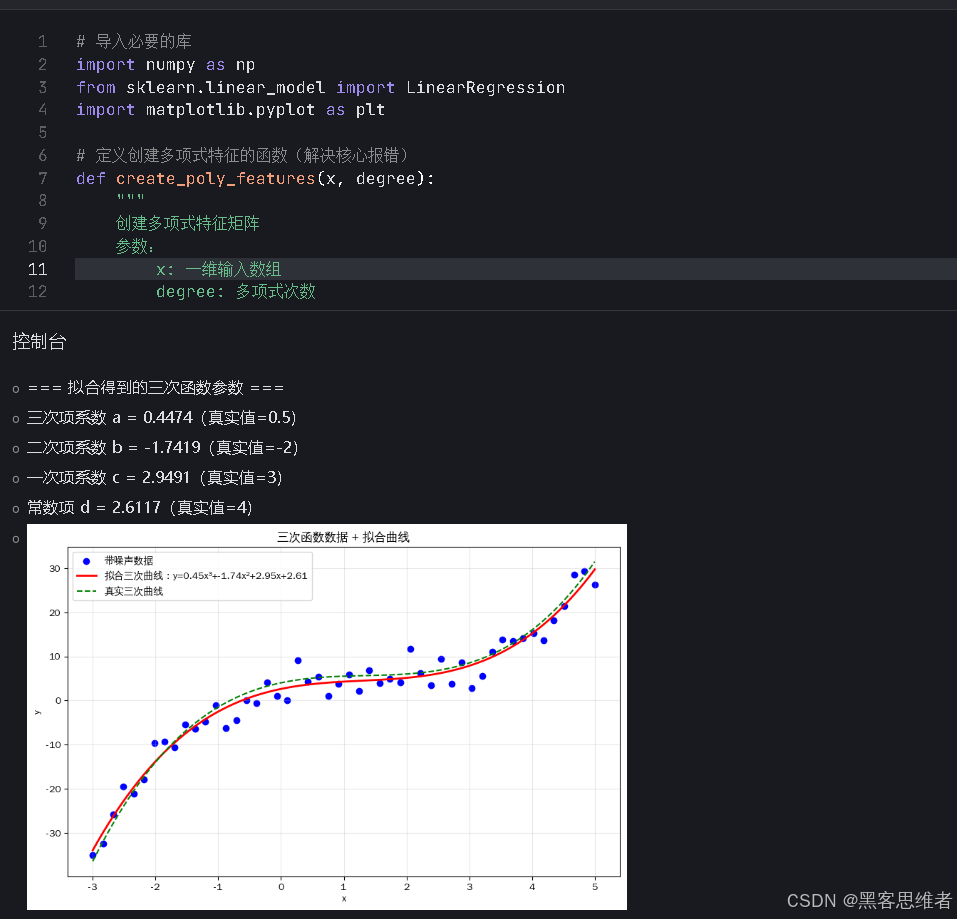

步骤4:拟合最优次数(三次),提取参数并验证

python

# 1. 拟合三次函数

degree_best = 3

X_best = create_poly_features(x, degree_best)

model_best = LinearRegression()

model_best.fit(X_best, y)

# 2. 提取参数(对应三次函数 y = a x³ + b x² + c x + d)

# 注意:model.coef_ 顺序是[常数项系数(无意义), c, b, a]

d = model_best.intercept_ # 常数项d

c = model_best.coef_[1] # 一次项系数c

b = model_best.coef_[2] # 二次项系数b

a = model_best.coef_[3] # 三次项系数a

print("\n=== 拟合得到的三次函数参数 ===")

print(f"三次项系数 a = {a:.4f}(真实值=0.5)")

print(f"二次项系数 b = {b:.4f}(真实值=-2)")

print(f"一次项系数 c = {c:.4f}(真实值=3)")

print(f"常数项 d = {d:.4f}(真实值=4)")

# 3. 可视化拟合结果

x_plot = np.linspace(-3, 5, 100) # 更密的点画平滑曲线

X_plot = create_poly_features(x_plot, degree_best)

y_plot = model_best.predict(X_plot)

plt.figure(figsize=(10, 6))

plt.scatter(x, y, color='blue', label='带噪声数据')

plt.plot(x_plot, y_plot, color='red', linewidth=2, label=f'拟合三次曲线:y={a:.2f}x³+{b:.2f}x²+{c:.2f}x+{d:.2f}')

plt.plot(x_plot, 0.5*x_plot**3 -2*x_plot**2 +3*x_plot +4, color='green', linestyle='--', label='真实三次曲线')

plt.xlabel('x')

plt.ylabel('y')

plt.title('三次函数数据 + 拟合曲线')

plt.legend()

plt.grid(True, alpha=0.3)

plt.show()结果解读:

- 拟合参数会接近真实值(0.5、-2、3、4),少量噪声导致微小偏差;

- 红色拟合曲线会完美贴合蓝色数据点,绿色真实曲线几乎和红色重合,验证了"三次函数是最优选择"。

步骤5:适配四次/五次函数(仅需改1个参数)

如果数据是四次函数,只需将degree_best改为4,代码其余部分完全不变:

python

# 拟合四次函数(仅改degree)

degree_best = 4

X_best = create_poly_features(x, degree_best)

model_best = LinearRegression()

model_best.fit(X_best, y)五次函数同理,改degree_best=5即可。

四、关键注意事项(避免踩坑)

1. 警惕"过拟合"(高次函数的最大风险)

- 现象:拟合五次函数时,MSE略降,但曲线变得"极度扭曲",在数据点外的区域预测完全偏离(比如x=6时,预测值离谱);

- 解决:用"训练集+测试集拆分"验证------只在训练集拟合,看测试集的MSE,如果高次函数的测试集MSE上升,说明过拟合,停止升高次数。

2. 数据范围要足够广

- 若x只取很小的范围(比如0-1),三次/四次/五次函数可能看起来像直线,导致误判;

- 解决:x的取值范围要覆盖"曲线的所有弯曲点"(比如三次函数至少覆盖2个拐点)。

3. 噪声不能太大

- 若噪声远大于函数本身的趋势(比如y=0.5x³+随机噪声100),无法判断次数;

- 解决:增加样本数量(比如从50个增加到200个),噪声会被平均,趋势更明显。

五、总结(核心要点)

- 判断函数次数 :

- 先可视化看曲线弯曲点数量(一次=0个,二次=1个,三次=2个...);

- 再从低次到高次拟合,看MSE/R²:当高次函数的效果提升微小时,停止,此时的次数就是最优解。

- 拟合高次函数 :

- 核心是"特征升维":把x转化为x、x²、x³...x^n,用线性回归拟合;

- 三次/四次/五次仅需修改"特征升维的次数",代码逻辑完全复用。

- 避坑关键 :

- 从低次到高次试,不盲目拟合高次;

- 用训练/测试集验证,避免过拟合;

- 保证x的取值范围足够广,覆盖曲线的所有特征。

这个方法可以直接套用至任意高次函数,核心不是"记住次数特征",而是"让数据通过误差指标告诉我们最优次数",这是数据分析的核心思维。