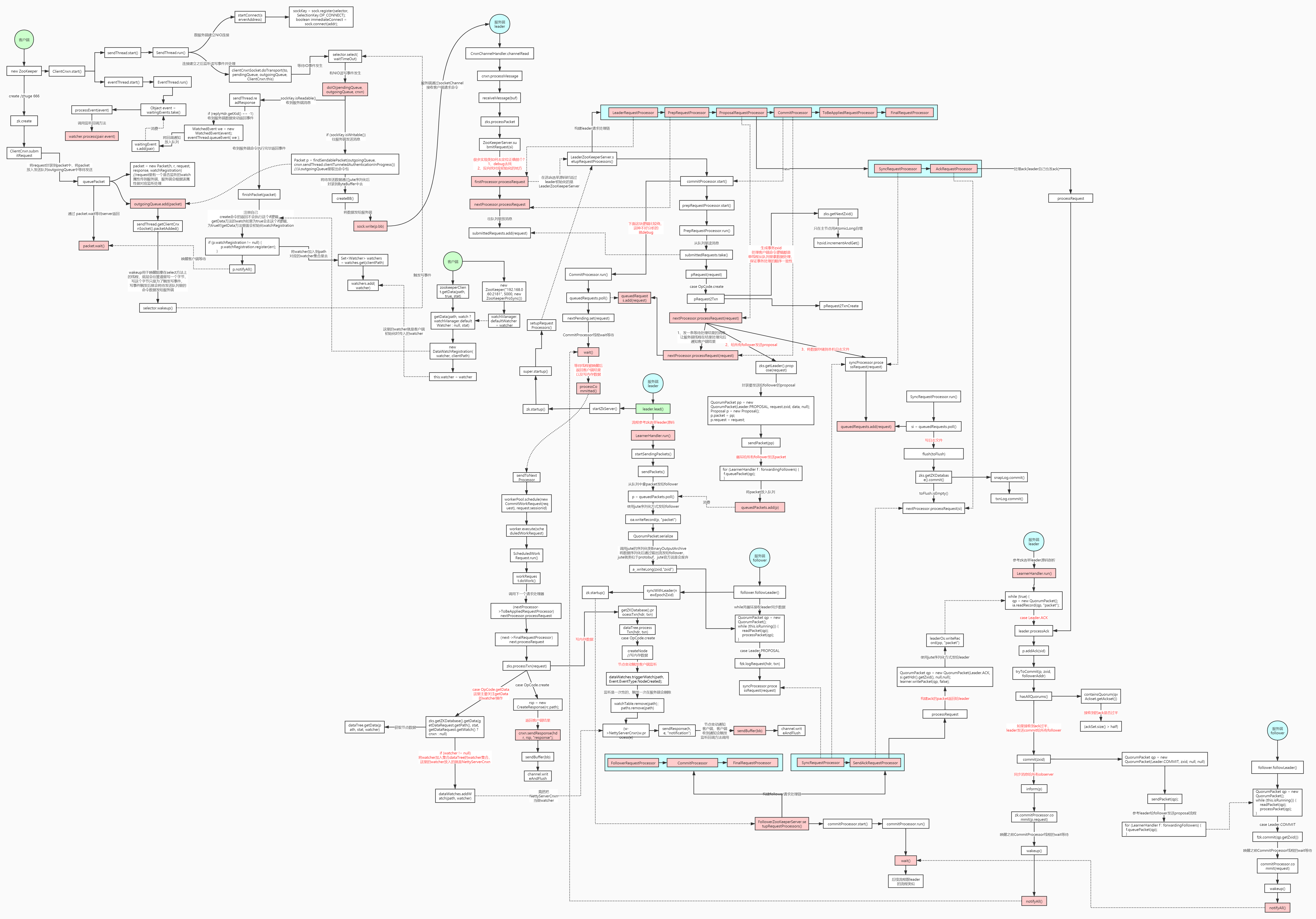

一、ZAB协议核心概念解析

1.1 ZAB协议定义

ZAB协议全称ZooKeeper Atomic Broadcast,是一种支持崩溃恢复的原子广播协议。它包含两个核心模式:

-

消息广播模式:正常工作时,Leader向所有Follower原子广播事务

-

崩溃恢复模式:Leader故障时,重新选举并恢复数据一致性

1.2 ZAB与Paxos的关系

ZAB协议是Paxos算法的一种简化实现,针对ZooKeeper的使用场景进行了优化:

| 特性 | Paxos | ZAB |

|---|---|---|

| 设计目标 | 通用一致性协议 | 专为ZooKeeper设计 |

| 实现复杂度 | 较高,理论完备 | 相对简化,工程友好 |

| 消息类型 | 多种消息类型 | 简化消息类型 |

| 性能优化 | 一般 | 针对写多读少优化 |

二、ZAB协议架构设计

2.1 系统架构概览

┌─────────────────────────────────────────────────────┐ │ Client Cluster │ └─────────────────────────────────────────────────────┘ │ ▼ ┌─────────────────────────────────────────────────────┐ │ ZooKeeper Cluster │ │ ┌──────────┐ ┌──────────┐ ┌──────────┐ │ │ │ Leader │◄──►│ Follower │◄──►│ Follower │ │ │ └──────────┘ └──────────┘ └──────────┘ │ │ │ │ │ │ │ └──────────────┴───────────────────┘ │ │ Atomic Broadcast │ └─────────────────────────────────────────────────────┘

2.2 ZXID:事务唯一标识

ZXID是64位长整型,结构如下:

java

// ZXID结构:高32位(epoch) + 低32位(counter)

// 示例:0x100000001 表示epoch=1, counter=1

public class ZxidUtils {

public static long makeZxid(long epoch, long counter) {

return (epoch << 32) | (counter & 0xffffffffL);

}

public static long getEpochFromZxid(long zxid) {

return zxid >> 32;

}

public static long getCounterFromZxid(long zxid) {

return zxid & 0xffffffffL;

}

}三、消息广播模式源码解析

3.1 消息广播流程

ZAB的消息广播类似于两阶段提交(2PC),但优化了阻塞问题:

java

// 核心广播流程源码分析

public class Leader {

// 提议队列,存放待广播的事务

private final ConcurrentLinkedQueue<Proposal> outstandingProposals =

new ConcurrentLinkedQueue<>();

// 提交队列,存放已提交的事务

private final ConcurrentLinkedQueue<Proposal> toBeApplied =

new ConcurrentLinkedQueue<>();

/**

* 处理客户端写请求的主流程

*/

public Proposal processWriteRequest(Request request) {

// 1. 创建事务提议

Proposal p = new Proposal();

p.request = request;

p.zxid = getNextZxid(); // 分配全局递增ZXID

// 2. 记录到事务日志

zkDb.append(p);

// 3. 发送给所有Follower(异步)

sendPacketToFollowers(p);

// 4. 等待半数以上确认

waitForAck(p);

// 5. 提交事务

commit(p);

return p;

}

/**

* 发送提议给Follower

*/

private void sendPacketToFollowers(Proposal p) {

QuorumPacket packet = createProposalPacket(p);

for (LearnerHandler f : getFollowers()) {

try {

// 异步发送,避免阻塞

f.queuePacket(packet);

// 添加到未完成提议列表

outstandingProposals.add(p);

} catch (Exception e) {

LOG.warn("Failed to send proposal to follower", e);

}

}

}

/**

* 等待半数以上确认

*/

private void waitForAck(Proposal p) {

// 使用CountDownLatch等待确认

final CountDownLatch latch = new CountDownLatch(1);

AckProcessor processor = new AckProcessor(p, latch);

// 启动确认处理器

ackProcessorExecutor.submit(processor);

try {

// 等待超时时间为syncLimit * tickTime

if (!latch.await(syncLimit * tickTime, TimeUnit.MILLISECONDS)) {

throw new SyncTimeoutException("Wait for ack timeout");

}

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

}

/**

* 提交事务

*/

private void commit(Proposal p) {

// 1. 记录提交日志

zkDb.commit(p.zxid);

// 2. 发送COMMIT消息给Follower

QuorumPacket commitPacket = createCommitPacket(p.zxid);

for (LearnerHandler f : getFollowers()) {

f.queuePacket(commitPacket);

}

// 3. 应用事务到内存数据库

zkDb.apply(p);

// 4. 从未完成列表中移除

outstandingProposals.remove(p);

toBeApplied.add(p);

}

}3.2 两阶段提交优化

ZAB对传统2PC的优化体现在:

java

// 传统2PC:需要所有参与者确认

// ZAB优化:只需要半数以上确认即可提交

public class ZabTwoPhaseCommit {

private boolean hasQuorum(Set<Long> acks) {

// 计算确认的Follower数量(包括Leader自己)

int ackCount = acks.size() + 1; // +1 for leader itself

// 检查是否超过半数

return ackCount > (getVotingMembers().size() / 2);

}

// 异步确认机制,避免同步阻塞

public void processAckAsync(long zxid, long sid) {

CompletableFuture.runAsync(() -> {

synchronized (ackMap) {

Set<Long> acks = ackMap.getOrDefault(zxid, new HashSet<>());

acks.add(sid);

if (hasQuorum(acks)) {

// 达到法定人数,触发提交

commitIfNotCommitted(zxid);

}

}

});

}

}3.3 消息队列解耦设计

java

// Leader和Follower之间的异步消息队列

public class LearnerHandler extends Thread {

// 发送队列

private final BlockingQueue<QuorumPacket> queuedPackets =

new LinkedBlockingQueue<>();

// 接收队列

private final BlockingQueue<QuorumPacket> receivedPackets =

new LinkedBlockingQueue<>();

@Override

public void run() {

while (running) {

// 发送线程

QuorumPacket packetToSend = queuedPackets.poll();

if (packetToSend != null) {

sendPacket(packetToSend);

}

// 接收线程

QuorumPacket received = receivePacket();

if (received != null) {

receivedPackets.offer(received);

}

}

}

// 异步发送消息

public void queuePacket(QuorumPacket packet) {

queuedPackets.offer(packet);

}

}四、崩溃恢复模式源码深度剖析

4.1 崩溃恢复的核心原则

ZAB协议在崩溃恢复时遵循两个基本原则:

-

已提交的事务必须被保留

-

未提交的事务必须被丢弃

4.2 Leader选举与数据恢复

java

// FastLeaderElection中与ZAB相关的选举逻辑

public class FastLeaderElection {

/**

* 选举新Leader的核心算法

* 确保选出的Leader拥有最大的ZXID

*/

public Vote lookForLeader() throws InterruptedException {

// 初始化投票(投给自己)

Vote currentVote = new Vote(self.getId(),

self.getLastLoggedZxid(),

self.getCurrentEpoch(),

self.getPeerState());

// 广播投票

sendNotifications();

// 收集投票

while (self.getPeerState() == ServerState.LOOKING) {

Notification n = recvqueue.poll(timeout, TimeUnit.MILLISECONDS);

if (n != null) {

// 比较ZXID,选择最大的

if (compareZxid(n.zxid, currentVote.getZxid()) > 0) {

// 更新投票给ZXID更大的节点

currentVote = new Vote(n.sid, n.zxid, n.peerEpoch, n.state);

sendNotifications();

}

// 统计票数,检查是否获得多数

if (hasQuorumFor(currentVote)) {

// 选举成功

if (currentVote.getId() == self.getId()) {

// 自己成为Leader,开始恢复阶段

leader = new LeaderZooKeeperServer(self, zkDb);

leader.start();

leader.lead();

} else {

// 自己成为Follower,连接Leader

follower = new FollowerZooKeeperServer(self, zkDb);

follower.start();

follower.followLeader();

}

break;

}

}

}

return currentVote;

}

// 比较两个ZXID的大小

private int compareZxid(long zxid1, long zxid2) {

long epoch1 = ZxidUtils.getEpochFromZxid(zxid1);

long epoch2 = ZxidUtils.getEpochFromZxid(zxid2);

if (epoch1 > epoch2) return 1;

if (epoch1 < epoch2) return -1;

long counter1 = ZxidUtils.getCounterFromZxid(zxid1);

long counter2 = ZxidUtils.getCounterFromZxid(zxid2);

return Long.compare(counter1, counter2);

}

}4.3 数据同步流程

java

// Leader启动后的数据同步过程

public class Leader {

/**

* Leader主循环,处理数据同步

*/

public void lead() throws Exception {

// 1. 等待建立与Follower的连接

waitForFollowers();

// 2. 启动同步线程

startSyncThread();

// 3. 处理客户端请求

while (running) {

Request request = takeRequest();

processRequest(request);

}

}

/**

* 数据同步线程

*/

private class SyncThread extends Thread {

@Override

public void run() {

for (LearnerHandler learner : getLearners()) {

try {

// 同步数据到该Follower

syncWithFollower(learner);

} catch (Exception e) {

LOG.warn("Failed to sync with follower", e);

}

}

}

private void syncWithFollower(LearnerHandler learner) throws Exception {

// 获取Follower的最后ZXID

long followerLastZxid = learner.getLastZxid();

// 获取Leader的最后提交的ZXID

long leaderLastZxid = zkDb.getLastProcessedZxid();

if (followerLastZxid == leaderLastZxid) {

// 数据已经同步

learner.setSyncStatus(SyncStatus.UP_TO_DATE);

} else if (followerLastZxid < leaderLastZxid) {

// Follower需要追赶

syncFollower(learner, followerLastZxid, leaderLastZxid);

} else {

// Follower的ZXID比Leader大,不应该发生

LOG.error("Follower has larger zxid than leader: {} > {}",

followerLastZxid, leaderLastZxid);

// 触发回滚或重新选举

handleInconsistentZxid(learner);

}

}

private void syncFollower(LearnerHandler learner,

long followerZxid, long leaderZxid)

throws Exception {

// 获取需要同步的事务

List<Proposal> proposals = getProposalsSince(followerZxid);

// 发送DIFF消息(差异同步)

if (proposals.size() < MAX_DIRECT_SYNC) {

// 差异较小,直接发送差异

sendDiff(learner, proposals);

} else {

// 差异太大,发送SNAP消息(全量快照)

sendSnapshot(learner);

}

// 等待Follower确认同步完成

waitForSyncCompletion(learner);

}

}

}4.4 崩溃场景处理

场景1:Leader在发送提议后崩溃

java

// 处理未提交的事务

public class RecoveryProcessor {

/**

* 新Leader恢复时处理未提交的事务

*/

public void recoverUncommittedProposals() {

// 获取所有未提交的提议

List<Proposal> outstanding = getOutstandingProposals();

for (Proposal p : outstanding) {

// 检查提议是否已经被半数以上接受

if (isAcceptedByQuorum(p)) {

// 已被接受,重新提交

reCommitProposal(p);

} else {

// 未被半数接受,丢弃

discardProposal(p);

LOG.info("Discarding uncommitted proposal: {}", p.zxid);

}

}

}

private boolean isAcceptedByQuorum(Proposal p) {

// 从日志中恢复ack信息

Set<Long> acks = recoverAcksFromLog(p.zxid);

return acks.size() + 1 > (getVotingMembers().size() / 2);

}

}场景2:Leader在提交过程中崩溃

java

// 处理部分提交的事务

public class CommitRecovery {

/**

* 恢复部分提交的事务

*/

public void recoverPartialCommits() {

// 获取Leader日志中最后提交的ZXID

long lastCommittedZxid = getLastCommittedZxidFromLog();

// 获取所有Follower的最后ZXID

Map<Long, Long> followerLastZxids = getFollowerLastZxids();

// 找出最小的已提交ZXID(被所有正常节点接受)

long minCommitted = findMinCommittedZxid(followerLastZxids);

if (minCommitted < lastCommittedZxid) {

// 有些事务只被部分节点提交,需要回滚

rollbackPartialCommits(minCommitted, lastCommittedZxid);

}

}

private void rollbackPartialCommits(long fromZxid, long toZxid) {

for (long zxid = toZxid; zxid > fromZxid; zxid--) {

// 回滚事务

Proposal p = getProposal(zxid);

if (p != null) {

rollbackProposal(p);

LOG.warn("Rollback partial commit: {}", zxid);

}

}

}

}五、ZXID生成与管理的源码实现

5.1 ZXID生成器

java

// ZXID生成的核心实现

public class ZxidGenerator {

private final AtomicLong currentEpoch = new AtomicLong(0);

private final AtomicLong counter = new AtomicLong(0);

/**

* 生成下一个ZXID

*/

public synchronized long nextZxid() {

// 低32位:计数器递增

long c = counter.incrementAndGet() & 0xffffffffL;

// 高32位:当前epoch

long e = currentEpoch.get() << 32;

return e | c;

}

/**

* 开启新的选举周期

*/

public synchronized void newEpoch() {

long newEpoch = currentEpoch.incrementAndGet();

counter.set(0); // 计数器重置

LOG.info("Starting new epoch: {}", newEpoch);

}

/**

* 解析ZXID

*/

public static class ZxidInfo {

public final long epoch;

public final long counter;

public ZxidInfo(long zxid) {

this.epoch = zxid >> 32;

this.counter = zxid & 0xffffffffL;

}

@Override

public String toString() {

return String.format("epoch=%d, counter=%d", epoch, counter);

}

}

}5.2 事务日志管理

java

// 事务日志的存储和恢复

public class FileTxnLog {

private final File logDir;

private volatile long lastZxid = 0;

/**

* 追加事务日志

*/

public synchronized long append(TxnHeader hdr, Record txn)

throws IOException {

// 分配ZXID

long zxid = hdr.getZxid();

// 写入日志文件

File logFile = getCurrentLogFile();

try (FileOutputStream fos = new FileOutputStream(logFile, true)) {

// 序列化事务头和数据

byte[] data = serialize(hdr, txn);

fos.write(data);

fos.getFD().sync(); // 强制刷盘

}

// 更新最后ZXID

if (zxid > lastZxid) {

lastZxid = zxid;

}

return zxid;

}

/**

* 读取事务日志

*/

public List<TxnLogEntry> read(long fromZxid) throws IOException {

List<TxnLogEntry> entries = new ArrayList<>();

// 找到包含fromZxid的日志文件

File logFile = findLogFileContaining(fromZxid);

try (FileInputStream fis = new FileInputStream(logFile)) {

// 跳过之前的事务

skipToZxid(fis, fromZxid);

// 读取后续事务

TxnLogEntry entry;

while ((entry = readNextEntry(fis)) != null) {

entries.add(entry);

}

}

return entries;

}

/**

* 截断日志(用于回滚)

*/

public synchronized void truncate(long zxid) throws IOException {

// 找到zxid对应的文件位置

File logFile = findLogFileContaining(zxid);

long position = findPositionOfZxid(logFile, zxid);

// 截断文件

try (RandomAccessFile raf = new RandomAccessFile(logFile, "rw")) {

raf.setLength(position);

}

LOG.info("Truncated log to zxid: {}", zxid);

}

}六、ZAB协议的高级特性

6.1 观察者模式支持

java

// 观察者不参与投票,但接收数据更新

public class ObserverZooKeeperServer extends LearnerZooKeeperServer {

@Override

public void startup() {

// 连接Leader

connectToLeader();

// 同步数据

syncWithLeader();

// 启动请求处理器

startRequestProcessor();

}

/**

* 观察者处理写请求(转发给Leader)

*/

@Override

public void processWriteRequest(Request request) {

// 观察者不处理写请求,转发给Leader

forwardToLeader(request);

}

/**

* 接收Leader的广播

*/

public void processPacket(QuorumPacket packet) {

switch (packet.getType()) {

case Leader.PROPOSAL:

// 处理提议

processProposal(packet);

break;

case Leader.COMMIT:

// 处理提交

processCommit(packet);

break;

case Leader.UPTODATE:

// 数据已同步

setSyncStatus(SyncStatus.UP_TO_DATE);

break;

default:

LOG.warn("Unknown packet type: {}", packet.getType());

}

}

}6.2 流水线优化

java

// 使用流水线提高广播性能

public class PipelineBroadcaster {

private final ExecutorService pipelineExecutor;

private final Map<Long, PipelineContext> pipelineContexts;

/**

* 流水线广播:将多个提议打包发送

*/

public void pipelineProposals(List<Proposal> proposals) {

if (proposals.isEmpty()) return;

// 按Follower分组,建立流水线

for (LearnerHandler learner : getLearners()) {

PipelineContext ctx = new PipelineContext(learner, proposals);

pipelineExecutor.submit(() -> sendPipeline(ctx));

}

}

private void sendPipeline(PipelineContext ctx) {

LearnerHandler learner = ctx.getLearner();

List<Proposal> proposals = ctx.getProposals();

// 批量发送提议

for (int i = 0; i < proposals.size(); i += BATCH_SIZE) {

List<Proposal> batch = proposals.subList(i,

Math.min(i + BATCH_SIZE, proposals.size()));

// 发送批量提议

QuorumPacket batchPacket = createBatchPacket(batch);

learner.queuePacket(batchPacket);

// 等待批量确认

waitForBatchAck(batch, learner);

}

}

/**

* 批量确认处理

*/

private class BatchAckProcessor {

public void processBatchAck(long startZxid, long endZxid, long sid) {

for (long zxid = startZxid; zxid <= endZxid; zxid++) {

// 更新每个提议的确认状态

updateAck(zxid, sid);

// 检查是否可以提交

if (hasQuorumFor(zxid)) {

commitIfNotCommitted(zxid);

}

}

}

}

}七、ZAB协议的性能调优

7.1 关键配置参数

properties

# zoo.cfg中的ZAB相关配置 # 同步限制(tick的倍数) syncLimit=5 # 初始化连接时间限制 initLimit=10 # 快照触发条件(事务数量) snapCount=100000 # 最大客户端连接数 maxClientCnxns=60 # 最小会话超时 minSessionTimeout=4000 # 最大会话超时 maxSessionTimeout=40000 # 预分配日志文件大小 preAllocSize=65536 # 自动清理快照和日志 autopurge.snapRetainCount=3 autopurge.purgeInterval=24

7.2 性能监控指标

java

java

// ZAB协议性能监控

public class ZabMetrics {

private final Meter broadcastRate = Metrics.meter("zab.broadcast.rate");

private final Timer broadcastLatency = Metrics.timer("zab.broadcast.latency");

private final Counter recoveryCount = Metrics.counter("zab.recovery.count");

private final Gauge outstandingProposals = Metrics.gauge("zab.outstanding.proposals",

() -> getOutstandingProposalsCount());

/**

* 记录广播性能

*/

public void recordBroadcast(long startTime, int proposalCount) {

long duration = System.currentTimeMillis() - startTime;

broadcastLatency.update(duration, TimeUnit.MILLISECONDS);

if (duration > 0) {

double rate = proposalCount * 1000.0 / duration;

broadcastRate.mark((long) rate);

}

}

/**

* 记录恢复事件

*/

public void recordRecovery(RecoveryType type, long duration) {

recoveryCount.increment();

Metrics.timer("zab.recovery.duration",

"type", type.name()).update(duration, TimeUnit.MILLISECONDS);

}

public enum RecoveryType {

LEADER_ELECTION,

FOLLOWER_SYNC,

LOG_TRUNCATION

}

}7.3 内存优化策略

java

// 内存中事务缓存优化

public class ProposalCache {

private final LinkedHashMap<Long, Proposal> cache;

private final int maxSize;

public ProposalCache(int maxSize) {

this.maxSize = maxSize;

this.cache = new LinkedHashMap<Long, Proposal>(16, 0.75f, true) {

@Override

protected boolean removeEldestEntry(Map.Entry<Long, Proposal> eldest) {

return size() > maxSize;

}

};

}

/**

* 添加提议到缓存

*/

public synchronized void put(Proposal p) {

cache.put(p.zxid, p);

// 如果缓存太大,触发压缩

if (cache.size() > maxSize * 1.1) {

compressCache();

}

}

/**

* 压缩缓存:移除已提交的事务

*/

private void compressCache() {

Iterator<Map.Entry<Long, Proposal>> it = cache.entrySet().iterator();

while (it.hasNext()) {

Map.Entry<Long, Proposal> entry = it.next();

if (isCommitted(entry.getKey())) {

it.remove();

}

}

}

/**

* 批量获取提议

*/

public synchronized List<Proposal> getRange(long startZxid, long endZxid) {

List<Proposal> result = new ArrayList<>();

for (long zxid = startZxid; zxid <= endZxid; zxid++) {

Proposal p = cache.get(zxid);

if (p != null) {

result.add(p);

} else {

// 缓存未命中,从磁盘加载

p = loadFromDisk(zxid);

if (p != null) {

result.add(p);

cache.put(zxid, p); // 加入缓存

}

}

}

return result;

}

}八、ZAB协议在真实场景中的应用

8.1 大规模集群优化

java

// 大规模集群下的ZAB优化

public class LargeClusterZabOptimizer {

/**

* 动态调整广播策略

*/

public void optimizeForLargeCluster(int clusterSize) {

if (clusterSize > 50) {

// 大规模集群优化

enableBatching();

enablePipeline();

adjustBatchSize(clusterSize);

} else if (clusterSize > 20) {

// 中等规模优化

enableBatching();

disablePipeline();

} else {

// 小规模,使用默认设置

disableBatching();

disablePipeline();

}

}

private void adjustBatchSize(int clusterSize) {

// 根据集群大小动态调整批量大小

// 公式:batchSize = max(1, 100 / log10(clusterSize))

double batchSize = Math.max(1, 100 / Math.log10(clusterSize));

setBatchSize((int) batchSize);

LOG.info("Adjusted batch size to {} for cluster size {}",

batchSize, clusterSize);

}

/**

* 分级确认机制

*/

public void hierarchicalAck() {

// 将Follower分组,每组选一个代表

Map<Integer, List<LearnerHandler>> groups = groupFollowers();

for (List<LearnerHandler> group : groups.values()) {

// 选择组长

LearnerHandler leader = selectGroupLeader(group);

// 只等待组长确认

waitForAckFromLeaderOnly(leader);

// 组长负责组内同步

leader.syncWithinGroup(group);

}

}

}8.2 跨数据中心部署

java

// 跨数据中心的ZAB部署

public class MultiDataCenterZab {

/**

* 跨数据中心数据同步

*/

public void syncAcrossDC() {

// 主数据中心有完整的ZAB集群

ZooKeeperServer masterDC = createMasterDC();

// 从数据中心只有Observer

ZooKeeperServer slaveDC = createSlaveDC();

// 建立跨数据中心连接

establishCrossDCConnection(masterDC, slaveDC);

// 异步数据同步

startAsyncReplication(masterDC, slaveDC);

}

/**

* 处理网络分区

*/

public void handleNetworkPartition() {

// 检测网络分区

if (isNetworkPartitioned()) {

// 暂停写操作

pauseWrites();

// 等待分区恢复或手动干预

waitForPartitionRecovery();

// 恢复后同步数据

syncAfterPartition();

// 恢复写操作

resumeWrites();

}

}

/**

* 异步复制管理器

*/

private class AsyncReplicator {

private final BlockingQueue<Proposal> replicationQueue;

private final ExecutorService replicatorThreads;

public void startReplication() {

for (int i = 0; i < getReplicatorThreadCount(); i++) {

replicatorThreads.submit(() -> {

while (running) {

Proposal p = replicationQueue.poll(100, TimeUnit.MILLISECONDS);

if (p != null) {

replicateToSlaveDC(p);

}

}

});

}

}

private void replicateToSlaveDC(Proposal p) {

try {

// 异步复制,不阻塞主集群

asyncSend(p, getSlaveDCEndpoint());

// 记录复制状态

recordReplicationStatus(p.zxid, ReplicationStatus.IN_PROGRESS);

} catch (Exception e) {

LOG.warn("Failed to replicate to slave DC", e);

recordReplicationStatus(p.zxid, ReplicationStatus.FAILED);

// 加入重试队列

retryLater(p);

}

}

}

}九、ZAB协议测试与验证

9.1 单元测试框架

java

// ZAB协议单元测试

public class ZabProtocolTest {

@Test

public void testAtomicBroadcast() throws Exception {

// 创建测试集群

TestCluster cluster = createTestCluster(3);

// 启动集群

cluster.start();

// 发送写请求

long startZxid = cluster.getLeader().getLastZxid();

cluster.getLeader().propose("test-data");

// 验证所有节点数据一致

assertConsistent(cluster, startZxid + 1);

// 停止集群

cluster.stop();

}

@Test

public void testCrashRecovery() throws Exception {

// 创建测试集群

TestCluster cluster = createTestCluster(5);

cluster.start();

// 记录初始状态

Leader originalLeader = cluster.getLeader();

long originalEpoch = originalLeader.getEpoch();

// 模拟Leader崩溃

cluster.crashLeader();

// 等待重新选举

cluster.waitForNewLeader(10, TimeUnit.SECONDS);

// 验证新Leader的epoch增加了

Leader newLeader = cluster.getLeader();

assertTrue(newLeader.getEpoch() > originalEpoch);

// 验证数据一致性

assertConsistent(cluster, cluster.getLastZxid());

cluster.stop();

}

@Test

public void testPartialCommitRecovery() throws Exception {

// 测试部分提交的恢复

TestCluster cluster = createTestCluster(3);

cluster.start();

// 发送多个请求

for (int i = 0; i < 10; i++) {

cluster.getLeader().propose("data-" + i);

}

// 在提交过程中杀死Leader

cluster.killLeaderDuringCommit();

// 等待恢复

cluster.waitForRecovery();

// 验证未完成的事务被正确处理

assertNoOrphanedProposals(cluster);

cluster.stop();

}

private void assertConsistent(TestCluster cluster, long expectedZxid) {

for (ZooKeeperServer server : cluster.getServers()) {

assertEquals("Server " + server.getId() + " has inconsistent zxid",

expectedZxid, server.getLastZxid());

}

}

}9.2 混沌工程测试

java

// 使用混沌工程测试ZAB的健壮性

public class ZabChaosTest {

@ChaosTest

public void testNetworkPartition() throws Exception {

// 创建大规模集群

TestCluster cluster = createTestCluster(9);

cluster.start();

// 模拟网络分区(将集群分成3组)

NetworkPartition partition = new NetworkPartition(cluster, 3);

partition.apply();

// 验证分区检测

assertTrue(cluster.detectPartition());

// 尝试写操作(应该失败或阻塞)

try {

cluster.getLeader().propose("test-during-partition");

fail("Write should fail during network partition");

} catch (Exception expected) {

// 预期异常

}

// 恢复网络

partition.recover();

// 验证最终一致性

cluster.waitForConsistency(30, TimeUnit.SECONDS);

cluster.stop();

}

@ChaosTest

public void testSlowFollower() throws Exception {

// 创建测试集群

TestCluster cluster = createTestCluster(5);

cluster.start();

// 选择一个Follower,模拟网络延迟

Follower slowFollower = cluster.getRandomFollower();

simulateNetworkLatency(slowFollower, 5000); // 5秒延迟

// 发送写请求

for (int i = 0; i < 100; i++) {

cluster.getLeader().propose("data-" + i);

}

// 验证Leader不会因为慢Follower而阻塞

assertTrue(cluster.getLeader().isMakingProgress());

// 移除网络延迟

removeNetworkLatency(slowFollower);

// 验证慢Follower最终能追上

cluster.waitForFollowerToCatchUp(slowFollower, 60, TimeUnit.SECONDS);

cluster.stop();

}

@ChaosTest

public void testClockSkew() throws Exception {

// 测试时钟偏移对ZAB的影响

TestCluster cluster = createTestCluster(3);

cluster.start();

// 模拟时钟偏移(向前跳1小时)

cluster.getLeader().adjustClock(3600000);

// 发送请求

cluster.getLeader().propose("test-after-clock-skew");

// 验证时钟偏移被检测到

assertTrue(cluster.detectClockSkew());

// 验证系统继续工作(或进入安全模式)

if (cluster.isInSafeMode()) {

LOG.info("Cluster entered safe mode due to clock skew");

} else {

assertConsistent(cluster);

}

cluster.stop();

}

}十、总结与最佳实践

10.1 ZAB协议的核心优势

-

简化设计:相比Paxos更易理解和实现

-

高性能:优化的两阶段提交,减少同步阻塞

-

强一致性:确保所有节点数据最终一致

-

容错性:支持Leader故障自动恢复

-

有序性:通过ZXID保证事务全局有序

10.2 生产环境部署建议

集群规模规划

yaml

# 推荐集群配置 小型集群(3-5节点): 适用于测试环境、开发环境 中型集群(5-7节点): 适用于生产环境、中等负载 大型集群(7+节点): 适用于大规模生产环境,需要优化配置 # 节点配置建议 内存: 至少8GB,推荐16GB+ 磁盘: SSD,保证IO性能 网络: 低延迟、高带宽内网

监控告警配置

java

// 关键监控指标

public class ZabCriticalMetrics {

// 必须监控的指标

public static final List<String> CRITICAL_METRICS = Arrays.asList(

"zab.broadcast.latency", // 广播延迟

"zab.outstanding.proposals", // 未完成提议数

"zookeeper.leader.epoch", // Leader周期

"zookeeper.zxid.gap", // ZXID差距

"zookeeper.follower.lag" // Follower延迟

);

// 告警阈值

public static final Map<String, Number> ALERT_THRESHOLDS = new HashMap<>();

static {

ALERT_THRESHOLDS.put("zab.broadcast.latency", 1000); // 1秒

ALERT_THRESHOLDS.put("zab.outstanding.proposals", 1000);

ALERT_THRESHOLDS.put("zookeeper.follower.lag", 10000); // 落后10000个事务

}

}10.3 故障排查手册

常见问题及解决方案

java

public class ZabTroubleshootingGuide {

// 问题1: 选举频繁发生

public void fixFrequentElections() {

// 可能原因: 网络不稳定、sessionTimeout太短

// 解决方案:

// 1. 检查网络连接和防火墙

// 2. 调整tickTime和sessionTimeout

// 3. 增加syncLimit

}

// 问题2: 写性能下降

public void fixWritePerformance() {

// 可能原因: 磁盘IO瓶颈、网络延迟、队列积压

// 解决方案:

// 1. 使用SSD磁盘

// 2. 调整snapCount和preAllocSize

// 3. 启用流水线广播

// 4. 监控和优化网络

}

// 问题3: 内存持续增长

public void fixMemoryLeak() {

// 可能原因: 未清理的提议缓存、观察者连接泄漏

// 解决方案:

// 1. 检查提议缓存大小

// 2. 监控连接数,确保正常关闭

// 3. 定期重启(如有必要)

}

// 问题4: 数据不一致

public void fixDataInconsistency() {

// 可能原因: 脑裂、日志损坏、bug

// 解决方案:

// 1. 使用数据一致性检查工具

// 2. 从快照恢复

// 3. 升级到最新版本

// 4. 联系社区支持

}

}Zookeeper写数据ZAB协议源码剖析: